Solaris, il racconto della scienza - Un manifesto

Noi uomini partiamo per il cosmo pronti a tutto:

alla solitudine, alla lotta, al martirio e alla morte.

Anche se per pudore non lo proclamiamo a gran voce,

spesso siamo convinti di essere persone straordinarie.

In realtà quello che vogliamo non è conquistare il cosmo,

ma estendere la Terra fino alle sue frontiere.[1]

PERCHÉ UNA RUBRICA CHIAMATA SOLARIS?

Solaris è un romanzo pubblicato da Stanislaw Lem nel 1961, l’anno in cui Jurij Alekseevič Gagarin accedeva allo spazio per la prima volta nella storia dell’umanità. È la storia di un incontro tra uno psicologo-astronauta e la forma di vita del pianeta Solaris. Ma è anche una riflessione sul senso del “contatto”, sulla straniante alterità del cosmo.

Solaris è un pianeta oceanico che non risponde all’umano: con apparente e incomprensibile volontà crea geometrie megalitiche e “quasi architettoniche”, materializza figure femminee estratte dall’inconscio di chi gli si avvicina e poi disfa ogni sua creazione nell’oblio della sua essenza marina.

“Perché il mondo parla?” Si chiede Kris Kelvin - lo psicologo coinvolto nello studio di Solaris e attorno a cui gira la narrazione - “vuole giocare con noi? O forse punirci?”[2]

----------

La letteratura parla della scienza esprimendone l’immagine sociale, la scienza parla infondendo le sue fantasie nelle storie che ci raccontiamo. Libri più o meno noti, pellicole apparentemente super partes partecipano collettivamente alla produzione degli immaginari scientifici e fantascientifici che finiscono inevitabilmente per influire sulle nostre aspettative future, sulla nostra percezione presente, sul modo in cui riorganizziamo il passato.

La letteratura, come le grandi cose, vive nel via vai che oscilla tra l’espressione e la descrizione.

Può raccontare la scienza che conosciamo, favorirne la diffusione; si pensi a Quando abbiamo smesso di capire il mondo (2021) di Benjamín Labatut o a La Bomba (2020) di Alcante, Bollet e Rodier.

La letteratura è avvertimento sul futuro e tentativo di previsione.

Günther Anders scriveva che autori come Huxley, Orwell o Lem lasciano indietro i filosofi che arrancano: i secondi indaffarati a definire chi ha fatto cosa, i primi preoccupati di cosa le cose faranno di noi.[3]

Tramite l’artificio e l’incanto si raccontano i timori di un’intera società, come nei grandi racconti socio-fantascientifici di James Graham Ballard o, ancora, nel romanzo scientifico-distopico che ha ispirato molti racconti del secolo scorso: Noi (1924) di Evgenij Ivanovič Zamjatin.

Alle volte la letteratura è la via privilegiata per testimoniare l’incontro del singolo - così piccolo - rispetto ai grandi Golem della scienza, della medicina, della tecnologia, del progresso.

Ne è esempio: Non morire di Anne Boyer, una lunga lettera di denuncia al mondo delle terapie contro il cancro che sarà oggetto di questa prima uscita.

D’altra parte, L’enorme bagaglio immaginativo di cui la letteratura si fa carico è ciò che, a sua volta, influenza inevitabilmente le pretese e le traiettorie di chi lavora attivamente nel mondo “scientifico”.

Ci sono le scienze, gli scienziati con il camice bianco, le tecnologie, le politiche di controllo e sviluppo, le controversie e le invidie, i dati e le persone.

Poi c’è Kris, “razionale e scientifico”, trascinato nell’alterità policroma di Solaris. C’è la solaristica, fatta di termini dotti ed esperti che su Solaris non avevano mai messo piede, pur scrivendone: solarista-ciberneti, solarista-simmetriologi… Infine c’è Lem che scrive una storia: sua, nostra? È sempre Kelvin a rispondere, rieccheggiando un noto aforisma di Proust: “non abbiamo bisogno di altri mondi, ma di specchi”.[4]

L’immenso insieme di queste storie mostra le scienze e le tecnologie nel rapporto che instaurano con la singola vita o con un gruppo sociale, con le speranze implicite di un’intera cultura, nel continuo gioco di scambi che le attraversa.

Perciò, noi che vi raccontiamo questi libri, non potevamo che chiamare Solaris questa rubrica: nell’amore per ciò che ci si racconta, speriamo che le parole possano parlarci ancora, e nuovamente.

NOTE

[1] S. Lem, Solaris (1961), a cura di M. Cataluccio, 2013, p. 108.

[2] S. Lem, Solaris, cit., p. 110.

[3] G. Anders, L'uomo è antiquato vol. II (1979), tr. it. M. A. Mori, Bollati Boringhieri editore, Torino 2007, p. 396.

[4] S. Lem, Solaris, cit., p. 109.

Etica, morale & Intelligenza Artificiale

L’intelligenza artificiale è una tecnologia “nuova” che sta trovando applicazione in numerosi campi scientifici, industriali, sociali e politici, e – come per ogni nuova tecnologia – nella sua applicazione possono emergere dei problemi di carattere etico e morale.

In questo post:

- cerco di mettere in rilievo perché sia opportuno dedicare attenzione alla correlazione tra intelligenza artificiale e questioni etiche e morali

- analizzo due casi concreti di utilizzo di tecnologie intelligenti alla ricerca di spunti di riflessione

- provo a rappresentare un esempio di catena di responsabilità nella realizzazione di questo tipo di tecnologie

- e, infine, traggo delle conclusioni di ordine morale – che mi piacerebbe che fossero normative

Per definire convenzionalmente e localmente – giusto per la lettura di questo post – l’Intelligenza Artificiale, mi attengo a questa coppia di definizioni, la prima di “intelligenza”, di E. Scribano, in un suo libro su Descartes, da me modificata in senso più generale, e la seconda di “artificiale”, dal Dizionario Treccani:

- intelligenza: il vivente è una macchina intelligente, se traduciamo questo termine nell'insieme dei comportamenti causati da stati fisici che consentono al corpo vivente di reagire all'ambiente in modo funzionale a degli obiettivi [1], tenendo conto dell'esperienza passata [2]

- artificiale: fatto, ottenuto con arte

Allo stesso livello di generalità prendiamo in considerazione la definizione che si trova sul sito di un gigante delle tecnologie, la Oracle Corporation:

Intelligenza Artificiale (I.A.): sistemi o macchine che imitano l'intelligenza umana per eseguire certe attività e che sono in grado di migliorarsi continuamente in base alle informazioni raccolte [3]

PERCHÈ PARLARE DI ETICA E DI MORALE ASSOCIATE ALL’IA?

La riflessione può nascere in un contesto molto familiare, la guida di una automobile con un sistema intelligente anti-collisione: il sistema ha provocato la frenata, ha letteralmente “inchiodato” la macchina in mezzo al Carrobbio [4], senza che il guidatore (io) capisse perché o potesse intervenire. La ragione della frenata era un gatto che era passato a pochi centimetri dal sensore radar e che, senza anti-collisione, forse non avrei risparmiato.

Le lateralità di questo salvataggio di un gatto del Carrobio sono state, per fortuna, senza conseguenze:

1) il cane di famiglia è finito a gambe all’aria nel bagagliaio

2) l’auto che mi seguiva ha inchiodato a sua volta evitando il tamponamento

Non si può negare, osservando questo caso banale, che un problema morale nell’utilizzo di tecnologie intelligenti c’è.

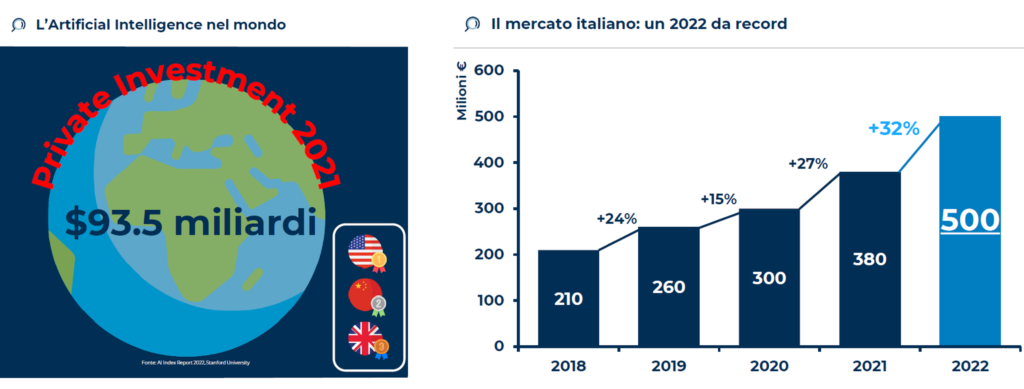

C’è ed è pervasivo: nel 2022 gli investimenti per l’IA sono di 500 milioni di euro in Italia [5] e di più di 90 miliardi di dollari nel mondo[6].

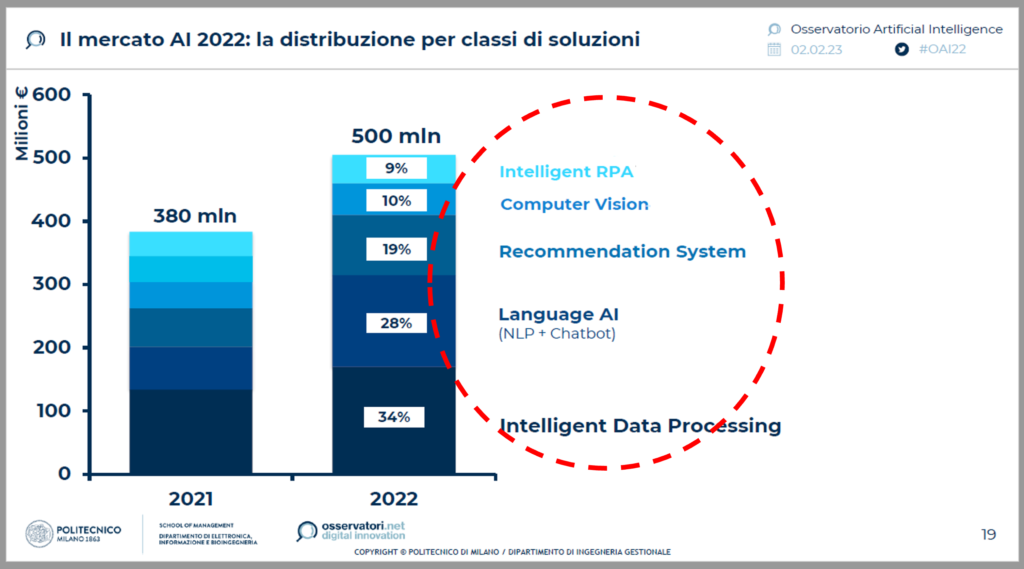

C’è e prende diverse direzioni: gli investimenti in Italia sono destinati all’Elaborazione Intelligente di Dati (34%), alla Comprensione del Linguaggio Naturale (28%), ai Sistemi di Supporto alla Decisione (19%), alla Visione Computerizzata (10%) e all’Automazione Robotica dei Processi.[7]

Il caso della frenata, del gatto del Carrobbio e del cane di famiglia si colloca tra Visione Computerizzata, Elaborazione Intelligente di Dati e Automazione dei Processi.

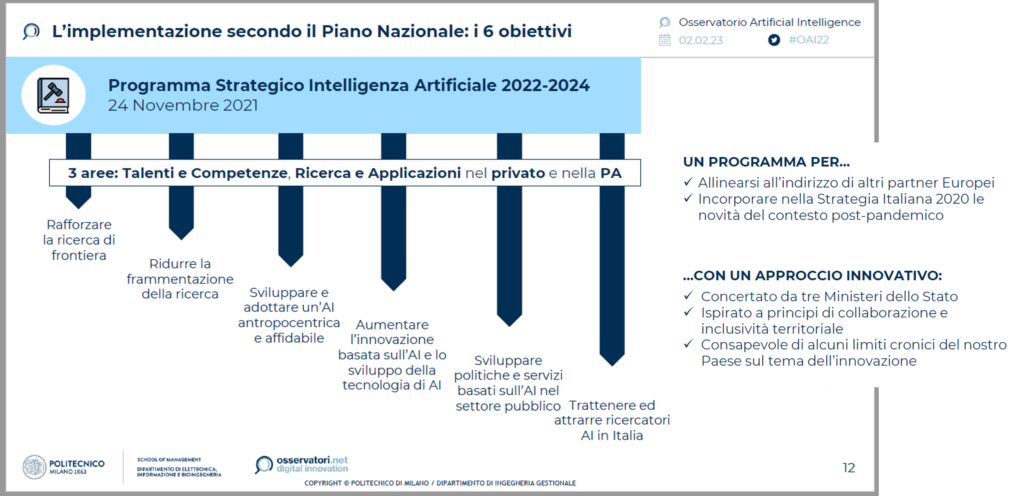

Inoltre, lo sviluppo delle tecnologie di IA è sostenuto dalle Istituzioni: ad esempio, lo Stato italiano ha elaborato un Programma Strategico per gli anni 2022 – 2024, focalizzato su Talenti (da creare o trattenere), Competenze (da generare) e Applicazioni, nel privato e nella Pubblica Amministrazione. [8]

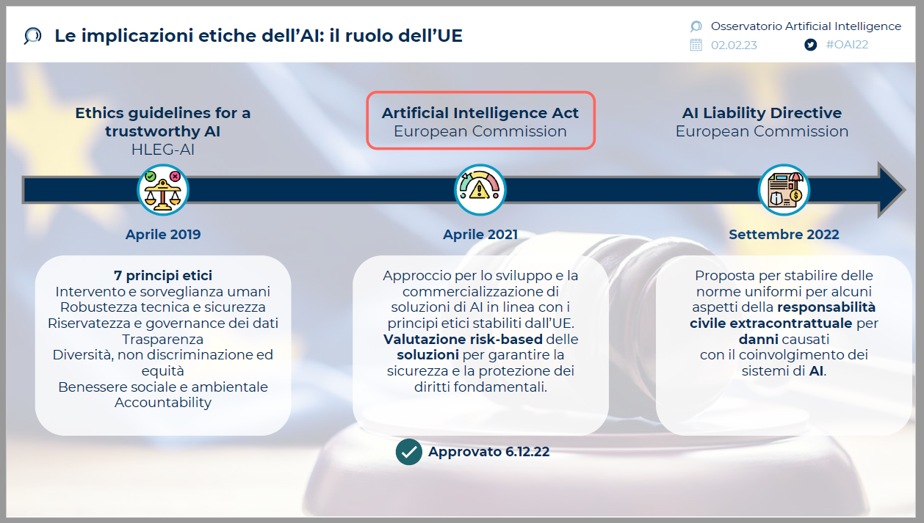

Le Istituzioni non nascondono il problema morale e alcune preoccupazioni; tra il 2019 e il 2022, l’Unione Europea ha varato 3 deliberazioni [9] che cercano di normare le implicazioni etiche della nuova tecnologia: le “Linee Guida per una IA affidabile” si focalizzano sulla robustezza, sul rispetto della sicurezza degli esseri umani (escludendo il gatto del Carrobbio, il cane di famiglia e altri viventi non umani), della trasparenza, della privacy, della non-discriminazione, del benessere ambientale e sociale, e sulla attribuzione di responsabilità per le azioni delle tecnologie; un Atto per l’Intelligenza Artificiale, che delinea l’approccio corretto per lo sviluppo e l’applicazione; una proposta per stabilire delle norme di responsabilità civile in caso di danni.

Il problema morale è enfatizzato dal comportamento delle Aziende: più di un terzo delle Aziende che utilizzano IA non ritiene rilevante il tema etico, il 40% lo prende in considerazione in termini futuri o in modo destrutturato; solo il 21% ha una strategia definita[10] .

-------

L’APPROCCIO DEL PARLAMENTO EUROPEO

Una pubblicazione del Parlamento Europeo, su rischi e vantaggi dell’Intelligenza Artificiale, esprime la visione dell’Istituzione che legifera per l’EU sull’IA:

“L’intelligenza artificiale può consentire lo sviluppo di una nuova generazione di prodotti e servizi, anche in settori in cui le aziende europee sono già in una posizione di forza come l’economia circolare, l’agricoltura, la sanità, la moda e il turismo. Può infatti offrire percorsi di vendita più fluidi e ottimizzati, migliorare la manutenzione dei macchinari, aumentare sia la produzione che la qualità, migliorare il servizio al cliente e risparmiare energia.” [11]

“L’intelligenza artificiale potrebbe significare una migliore assistenza sanitaria, automobili e altri sistemi di trasporto più sicuri e anche prodotti e servizi su misura, più economici e più resistenti. Può anche facilitare l’accesso all’informazione, all’istruzione e alla formazione.” [12]

“L’IA aiuta a rendere il posto di lavoro più sicuro, perché il lavoro più pericoloso può essere demandato ai robot, e offrire nuovi posti di lavoro grazie alla crescita delle industrie dell’intelligenza artificiale.”[13]

E stima l’aumento della produttività del lavoro tra l’11% e il 37% entro il 2035. [14]

L’approccio tradisce la visione scientista, positivista ed efficientista –che proviene dalla pratica scientifica e dalle aziende che ricercano efficacia ed efficienza.

Poco viene detto sulle lateralità negative.

Si potrebbe tradurre: benvenuta la nuova tecnologia che aiuta la crescita e il comfort delle persone che già hanno la gran parte delle opportunità e dei privilegi.

---------

DUE CASI CONCRETI ED EMBLEMATICI

Il primo caso esemplare è quello già accennato del radar anti-collisione dell’automobile.

Tra i soggetti potenzialmente coinvolti negli effetti di applicazione ci sono – oltre al gatto del Carrobbio e al cane di famiglia: il guidatore, i passeggeri che possono riportare danni, i passanti che si possono salvare, gli altri automobilisti che hanno tempi di reazione molto minori del sistema e possono subire danni fisici in caso di tamponamento.

Il problema morale, in questo caso, può essere delineato in questi termini:

- il sistema deve intervenire o solo “avvisare”, cioè, suggerire al guidatore un intervento?

- Cosa farebbe un umano senza il sistema?

- Che frequenza e gravità hanno gli effetti collaterali negativi?

- Per gestire il trade-off tra danni ad un vivente e un altro, si deve fornire al sistema una scala di valore delle categorie di esseri viventi per decidere cosa fare?

- Quanto deve essere grande e vicina la sagoma rilevata, per attivare la frenata?

- Si deve lasciare al guidatore la possibilità di disattivare il sistema?

- Come sono influenzate dalle culture locali, in Europa, in USA, in Cina, le categorie logiche che informano il sistema? John, Hu, Michelle, Stella darebbero le stesse istruzioni alla macchina? E quando Jack usa la macchina di Michelle?

Il secondo contesto che esaminiamo è quello delle applicazioni in campo medico, in particolare dei sistemi intelligenti di supporto alla diagnosi, per i quali KBV Research stima 1,3 miliardi di dollari di spesa all’anno.[15]

Le principali applicazioni diagnostiche, basate sui grandi numeri e sull’analisi statistica, sono rivolte a pratiche come:

- la diagnosi differenziale – che è discernimento tra diverse possibili patologie con sintomatologie simili

- la ricerca di pattern fuori focus – cioè, di sintomi, fenomeni, elementi e manifestazioni minori che, se identificati, possono aiutare a diagnosticare patologie che sono fuori dal focus diagnostico principale

- l’analisi ex-post del tasso di errore diagnostico umano, per esempio a fronte di determinati schemi di sintomi che “puntano” a diverse possibili patologie

per ridurre il tasso di errore diagnostico umano.

Una ragione per cui si investono capitali così ingenti sulle tecnologie diagnostiche intelligenti è, infatti, l’incidenza di errori diagnostici dei medici, che si stima causi alcune migliaia di morti in Italia e decine di migliaia negli USA;[16] oltre al costo sociale, questi errori comportano anche costi finanziari ingenti – in termini di ulteriori esami, ricoveri e, soprattutto, risarcimenti.

Le cause degli errori diagnostici, secondo uno studio congiunto di Sidney University e University of Newcastle (Aus), sono per il 15% di tipo cognitivo, legate a:

- uso errato della statistica

- ancoraggi, ossia collegamenti rigidi tra situazioni sintomatiche e diagnosi

- errori di framing

- pletora o carenza di esami

- fissazione su esperienze di successo

- cecità attentiva

In questo senso, i tanti sostenitori dell’utilizzo delle tecnologie intelligenti in diagnostica, che si richiamano al concetto di Medicina Basata sulle Evidenze (EBM, Evidence Based Medicine), ritengono che questi sistemi possano supportare il lavoro diagnostico grazie a:

- l’uso razionale delle informazioni

- l’interpretazione automatizzata dei dati diagnostici

- l’uso intensivo delle statistiche, delle frequenze storiche e delle previsioni probabilistiche

Tuttavia, i sistemi di Intelligenza Artificiale cadono spesso in errori (allucinazioni), come è accaduto a ChatGPT quando ha suggerito che si possono ottimamente sostituire i bisturi con i grissini. [17]

Il problema morale sotteso all’uso di queste tecnologie in diagnostica è correlato a:

- la possibilità di errore sistematico nella progettazione degli algoritmi di apprendimento e di analisi

- la prevalenza della statistica sull’esperienza, che può influenzare il medico sulle occorrenze più probabili e ad ignorare le possibilità meno frequenti, replicando gli effetti degli errori cognitivi

- l’effetto black box, ossia l’accettazione acritica di ciò che suggerisce il sistema.

-----------

PROBLEMA DELLA RESPONSABILITÀ

Il problema morale solleva quello della responsabilità, che vede coinvolta una serie di figure professionali quali, p.e.: il progettista, l’ingegnere della conoscenza che controlla l’apprendimento, il programmatore che “scrive” i meccanismi di autoapprendimento, il produttore, l’acquirente – p.e.: il dipartimento acquisti della struttura sanitaria, l’utilizzatore tecnico e l’utilizzatore finale che prende la decisione diagnostica e alimenta il meccanismo di autoapprendimento.

Ad esempio: in caso di danni ad un paziente derivanti da malfunzionamento o da una distorsione del sistema, a chi va attribuita la responsabilità? A chi l’ha realizzato oppure a chi l’ha istruito? Al produttore che lo vende sulla base di una promessa di valore che volutamente tralascia le negatività? All’acquirente abbagliato dai risparmi? Oppure all’utilizzatore finale che prende per buono acriticamente il responso della “macchina”?

La responsabilità morale – a mio avviso – ricade su tutti i soggetti che hanno trascurato, con motivazioni differenti, i rischi di errore e di lateralità del sistema.

In assenza di una norma che regoli tutte le fasi del processo, è evidente che anche la responsabilità giuridica è difficile da attribuire.

Forse è più facile agire affinché questi errori accadano con minore frequenza, grazie alla consapevolezza sui rischi legati all’utilizzo delle tecnologie e a un grado superiore di responsabilizzazione preventiva di tutti i soggetti.

-----------

CI SONO DELLE CONCLUSIONI?

Posto che quello della IA può essere un cambiamento epocale con enormi caratteri positivi, vorrei delineare delle possibili raccomandazioni generali di ordine morale:

- non ci si può sottrarre ad una analisi approfondita dei criteri morali che informano i comportamenti delle macchine;

- va tenuto presente che i modelli di apprendimento sono altrettanto sensibili al problema morale; come vengono addestrate le macchine, quali euristiche adottano, quali modelli di percezione [18] vengono usati, sono fattori determinanti per il comportamento delle tecnologie e per l’orientamento delle decisioni umane;

- non è il caso di sostituire l’analisi e l’esperienza con i modelli statistici: in diagnostica, p.e., l’IA può egregiamente svolgere funzioni di supporto ma è preferibile che “non prenda decisioni”

- ci si deve guardare dall’effetto black box, soprattutto se nei sistemi sono incluse funzionalità di apprendimento;

- non vanno mai dimenticate le lateralità sociali

Ma questo vale per tutte le nuove tecnologie.

NOTE

[1] Il testo originale (vedi nota successiva) recitava “alla conservazione della vita”

[2] E. Scribano, Macchine con la mente, Carocci Editore, 2015

[3] https://www.oracle.com/it/artificial-intelligence/what-is-ai/

[4] Il Carrobbio, da quadrivium, è un largo di Milano le cui origini risalgono all'epoca romana. È posto indicativamente alla confluenza fra via Torino, corso di Porta Ticinese, via San Vito, via Cesare Correnti e via del Torchio. Nei dintorni circolano ancora numerosi gatti randagi.

[5] Politecnico di Milano, Osservatori.net - Osservatorio Artificial Intelligence 2023

[6] AI index report 2022, Stanford University

[7] : Politecnico di Milano, Osservatori.net - Osservatorio Artificial Intelligence 2023

[8] Ibidem

[9] Ibidem

[10] Ibidem

[11] Parlamento Europeo - https://www.europarl.europa.eu/news/it/headlines/society/

20200918STO87404/quali-sono-i-rischi-e-i-vantaggi-dell-intelligenza-artificiale

[12] Ibidem

[13] Ibidem

[14] Ibidem

[15] KBV RESEARCH - https://www.kbvresearch.com/artificial-intellgence-diagnostic-market

[16] Morti in ospedale all’anno per errori diagnostici, in Italia: più di 10.000 (M. Motterlini, V. Crupi, Decisioni Mediche, Raffello Cortina Editore, 2005); in Usa: tra 44.000 e 100.000 (Politecnico di Milano, 2002; United States Institute of Medicine, 1999)

[17] Corriere della Sera, 24.01.2023

[18] A breve sarà a disposizione sul blog un articolo di un filosofo orientale che focalizza l’attenzione sulla dimensione epistemologica dell’IA

Non morire, di Anne Boyer

Non Morire, di Anne Boyer, Ed. La nave di Teseo, 2020.

Una malattia mediata dagli schermi digitali, tra blogger, truffatori e feticisti del cancro, ma anche dalle pagine della grande letteratura, da John Donne a Susan Sontag.

«È un libro che non si riesce a smettere di leggere. Una delle descrizioni più belle del mondo del cancro. Di chi non ce la fa e ti abbandona. Della chemioterapia che “è una lunga attesa di essere chiamati per nome”. Delle narrazioni eroiche e intollerabili e dell’imperativo ambivalente a essere positivi» – Chiara Lalli, La Lettura

Una settimana dopo il suo quarantunesimo compleanno, ad Anne Boyer viene diagnosticato un cancro al seno altamente aggressivo. Per una madre single che vive del suo stipendio, abituata a prendersi cura del prossimo e che ora si trova invece a dover contare sugli altri, è un cambiamento traumatico, ma anche l’occasione per raccontare la malattia con parole nuove. Così la forza e la precisione della scrittura riscattano la fatica di un percorso segnato dall’incredibile macchina del profitto messa in opera dal capitalismo sulla nostra salute, capace di distribuire in modo iniquo sofferenza e morte secondo sesso, classe sociale, razza.

Non morire, di Anne Boyer - Un confronto con la medicina

Non morire (La nave di Teseo, 2020) è il libro di Anne Boyer dedicato al racconto delle sue esperienze e impressioni successive alla diagnosi di un carcinoma mammario, che ricevette nel 2014 all’età di 41 anni.

Boyer è poetessa e saggista nata e cresciuta in Kansas e, con Non morire, ha vinto il Premio Pulitzer nel 2020.

-----------

Vi parlo di questo libro perché non è il racconto di una malattia, bensì il racconto di una persona che ha il cancro.

La sua ribellione risulta potente proprio nella misura in cui - di fronte a tutto il mondo - Boyer continua imperterrita a affermare la sua completezza come persona.

La sua opposizione è un caleidoscopio di estrema lucidità, nelle sue critiche femministe e sociologiche, nella passione poetica e filologica, nelle sue impressioni, nell’introspezione e intimità delle riflessioni.

-----------

In questo post cerco di riassumere alcune delle sensazioni – non saranno piacevoli – che emergono dalla lettura di Boyer, in particolare dal suo confronto con la medicina e con la scienza.

Sono argomenti che la sociologia della salute ha già trattato, spesso in modo approfondito, dove possibile li segnalerò in nota.

In chiusura riporto uno dei casi che Boyer ha raccolto per raccontare le truffe e la sporcizia nel mondo delle cure del cancro americano.[1]

Per un quadro completo, per comprendere e conoscere meglio, per una visione più ampia e una poetica amarezza nel cuore, leggete il libro!

------------

Etichette

La prima etichetta è quella diagnostica. «Prendere oggetti e azioni da un sistema e riclassificarli come elementi in un altro sistema è ciò che fa la diagnosi: prende informazioni dai nostri corpi e riorganizza ciò che avevamo dentro in un sistema imposto da lontano». Il radiologo evidenzia la massa, assegna un punteggio.

Si diventa malati, pazienti, clienti.

Boyer descrive la lenta spersonalizzazione di sé che avviene entrando nel dispositivo dell’oncologia. Mentre ancora il corpo non percepisce la differenza tra sano e malato, questo mondo apre le sue porte e comincia a tradurti in numeri e dati.

Quando con la malattia sorge la sofferenza, ci si rivolge alla medicina in cerca di un vocabolario per definire quel male. Non sempre questo avviene - spesso perché, ormai spersonalizzati, non ci si riconosce più - e i malati, racconta Boyer, sviluppano una loro narrazione intorno alla ricerca di risposte.

------------

Quindi si accede al padiglione, «crudele democrazia dell’apparenza», gli stessi volti, gli stessi segni sul corpo, umori, sudori, sangue e urine.

Può farci ribrezzo, ma sono le condizioni a cui le chemioterapie portano i malati.

«Non sembriamo persone: sembriamo persone col cancro. Somigliamo a una patologia prima di somigliare a noi stessi.»

Nel padiglione la produzione del malato di cancro viene portata a termine. Il nome viene registrato su un codice a barre a quel codice si aggiungono via via tutti i dati del paziente.[2]

Meglio, specifica Boyer, sono le donne a farlo.

Perché il tumore al seno è una malattia che ha un genere[3]. Sono le infermiere che lavorano nel padiglione certo, ma prima ancora sono le pazienti che si prestano a quel lavoro.

Compilano questionari, controllano la correttezza dei dati in database, rispondono alle domande delle persone incaricate della loro cura. «La parola “cura” raramente richiama alla mente una tastiera» scrive Boyer, eppure è così, la cura e la raccolta dati vanno a braccetto in un paradossale sistema sincronizzato che culmina nella richiesta di quantificare il tuo dolore da 1 a 10.[4]

Diventa una paziente fatta di dati, prodotta dal lavoro femminile.

------------

Vita del paziente

A un certo punto l’autrice deve prendere atto che è diventata una paziente.

Ha provato a lungo a resistere; si è informata sui social network e sui motori di ricerca; ha imparato a consultare le riviste scientifiche di settore, per cercare una comprensione che i medici non le davano.

A resistere è l’immagine del sé precedente alla diagnosi, si cerca di comportarsi normalmente, di truccarsi, di portare parrucche e vestiti che coprano le ferite delle terapie.

Non basta, si crolla, anzi, proprio quell’aspetto che si ricercava viene in odio perché non lo si è fatto per sé stessi, ma per rispondere alle richieste di una società che non vuole prendersi cura dei suoi.

La società chiede di nasconderti in quanto malato di cancro. Chiede di dissimulare, di pensare positivo, di vivere la terapia con coraggio.

Certo, Boyer è forte, nella sua convinzione di voler vincere la malattia.

Ma non può raccontare questo, non può raccontare la sua battaglia con orgoglio e un nastro rosa appuntato perché è arrabbiata: «Preferirei non scrivere nulla piuttosto che far propaganda del mondo così com’è».

Lei, madre, single, riesce a malapena a seguire il percorso di cura grazie all’aiuto di amiche e amici, tanto da chiedersi se fosse stata una persona un poco meno piacevole che fine avrebbe fatto?

I giorni di malattia al lavoro finiscono presto, devi negoziare la tua nuova situazione, ma hai una condanna a morte scritta in faccia.

L’assicurazione copre certe cure.

Dopo la chemioterapia resti devastata, intossicata per giorni, per non parlare di quando si decide per l’asportazione del tumore. Operazione in giornata, la mammella viene rimossa e il paziente rimandato a casa: questi i costi che ci si può permettere.

«Sono sopravvissuta. Eppure, a causa del regime ideologico del cancro, definendomi una sopravvissuta mi sembra di tradire i morti.»

-------------

Certo Boyer è impietosa ma quello che risulta vero è la sua richiesta di essere accettata per come è con la sua malattia.

Chiede che le sia permesso anche di essere debole, di non farcela, di un posto in questo mondo anche per la donna malata di tumore al seno.

Invece la società è letale con chi non collabora alla sua guarigione: «Il rifiuto conduce all’isolamento: l’esecuzione sociale dell’ottemperanza medica intorno a una patologia genderizzata come il tumore al seno può essere brutale.»

Chi muore poi, tradisce il Progresso della società; quella stessa società in cui – come risponde la figlia di Boyer a sua madre– siamo condannati a vivere e che ci fa ammalare.

------------

Non morire si rivela quindi essere una denuncia poetica delle nostre società tecno-scientifiche.

Se possiamo curare alcune patologie con le “pallottole magiche” o con operazioni ad hoc, il tumore è si rivela più grande di quanto pensiamo.

Di fronte alla persona, il sistema ospedaliero simil-fordista fallisce.

Questo è ancora più marcato quando si è donna (per non parlare di quando si è donna e nera) perché il sistema della cura non è alieno alle dinamiche discriminatorie e patriarcali della società tutta.

Chi si ammala di forme gravi se ha la fortuna di morire presto diventa un “angelo”, le donne che sopravvivono sono invece spesso «abbandonate, tradite, rese disabili, licenziate».

Boyer è sopravvissuta a quel nodulo alla mammella, ma stenta a sopravvivere alla cura: «I fiocchi rosa adornano gli oggetti e i processi che ammazzano la gente. Non esiste cura né c’è mai stata».

------------

La truffa

Ecco uno dei racconti che Boyer raccoglie, che costituiscono una raccolti di casi e truffe scientifiche legate alle terapie contro il cancro, negli Stati Uniti ma con effetti anche negli altri paesi:

Nel 1991 viene diagnosticato un tumore mammario a Nelene Fox.

La compagnia assicurativa non voleva coprire le spese per una nuova terapia basata su un trapianto di midollo osseo contornato da un’alta dose di chemio.

Fox riuscì a pagarsi le spese da sola, ma morì due anni dopo la diagnosi senza accedere alla terapia.

La famiglia fece causa alla compagnia assicurativa ricevendo 89 milioni di dollari di indennizzo.[5]

A partire da questo evento e incoraggiate dai successi dell’attivismo per l’AIDS[6] - racconta Boyer – le donne con tumore al seno si organizzarono in lobby per avere accesso alla nuova terapia.

«Gli ospedali addebitarono da ottantamila dollari a centomila per l’altamente remunerativa procedura, con un costo ospedaliero di meno di sessantamila dollari.»

Lentamente gli assicuratori si prestano e quarantunomila pazienti ricevono la cura.

La terapia era dolorosa e prevedeva l’isolamento per giorni in ospedale, inoltre erano previsti diversi effetti collaterali anche gravi. «Secondo alcuni documenti, la terapia ha ucciso una donna su cinque.»[7]

L’unico studio a supporto era quello condotto da Werner Bezwoda. Quando i ricercatori replicarono quella procedura per la terapia, quattro delle sei donne trattate riportarono gravi danni cardiaci, di queste quattro due morirono di lì a poco.

Più tardi Bezwoda ammetterà che la sua ricerca era fraudolenta.[8]

È del 2016 invece uno studio che conferma[9] i risultati di molte ricerche precedenti: il carcinoma mammario è stato trattato eccessivamente e la maggior parte delle donne con diagnosi di cancro al seno hanno ricevuto trattamenti che non erano necessari. Le mammografie avevano portato all’individuazione precoce di tumori. Questa anticipazione invece di salvarle le ha condannate a trattamenti invasivi e spese insostenibili.

-------

«Morire di cancro al seno non è una prova della debolezza o del fallimento morale dei morti. Il fallimento morale del cancro non è nelle persone che muoiono: è nel mondo che le fa ammalare, le manda in bancarotta per una cura e poi le fa ulteriormente ammalare, infine le incolpa per le loro morti.»

NOTE

[1] Per un’analisi che tenga conto della storia delle politiche italiane sul cancro, comparate a quelle statunitensi, si può leggere G. Vicarelli, Le tappe della politica oncologica in Italia. Riflessioni a margine del caso Di Bella, in “Prospettive sociali e sanitarie”, 2, pp. 6-11.

[2] Boyer racconta nel dettaglio la conformazione del padiglione con cure “passthrough”, che contrappone all’etimo di clinica, alla cura prestata al letto del paziente. Un classico in sociologia al riguardo è D. Sudnow, Passing On. The Social Organization of Death, Englewood Cliffs, Prentice Hall 1967.

[3] Anche gli uomini possono venire colpiti da forme di neoplasia alla mammella, ma i casi sono rarissimi e il tumore al seno si configura come una malattia della donna anche per le implicazioni sociali e politiche che comporta. Queste tematiche sono tutte affrontate da Boyer nel suo libro.

[4] Boyer prova a raccontare il dolore in scale che non siano numeriche, a esempio con frasi tratte dalle poesie di Emily Dickinson – un gioco che fa con le sue amiche per esorcizzare la brutalità della richiesta del medico.

[5] E. Eckholm, $89 Million Awarded Family Who Sued H.M.O, “The New York Times”, 30 dicembre 1993.

[6] Per approfondire l’impatto della partecipazione pubblica alle policy e terapie riguardanti l’AIDS: S. Epstein, Impure Science: AIDS, Activism and the Politics of Knowledge, University of California Press, Berkeley 1996.

[7] R.A. Rettig, False Hope: Bone Marrow Transplantation for Breast Cancer, Oxford, Oxford University Press, 2007.

[8] D. Grady, Breast Cancer Researcher Admits Falsifying Data, “The New York Times”, 5 febbraio 2000.

[9] M. Healy, Majority of Women Diagnosed with Breast Cancer after Screening Mammograms Get Unnecessary Treatment, “Los Angeles Times”, 12 ottobre 2016.