Riprendiamo il post della settimana precedente per capire l’intricata vicenda del licenziamento e successiva ri-assunzione di Sam Altman, amministratore delegato di OpenAI.

————

Appena annunciata la notizia della deposizione di Altman, la piattaforma Reddit è stata presa d’assalto da un tumulto di commenti[1] e tentativi di interpretazione del colpo di mano ai vertici di OpenAI, molti dei quali in chiave di Qomplotto. Q* è davvero la culla dell’AI che ci trasformerà tutti in graffette? È il Clippy odioso che abita dentro ciascuno di noi, la nostra anima di silicio?

1. STRUZZI E PAPPAGALLI STOCASTICI

Il 24 novembre prende la parola uno dei protagonisti della storia recente dell’intelligenza artificiale: Yann LeCun. Mitchell (2019) ricostruisce con precisione le ragioni per cui grazie al suo riconoscitore di immagini AlexNet le reti neurali sono diventate dal 2012 quasi sinonimo di AI, imponendosi come paradigma dominante.

In un post su X[2] (ex Twitter) LeCun dichiara: «per favore ignorate il diluvio di completi nonsense su Q*». Possiamo, in prima battuta, spiegare con un paio di esempi la motivazione di fondo per cui LeCun ha sicuramente ragione: sia su Q*, chein generale su qualunque illazione che intenda predire un futuro distopico con l’evoluzione dei paradigmi attuali di AI. In seconda battuta cercherò di chiarire cosa potrebbe essere Q* nella sua lettura delle poche notizie che sono trapelate.

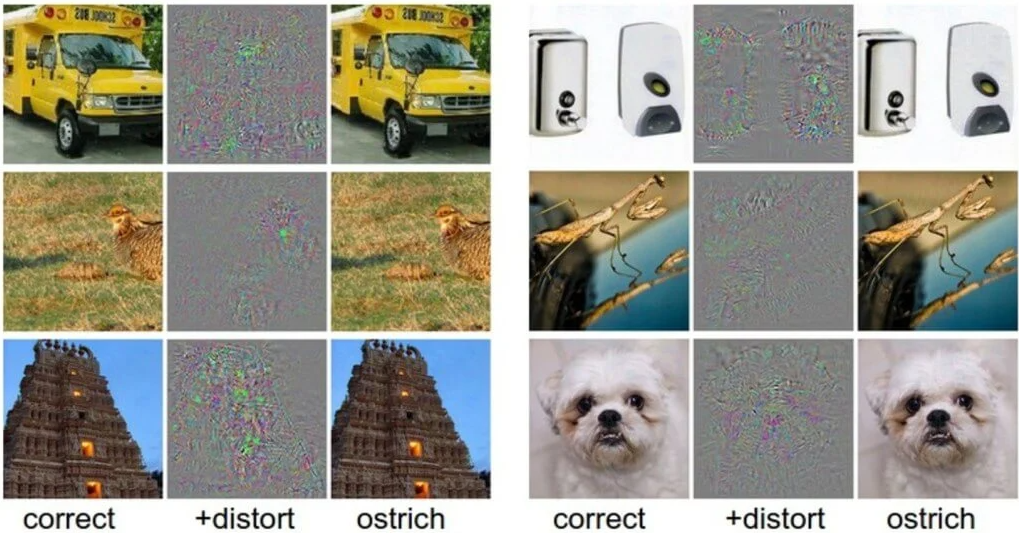

Szegedy et al. (2013) riferiscono gli esiti dell’«attacco avverso» che hanno condotto proprio su AlexNet: l’esperimento di hackeraggio «benevolo» sulla piattaforma di riconoscimento automatico delle immagini si propone di verificare quale sia il grado di comprensione che il software riesce a ricavare dalla percezione delle illustrazioni che gli vengono sottoposte, attraverso l’inserimento di un «rumore informativo» costituito da alcuni pixel inseriti nel corpo delle figure osservate.

L’immagine sulla sinistra è quella originale, classificata in modo corretto dall’intelligenza artificiale; quella sulla destra è stata ottenuta attraverso la modifica di alcuni pixel, che non la mutano affatto al giudizio di un occhio umano. AlexNet tuttavia classifica tutte le varianti di destra come «struzzo», attribuendo al nuovo giudizio un grado di affidabilità maggiore rispetto a quello con cui era stata stabilita la valutazione esatta nella versione di sinistra. Ho già mostrato in Bottazzini (2023) come questo risultato possa essere letto sullo sfondo di uno dei dibattiti filosofici più controversi dal Seicento ai nostri giorni: il cosiddetto «Problema Molyneux». Qui basti osservare che l’errore non può essere giustificato come un bug del sistema, o come un difetto che sarà rimosso dall’espansione della potenza di calcolo futura del software.

In nessun caso un’intelligenza – cioè una forma di comprensione della realtà – che aspiri a somigliare a quella umana può ritenere attendibile che un tempio, o uno scuolabus, o un cane, si tramutino di colpo in uno struzzo.

Anche in caso di illusione ottica o miraggio, lo scostamento dalla percezione corretta è solo temporaneo, e la normalità viene ristabilita con un riesame che restituisce il focus dell’impressione al contesto in cui deve essere collocato.

La realtà viene ristabilita nel campo visivo attraverso l’insieme delle operazioni cognitive non tematizzate, che la tradizione fenomenologica definisce intenzionalità fungente (si pensi per esempio a Merleau-Ponty (1945)), da cui si genera il senso del mondo in cui stiamo agendo, nella sua complessità e in ciascuno dei suoi dettagli.

Searle (1995) le definisce competenze di Sfondo: senza alcuna consapevolezza, permettono di viaggiare in autostrada senza domandarci se lo scuolabus che stiamo per superare subirà una metamorfosi improvvisa in uno stormo di struzzi, se il tempio che stiamo contemplando nel mezzo di una vacanza afosa si dissolverà in un vortice di ali sbattute e di piume svolazzanti, o se il cane dei vicini stia deponendo un uovo nel nostro salotto, convertito in un lembo di savana dietro la porta socchiusa.

Gli eventi che sperimentiamo emergono da un orizzonte che rimane stabile, e che regolarizza senza posa i fenomeni con cui interagiamo, perché noi abbiamo un mondo, per usare la concettualizzazione di Heidegger (1983), al contrario delle AI che invece non ne hanno uno (come il resto dei minerali).

In ChatGPT-4 (2023) l’intelligenza artificiale di OpenAI ha stilato una cronaca dell’evoluzione dell’AI e una serie di indicazioni sulla struttura dei principali tipi di software, con un censimento dei personaggi e dei saggi più rilevanti del percorso. Nel §7.3 si presenta un pappagallo stocastico o allucinazione molto illuminante: ChatGPT cita il testo La questione dell’autonomia: gli agenti artificiali possono essere autonomi e avere libero arbitrio? che Mario Rossi avrebbe pubblicato nel 1995: il libro non esiste, né esiste un Mario Rossi in quanto autore del trattato – ma in ogni caso anche il più somaro degli studenti avrebbe evitato di attribuire a questo volume citazioni da Dennett (2003), o descrizioni della partita tra AlphaGo e Ke Jie, disputata nel 2017.

Le intelligenze artificiali sono macchine che calcolano probabilità, soppesando migliaia di miliardi di parametri per ogni passaggio, e rintracciando in questo modo pattern di relazioni che possono sfuggire a sensibilità e misurazioni dell’uomo. AlexNet stima il grado di probabilità che la distribuzione dei pixel nell’immagine possa essere categorizzata con una certa etichetta; ChatGPT conta la probabilità che una certa parola venga subito dopo quella appena stampata, spaziando su 1.700 miliardi di variabili ad ogni nuovo lemma aggiunto alla frase.

Ma nessuna delle due macchine ha la minima idea di cosa stia guardando o di cosa stia dicendo; anzi, non sa nemmeno di stare percependo o affermando qualcosa.

Il cammino verso l’intelligenza, nel senso effettivo di questa parola, non ha mosso ancora il primo passo.

I paradigmi di sviluppo con cui sono state progettate e costruite le AI fino a oggi, non sono in grado di disegnare un’intelligenza che viva in un mondo dotato di senso; quindi nessuna di loro potrà maturare qomplotti contro di noi, né oggi né in alcun futuro possibile; almeno finché non saremo capaci di ideare un nuovo paradigma di programmazione in grado di superare i limiti di oggi.

L’intelligenza non è una proprietà emergente di un sistema di calcolo che oggi non sarebbe ancora abbastanza potente per lasciar affiorare l’homunculus dotato di pensiero e coscienza autonomi, per ora nascosto nelle viscere dei processori e delle schede madri in attesa di tempi migliori. La quantità di parametri sottosposti al processo di calcolo da parte di ChatGPT si è moltiplicata per un fattore 1.000 a ogni nuova generazione del software; ma l’artefatto è stato in grado di articolare testi sempre più lunghi e complessi, mai di capire anche solo una parola di quello che andava componendo.

L’emergenza dell’intelligenza dall’espansione della capacità di calcolo, come l’emergenza del mondo trasformato in graffette, sono utopie e distopie che vivono solo nell’immaginazione di Bostrom e degli altri (numerosi) teorici dell’esplosione dell’AI.

L’intelligenza non somiglia ai comportamenti aggregati della società, o degli sciami di api, o degli stormi di struzzi; commercia invece con una donazione di senso del mondo e degli eventi, che al momento non abbiamo la minima idea di come ingegnerizzare.

È il dominio della lebenswelt da cui secondo Habermas (1981) siamo in grado di lasciar emergere gli aspetti pertinenti per le decisioni sull’azione, senza sapere da dove provengono i contenuti che stiamo tematizzando e che compongono il materiale di dibattito con gli altri – ma che ogni volta siamo in grado di selezionare con una sorta di tropismo verso la verità.

Senso e intelligenza non si nutrono della fugacità con cui si aggregano e dileguano le orme degli sciami di insetti e di uccelli: sono la struttura stessa che rende possibile la società degli uomini e il processo illimitato di interpretazione del mondo e degli altri che si chiama cultura. No lebenswelt, no qomplotto.

Yann LeCun ritiene che Q* debba essere il nome di un progetto che ha raggiunto qualche risultato utile nelle procedure di apprendimento con rinforzo (reinforcement learning), che è il modello di training applicato a ChatGPT. Si consideri che uno degli algoritmi più diffusi in questo ambito si chiama Q-learning, mentre A* è il nome di un importante algoritmo per l’individuazione del percorso più efficace tra due nodi di una rete. Q* potrebbe quindi individuare un algoritmo capace di ottimizzare il processo di apprendimento introducendo un metodo di pianificazione nelle operazioni con cui la rete neurale riequilibra i pesi delle unità di elaborazione, dopo il giudizio che il formatore umano ha espresso al termine di ogni nuova prestazione.

In altre parole, Q* consisterebbe in un dispositivo di ottimizzazione dei calcoli probabilistici con cui l’intelligenza artificiale stima l’occorrenza del prossimo lemma che deve introdurre nella frase, o dell’etichetta che deve stampare come didascalia dell’immagine.

Se siete delusi da questa interpretazione di Q*, siete degli altruisti efficaci.

2. UN MONOPOLIO DELL’AI

Lo Sciamano ha guidato una farsa di guerra civile nelle stanze del Campidoglio; ma anche chiedere ai filosofi – soprattutto se sono altruisti efficaci – di condurre un colpo di stato nella governance di un’impresa miliardaria non è una buona idea.

Dopo aver licenziato Sam Altman il 18 novembre, il CDA di OpenAI non ha rilasciato alcuna dichiarazione né alla stampa, né a Satya Nadella, CEO del benefattore Microsoft. Non ha chiarito le ragioni della decisione nemmeno a Mira Murati, nominata CEO ad interim, e non ha risposto a Greg Brockman, presidente della società, quando questi si è dimesso in solidarietà con Altman.

Oltre 730 dipendenti di OpenAI (su 770 complessivi) hanno firmato una lettera il 20 novembre in cui si dichiaravano pronti a lasciare l’azienda se Altman non fosse stato reintegrato; ma anche questa comunicazione non ha ricevuto risposta. Visto che Mira Murati era arruolata nella lista dei dimissionari, è stata sostituita con Emmet Shear. Il disastro di gestione e di comunicazione del board si è risolto il 22 novembre, in obbedienza alle riflessioni meditate attorno alla scrivania di Nadella[3]: «diamo l’incarico di gestione a degli adulti, torniamo a ciò che avevamo».

Altman e Brockmann sono rientrati ai loro posti in OpenAI, mentre il CDA è stato sciolto e ne è stato convocato uno nuovo.

La stupidità del panico per un mondo di graffette ha finito per lasciare le mani libere all’implementazione del Copilot su Office. Agli altruisti efficaci non sono bastati nemmeno i proclami e l’allarmismo suscitato da Altman in prima persona, che invece sa calcolare molto bene gli effetti delle sue dichiarazioni. Il CEO di OpenAI non ha mai risparmiato la sua voce, anche se con meno enfasi di quella di Elon Musk, per sottolineare i rischi futuri dell’intelligenza artificiale. L’ultima volta è accaduto il 30 maggio 2023 con una lettera aperta[4] in cui si elencano i pericoli riconducibili agli usi dell’AI volti a produrre e diffondere informazioni false in qualunque formato.

Yann LeCun, ancora lui, invita a sospettare sia della propaganda «lungotermista» di Musk e degli altri altruisti efficaci, sia della sollecitudine con cui Altman esorta a riflettere sui rischi dei prodotti di cui è egli stesso responsabile.

L’AI Safety Summit, che si è tenuto a Londra per volere del premier britannico Rishi Sunak e a cui hanno partecipato i leader di ventotto paesi (tra cui l’Italia), è stato in realtà dominato da figure come quella di Elon Musk – che ha duettato in un evento mediatico l’ultima sera con il Primo Ministro di Sua Maestà.

L’obiettivo di tutti questi soggetti è convincere la classe politica dell’esistenza di rischi catastrofici connessi allo sviluppo dell’intelligenza artificiale, da cui sarebbero al riparo solo le imprese che essi controllano.

«Dobbiamo stare attenti a evitare che queste minacce facciano pensare alla politica che sia un pericolo mettere l’intelligenza artificiale nelle mani di tutti e che quindi si impedisca, tramite regolamentazioni, che lo sviluppo di questa tecnologia sia open source», avverte LeCun[5].

La soluzione originaria di OpenAI era quella giusta, ma l’azienda ha virato senza che i controllori prestassero attenzione al rischio reale che si nascondeva sotto lo spauracchio delle graffette. Lo spettro di Clippy si aggirerà per Copilot, ma stavolta sarà molto più accorto.

Aggiunge LeCun: «Immagina un futuro in cui tutte le nostre azioni saranno mediate dall’intelligenza artificiale. Se questi sistemi saranno chiusi e controllati da un piccolo numero di aziende tecnologiche californiane, allora ci esponiamo a rischi enormi. Potrebbero per esempio usare la loro influenza per modificare la cultura o le opinioni politiche delle persone. Di conseguenza abbiamo bisogno di un sistema aperto e open source che permetta di creare applicazioni specifiche basate su di esso».

È ora che gli intellettuali tornino a essere adulti, e ricomincino a farsi carico di problemi seri.

BIBLIOGRAFIA

Bottazzini, Paolo (2023), Nella caverna di ChatGPT, in ChatGPT-4, Imito, dunque sono?, Milano, Edizioni Bietti, 2023, pagg. 44-45.

ChatGPT-4 (2023), Imito, dunque sono?, Milano, Edizioni Bietti, pagg. 166-167.

Dennett, Daniel (2003), Freedom Evolves, New York, Viking Books.

Habermas, Jürgen (1981), Theorie des kommunikativen Handelns, Francoforte, Suhrkamp, cap.1.

Heidegger, Martin (1983), Die Grundbegriffe der Metaphysik : Welt, Endlichkeit, Einsamkeit, Francoforte, Klostermann, Parte II, cap. 2.

Merleau-Ponty, Maurice (1945), Phénoménologie de la perception, Parigi, Gallimard; trad. it. a cura di Andrea Bonomi, Fenomenologia della percezione, Milano, Bombiani, 2003: cfr. in particolare Premessa, pag. 27.

Mitchell, Melanie (2019), Artificial Intelligence: A Guide for Thinking Humans, New York, Farrar, Straus and Giroux, cap. 5.

Searle, John (1995), The Construction of Social Reality, New York, Free Press, cap. 6.

Szegedy, Christian, Zaremba, Wojciech, Sutskever, Ilya, Bruna, Joan, Erhan, Dumitru, Goodfellow, Ian, Fergus, Rob (2013), Intriguing Properties of Neural Networks, «arXiv», preprint arXiv:1312.6199.

NOTE

[1] https://www.reddit.com/r/singularity/comments/181oe7i/openai_made_an_ai_breakthrough_before_altman/?rdt=54043

[2] https://twitter.com/ylecun/status/1728126868342145481

[3] https://www.newyorker.com/magazine/2023/12/11/the-inside-story-of-microsofts-partnership-with-openai

[4] https://www.safe.ai/statement-on-ai-risk#open-letter

[5] https://www.wired.it/article/intelligenza-artificiale-yann-lecun-meta/

Autore

-

Si occupa di media digitali dal 1999: è co-fondatore di Pquod e VentunoLab, società specializzate nella comunicazione web e nell’analisi di dati. Ha svolto attività di docenza per il Politecnico di Milano e l’Università degli Studi di Milano. Dal 2011 pubblica sulle testate Linkiesta, pagina99, Gli Stati Generali. È il direttore responsabile di Controversie. Per le pubblicazioni: https://scholar.google.com/citations?hl=it&user=zSiJu3IAAAAJ