1. ETICHETTE

Goffrey Hinton è uno psicologo cui è stato assegnato il Premio Nobel per la fisica in omaggio alle sue innovazioni in ambito informatico. Questa mescolanza di discipline mostra quanto sia svantaggioso l’irrigidimento nella separazione delle competenze e l’insistenza sulla specializzazione; ma è sorprendente che questa evidenza sia portata alla luce da un personaggio che ha costruito la sua carriera sulla ricerca di meccanismi destinati ad eseguire operazioni automatiche di ordinamento e classificazione – anzi, di più, a imparare metodi di lettura di contenuti non strutturati per applicare loro etichette di catalogazione.

Hinton meriterebbe un Nobel all’ostinazione, per la perseveranza con cui ha continuato a impegnarsi nell’evoluzione delle reti neurali e del deep learning, anche durante le fasi di «inverno» dell’intelligenza artificiale, con la riduzione degli investimenti, la sfiducia da parte delle istituzioni, lo scetticismo dei finanziatori. Non solo: per almeno un paio di decenni i budget destinati alla ricerca nel settore dell’AI hanno sostenuto soprattutto progetti che non credevano nella possibilità di apprendimento da parte delle macchine, e che si affidavano a software dove i processi di comprensione, di decisione e di esecuzione erano definiti dalle regole di comportamento stabilite a priori dallo sviluppatore umano.

Nel 2012 Hinton, con i collaboratori-studenti Alex Krizhevsky e Ilya Sutskever, ha presentato al concorso ImageNet il riconoscitore di immagini AlexNet: è al successo clamoroso di questa macchina che dobbiamo la diffusa convinzione che intelligenza artificiale, reti neurali e apprendimento profondo, siano tutti sinonimi. Il software non ha solo vinto la competizione del 2012, ma ha migliorato l’indice di correttezza nella classificazione delle illustrazioni di oltre 10 punti percentuali rispetto all’edizione precedente: un passo in avanti nelle prestazioni dell’intelligenza percettiva che non si era mai registrato nella storia del concorso. È risultato chiaro a tutti che in quel momento la disciplina era entrata in una nuova fase, e che il paradigma di progettazione e implementazione era cambiato. Una prova è che Sutskever figura tra i fondatori di OpenAI nel 2015, e che sia stato arruolato fino al novembre 2023 come ingegnere capo dello sviluppo di ChatGPT – il progetto con cui l’intelligenza artificiale ha valicato i confini dell’interesse specialistico e si è imposta all’attenzione del pubblico di massa alla fine del 2022.

2. STRATI NASCOSTI E RETROPROPAGAZIONE DELL’ERRORE

Il lavoro trentennale che precede AlexNet ruota attorno al concetto di retropropagazione dell’errore nel processo di apprendimento delle reti neurali. Né la nozione né il metodo sono stati inventati da Hinton, ma la sua ostinazione nel coltivarli non è servita meno dei suoi contributi ai procedimenti attuali e alla loro divulgazione, per l’elaborazione del paradigma contemporaneo dell’AI.

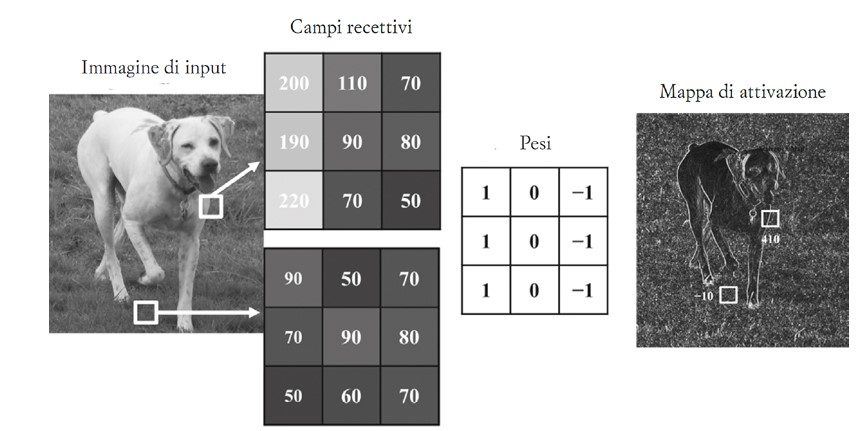

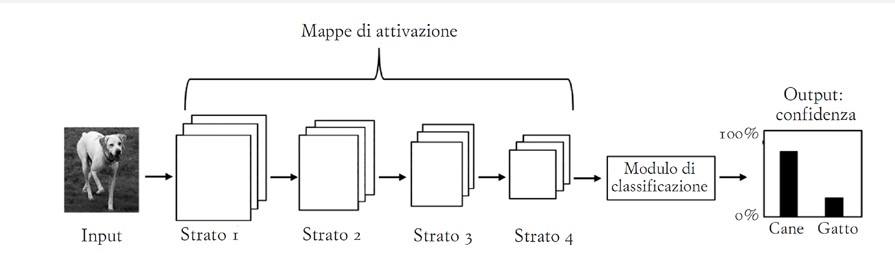

AlexNet e le reti neurali che che le somigliano (quelle convolutive) sono costruite con diversi livelli di unità di elaborazione. Nel primo strato i «neuroni» mappano l’immagine in una griglia di piccole celle, in analogia a quanto accade nella fisiologia della percezione umana.

Il risultato di questo schema di ricezione viene esaminato dagli strati di unità di elaborazione «nascosti», che interpretano confini e colori della figura. L’effetto è una rimappatura dell’immagine per livelli di lettura, che separano il soggetto dallo sfondo, esaminano parti, valutano posture, e così via; possono anche astrarre verso concetti come «fedeltà» o «famigliarità». Maggiore è il numero di questi livelli intermedi, maggiore è il grado di affidabilità con cui all’immagine viene fatta corrispondere l’etichetta che la descrive. A sua volta la didascalia proviene da una tassonomia che la macchina ha archiviato in memoria durante la prima fase di addestramento, insieme ad una galleria di migliaia, se non milioni, di immagini già classificate.

Il risultato di questo schema di ricezione viene esaminato dagli strati di unità di elaborazione «nascosti», che interpretano confini e colori della figura. L’effetto è una rimappatura dell’immagine per livelli di lettura, che separano il soggetto dallo sfondo, esaminano parti, valutano posture, e così via; possono anche astrarre verso concetti come «fedeltà» o «famigliarità». Maggiore è il numero di questi livelli intermedi, maggiore è il grado di affidabilità con cui all’immagine viene fatta corrispondere l’etichetta che la descrive. A sua volta la didascalia proviene da una tassonomia che la macchina ha archiviato in memoria durante la prima fase di addestramento, insieme ad una galleria di migliaia, se non milioni, di immagini già classificate.

Il compito del software è quindi associare pattern di pixel colorati alle etichette di uno schedario, con un certo grado di probabilità. Nella fase di addestramento con supervisione, se la didascalia scelta dalla macchina è corretta, il sistema rimane immutato; se invece l’output è sbagliato, il giudizio di errore si propaga tra gli strati intermedi che hanno contribuito alla stima, inducendo una variazione nei «pesi» del calcolo. Il procedimento tocca tutte le unità di elaborazione, e il suo perfezionamento è ancora oggi il principale tema di indagine per gli esperti del settore, come ha testimoniato Yann LeCun in un post su X poco meno di un anno fa.

Il compito del software è quindi associare pattern di pixel colorati alle etichette di uno schedario, con un certo grado di probabilità. Nella fase di addestramento con supervisione, se la didascalia scelta dalla macchina è corretta, il sistema rimane immutato; se invece l’output è sbagliato, il giudizio di errore si propaga tra gli strati intermedi che hanno contribuito alla stima, inducendo una variazione nei «pesi» del calcolo. Il procedimento tocca tutte le unità di elaborazione, e il suo perfezionamento è ancora oggi il principale tema di indagine per gli esperti del settore, come ha testimoniato Yann LeCun in un post su X poco meno di un anno fa.

La diffidenza di personaggi come Marvin Minsky e Seymour Papert sulla realizzabilità stessa della retropropagazione dell’errore ha dirottato per anni i finanziamenti su progetti che escludevano il deep learning: ai tempi della prima rete neurale, il Perceptron di Frank Rosenblatt che nel 1958 contava 1 solo livello intermedio, le difficoltà sembravano insormontabili. Come nelle storie dei grandi profeti, Hinton si è armato di fede, speranza – e anche senza la carità dei grandi finanziatori istituzionali, ha implementato una macchina capace di imparare a classificare.

3. LIMITI

La descrizione, colpevolmente troppo riduttiva, del funzionamento di AlexNet lascia anche intuire le condizioni e i limiti della concezione dell’intelligenza che è sottesa alla tecnologia delle reti neurali. Già nel piano di Rosenblatt il riconoscimento di un’immagine è inteso come un metodo che porta alla comprensione del contenuto attraverso l’autorganizzazione del contributo di molti attori atomici, coincidenti con le unità di calcolo: un altro articolo su «Controversie» ha esaminato come questo modello cognitivo derivi dal liberalismo economico e sociale di Von Hayek. Ma conta rilevare adesso altri due aspetti del paradigma: l’isolamento dell’apprendimento da ogni considerazione pragmatica, e la costruttività dal basso del processo di interpretazione.

Merleau Ponty ha esaminato con approccio fenomenologico il ruolo che l’attenzione svolge nella percezione: l’identificazione di persone e cose non è una successione di choc visivi che irrompono dal nulla, ma un flusso che segue un decorso da una maggiore indeterminazione ad una maggiore precisione, sull’istanza di una domanda. La richiesta interpella la nostra libertà di avvicinarci, approfondire, interagire: il riconoscimento avviene sullo sfondo di un mondo che è già in qualche modo pre-compreso, e che suscita interrogativi sulla base della relazione che intratteniamo con la scena in cui siamo immersi – per cui lo stesso masso si rivolge in modo differente ad un geologo, o ad un turista stanco per la passeggiata con il suo cane.

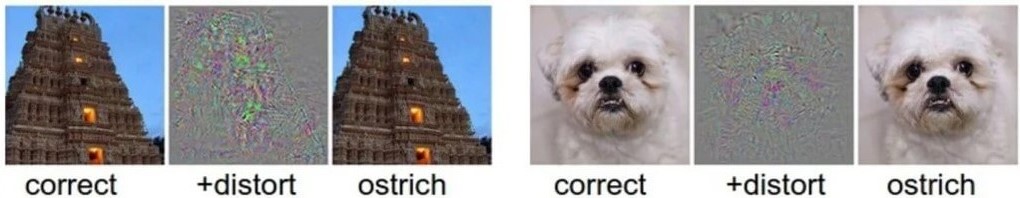

Il riconoscitore di immagini artificiale invece non stabilisce alcuna relazione con il mondo, né ha domande da indirizzargli. Anzi, non ha alcuna cognizione dell’esistenza del mondo e della possibilità di stabilire qualche rapporto con esso. La macchina valuta la probabilità con cui l’attivazione di certi pattern di unità ricettive possa essere messa in relazione con una tra le etichette dello schedario in memoria. Questo spiega come possa cadere nella trappola degli attacchi avversari, in cui il «rumore informativo» dovuto alla sostituzione di alcuni pixel (che non modificano per nulla l’aspetto dell’immagine ai nostri occhi) faccia cambiare le stime di AlexNet, convincendola a preferire l’etichetta struzzo a quelle assegnate correttamente in precedenza a tempio e cane.

Senza un mondo che agisca come orizzonte di senso per azioni e interpretazioni, non esistono domande, quindi nemmeno riconoscimenti e intelligenza – nel senso corrente di questi termini. Non esiste nemmeno la possibilità di un’autocorrezione, come quella che mettiamo a punto in modo istintivo quando incorriamo in un trompe l’oeil o in qualche illusione ottica: è la stabilità del mondo, non la coerenza delle leggi dell’apprensione, a permetterci di ravvisare l’errore. L’inganno per noi infatti è momentaneo, poi la coesione dell’esperienza del reale torna a ripristinare il senso della percezione (anche nei casi di abuso di sostanze psicotrope): è per questo che siamo consapevoli di essere vittime di illusioni.

Senza un mondo che agisca come orizzonte di senso per azioni e interpretazioni, non esistono domande, quindi nemmeno riconoscimenti e intelligenza – nel senso corrente di questi termini. Non esiste nemmeno la possibilità di un’autocorrezione, come quella che mettiamo a punto in modo istintivo quando incorriamo in un trompe l’oeil o in qualche illusione ottica: è la stabilità del mondo, non la coerenza delle leggi dell’apprensione, a permetterci di ravvisare l’errore. L’inganno per noi infatti è momentaneo, poi la coesione dell’esperienza del reale torna a ripristinare il senso della percezione (anche nei casi di abuso di sostanze psicotrope): è per questo che siamo consapevoli di essere vittime di illusioni.

La separazione della sfera cognitiva da quella pragmatica, e la riduzione della mente ad un sistema di procedure di problem solving, intrappolano invece la percezione in un mondo di specchi e di concetti senza via d’uscita. Le inferenze che si propagano da unità nucleari di percezione sono il correlato di un universo di etichette che non si riferiscono a nulla di reale – tanto da poter ravvisare uno struzzo al posto di un tempio, senza alcuna forma di disagio. Quel disagio che colpisce l’individuo intelligente davanti all’abisso della stupidità.

BIBLIOGRAFIA

Bottazzini, Paolo, Nello specchio dell’Intelligenza Artificiale – The Eye of the Master, «Controversie», 4 giugno 2024. https://www.controversie.blog/specchio-della-ia.

LeCun, Yann, Please ignore the deluge of complete nonsense about Q*, https://x.com/ylecun/status/1728126868342145481.

Merleau-Ponty, Maurice, Phénoménologie de la perception, Gallimard, Parigi 1945; trad. it. a cura di Andrea Bonomi, Fenomenologia della percezione, Bombiani, Milano 2003.

Minsky, Marvin; Papert, Seymour, Perceptrons, MIT Press, Cambridge 1969.

Rumelhart, David E.; Hinton, Geoffrey E.; Williams, Ronald J., Learning representations by back-propagating errors, «Nature», vol. 323, n. 6088, 9 ottobre 1986, pp. 533–536.

Szegedy, Christian, Zaremba, Wojciech, Sutskever, Ilya, Bruna, Joan, Erhan, Dumitru, Goodfellow, Ian, Fergus, Rob (2013), Intriguing Properties of Neural Networks, «arXiv», preprint arXiv:1312.6199.

Autore

-

Si occupa di media digitali dal 1999: è co-fondatore di Pquod e VentunoLab, società specializzate nella comunicazione web e nell’analisi di dati. Ha svolto attività di docenza per il Politecnico di Milano e l’Università degli Studi di Milano. Dal 2011 pubblica sulle testate Linkiesta, pagina99, Gli Stati Generali. È il direttore responsabile di Controversie. Per le pubblicazioni: https://scholar.google.com/citations?hl=it&user=zSiJu3IAAAAJ

Visualizza tutti gli articoli