I costi ambientali del digitale - Una bibliografia ragionata

Che il grande baraccone digitale planetario, che oggi si manifesta in particolare sub specie intellegentiae artificialis, nasconda, dietro le luminarie della facciata, un lato oscuro di pesantissimi costi ambientali è testimoniato da una mole di dati sempre maggiore. Così come cresce per fortuna l’informazione in merito, filtrando addirittura sugli organi d’informazione mainstream, dove in genere s’accompagna tuttavia alla rassicurante prospettiva di soluzioni tecnologiche a portata di mano. È comunque bene che la consapevolezza della dimensione industriale e materiale del web, con le relative conseguenze in termini di “impronta ecologica”, si faccia strada nella coscienza collettiva. Come contributo in questo senso, dopo avere discusso in due precedenti articoli su questa rivista [qui e qui] il libro di Giovanna Sissa, Le emissioni segrete, Bologna, Il Mulino, 2024, proponiamo di seguito una piccola bibliografia ragionata sull’argomento.

- Guillaume Pitron, Inferno digitale. Perché Internet, smartphone e social network stanno distruggendo il nostro pianeta, Roma, LUISS University Press, 2022. Fa girar la testa il viaggio vertiginoso tra dati, numeri, luoghi e situazioni in cui Pitron ci accompagna per mostrarci che la crescita illimitata del capitalismo digitale non è meno energivora e inquinante delle “vecchie industrie” (ma appunto questa distinzione è buona… per i gonzi). Il libro, infatti, sfata nel modo più drastico la mitologia diffusa del carattere ecocompatibile dell’universo digitale. Alternando analisi e reportage giornalistico, Pitron riesce a dare un quadro documentato e insieme davvero drammatico degli effetti dannosi che l’industria digitale scarica sull’ambiente (da segnalare l’impressionante capitolo dedicato all’inquinamento registrato nelle città di Taiwan, dove si concentra una parte molto significativa della filiera). Un libro, infine, ben lontano da ogni compassata «avalutatività» delle scienze sociali, con buona pace di Max Weber.

- Kate Crawford, Né intelligente né artificiale. Il lato oscuro dell’IA, Bologna, Il Mulino, 2021. Questo libro, opera di una delle più intelligenti studiose di questi argomenti, non è specificamente dedicato al tema dei costi ambientali del digitale, ma piuttosto a una complessiva visione critica dell’Intelligenza Artificiale (come recita il titolo originale, un Atlas of AI. Power, Politics, and the Planetary Costs of Artificial Intelligence), di cui vengono enfatizzate le implicazioni politiche, sociali, antropologiche ecc. In tale quadro è dato molto spazio al tema della “materialità” del mondo digitale, perché – scrive la Crawford – «l’intelligenza artificiale può sembrare una forza spettrale, come un calcolo disincarnato, ma questi sistemi sono tutt’altro che astratti. Sono infrastrutture fisiche che stanno rimodellando la Terra, modificando contemporaneamente il modo in cui vediamo e comprendiamo il mondo».

- Juan Carlos De Martin, Contro lo smartphone. Per una tecnologia più democratica, Torino, Add, 2023. Particolarmente incentrato sul ruolo di vera e propria protesi del corpo umano, nonché di oggetto-feticcio che lo smartphone («la macchina per eccellenza del XXI secolo») tende ad assumere, questo libro contiene molti dati e osservazioni utili sul tema della sua materialità e appunto del suo impatto ambientale.

- Andrew Blum, Viaggio al centro di internet, a cura di Fabio Guarnaccia e Luca Barra, Roma, Minimum fax, 2021 (ed. or. 2012). Uscito originariamente nel 2012 e giunto in traduzione italiana dieci anni dopo, il Viaggio di Blum ha appunto la forma di un singolare reportage nella geografia, nei luoghi fisici (per esempio i tanti anonimi capannoni in cui si trovano i data-center) in cui si materializza il web: «per fare visita a Internet – scrive l’autore – ho cercato di liberarmi dell’esperienza personale che ne avevo già, del modo in cui si palesa su uno schermo, per portare a galla la sua massa nascosta». E può essere utile sapere che l’idea della ricerca venne al giornalista statunitense quando, una sera, si trovò con la connessione fuori uso nella sua casa in campagna a causa di… uno scoiattolo che gli aveva rosicchiato i cavi!

- Siate materialisti! è l’appello che campeggia sulla copertina dell’appassionato e stimolante pamphlet di Ingrid Paoletti (Torino, Einaudi, 2021), docente di Tecnologia dell’architettura al Politecnico di Milano. Niente a che fare con una dichiarazione di fede filosofica di stile settecentesco, però: qui il «materialismo» che si invoca è piuttosto una rinnovata attenzione alla dimensione materiale della nostra vita, ai manufatti che la popolano e che tuttavia noi ormai diamo per scontati e in certo modo naturali. Una disattenzione, questa verso la “materia”, dagli evidenti risvolti ecologici (piace qui ricordare la bella figura di Giorgio Nebbia, che riteneva proprio per questo la merceologia una scienza altamente civile), e che tocca in particolare il mondo del digitale: il web e i suoi servizi continuano, in effetti, ad apparire ai nostri occhi un campo di interazioni puramente cognitive e sociali, slegata da ogni implicazione materiale.

- È un libro a più voci (davvero tante) Ecologia digitale. Per una tecnologia al servizio di persone, società e ambiente, Milano, AltrEconomia, 2022, una guida completa ai diversi “lati oscuri” (non solo quello ambientale) della digitalizzazione. Con una particolare attenzione alle soluzioni pratiche proposte dagli studiosi e dai tecno-attivisti che cercano di pensare – e progettare – un digitale (davvero) sostenibile, che significa anche, tra l’altro, contenerlo e ridimensionarlo.

- Propone una visione a tinte (giustamente) fosche Terra bruciata (Milano, Meltemi, 2023) di Jonathan Crary, un bravo saggista americano che si era segnalato alcuni anni fa per un atto d’accusa molto ben documentato contro “l’assalto capitalistico al sonno” (24/7, Einaudi, 2015). Crary parla in questo libro del degrado ambientale prodotto dalla industria del digitale non come di un fenomeno isolato, ma come parte integrante di un capitalismo ormai completamente insostenibile. In questo senso, il luccicante mondo digitale è solo la quinta teatrale (l’ultima allestita dal discorso autocelebrativo dominante) che cerca di spacciare un mondo ormai marcescente in un paradiso transumano.

- Paolo Cacciari, Ombre verdi. L’imbroglio del capitalismo green, Milano, AltrEconomia, 2020. Ricco di considerazioni (e di dati) sul tema dell'impatto ecologico delle tecnologie digitali, il libro di Paolo Cacciari è principalmente dedicato alla decostruzione critica del “nuovo imbroglio ecologico” (come lo si potrebbe chiamare con il titolo del celebre saggio di Dario Paccino del 1972) rappresentato dalla cosiddetta green economy. Anche perché «la riconversione dal fossile al green – definita la terza o quarta rivoluzione industriale – è gestita dalle stesse centrali del grande capitale finanziario». Centrali che non brillano, di norma, per attenzioni filantropiche, né appunto ambientali.

Parola-chiave: decoupling, ovvero l’asserito «disaccoppiamento» tra crescita economica e impatto ambientale reso possibile dalle tecnologie dell’informazione della comunicazione (ICT), un mito qui debitamente sbugiardato.

- La critica della favoletta “eco-capitalistica” del decoupling, nonché il riferimento alla insostenibilità ambientale del «consumismo cognitivo che si poggia sulle ICT» trova spazio anche in Il capitale nell’Antropocene, Torino, Einaudi, 2024 (ed.or. 2020) di Saito Kohei, il popolare saggista che ha fatto scoprire ai giapponesi i temi dell’eco-marxismo, ricevendo peraltro un successo inusuale per le opere di saggistica politico-sociale (il suo Ecosocialismo di Karl Marx ha venduto in patria mezzo milione di copie!), e che oggi, sull’onda di questo successo, viene accolto come una star anche in Italia. Insomma, anche le mode talvolta fanno cose buone…

- È un manuale rivolto ai corsi di media e comunicazione Gabriele Balbi e Paolo Magaudda, Media digitali. La storia, i contesti sociali, le narrazioni, Bari-Roma, Laterza, 2021: un volume che intende fornire una visione interdisciplinare del fenomeno digitale, con particolare attenzione a un approccio storico e sociologico (insomma: la Rete non cade dal cielo e non è socialmente neutrale), e ben consapevole della «dimensione infrastrutturale e materiale della rete internet».

- Chi, infine, volesse andare alle fonti, può consultare il periodico rapporto sull’economia digitale preparato annualmente dall’UNCTAD, l’agenzia ONU sui temi del commercio e dello sviluppo e disponibile in rete. Sul Digital Economy Report 2024, https://unctad.org/publication/digital-economy-report-2024 , si possono trovare tutti i dati più aggiornati sul tema (uno tra i mille: la vendita di smartphone ha raggiunto il miliardo e duecento milioni di unità nel 2023, il doppio del 2010) e documentazione nei più diversi formati: tabelle, infografiche molto accattivanti, il documento scaricabile in PDF in sei lingue, video di accompagnamento, podcast ecc.

A riprova che, in questo campo come in molti altri, le informazioni ci sono in abbondanza e ormai a disposizione di chiunque. Siamo noi, abitatori del tempo presente, che siamo sempre meno capaci di farne uso e di trarne conseguenze razionali, anche perché costantemente distratti dagli apparati del potere mediale stesso.

Politiche della montagna - Il conflitto geotermico sul Monte Amiata tra pianificazione su larga scala e modi di vita locali

La geotermia è generalmente considerata una fonte di energia rinnovabile e sostenibile, poiché sfrutta il calore naturale della Terra, che dal nucleo si diffonde attraverso il mantello e la crosta fino alla superficie. Questa energia può essere impiegata sia per la produzione di elettricità sia per il riscaldamento. In Italia, tuttavia, il caso del Monte Amiata, in Toscana, rappresenta un esempio emblematico di conflitto tra sostenibilità ambientale, sviluppo energetico e diritti delle comunità locali. Situato tra le province di Grosseto e Siena, il Monte Amiata è un ex vulcano che ospita impianti geotermici gestiti da ENEL Green Power. La geotermia ha una lunga tradizione in Toscana, con i primi impianti costruiti nei primi anni del Novecento a Larderello (Pisa). Se in alcune aree della regione questa forma di energia è stata considerata un'opportunità di sviluppo, sul Monte Amiata ha suscitato una forte opposizione. Tale conflitto si è intensificato ulteriormente dopo che la Regione Toscana ha annunciato nuovi piani per espandere la costruzione di centrali geotermiche sul territorio. Le principali preoccupazioni riguardano l'impatto ambientale e sanitario, poiché le emissioni di sostanze come arsenico, mercurio e anidride carbonica sollevano dubbi sulla sicurezza della popolazione e sulla tutela della biodiversità locale.

IL DIBATTITO SCIENTIFICO: DATI E INTERPRETAZIONI CONTRASTANTI

Le principali controversie legate alla geotermia sul Monte Amiata riguardano tre aspetti: 1) l'impatto ambientale degli impianti; 2) le conseguenze sulla salute della popolazione; 3) gli effetti sull’economia locale.

Le associazioni e gli attivisti contestano la presunta sostenibilità della geotermia nella zona, denunciando il rilascio in atmosfera di sostanze inquinanti come arsenico, idrogeno solforato, mercurio e grandi quantità di CO₂.

Sul piano sanitario, le preoccupazioni sono aumentate dopo la pubblicazione di uno studio del CNR di Pisa (ARS Toscana 2010), che ha evidenziato nei comuni del Monte Amiata con attività geotermiche un tasso di mortalità maschile superiore di circa il 13% rispetto ai comuni vicini. Tuttavia, ENEL, l’amministrazione regionale e alcune associazioni tecniche negano una correlazione diretta tra queste statistiche e la produzione geotermica. In risposta alle proteste, ENEL ha introdotto nei suoi impianti i filtri "AMIS", progettati per ridurre le emissioni di mercurio e idrogeno solforato. Tuttavia, le associazioni ambientaliste ritengono che questi filtri non siano sufficientemente efficaci nell’eliminare molte altre sostanze inquinanti.

Sul piano economico, gli oppositori della geotermia temono che lo sfruttamento energetico comprometta le risorse naturali e il paesaggio, mettendo a rischio il turismo e le attività agricole, pilastri dell’economia locale. Il Monte Amiata è infatti un’area di grande valore paesaggistico e agricolo, nota per la produzione di vino, olio, castagne e altri prodotti tipici. Secondo i critici, la geotermia ha avuto un impatto minimo sull’occupazione locale – contrariamente a quanto sostenuto da ENEL e dalla Regione Toscana – ma ha invece danneggiato i settori economici tradizionali della zona.

LE RADICI DEL CONFLITTO: DIVERSI TIPI DI ATTACCAMENTI AL TERRITORIO

Oltre agli aspetti scientifici, il dibattito sulla geotermia del Monte Amiata ha una forte dimensione sociale e politica. Le comunità locali, organizzate in comitati, esprimono un profondo senso di solastalgia (Lampredi, 2024) – l'angoscia di non sentirsi più a casa pur essendo ancora a casa, causata dal degrado o dalla trasformazione dell’ambiente naturale a cui una persona è emotivamente legata, spesso dovuta a cambiamenti climatici, industrializzazione o disastri ambientali. La percezione di essere escluse dai processi decisionali ha alimentato il conflitto, rafforzando la sfiducia nei confronti delle istituzioni e delle aziende coinvolte.

Sul piano politico, la Regione Toscana ha continuato a sostenere l’espansione della geotermia, minimizzando il conflitto e definendolo un “non-conflitto”. L'opposizione locale è stata spesso ridotta a una reazione emotiva e classificata come un caso di sindrome NIMBY (Not In My Back Yard, "Non nel mio cortile"). Tuttavia, le proteste e le azioni legali intraprese dai comitati locali hanno rallentato l’approvazione di nuovi impianti e portato la questione al centro del dibattito pubblico.

Per comprendere il conflitto, è fondamentale considerare i diversi legami che le parti coinvolte hanno con il territorio. Gli oppositori della geotermia sono spesso agricoltori, operatori termali, proprietari di agriturismi e piccoli imprenditori, la cui sussistenza dipende dalla tutela dell’ambiente locale. Per loro, il Monte Amiata non è solo una risorsa economica, ma un luogo profondamente legato alla loro storia familiare e alla loro identità. Al contrario, i promotori della geotermia, che detengono un maggiore potere decisionale, affrontano la questione da una prospettiva principalmente tecnica. Il conflitto riflette quindi anche uno scontro tra coinvolgimento diretto e distacco dal territorio, influenzando il modo in cui la risorsa geotermica viene promossa, accolta, contrastata e negoziata

LA "MONTAGNA MADRE": UN LEGAME ANTICO E SPIRITUALE

Già nell’antichità, gli abitanti del luogo chiamavano il Monte Amiata “Montagna Madre” per il sostentamento che ha garantito alle famiglie della zona per generazioni, grazie alla ricchezza della sua biodiversità. Inoltre, il suo aspetto spirituale è di primaria importanza, poiché il calore della terra ha ispirato un legame profondo e secolare tra la montagna e i suoi abitanti. L'idea della Montagna Madre ha origini antiche e affonda le sue radici non solo nella storia cristiana del luogo, ma anche in quella etrusca. Per gli Etruschi, infatti, la vetta del Monte Amiata era considerata la dimora del dio Tinia, assimilabile a Zeus nella mitologia greca e a Giove in quella romana. L'immagine sottostante (figura 1) raffigura l’Allegoria del Monte Amiata, un dipinto di Nasini situato nell'abbazia di Abbadia San Salvatore, uno dei borghi più attivi dal punto di vista geotermico della montagna.

Figura 1: “Allegoria del Monte Amiata", F. Nasini, abbazia di San Salvatore (foto di Cesare Moroni)

Il Monte Amiata ospita inoltre Merigar, uno dei più importanti centri tibetani d’Europa. Il suo nome, che significa residenza della montagna di fuoco, richiama esplicitamente il passato vulcanico della zona. La montagna è quindi un luogo di culto per diverse tradizioni religiose, non solo cristiane, tutte in qualche modo legate al calore sotterraneo che caratterizza il territorio.

È impossibile non notare l’evidente legame simbolico tra il calore della montagna, che per generazioni ha nutrito la biodiversità e garantito la sussistenza delle comunità locali, e il suo sfruttamento attuale per alimentare le centrali geotermiche, inserendolo in logiche economiche più ampie.

CONCLUSIONE

Il caso della geotermia sul Monte Amiata dimostra che la transizione ecologica non può essere ridotta a una semplice questione tecnica ed economica, ma deve includere anche le percezioni e le esigenze delle comunità locali. Il dibattito scientifico rimane aperto, con studi che offrono dati contrastanti sugli impatti ambientali, economici e sanitari degli impianti geotermici.

Per evitare conflitti e garantire una transizione energetica equa e sostenibile, è fondamentale adottare processi decisionali inclusivi, che favoriscano un confronto trasparente tra esperti, istituzioni e cittadini. Solo attraverso un approccio partecipativo sarà possibile trovare un equilibrio tra innovazione tecnologica, tutela ambientale e giustizia sociale

RIFERIMENTI BIBLIOGRAFICI

ARS Toscana. 2010. Geotermia e Salute. https://www.ars.toscana.it/geotermia-e-salute/dati-estatistiche/1728-progetto-di-ricerca-epidemiologica-sulle-popolazioni-residentinellintero-bacino-geotermico-toscano-ottobre-2010.html

Lampredi, G. (2024). Solastalgia as Disruption of Biocultural Identity. The Mount Amiata Geothermal Conflict. Society & Natural Resources, 37(11), 1508-1527.

Scienza ed arte - Per una rinnovata sinergia

Oggi, il rapporto tra arte e scienza è oscurato e perduto. L’han detto e scritto in molti: Feyerabend e Thomas (1989), Greco (2013), Odifreddi (2023), solo per citare che pochi autori. Un tema enorme, su cui un post può solo abbozzare alcune considerazioni.

Nel 1929, Norbert Wiener, il matematico che sarebbe poi diventato noto come il padre della cibernetica, affermava che la scienza dei numeri è, in senso stretto, un'arte. Secondo Wiener, la matematica poteva (e doveva) essere considerata parte integrante della storia dell'arte (Odifreddi 2023).

Sul rapporto benefico tra arte e scienza ci sono moltissimi esempi, dalla storiografia alla musica, dall'architettura e alla fisica e alle neuroscienze. Eppure, l’età scientista in cui stiamo vivendo tende a trascurarlo o a nasconderlo. Questa visione scientista è stata contrastata dalla controversia scatenata dallo scrittore e fisico inglese Charles Percy Snow, con il suo libro Le Due Culture e la rivoluzione scientifica (1959). Con esso Snow denunciava la crescente frattura tra la cultura scientifica e quella umanistica. La sua accusa risuonò con forza tra molti intellettuali, poiché questa separazione era estranea a figure come Dante, Galileo, Empedocle, Leonardo, Cartesio, Goethe, Einstein, gli anonimi architetti delle cattedrali gotiche e Michelangelo. Ancora oggi, questa divisione è sconosciuta ad artigiani esperti e fisici che affrontano i misteri dell'ignoto (cfr. Greco 2013).

Per mostrare concretamente l’utilità di questa sinergia, farò tre esempi.

SINERGIE TRA ARTE E MEDICINA

Non è sempre facile stabilire quando alcune malattie sono sorte per la prima volta. A tal fine i romanzi ci ha fornito informazioni importanti relativamente alla peste, il colera, il vaiolo etc. che si sono manifestati nel corso dei secoli. La pittura è un’altra fonte inesauribile. Infatti, nei personaggi ritratti nei quadri si possono ritrovare i segni di una malattia: la sindrome di Mondor nella Betsabea di Rembrandt (1654); l’esadattilismo nell’Uomo vitruviano di Leonardo (1490), nella Madonna di Casa Santi (1498) e nella Madonna Sistina (1513-14) di Raffaello; la neurofibromatosi di tipo I ne La Camera degli Sposi di Mantegna (1465-1474); l’ipertricosi nel Petrus Gonsalvus di un anonimo pittore tedesco (1580 circa); il tumore al seno nella scultura La notte di Michelangelo (1534). E così via per molte altre malattie come la tubercolosi, l’herpes zoster, la depigmentazione cutanea, il rinofima, l’artrite etc.

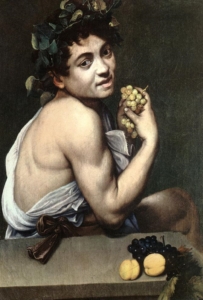

Un caso esemplare è il Bacchino malato di Caravaggio (1593), affetto dal morbo di Addison, dal nome del medico britannico che per primo lo descrisse. Ma solo nel 1855, ben 250 anni più tardi!

Bacchino malato, Caravaggio (1593)

Bacchino malato, Caravaggio (1593)

Come ha scritto il chirurgo vascolare italiano Paolo Zamboni, nelle pagine del Journal of Thrombosis and Haemostasis (28 April 2020), il modello è pallido, con riflessi scuri in alcune aree della cute; forse ha anche dolori addominali, come fa pensare la posizione curva in avanti; si sta cibando di uva come se avesse bisogno di zuccheri a causa di una possibile ipoglicemia. Inoltre, l’angolo interno dell’occhio, poco irrorato, depone per un’anemia. Il pollice scuro e l’unghia nerastra e opaca (anziché entrambi rosei) rivelano una acantosi nigricans (una condizione in cui la pelle si presenta iperpigmentata, ispessita, vellutata e di colore più scuro rispetto alle zone circostanti).

LETTERATURA E TECNOLOGIA: QUANDO FANTASIA E SCIENZA SI FONDONO

Jules Verne (1828-1905) è considerato, uno dei padri nobili della fantascienza moderna o, come veniva definita all’epoca, “narrativa d’anticipazione”. Guidato da una forte passione per la tecnologia, con i suoi racconti ambientati nell’aria, nello spazio, nel sottosuolo e nel fondo dei mari ha ispirato molti scienziati delle epoche successive.

Nel romanzo Dalla Terra alla Luna (1865), Verne descrive un viaggio a bordo di un proiettile sparato da un gigantesco cannone e uno sbarco sulla Luna. All’epoca questa idea fu contestata da molti scienziati ma, dopo tutto, si trattava di un romanzo d’avventura e di fantascienza. Un po' più tardi fu pubblicato Intorno alla Luna (1869); questo romanzo va oltre il viaggio e segue le avventure degli eroi sulla Luna.

In Ventimila leghe sotto i mari (1869-1870), Verne immagina un grande sottomarino elettrico, il Nautilus. E il Nautilus non vi ricorda forse il DSV Alvin varato nel 1964? Il Nautilus, come il DSV Alvin, era una propulsione esclusivamente elettrica. Infatti, Verne rifiutò il carbone come combustibile, proponendo invece batterie elettriche (di una composizione chimica sconosciuta) per azionare il congegno. Ciò rende Verne un precursore dei carburanti alternativi. Nello stesso libro scrive di una pistola che dà una forte scossa elettrica, molto simile all'attuale taser.

Gli studi per creare macchine volanti risalgono agli schizzi di Leonardo da Vinci, ma fu verso la fine dell'Ottocento che l'elicottero, come lo conosciamo, cominciò a prendere forma. Nello stesso periodo, Jules Verne pubblicò Robur il conquistatore (1886), un romanzo in cui il personaggio principale costruiva un velivolo di truciolato (quindi aveva grande resistenza e leggerezza allo stesso tempo) che volava tramite rotori, proprio come fanno gli elicotteri moderni. Rotori aggiuntivi a prua e a poppa servivano a spingere il velivolo verso il cielo. Verne prese i prototipi di elicottero esistenti e immaginato come si sarebbero sviluppati.

In un breve racconto scritto nel 1889, La giornata di un giornalista americano nel 2889, Verne descrive un'alternativa ai giornali: “ogni mattina, invece di essere stampato come nell'antichità, l'Earth Herald viene 'parlato'. È attraverso una vivace conversazione con un giornalista, un personaggio politico o uno scienziato che gli abbonati possono apprendere tutto ciò che capita di interessarli”. Ci vollero molto meno dei mille anni previsti da Verne per avere i primi giornali radio (negli anni Venti) e poi i primi telegiornali (negli anni Quaranta).

Jules Verne era ben lungi dall’essere uno scienziato, ma le sue opere e i progressi che si stavano realizzando all’epoca servirono a introdurre molte delle invenzioni che sarebbero arrivate successivamente e che, nel tempo, sono finite per diventare elementi ordinari della nostra vita quotidiana. Si può quindi sostenere che la letteratura ha fornito la vision alla scienza e tecnologia.

ARTE, SCIENZA E AMBIENTE

La nefologia è una branca della meteorologia che studia le nuvole (dal greco nephos che significa appunto nube, nuvola). Gli cloudspotters (osservatori di nuvole) classificano accuratamente le nuvole una a una, dando loro un’identità (con tanto di descrizione) e seguendo uno schema simile a quello degli organismi viventi, basato su aspetto e altitudine. Si contano 10 gruppi principali o generi (stratus, cumulus, stracumulus, nimbostratus, cumulonimbus, altocumulus, altostratus, cirrostratus, cirrocumulus e cirrus), che a loro volta si suddividono in specie e varietà.

Moltissimi pittori come John Constable, Joseph Mallord, Caspar David Friedrich, Gustave Courbet si sono cimentati all'interno delle loro opere nella raffigurazione delle nuvole. Il primo fra tutti fu Andrea Mantegna.

Il greco Christos Zerefos, specialista in scienze atmosferiche, sostiene che attraverso l'analisi dei colori (soprattutto le quantità di rosso e di verde) dei cieli delle pitture dei paesaggisti si può calcolare lo spessore ottico dell'atmosfera, cioè la quantità di aerosol presente nell'atmosfera al momento in cui la tela è stata dipinta. Conoscere la qualità dell'aria prima della rivoluzione industriale permette di comprendere l'impatto delle attività umane sull'inquinamento. Zeferos si è concentrato, in particolare, sul pittore e incisore inglese William Turner. I pigmenti rossi e verdi che hanno colorato i cieli dei suoi dipinti sono la prima testimonianza dei livelli di inquinamento dell'aria di un paio di secoli fa. All'epoca si sapeva poco e niente circa l'inquinamento e, anzi, nessuno scienziato fino al 1829 si preoccupò di tracciare le polveri nocive che fluttuavano nel cielo. Ai tempi di Turner le fabbriche (con i loro fumi) si moltiplicavano, le locomotive a vapore si diffondevano velocemente, i vulcani continuavano ad esplodere ― come nel caso dell'indonesiano Tambora, che nel 1815 scagliò 36 miglia cubiche di roccia frantumata nell'atmosfera ed ebbe ripercussioni sull'intero pianeta poiché le ceneri fecero più volte il giro della terra trasformando l’anno successivo (il 1816) “nell'anno senza estate”. I ricercatori hanno infatti osservato che i cieli dipinti negli anni successivi alle eruzioni vulcaniche contenevano una maggiore dose di rosso. Dura doverlo ammettere, ma, spesso, i tramonti dai colori bellissimi quanto curiosi che vediamo nei dipinti di Turner - un po' rossi, un po' arancioni - sono il frutto dell’inquinamento…

RIFERIMENTI BIBLIOGRAFICI

Feyerabend, Paul K. e Christian Thomas (1989), Arte e scienza, Roma: Armando.

Greco Pietro (2013) (a cura di) Armonicamente. Arte e scienza a confronto, Milano: Mimesis

Odifreddi, Piergiorgio (2023), Arte e matematica, due visioni complementari per descrivere la realtà, in “Le Scienze”, 18 agosto,

Snow, Charles P. (1959), trad. it. Le due culture, Milano: Feltrinelli, 2017.

Le mani sulla montagna - “Consumismo sciistico” o sviluppo sostenibile?

Questo articolo è pubblicato in contemporanea

dal Gruppo di divulgazione e discussione online

“Ideeinformazione”

Nelle aree alpine – si è notato più volte in questi anni – il fenomeno del cambiamento climatico si sta facendo sentire con particolare acutezza. Ma a farsi sentire sembra anche una scarsa volontà di cambiare stili di vita e atteggiamenti culturali, in particolare l’idea di sviluppo del territorio. Come del resto nelle grandi pianure. Fortunatamente, però, crescenti sono anche le reazioni delle popolazioni locali, sempre più consapevoli della necessità di “cambiare rotta” dal punto di vista economico-sociale, orientandosi verso un modello di sviluppo meno consumistico e “quantitativo”. Qualcosa che può insegnare molto (e – perché no – dare anche un po’ di speranza) a chi nelle aree montane non vive.

Nelle prealpi lombarde ci sono ameno due casi di scuola, che illustrano bene questa situazione.

IL COMPRENSORIO SCIISTICO VILMINORE-LIZZOLA (BG)

Vilminore e Lizzola sono due comprensori sciistici nella Bergamasca: il primo in valle di Scalve, sopra il comune di Vilmonore, e il secondo nella parallela Val Seriana, sopra Valbondione (di cui Lizzola è frazione). In mezzo c’è il Pizzo di Petto (mt.2.227) che può essere valicato a piedi attraverso il Passo di Manina. Ebbene, da qualche tempo sta prendendo forma un progetto per la “valorizzazione” turistica e sciistica dell’area attraverso la realizzazione di un tunnel che colleghi i due comprensori. Bucando evidentemente la montagna. Grazie a questa grande opera sciistica (potremmo forse coniare al proposito un nuovo acronimo: GOS), dunque lo sciatore potrebbe godere senza scendere dagli sci né perdere quota delle due aree di divertimento. Peccato che su questi tracciati, in gran parte tra i 1.800 e i 2.200 mt., cade sempre meno neve negli ultimi anni, anche durante le stagioni buone, e per periodi sempre più brevi…

Il progetto, il cui costo previsto è di 70 milioni di euro di cui 50 pubblici, sta muovendo solo i primi passi; sono comunque previsti, oltre agli estremamente invasivi lavori di perforazione per il tunnel di collegamento, sbancamenti, vasche di accumulo dell’acqua per l’innevamento artificiale, infrastrutture viarie, la dismissione delle funivie esistenti per sostituirle con una nuova.

Quello che però va qui segnalato è che appena la notizia ha fatto il giro dei paesi della valle la popolazione è insorta decisamente contro l’insensatezza di questo ipotetico mega-progetto, e così sul finire del 2024 la petizione lanciata dal locale collettivo Terre Alt(r)e[1] ha raggiunto rapidamente le 25.000 firme (!), mentre il 3 gennaio di quest’anno una prima assemblea pubblica, a Vilminore, ha raccolto oltre trecento persone che per quattro ore hanno seguito attentissime e preoccupate i relatori convocati da una rete di associazioni, tra e quali il CAI locale.[2]

I NUOVI IMPIANTI SUL MONTE SAN PRIMO (CO)

Il progetto denominato “Oltre Lario” è, se possibile, ancora più folle. Qui parliamo del monte San Primo, il rilievo più elevato del cosiddetto “Triangolo lariano”, ovvero di quel “triangolo” avente come vertici ideali Como, Lecco e Bellagio. Il massiccio montuoso supera di poco i 1.600 mt. e non ci ha mai nevicato troppo (oltretutto si tenga presente che quella zona risente dell’effetto mitigazione esercitato dal lago). In passato, comunque vi erano state costruite delle piste da sci con relativi impianti, da molto tempo abbandonati, secondo il destino comune a gran parte degli impianti a media altezza delle aree prealpine[3] (in verità non solo per ragioni climatiche, ma anche per cambiamenti degli stili di vita e delle pratiche turistiche).

Dal 2022, dunque, un progetto finanziato da Ministero dell’Interno, Regione Lombardia e Comunità montana del Triangolo lariano, e fortemente sostenuto dal Comune di Bellagio, prevede tra le altre cose la costruzione di un nuovo impianto sciistico sul Monte San Primo con ovviamente creazione di piste, cannoni sparaneve e un laghetto di accumulo per l’innevamento artificiale, tapis-roulants e una serie di parcheggi. Da subito una grande mobilitazione ha attraversato i paesi dell’area, dando vita al Coordinamento “Salviamo il Monte San Primo” (che riunisce decine di associazioni locali)[4] e che ha per ora ottenuto, se non altro, un “ripensamento” del progetto. Che però – denunciano di recente i sostenitori del coordinamento – non è cambiato in modo significativo e continua a impegnare oltre due milioni di euro dei cinque previsti per le opere legate, appunto, a questi nuovi, surreali, impianti sciistici.

Le associazioni temono che un simile progetto trasformi «la montagna lariana in un dispendioso luna-park, sperperando ingenti soldi pubblici per depauperare un territorio di grande pregio naturale e culturale». Tra le maggiori preoccupazioni, oltre al danno per un’area che è di grandissimo pregio naturalistico e inevitabilmente vocata a un turismo “dolce” (è il caso del percorso escursionistico noto come “Dorsale del Triangolo lariano” da Como a Bellagio), quella relativa agli impianti per il prelievo di acqua funzionali alla produzione della neve artificiale (la zona presenta carsismi e difficoltà nel prelievo di acqua per gli usi civili nelle lunghe estati siccitose di questi ultimi anni – ci manca questo prelievo extra del tutto insensato!).

Passando da vicende di portata locale a questioni più ampie, è evidente che queste tendenze si trovano nella concezione che sta alla base della progettazione delle future Olimpiadi invernali Milano-Cortina 2026, i cui lavori nei prossimi mesi conosceranno una forte accelerazione (il 6 febbraio scorso è stato infatti il “One year to Go”, la cerimonia ufficiale a un anno dall’inizio dei giochi). Anche in questo caso, dietro qualche rapida frase di facciata “green” (il sindaco di Milano Sala ha assicurato che i Giochi saranno molto «sostenibili» e che alla fine come ai tempi di Expo 2015 «saranno tutti contenti»[5] – ma tutti chi?), c’è una micidiale operazione di opere «essenziali» sparse a pioggia tra Lombardia e Veneto, che non faranno che lasciare i territori più sfigurati e cementificati. O meglio, i segni si vedono già.[6]

RIPENSARE LO SVILUPPO E I TERRITORI. A PARTIRE DALLE AREE MONTANE

Le due vicende che abbiamo richiamato – ma molte altre si potrebbero rintracciare – ci mostrano in definitiva come forti siano le tenenze conservative nel modo di pensare l’impresa, lo sviluppo e il turismo (è difficile uscire dal mito della crescita illimitata), ma come anche in questi ultimi decenni tante popolazioni, imprese, amministrazioni locali, intellettualità diffusa abbiano maturato una visione nuova, capace di pensare strade inedite e inaspettate per coniugare vita moderna e tutela dell’ambiente.

Le vicende e i luoghi che abbiamo visto parlano, tra l’altro, di quelle aree che sono state definite «montagne di mezzo», cioè quella media montagna che non presenta i caratteri della “eccellenza turistica” per come è comunemente intesa. È una «dimensione intermedia» – ha osservato in un libro intelligente il geografo Mauro Varotto – tra le montagne per antonomasia, specializzate «in direzione della modernizzazione turistico-industriale» e della «compensazione naturalistica»,[7] e le aree urbane industrializzate (anzi, “post-industrializzate”, se mi consente lo scherzo terminologico), caotiche affollate e inquinate. Aree dunque destinate, in questo modello di (mal)sviluppo ad abbandono e “regressione”, a invecchiamento e spopolamento. Contro questo “destino”, che in realtà è solo l’effetto di un ben preciso orientamento dello sviluppo territoriale basato sugli imperativi del profitto, è necessario ripensare ai modelli di telefrequentazione di una montagna panoramica a disposizione del tempo libero della popolazione urbana: serve una rivoluzione copernicana che non intenda più la montagna al servizio del turista o escursionista, ma l’escursionista e il turista al servizio della montagna.[8]

Vi è oggi in Italia, per fortuna, un vasto movimento, di pensiero, di opinione, ma anche di “pratiche di vita”) che si oppone fermamente a queste visioni incentrate su un mito della crescita economica che, applicato alle aree montane, appare perfino ridicolo. Un movimento che, peraltro, non può essere derubricato a “politica del no”, ma che al contrario intende dare un “altro futuro”, di economia alternativa, al mondo delle montagne che peraltro rappresenta oltre un terzo del territorio italiano. Tra i punti alti di questa riflessione troviamo, infatti, il Manifesto di Camaldoli, un documento elaborato al termine di un convegno nazionale svoltosi appunto a Camaldoli nel 2019,[9] dove si legge tra l’altro: L’idea che la montana lasciata alle forze della natura ritrovi da sola un equilibrio stabile – la cosiddetta ri-naturazione – è del tutto infondata. Come tutti i manufatti la montagna richiede manutenzione. In netto contrasto con i comportamenti odierni di tipo distruttivo e predatorio va riscoperta la tradizionale cultura del limite, che dovrà anche presiedere all’uso produttivo della terra, ai consumi di suolo e agli altri usi del territorio. (…)

Occorre dunque lavorare a uno scenario alternativo a quello della città che invade la montagna, della proliferazione delle seconde case, delle piste da sci sempre più dipendenti dall’innevamento artificiale e dal prelievo idrico. Nuovi modelli di vita, di socialità e di compresenza culturale richiedono un’alleanza fra anziani restanti, depositari di saperi contestuali, e “nuovi montanari” innovativi. Vi concorrono iniziative e nuovi strumenti come cooperative di comunità, ecomusei che attivano coscienza di luogo, osservatori del paesaggio, comunità del cibo, feste paesane “sagge”, forme attive e inclusive di valorizzazione delle minoranze linguistiche e di integrazione dei migranti.[10]

Un pensiero altro sulla e della montagna, da cui ci sarebbe molto da imparare. Anche qui in pianura.

NOTE

[1] https://terrealtre.noblogs.org/

[2] Si veda la puntuale cronaca di Radio Onda d’Urto: https://www.radiondadurto.org/2025/01/27/nuovo-comprensorio-sciistico-colere-lizzola-prosegue-la-raccolta-di-firme-contraria-e-in-preparazione-nuove-iniziative/. E qui il video dell’incontro del 3 gennaio a Vilminore, intitolato “Comprensorio sciistico Colere-Lizzola. Patrimonio di tutti o parco divertimenti per pochi?”: https://terrealtre.noblogs.org/post/2025/01/10/video-dellincontro-pubblico-comprensorio-sciistico-colere-lizzola-patrimonio-di-tutti-o-parco-divertimenti-per-pochi-organizzato-a-vilminore-il-03-01-2025/

[3] Nell’Appennino le cose vanno anche peggio, per ovvie ragioni climatiche: dei cento impianti esistenti la metà sono chiusi. E nonostante questo – ha osservato Giuliano Bonomi, naturalista dell’Università di Napoli che ha condotto su questa realtà un’ampia ricerca – «negli ultimi anni stiamo assistendo a un paradosso: sono proliferati i progetti volti a costruire nuovi impianti di risalita in tutto l’Appennino, grazie anche a finanziamenti in parte o totalmente pubblici» (cfr. Alessandro Pirovano, La montagna che non si arrende a “grandi eventi” e impianti sciistici senza futuro, “Altreconomia”, 5 febbraio 2025, https://altreconomia.it/la-montagna-che-non-si-arrende-a-grandi-eventi-e-impianti-sciistici-senza-futuro/).

[4] https://bellagiosanprimo.com/

[5] https://stream24.ilsole24ore.com/video/economia/milano-cortinasala-fascino-cinque-cerchi-dara-grande-visibilita/AGQg6qkC

[6] Per una presentazione d’insieme degli scempi che porteranno con sé le Olimpiadi invernali 2026, si veda Luigi Casanova, Ombre sulla neve. Milano-Cortina 2026. Il “libro banco” delle Olimpiadi invernali, Milano, Altreconomia, 2022. Qui il video della presentazione del libro alla Casa della Cultura di Milano, il 15 dicembre 2022: https://www.youtube.com/watch?v=RoMk-HK9s9c&t=10s. E per un aggiornamento, l’articolo di Duccio Facchini, “L’impronta olimpica”: le opere di Milano Cortina 2026 dall’alto,“Altreconomia”, n. 278 / febbraio 2025, p. 21-25, che documenta, foto satellitari alla mano, gli effetti tutt’altro che “sostenibili” sui territori interessati dalle opere olimpiche.

[7] Mauro Varotto, Montagne di mezzo. Una nuova geografia, Torino, Einaudi, 2020, p. 165.

[8] Ivi, p. 167-68.

[9] Il manifesto è stato approvato al termine del convegno nazionale “La nuova centralità della montagna” (Camaldoli, 8-9 novembre 2019), e si trova in Luigi Casanova, Avere cura della montagna. L’Italia si salva dalla cima, Milano, Altreconomia, 2020, p. 29-36.

[10] Ivi, p. 32-33.

Biochar, il carbone amico

Quando pensiamo al carbone, andiamo subito col pensiero all’inquinamento, a colonne di fumo nero e denso e alle città coperte di fuliggine di non tanti decenni orsono. E, nonostante i progressi tecnologici che hanno reso progressivamente meno inquinanti i sistemi di combustione del carbone, questa visione è ancora attuale, perché il carbone è ancora largamente usato in tutto il mondo nelle centrali per la produzione di energia elettrica (circa il 30% dell’energia elettrica mondiale è prodotta da centrali a carbone, fonte IEA - International Energy Agency).

Ma in questo articolo parliamo di un altro tipo di carbone che - al contrario - ha delle proprietà che lo pongono agli antipodi del carbone fossile e dei suoi utilizzi: questo prodotto si chiama biochar e la sua scoperta è relativamente recente, i primi studi scientifici si devono al professor Johannes Lehmann della Cornell University negli anni 80.

Il biochar è il residuo carbonioso ottenuto dalla combustione in assenza di ossigeno di biomassa (materia organica). Qualsiasi tipo di biomassa di origine vegetale o animale, sottoposta al processo di combustione in assenza di ossigeno – pirolisi – produce biochar. Evidentemente la materia di partenza (feedstock), influisce sulle caratteristiche chimiche del prodotto finale.

Proviamo, qui, a dare una breve panoramica globale delle qualità di questo composto e a focalizzare un aspetto di particolare interesse, ovvero la sua capacità di stoccare CO2, diventando, quindi, anche un elemento per contrastare l’immissione di gas a effetto serra in atmosfera.

COME SI FA IL BIOCHAR

Il carbone vegetale si fa dalla notte dei tempi; in tutta l’Europa mediterranea c’erano le carbonaie dove si bruciavano residui legnosi per produrre carbone, il biochar è l’evoluzione scientifica di questo sapere antico.

Oggi esistono sofisticate apparecchiature che per produrre il biochar attivano un processo di combustione lenta a temperature di circa 500-600 gradi Celsius in assenza di ossigeno.

A partire dal feedstock introdotto, si realizzano essenzialmente tre prodotti:

- il biochar, ovvero la frazione solida del processo di pirolisi

- il syngas, i residui gassosi del processo

- il bio-olio, residuo liquido del processo

In realtà la questione è più complessa e se il processo di combustione prevede la presenza di limitate quantità di ossigeno, parliamo di “gassificazione” e l’output del processo è diverso.

Tuttavia, concentrandoci sul solo biochar, esso viene prodotto essenzialmente a partire da biomassa vegetale, residui legnosi di qualsiasi origine.

Si comprende facilmente che questo tipo di processo permette l’utilizzo e la valorizzazione circolare di materiale che altrimenti andrebbe disperso o bruciato senza alcun vantaggio. Parliamo dei residui di potature, sfalci, rami degli alberi che diventano tronchi puliti destinati alle segherie per usi industriali.

E su questo punto va aperta una parentesi: i boschi vanno gestiti e i piani di tagli programmati non solo non arrecano alcun danno ma, al contrario, fanno bene alla salute dei boschi.

Il problema è il disboscamento selvaggio e illegale (che non esiste in Europa), non certo la gestione forestale sostenibile che prevede dei tagli programmati mirati a rinforzare lo stato di salute del bosco o della foresta.

Nel processo di pirolisi, fatto cento in quantità il feedstock, la resa è del 25 – 30% circa, ovvero si ottiene, dalla combustione della massa vegetale, il 30% di biochar.

Ne risulta un prodotto simile alla carbonella che si usa per i barbecue, ma più fine, le cui caratteristiche principali sono la porosità, la capacità di trattenere l’acqua, il potere alcalinizzante dei terreni.

APPLICAZIONI IN AGRICOLTURA

Il biochar può essere utilizzato in agricoltura, come filtro nella depurazione di acque inquinate, nell’edilizia come materiale per l’isolamento, nella produzione di biocarburanti.

Ma il suo utilizzo attualmente più diffuso e importante è quello agricolo.

Distribuito sui terreni è un potente ammendante[1], quindi migliora la qualità chimiche, fisiche e biologiche dei terreni, rendendoli molto più produttivi e contrastando gli effetti della siccità perché trattiene l’acqua nei terreni.

Immesso nel terreno, il biochar aumenta il ph, quindi rende la terra più alcalina, aumenta la disponibilità di acqua, migliora le condizioni di sviluppo delle radici, migliora l’apporto e l’assorbimento di nutrienti per le piante, aumenta la resistenza alle malattie e ai fattori di stress ambientale.

In pratica, è una specie di potentissimo ricostituente dei terreni.

In funzione del tipo di terreno di cui si vogliono migliorare le caratteristiche chimico – fisiche, si potranno produrre diversi tipi di biochar (variando la composizione del feedstock e le condizioni di pirolisi) che daranno risposte mirate per obiettivi specifici. Risultati eccellenti si stanno raggiungendo con i terreni aridi, sabbiosi, sovrasfruttati.

BIOCHAR E ATMOSFERA

Ma c’è un’altra caratteristica di grande interesse di questo prodotto, esso è efficace per il sequestro di CO2 dall’atmosfera.

Infatti, al termine del processo di produzione, la CO2 presente nel materiale vegetale viene mineralizzata e quindi “intrappolata” nel biochar. Circa il 90% di questa CO2 resta inglobato nella struttura molecolare del prodotto che rimane stabile per centinaia di anni.

È bene precisare che è giusto parlare di sequestro e non di stoccaggio della CO2 in quanto si tratta di carbonio di origine vegetale fotosintetizzato a partire da CO2 atmosferica.

In questo modo il biochar diventa anche uno strumento di lotta all’effetto serra, e infatti la sua produzione permette anche di emettere crediti di carbonio (al termine di un processo di certificazione) da vendere sul mercato volontario (quindi non per le aziende obbligate a compensare le proprie emissioni).

Che i boschi bruciati rinascano velocemente e con grande forza è un fenomeno conosciuto da sempre; una delle ragioni che determinano questa situazione è la modifica delle caratteristiche del suolo dovuta alle ceneri. È esattamente ciò che fa il biochar.

A volte la scienza va avanti guardando al passato.

PER APPROFONDIRE

Ichar, Associazione Italiana Biochar

International Biochar Initiative

Unibo, Biochar, presente e futuro

NOTE

[1] La differenza tra una sostanza ammendante e un fertilizzante è che la prima interviene sulla struttura del suolo e apporta migliorie stabili nel tempo, i fertilizzanti sono solo l’immissione nel terreno di sostanze nutritive che vengono utilizzate e consumate dalle piante.

L’arte di fare attenzione nel tempo delle catastrofi - Il pensiero di Isabelle Stengers

Nel suo libro Nel tempo delle catastrofi (2021, Rosemberg & Sellier), Isabelle Stengers, una delle più importanti filosofe della scienza contemporanee, propone in maniera divulgativa una serie di riflessioni che tentano di delineare una connessione tra il pensiero ecologista e quello femminista. Ciò che emerge dalla lettura, è che entrambi gli approcci non sono solo intimamente connessi, fino a rappresentare due facce della stessa medaglia, riguardo ai problemi che sollevano e agli scopi che si prefiggono, ma nella loro più profonda essenza sono accomunati perché esprimono anche una radicale rivalutazione – e archiviazione – della narrazione del progresso, nella sua duplice veste di obbiettivo delle scienze (incluse quelle sociali, e sì, anche delle humanities) e indiscusso fine economico.

Più precisamente quindi, è attraverso la mobilitazione di diverse prospettive – epistemologica, di genere e di ecologia politica – e mostrando esplicitamente l’impossibilità di scindere l’una dalle altre, che l’autrice elabora la propria proposta per riformare le scienze secondo una concezione del sapere fortemente democratica e anticlassista. Questo allo scopo precipuo di «imparare l’arte di fare attenzione», come lei dice, nel nuovo regime climatico in cui Gaia ha fatto irruzione, costringendoci a pensare e a convivere con le minacce ecologiche che mettono in crisi il nostro modello di civiltà[1].

Stengers, infatti, argomenta che per potersi dire davvero «obiettori della crescita», occorre mettere in discussione proprio «quali idee usiamo per pensare altre idee», come direbbe l’antropologa Marilyn Strathern, perché queste inficiano la possibilità di affermare una forma di organizzazione sociale veramente plurale e sostenibile, oltre che un controllo orizzontale e diffuso del sapere e della tecnica.

Per farlo quindi, la storica della scienza esamina la genealogia del pensiero moderno, a partire dalla scoperta dei «fatti sperimentali», come delle entità che acquisiscono la capacità di prefigurare il modo in cui essi stessi devono essere interpretati. Acquisendo dunque una certa autonomia nel far pensare e dirigere gli esseri umani che li hanno fabbricati. Un’autonomia che però, come illustra appunto l’autrice, è andata sempre più trasformandosi in indipendenza:

«Tuttavia, chi ha scoperto che una simile riuscita era possibile, Galileo, si è affrettato a generalizzarla, vale a dire a trasformare la riuscita (riuscire a produrre un tipo di fatto che “provi”) in metodo (inchinarsi davanti ai fatti). Gli diventava così possibile contrapporre la nuova ragione scientifica, che riconosce autorità ai soli fatti, all’attitudine di chiunque prenda posizione riguardo questioni indecidibili, che conferiscono potere alle sue convinzioni o ai suoi pregiudizi. Questa messa in scena è senza dubbio una delle operazioni di propaganda meglio riuscite nella storia umana, se è vero che essa è stata ripresa e ratificata anche da parte dei filosofi – sebbene essi stessi ne risultassero spogliati della loro pretesa all’autorità. Certi vanno ancora oggi ripetendo il giudizio lapidario di Gaston Bachelard: ‘In linea di principio, l’opinione ha sempre torto. L’opinione pensa male; anzi, non pensa; traduce dei bisogni in conoscenze’. Che questo giudizio sia stato emesso in un libro intitolato La formazione dello spirito scientifico è una circostanza capace di testimoniare di una logica profonda. Un tale “spirito scientifico” è definibile solo in contrapposizione a qualcosa che sarebbe “non scientifico” – e ciò vale anche quando qualcuno si crede intelligente a invertire specularmente il significato di questa opposizione, attribuendo alla “gente” una ricchezza soggettiva o emozionale di cui sarebbe invece privo lo spirito scientifico, freddo, calcolatore e razionale» (Cit. p. 88).

Si sviluppa così una prima contrapposizione fra i gruppi di esperti (conoscitori di prima mano dei fatti naturali) e i profani, cioè tutti gli altri che vivrebbero nell’ignoranza rispetto a questi fatti, o peggio ancora nel disorientamento in base a bias culturali da correggere – che quindi corrisponde a una distinzione di ceto, stabilito in base alla scolarizzazione e professionalizzazione del sapere. A questa antitesi si aggiunge la naturalizzazione di questi fatti, che porta anche a oscurare le domande (cioè l’opportunità o meno di una scoperta o un’invenzione, in base al gruppo che la richiede e le sue esigenze), gli strumenti, il lavoro, le numerose prove ed errori, e il finanziamento che li hanno generati e le conseguenze che ne derivano. E si perviene quindi alla etero-direzione della società da parte di «fatti che parlano da soli», capaci di imporre valori e fini alla collettività senza che la formazione del loro determinismo possa essere messa in discussione.

L’invenzione della natura e dei fatti come entità esterne alla società e al regno della cultura, o più precisamente dell’oggettività, in quanto referenza indipendente dalla sua opinabile realizzazione a partire da soggetti incarnati che la generano, si propone come termine ultimo e insindacabile per la risoluzione di tutte le controversie, scientifiche, economiche e politiche; da essa discende la predisposizione di acritiche “parole d’ordine” che favoriscono e allo stesso tempo deresponsabilizzano coloro che le pronunciano.

Dal determinismo scientifico e tecnologico a quello economico il passo è breve; dove la realizzazione del valore di un bene e la sua commercializzazione è conseguentemente effettuata prescindendo – o circoscrivendo – da tutta la sfera di elementi possibili che contribuiscono a realizzarlo. Come l’estrazione e trasformazione di “risorse” non-umane da un lato, ma anche e soprattutto dal lavoro negletto di cura e riproduzione della vita necessaria alla creazione dei beni, che è stato storicamente svolto dalle donne.

Prendiamo ad esempio la diffusione dell’etichetta «l’era dell’Intelligenza Artificiale», che sentiamo ripetere costantemente come un mantra da entusiasti tecnofili, per forzarci ad accettare come un fatto compiuto un programma simil-totalitario di politiche sociali e culturali, basato sul preteso successo di un prodotto che in realtà è ancora indefinito e limitato proprio perché basato su un software chiuso, quale appannaggio esclusivo delle poche imprese che lo sviluppano: si tratta di un piano che parte dal bisogno di giustificare la gestione accentrata delle enormi quantità di dati che queste raccolgono, mentre rimane sottaciuto l’importante impatto ecologico dei loro servizi e prodotti[2]. Tuttavia, il successo del software è notevolmente ridimensionato – e ridicolizzato – non solo perché non rappresenta un fatto compiuto dalle vesti immateriali, ma anche da quanto riportato da Oxfam, cioè che il lavoro di cura non retribuito svolto dalle donne di tutto il mondo, varrebbe almeno tre volte il valore dell’industria delle stesse big tech, così da aver provocatoriamente nominato il suo rapporto “l’era della cura”[3].

In questo senso, si vede come la natura come entità disponibile e appropriabile – perché considerata esterna ai condizionamenti della società, che infatti dovrebbe semplicemente limitarsi ad “allocare al meglio le risorse scarse” – si rifletta nell’oggettivazione della donna come “risorsa” gratuita, remissiva e liberamente sfruttabile. Così, la figura dello scienziato ricalca quella del capitalista nella loro estrazione di ricchezza che rimane irresponsabile nei confronti delle loro sorgenti di valore. Ovvero, gli attaccamenti ecologici generativi necessari per la vita.

La scienza maschile si basa così su una soggettività virtuale del ricercatore che, quasi non avesse avuto bisogno di nascere ed essere nutrito, esprime uno «sguardo da nessun luogo» su un universo concepito come res extensa da conquistare progressivamente e da cui estrarre profitto[4]. In maniera profondamente differente, i saperi situati femminili non hanno invece direzione prestabilita, ma sentono il bisogno di radicarsi nel rizoma dei legami terrestri da cui dipendono, e di favorire la loro prosperità.

In effetti, al contrario dei quei barbari che tentano di lasciare il pianeta, per andare a conquistarne altri, o degli altri che con atteggiamento disfattista si sentono inermi rispetto all’apocalisse, questi tipi di conoscenze tentano precisamente di «avere luogo» e di «riferirsi a qualcuno», coltivando l’arte di fare attenzione alle entità neglette che compartecipano alla nostra sfera di esistenza particolare e di cui ignoriamo l’importanza favorendo le condizioni per l’abitabilità. Basti pensare alle catastrofi ambientali che si fanno sempre più tragiche e impellenti, mostrando tutta la nostra incomprensione e incuranza delle connessioni ecologiche da cui dipendiamo che ne sono all’origine.

Riprendendo quindi per concludere un altro passaggio dell’autrice, che si tratti di saperi «altri» o non-umani, che definisce «pratici», a partire dal riferimento pragmatico a ciò che li rende tali, ovvero il lavoro attorno ad una causa che impegna a pensare e ad agire in comune,

«ciò che ho tentato di fare nel caso particolare della ricerca scientifica e della valutazione dei ricercatori, è di pensare a partire da ciò che manca, da ciò di cui la mancanza ci rende malati, così critici e lucidi quanto vogliamo, ma crucialmente incapaci di resistere a ciò che ci distrugge. Sapersi malati, è creare un senso del possibile – non sappiamo ciò che avrebbe potuto essere, ciò che potrà essere la strana avventura delle scienze moderne, ma sappiamo che «fare di più» di quello che abbiamo l’abitudine di fare non sarà sufficiente a permetterci di comprenderla. Si tratta di disimparare la rassegnazione più o meno cinica (realista) e di ridivenire sensibili a ciò che forse sappiamo, ma in modo anestetizzato. È qui che la parola lentezza, così come è utilizzata dai movimenti slow, risulta adeguata: la rapidità domanda e crea l’insensibilità a tutto ciò che potrebbe rallentare, alle frizioni, ai contrasti, alle esitazioni che fanno sentire che non siamo soli al mondo; rallentare è ridivenire capaci di apprendere, di fare conoscenza con, di riconoscere ciò che ci sostiene e ci fa prosperare, di pensare e di immaginare, e, nello stesso processo, di creare insieme ad altri dei rapporti che non siano di cattura; si tratta quindi di creare fra noi e insieme ad altri il tipo di rapporto che si conviene fra malati, che hanno bisogno gli uni degli altri al fine di riapprendere gli uni con gli altri, tramite gli altri, grazie agli altri, che domandano una vita degna di essere vissuta, dei saperi degni di essere coltivati» (Stengers I. (2013), Une autre science est possible! Manifeste pour un ralentissement des sciences, La Découverte, Paris, p. 82).

NOTE

[1] Cfr. La politica dopo l’emergere di Gaia, il migliore dei mondi possibili, Controversie, 12/03/2024

[2] Scrive così Francesco Cara su Altreconomia in un articolo del 28 maggio 2024: «esiste una percezione diffusa secondo la quale il digitale è virtuale e immateriale e quindi non produce impatti ambientali significativi in termini di sfruttamento delle risorse, inquinamento, emissioni climalteranti e rifiuti. Nel libro “Ecologia digitale” abbiamo mostrato come il digitale, inteso come sistema costituito da centri di calcolo, reti di trasmissione e dispositivi, sia in realtà altamente energivoro, emissivo e idrovoro; grande consumatore di metalli rari e allo stesso tempo grande produttore di rifiuti. Immersi nel mondo delle rappresentazioni digitali, si tende infatti a dimenticare che il livello simbolico del settore, dove qualunque testo, immagine, video, brano musicale viene tradotto in sequenze di stati binari: Off (0) e On (1), poggi su segnali elettrici che scorrono su circuiti elettronici. Per ricevere l’informazione, archiviarla, trattarla e trasmetterla, il sistema digitale necessita quindi di materiali con caratteristiche conduttive ed elettromagnetiche particolari, di microprocessori molto impattanti, e di una fornitura ininterrotta di elettricità. Inoltre, il flusso elettrico disperde calore che, nei centri di calcolo, viene gestito con l’ausilio di sistemi di raffreddamento che, a loro volta, richiedono materiali, lavorazioni, elettricità e acqua. E lo stesso discorso vale per le reti di trasmissione dati». Disponibile al link: https://altreconomia.it/lecologia-digitale-alla-prova-dellintelligenza-artificiale-generativa/

[3] Cfr. Oxfam (2020), Time to Care: Unpaid and underpaid care work and the global inequality crisis. Disponibile al link: https://oxfam.dk/documents/analyser/davos/rapport_time-to-care-inequality-200120-embargo-en.pdf

[4] Cfr. Clarke A., Haraway D. (2022), Making Kin. Fare parentele, non popolazioni, DeriveApprodi, Roma

Cicli glaciali e attività antropica. La concentrazione dei gas serra in atmosfera - Seconda parte

Nel precedente post[1] abbiamo mostrato che, anche se è stata dimostrata la correlazione tra l’aumento spontaneo della concentrazione di gas serra in atmosfera e il comportamento dei moti millenari del pianeta Terra, rimanevano comunque da comprendere alcune incongruenze riguardo a:

- la grande e anomala quantità di gas serra attualmente presente in atmosfera e

- la sua non riconducibilità alla sola attività dell’era industriale.

Quando si parla di emissioni di metano e di cambiamento climatico, il primo e spontaneo pensiero è di puntare il dito verso gli allevamenti di ruminanti. Complice di questo automatismo è la contingenza storica di crescente avversione nei confronti degli allevamenti intensivi per l'approvvigionamento alimentare.

Meno frequentato è, invece, un altro concorrente a questo genere di emissioni che, anche se meno celebre, è non meno importante. Anzi, è forse storicamente ben più influente nell’emissione di questo specifico gas serra: si tratta della coltivazione sommersa del riso[2].

Come promesso, riporterò qui, per brevissimi tratti, l’interessante teoria che William F. Ruddiman, paleoclimatologo della Virginia University, pubblicò nel 2001 assieme all’allora suo studente Jonathan S. Thomson, e che mette in relazione l'invenzione e la diffusione di questa tecnica di coltivazione con l’aumento anomalo di metano immesso registrato a partire da cinque millenni fa.

Mi soffermerò maggiormente sugli aspetti storici e logici che hanno permesso la validazione di questo studio[3].

L’IMPATTO ANTROPOGENICO IN GENERALE

Nei termini di adozione tecnologica, di qualità del processo produttivo e di quantità produttiva, è oggi un’evidenza apprezzabile e scientificamente dimostrata quella dell’impatto che le attività umane hanno sull’alterazione di un equilibrio climatico “naturale”. La schiera di convinti negazionisti è ormai ridotta ad una esigua cerchia che conta più che altro provocatori con altri fini o fenomeni da studio sociologico, che si autoescludono dalle discussioni serie su questo tema.

Tra la fine XIII e la metà del XIX secolo vi è stato un aumento progressivo dell’attività di disboscamento col fine di alimentare gli stabilimenti produttivi e le attività di tipo estrattivo, mentre oggi prosegue principalmente per ampliare la superficie coltivabile del pianeta.

La scoperta dei combustibili fossili avvenuta nel XIX secolo e il loro progressivo impiego in ambito industriale hanno portato all’aumento spropositato delle emissioni di anidride carbonica.

L’aumento delle emissioni di metano è, invece, per lo più imputabile: alla sua fuga accidentale durante l’estrazione e il trasporto delle risorse fossili; all’aumento della popolazione mondiale, combinato al miglioramento delle relative condizioni di vita[4], all’aumento della produzione di rifiuti e alla conseguente dell’estensione delle relative discariche a cielo aperto.

A questi fenomeni si aggiunge anche il necessario aumento delle aree agricole irrigate e di allevamento, che portano a legittimare quel “dito contro” a cui abbiamo inizialmente accennato, rivolto contro le emissioni fisiologiche dei ruminanti, ossia dalle deiezioni e dalla fermentazione enterica, ovvero dalla digestione del cibo.

Alla fine del XX secolo queste emissioni saranno tali da aver raggiunto livelli che equivalgono ai record paleoclimatici di molti milioni di anni fa, in particolari fasi dei processi di intensa formazione delle terre oggi emerse.

Abbiamo, dunque, un sospetto più che fondato: l’impatto antropogenico è la principale causa di questo aumento anomalo degli ultimi tre secoli.

Siamo ora pronti a tornare alla proposta di Ruddiman e Thomson.

LA NASCITA DELL’AGRICOLTURA E LA SCOPERTA DELL’IRRIGAZIONE SOMMERSA: L’ALTRA METÀ MANCANTE DELLE EMISSIONI DI METANO

Intrapresa la strada della ricerca sulla via del sospetto ruolo antropogenico precedente all’era industriale, i due iniziarono a valutare anche i dati archeologici provenienti proprio dall’epoca di quella prima anomalia: la naturale diminuzione di concentrazione di metano in atmosfera si arrestò e iniziò invece a risalire, contrariamente a quanto sarebbe dovuto accadere per migliaia di anni da allora fino alla prossima glaciazione.

Secondo Ruddiman e Thomson la più probabile spiegazione di questa inversione è da attribuirsi all’invenzione dell’irrigazione del riso, la cui domesticazione della pianta risalirebbe ad almeno 9000 anni fa in Cina, nel bacino dello Yangtze.

La tecnica della coltivazione sommersa, lo dimostrano i ritrovamenti archeologici, era già in uso nelle pianure Sud-Est Asiatiche 5000 anni fa[5], e si estese, 2000 anni dopo, fin nelle pianure dell’India del Nord e Centro-Orientale. Alla sua diffusione si aggiunse poi la progressiva evoluzione dell’ingegneria agricola con la creazione di sistemi di canali sempre più complessi, che portavano l’acqua dai punti più depressi delle pianure fino anche ai fianchi delle colline.

Per comprendere la portata del fenomeno studiato da Ruddiman e Thomson è, tuttavia, opportuno allontanare dalla mente la tecnica di coltivazione odierna di questa pianta erbacea, che ci porterebbe fuori strada

Diversamente dai rifiuti e dall’allevamento, la coltivazione del riso richiede per la propria produzione un’estensione non direttamente proporzionale al numero degli esseri umani che ne dipendono. Questo diviene evidente se pensiamo alla certa inefficienza della coltura del riso a partire dalle sue origini in termini di:

- varietà meno produttive che, a parità di raccolto, imponevano la necessità di inondare aree più estese del suolo;

- maggiore presenza di varietà di erbe infestanti e di biodiversità connesse all’ambiente palustre, ossia alla loro relativa decomposizione nelle stesse risaie.

Come abbiamo visto nello studio del meteorologo J. Kutzbach[6], in tutte le aree palustri, la decomposizione della materia organica in clima anaerobico è a carico dei microrganismi metanogeni, incluse in questa categoria ambientale vi sono le coltivazioni sommerse del riso.

Aree sommerse più estese, in termini pragmatici, significano una maggiore produzione di metano prodotta da questo genere di coltura.

Si può parlare di efficienza tangibile di questa tecnica agricola solo a partire dalla metà del XX secolo, con l’invenzione dei pesticidi e dei diserbanti, i quali non erano prima d’allora nel dominio d’azione tecnologica dell’agricoltore, e anche con l'evoluzione della selezione genetica delle varietà seminate. Efficienza anch’essa con i suoi costi notevoli in termini di impatto ambientale, ma che esulano dal tema che stiamo qui trattando.

Se pensiamo dunque all’insieme di elementi di estensione delle risaie collegata alla loro bassa efficienza, alla loro progressiva diffusione crescente, per millenni, sull’intero pianeta abitato e agli effetti spontanei dovuti all’habitat anaerobico palustre, comprendiamo meglio perché Ruddiman e Thomson avessero ben intuito che dietro alla spiegazione di questa anomalia e delle sue crescenti dimensioni ci fosse sempre una matrice antropogenica: l’invenzione dell’irrigazione agricola, soprattutto quella sommersa del riso.

NOTE

[1] “John Kutzbach e le correlazioni naturali tra i cicli glaciali e la concentrazione dei gas serra in atmosfera.” è il post in questione. Consigliamo al lettore anche la lettura di “Stiamo ritardando la prossima glaciazione? Si.” per aver una visione più chiara e solida del terreno d’indagine in cui si inserisce il presente post.

[2] Faccio presente al lettore che anche il metano (CH₄), per quanto sia un gas più dannoso, è anche meno “famoso” del suo concorrente l’anidride carbonica (CO2). In termini di inquinamento atmosferico il primo è infatti di 25-30 volte più dannoso della seconda.

[3] Il clima globale del Pianeta è un sistema altamente complesso, l’invito che faccio al lettore è di approfondire dunque gli aspetti specifici di questa teoria nel testo di riferimento principale utilizzato per presentargliela: “L’aratro, la peste, il petrolio - L’impatto umano sul clima” di William F. Ruddiman.

[4] Si tenga presente che secondo le stime attuali, l'aumento della popolazione è raddoppiata circa ogni 1000-1500 anni, da 5000 a questa parte. È solo con l'avvento della rivoluzione industriale che la crescita demografica prende ritmi mai visti. Si è stimato il raggiungimento di circa mezzo miliardo di esemplari della specie umana verso la fine 1500, mentre a inizio 1800 era 1 miliardo: oggi circa 8 miliardi in più rispetto a inizio 1500. La stima, su base archeologica, proiettata a 5000 anni fa ammonta a circa 40 milioni.

[5] Curiosità: nello Xinjiang di quasi 4000 anni fa, nell’attuale Cina, si estraeva e si faceva uso domestico del carbone fossile.

[6] Si veda la Nota #1.

FONTI

Willian F. Ruddiman, Jonathan S. Thomson, “The case for human causes of increased atmospheric CH4 over the last 5000 years”, Quaternary Science Reviews, vol. 20, Issue 18, December 2001, pp. 1769-1777, 2001

Ruddiman, “L’aratro, la peste, il petrolio - L’impatto umano sul clima”, UBE Paperback, 2015

Alice Fornasiero, Rod A. Wing, Pamela Ronald, “Rice domestication”, Current Biology, vol. 32, 1º gennaio 2022, pp. R20–R24

Istituto Superiore per la Protezione e la Ricerca Ambientale RAPPORTI 374/2022 Il metano nell’inventario nazionale delle emissioni di gas serra. L’Italia e il Global Methane Pledge, 2022

NASA, “Atmospheric Methane Concentrations”, ONLINE https://climate.nasa.gov/vital-signs/methane?intent=121

IMEO, “Methane Data”, ONLINE, https://methanedata.unep.org/plumemap

Cicli glaciali e attività antropica - La concentrazione dei gas serra in atmosfera

Come abbiamo accennato in un precedente post[1],dallo studio sui cicli glaciali emerge una relazione diretta tra il variare della radiazione solare e la concentrazione naturale dell’anidride carbonica e del metano presenti in atmosfera.

La prima spiegazione valida a questo fenomeno arrivò nel 1981, quando il meteorologo John Kutzbach pubblicò uno studio in cui ipotizzava che, alle latitudini tropicali e in corrispondenza coi moti ciclici millenari terrestri, all’aumento della radiazione solare corrispondesse un aumento di intensità del fenomeno dei monsoni estivi che coinvolgono il Nord Africa [2], con relativa crescita di umidità ed espansione delle aree verdi in regioni attualmente desertiche.

Una delle conferme più incisive di questa teoria arrivò dagli studi effettuati sui carotaggi della calotta glaciale antartica estratti dalla stazione russa di Vostock (arrivata a circa 3.300 metri di profondità), al cui interno si trovavano imprigionate bolle d’aria risalenti fino a circa 400.000 anni fa. Oltre a confermare la maggiore umidità globale nell’epoca interessata dallo studio di Kutzbach, questi risultati rivelarono anche una maggiore presenza di metano nell’atmosfera nei periodi di più intenso irraggiamento solare [3], ossia in coincidenza con la maggiore presenza di vegetazione alle latitudini tropicali.

IL COMPORTAMENTO NATURALE DEL METANO NEI MILLENNI

Da quanto emerge dai carotaggi glaciali e da quelli oceanici, il ciclo di concentrazione atmosferica di CH₄ ha sempre mantenuto un’oscillazione costante nelle decine e centinaia di millenni passati, in correlazione coi moti millenari del pianeta [4].

Come risulta dalle verifiche effettuate in seguito sullo studio di Kutzbach, la variazione della concentrazione di metano in atmosfera è dovuta al fatto che in queste vastissime aree tropicali si trovavano grandi aree verdi che, nei momenti di maggiore intensità monsonica, venivano sommerse: la teoria aveva trovato le sue conferme.

In sostanza, il ristagno di queste acque innescava su scala macroscopica fenomeni di decomposizione organica anaerobica a carico dei microrganismi metanogeni, del tutto analoga a quella degli ambienti palustri.

Questa attività monsonica e i suoi effetti scatenanti le emissioni naturali di metano vanno estesi, oltre che alla regione del Sahel nordafricano studiato da Kutzbach, anche a tutte le vastissime aree tropicali che attraversano l’Arabia meridionale, l’India, il Sudest asiatico, fino ad arrivare alla Cina meridionale [5].

PERCHÉ AUMENTO ANOMALO “RECENTE” DELLE EMISSIONI DI CH₄?

Il ciclo di precessione coi suoi relativi effetti studiati da Kutzbach si compie in circa 25.000 anni, con intensità variabili dovute al concorso degli altri moti millenari compiuti dalla Terra.

Al giorno d’oggi ci troviamo nel minimo storico della radiazione solare estiva, a circa 10.000 anni di distanza dal massimo, e la concentrazione atmosferica di metano, anziché diminuire come era stato previsto, è aumentata.

Come risulta dalle diverse attività di studio elencate in precedenza, l’arresto del decremento e questo trend di anomalo aumento sono cominciati ben 5000 anni fa, ossia molto prima della rivoluzione industriale, a cui fino ad allora si attribuiva l’unica variazione anomala, e il cui inizio oscilla tra 250 e 200 anni fa.

Rimaneva ancora inspiegato e dunque attribuito a fattori "naturali" e “non-industriali” l’incremento precedente a quest’ultima era della produzione umana, a vantaggio anche dei negazionisti di un anomalo cambiamento climatico in atto e di chi faceva dunque risalire le cause a questi non ben precisati fenomeni naturali.

Se la spiegazione determinante di questi cambiamenti fosse risieduta nella sola “Natura”, allora il clima terrestre sarebbe dovuto andare incontro a un raffreddamento globale. Invece non è stato così.

Non solo le temperature medie sono aumentate, ma anche le emissioni di gas serra prodotte negli ultimi 250-200 anni non erano spiegabili, in quanto rappresentavano la sola metà del totale presente in atmosfera registrato all’epoca dei suoi studi.

La metà mancante andava cercata altrove e, escluse di per certo le cause naturali, il sospetto rimaneva in ambito antropico.

---------------------

La risposta a questo comportamento anomalo pre-industriale arrivò quando William Ruddiman ebbe un'intuizione, che verrà descritta in un prossimo post.

NOTE

[1] Il post è “Stiamo ritardando la prossima glaciazione? Si.” e ne consigliamo la lettura in quanto propedeutico alla comprensione di questo presente.

[2] Questa teoria nacque dall’obiettivo primario di comprendere perché nella zona desertica del Sahel vi siano testimonianze di una precedente esistenza di fiumi e vegetazione.

[3]Vedi nota #1

[4] Fatta ovviamente esclusione per le emissioni straordinarie di metano dovute alle naturali attività vulcaniche, riconoscibili perché corrispondono ad aumenti di proporzione in un lasso brevissimo di tempo.

[5] Il lettore sarà agevolato nella comprensione di questo fenomeno di desertificazione progressiva se riporterà la sua mente agli studi scolastici sulle popolazioni della “Mezzaluna Fertile”, nonché ai monumenti e alle città ritrovate, ora in pieno deserto.

Internet non è una “nuvola” - Seconda parte

Nella prima parte di questo articolo, sulla scorta del recente volumetto di Giovanna Sissa Le emissioni segrete (Sissa G., Le emissioni segrete. L’impatto ambientale dell’universo digitale, Bologna, Il Mulino, 2024), abbiamo visto come il processo di produzione dei dispositivi elettronici e anche il funzionamento della rete siano fonti di consumi energetici ormai colossali e in via di costante incremento, a misura che procede la… “digitalizzazione della vita”. Ragionando in termini di emissioni di gas a effetto serra dovute a tali consumi, si parla, nel primo caso, di emissioni incorporate e nel secondo di emissioni operative. Delle prime fanno parte non solo quelle dovute al processo produttivo, ma anche quelle necessarie allo smantellamento e al riciclo dei prodotti, giunti a fine-vita. E di quest’ultimo aspetto ci occupiamo ora: dell’e-waste, ovvero della “spazzatura elettronica”.

E-WASTE, OVVERO: RITORNO ALLA TERRA

Non c’è prodotto, non c’è merce, che prima o dopo, in un modo o nell’altro, non torni alla terra sotto forma di rifiuto. E a questa legge, che ci hanno spiegato i grandi maestri del pensiero ecologico come lo statunitense Nicholas Georgescu-Roegen o qui in Italia Laura Conti e Giorgio Nebbia,[1] non fa eccezione il mondo digitale, con tutta la sua multiforme schiera di dispositivi personali, sottoposti peraltro a un ritmo sempre più rapido di obsolescenza-sostituzione (e non ci si faccia ingannare dalle rassicurazioni di aziende e istituzioni, come la Commissione europea, sull’impegno a superare le pratiche della obsolescenza programmata e a modificare il design dei propri prodotti in funzione del riciclo, riparazione ecc.! Nel caso migliore, si tratta di… pannicelli caldi).

Anche i processi di riciclo e trattamento comportano consumo di risorse e dunque emissioni (sono anch’esse da considerare “emissioni incorporate”). In questo caso a determinare le emissioni sono appunto procedimenti industriali molto complessi che devono estrarre da ogni dispositivo i materiali riutilizzabili.

Ebbene, quel che si scopre, in questo caso, è che dal punto di vista delle emissioni questa fase del ciclo di vita dei dispositivi elettronici sembra comportare un peso molto minore, ma questa – nota l’autrice – non è una buona notizia: significa molto semplicemente che gran parte di questa mole di materiali non vengono trattati adeguatamente. Anzi, diciamola meglio: non vengono trattati del tutto. Le ragioni – spiega Sissa – sono insieme tecniche ed economiche: i processi industriali di recupero dei materiali (anche di valore) contenuti in un pc o in uno smartphone sono talmente complessi (data la quantità minima di materiali da recuperare) da rendere in definitiva del tutto diseconomica l’operazione.

Le (poche) ricerche esistenti parlano di una percentuale non superiore al 20% di materiale riciclato; tutto il resto, molto semplicemente, viene… spedito in Africa o in un qualunque altro paese disperato, post (post?) coloniale o semplicemente intenzionato a garantirsi un po’ di rendita a costo di chiudere tutti e due gli occhi sugli effetti ecologici di questo “servizio”.[2]

È fuori dubbio che, in questo caso, il tipo di impatto ecologico è di carattere diverso: infiltrazione di sostanze tossiche nelle falde sottostanti le grandi discariche (in particolare piombo, cadmio, diossine…), avvelenamento di animali e verdure, dell’aria, intossicazione delle popolazioni che spesso finiscono per costruire intorno a questi gironi infernali hi-tech vere e proprie economie informali che consentono, in contesti sociali poverissimi, occasioni di sopravvivenza per vaste masse e perfino di arricchimento per piccoli strati di una umanità tutta egualmente avvelenata. Se si vuole avere un’idea di queste realtà, si può guardare alla colossale discarica di Agbogbloshie (Accra), in Ghana, dove migliaia di persone vivono e lavorano attorno a questo terribile... business.[3]

CONTROVERSIE ECO-DIGITALI