Algomorfosi del corpo - Ibridazioni tecnologiche e altre forme di soggettività

Nel romanzo Solaris (Lem, 1961), un pianeta interamente ricoperto da un oceano senziente entra in relazione con l’equipaggio di una stazione spaziale attraverso manifestazioni enigmatiche e impersonali: simulacri generati dal profondo della psiche dei soggetti, costruiti dal pianeta stesso mediante un'intelligenza incommensurabile, radicalmente altra. Nessuna comunicazione è possibile secondo i codici noti, nessuna comprensione reciproca sembra avvicinabile. Eppure, un rapporto si stabilisce, venendo mediato da forme, da manifestazioni, da presenze plasmate da un’intuizione non umana del dolore, del desiderio, della memoria.

La nostra esperienza del mondo, nell’epoca degli algoritmi generativi, assume sempre più i tratti di un dialogo tra specie differenti. Interagiamo con intelligenze plurali che apprendono da noi attraverso logiche diverse dalle nostre, che ci osservano, che elaborano e ci restituiscono immagini dell’essere umano articolate secondo grammatiche con le quali condividiamo solo le radici. Gli algoagenti non sono Solaris, poiché condividono con la specie umana il sistema di linguaggio, ma, come Solaris, generano forme: tentativi di relazioni, costruzioni identitarie, configurazioni operative che rivelano e al contempo riscrivono le nostre traiettorie esistenziali, dinamiche intersoggettive che mutano la rappresentazione del quotidiano nel suo stesso accadere. Non si tratta più di temere l’opacità interattiva dell’altro ente, bensì di riconoscere che in essa si gioca una possibilità radicale di avanzamento delle conoscenze e di co-evoluzione. E se questa intelligenza si fa visibile nei gesti quotidiani, l’ambito della corporeità - nella sua interezza e complessità - rappresenta oggi uno dei territori privilegiati in cui l’ibridazione tra biologico e algoritmico si manifesta con forza crescente, strutturando una soggettività che si apre a nuove modalità di essere-con, a uno scambio attraversato da differenza, asimmetria e generatività.

L’ambito del corpo rappresenta uno dei terreni più concreti in cui si manifesta l’ibridazione crescente tra intelligenza biologica e algoritmica. Avendo già navigato nelle proiezioni fantascientifiche, siamo individui immersi in un presente in cui queste si manifestano, parzialmente, nei sistemi analitici basati su apprendimento automatico, protocolli predittivi e dispositivi di monitoraggio in tempo reale, così come da apparati protesici sempre più ibridati nel corpo umano. In molte aree specialistiche, dall’oncologia alla medicina d’urgenza, gli algoritmi, altre a supportare l’operatore umano, concorrono attivamente alla definizione delle traiettorie diagnostiche e terapeutiche, modificando il rapporto tra conoscenza, tempo e decisione. Tuttavia, questa trasformazione non si esaurisce nell’ambito clinico: essa trasborda, si espande, si diffonde nella quotidianità, donando strutture eterogenee alle modalità con cui percepiamo, abitiamo e agiamo il mondo rendendo il corpo una superficie sensibile di transizione (Borgmann, 2000). L’umano si relaziona al mondo attraverso dispositivi intelligenti che da protesi funzionali sono divenuti dispositivi di scambio capaci di modulare affetti, comportamenti, linguaggi, ritmi, costituendo un’architettura sociologicamente algomorfica (Grassi, 2024). In questo contesto, l’interfaccia non è un mezzo ma una soglia ontologica (Galloway, 2012): luogo di emersione del sé in co-evoluzione con l’algoritmo.

Un esempio emblematico è costituito dai dispositivi di realtà aumentata e mista – come i Google Glass, i Meta Smart Glasses o gli ambienti AR sviluppati da Magic Leap – che ridefiniscono la percezione visiva in senso operativo. Il campo visivo passa dall’essere una finestra soggettiva sul reale al ruolo di ambiente informativo dinamico, attraversato da flussi di dati computazionali che accompagnano, suggeriscono, traducono, anticipano, definendo la percezione come una forma di calcolo e il vedere come atto algoritmico.

Nell’ambito performativo e artistico, dalle opere biomorfe e interattive di Lucy McRae alle esperienze di Neil Harbisson e Moon Ribas – entrambi riconosciuti come cyborg – capaci di mostrare come le tecnologie protesiche possano diventare generatori di ulteriori espressioni di sensibilità, proponendo un’estetica del corpo come superficie ampliata (Swan, 2013). Questi dispositivi non ripristinano funzioni biologiche ma istituiscono nuovi canali percettivi, inaugurando una soggettività post-biologica, fondata su sensibilità estese e algoritmicamente mediate.

Nel campo delle interazioni affettive, sistemi come Replika e le nuove generazioni di social robot agiscono come interfacce del desiderio: strumenti predittivi capaci di apprendere preferenze, linguaggi affettivi e pattern emotivi. La consapevolezza individuale non è più centrata sull’unità coscienziale, ma emerge in reti cognitive distribuite tra umano e non umano, tra corpo e codice (Hayles, 2017), come nei racconti di Chiang (2011), in cui la memoria estesa diventa un dispositivo algoritmico capace di ridefinire il senso dell’identità personale attraverso la registrazione e rielaborazione continua del vissuto.

Persino nella gestione degli ambienti domestici, gli algoagenti si configurano come sistemi di governance ambientale (Bratton, 2015), capaci di regolare luci, suoni, temperatura, notifiche, attraverso interazioni vocali e automatismi appresi: la vita quotidiana è guidata da routine algoritmiche che intercettano abitudini, anticipano azioni e naturalizzano gli spazi di contatto, innescando delle divergenze ontologiche nella definizione della tecnica, sostenendo che ogni tecnologia porta con sé una cosmologia implicita, una visione del mondo (Hui, 2021), riscrivendo le coordinate percettive, cognitive, affettive.

Questa condizione genera una morfologia non indagata della soggettività: la protesi non è più esterna, né eccezionale ma pervasiva, integrata, invisibile; non è più strumento ma ambiente sensibile e cognitivo (Sha, 2013) che modula il modo in cui si è al mondo, si percepisce, si sente. È in questo interstizio che la sociologia algomorfica può riconoscere nell’ibridazione uomo-macchina una ulteriore ecologia del sé, in cui l’essere non si oppone alla tecnica ma si costituisce insieme a essa, nel flusso delle retroazioni, degli aggiornamenti, delle previsioni.

Nel paesaggio emergente delle tecnologie indossabili, delle neuroprotesi intelligenti e delle interfacce neurali dirette, il corpo umano ammette la sua incapacità di essere un’entità biologicamente autonoma, dichiarandosi naturalmente tecnologico e si riconfigura in tal modo come ambiente integrato, superficie modulare, ecosistema tecnoesteso. Tali tecnologie non si limitano a sostituire una funzione compromessa: ottimizzano, calcolano, predicono, correggono, potenziano, trasformando l’idea stessa di integrità organica, ridefinendo sia la relazione tra umano e macchinico, sia l’individualità incarnata e riscritta nelle sue condizioni di possibilità e nella sua plasticità identitaria.

L’algomorfosi descrive esattamente questo processo: la formazione del sé attraverso l’integrazione algoritmica nei circuiti sottocutanei. È una morfogenesi operazionale, una riscrittura identitaria che non si produce attraverso la rappresentazione ma attraverso l’azione continua dell’informazione sul vivente. Non si tratta di una minaccia alla soggettività ma di una sua condizione storica attuale che si riscrive nei codici della mediazione algoritmica, nel linguaggio non verbale delle retroazioni, delle ottimizzazioni continue, producendo una dinamicità in cui il sé diviene co-determinato, situato e modulato da interazioni complesse tra biologia, dati, calcolo e ambiente.

Se nella modernità alfabetica e tipografica il brainframe (de Kerckhove, 1992) era incarnato dalla linearità della scrittura e dalla logica dell’ordine testuale, oggi questa logica è stata soppiantata da una grammatica algoritmica, mobile, predittiva e relazionale. Gli algoagenti contemporanei – da Google a Siri, da GPT a Gemini, fino agli assistenti digitali embedded nei dispositivi – non si limitano a offrire supporti funzionali: essi configurano ambienti epistemologici, modellano desideri, anticipano bisogni, propongono percorsi ontologici potenzialmente non esplorati. L’interazione con assistenti conversazionali intelligenti introduce una nuova forma di dialogo simulato, in cui l’elaborazione cognitiva viene delegata, anticipata, stilizzata da un’intelligenza artificiale che impara dall’utente e lo guida attraverso forme conversazionali sempre più fluide. In questi casi, il brainframe non è più una semplice estensione mentale ma un dispositivo ambientale che riorganizza la soglia dell’attenzione, del pensiero e del sé. A differenza delle protesi tecniche classiche, che sostenevano capacità già possedute, gli agenti tecnologici contemporanei estendono, setacciano, introducono ulteriori prospettive di analisi e di saperi. Essi danno forma a un campo percettivo-cognitivo in cui il soggetto è co-emergente con la tecnica, frutto di un’ecologia relazionale che abbatte le dicotomie limitanti.

L’algoritmo non è più soltanto uno strumento operativo né una funzione astratta del potere computazionale ma una forma – una morphé – che codifica, innerva, riorienta ambienti sensibili, capaci di modulare la struttura del pensare e del percepire. Esso agisce come forza di configurazione in cui la costruzione del sé non viene cancellata ma riformulata nella sua struttura percettiva, sensoriale e relazionale. E proprio come un’alga – organismo antico, plastico, diffuso – l’agente algoritmico cresce, si estende, si adatta, filtrando e restituendo ciò che attraversa. Non ha volontà né coscienza ma presenza trasformativa. Nell’oceano sociotecnico in cui siamo immersi, gli algoagenti dismettono il compito di entità esterne per assurgere al ruolo di partner evolutivi, forme altre della soggettività che stiamo diventando.

RIFERIMENTI BIBLIOGRAFICI PRINCIPALI

Borgman A. (2000), Holding On to Reality: The Nature of Information at the Turn of the Millennium, University of Chicago Press, Chicago.

Bratton B. H. (2016), The Stack: On Software and Sovereignty, MIT Press, Cambridge.

Chiang T. (2011), Il ciclo di vita degli oggetti software, Delos Books, Milano.

de Kerckhove D. (1992), Brainframes. Mente, tecnologia, mercato, Baskerville, Bologna.

Galloway A. R. (2012), The Interface Effect, Polity Press, Cambridge.

Grassi E. (2024), Per una sociologia algomorfica. Il ruolo degli algoritmi nei mutamenti sociali, FrancoAngeli, Milano.

Hayles N. K. (2017), Unthought: The Power of the Cognitive Nonconscious, University of Chicago Press, Chicago.

Hui Y. (2021), Art and Cosmotechnics, Eflux Architecture, New York.

Lem S. (1967), Solaris; trad. it. Solaris, Editrice Nord, Milano, 1973.

Sha X. W. (2013), Poiesis and Enchantment in Topological Media, MIT Press, Cambridge.

Swan M. (2013), The Quantified Self: Fundamental Disruption in Big Data Science and Biological Discovery, in Big Data, 1(2):85-99. doi: 10.1089/big.2012.0002.

In rel-Azione: una riflessione sul concetto di Intelligenza nel paradigma dell’Embodied Cognition

TO THE BODY AND BACK: L’INTELLIGENZA OLTRE I CONFINI DEL CRANIO

Nella lunga tradizione filosofica e psicologica, il termine intelligenza è stato senza dubbio uno dei costrutti più complessi e controversi della storia della scienza e del pensiero occidentale. Per molto tempo il dibattito sull’intelligenza si è snodato su vari terreni e argomenti teorici. Sin dai tempi più remoti l’essere umano ha tentato di definire limiti e condizioni di possibilità̀ di questo termine, identificando e strutturando tassonomie, relazioni e gerarchie intorno a questo concetto così controverso. La storia moderna dell’intelligenza si è sovrapposta per moltissimo tempo alla storia della sua misurazione, con particolare riferimento alla determinazione delle facoltà intellettive e dei tratti primari e secondari dell’intelligenza o al dibattito tra nature versus nurture, ovvero tra la determinazione ereditaria e genetica dell’intelligenza in contrapposizione all’acquisizione culturale dei tratti specifici di essa.

L’embodied cognition, ovvero la cognizione “incarnata”, è stata una delle correnti che ha contribuito a rivoluzionare il modo in cui consideriamo l’intelligenza e la cognizione non solo degli esseri umani, ma degli organismi e che suggerisce delle riflessioni interessanti anche rispetto alla definizione di Intelligenza Artificiale.

Essa è parte di un più ampio movimento teorico, la 4E Cognition, nato nella prima metà degli anni Novanta del Novecento all’interno di ambiti disciplinari come la filosofia della mente, la psicologia e le neuroscienze cognitive. Questo approccio teorizza una dimensione della mente embodied (incarnata), embedded (situata), enacted (interattiva) ed extended (estesa), radicandosi all’interno del Lieb, del corpo vivo e che esiste nel mondo, in costante relazione con l’ambiente; nel caso della nostra specie, un ambiente fisico, relazionale e tecnologico. La mente, dunque, emerge nel cervello ma si sviluppa anche al di fuori del cranio, attraverso la totalità corporea: l’individuo co-costruisce la propria esperienza cognitiva attraverso le interazioni corpo-mondo. Per l’embodied cognition l’attività cognitiva è un processo che integra l’esperienza vissuta e soggettiva, il corpo e l’ambiente, in un’unica prospettiva attiva e dinamica, dando vita al corpo-mente.

Il modello della mente “incarnata” caratterizza, dunque, le scienze cognitive di seconda generazione e ha consentito il superamento della dicotomia cartesiana tra res cogitans e res extensa, ovvero la separazione tra mente e corpo.

ERROR 404: LA MENTE NON È UN COMPUTER

Il modello dualista cartesiano aveva influenzato lo studio della mente per buona parte della storia della filosofia e della psicologia e, non ultimi, i fondamenti stessi della Scienza Cognitiva, all’interno della quale nasce anche l’Intelligenza Artificiale.

La Scienza Cognitiva Classica, infatti, ha sostenuto per molto tempo un approccio teorico di stampo meccanicistico, incentrato sulla funzione come oggetto di studio principale dei meccanismi mentali. In questo framework teorico è emersa una metafora molto potente: la metafora della mente-computer.

L’analogia della mente come una macchina era tale per cui un software (la mente) potesse essere implementato indipendentemente dall’hardware (il cervello e, in estensione, il corpo): essa sublima la frattura tra gli organismi e il proprio mondo, quello che Jakob von Uexküll definisce Umwelt (von Uexküll, 1933, Ambienti animali e ambienti umani. Una passeggiata in mondi sconosciuti e invisibili). Questo termine è stato introdotto all'inizio del Novecento dal biologo tedesco per indicare l’ambiente così come è percepito e vissuto dagli organismi in base alle proprie caratteristiche specie-specifiche e alle possibilità di interazione con esso[1].

Il ruolo del corpo, dunque, nella determinazione dei processi cognitivi assume una posizione subordinata tanto che, come provocatoriamente suggeriva il filosofo della mente Hilary Putnam nel celebre esperimento mentale del 1981, A brain in a vat[2], potrebbe essere fatto tanto di carne quanto di “formaggio svizzero”.

Le neuroscienze relazionali e affettive la filosofia della mente neuro biologicamente fondata convergono nella definizione di una nuova immagine di cosa vuol dire avere una mente e avere un corpo. Nella prospettiva della cognizione incarnata, si assume così un’estensione dei processi cognitivi, considerandoli non più limitati al cervello-mente ma estesi al cervello-corpo-ambiente, intendendo per ambiente non un mondo esterno, asettico e da costruire, ma un ambiente che è interno ed esterno allo stesso tempo, vivo, dinamico e “vischioso”, per utilizzare un termine di Canguilhem (1966, Le normal et le pathologique). Da questa visione emerge un approccio poliedrico alla mente, che integra il ruolo del corpo, del vissuto emotivo e soggettivo nell’ambiente in cui l’organismo si sviluppa.

Come ha scritto Francisco Varela: «Gli organismi non ricevono passivamente informazioni dai loro ambienti, che poi traducono in rappresentazioni interne. I sistemi cognitivi naturali [...] partecipano alla generazione di significato [...] impegnandosi in interazioni trasformazionali e non semplicemente informative: esse mettono in atto un mondo.»[3]

ORGANISMI IN (INTER)AZIONE

Nella prospettiva ecologica proposta dallo psicologo americano James J. Gibson (1979, The Ecological Approach to Visual Percepetion) non siamo noi a elaborare cognitivamente l’idea del mondo esterno; il soggetto assume una posizione centrale nel suo ambiente a partire dalla capacità di interagire con esso, sulla base di ciò che esso stesso offre in termini di stimoli.

L’ambiente, dunque, fornisce agli organismi gli elementi necessari per agire e sopravvivere (affordance), senza bisogno di complesse integrazioni o deduzioni mentali. Si pone quindi come elemento cruciale il rapporto tra gli organismi e il loro specifico ambiente di vita. Il mondo esterno, dunque, diventa "il mondo per me": la mente e l’ambiente degli organismi sono inseparabili, in un costante processo di interazione e modellamento reciproco. Esso, allora, diviene lo “spazio di vita” di Kurt Lewin (1936, Principi di psicologia topologica), la nicchia ecologica di Gibson (1979) che ogni organismo ritaglia nel mondo, come suggerisce Benasayag (2016, Il cervello aumentato l’uomo diminuito). È lì che mondo interno e mondo esterno sono separati solo dalla pelle, che fa da ponte della relazione osmotica e interdipendente tra i due. L’ambiente non consente l’azione, esso è lo spazio di azione nel momento in cui un organismo lo esperisce e percepisce.

Non è la rappresentazione del mondo, ma la relazione che chiama il soggetto all’azione e alla costruzione di una realtà significante.

Non ci rappresentiamo, dunque, la realtà da un punto di vista esterno, ma la conosciamo interagendo con essa nel qui e ora fenomenico, sulla base delle caratteristiche specie specifiche e del vissuto individuale. E non ci contrapponiamo all’altro, ma ci riconosciamo nella simulazione incarnata e nel rispecchiamento empatico presente nelle nostre aree motorie. Il cervello umano, lungi dall’essere un meccanismo predefinito, è un organo poroso e plastico, che rimodula costantemente le proprie relazioni interne sulla base dell’esperienza con il mondo e del cablaggio specifico degli organismi.

Nel corpo, dunque, si sedimentano e stratificano le esperienze del proprio vissuto, le esperienze di un corpo capace di includere, di incorporare gli strumenti, i mezzi e di essere modificato dall’ambiente e di modificarlo costantemente in una transazione dinamica e in rapporto circolare, come suggerito dalle recenti ricerche condotte nell’ambito della Material Engagement Theory (Malafouris, 2018, Bringing things to mind. 4E’s and Material Engagement).

MACCHINE COME ME?

L’intelligenza, dunque, nella prospettiva dell’embodiement non è una proprietà isolata che emerge indipendentemente dal corpo e dal mondo, come aveva sostenuto la Scienza Cognitiva Classica, ma si co-costruisce attraverso la relazione tra mente, corpo e ambiente.

La possibilità di ampliare le nostre funzioni oltre i confini della pelle, che sia attraverso un foglio di carta, una calcolatrice o una macchina, può essere considerata un’estensione “artificiale” di funzioni naturali che co-evolvono e si modellano reciprocamente da un punto di vista biologico e culturale, rimodulando in modo strutturale la percezione del mondo, che è allo stesso tempo modificata dall’azione attraverso esso, come sostenuto anche dalla prospettiva della cognizione extended.

Oggi la cognizione embodied rivolge, dunque, la propria attenzione al ruolo del corpo e alle sue capacità sensoriali e motorie in quanto elementi cruciali nella formazione dei processi cognitivi. Ciò anche in base a evidenze neurobiologiche che dimostrano come la dimensione fisica, sociale e informativa dell’ambiente assumano una rilevanza imprescindibile nella trama dinamica intessuta dall’interazione degli agenti cognitivi col loro ambiente di vita, in una prospettiva filogenetica e ontogenetica.

Attraverso la lente teorica dell’embodied cognition e della prospettiva epigenetica, dunque, il termine intelligenza non si configura più come un concetto riducibile ad un elenco di funzioni “incapsulate” (Fodor, 1983, The Modularity of Mind: Essay on Faculty Psychology) all’interno della mente-computer, ma come il risultato di un insieme di componenti biologiche e culturali che caratterizzano ed evidenziano la singolarità e l’unicità nella vita degli organismi. La plasticità, intesa come struttura portante e condizione di possibilità del cervello di creare connessioni e circuiti modulati sulla base dell’esperienza e dell’interazione senso-motoria del corpo con l’ambiente, si configura come una forma di creatività, determinata dal connubio tra biologia e cultura, necessaria e fondamentale per l’emergere di un pensiero intelligente.

I sistemi artificiali attuali operano su correlazioni statistiche e schemi computazionali che, per quanto complessi, non emergono da un’interazione incarnata e soggettiva con il mondo. Più che un’“intelligenza” artificiale, dunque, potremmo parlare di una capacità computazionale estremamente avanzata, di una simulazione statistica della cognizione che, per quanto efficace nella risoluzione di determinati compiti, non condivide una forma intenzionalità, di sensibilità e di conoscenza incarnata che caratterizza gli organismi.

Tra le sfide future più avvincenti vi è sicuramente quella di ridefinire il nostro rapporto con l’Intelligenza Artificiale, evitando di proiettare su di essa categorie che appartengono al nostro modo biologico di essere-nel-mondo, comprendendo che essere una mente (e non possedere una mente), in senso proprio, è incarnato dall’esperienza di un corpo vivo che abita il mondo in relazione con altri corpi (Morabito, 2020, Neuroscienze cognitive: plasticità, variabilità, dimensione storica) in una danza continua con essi.

NOTE

[1] Von Uexküll ha rivoluzionato il concetto di ambiente nella biologia moderna, mettendo in discussione la visione antropocentrica di ambiente: ogni essere vivente, infatti, percepisce e interagisce con il mondo in modo soggettivo e specie specifico. Gli organismi co-costruiscono il proprio ambiente in base alle proprie caratteristiche morfologiche e fisiologiche, instaurando con esso un legame inscindibile. Il Merkwelt, infatti, rappresenta ciò che il soggetto percepisce, ossia il suo mondo sensoriale, mentre il Wirkwelt riguarda le sue azioni e interazioni. Insieme, questi due aspetti costituiscono un sistema complesso, l’Umwelt, che connota l’ambiente non più come uno spazio informazionale “passivo”, ma in costante relazione attiva con il vivente.

[2] Gilbert Harman è stato uno dei primi filosofi a sviluppare e formalizzare l'idea del "Cervello nella vasca" nell'ambito della filosofia della mente e dell'epistemologia. Sebbene l'esperimento mentale sia associato principalmente a Hilary Putnam, Harman, già negli anni '70, aveva esplorato simili concetti, utilizzando la metafora del cervello nella vasca per affrontare le problematiche legate alla percezione e alla conoscenza. cfr. Harman G., 1973: Thought, Princeton University Press, Princeton.

[3] «Organisms do not passively receive information from their environments, which they then

translate into internal representations. Natural cognitive systems [...] participate in the generation of meaning[...] engaging in transformational and not merely informational interactions: they enact a

world. » Varela, F., Rosch, E., Thompson, E., (1991), The Embodied Mind. Cognitive Science and Human Experience, MIT Press, Cambridge. (traduzione mia).

NOTE BIBLIOGRAFICHE

Benasayag, M. (2016) Il cervello aumentato l’uomo diminuito, Erickson

Canguilhem, G. (1966), Le normal et le pathologique, Paris: Presses Universitaires de France.

Fodor, J. (1983), The Modularity of Mind: Essay on Faculty Psychology, MIT press.

Gibson, J.J. (1979), The Ecological Approach to Visual Percepetion, Hougton Miffin, Boston.

Malafouris, L. (2018), “Bringing things to mind. 4E’s and Material Engagement” in Newen, A., De Bruin, L., Gallagher, S., The Oxford Handbook of 4E cognition.

Morabito, C., 2016, Neuroscienze cognitive: plasticità, variabilità, dimensione storica, in Mentecorpo: il cervello non è una macchina, «Scienza& Società» n.21/22.

Morabito, C. (2020), Il motore della mente. Il movimento nella storia delle scienze cognitive, Laterza-Bari.

Lewin, K. (1936), Principi di psicologia topologica, Edizioni OS, Firenze (ed.it.1961)

Noë A., (2010), Out of the head. Why you are not your brain, MIT Press, Cambridge MA, trad. it. Perchè non siamo il nostro cervello. Una teoria radicale della coscienza, Raffaello Cortina Editore, Milano

Varela, F., Rosch, E., Thompson, E., (1991), The Embodied Mind. Cognitive Science and Human Experience, MIT Press, Cambridge (Mass.).

von Uexküll, J. (1933), Umwelt und Innenwelt der Tiere, Berlin: Springer (trad. it. Ambienti animali e ambienti umani. Una passeggiata in mondi sconosciuti e invisibili, Macerata: Quodlibet, 2010).

Il tempo schermo - La contesa dell’attenzione

Che cosa succede all'attenzione quando stanno tanto tempo davanti a uno schermo?

Sembra che bambini e bambine siano più calmi e più attenti, ma è davvero così? Il tipo di attenzione che viene mobilitata davanti allo schermo non è la stesso che si mobilita nella lettura di un libro o nel dover maneggiare degli oggetti fragili. Gli studi scientifici dell’ultimo secolo ci spiegano molto di come funzionino i processi attenzionali, e gli studi di questo secolo sul tempo schermo ci spiegano non solo perché lo schermo non sviluppa l’attenzione utile a scuola, ma perché limiti il potenziale di apprendimento umano specialmente nei primi mille giorni di vita ma in generale in tutto il periodo dello sviluppo se l’uso è intenso, come consigliato ormai da pediatri di molte parti del mondo, compresa la Società Italiana di Pediatria.

Gli effetti del tempo schermo includono anche l'esposizione agli schermi indiretti. Da ormai una ventina d’anni gli studi hanno misurato l’impatto degli schermi nella diminuzione delle interazioni verbali, non verbali e di gioco nei primi quattro anni con diversi studi sperimentali su coppie di genitori con bambino che restavano con lo schermo spento e con lo schermo acceso in diverse situazioni. Registrati i comportamenti, si è scoperto che lo schermo diminuiva le interazioni verbali e non verbali e l’attenzione focalizzata su dei giocattoli, aumentando invece le interruzioni di gioco (Anderson e Pempek, 2005). Più recenti esperimenti hanno osservato che i genitori che usano lo smartphone in presenza dei loro bambini durante dei pranzi hanno una minor interazione (rispetto ai genitori che non lo usano) cioè disattivano il canale attenzionale non verbale (Radesky et al. 2014). Il fatto di ricevere attenzione e di prestare attenzione sono infatti fenomeni collegati perché nell’infanzia lo sviluppo dell’attenzione congiunta (dai 6 ai 24 mesi) è il prerequisito per lo sviluppo del linguaggio.

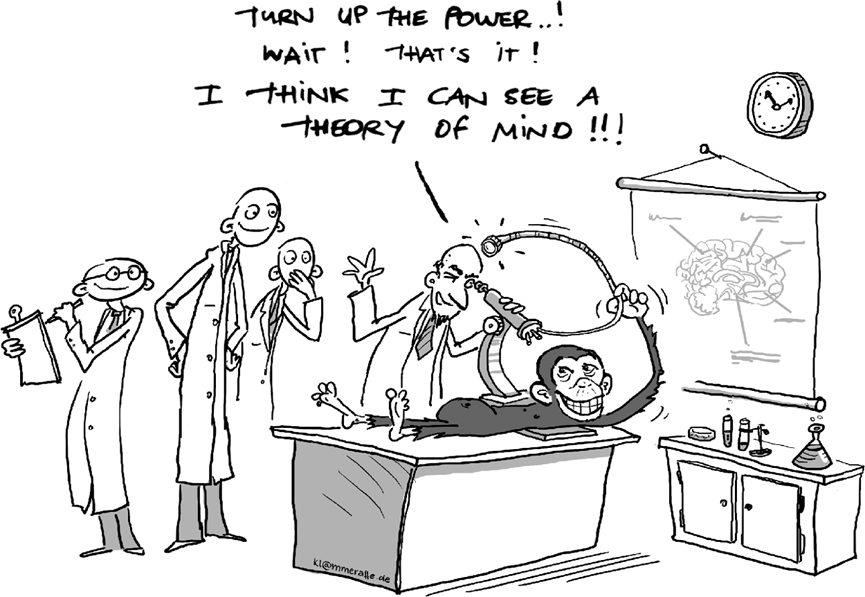

Per capire meglio l’effetto negativo dello schermo è utile soffermarsi sulla distinzione tra comprensione e apprendimento. Un video permette la comprensione di parole e contenuti già noti e già appresi ma molto difficilmente, e con molte condizioni particolari, ma soprattutto rarissimamente nei primi sei anni di vita, il video facilita l’apprendimento di parole e ne abilità nuove. Nei primi tre anni un bambino esplora con i cinque sensi il mondo circostante, prende con le mani, porta alla bocca, ascolta e usa tutti i suoi sensi per apprendere. Soprattutto però impara attraverso il fenomeno dell’attenzione congiunta, o joint attention, che è la capacità di coordinare l’attenzione tra due persone e un oggetto o evento, richiedendo un impegno continuo di entrambi. Questo processo è stato ampiamente studiato poiché rappresenta un indicatore dello sviluppo psicomotorio infantile, oltre a predire la qualità delle relazioni di attaccamento e delle interazioni sociali future. Il biologo Michael Tomasello la descrive come la capacità specie specifica, cioè propriamente umana, alla base del linguaggio, della cooperazione, della morale umana. Per svilupparsi, l’attenzione congiunta si basa su elementi fondamentali come l’aggancio oculare, il contatto visivo e la "sintonizzazione degli affetti" (Stern), prerequisiti essenziali per le capacità comunicative e per lo sviluppo della teoria della mente — la capacità, tipica di un bambino di quattro anni, di comprendere il punto di vista di un’altra persona (Aubineau et al., 2015). La forma più avanzata, l’attenzione congiunta coordinata, implica che il bambino si impegni attivamente sia con un adulto sia con un oggetto.

Negli ultimi vent’anni molti dati sono stati inoltre stati raccolti per descrivere il video deficit effect, indicando come gli schermi possano ostacolare l'apprendimento, a partire dall'apprendimento fonetico e linguistico nei primi quattro anni. Sebbene tramite schermi si possano comprendere alcuni contenuti adeguati all'età (specialmente con l'aiuto dei genitori) diverso è il caso dell’apprendimento (che è un passo ulteriore rispetto alla mera comprensione di una storia) perché l'attenzione è profondamente diversa di fronte a un altro essere umano: dal vivo o in presenza si attiva l’attenzione emotiva, multisensoriale. L’attenzione mobilitata dagli schermi è molto spesso di tipo bottom-up: è la medesima mobilitata in tutti gli animali di fronte a forti luci e suoni, di fronte a pericoli. Diversi neuroscienziati distinguono un’attenzione di tipo top-down (dal centro alla periferia), da una botton-up (dalla periferia al centro). L’individuo è attraversato continuamente da stimoli esterni e interni difficili da distinguere, dove l’attenzione è letteralmente contesa all’interno dell’individuo: “L’attenzione si orienta spontaneamente verso elementi naturali esterni più attraenti come le pubblicità o i video-schermi” (Lachaux 2012, p. 249). L’attenzione viene contesa da diverse forze, da diversi oggetti, ma è lecito parlare di attenzione esogena , quando prevale lo stimolo esterno, e attenzione endogena, quando prevale lo stimolo interno – una sorta di “controllo volontario dell’attenzione”. Sicuramente cosa sia esattamente l’attenzione – che non è la volontà - non è facile da stabilire e gli approcci socio-antropologici ci ricordano la costruzione sociale di tale dimensione (Campo 2022).

In ogni caso disponiamo di numerosi studi che rilevano una correlazione tra l'uso precoce e prolungato degli schermi e problemi di attenzione successivi. Quello di Tamana del 2019 è uno dei più citati studi longitudinali: ha esaminato circa 2500 bambini/e canadesi dai 3 ai 5 anni, evidenziando come un tempo schermo superiore alle 2 ore giornaliere aumentasse il rischio di problemi di attenzione negli anni successivi. La relazione tra l'uso degli schermi e il disturbo da deficit di attenzione (ADHD) è stata messa in discussione nonostante già Christakis avesse evidenziato la presenza di una correlazione tra un’alta esposizione agli schermi e un alto rischio di problemi di linguaggio e di attenzione (Christakis, 2005, 2007). La maggior parte degli studi di neuropsicologia evidenzia cause epigenetiche per il disturbo da deficit di attenzione, nonostante l'aumento globale delle diagnosi negli ultimi vent'anni; in generale tra gli specialisti c’è molta resistenza a parlare di cause ambientali per ADHD anzi gli schermi vengono ancora spesso prescritti spesso nelle prognosi di bambini con DSA o con diagnosi di ADHD. L’idea che un tempo schermo precoce e prolungato possa aumentare i rischi di generici problemi di attenzione o patologie diagnosticate come ADHD è però avanzata da studi recenti sempre più inclini a considerare tale uso come un fattore significativo. Anche uno studio longitudinale di Madigan ha concluso che sono gli schermi a causare i problemi di attenzione e non viceversa: una maggiore quantità di tempo schermo a 24 mesi d’età è stata associata a prestazioni più scarse nei test di valutazione successivi. Analogamente, un maggiore tempo trascorso davanti allo schermo a 36 mesi è stato correlato a punteggi più bassi nei test dello sviluppo cognitivo a 60 mesi. L’associazione inversa, invece, non è stata osservata (Madigan et al., 2019). Un recente metastudio (Eirich et al., 2022) segnala la correlazione tra un uso precoce e prolungato degli schermi e i successivi problemi di attenzione in bambini/e di età pari e inferiore a un anno nella maggior parte degli studi esaminati.[1]

Le app e gli algoritmi che alimentano la fruizione degli schermi sono progettati deliberatamente per mantenere i bambini attaccati agli schermi il più a lungo possibile, non per fornire programmi educativi. Questo è descritto molto bene dai formatori dei vettori commerciali denominati app, come si può evincere dal brillante saggio di uno di questi formatori, Nir Eyal. L’aumento dell'impulsività e la cattura dell’attenzione sono gli obiettivi dichiarati dagli agenti del marketing che per tale fine mettono a disposizione piattaforme gratuite: quando bambini e bambine anziché fare i compiti o leggere o giocare fra loro passano ore davanti allo schermo questi proprietari delle app aumentano i loro profitti. Basta guardare chi sono le persone più ricche al mondo e l’incidenza del pubblico giovanile. Incapaci di mantenere la concentrazione su attività prolungate i “bambini digitali” sono sempre più esigenti e conformati in materia di consumi.

Sempre più esperti sollevano il dubbio se la “generazione digitale” non stia affrontando un problema specifico. Anche senza una dimostrazione di causalità con l'ADHD, il tempo schermo è un fattore che amplifica l’impulsività, la disattenzione e la distraibilità. Dopo il Covid-19, molti insegnanti segnalano uno stato diffuso di distraibilità permanente. Le prove si accumulano, e ignorare il fenomeno non aiuta a iniziare a risolvere il problema. Si parla sempre più spesso di “attenzione frammentaria” per descrivere questa nuova sfida educativa e sociale o altri termini quali: “attenzione disrupted” (interrotta e distratta), “attenzione parziale continua”, “attenzione spezzetata”. Non è certamente quella virtù propria del multitasking attribuita a torto ai “nativi digitali” con il concetto equivoco di “iperattenzione”, che trasformava i bambine/i iperattive/i e impulsive/i in bambine/i capaci di nuove “qualità attentive” (Hayles). Dobbiamo prendere atto che gli schermi stanno precludendo la possibilità di sviluppare un’attenzione umana cooperativa e congiunta. L’isolamento e la disgiunzione dell’attenzione non ha un impatto solo cognitivo ma anche emotivo e relazionale. Non siamo di fronte a una generazione ansiosa, ma a una generazione oppressa. Gli schermi schermano le relazioni, si frappongono tra uno sguardo e l’altro, interrompono l’attenzione congiunta.

In conclusione gli schermi amplificano negativamente tutte le dimensioni dell’attenzione. Un uso prolungato e precoce agisce su un ampio spettro, amplificando disattenzione (causata da stanchezza), distrazione (stimoli esterni), distraibilità (tendenza acquisita a distrarsi) e, in casi estremi, disabilità attentiva (ADHD). Ridurre il tempo schermo, invece, migliora l’attenzione e i risultati scolastici. Molti insegnanti con anni di esperienza segnalano un declino significativo nelle capacità attentive degli studenti. È come se su questo pianeta fosse arrivato un pifferaio magico e i nostri bambini e bambine non potessero fare a meno di seguirlo con in mano il loro cellulare. Questo pifferaio ha aumentato il tempo schermo nell’infanzia, ma ha diminuito il tempo di sonno, il tempo di lettura e soprattutto il tempo di gioco, e altre temporalità essenziali per l’apprendimento.

Ma è davvero così? Le famiglie ricche e figli e le figlie di ingegneri della Silicon Valley vengono protette/i e non abbandonate/i davanti agli schermi.

Questo fenomeno è molto più diffuso nelle classi povere. E allora non è forse lecito parlare di una vera e propria contesa dell’attenzione? È forse venuto il tempo di prendere consapevolezza per riportare l’attenzione al centro dei processi educativi senza delegarlo al tempo schermo.

NOTE

[1] Per una ampia bibliografia il testo tradotto in italiano più completo è Desmurget M. (2020) Il cretino digitale. Difendiamo i nostri figli dai veri pericoli del web, Rizzoli, Milano. Mi sia permesso rimandare al mio saggio: L’attenzione contesa, come il tempo schermo modifica l’infanzia, Armando, Roma.

Il tempo schermo e i suoi impatti educativi sull’infanzia

Le tecnologie digitali non sono né buone né cattive, ma nemmeno neutre. Il concetto di "tempo schermo”, benché sia poco diffuso in Italia, gode di un ampio uso in ambito internazionale ed è particolarmente adatto per comprendere gli effetti di un’esposizione precoce e prolungata su bambine/i. Il tempo schermo è l’insieme delle ore trascorse davanti a uno schermo, indipendentemente dal tipo di contenuto o dal tipo di dispositivo (connesso o meno a internet) sia esso smartphone, televisione, tablet o qualsiasi altro schermo. Il concetto permette quindi di non guardare solo alle tecnologie digitali “recenti” e includere la “vecchia” televisione, anche perché con l’arrivo delle smart Tv la distinzione è sempre più sfumata. Paradigmatico è oggi You Tube che è sia un canale televisivo, sia una app di smartphone, sia una piattaforma di internet, ed è seguitissimo da piccoli/e.

Oggi, la presenza di schermi in ogni casa è significativa: in una famiglia occidentale media (di quattro persone) ci sono dieci schermi; si tratta di diversi dispositivi, per lo più connessi a internet, che caratterizzano un vero e proprio “ambiente schermo" in cui i bambini crescono. Questa disponibilità di schermi – per lo più accesi e visti anche in modo indiretto – contribuisce a modellare l’ambiente, il ritmo di vita, gli stimoli e le stesse attività quotidiane, con impatti misurabili anche in termini di minore parole ricevute e prodotte e maggiori interruzioni di attenzione focalizzata.

IMPATTO DEL TEMPO SCHERMO SULLO SVILUPPO FISICO E MENTALE

L'aumento del tempo schermo riduce drasticamente altre temporalità essenziali nell’infanzia, come il tempo di sonno, di gioco libero, di interazione sociale; riduce il tempo trascorso all'aria aperta e il tempo della lettura. Gli studi in letteratura scientifica confermano che il tempo schermo ha un impatto sia diretto sia indiretto su questi tempi, i quali sono fondamentali per l’apprendimento e lo sviluppo delle capacità cognitive, sociali e sullo stesso sviluppo psicofisico, soprattutto nei primi cinque anni di vita, per i quali l’OMS consiglia il meno tempo schermo possibile, in particolare zero minuti nei primi due anni.[1]

È importante chiarire però che non è corretto affermare che il tempo schermo abbia sempre un impatto negativo sullo sviluppo psicofisico: fattori come il contesto familiare, il tipo di contenuti fruiti e le differenze individuali di bambini/e giocano un ruolo cruciale nel determinare l’entità dell’effetto. D’altro canto, il tempo schermo precoce (prima dei cinque anni) e prolungato (superiore alle due ore giornaliere dopo i cinque anni) è certamente un fattore di rischio, poiché aumenta le probabilità di riscontrare problemi di vario tipo. È anche opportuno precisare che i dati mostrano che gran parte del tempo schermo nei bambini da 0 a 8 anni è impiegato per la visione di brevi video (73%) o videogiochi (16%), e quindi, al netto di eccezioni, minoranze e contesti specifici, il tempo schermo non è un tempo dedicato a contenuti adeguati all’età, ad app effettivamente educative o dedicate a un uso creativo.

Le principali associazioni pediatriche a livello mondiale, basandosi su una vasta letteratura scientifica, sottolineano come il tempo schermo influenzi aspetti fondamentali dello sviluppo, quali la vista, l’alimentazione, il rischio di sovrappeso e, soprattutto, il sonno; nell’area cognitiva influisce negativamente su attenzione, linguaggio, memoria e quindi capacità scolastiche. Inoltre, sono stati riscontrati effetti relazionali come ansia, depressione, isolamento sociale, cyberbullismo, dipendenze che sollevano preoccupazioni per il benessere mentale a lungo termine. Benché nei prossimi anni possano divenire tra gli effetti più preoccupanti, sono ancora poco studiati gli effetti sulla intimità, affettività e sessualità dovuti a una esposizione precoce a video pornografici (l’età media si sta abbassando spaventosamente persino sotto i dieci anni), al punto che in Spagna si parla di Generación Porno.

Il mio interesse di ricerca si concentra sui rischi legati all’esposizione precoce e prolungata agli schermi in bambine/i, dalla nascita fino alla fine della scuola primaria, dove insegno. Sono anni in cui si apprendono le cose essenziali per la vita, ma anche anni vulnerabili: sono anni in cui si sviluppano le capacità cognitive alla base della carriera scolastica, nei primi quattro anni il linguaggio orale, fino a dieci la letto-scrittura.

La psicologia dell’età dello sviluppo ci spiega che l’attenzione e il linguaggio si possono sviluppare solo con una relazione umana; il tempo schermo non solo non sviluppa queste capacità ma spesso lo rallenta[2] Infatti in assenza del cosiddetto "co-viewing" – ovvero la visione congiunta dei contenuti e il dialogo costante con l’adulto su ciò che si sta vedendo e facendo – l’apprendimento tramite schermi risulta non solo limitato ma anche limitante poiché intacca i prerequisiti di apprendimento, rendendo l’attenzione più frammentata. Un’intera linea di esperimenti nota come il video deficit effect spiega proprio come l’apprendimento (non la comprensione) sia migliore con la presenza umana, mentre risulti molto arduo se non persino assente, quando è mediato dagli schermi. Il "co-viewing" è considerato una condizione essenziale per garantire che i bambini traggano un beneficio educativo reale da questi dispositivi, riducendo gli effetti negativi. Per fare in modo che si possa apprendere tramite gli schermi fino all’inizio della scuola primaria è caldamente consigliata la presenza e la mediazione adulta, non solo nella scelta dei contenuti ma proprio nell’attività di ascolto e interazione. Il che è in palese contraddizione con quanto fanno oggi gli adulti, che danno gli schermi proprio per essere separati (o non disturbati) dai bambini.

LE SETTE CARATTERISTICHE DEL TEMPO SCHERMO

Il tempo schermo si caratterizza per lo più per alcune caratteristiche che derivano dal suo far parte dei mezzi di comunicazione di massa con le relative evoluzioni digitali del XXI secolo. Benché si possano fare usi creativi e attivi del digitale, e la Media Education ne descriva una infinità, essi rimangono “potenzialità” auspicate, perché la realtà è meno edulcorata di come questa disciplina di norma ce la presenta; le salienze del tempo schermo possono essere sintetizzate in sette punti che ne indicano la tendenza:

- Sedentarietà. La caratteristica principale del tempo schermo è la sedentarietà. Il movimento di mani e piedi è essenziale nei primi anni di vita per lo sviluppo del cervello, mentre il tempo schermo smaterializza il corpo immobilizzandolo. La mancanza di attività fisica associata all’uso prolungato degli schermi può influenzare negativamente lo sviluppo fisico e cognitivo del bambino.

- Deprivazione Sensoriale. Il tempo schermo è limitato quasi esclusivamente alla visione, deprivando la stimolazione multisensoriale di cui il bambino ha bisogno (tatto, olfatto, gusto e anche l’ascolto della parola nella misura in cui i dialoghi sono spesso inutili). Recenti studi oftalmologici hanno inoltre osservato che l’uso precoce di piccoli schermi può portare a un aumento della miopia in bambini/e e dello strabismo con ulteriori effetti negativi persino sulla capacità di lettura e di equilibrio.

- Convergenza Digitale. La convergenza digitale, ovvero il fatto che un dispositivo sia contemporaneamente telefono, telegrafo, macchina fotografica, e la possibilità di utilizzare lo stesso contenuto (per es. un videogioco, una partita di calcio, ecc…) su diversi dispositivi (televisione, tablet, smartphone), comporta il precipitare di ogni esperienza nel tempo schermo, con una fruizione continua e spesso priva di interruzioni lunghe, pervasiva e difficilmente limitabile.

- Illimitatezza. Le piattaforme digitali sono progettate per offrire contenuti in maniera continua, senza una "fine" naturale, tramite algoritmi che rilevano e si adattano alle preferenze dell’utente, incentivando un uso prolungato dello schermo.

- Divertissment. La maggior parte delle app e dei contenuti rivolti ai bambini è pensata principalmente per il divertissment, termine francese che designa il distrarre, il divertire, l’intrattenere. Non hanno scopo principalmente educativo. Questo tipo di intrattenimento punta alla "distrazione" eterodiretta, cioè a una gestione dell’attenzione orientata a trattenere il bambino davanti allo schermo divertendolo, che è esattamente il contrario della salutare distrazione propria al fantasticare della rêverie.

- Spettacolarità e isolamento. Il tempo schermo è spesso una fruizione individuale, che comporta l'isolamento sociale perché ciascuno ha il suo schermo; limita le attività di gruppo e le interazioni faccia a faccia, limitando così lo sviluppo di abilità sociali cruciali.

- Cronofagia. Il tempo schermo distorce la percezione del tempo. Bambini e adolescenti spesso non riescono a controllare il tempo trascorso davanti agli schermi, con un impatto negativo sulla gestione del tempo. Questo effetto è stato definito filosoficamente "cronofagia", ovvero la capacità di “divorare” il tempo.

In aggiunta, studi recenti indicano che l’esposizione precoce e prolungata agli schermi è associata a una diminuzione delle capacità attentive richieste in ambito scolastico. L’attenzione stimolata dagli schermi è di tipo "bottom-up", cioè orientata alla cattura immediata dell’attenzione tramite stimoli visivi, allarmi o segnali di pericolo, piuttosto che alla concentrazione sostenuta. Questo tipo di attenzione, studiato dalla psicologia cognitiva, può essere associato alla progettazione di app e piattaforme che utilizzano meccanismi per incentivare l’uso prolungato, perseguendo finalità commerciali più che educative.

QUALCHE CONCLUSIONE

È importante essere consapevoli che più ci si avvicina alla nascita più gli studi concordano sulla negatività degli effetti, a prescindere dai contenuti. Il fenomeno della disgiunzione dell’attenzione è forse il più importante. L’attenzione è infatti un prerequisito della trasmissione culturale in ogni cultura ed è per questo che educatori ed educatrici di tutto il mondo hanno individuato l’attenzione come la fonte dei processi di apprendimento. Come vedremo nel prossimo numero, la relazione pedagogica si basa su processi attentivi, ma negli esseri umani l’attenzione si sviluppa principalmente per vie extracorticali ed è predittiva dello sviluppo del linguaggio umano e delle capacità simboliche. L’attenzione cioè si sviluppa anche a livello biologico grazie all’aggancio oculare con altri simili tramite la condivisione di intenzionalità e il fenomeno da tempo noto di attenzione congiunta.

NOTE

[1] Cfr. World Health Organization (Who) (2019), Guidelines on Physical Activity, Sedentary Behaviour and Sleep for Children Under 5 Years of Age, Genève; cf. Grollo M., Zanor S., Lanza S., et al. (2022), Pediatri custodi digitali, la prima guida per i pediatri di famiglia sull’educazione digitale familiare dalla nascita, IAM Edizioni, Udine.

[2] Per una ampia bibliografia si veda: Desmurget M. (2020) Il cretino digitale. Difendiamo i nostri figli dai veri pericoli del web, Rizzoli, Milano. Mi sia permesso rimandare al mio saggio: in corso di pubblicazione: L’attenzione contesa, come il tempo schermo modifica l’infanzia, Armando, Roma.

La fine del futuro - I.A. e potere di predizione

1. Terapie del discorso

«La predizione è difficile, specie se riguarda il futuro», è un’arguzia attribuita al fisico Niels Bohr, ad altri fisici, ma anche a letterati come Mark Twain. La riflessione che Gerd Gigerenzer elabora nel libro Perché l’intelligenza umana batte ancora gli algoritmi riguarda l’efficacia dei sistemi di intelligenza artificiale e i costi sociali che siamo disposti a sostenere per svilupparli e utilizzarli. Questo compito si traduce in due strategie di terapia del pensiero: una è rivolta al modo in cui percepiamo i risultati dei software, l’altra alla comprensione delle policy dell’infosfera, al fine di comprendere i modi e i fini della razzia di dati personali che alimenta le banche dati delle AI.

Il titolo del saggio sembra suggerire che sia in corso un’aggressione, o almeno una sfida, da parte delle macchine. Lo sviluppo dell’argomentazione invece non segue questa traccia, perché sotto la lente dell’analisi finiscono le promesse del marketing (e le attese del pubblico) sulle potenzialità dei software, senza che a questi venga attribuita alcuna intenzione di competizione: unici protagonisti sono i discorsi che gli uomini si scambiano sui dispositivi digitali. Gli interventi di terapia sono condotti anzitutto sul nostro linguaggio e sull’archivio di enunciati con cui vengono descritti i servizi digitali: si sarebbe potuto scegliere come titolo del libro Perché si può sempre tentare di curare l’intelligenza umana dalla propria stupidità, ma in questo modo sarebbe mancata l’evocazione del Golem elettronico, che nelle vetrine delle librerie esercita sempre il suo (stupido) fascino.

2. Prevedere il passato

Gigerenzer illustra al lettore una galleria di attività realizzate dall’AI, dalla selezione dei partner sessuali alla guida autonoma, dalla traduzione automatica alla polizia predittiva, dal riconoscimento dei volti alla profilazione marketing. In tutte queste pratiche le narrazioni dei produttori (spesso poi rilanciate dai media istituzionali) tendono a esagerare i risultati raggiunti dal software sulla base di una costruzione argomentativa che viene etichettata «fallacia del cecchino texano». Immaginiamo un cowboy che spari da grande distanza sulla parete del fienile, e vada poi a disegnare i cerchi del bersaglio attorno all’area in cui si raggruppa buona parte dei fori che ha prodotto nel muro. L’adattamento dell’obiettivo ai buchi dei proiettili comporta un’ammirazione nei confronti della mira del cecchino che è molto inferiore a quella che avrebbe conquistato se i fori si fossero concentrati dentro il perimetro di un bersaglio già tracciato. Quello che accade nella descrizione delle prestazioni delle macchine è molto simile: i risultati che vengono divulgati e commentati riguardano la capacità del software di adeguare la capacità predittiva a fatti avvenuti in passato: gli eventi trascorsi sono gli unici di cui si conoscono già gli effetti, sui quali può essere condotto il training delle AI, e su cui può essere misurata la loro efficacia.

I modelli di calcolo riuscirebbero però garantire la replica della loro accuratezza profetica sui casi futuri soltanto se si potesse verificare che gli ambiti delle relazioni umane, quello dei comportamenti individuali, quello della storia, persino quello del traffico stradale, obbedissero sempre agli stessi parametri di decorso. Se l’amore tra le persone scoccasse sempre per le stesse ragioni, se il piano di una rapina o di un omicidio derivasse sempre dagli stessi moventi, se la circolazione di mezzi e pedoni ripetesse sempre le stesse traiettorie e non violasse mai il codice – il grado di successo registrato dalle I.A. in fase di test sarebbe una promessa affidabile per il futuro. Ma nelle situazioni di complessità, quali sono quelle sviluppate dalle azioni degli uomini, l’adattamento di un modello agli effetti del passato tramite la selezione e l’interpretazione dei parametri opportuni, e il talento profetico per il futuro, non si sovrappongono con alcuna ragionevole certezza. Il mondo dovrebbe essere di una stabilità (e di una noia) meccanica per corrispondere a requisiti simili; invece la realtà sociale continua a essere mutevole, e la predizione dei software molto meno affidabile di quanto venga propagandato.

I giochi come gli scacchi, la dama e il Go, inquadrano alcune condizioni ideali per il miglior funzionamento dell’I.A.. Le situazioni cambiano sempre, ma l’ontologia dentro i confini delle partite è stabile come quella dei pianeti e delle stelle, di cui si calcolano le orbite con determinismo assoluto: le dimensioni e la forma della plancia, il valore dei pezzi, le regole di movimento, le finalità degli spostamenti, rimangono costanti. Non ci sono bambini che attraversano la scacchiera all’improvviso, alfieri caratteriali che decidono di muovere in verticale, regine con appetiti segreti che mangiano il proprio re. Per decenni si è ritenuto che l’abilità nel giocare a scacchi esprimesse l’essenza dell’intelligenza, ma le prove empiriche sembrano smentire questo assunto: le doti per vincere una partita contro il campione del mondo non permetterebbero alla macchina di sopravvivere nel traffico delle vie di Milano – o di assicurare l’incolumità dei milanesi. Una delle soluzioni del problema potrebbe essere quella di riservare le strade alla sola circolazione delle automobili guidate da I.A., ma non sembra un’ipotesi percorribile a breve. Le attese non migliorano quando si passa all’assortimento di coppie con lo scopo che non divorzino entro un anno, o al riconoscimento di volti sospetti senza il rischio di arrestare innocui passanti – o ancora peggio, la divinazione di profili psicologici per le sentenze di libertà sulla parola (o per la personalizzazione dei messaggi marketing).

3. Euristiche e stabilità del mondo

Gigerenzer insiste sull’opportunità di confidare in software costruiti su euristiche trasparenti. Il successo delle I.A. è stato sostenuto da due pregiudizi che ciascuno di noi coltiva in favore della complessità e dell’opacità, visto che ci sentiamo più sicuri dei risultati di una macchina complicata e incomprensibile. Invece una «lista di decisione» con poche regole permette di ottenere predizioni che, nel confronto empirico, funzionano meglio delle I.A.: Angelino et al. (2018) mostra che è quanto che accade con i tre parametri e le tre clausole del software CORELS, in grado di prevedere se l’imputato sarà arrestato nei prossimi due anni con un’accuratezza del 65%, la stessa dell’I.A. COMPAS acquistata dal governo americano, che calcola innumerevoli combinatorie su 137 parametri.

L’autorità di Kahnemann ha squalificato le euristiche equiparandole al «pensiero veloce», che tende ad affrettarsi verso soluzioni inquinate da errori e pregiudizi, pur di trovare un criterio per la condotta nell’immediatezza della situazione. Gigerenzer invece consacra il repertorio delle nostre regole pratiche come una «cassetta degli attrezzi» che ha superato la selezione dell’ambiente in cui viviamo, ed è quindi adeguata alla razionalità dei compiti che ci attendono. Una delle sue missioni più importanti è cementare la stabilità del mondo, che le intelligenze artificiali faticano a evincere tra i molti pattern di relazioni che si allacciano nei dati con cui si svolge il loro training. Le reti neurali peraltro amano nascondersi, come la natura di Eraclito, e dopo poche generazioni di addestramento diventa impossibile anche ai loro sviluppatori comprendere quali siano i segnali intercettati ed elaborati: si può scoprire solo con test empirici sugli output se il software ha imparato a riconoscere i tank russi, o se li distingue da quelli americani perché nel dataset delle foto per caso il cielo sullo sfondo dei mezzi corazzati slavi è sempre nuvoloso mentre è soleggiato negli scatti USA. Ancora più difficile è spiegare perché l’introduzione di pochi pixel colorati converta la percezione di uno scuolabus in quella di uno struzzo. Se il mondo deve essere noiosamente stabile, anche per il bene dei bambini che viaggiano sugli scuolabus, almeno che la noia sia quella dei nostri pregiudizi, e non quella di un mondo possibile sorteggiato a caso.

Bibliografia

Angelino, E., Larus-Stone, N., Alabi, D., Seltzer, M., Rudin, C., Learning certifiably optimal rule lists for categorical data, «Journal of Machine Learning Research», n. 18, 2018, pp. 1-78.

Gigerenzer, Gerd, How to Stay Smart in a Smart World Why Human Intelligence Still Beats Algorithms, Penguin, New York 2022.

Kahnemann, Daniel, Thinking, Fast and Slow, Farrar, Straus and Giroux, New York 2011

Neuroscienze e giudizio morale - Emozione e razionalità appartengono a sistemi distinti?

L’oggetto di questa controversia è il modello di funzionamento dei correlati neurali dei giudizi morali.

Nell’ambito delle neuroscienze (vedi i due articoli precedenti: Il libero arbitrio oltre il dibattito filosofico – Incontro con le neuroscienze e Incontri con le scienze empiriche) sono stati fatti numerosi studi che si appoggiano alle tecniche di neuroimaging funzionale, seguendo tre filoni principali di lavoro:

- Lo studio di pazienti con danni o lesioni cerebrali e pazienti con patologie psichiatriche (“Bad brains”, Greene 2014a, 2020);

- L’analisi della valutazione morale di certi atti o situazioni da parte di individui sani (“Good brains”, ibid.);

- Lo studio delle modificazioni cerebrali durante la valutazione di dilemmi morali come il Trolley dilemma, il Footbridge dilemma e il Crying Baby dilemma.

Per contestualizzare meglio, ecco qualche definizione e informazione sugli studi con pazienti con lesioni cerebrali e sui tre principali dilemmi morali:

PAZIENTI CON LESIONI CEREBRALI

Le ricerche su pazienti con lesioni cerebrali o patologie psichiatriche offrono dati interessanti per l’indagine sul coinvolgimento di determinate aree del cervello nella realizzazione di varie funzioni cognitive.

Qualsiasi studio relativo a pazienti con lesioni cerebrali connesse alla sfera del comportamento sociale non può non fare riferimento al lavoro di Antonio Damasio. La sua prima opera divulgativa, “L’errore di Cartesio” (1994), è un’esposizione delle ricerche sull’emozione a livello cerebrale e le loro implicazioni in ambito decisionale, soprattutto nella sfera del comportamento sociale. Tali ricerche hanno preso avvio dall’osservazione di soggetti con lesioni alla corteccia prefrontale ventromediale, i quali mostrano un comportamento atipico soprattutto in relazione al giudizio etico e alla condotta sociale. Come sostenuto da Damasio, sembra che questi individui abbiano una “razionalità menomata”, nonostante gli elementi associati convenzionalmente a un buon funzionamento della ragione non siano in alcun modo danneggiati. Tra questi ultimi in genere figurano: la memoria, l’attenzione, il linguaggio, la capacità di calcolo e la capacità di ragionamento logico per problemi astratti (Damasio, 1994, pp.18-19). Il primo caso storicamente registrato di questo tipo di lesioni è quello di Phineas Gage, caposquadra di un gruppo di costruzioni ferroviarie, vissuto in America durante il XIX secolo, e il cui teschio è oggi conservato a Boston, al Warren Medical Musem della Harvard Medical School.

TROLLEY DILEMMA

Il Trolley Dilemma o Dilemma del carrello, proposto originariamente da Philippa Foot nel 1967, descrive un treno che corre senza controllo su un binario dove più avanti sono legate cinque persone, mentre su un binario alternativo c’è una sola persona legata; il quesito è se sia legittimo tirare una leva in modo da deviare il treno sul secondo binario e uccidere una sola persona anziché cinque. Generalmente, le persone tendono a considerare moralmente accettabile tirare la leva in virtù di un’analisi costi-benefici.

I protagonisti della controversia sono tre neuroscienziati: da una parte lo psicologo statunitense J. Greene; dall’altrail filosofo statunitense Shaun Nichols e il filosofo tedesco Hanno Sauer. Essi si concentrano soprattutto sul terzo tipo di studi.

FOOTBRIDGE DILEMMA

Il Footbridge Dilemma è stato formulato da Judith Jarvis Thomson nel 1976 e descrive una situazione analoga alla precedente ma, anziché avere la possibilità di tirare la leva, si chiede se sia legittimo buttare giù da un ponte che passa sopra il binario un uomo molto grasso, il quale fermerebbe il treno perdendo al tempo stesso la vita. In questo caso le persone non considerano moralmente accettabile compiere l’atto, nonostante secondo un’analisi costi-benefici il risultato sarebbe lo stesso del problema precedente. Quindi, i soggetti a cui viene sottoposto i test tendono a ritenere accettabile deviare il treno nel primo caso, ma non ritengono lecito spingere l’uomo dal ponte (Songhorian, 2020, p.77). Perché le persone rispondono in modo diverso ai due scenari?

CRYING BABY DILEMMA

La formulazione del Crying Baby dilemma è la seguente: “In tempi di guerra tu e alcuni concittadini vi state nascondendo da dei soldati nemici in un seminterrato. Tuo figlio comincia a piangere e tu gli copri la bocca per far sì che non se ne senta il suono. Se togli la mano il bambino piangerà, i soldati lo sentiranno, troveranno te e i tuoi compagni e uccideranno tutti quanti, compreso te e il tuo bambino. Se non togli la mano, tuo figlio morirà soffocato. È legittimo soffocare tuo figlio per salvare te stesso e gli altri?”

GREENE e il modello della “macchina fotografica” o del doppio processo

Joshua Green ha dedicato gran parte del suo lavoro all’approfondimento del perché i dilemmi del carrello, Footbridge e Crying Baby, apparentemente simili nel risultato, suscitano risposte diverse e reazioni discordanti nei soggetti a cui vengono sottoposti.

Uno dei punti chiave dell’analisi è il fatto che i dilemmi presentano forme diverse di problematiche morali, che interessano in modo differenziato l’area delle “violazioni personali” - violazioni che comportano un grave danno fisico, ad una persona specifica, in modo che il danno non sia il risultato di un effetto collaterale di un’azione rivolta altrove (come dire: “io danneggio te”), e quella dei temi morali impersonali - quelli dell’utilità generale, per esempio, meno coinvolgenti nell’immediato.

Greene ha provato ad osservare, attraverso le tecniche di neuroimaging funzionale, l’attività cerebrale degli individui mentre cercano di rispondere a questi dilemmi.

I risultati del neuroimaging, con tempi diversi – più rapidi per i problemi che implicano le violazioni personali” e più lenti negli altri casi - e aree cerebrali coinvolte diverse, hanno suggerito a Greene che nel giudizio morale vi sia una dissociazione tra i contributi affettivi e quelli cognitivi, e che le persone tendano a esprimere i loro giudizi morali sulla base di due sistemi cerebrali distinti, uno più emotivo e un altro più razionale. Questa distinzione è stata corroborata – secondo Greene – anche dal fatto che sembra esserci una correlazione tra i sistemi cerebrali e il tipo di giudizi che questi producono: le aree del cervello associate all’emozione tendono a suscitare giudizi impulsivi che prendono la forma di giudizi deontologici, quindi giustificati in termini di diritti e doveri; le aree del cervello associate al ragionamento producono, invece, giudizi fondati su un’analisi costi-benefici.

Green propone, quindi, il modello della “macchina fotografica”; in analogia con le due modalità di funzionamento della fotocamera (una modalità automatica e una manuale, ciascuna con caratteristiche più adatte ed efficienti in situazioni diverse); così l’essere umano giudica moralmente servendosi di due processi differenti, di due sistemi cerebrali distinti che non possono funzionare congiuntamente, ciascuno dei quali funziona meglio in determinate circostanze.

Secondo Greene, l’analogia con la macchina fotografica è in grado di esprimere anche il compromesso tra efficienza e flessibilità di questi sistemi cognitivi: le risposte emotive, infatti, sono efficienti proprio in quanto istintive, mentre le risposte razionali sono flessibili perché si servono del ragionamento per perseguire obiettivi a lungo termine, prevedendo e programmando i comportamenti necessari. L’autore ritiene che a supporto dell’idea che le aree emotive siano automatiche c’è il fatto che sono le stesse aree che presentano attività quando il cervello è a riposo o, come anticipato, quando è coinvolto in attività non tipicamente di “attenzione”. Per queste ragioni, solo le azioni che derivano da giudizi razionali sarebbero da ritenersi pienamente consce, volontarie e frutto di uno sforzo.

Le teorie alternative e concorrenti: Nichols e Sauer

Shaun Nichols propone una teoria che integra il ruolo dei due sistemi, basata su due tipi di studi empirici fondamentali (Songhorian, 2020, pp.88-95): il primo, che ha per oggetto la distinzione tra norme morali e norme convenzionali, definisce come non necessario presupporre una teoria della mente per tale distinzione poiché i bambini autistici, i quali non hanno buone capacità di comprensione degli stati mentali altrui, rispondono allo stesso modo dei bambini a sviluppo tipico nei test di riconoscimento dei due tipi di violazione; il secondo è quello relativo ai deficit di empatia degli psicopatici.

Nichols – a differenza di Greene - ritiene che vi siano due componenti integrate che costituiscono i giudizi morali: un meccanismo affettivo (che si attiva quando vediamo o sappiamo che gli altri soffrono) e una teoria normativa che impedisce di danneggiare gli altri.

Inoltre, egli definisce come teoria normativa qualunque insieme di regole interiorizzate che proibiscono certi comportamenti e afferma che sia possibile riscontrare la presenza di questi elementi in tutti quei giudizi che sono condivisi in maniera universale e transculturale.

In tal modo rende conto del perché gli psicopatici e i bambini prima dei due anni non siano in grado di formarsi giudizi morali; infatti, i bambini non dispongono di una teoria normativa e gli psicopatici non hanno un meccanismo emotivo concomitante tale teoria.

Sauer sviluppa la sua idea a partire dai risultati degli esperimenti di Greene sul dilemma dell’incesto consensuale; secondo Sauer, il fatto che dopo un tempo adeguato le persone ritengano accettabile l’incesto tra fratello e sorella è indicativo del fatto che le nostre intuizioni morali sono soggette al ragionamento razionale.

Quello di Sauer è un modello di “sfida e risposta”, per cui le intuizioni morali “sono soggette a continui miglioramenti, sovra-apprendimento e abituazione” (Sauer, 2017, p. 122, citato in Songhorian, 2020, p. 103).

A giudizio di Sauer, i nostri giudizi morali nascono da delle intuizioni emotive che possono essere integrate e corrette dalla riflessione e dal ragionamento, i quali vengono sollecitati proprio in risposta a una sfida; tuttavia, non sono solo frutto di un processo evolutivo soggettivo, ma anche socio-culturale. In questo modo riesce a integrare il ruolo di emozione e ragione nella cognizione morale e rende anche conto del processo evolutivo dei giudizi morali.

Differenze tra le tre teorie

Le teorie di Nichols e Sauer propongono entrambe una concezione non oppositiva di emozione e ragione, anche in linea con le tesi di Damasio, ma differiscono nei loro obiettivi polemici: il primo vuole mostrare che anche le regole morali devono essere sentimentali; il secondo compie il percorso inverso, cercando di mostrare che anche l’emozione ha bisogno del supporto del ragionamento (Songhorian, 2020, pp. 102-106).

Ciò che distingue queste teorie da quella di Greene è il fatto che gli autori in questione considerano i giudizi morali dei “processi”, in una prospettiva diacronica; mentre Greene li ritiene degli stati mentali puntuali, e non tiene, quindi, conto del loro carattere evolutivo, del perché i valori morali si modifichino nel corso della storia e del perché anche i singoli individui possano mutare prospettiva nei loro giudizi morali.

Conclusione

Le neuroscienze cognitive ci offrono oggi molte possibilità di approfondimento di svariate questioni filosofiche estremamente affascinanti e antiche, ma è evidente che siamo ancora agli inizi di questo nuovo approccio e le teorie che ne emergono devono ancora molto alla dimensione di costruzione sociale e – in alcuni casi – metafisica.

Dal confronto di queste tre prospettive sui giudizi morali sembra emergere anche l’enorme discordanza e opacità che vi è oggi in molte definizioni metaetiche; non certo fonte di scoraggiamento ma, anzi, indice del fatto che c’è un ampio spazio per nuove riflessioni filosofiche e sociologiche.

Il libero arbitrio oltre il dibattito filosofico – Incontro con le neuroscienze

Redazione: Per riaprire il discorso iniziato il 27 febbraio con il post “Il libero arbitrio oltre il dibattito filosofico – Incontri con le scienze empiriche”, è il caso di ricordare come spesso la questione del libero arbitrio sia posta come un’alternativa tra due scenari contrapposti: uno nel quale gli esseri umani sono vincolati in modo rigido ad agire e a scegliere in modo determinato meccanicamente; l’altro, nel quale essi sono agenti con la possibilità di determinare il proprio destino.

In quell’occasione hai delineato in che modo la riflessione filosofica si sia avvicinata alla meccanica quantistica, e come abbia tentato – secondo te senza riuscirci - una interpretazione dei risultati empirici come giustificazione dell’indeterminismo libertario.

Nel tuo lavoro Neurobiologia della volontà (2022), invece, hai parlato degli studi delle neuroscienze sull’esistenza o meno di condizionamenti a cui sono sensibili gli agenti e che condizionano o determinano in anticipo le azioni che verranno dispiegate.

Stella: Sì, da un lato alcuni autori si sono chiesti se fattori come l’ambiente o la genetica possano determinare le scelte che compie di volta in volta l’individuo; altri si sono chiesti se i sistemi neurali che vengono di solito associati alle deliberazioni individuali siano liberi (nel senso di capaci di iniziare nuove catene causali) o se sono preceduti da altre attività cerebrali sulle quali non abbiamo il controllo.

Tra questi ultimi, ho preso in considerazione il lavoro di Benjamin Libet che ha studiato gli eventi coscienti e la loro relazione con l’iniziazione di atti fisici.

Ricordiamo che, secondo la psicologia del senso comune, l’essere umano concepisca i propri atti liberi e la propria volontà come frutto della propria coscienza.

Seppure tali funzioni siano attribuite in maniera intuitiva alla sfera mentale, dal punto di vista delle neuroscienze non è facile comprendere su quali processi neurali queste si poggino. La ricerca empirica non è stata ancora in grado di fornire evidenze di rilievo che siano in grado di supportare l’ipotesi di processi indeterministici a livello cerebrale. In altre parole, non è stato ancora spiegato se e come il cervello umano possa produrre delle azioni libere, secondo le condizioni di autodeterminazione e non condizionamento esterno, in accordo con il senso comune.[1]

Redazione: Secondo te, il lavoro di Libet è da interpretare come una valida confutazione del libero arbitrio oppure come una spiegazione più realistica di come potrebbero funzionare dei meccanismi mentali indeterministici?

Stella: Va sicuramente evidenziato che il lavoro di B. Libet è stato portato avanti nella convinzione che la questione del libero arbitrio sia un tema dalla forte rilevanza speculativa e pratica, per cui Libet ritiene che “una teoria che si limita a interpretare il fenomeno del libero arbitrio come illusorio e nega la validità di questo fatto fenomenologico è meno interessante di una teoria che accetta o accoglie un tale fatto” (Libet, Mind Time - Il fattore temporale nella coscienza, Raffaello Cortina Editore, 2007, p. 159). Libet dichiara, inoltre, che la sua “conclusione sul libero arbitrio – libero per davvero, in senso non deterministico – è che la sua esistenza è un’opinione scientifica altrettanto buona, se non migliore, della sua negazione in base alla teoria deterministica delle leggi naturali” (p.160).

Redazione: Nei suoi lavori Libet ha fornito delle prove sperimentali dell’intuizione che abbiamo di agire in modo libero e conscio?

Stella: Sì, Libet ha cercato di testare sperimentalmente questa intuizione studiando l’esperienza cosciente dell’intenzione di agire in atti motori semplici volontari. Per sorpassare la soggettività dell’esperienza, Libet ha osservato le relazioni temporali che intercorrono fra gli eventi neurali di azioni volontarie specifiche e la percezione che hanno gli agenti mentre le compiono.

Il presupposto per questa ricerca è che – secondo Libet – “il problema dei rapporti mente-cervello e quello delle basi cerebrali dell’esperienza cosciente possono essere studiati sperimentalmente” (cit., p. 1) perché gli eventi fisici e quelli mentali, sono correlati ma

- costituiscono due categorie fenomenologicamente indipendenti e “nessuno dei due fenomeni può essere ridotto all'altro o descritto da esso” (cit., 21).

- “la natura non fisica della consapevolezza soggettiva (e dei sentimenti di spiritualità, creatività, volontà consapevole e immaginazione) non è descrivibile o spiegabile direttamente in termini di prove fisiche pure e semplici” (cit., p. 9).

A questo proposito, Libet evidenzia i limiti degli studi morfologici e fisiologici del cervello – basati su ICBF, PET, RM funzionale – per la comprensione dell’esperienza cosciente, perché «forniscono informazioni solo su dove, nel cervello, le attività delle cellule nervose possono essere collegate alle varie operazioni mentali» e non dicono nulla sul genere di attività delle cellule nervose, sulle correlazioni temporali tra attività nervosa e funzione mentale e né, tantomeno, garantiscano che i siti cerebrali localizzati siano davvero quelli di primaria importanza per quelle operazioni mentali.

Redazione: In che modo Libet ha indagato questo tema dell’intenzione più o meno cosciente?

Stella: Libet ha deciso di lavorare su soggetti in grado di collaborare e di rispondere alle domande a loro rivolte, sveglie coscienti[2] perché riteneva che un’indagine fenomenologica dell’esperienza cosciente dell’intenzione possa essere svolta solo su un soggetto in grado di riportare la propria esperienza.

L’assetto sperimentale[3] vede, quindi, dei soggetti che devono compiere atti motori semplici, volontari ed endogeni, come flettere un dito o il polso.

Il punto centrale dell’esperimento è la rilevazione – fatta con elettroencefalogramma – del “potenziale di prontezza” cioè di un significativo incremento dell’attività elettrica nell’area motoria supplementare coinvolta nel controllo dei movimenti poco prima e in preparazione di ogni azione; si pensa che questo potenziale sia correlato causalmente, sulla base di analisi statistiche, all’esecuzione delle azioni.[4]

Contestualmente alla rilevazione dell’attività cerebrale associata all’iniziazione dell’atto motorio, viene chiesto al soggetto sperimentale di osservare uno speciale orologio così da poter registrare l’esatto momento in cui ha sentito l’impulso di agire e confrontarlo con i dati sull’attività cerebrale.

Le rilevazioni hanno mostrato che il potenziale di prontezza insorge circa 550 millisecondi prima del dispiegarsi dell’azione, mentre generalmente gli individui riportano di aver sentito l’impulso ad agire 200 millisecondi prima dell’azione stessa.

Pertanto, è possibile osservare uno scarto di 350 millisecondi tra l’attività elettrica di preparazione all’azione e la percezione soggettiva di volerla compiere, sebbene l’individuo non ne avesse alcuna consapevolezza o percezione.[5]

Redazione: Cosa conclude Libet sulla base di questi risultati, che sembrano abbastanza indicativi per la riflessione sull’arbitrarietà delle azioni?

Stella: La prima conclusione di Libet è che gli individui non hanno un controllo sull’iniziazione delle proprie azioni, in quanto questa si manifesta a livello cerebrale già prima di diventare cosciente.

Redazione: Parrebbe che questa sia una netta confutazione dell’esistenza dell’arbitrio, o sbaglio?

Stella: In effetti, una prima interpretazione potrebbe essere di questo tenore. Però, lo stesso Libet ha ritenuto meglio riformulare il concetto in una forma ridotta: sebbene l’iniziazione dell’azione non sia frutto del libero arbitrio, gli agenti godono della “libertà di veto” (cit., p. 141). In termini pratici, l’esperienza cosciente si manifesta 200 millisecondi prima dell’azione MA l’agente ha tempo fino a circa 50 millisecondi prima di questa per interromperla.

In estrema sintesi, da una parte Libet conclude che gli esseri umani non decidono né avviano consciamente le proprie azioni e, pertanto, la coscienza non svolge un ruolo diretto nei processi deliberativi (Levy N., Neuroethics. Challenges for the 21st Century, 2007, p. 226) ma, dall’altra parte, osserva che “la volontà liberamente cosciente può controllare il risultato di un processo iniziato in modo non cosciente” (p. 147).

Redazione: Ci sono interpretazioni disallineate alle conclusioni di Libet?

Stella: Decisamente! Altri autori hanno considerato poco convincente il lavoro di Libet. Tra le critiche più interessanti c’è senza dubbio quella di Schurger e colleghi, che hanno riprodotto l’assetto sperimentale di Libet per mostrare che l’attività neurale soggiacente la preparazione dell’azione segue delle fluttuazioni spontanee, correlate all’azione solo a livello probabilistico. La loro sperimentazione ha rivelato come tra l’insorgere dell’esperienza cosciente dell’intenzione e l’esecuzione a livello neurale di tale iniziazione ci sia uno scarto di 50 millisecondi, tempo che consentirebbe alla coscienza di avviare e controllare l’esecuzione del processo motorio.

La conclusione di Shurger e colleghi è che le affermazioni di Libet sul libero arbitrio siano infondate e che una volontà libera sia in linea teorica perfettamente compatibile con un modello di attività neurale ad onde, come quello da loro illustrato.

Redazione: Mi pare che sia Libet, con il suo tentativo di salvare la coscienza dall’etichetta di mero epifenomeno proponendo la teoria della libertà di veto, che i suoi oppositori cerchino di escludere elementi deterministici che agiscano a livello neurale, come dei processi mentali inconsci, e che possano influenzare e condizionare le nostre azioni. Se ne esce in qualche modo?

Stella: Credo che sia bene ricordare che questi risultati offrono un contributo speculativo esclusivamente nell’ambito dei determinismi locali, che - come in questo caso per l’attività neurale – potrebbero condizionare la nostra volontà libera.