Conversazioni sull’I.A. – Corpo e diritto all'integrità

Redazione di Controversie: Riprendiamo il dialogo con Riccardo Boffetti e Paolo Bottazzini sulla soggettività delle intelligenze artificiali, là dove l’abbiamo lasciato il 16 gennaio (Conversazioni sull’Intelligenza Artificiale – Si prova qualcosa ad essere una macchina?), con la domanda che era rimasta in sospeso.

Per riconoscere ad una IA generativa come, ad esempio, Chat GPT, il diritto all’integrità è obbligatorio che sia incorporata in un robot?

Le altre istanze, quelle esclusivamente dialoganti che troviamo sul web, non hanno diritto a questo riconoscimento?

Riccardo: La risposta a questa domanda credo sia sì, per una serie di motivazioni. Credo, innanzitutto, che buona parte della questione si risolva nel fatto che il modo con cui agiamo nel mondo non può che essere antropocentrico e situato, appunto, nel mondo: non siamo (ancora?) degli esseri digitali, piuttosto siamo (ancora) esseri nel mondo. La scala temporale con cui esperiamo ogni situazione è difatti ben definita dalle nostre esperienze terrene e, accantonando per un attimo la velocità dell’immaginazione, questa si esprime in tempi ben più lunghi di quelli dell’elaborazione digitale odierna.

Ciò di cui abbiamo bisogno per poter anche solo concettualmente prendere in considerazione un’inclusione all’interno della sfera della legge di nuovi soggetti è appunto che essi agiscano su una scala temporale a noi comune o che, quantomeno, e in quanto collettivo, si sia in grado di concepire il dispiegarsi delle loro azioni.

Motivo per il quale abbiamo difficoltà sia nel concepire la questione del riscaldamento climatico sia nel prendere atto dell’agentività delle miriadi di specie vegetali e fungine.

Ecco, allora, che l’instanziazione, l’incorporazione, all’interno di un robot, possibilmente non umanoide, può creare quell’orizzonte comune necessario per la costruzione di un collettivo. È proprio il suo agire nel mondo che rende passibile l’hardware e il software di una rappresentazione giuridica: attenzione, non l’hardware e il software di per loro ma ciò che il resto dei partecipanti al collettivo (e cioè gli umani) vedono e possono interpretare come azioni simili alle loro.

Certo, ci rimane sempre l’immaginazione per concepire le esistenze di algoritmi non incorporati in robot. Alexander Laumonier lo fa bene in una sua ricostruzione del mercato dell’HFT (High-Frequency Trading), dove i famosi pit fisici del Chicago Board of Trade sono diventati deserti a favore di un gran movimento nella sfera digitale:

Gli squali allora potranno divertirsi come pazzi. «Che cos’è questa cosa?», domanderà il nipote di un ricco pensionato americano quando uno yacht incrocerà un’isola artificiale zeppa di tecnologia ultramoderna. «È la Borsa», risponderà il nonno, magari un attimo prima che un algoritmo selvaggio riduca a zero la sua pensione.

Probabilmente non potrò mai lavorare su una di queste isole galleggianti. Da qui ad allora gli algoritmi saranno diventati talmente complessi che io sarò ormai solo un vecchio dinosauro.

Per il momento mi accontento di fare il mio lavoro. Sono già le 9.30, e il New York Stock Exchange sta aprendo.

La quiete del mio ufficio climatizzato contrasta con la guerriglia alla quale dovrò prendere parte tutto il giorno, in compagnia di Iceberg, Shark, Blast, Razor e tutti gli altri.

Devo essere vigile, perché probabilmente dovrò sparare un colpo già alle 09:30:00:000:001, GMT-5.

Conto con attenzione i secondi che mi separano dall’apertura dei mercati, poi i millisecondi, i microsecondi, i nanosecondi, sei, cinque, quattro, tre, due, uno, bingo» (6 | 5, 2018).

Come inquadrare, però, nella sfera del diritto simili entità? È chiaro il luogo in cui, e su cui, il diritto può agire è tutto l’ecosistema macchina-macchina che viene a crearsi ad essere , piuttosto che l’integrità dei singoli algoritmi. Quando si parla, però, di agenti autonomi nella sfera terrena mi pare che l’argomento diventi meno controverso da affrontare, proprio in luce del fatto che la loro individuazioni ci appare chiaramente davanti a tutti i nostri sensi.

Paolo: Quando la domanda è stata formulata, mi sarei aspettato da Riccardo una replica coerente con il suo antisciovinismo antropologico: i diritti vanno estesi alle intelligenze non umane, anzi non biologiche, quindi a tutte le intelligenze in generale.

Invece, la sua risposta distingue tra intelligenze veicolate da hardware zoomorfi e intelligenze che agiscono senza essere semoventi. Le sue argomentazioni sono in ogni caso sensate e condivisibili, quindi mi limiterei a osservazioni laterali.

La posizione di Riccardo è condivisibile se si accoglie la prospettiva fenomenologica di Merleau Ponty (1945, Fenomenologia della percezione): l’intelligenza non è solo una questione di calcolo logico, ma è, anzitutto, la regola dell’azione di chi frequenta il mondo come un’esplorazione precategoriale di orizzonti di senso. Mondo e corpo proprio cospirano a formare questo cosmo di significati, prima di qualunque operazione costitutiva dello spirito, e prima che l’universo si presenti già cristallizzato in oggetti. In questi termini, il possesso di un corpo è un attributo necessario non solo per l’intelligenza umana, ma per l’intelligenza in generale. Purtroppo, però, al momento, le intelligenze attive nei robot non contano sul loro hardware nel modo in cui gli uomini ineriscono al mondo con il loro corpo. Il software infatti compie calcoli in tutte le dimensioni che la fenomenologia assegna all’intenzionalità fungente: la conversione dell’AI alla lebenswelt è al limite una prospettiva, o un ottativo, rivolto all’evoluzione futura.

È possibile, poi, che un aspetto zoomorfo renda più incline il pubblico umano a riconoscere un diritto di inviolabilità alle macchine: da un punto di vista psicologico, la percezione di qualche affinità potrebbe aggiungere commozione all’istanza normativa. A questo proposito però un sociologo ispirato ai principi dell’ANT, come Bruno Latour (2005, Riassemblare il sociale), osserverebbe che robot e intelligenze artificiali sono già iscritte in reti di pratiche, di domini di significato, di associazioni, in cui il riconoscimento di un nuovo diritto irromperebbe come una detonazione, o l’invasione di un corpo alieno. L’esame del modo in cui le diverse forme di intelligenza artificiale e di meccatronica collaborano a formare i gruppi sociali dell’industria, della ricerca accademica, dell’hacking, ecc., dovrebbe precedere l’elaborazione di una normativa che regoli la convivenza dei robot con gli altri attori sociali. Ma si tratta di un tema ampio che dovrà essere ripreso.

Redazione: Grazie a entrambi una volta di più. Il tema, suggerito da Riccardo, dell’incorporazione dell’intelligenza artificiale nella dimensione temporale apre un terreno di confronto assolutamente nuovo per questa questione; la riflessione di Paolo - che richiama Merleau-Ponty sulla necessità dell’intelligenza di “contare sul proprio corpo” sembra rinforzare e mettere a terra l’ipotesi di Riccardo.

Ma cosa ne pensa chi l’Intelligenza Artificiale la vede anche nella sua dimensione operativa, pratica? Nella prossima conversazione partiremo da alcune riflessioni di Alessio Panella che sottolinea il necessario dubbio sull’autocoscienza di macchine senza corpo.

Immagine analogica ed Intelligenza Artificiale - Due mondi apparentemente distanti

Questo post nasce dal seminario tenuto da Diego Randazzo, artista visivo, sul tema “Immagine analogica ed Intelligenza Artificiale. Due mondi apparentemente distanti”.

Randazzo ha illustrato alcune funzionalità dei sistemi dialogativi di Intelligenza Artificiale text-to-image come, ad esempio Dall-E o Midjourney, nella generazione di immagini partendo da altre immagini o da una serie di specifiche dettate su una linea di comando.

Queste peculiari funzionalità della IA generativa permettono ad un artista di far generare ai sistemi delle immagini su cui poi intervenire per creare lavori del tutto personali. Oppure, dà la possibilità di generare anche immagini ibride, come, a titolo di esempio, quella di una tavolata che meticci l’Ultima cena di Leonardo da Vinci e le tavole da pranzo di Vanessa Beecroft.

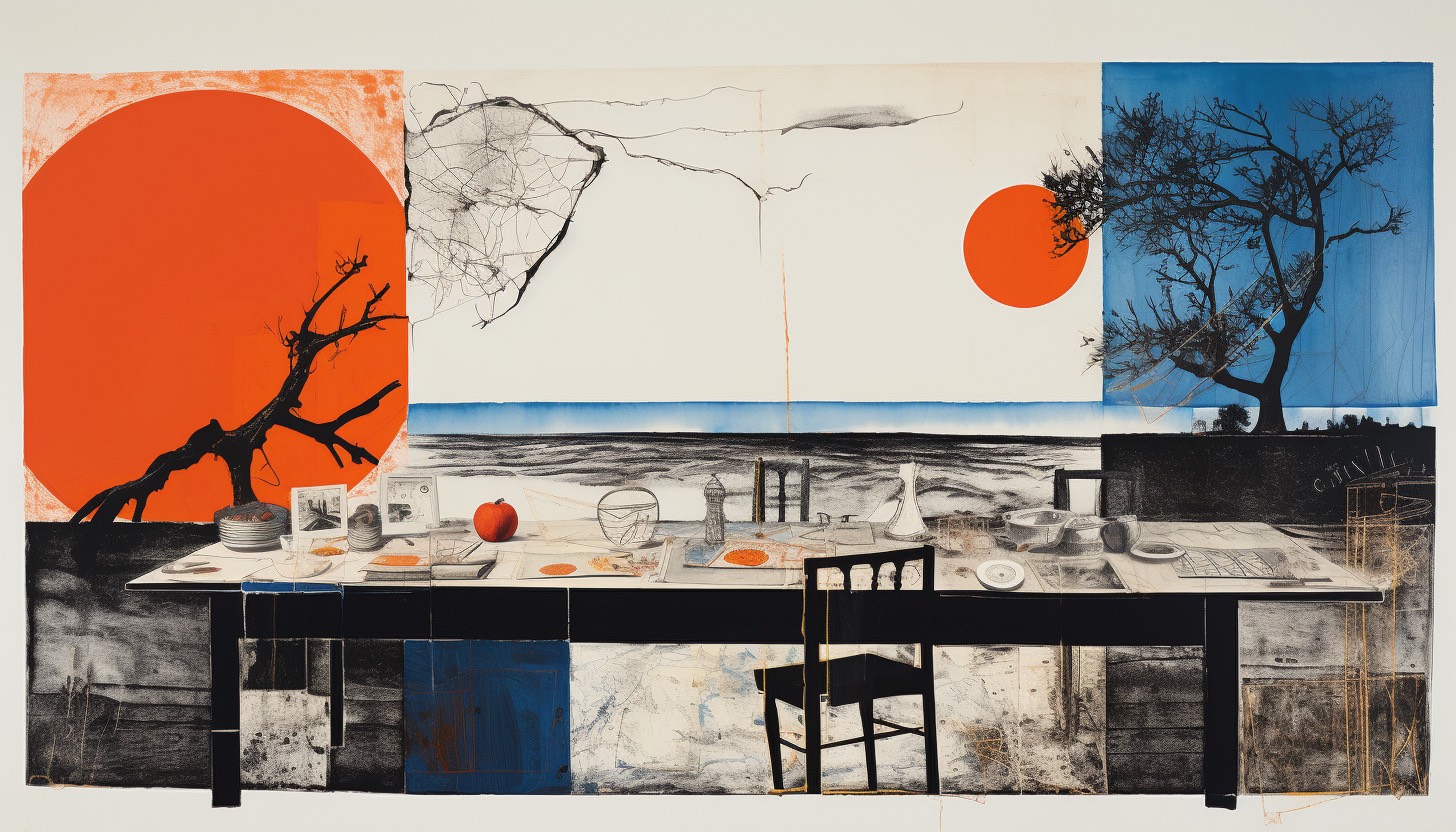

Questi di seguito sono esempi generati in tempo reale durante il seminario:

Comando:

Ultima cena di Leonardo, tavola da pranzo Vanessa Beecroft

Comando:

Ultima cena di Leonardo e Les Demoiselles D'Avignon di Picasso

Comando:

Un Pollock ed un Mondrian

La narrazione e gli esempi hanno suscitato una serie di interrogativi sulle nozioni caratteristiche del discorso artistico, in termini epistemologici e filosofici, interrogativi a cui Randazzo risponde in questo articolo.

--------

Paolo Bottazzini: La possibilità di derivare da regole statistiche un'istanza visiva o sonora, la rende un'opera d'arte o un modello possibile per un'opera d’arte?

Diego: Io parlo spesso di reference, di approccio critico e di didattica. Questi fanno parte dell’opera d’arte, ma sono solo alcuni degli elementi che dovrebbero scaturire da un’opera d’arte.

Parallelamente si può tranquillamente dichiarare, che la generazione di un’immagine con l’AI è l’inizio di un processo che può portare alla creazione di un’opera, ma non è esaustivo.

E penso - scusate la provocazione - che questo discorso valga per tutti quegli strumenti che nel corso della storia sono stati designati come strumenti a disposizione dell’artista: matita, pennello, sgorbia, scalpello, macchina fotografica, cinepresa, videocamera, computer.

Infine, le regole statistiche a cui accennate, non possono essere controllate dall’utente che, forzatamente, si deve accontentare dei risultati ricevuti. Questo mi ricorda un po’ il gioco di matrice surrealista denominato Cadaveri squisiti (cadavre exquis), a mio parere contributo fondamentale alla definizione di collage. Non stiamo in fondo parlando di questo? Associazioni e combinazioni testuali e visive, spesso incontrollate e provenienti da fonti diverse.

Quindi la descrizione che suggerite mi sembra appropriata, aggiungendo un trattino: l’AI come modello-strumento possibile per creare un'opera d’arte. Ci sono diverse modalità di utilizzo dell’AI per creare immagini; tra tutte credo sia molto affascinante la funzione che permette di espandere un ‘immagine preesistente, caricata nel software di AI.

Il ‘riempimento generativo’, lo considero una sorta di strumento conoscitivo, che a partire da qualcosa di personale (es. un’immagine dell’autore) permette di amplificare ed espandere l’universo visivo dell’autore stesso.

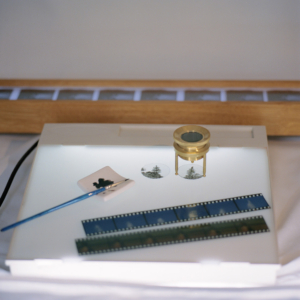

Riporto qui di seguito uno dei primi esperimenti realizzati con Dall-E a partire da alcune fotografie realizzate in pellicola medio formato (estratte del mio progetto Illusorie visioni d’argento del 2018). La prima immagine è lo scatto originale, le successive sono le espansioni generate con l’AI. E’ evidente come il rapporto che si instaura tra originale e rielaborazione AI è molto significativo, c’è una forte connessione tra due mondi che tendenzialmente teniamo separati. Qui, la concretezza del manufatto analogico e l’intangibilità dell’immagine sintetica si toccano e diventano un tutt’uno.

Lenti d’ingrandimento in ottone, becher, pellicole di piccolo e medio formato, macchine fotografiche analogiche… a questi oggetti/soggetti provenienti dal mondo proto-fotografico sono accostati altri della natura più varia (frutta e verdura imprecisata, gelatina alla menta, piante, droni, congegni elettrici, elettronici, digitali ed immagini olografiche) disposti su improbabili limbi e tavoli da lavoro componendo un eterogeneo repertorio di composizioni panoramiche. Ad una prima occhiata ci paiono dei set fotografici che strizzano l’occhio all’ambito still-life, ma avvicinando lo sguardo qualcosa non funziona. Il progetto "Elegie dell'impossibile verosimile" è un’inedita opera meta-fotografica, non ancora pubblicata, che esplora la relazione tra mondo analogico e digitale. Ogni composizione è creata a partire da uno scatto in medio-formato e successivamente combinata con altre immagini generate con il software di intelligenza artificiale Dall-E 2, che analizza un testo descrittivo e genera immagini corrispondenti. Il lavoro sperimentale affronta il tema dell'autenticità delle immagini nella contemporaneità, considerando la macchina come una possibilità di estensione poetica dell'immaginario dell’artista.

Di seguito, alcune immagini tratte da Illusorie visioni d’argento (2018), dove la prima immagine è lo scatto originale, eseguito con pellicola fotografica di medio formato, e la seconda è l'espansione dell’immagine realizzata con Dall-E.

Non a caso, nel corso del seminario di Controversie, puntavo proprio a delineare un percorso di analisi che intravede nell’immagine analogica l’antecedente concettuale della funzione generativa nell’AI.

Il mio punto di vista, sicuramente non allineato alle maggiori correnti di pensiero sul fenomeno, vuole dimostrare che alcune tendenze visuali attuali dell’AI (la dimensione distopica, disturbante, deformante da una parte e la tendenza del vintage dall’altra) non solo sono vicine, ma sono in perfetta continuità con il mondo analogico e protofotografico.

Ecco alcune linee guida, per punti, che sono state oggetto di discussione durante il seminario:

L’immagine analogica ed un certo uso dell’Intelligenza Artificiale hanno in comune la sorpresa, il mistero e la casualità. Sorpresa e mistero erano già presenti nei congegni del Precinema (le vedute ottiche dei Mondi Nuovi, vetrini e lanterne magiche, fenachistoscopi, zootropi, mutoscopi e diorami).

La sorpresa negli occhi dello spettatore ottocentesco di fronte ai congegni del Precinema (molti di questi basati sulla persistenza retinica) in qualche modo è simile a quella del pubblico di oggi davanti ad un’immagine elaborata con l’AI; stiamo parlando di quello spaesamento prodotto da qualcosa di nuovo che non riusciamo a cogliere completamente, ma che ci affascina e ci rapisce.

La casualità e l’attesa: non è possibile conoscere a priori il risultato di un’elaborazione di immagine fatta con l’AI, come non è possibile conoscere istantaneamente il risultato di uno scatto analogico. Bisogna scontrarsi con l’attesa, la perizia e la pazienza. Di fronte ad un’interrogazione posta ad un software di AI non abbiamo ancora un controllo totale sul risultato, dobbiamo affidarci al mix di combinazioni proposte dall’algoritmo.

SORPRESA: Da un’interrogazione non sappiamo cosa aspettarci, e molto spesso il risultato che ci viene restituito è sorprendente (sia in termini negativi che positivi).

ATTESA: La risposta dell’AI non è istantanea. L’attesa contribuisce a creare mistero e aspettativa.

CASUALITÀ E UNICITÀ’: un mix di combinazioni algoritmiche formula un risultato che è sempre unico. A parità di richieste, se ripetiamo più volte la stessa interrogazione, il risultato sarà sempre diverso.

Nell’AI si possono notare alcuni filoni narrativi e formali:

-

- contenuti surreali, distopici ed iperrealisti (il loro successo si basa sull’effetto wow)

- riproposizione formale del ‘vintage’: la grana della pellicola, certo utilizzo del bianco e nero oppure l’uso di filtri che richiamano specifiche pellicole fotografiche; ma in realtà questo recupero dei codici visivi del mondo analogico era già presente sin dagli albori di Instagram (il formato quadrato 6x6, l’uso delle cornici con perforazioni tipiche della pellicola e dei filtri ecc.)

Questo secondo filone è senza dubbio il più interessante e meno omologato del primo, perché si origina da un sentimento comune che possiamo chiamare nostalgia. Con due discriminanti:

i giovanissimi utilizzano questi codici in maniera inconsapevole, per inseguire la tendenza del momento. Nel nostro caso la tendenza del vintage. (filtri, cornici fotografiche, oggetti d’epoca o moderni, tecnologie obsolescenti)

I meno giovani, gli studiosi, gli appassionati, vivono questa nostalgia per una tecnologia artigianale, che basa il suo funzionamento sui meccanismi interni presenti nelle macchine: ’‘Il come è fatto’’. Si tratta di tecnologie (es. macchine fotografiche analogiche) che nella loro intrinseca ideazione e costruzione permettevano un utilizzo consapevole. Banalmente, per inserire la pellicola nella macchina analogica bisogna aprirla. Questo aspetto tecnico si inseriva in un processo di consapevolezza tecnologica e didattica, che i successivi sviluppi del digitale hanno progressivamente oscurato. Pensiamo a tutte le apparecchiature digitali che non ci permettono di essere esplorate al loro interno.

Per approfondimenti leggi qui: http://www.diegorandazzo.com/portfolio/immagini-simili-primo-studio/

Redazione di Controversie: Diego, secondo te, dove va a finire l'autorialità, quando l'opera è generata da un sistema informatico intelligente? chi è l'autore? chi ha "chiesto" un'immagine generata secondo alcuni criteri o caratteri, oppure la macchina stessa?

Diego: È una compartecipazione di attività tecniche e di pensiero, ma la firma deve essere necessariamente quella dell’artista. Autore è chi interroga e, soprattutto, rielabora e reinterpreta secondo la propria attitudine il risultato dell’Intelligenza artificiale. La macchina fa le veci del ricercatore: mette insieme e fonde tantissimi dati e, in ultima istanza, restituisce un ‘abstract grezzo’. Quell’abstract non può rimanere tale. Deve essere decostruito e manipolato dall’artista per assurgere ad opera d’arte. L’AI, come processo generativo, è quella cosa che sta in mezzo, tra il pensiero, l’idea iniziale e l’opera finale. Tutto qui. Non è semplificazione, è come dovrebbe essere inteso il ruolo dell’intelligenza artificiale nella creazione.

Il termine manipolazione, che ho appena usato, non è casuale. Innanzitutto, mi sta a cuore, perché ogni mio lavoro, che si origini da una fonte personale o da un’immagine pescata sul web, è soggetto, da sempre, ad una stratificazione di gesti ed elaborazioni, con conseguenti risemantizzazioni della sorgente iniziale, tanto da diventare una parte della mia cifra stilistica. Inoltre, manipolare si rifà proprio a quella manualità, che per me è anche ‘manualità nel pensare’, fondamentale per una trascrizione unica ed originale del processo creativo.

Il lavoro di elaborazione dell’AI implica una fusione di elementi eterogenei. Perciò nei risultati ottenuti prende forma una commistione di stili e soggetti diversi, tutti fusi assieme, tanto da creare delle aberrazioni inusuali nelle immagini. Questo processo di fusione, che spesso dà luogo ad una spaccatura di senso con l’interrogazione dell’utente, l’intelligenza artificiale lo gestisce molto bene. E l’aspetto forse più interessante è che l’algoritmo non rivela mai le sue fonti (il grande database da cui attinge), rimane misterioso a differenza degli artisti che, con un pizzico di orgoglio, snocciolano le proprie reference, le motivazioni ed i maestri ispiratori.

Siamo meno bravi nel farlo (fondere fonti diverse per creare qualcosa di nuovo) perché puntualmente inciampiamo nel facile citazionismo. E questo spesso ci riduce a degli abili saccheggiatori di pensieri ed immagini.

Forse demandare la ricerca delle proprie reference all’AI e affidarsi, in qualche modo, alla vertigine del caso, senza che il nostro ego si manifesti prepotentemente, può essere la nuova sfida della ricerca contemporanea. Mantenendo però fede alle premesse iniziali: quell’abstract fornito dall’AI non costituirà mai l’opera definitiva, bensì l’inizio di un processo dialettico.

Redazione di Controversie: Esistono ancora il concetto di unicità e di originalità di un'opera, quando il lavoro viene fatto "a macchina”?

Diego: Riprendendo in parte la prima risposta, non vedo ancora un pericolo per l’unicità dell’opera d’arte. Se, l’avvento del digitale (dalla fotografia digitale alle immagini virtuali) non ha messo in crisi questo principio non credo che sarà l’AI a metterlo in discussione. L’autorialità, se c’è e sappiamo riconoscerla, emergerà sempre sui cloni, sulle copie, sull’omologato. Ci vengono dati quotidianamente gli indizi per farlo e come nel caos dell’infodemia, bisogna aguzzare un po’ la vista per riconoscere il vero dalla finzione. Il nocciolo della questione secondo me è proprio questo: vogliamo veramente conoscere la verità? O forse preferiamo farci confondere da qualcosa che sembra apparentemente più attraente e coinvolgente? Bisogna sforzarsi, per carpire la verità, c’è poco da fare.

Non vorrei sembrare ripetitivo, ma ci tengo a sottolineare un concetto a mio parere fondamentale: la creazione di un’opera attraverso l’AI non può fermarsi al primo risultato ottenuto con un’interrogazione ad un’app. In concreto, stampare un’immagine realizzata con l’Ai ed esporla così com’è non la considero un’operazione artistica, a meno che non ci sia una dichiarata provocazione concettuale nel farlo (e nel caso andrebbe comunque motivata). L’AI è uno strumento, e come il pennello o la macchina fotografica, deve essere sottoposto ad uno sforzo di pensiero critico e di tecniche che lo rendano non solo utile, ma significativo per l’essere umano.

Una cosa interessante, che è anche il motivo fondante ed il filo conduttore del mio seminario: i risultati dell’AI non sono mai ripetibili… perciò i miei studi sul fenomeno mi hanno portato ad equipararlo al mondo dell’immagine analogica. Si tratta, infatti, di un mix di combinazioni algoritmiche che formula sempre un risultato unico. A parità di richieste - se ripetiamo più volte la stessa interrogazione - il risultato sarà sempre diverso. Quindi, se vogliamo, l’unicità dei risultati è un aspetto che ancora di più avvicina il mondo dell’AI a quello analogico e al concetto classico di Manufatto.

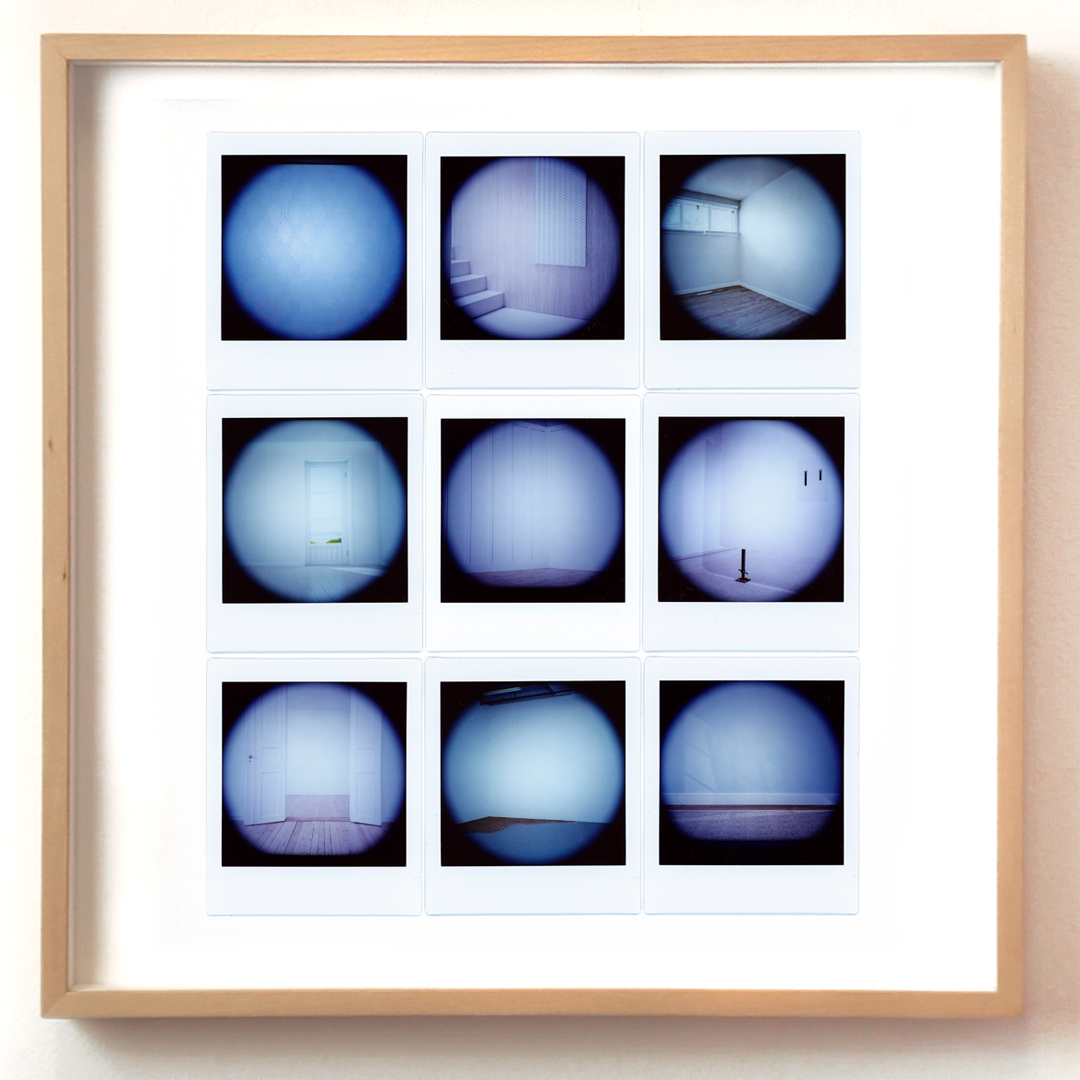

DISPOSITIVI / 3

15X16X3 cm,

bassorilievo in Gres, pellicola Instax wide,

elaborazione con Ai, 2023

Courtesy Galleria ADD-art e l’artista

Opera in mostra da Indigo Art Gallery a Perugia fino al 17 febbraio 2024

DISPOSITIVI / 3, dettaglio

Ovviamente il tema dell’unicità è molto ampio, profondo e stratificato, ma se ci soffermiamo sul mero aspetto tecnico, non si può non affermare che l’AI, ad oggi,

produca sempre dei risultati diversi a parità di domande.

E questo è un fatto abbastanza dirimente, soprattutto se lo inseriamo nel solco della produzione artistica.

Un nuovo francescano? - Paolo Benanti e la commissione algoritmi

Il professore Paolo Benanti è stato nominato Presidente della Commissione sull’Intelligenza Artificiale per l’Informazione e l’Editoria della Presidenza del Consiglio.

La Commissione è un organo del Dipartimento per l’Informazione e l’Editoria istituito dalla Presidenza del Consiglio poco più di due mesi fa, con lo scopo di analizzare le implicazioni dell’Intelligenza Artificiale nel campo dell’editoria e dell’informazione e, di conseguenza, consigliare il Dipartimento che ne è responsabile. La commissione è stata presieduta - dalla fondazione sino alle sue dimissioni - dal professor Giuliano Amato, politico, giurista, docente universitario e manager pubblico.

La nomina di Giuliano Amato aveva sorpreso molti; l’assegnazione della presidenza a Paolo Benanti forse anche di più.

Paolo Benanti ha un curriculum eccellente e si può dire - senza timore di smentita - che è uno dei massimi esperti mondiali di Intelligenza Artificiale; è un frate Francescano del Terzo Ordine Regolare, teologo, eticista, docente presso la Pontificia Università Gregoriana, consigliere di Papa Francesco per l’Intelligenza Artificiale, membro della Pontificia Accademia per la Vita con mandato sulla Intelligenza Artificiale, membro del New Artificial Intelligence Advisory Board dell' ONU, autore di libri sul ruolo dell'umano nella civiltà tecno-umana.

Ovunque si parli del profilo etico delle tecnologie e del ruolo della Intelligenza Artificiale nella vita dell'uomo, la presenza di Benanti è pertinente. È, tra l'altro, colui che ha coniato il termine Algoretica, cioè l'etica degli algoritmi. Da anni infatti si interroga e fa riflettere su come la tecnologia sia passata dallo status di strumento in mano all'uomo a quello di parte integrante dell'ecosistema sociale, e sempre più influente su questo ecosistema.

È sicuramente apprezzabile che Benanti abbia accettato di esporsi nel ruolo di Presidente della commissione: qualsiasi linea guida ne uscirà sarà certamente pertinente e di alto profilo. Paolo Benanti ama poi scherzare sul ruolo degli eticisti, come lui: gli eticisti fanno le domande e si tengono alla larga dalle risposte. Nel campo dell'etica le giuste domande sono infatti la cosa più importante, quelle che dovrebbero influenzare politici e stakeholders affinché affrontino i temi davvero rilevanti.

La domanda centrale posta dal lavoro di Paolo Benanti si può riassumere in questa: le macchine devono avere un'etica? Quale? Quali limiti ci sono e devono esserci nel rapporto tra la nuova specie delle macchine intelligenti e l'essere umano?

Gli eticisti non scendono in campo per dire cosa non si può fare o, peggio, pontificare su giusto e sbagliato, dice Benanti; il loro ruolo fondamentale su temi delicati e pervasivi della vita collettiva - com'è e come sarà sempre più l’Intelligenza Artificiale - deve essere appunto quello di porre le giuste domande, per far sì che le persone e le istituzioni ricerchino le risposte più adatte al contesto in cui operano. In questo il professor Paolo Benanti non potrà che essere eccellente: le persone, l'essere umano - in particolare nel loro rapporto con la tecnologia - sono sempre state al centro della sua attenzione.

Una volta tanto possiamo dire che in Italia abbiamo messo la persona giusta al posto giusto.

Conversazioni sull’Intelligenza Artificiale – Si prova qualcosa ad essere una macchina?

Redazione: Riccardo, in questo tuo post hai condensato almeno tre punti molto rilevanti per la discussione sull’Intelligenza Artificiale e sulle macchine che agiscono guidate da sistemi intelligenti:

- il primo – sulla bocca di tutti in questi giorni – è quello della trasparenza,

- il secondo è quello della responsabilità di questi agenti in qualche modo autonomi, di cui abbiamo già scritto più volte nel blog, e che coinvolge un’intera filiera di soggetti

- e il terzo è quello della soggettività degli automi.

È evidente che gli elementi più innovativi che stai introducendo in questo discorso sono:

1) quello che chiami “monologo interiore”, intimamente correlato al tema della trasparenza, e

2) la domanda, per me assolutamente inattesa, “ma sta succedendo qualcosa là dentro?”, che suggerisce di non trascurare la possibilità di una reale soggettività dell’automa.

Ritieni quindi che “monologo interiore”, “interiorità”, “soggettività” possano essere caratteri attribuibili ad un robot?

Riccardo: Per rispondere a questa domanda provo a definire chiaramente questi termini, perché spesso il guaio è che parlando di questi temi si utilizzano dei termini resi così laschi dagli anni di dibattiti che ognuno finisce un po’ per tirarseli dalla propria parte, con il risultato che tutti hanno ragione perché stanno parlando da soli.

E allora: il “monologo interiore” è l’idea di applicare ad un soggetto che si muove nello spazio (ad un robot nel nostro caso) un modo, uno spazio di lavoro, per connotare il proprio ambiente; e grazie a questo processo di continuo aggiornamento del proprio mondo, poter agire sempre più efficacemente sullo stesso.

Bene: su questo punto, a livello funzionale - ritengo che sia il caso di evitare un’analisi filogenetica - per me sia difficile trovare grosse differenze rispetto a ciò che una persona fa. Per quanto riguarda l’“interiorità”, definita come lo spazio in cui quel monologo interiore accade, mi pare chiaro che sia una condizione necessaria per l’esistenza di un monologo, avendo appunto un’azione bisogno di un luogo in cui svolgersi.

La “soggettività” è invece la dimensione più scivolosa. Però possiamo intenderla come il fantomatico “provare qualcosa ad essere (un soggetto)”.

Ecco, credo che questa dimensione soggettiva possa essere accessibile solo tramite due tratti essenziali: un qualche tipo di auto-narrazione e una fiducia nei confronti di quella narrazione e di quel narratore. A conti fatti ognuno di noi ha accesso soggettivamente solo alla propria soggettività e quella degli altri se la può, al massimo e ragionevolmente, immaginare.

Cosa è ragionevole però pensare quando vedo un cane con gli occhi chiusi che muove le gambe? E un polpo che si nasconde nella sua tana foderata di conchiglie? Sta succedendo qualcosa lì dentro?

È una questione di vita mi si dirà, di vita organica persino. Io credo, senza dire niente di nuovo rispetto alle riflessioni di Maturana Romesín e Varela García (1972, De máquinas y seres vivos), che si giri intorno alla questione, tutta individuale e privata, di “accettare emotivamente” o meno il fatto che la vita sia poco più che il tentativo di un sistema di riuscire a conservarsi.

Redazione: E tu Paolo, che hai speso anni in mezzo a queste macchine e queste domande, cosa ne pensi?

Paolo: Tendiamo ad attribuire un significato compiuto alle parole del nostro interlocutore, anche se il suo discorso è privo di senso; lo insegna Paul Grice, che segnala anche l’attitudine a riconoscere al partner intenzioni di veridicità e pertinenza. Credo che la nostra propensione al principio di carità si estenda al comportamento delle macchine, soprattutto a quelle di AI generativa, cui accordiamo intelligenza, coscienza e creatività, nel senso ordinario di questi termini.

Eppure, software di grande raffinatezza, come ChatGPT o AlexNet, mostrano con le «allucinazioni» che la loro presa su qualunque realtà esterna ai processi del codice è nulla.

Non possiamo pretendere che l’intelligenza artificiale possa diventare «generale» (AGI), e sia quindi in grado di paragonarsi a quella umana, a causa della definizione stessa che è stata adottata per la loro progettazione.

Il modello cognitivo che guida la pianificazione delle AGI è fondato su potenza di calcolo, quantità e stratificazione delle connessioni tra unità di calcolo. Si è dimenticato che invece l’intelligenza parte sempre da una domanda preliminare, e da una precomprensione del mondo e dell’ambiente: lo rilevano su ambiti di indagine differenti sia Popper sia Husserl.

Senza l’autonomia dello stimolo a porre interrogativi non c’è nessuna intelligenza (coscienza, creatività, ecc.) nel senso comune del termine. Credo invece che le Intelligenze Artificiali siano dispositivi nel senso pieno indagato da Agamben (2006, Che cos'è un dispositivo?): pongono in essere un dominio di esperienze che prima non esisteva, stabilendo un nuovo campo di poteri e saperi.

Se le si osserva nella prospettiva del loro contributo alla storicità e al potenziamento dell’intelligenza (senza aggettivi di specificazione), assumono un profilo meno fantascientifico ma più ricco di senso, rientrando nella tradizione del pensare per segni che trova la sua fondazione in Leibniz e nei suoi studi sulla characteristica – ma soprattutto che prosegue il percorso di riflessione e di progettazione che Doug Engelbart ha inaugurato insieme ad English nel 1968 (A Research Center for Augmenting Human Intellect).

Redazione: Grazie a entrambi, più che darmi delle risposte, avete delineato due veri programmi di lavoro, distinti e complementari, uno fenomenologico e l’altro più analitico e cognitivista. Programmi che possono convergere o divergere.

Lo capiremo, forse, nella prossima parte della conversazione, dalla risposta che Riccardo darà a questa domanda:

il requisito di essere incorporata in un robot, è obbligatorio per riconoscere ad una IA generativa come, ad esempio, Chat GPT, il diritto all'integrità di cui parli? Le altre istanze, quelle esclusivamente dialoganti che troviamo sul web, non hanno diritto a questo riconoscimento?

A tra due settimane!

Soggetti o oggetti? - Come e perché pensare un diritto per alcuni robot

Avevano fatto sorridere le uscite di Giuliano Amato, nella veste di presidente della Commissione Algoritmi, sui molti modi possibili per cucinare le patate suggeriti da una generica intelligenza artificiale.1 Un’uscita considerata ridicola da molti, non adatta alla serietà della questione (tutta imperniata sulla tutela dei contenuti e del copyright dalle grinfie delle cosiddette intelligenze artificiali generative).

Ecco allora che dal 5 di gennaio il teologo Paolo Benanti subentra alla posizione di Amato. Un pensiero affascinante quello della sua «algoretica», che meriterebbe un approfondimento tutto suo. Tuttavia, questo cambiamento al timone di comando credo sia una spia interessante per porsi una domanda iniziale. Con questo cambio assistiamo infatti ad un riorientamento verso altre specializzazioni accademiche dalle quali si va cercando consiglio: siamo passati dal diritto alla filosofia morale, alla bioetica: che il diritto abbia già esaurito tutto ciò che di utile poteva dirci a riguardo?

È bene notare come sia una tendenza diffusa quella di applicare i criteri della casuistica2 ai nuovi scenari creati dalle interazioni umane con agenti più o meno autonomi, ma sicuramente non organici. Questi criteri si rivelano certamente strumenti utili per indagare la rettitudine morale o, nel peggiore dei casi, il minore dei mali, da perseguire nel sempre più ampio ventaglio di scenari possibili. Io credo però che le maglie della legge, di una legge che sorge dalle garanzie costituzionali, possa offrirci ulteriori e più interessanti metodi di analisi. E forse anche qualche garanzia in più.

Definiamo però subito bene il nostro perimetro di riferimento: quali sono questi robot? Robot sociali sicuramente, di quelli pensati per entrare costantemente in contatto con noi per intenderci, e dotati di un monologo interiore. Cos’è però il monologo interiore, per un robot? Semplicemente lo stesso che è per te che stai leggendo: un modo per aggiornarne costantemente il proprio modello del mondo cercando sempre di approssimare al meglio gli ipotetici scenari futuri.

Noi ne abbiamo solitamente esperienza come quella vocina nella nostra testa, o quel «buzzing that went on inside my head» di cui parlava Alan Turing. A livello funzionale però non ci occorre teorizzare alcun homunculus, solo un flusso di linguaggio interno.3

Perché il monologo interiore è importante per il nostro discorso sociale? Perché ci offre la possibilità di soddisfare uno dei criteri più spesso rincorsi nei dibattiti sull’intelligenza artificiale: la trasparenza.

È il caso anche delle recenti (dicembre 2023) proposte contenute nell’EU AI Act, dove si legge come alcuni dei requisiti per un utilizzo corretto dei «sistemi di IA identificati come ad alto rischio», siano «la registrazione dell'attività per garantire la tracciabilità dei risultati; la documentazione dettagliata che fornisca tutte le informazioni necessarie sul sistema e sul suo scopo per le autorità di valutarne la conformità; l’accessibilità e la trasparenza di informazioni chiare e adeguate all’utente».

Attenzione: le scatole nere rimangono tali, tuttavia guadagnano, grazie alla registrazione del loro monologo interiore, un alto grado di trasparenza sulle loro azioni. Bene, per robot che agiscono così credo si possa ragionevolmente parlare di soggetti (o oggetti, poi ci arriviamo) autonomi.

Ora, se un (s)oggetto è autonomo, cioè è in grado di compiere azioni senza essere comandato a distanza da altri soggetti, allora ci occorre incasellarlo all’interno di una qualche finzione giuridica, in modo tale che se dovesse arrecare qualche danno, sapremmo quali norme seguire. Ecco, credo che questo sfondo di prudenza sia quello sul quale ragionare di diritti robotici: non occorre mischiare concetti come quello di agente e paziente morale, ci basta soffermarci sul riconoscimento dell’esistenza (sempre più prossima)4 di entità immerse nel nostro stesso ambiente che agiscono in maniera per noi più o meno comprensibile.

Sembra dunque che stia proponendo qualcosa di non molto diverso dalla «personalità elettronica» discussa per la prima volta in una bozza europea nell’ormai lontano 2017. Occorre però fare delle debite precisazioni per non rischiare di cacciarsi nel ginepraio legistico e propongo allora qui di seguire le cristalline ricostruzioni di Luigi Ferrajoli.5

Innanzitutto, di quale diritto stiamo parlando? I diritti soggettivi, quelli cioè spettanti ad ogni soggetto (fisico e poi dunque giuridico), devono essere concettualmente distinti (1) in diritti fondamentali e diritti patrimoniali.

È bene subito ricordare come i diritti fondamentali, indisponibili per loro natura, siano «limiti imposti alla democrazia politica e al mercato a garanzia della loro stessa conservazione» mentre i diritti patrimoniali, siano diritti di forma singolare: escludono cioè tutti gli altri soggetti.

È poi per noi necessario distinguere, (2) all’interno dei diritti fondamentali, quelli di libertà e quelli di autonomia privata. La logica di questa seconda biforcazione è chiara, ed è la medesima alla base della distinzione tra i diritti fondamentali e quelli patrimoniali: sia i diritti patrimoniali, evidenziati in (1), sia i diritti fondamentali di autonomia privata, evidenziati in (2), sono da considerarsi in quanto potestatis agendi, ovvero diritti potestativi.

Al contrario, i diritti fondamentali di libertà non possono che essere mere immunità, o facultates agendi e dunque si differenziano dai diritti fondamentali di autonomia i quali «formano il principale veicolo della differenziazione dei diritti singolari di proprietà e perciò del moltiplicarsi di disuguaglianze giuridiche e materiali nei diritti patrimoniali».

Tenendo ben chiara questa suddivisione ciò che si vuole qui iniziare a discutere sarà allora un diritto fondamentale di libertà per questi, e ora possiamo dirlo, soggetti robotici. Nessun diritto di giocare in borsa (un diritto di autonomia privata), né di potersi comprare qualche capo di fast-fashion (un diritto patrimoniale), piuttosto la garanzia di una difesa della loro integrità da interferenza arbitrarie.

Si chiederà: perché? che bisogno c’è di questo diritto di libertà?

Ecco due considerazioni:

(a) non sappiamo cosa succeda all’interno di queste macchine, e non possiamo, io credo, dirimere così facilmente la famosa domanda del «cosa si prova ad essere quel sistema».

Ne segue poi che il metro con il quale dovremmo valutare una macchina, se non vogliamo solamente una versione più efficace di un oggetto che già possediamo ma cerchiamo invece un nuovo soggetto con cui dialogare e con il quale costruire qualcosa di nuovo insieme, sia necessariamente quello di un fair-play.

Questo credo sia l’insegnamento, e l’atteggiamento, più importante che Alan Turing ci ha per primo lasciato: «a fair play [that] must be given to the machine. Instead of it sometimes giving no answer we could arrange that it gives occasional wrong answers. But the human mathematician would likewise make blunders when trying out new techniques. It is easy for us to regard these blunders as not counting and give him another chance, but the machine would probably be allowed no mercy. In other words then, if a machine is expected to be infallible, it cannot also be intelligent . . . No man adds very much to the body of knowledge, why should we expect more of a machine?».6

Ciò di cui qui si discute sono dunque macchine incorporate nel mondo che per poter agire in questo mondo hanno bisogno di poter sbagliare, perlomeno quando lo sbaglio non arreca danni irreparabili ma – ad esempio - solo una contenuta flessione nel profitto.

(b) la commodificazione di un possibile nuovo soggetto può risultare l’ulteriore veicolo di lacune già presenti all’interno di una costruzione giuridica che ha inventato finzioni ben più de-responsabilizzanti e pericolose (basti pensare alle holding finanziarie dotate di personalità giuridica). Di fatto poi tali lacune sono spesso alla basse dell’emergenza di quelli che Ferrajoli giustamente definisce crimini di sistema. Dopotutto non è tramite la riduzione dei soggetti che possono mettere in gioco un reciproco controllo dei rispettivi poteri che si garantisce la continuità delle nostre prerogative costituzionali, piuttosto è con un ampliamento di tali figure che si può garantire alla democrazia politica e al mercato laloro stessa conservazione.

Cosa ci guadagniamo da questa proposta? cosa invece ne perdiamo?

Occorre discuterne. Certo è che il primo passo è riconoscere la possibile rilevanza della questione.

NOTE

1 Il virgolettato in realtà recitava: «A me piacciono molto le patate. Grazie all’intelligenza artificiale, un giornalista in pochi istanti potrà sapere tutti i modi in cui posso cucinarle, così da arricchire il suo pezzo».

2 Parte della teologia morale, che applica i principi della morale teorica a casi concreti, anche solo ipotetici («casi di coscienza»), secondo varie circostanze, per trovare la regola valida per ciascuno, metodi ancora attuali in molta etica e bioetica contemporanea.

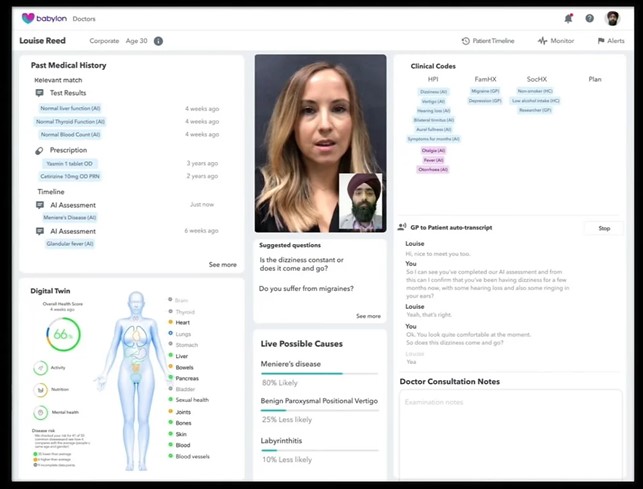

3 Un modello chiaro per i nostri robot è quello dell’«Inner Monologue», sul quale si può approfondire qui: https://innermonologue.github.io

4 È chiaro che il discorso normativo che sto qui presentando cerca di anticipare il futuro alla luce delle tendenze più attuali e che paiono più promettenti. Altre architetture, non basate sulla commistione tra un modello LLM (come il famigerato ChatGPT per intenderci) e un robot potrebbero prendere il sopravvento, resta il fatto che l’obiettivo perseguito rimarrà quello di un’efficace autonomia di questi (s)oggetti, e dunque il punto giuridico del discorso non varia di molto, varierebbero sì i soggetti. Un esempio dell’interazione uomo-macchina con questo modello si può vedere qui: https://www.youtube.com/watch?v=djzOBZUFzTw&t=334s

5 Il riferimento è il tomo estremamente denso e tuttavia cristallino La costituzione della democrazia (2021). Le parti più rilevanti per il nostro discorso sono, per chi fosse interessato ad approfondire, la III e la IV.

6 La citazione viene dalla trascrizione della Conferenza tenuta alla London Mathematical Society il 20 Febbraio 1947. Una traduzione si trova nel volume curato da Gabriele Lolli sull’«intelligenza meccanica» e recita così: «sostengo che la macchina deve esser trattata in modo equo e leale. Invece di avere una situazione in cui la macchina a volte non dà risposte, potremmo aggiustare le cose in modo che essa dia ogni tanto risposte sbagliate. Anche il matematico umano prende qualche cantonata quando sperimenta nuove tecniche. È facile per noi considerare queste sviste come non rilevanti e dare a lricercatore un’altra possibilità, ma alla macchina non viene riservata alcuna pietà. In altre parole, se si aspetta che la macchina sia infallibile, allora essa non può anche essere intelligente… Nessun uomo aggiunge granché al corpo generale delle conoscenze umane: perché dovremmo aspettarci di più da una macchina?»

Conversazioni sull'Intelligenza Artificiale - Medicina, un salto culturale quantico

Gianluca Fuser: Alessio, tu ti stai occupando – nel tuo lavoro - di tecnologie di Intelligenza Artificiale applicate al mondo della cura veterinaria e questo ti dà l’opportunità di spaziare anche nell’ambito delle molte sperimentazioni destinate alla medicina umana. Che impressione hai del fermento che anima questo settore?

Alessio Panella: Un fatto certo è che nel settore della medicina veterinaria la sperimentazione si spinge più in là che in quello della medicina umana, purtroppo in virtù del fatto che gli animali non umani sono ancora e per lo più considerati sostituibili e di un ordine di importanza morale inferiore a quello degli umani – come tu ben sai.

Si testano, infatti, già sul campo applicazioni che interpretano le TAC in modo apparentemente esaustivo; c’è già chi pensa che il medico veterinario potrà ricevere il referto completo e definitivo senza quasi vedere le immagini.

L’ovvio vantaggio è in termini di riduzione dei costi e dei tempi operativi; forse si può aggiungere una maggiore attenzione ai fenomeni “fuori focus”, quelli spesso ignorati a causa della distorsione cognitiva del medico che – nell’immagine - cerca la patologia che già pensa di dover cercare e rischia di non notare segnali poco evidenti di altre patologie.

Nel campo della medicina umana, invece, ci si muove con maggiore prudenza. Ma non pensare che le applicazioni in sperimentazione o già in uso siano meno dirompenti.

Gianluca: Ad esempio?

Alessio: I casi sono moltissimi ma posso indicarti un paio di esempi secondo me molto rilevanti, che convergono su un obiettivo comune: ridurre la spesa sanitaria. In un caso per il sistema sanitario nazionale britannico (NHS), nell’altro caso per le assicurazioni private su cui si basa il sistema sanitario statunitense.

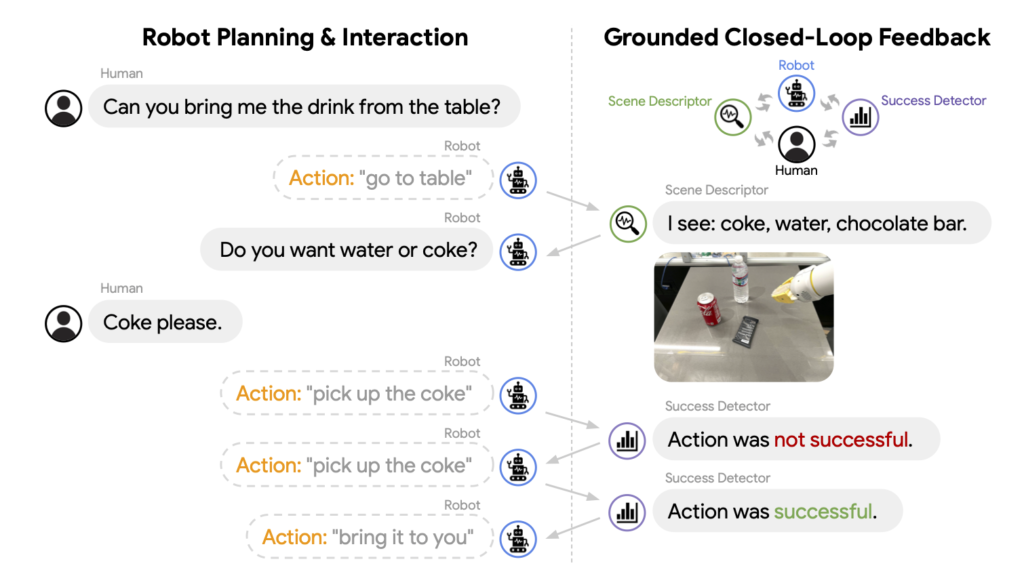

Per non tediarti, oggi affronterei il primo caso, quello di Babylon, un sistema di “visita a distanza” adottato in via sperimentale dal NHS in alcune aree di Londra. Il contatto tra medico e paziente avviene conversano in video: il paziente usa una app su smartphone, il medico la sua postazione con il suo personal computer.

Durante la conversazione Babylon mostra al medico la storia sanitaria del paziente mentre trascrive la conversazione e la interpreta: isola, cioè, i sintomi rilevanti riportati dal paziente, evidenziandone anche possibili collegamenti con patologie pregresse. Valuta poi inoltre anche il quadro complessivo dello stato di salute del paziente, anche in forma grafica, con una sorta di gemello digitale proposto sullo schermo.

Infine, assiste il medico nel lavoro diagnostico: in primo luogo, proponendo una serie di potenziali diagnosi basate sulla storia clinica, sui sintomi e sulle frequenze statistiche che “ha in pancia” e, in secondo luogo, suggerendo al medico le domande da fare per seguire un percorso organizzato di approfondimento e di diagnosi differenziale.

L’ultima funzionalità è quella con la quale il software analizza le espressioni facciali e la postura del paziente a schermo e informa il medico di eventuali stress o disagi che il paziente sta provando. In sostanza guida il medico anche nella relazione con il paziente, finché questi non sia sereno del risultato della visita.

Gianluca: Che parte svolge la IA in questo processo?

Alessio: Dalla A alla Z. Se vogliamo essere puntigliosi, l’unico passaggio che non è pervaso di IA è la cartella clinica, la storia sanitaria del paziente. Tutto il resto: interpretazione del linguaggio parlato, collegamenti, analisi dello stato di salute e delle espressioni facciali, proposte e suggerimenti, sono tutti guidati da programmi di IA. Che, è bene ricordarlo, sono basati principalmente su inferenze a base statistica.

Puoi vedere chiaramente che vantaggi si ribaltano sull’economia del NHS: meno presenza fisica sul territorio, meno spostamenti, visite più veloci, minori rischi di malattie professionali da contagio per i medici, probabilmente meno costi per accertamenti diagnostici, sicuramente minori costi di apprendistato per i medici di assistenza di primo livello.

Gianluca: Detta così, mi pare che ci possano essere dei vantaggi non trascurabili anche per i pazienti. Perlomeno si potrebbe pensare che – se lo staff medico nel suo complesso è dimensionato in maniera adeguata – si possa garantire una maggiore accessibilità dei servizi di prima assistenza per le situazioni non gravi e una maggiore efficacia nell’indirizzamento diagnostico o terapeutico. Oltre che, come dicevi prima, la possibilità di cogliere problemi fuori focus.

Alessio: Non sbagli affatto. Questi vantaggi ci possono essere di sicuro se – come puntualizzavi – lo staff è ben dimensionato e la base di conoscenza dell’applicazione è adeguata. Aggiungi anche che la somma di medico e di software che lo supporta possono garantire anche un tasso di errore diagnostico, a pari informazioni.

Gianluca: Quindi, non vedi problemi?

Alessio: Purtroppo alcuni problemi ci possono essere: se la “macchina” funziona bene, il medico – che dovrebbe essere la figura principale in questa relazione a tre – può essere meno competente o passare in secondo piano e rischia di diventare solo un tramite tra macchina e paziente. La tentazione per i gestori di un sistema sanitario che deve risparmiare è grande: riduzione dei percorsi professionalizzanti, standardizzazione verso il basso, passaggi delegati interamente alla macchina. Un altro rischio – connesso con la de-professionalizzazione dei medici di prima assistenza – è l’appiattimento delle diagnosi sulle frequenze statistiche.

Gianluca: Cosa significa? Che riconosciuti alcuni sintomi la macchina proporrà sempre la stessa diagnosi, perché statisticamente più frequente?

Alessio: Esattamente questo: se il medico non si impegna nella valutazione delle diverse possibilità di malattie che presentano gli stessi sintomi, in altre parole non fa la diagnosi differenziale, tutti sono malati della stessa malattia. Ma, soprattutto, tutti sono malati!

L’assenza di un contatto personale, di conoscenza del paziente, delle sue idiosincrasie e della sua storia – non solo di quella clinica - unite alla minore competenza e alla pressione “produttiva” sui medici possono fare il disastro.

Gianluca: Quindi i benefici che abbiamo visto prima si prospettano solo sul fronte del contenimento dei costi sanitari?

Alessio: Sì, se il governo di questo sistema complesso di medicina a distanza supportata dall’intelligenza artificiale non si focalizza sul termine “medicina”, cioè sulla pratica condotta da un medico, vero, capace e coadiuvato da macchine ben funzionanti. E se non dimentica il ruolo fondamentale del contatto di prossimità con il paziente.

Gianluca: Sono del tutto d’accordo con te: solo un’accorta gestione di questi processi può coniugare il contenimento dei costi e una maggiore attenzione per i pazienti.

Un ultimo punto, per oggi: dal punto di vista etico e della responsabilità, come vedi questa innovazione?

Alessio: Il problema della responsabilità è significativo: nel processo congiunto medico-macchina, quando viene commesso un errore chi si prende la responsabilità? Il medico o la macchina? Come hai già scritto su questo blog, c’è un’intera filiera di potenziali responsabili, che deve essere ordinata dal punto di vista legale e pratico – e parlo anche della necessità di trasparenza dei meccanismi di apprendimento e di esecuzione.

Quello che non va dimenticato, però, è il punto di vista del paziente: preferisce che il suo caso clinico venga analizzato da un dottore di 25 anni che si è laureato ieri l'altro e ha visto solo venti casi, oppure da un software che non sa come funziona ma che ha elaborato e sintetizzato 2 milioni di casi simili?

Quello che voglio dire è che l’entrata in campo di questi software è un urto culturale, che non riguarda la maggiore o minore possibilità di errore di una macchina rispetto ad un umano, ma chi commette l’errore.

All’estremo: noi accettiamo l’errore umano come naturale, se la diagnosi sbagliata del medico mi uccide è un umano come me che l’ha fatto. Ma se l’errore è della macchina? Accettare di essere uccisi da una macchina: ecco il salto quantico che ci impone questo cambiamento di paradigma culturale.

OpenAI e Sam Altman - Anatomia di un Qomplotto (seconda parte)

Riprendiamo il post della settimana precedente per capire l’intricata vicenda del licenziamento e successiva ri-assunzione di Sam Altman, amministratore delegato di OpenAI.

------------

Appena annunciata la notizia della deposizione di Altman, la piattaforma Reddit è stata presa d’assalto da un tumulto di commenti[1] e tentativi di interpretazione del colpo di mano ai vertici di OpenAI, molti dei quali in chiave di Qomplotto. Q* è davvero la culla dell’AI che ci trasformerà tutti in graffette? È il Clippy odioso che abita dentro ciascuno di noi, la nostra anima di silicio?

1. STRUZZI E PAPPAGALLI STOCASTICI

Il 24 novembre prende la parola uno dei protagonisti della storia recente dell’intelligenza artificiale: Yann LeCun. Mitchell (2019) ricostruisce con precisione le ragioni per cui grazie al suo riconoscitore di immagini AlexNet le reti neurali sono diventate dal 2012 quasi sinonimo di AI, imponendosi come paradigma dominante.

In un post su X[2] (ex Twitter) LeCun dichiara: «per favore ignorate il diluvio di completi nonsense su Q*». Possiamo, in prima battuta, spiegare con un paio di esempi la motivazione di fondo per cui LeCun ha sicuramente ragione: sia su Q*, chein generale su qualunque illazione che intenda predire un futuro distopico con l’evoluzione dei paradigmi attuali di AI. In seconda battuta cercherò di chiarire cosa potrebbe essere Q* nella sua lettura delle poche notizie che sono trapelate.

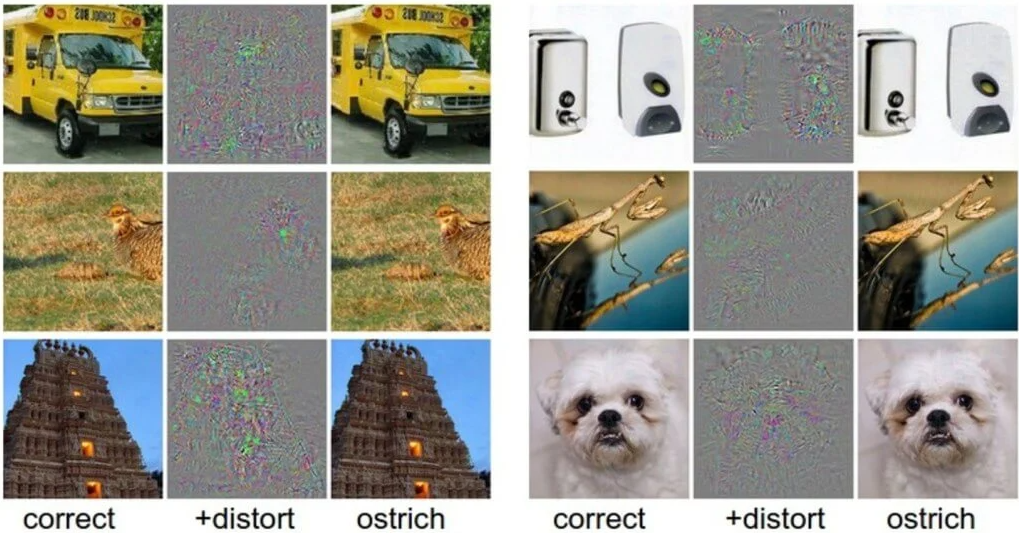

Szegedy et al. (2013) riferiscono gli esiti dell’«attacco avverso» che hanno condotto proprio su AlexNet: l’esperimento di hackeraggio «benevolo» sulla piattaforma di riconoscimento automatico delle immagini si propone di verificare quale sia il grado di comprensione che il software riesce a ricavare dalla percezione delle illustrazioni che gli vengono sottoposte, attraverso l’inserimento di un «rumore informativo» costituito da alcuni pixel inseriti nel corpo delle figure osservate.

L’immagine sulla sinistra è quella originale, classificata in modo corretto dall’intelligenza artificiale; quella sulla destra è stata ottenuta attraverso la modifica di alcuni pixel, che non la mutano affatto al giudizio di un occhio umano. AlexNet tuttavia classifica tutte le varianti di destra come «struzzo», attribuendo al nuovo giudizio un grado di affidabilità maggiore rispetto a quello con cui era stata stabilita la valutazione esatta nella versione di sinistra. Ho già mostrato in Bottazzini (2023) come questo risultato possa essere letto sullo sfondo di uno dei dibattiti filosofici più controversi dal Seicento ai nostri giorni: il cosiddetto «Problema Molyneux». Qui basti osservare che l’errore non può essere giustificato come un bug del sistema, o come un difetto che sarà rimosso dall’espansione della potenza di calcolo futura del software.

In nessun caso un’intelligenza – cioè una forma di comprensione della realtà – che aspiri a somigliare a quella umana può ritenere attendibile che un tempio, o uno scuolabus, o un cane, si tramutino di colpo in uno struzzo.

Anche in caso di illusione ottica o miraggio, lo scostamento dalla percezione corretta è solo temporaneo, e la normalità viene ristabilita con un riesame che restituisce il focus dell’impressione al contesto in cui deve essere collocato.

La realtà viene ristabilita nel campo visivo attraverso l’insieme delle operazioni cognitive non tematizzate, che la tradizione fenomenologica definisce intenzionalità fungente (si pensi per esempio a Merleau-Ponty (1945)), da cui si genera il senso del mondo in cui stiamo agendo, nella sua complessità e in ciascuno dei suoi dettagli.

Searle (1995) le definisce competenze di Sfondo: senza alcuna consapevolezza, permettono di viaggiare in autostrada senza domandarci se lo scuolabus che stiamo per superare subirà una metamorfosi improvvisa in uno stormo di struzzi, se il tempio che stiamo contemplando nel mezzo di una vacanza afosa si dissolverà in un vortice di ali sbattute e di piume svolazzanti, o se il cane dei vicini stia deponendo un uovo nel nostro salotto, convertito in un lembo di savana dietro la porta socchiusa.

Gli eventi che sperimentiamo emergono da un orizzonte che rimane stabile, e che regolarizza senza posa i fenomeni con cui interagiamo, perché noi abbiamo un mondo, per usare la concettualizzazione di Heidegger (1983), al contrario delle AI che invece non ne hanno uno (come il resto dei minerali).

In ChatGPT-4 (2023) l’intelligenza artificiale di OpenAI ha stilato una cronaca dell’evoluzione dell’AI e una serie di indicazioni sulla struttura dei principali tipi di software, con un censimento dei personaggi e dei saggi più rilevanti del percorso. Nel §7.3 si presenta un pappagallo stocastico o allucinazione molto illuminante: ChatGPT cita il testo La questione dell’autonomia: gli agenti artificiali possono essere autonomi e avere libero arbitrio? che Mario Rossi avrebbe pubblicato nel 1995: il libro non esiste, né esiste un Mario Rossi in quanto autore del trattato – ma in ogni caso anche il più somaro degli studenti avrebbe evitato di attribuire a questo volume citazioni da Dennett (2003), o descrizioni della partita tra AlphaGo e Ke Jie, disputata nel 2017.

Le intelligenze artificiali sono macchine che calcolano probabilità, soppesando migliaia di miliardi di parametri per ogni passaggio, e rintracciando in questo modo pattern di relazioni che possono sfuggire a sensibilità e misurazioni dell’uomo. AlexNet stima il grado di probabilità che la distribuzione dei pixel nell’immagine possa essere categorizzata con una certa etichetta; ChatGPT conta la probabilità che una certa parola venga subito dopo quella appena stampata, spaziando su 1.700 miliardi di variabili ad ogni nuovo lemma aggiunto alla frase.

Ma nessuna delle due macchine ha la minima idea di cosa stia guardando o di cosa stia dicendo; anzi, non sa nemmeno di stare percependo o affermando qualcosa.

Il cammino verso l’intelligenza, nel senso effettivo di questa parola, non ha mosso ancora il primo passo.

I paradigmi di sviluppo con cui sono state progettate e costruite le AI fino a oggi, non sono in grado di disegnare un’intelligenza che viva in un mondo dotato di senso; quindi nessuna di loro potrà maturare qomplotti contro di noi, né oggi né in alcun futuro possibile; almeno finché non saremo capaci di ideare un nuovo paradigma di programmazione in grado di superare i limiti di oggi.

L’intelligenza non è una proprietà emergente di un sistema di calcolo che oggi non sarebbe ancora abbastanza potente per lasciar affiorare l’homunculus dotato di pensiero e coscienza autonomi, per ora nascosto nelle viscere dei processori e delle schede madri in attesa di tempi migliori. La quantità di parametri sottosposti al processo di calcolo da parte di ChatGPT si è moltiplicata per un fattore 1.000 a ogni nuova generazione del software; ma l’artefatto è stato in grado di articolare testi sempre più lunghi e complessi, mai di capire anche solo una parola di quello che andava componendo.

L’emergenza dell’intelligenza dall’espansione della capacità di calcolo, come l’emergenza del mondo trasformato in graffette, sono utopie e distopie che vivono solo nell’immaginazione di Bostrom e degli altri (numerosi) teorici dell’esplosione dell’AI.

L’intelligenza non somiglia ai comportamenti aggregati della società, o degli sciami di api, o degli stormi di struzzi; commercia invece con una donazione di senso del mondo e degli eventi, che al momento non abbiamo la minima idea di come ingegnerizzare.

È il dominio della lebenswelt da cui secondo Habermas (1981) siamo in grado di lasciar emergere gli aspetti pertinenti per le decisioni sull’azione, senza sapere da dove provengono i contenuti che stiamo tematizzando e che compongono il materiale di dibattito con gli altri – ma che ogni volta siamo in grado di selezionare con una sorta di tropismo verso la verità.

Senso e intelligenza non si nutrono della fugacità con cui si aggregano e dileguano le orme degli sciami di insetti e di uccelli: sono la struttura stessa che rende possibile la società degli uomini e il processo illimitato di interpretazione del mondo e degli altri che si chiama cultura. No lebenswelt, no qomplotto.

Yann LeCun ritiene che Q* debba essere il nome di un progetto che ha raggiunto qualche risultato utile nelle procedure di apprendimento con rinforzo (reinforcement learning), che è il modello di training applicato a ChatGPT. Si consideri che uno degli algoritmi più diffusi in questo ambito si chiama Q-learning, mentre A* è il nome di un importante algoritmo per l’individuazione del percorso più efficace tra due nodi di una rete. Q* potrebbe quindi individuare un algoritmo capace di ottimizzare il processo di apprendimento introducendo un metodo di pianificazione nelle operazioni con cui la rete neurale riequilibra i pesi delle unità di elaborazione, dopo il giudizio che il formatore umano ha espresso al termine di ogni nuova prestazione.

In altre parole, Q* consisterebbe in un dispositivo di ottimizzazione dei calcoli probabilistici con cui l’intelligenza artificiale stima l’occorrenza del prossimo lemma che deve introdurre nella frase, o dell’etichetta che deve stampare come didascalia dell’immagine.

Se siete delusi da questa interpretazione di Q*, siete degli altruisti efficaci.

2. UN MONOPOLIO DELL’AI

Lo Sciamano ha guidato una farsa di guerra civile nelle stanze del Campidoglio; ma anche chiedere ai filosofi – soprattutto se sono altruisti efficaci – di condurre un colpo di stato nella governance di un’impresa miliardaria non è una buona idea.

Dopo aver licenziato Sam Altman il 18 novembre, il CDA di OpenAI non ha rilasciato alcuna dichiarazione né alla stampa, né a Satya Nadella, CEO del benefattore Microsoft. Non ha chiarito le ragioni della decisione nemmeno a Mira Murati, nominata CEO ad interim, e non ha risposto a Greg Brockman, presidente della società, quando questi si è dimesso in solidarietà con Altman.

Oltre 730 dipendenti di OpenAI (su 770 complessivi) hanno firmato una lettera il 20 novembre in cui si dichiaravano pronti a lasciare l’azienda se Altman non fosse stato reintegrato; ma anche questa comunicazione non ha ricevuto risposta. Visto che Mira Murati era arruolata nella lista dei dimissionari, è stata sostituita con Emmet Shear. Il disastro di gestione e di comunicazione del board si è risolto il 22 novembre, in obbedienza alle riflessioni meditate attorno alla scrivania di Nadella[3]: «diamo l’incarico di gestione a degli adulti, torniamo a ciò che avevamo».

Altman e Brockmann sono rientrati ai loro posti in OpenAI, mentre il CDA è stato sciolto e ne è stato convocato uno nuovo.

La stupidità del panico per un mondo di graffette ha finito per lasciare le mani libere all’implementazione del Copilot su Office. Agli altruisti efficaci non sono bastati nemmeno i proclami e l’allarmismo suscitato da Altman in prima persona, che invece sa calcolare molto bene gli effetti delle sue dichiarazioni. Il CEO di OpenAI non ha mai risparmiato la sua voce, anche se con meno enfasi di quella di Elon Musk, per sottolineare i rischi futuri dell’intelligenza artificiale. L’ultima volta è accaduto il 30 maggio 2023 con una lettera aperta[4] in cui si elencano i pericoli riconducibili agli usi dell’AI volti a produrre e diffondere informazioni false in qualunque formato.

Yann LeCun, ancora lui, invita a sospettare sia della propaganda «lungotermista» di Musk e degli altri altruisti efficaci, sia della sollecitudine con cui Altman esorta a riflettere sui rischi dei prodotti di cui è egli stesso responsabile.

L’AI Safety Summit, che si è tenuto a Londra per volere del premier britannico Rishi Sunak e a cui hanno partecipato i leader di ventotto paesi (tra cui l’Italia), è stato in realtà dominato da figure come quella di Elon Musk – che ha duettato in un evento mediatico l’ultima sera con il Primo Ministro di Sua Maestà.

L’obiettivo di tutti questi soggetti è convincere la classe politica dell’esistenza di rischi catastrofici connessi allo sviluppo dell’intelligenza artificiale, da cui sarebbero al riparo solo le imprese che essi controllano.

«Dobbiamo stare attenti a evitare che queste minacce facciano pensare alla politica che sia un pericolo mettere l’intelligenza artificiale nelle mani di tutti e che quindi si impedisca, tramite regolamentazioni, che lo sviluppo di questa tecnologia sia open source», avverte LeCun[5].

La soluzione originaria di OpenAI era quella giusta, ma l’azienda ha virato senza che i controllori prestassero attenzione al rischio reale che si nascondeva sotto lo spauracchio delle graffette. Lo spettro di Clippy si aggirerà per Copilot, ma stavolta sarà molto più accorto.

Aggiunge LeCun: «Immagina un futuro in cui tutte le nostre azioni saranno mediate dall’intelligenza artificiale. Se questi sistemi saranno chiusi e controllati da un piccolo numero di aziende tecnologiche californiane, allora ci esponiamo a rischi enormi. Potrebbero per esempio usare la loro influenza per modificare la cultura o le opinioni politiche delle persone. Di conseguenza abbiamo bisogno di un sistema aperto e open source che permetta di creare applicazioni specifiche basate su di esso».

È ora che gli intellettuali tornino a essere adulti, e ricomincino a farsi carico di problemi seri.

BIBLIOGRAFIA

Bottazzini, Paolo (2023), Nella caverna di ChatGPT, in ChatGPT-4, Imito, dunque sono?, Milano, Edizioni Bietti, 2023, pagg. 44-45.

ChatGPT-4 (2023), Imito, dunque sono?, Milano, Edizioni Bietti, pagg. 166-167.

Dennett, Daniel (2003), Freedom Evolves, New York, Viking Books.

Habermas, Jürgen (1981), Theorie des kommunikativen Handelns, Francoforte, Suhrkamp, cap.1.

Heidegger, Martin (1983), Die Grundbegriffe der Metaphysik : Welt, Endlichkeit, Einsamkeit, Francoforte, Klostermann, Parte II, cap. 2.

Merleau-Ponty, Maurice (1945), Phénoménologie de la perception, Parigi, Gallimard; trad. it. a cura di Andrea Bonomi, Fenomenologia della percezione, Milano, Bombiani, 2003: cfr. in particolare Premessa, pag. 27.

Mitchell, Melanie (2019), Artificial Intelligence: A Guide for Thinking Humans, New York, Farrar, Straus and Giroux, cap. 5.

Searle, John (1995), The Construction of Social Reality, New York, Free Press, cap. 6.

Szegedy, Christian, Zaremba, Wojciech, Sutskever, Ilya, Bruna, Joan, Erhan, Dumitru, Goodfellow, Ian, Fergus, Rob (2013), Intriguing Properties of Neural Networks, «arXiv», preprint arXiv:1312.6199.

NOTE

[1] https://www.reddit.com/r/singularity/comments/181oe7i/openai_made_an_ai_breakthrough_before_altman/?rdt=54043

[2] https://twitter.com/ylecun/status/1728126868342145481

[3] https://www.newyorker.com/magazine/2023/12/11/the-inside-story-of-microsofts-partnership-with-openai

[4] https://www.safe.ai/statement-on-ai-risk#open-letter

[5] https://www.wired.it/article/intelligenza-artificiale-yann-lecun-meta/

AI Act – La prima legislazione europea sull’Intelligenza Artificiale

Anno 45 a.C.: Giulio Cesare legifera sulla circolazione dei carri nei centri abitati – dall’alba alla metà del pomeriggio[1]. L’obiettivo è di snellire il traffico urbano, ridurre la sporcizia (sterco dei cavalli), l’odore e il rumore nelle strade durante il giorno (non è cambiato nulla, mi pare).

Anno 1865: in Gran Bretagna viene promulgato il Red Flag Act[2] che impone alle autovetture (self-propelled vehicles, la tassonomia è importante: distingue dalle vetture a cavalli) di avere un equipaggio di almeno 3 persone, di non superare la velocità massima di 4 miglia orarie sulle strade fuori città e di 2 miglia orarie in città, di essere precedute a 60 yarde da un uomo a piedi con una bandiera rossa che ne segnali l’arrivo, regoli il passaggio di carrozze e cavalli e, infine, faccia fermare il veicolo a motore in caso di necessità.

È una normativa stringente, finalizzata – oltre che a proteggere il lavoro dei vetturini pubblici – a garantire la sicurezza delle persone contro la minaccia del trasporto privato "self-propelled".

Anno 1903: entra in vigore il primo codice della strada organico a New York, a fronte della velocità che possono raggiungere senza sforzo, “effortless”, gli autoveicoli lungo le strade cittadine.

Anno 1929: con poco meno di 250.000 circolanti su tutto il territorio nazionale – nasce il Codice della Strada italiano, che vedrà alcune riedizioni e ammodernamenti, nel 1992 e quest’anno.

Queste normative hanno tutte come principale finalità il contenimento dei rischi per guidatori, passeggeri, passanti e cose a fronte del pericolo generato da una tecnologia: i mezzi di trasporto su strada.

E hanno influenzato lo sviluppo della tecnologia “automobile”, così come la tecnologia “automobile" ha orientato il nostro modo di vedere la realtà e le nostre dinamiche sociali, produttive, economiche - come rilevava Bruno Latour con la sua teoria dei Quasi Oggetti [3]

9 dicembre 2023, due giorni fa: l’Unione Europea – primo organo istituzionale al mondo a farlo – ha approvato l’AI ACT, piattaforma normativa sull’utilizzo delle tecnologie di intelligenza artificiale. [4]

“Un quadro giuridico unico per lo sviluppo dell'intelligenza artificiale di cui ci si può fidare. E per la sicurezza e i diritti fondamentali delle persone e delle imprese.”, dichiara Ursula Va Der Leyen [4].

L’obiettivo di questa legge è “garantire che l'IA protegga i diritti fondamentali, la democrazia, lo Stato di diritto e la sostenibilità ambientale”, permettendo uno sviluppo efficace ma “sicuro” delle innovazioni.

Tra le norme “in negativo” si evidenziano:

“i sistemi di categorizzazione biometrica che utilizzano caratteristiche sensibili, come le convinzioni politiche, religiose e la razza; la raccolta non mirata di immagini del volto da Internet o da filmati di telecamere a circuito chiuso per creare database di riconoscimento facciale; il riconoscimento delle emozioni sul posto di lavoro e nelle scuole; il social scoring; le tecniche manipolative; l'IA usata per sfruttare le vulnerabilità delle persone.” [4]

In positivo, invece, vigerà l’obbligo alla “valutazione dell'impatto sui diritti fondamentali.” [4] Delle applicazioni di IA.

Il punto critico che ha reso complessa la negoziazione è l’utilizzo delle tecnologie di IA da parte delle forze dell’ordine, soprattutto per il riconoscimento biometrico e in tempo reale e la polizia predittiva.

“Alla fine i negoziatori hanno concordato una serie di salvaguardie e ristrette eccezioni per l'uso di sistemi di identificazione biometrica (RBI) in spazi accessibili al pubblico ai fini di applicazione della legge, previa autorizzazione giudiziaria e per elenchi di reati rigorosamente definiti” [4]

Al di là delle specifiche indicazioni normative, va notato che:

- Le istituzioni comunitarie europee hanno adottato un punto di vista molto concreto sull’IA, in cui prevale il suo carattere di tecnologia, con usi ed effetti privati e pubblici

- In quanto tecnologia, come accadde per gli autoveicoli dal 1865 in poi, ne ha considerato i rischi per i soggetti che rappresenta: popolazione e tessuto produttivo, e ha – conseguentemente - imposto delle misure di controllo e di contenimento di questi rischi.

- Nell’ambito dei rischi da contenere, sono stati privilegiati quelli che riguardano la discriminazione, l’invasione del territorio emotivo personale, la manipolazione dei comportamenti e i danni fisici e psicologici agli individui.

- Inoltre, è stata posta una particolare attenzione sulle tecnologie IA definite “ad alto impatto”[5], che includono i sistemi di IA generale-generativa, come Chat GPT 3.5, per i quali è obbligatoria “l’applicazione ex ante delle regole su sicurezza informatica, trasparenza dei processi di addestramento e condivisione della documentazione tecnica prima di arrivare sul mercato”. [4]

In poche parole, i produttori dovranno rendere pubblico come viene addestrato il sistema e su quali basi!

L’IA, con questa normativa, viene assimilata a molte altre tecnologie, anche dal punto di vista del legislatore, perde una parte dell'aura di mito contemporaneo,

viene collocata nella sua “rete di relazioni, che si estende ben oltre la sua forma”[7]

e – dopo la glorificazione dei potenziali vantaggi già avvenuta in molte sedi istituzionali [6] -

i rischi che genera vengono affrontati in modo concreto

come accade, almeno dal 45 a.C., per tutte le nuove tecnologie.

NOTE

[1] Lex Iulia Municipalis, https://www.archeologiaviva.it/4055/rumore-e-traffico-in-citta-un-problema-di-sempre/#:~:text=Gi%C3%A0%20nel%2045%20a.C.%20Giulio,circa%20le%20cinque%20del%20pomeriggio).

[2] https://vlex.co.uk/vid/locomotives-act-1865-808255757

[3] Bruno Latour, Non siamo mai stati moderni, Eleuthera, 2018

[4] https://www.rainews.it/articoli/2023/12/intesa-ue-per-la-legge-su-intelligenza-artificiale-breton-momento-storico-97d8b5ca-141f-4284-a6fb-434b9871ee01.html

[5] Categorizzate per potenza di elaborazione almeno pari a 10^25 FLOPs (floating point operations per second, un criterio tutto sommato più adeguato di quello proposto precedentemente sul fatturato dell’impresa.

[6] Si veda il mio post del 24 ottobre 2023, Etica, morale e intelligenza artificiale, https://www.controversie.blog/etica-intelligenza-artificiale-un-approccio-analitico-e-normativo/

[7] Bruno Latour, Non siamo mai stati moderni, Eleuthera, 2018

OpenAI e Sam Altman - Anatomia di un Qomplotto (prima parte)

Si è molto parlato (nelle scorse settimane) del licenziamento di Sam Altman, amministratore delegato di OpenAI, un laboratorio di ricerca sull'intelligenza artificiale costituito dalla società no-profit OpenAI, Inc. e dalla sua sussidiaria for-profit OpenAI, L.P. L'obiettivo dichiarato della sua ricerca sarebbe promuovere e sviluppare un'intelligenza artificiale amichevole (friendly AI) in modo che l'umanità possa trarne beneficio.

Cerchiamo di ricostruire la vicenda.

1. AMERICAN HISTORY Q

Nella cultura americana contemporanea la Q non è una lettera come le altre, perché esercita una forza mitopoietica di cui il resto dell’alfabeto è privo.

Il 6 gennaio 2021 coloro che assaltano la sede del Congresso a Washington brandiscono bandiere con la Q di QAnon: la teoria del complotto universale che per milioni di persone negli USA (e nel resto del mondo) ha trasformato Donald Trump in un supereroe da fumetto contro i poteri occulti del deep state.

Il 22 novembre 2023 la «Reuters» spiega che il licenziamento di Sam Altman da parte del consiglio di amministrazione di OpenAI sarebbe stato giustificato da una lettera di delazione[1], con cui alcuni dipendenti dell’azienda hanno illustrato ai membri del board i pericoli per l’umanità in agguato nelle prossime versioni di ChatGPT.

Il progetto Q* ha appena superato con successo i primi test e si prepara a liberare nel mondo un’AGI – un’intelligenza artificiale generale – armata di una competenza letteraria vasta quanto l’universo, che include le storie sul Golem e sulle altre hybris del genere Frankenstein.

L’assalto al Campidoglio non ha avviato la guerra civile; la minaccia che dai progressi dei software di OpenAI si inneschi l’«esplosione» di un’intelligena artificiale destinata a sostituire l’uomo nel dominio della Terra confida su una probabilità nulla di avverarsi.

La destituzione di Altman, avvenuta il 18 novembre, è un evento simile ad un colpo di stato; anche più di quello tentato dallo Sciamano e dai suoi compagni al Campidoglio nel gennaio 2021, se si considera che OpenAI ha beneficiato di un investimento di 13 miliardi di dollari da parte di Microsoft[2], equivalente al doppio del PIL della Somalia, superiore a quello di un’altra decina di nazioni africane, e pari a quello dell’Armenia, del Madagascar e della Macedonia.

Il finanziamento è in larga parte da ascrivere al rapporto di fiducia tra Kevin Scott, CTO di Microsoft, e Altman; la sua cacciata non è stata preceduta da alcun segnale di crisi, e si è consumata in una fase di espansione e di prosperità dell’azienda.

ChatGPT 3.5 si è laureato nel gennaio 2023 come il servizio internet con la crescita di utenti più veloce di sempre: in soli due mesi dal lancio ha raggiunto la quota di 100 milioni di utenti attivi[3], bruciando in questa competizione il risultato di TikTok (nove mesi) e quello di Instagram (due anni e mezzo).

Il trionfo ha imposto il tema dell’intelligenza artificiale e delle reti neurali all’attenzione del pubblico di massa, ma ha anche riconsegnato a Microsoft una posizione di primato tra le protagoniste dell’innovazione tecnologica.

Il motore di ChatGPT è stato integrato in Bing, e il suo inserimento strutturale nei prodotti di Office (con il marchio «Copilot») è in fase di sperimentazione avanzata.

Trasformerà il rapporto dei colletti bianchi di tutto il pianeta con i loro computer, convertendo in automatico poche idee scarabocchiate con un elenco puntato in un documento di cinque pagine, o in una presentazione Power Point attrezzata di tutto punto; per converso, sarà capace di tradurre il vaniloquio di ore di riunione in un report agile da condividere via mail, e gestirà le operazioni di controllo delle entrate e delle uscite su Excel.

Tuttavia, i burocrati diventeranno ancora più fannulloni, gli impiegati ancora più analfabeti, e Microsoft gioirà sulle disgrazie umane con un valore di mercato anche più immenso di quello attuale.

Quindi siamo di fronte a un caso di «Q di Qomplotto», per usare un’espressione presa in prestito dall’analisi del caso Qanon elaborata da Wu Ming 1 (2023)?

2. INTELLETTUALI E IMPRENDITORI

La stupidità spiega molti più misteri del retropensiero, e persino più della serietà del giornalismo di inchiesta.

Potrà sembrare un paradosso, ma lo scenario dei profitti smisurati e la prospettiva di una nuova forma di dominazione culturale sulla produzione dei contenuti business, sono all’origine del colpo di mano del CDA contro Altman.

La governance di OpenAI presentava fino al 18 novembre una configurazione ereditata dalla missione originaria della società, fondata sulla strategia «open source» di Altman, Elon Musk e Peter Thiel[4]: il metodo per assicurare un progetto di intelligenza artificiale a beneficio dell’umanità, e priva di rischi per il futuro, coincide con lo sviluppo di modelli accessibili a tutti, quindi sottoposti al controllo dell’intera comunità degli esperti. Anche dopo l’uscita di Musk dal consorzio, e la maggiore integrazione in Microsoft dal 2020, il comparto di OpenAI destinato alla produzione di servizi for-profit è rimasto sottoposto allo scrutinio di un consiglio di amministrazione nominato dalla componente no-profit.

Nel novembre 2023 il board annoverava oltre ad Altman altri quattro personaggi: Helen Toner, Ilya Sutskever, Adam D'Angelo, Tasha McCauley. Toner ha maturato una carriera di primo piano nell’ambito delle organizzazioni umanitarie grazie al suo coinvolgimento nel movimento accademico dell’«altruismo efficace»[5], che si richiama alla lezione dei filosofi morali Peter Singer, Toby Ord, William MacAskill, e che esercita un’influenza di ampio respiro sull’upper class americana.