Cicli glaciali e attività antropica. La concentrazione dei gas serra in atmosfera - Seconda parte

Nel precedente post[1] abbiamo mostrato che, anche se è stata dimostrata la correlazione tra l’aumento spontaneo della concentrazione di gas serra in atmosfera e il comportamento dei moti millenari del pianeta Terra, rimanevano comunque da comprendere alcune incongruenze riguardo a:

- la grande e anomala quantità di gas serra attualmente presente in atmosfera e

- la sua non riconducibilità alla sola attività dell’era industriale.

Quando si parla di emissioni di metano e di cambiamento climatico, il primo e spontaneo pensiero è di puntare il dito verso gli allevamenti di ruminanti. Complice di questo automatismo è la contingenza storica di crescente avversione nei confronti degli allevamenti intensivi per l'approvvigionamento alimentare.

Meno frequentato è, invece, un altro concorrente a questo genere di emissioni che, anche se meno celebre, è non meno importante. Anzi, è forse storicamente ben più influente nell’emissione di questo specifico gas serra: si tratta della coltivazione sommersa del riso[2].

Come promesso, riporterò qui, per brevissimi tratti, l’interessante teoria che William F. Ruddiman, paleoclimatologo della Virginia University, pubblicò nel 2001 assieme all’allora suo studente Jonathan S. Thomson, e che mette in relazione l'invenzione e la diffusione di questa tecnica di coltivazione con l’aumento anomalo di metano immesso registrato a partire da cinque millenni fa.

Mi soffermerò maggiormente sugli aspetti storici e logici che hanno permesso la validazione di questo studio[3].

L’IMPATTO ANTROPOGENICO IN GENERALE

Nei termini di adozione tecnologica, di qualità del processo produttivo e di quantità produttiva, è oggi un’evidenza apprezzabile e scientificamente dimostrata quella dell’impatto che le attività umane hanno sull’alterazione di un equilibrio climatico “naturale”. La schiera di convinti negazionisti è ormai ridotta ad una esigua cerchia che conta più che altro provocatori con altri fini o fenomeni da studio sociologico, che si autoescludono dalle discussioni serie su questo tema.

Tra la fine XIII e la metà del XIX secolo vi è stato un aumento progressivo dell’attività di disboscamento col fine di alimentare gli stabilimenti produttivi e le attività di tipo estrattivo, mentre oggi prosegue principalmente per ampliare la superficie coltivabile del pianeta.

La scoperta dei combustibili fossili avvenuta nel XIX secolo e il loro progressivo impiego in ambito industriale hanno portato all’aumento spropositato delle emissioni di anidride carbonica.

L’aumento delle emissioni di metano è, invece, per lo più imputabile: alla sua fuga accidentale durante l’estrazione e il trasporto delle risorse fossili; all’aumento della popolazione mondiale, combinato al miglioramento delle relative condizioni di vita[4], all’aumento della produzione di rifiuti e alla conseguente dell’estensione delle relative discariche a cielo aperto.

A questi fenomeni si aggiunge anche il necessario aumento delle aree agricole irrigate e di allevamento, che portano a legittimare quel “dito contro” a cui abbiamo inizialmente accennato, rivolto contro le emissioni fisiologiche dei ruminanti, ossia dalle deiezioni e dalla fermentazione enterica, ovvero dalla digestione del cibo.

Alla fine del XX secolo queste emissioni saranno tali da aver raggiunto livelli che equivalgono ai record paleoclimatici di molti milioni di anni fa, in particolari fasi dei processi di intensa formazione delle terre oggi emerse.

Abbiamo, dunque, un sospetto più che fondato: l’impatto antropogenico è la principale causa di questo aumento anomalo degli ultimi tre secoli.

Siamo ora pronti a tornare alla proposta di Ruddiman e Thomson.

LA NASCITA DELL’AGRICOLTURA E LA SCOPERTA DELL’IRRIGAZIONE SOMMERSA: L’ALTRA METÀ MANCANTE DELLE EMISSIONI DI METANO

Intrapresa la strada della ricerca sulla via del sospetto ruolo antropogenico precedente all’era industriale, i due iniziarono a valutare anche i dati archeologici provenienti proprio dall’epoca di quella prima anomalia: la naturale diminuzione di concentrazione di metano in atmosfera si arrestò e iniziò invece a risalire, contrariamente a quanto sarebbe dovuto accadere per migliaia di anni da allora fino alla prossima glaciazione.

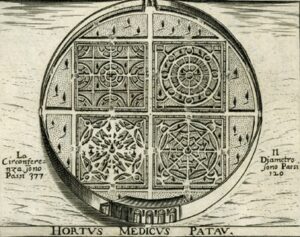

Secondo Ruddiman e Thomson la più probabile spiegazione di questa inversione è da attribuirsi all’invenzione dell’irrigazione del riso, la cui domesticazione della pianta risalirebbe ad almeno 9000 anni fa in Cina, nel bacino dello Yangtze.

La tecnica della coltivazione sommersa, lo dimostrano i ritrovamenti archeologici, era già in uso nelle pianure Sud-Est Asiatiche 5000 anni fa[5], e si estese, 2000 anni dopo, fin nelle pianure dell’India del Nord e Centro-Orientale. Alla sua diffusione si aggiunse poi la progressiva evoluzione dell’ingegneria agricola con la creazione di sistemi di canali sempre più complessi, che portavano l’acqua dai punti più depressi delle pianure fino anche ai fianchi delle colline.

Per comprendere la portata del fenomeno studiato da Ruddiman e Thomson è, tuttavia, opportuno allontanare dalla mente la tecnica di coltivazione odierna di questa pianta erbacea, che ci porterebbe fuori strada

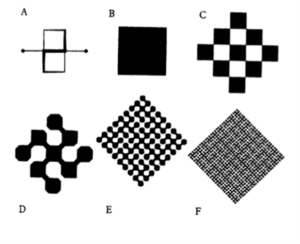

Diversamente dai rifiuti e dall’allevamento, la coltivazione del riso richiede per la propria produzione un’estensione non direttamente proporzionale al numero degli esseri umani che ne dipendono. Questo diviene evidente se pensiamo alla certa inefficienza della coltura del riso a partire dalle sue origini in termini di:

- varietà meno produttive che, a parità di raccolto, imponevano la necessità di inondare aree più estese del suolo;

- maggiore presenza di varietà di erbe infestanti e di biodiversità connesse all’ambiente palustre, ossia alla loro relativa decomposizione nelle stesse risaie.

Come abbiamo visto nello studio del meteorologo J. Kutzbach[6], in tutte le aree palustri, la decomposizione della materia organica in clima anaerobico è a carico dei microrganismi metanogeni, incluse in questa categoria ambientale vi sono le coltivazioni sommerse del riso.

Aree sommerse più estese, in termini pragmatici, significano una maggiore produzione di metano prodotta da questo genere di coltura.

Si può parlare di efficienza tangibile di questa tecnica agricola solo a partire dalla metà del XX secolo, con l’invenzione dei pesticidi e dei diserbanti, i quali non erano prima d’allora nel dominio d’azione tecnologica dell’agricoltore, e anche con l'evoluzione della selezione genetica delle varietà seminate. Efficienza anch’essa con i suoi costi notevoli in termini di impatto ambientale, ma che esulano dal tema che stiamo qui trattando.

Se pensiamo dunque all’insieme di elementi di estensione delle risaie collegata alla loro bassa efficienza, alla loro progressiva diffusione crescente, per millenni, sull’intero pianeta abitato e agli effetti spontanei dovuti all’habitat anaerobico palustre, comprendiamo meglio perché Ruddiman e Thomson avessero ben intuito che dietro alla spiegazione di questa anomalia e delle sue crescenti dimensioni ci fosse sempre una matrice antropogenica: l’invenzione dell’irrigazione agricola, soprattutto quella sommersa del riso.

NOTE

[1] “John Kutzbach e le correlazioni naturali tra i cicli glaciali e la concentrazione dei gas serra in atmosfera.” è il post in questione. Consigliamo al lettore anche la lettura di “Stiamo ritardando la prossima glaciazione? Si.” per aver una visione più chiara e solida del terreno d’indagine in cui si inserisce il presente post.

[2] Faccio presente al lettore che anche il metano (CH₄), per quanto sia un gas più dannoso, è anche meno “famoso” del suo concorrente l’anidride carbonica (CO2). In termini di inquinamento atmosferico il primo è infatti di 25-30 volte più dannoso della seconda.

[3] Il clima globale del Pianeta è un sistema altamente complesso, l’invito che faccio al lettore è di approfondire dunque gli aspetti specifici di questa teoria nel testo di riferimento principale utilizzato per presentargliela: “L’aratro, la peste, il petrolio - L’impatto umano sul clima” di William F. Ruddiman.

[4] Si tenga presente che secondo le stime attuali, l'aumento della popolazione è raddoppiata circa ogni 1000-1500 anni, da 5000 a questa parte. È solo con l'avvento della rivoluzione industriale che la crescita demografica prende ritmi mai visti. Si è stimato il raggiungimento di circa mezzo miliardo di esemplari della specie umana verso la fine 1500, mentre a inizio 1800 era 1 miliardo: oggi circa 8 miliardi in più rispetto a inizio 1500. La stima, su base archeologica, proiettata a 5000 anni fa ammonta a circa 40 milioni.

[5] Curiosità: nello Xinjiang di quasi 4000 anni fa, nell’attuale Cina, si estraeva e si faceva uso domestico del carbone fossile.

[6] Si veda la Nota #1.

FONTI

Willian F. Ruddiman, Jonathan S. Thomson, “The case for human causes of increased atmospheric CH4 over the last 5000 years”, Quaternary Science Reviews, vol. 20, Issue 18, December 2001, pp. 1769-1777, 2001

Ruddiman, “L’aratro, la peste, il petrolio - L’impatto umano sul clima”, UBE Paperback, 2015

Alice Fornasiero, Rod A. Wing, Pamela Ronald, “Rice domestication”, Current Biology, vol. 32, 1º gennaio 2022, pp. R20–R24

Istituto Superiore per la Protezione e la Ricerca Ambientale RAPPORTI 374/2022 Il metano nell’inventario nazionale delle emissioni di gas serra. L’Italia e il Global Methane Pledge, 2022

NASA, “Atmospheric Methane Concentrations”, ONLINE https://climate.nasa.gov/vital-signs/methane?intent=121

IMEO, “Methane Data”, ONLINE, https://methanedata.unep.org/plumemap

Cicli glaciali e attività antropica - La concentrazione dei gas serra in atmosfera

Come abbiamo accennato in un precedente post[1],dallo studio sui cicli glaciali emerge una relazione diretta tra il variare della radiazione solare e la concentrazione naturale dell’anidride carbonica e del metano presenti in atmosfera.

La prima spiegazione valida a questo fenomeno arrivò nel 1981, quando il meteorologo John Kutzbach pubblicò uno studio in cui ipotizzava che, alle latitudini tropicali e in corrispondenza coi moti ciclici millenari terrestri, all’aumento della radiazione solare corrispondesse un aumento di intensità del fenomeno dei monsoni estivi che coinvolgono il Nord Africa [2], con relativa crescita di umidità ed espansione delle aree verdi in regioni attualmente desertiche.

Una delle conferme più incisive di questa teoria arrivò dagli studi effettuati sui carotaggi della calotta glaciale antartica estratti dalla stazione russa di Vostock (arrivata a circa 3.300 metri di profondità), al cui interno si trovavano imprigionate bolle d’aria risalenti fino a circa 400.000 anni fa. Oltre a confermare la maggiore umidità globale nell’epoca interessata dallo studio di Kutzbach, questi risultati rivelarono anche una maggiore presenza di metano nell’atmosfera nei periodi di più intenso irraggiamento solare [3], ossia in coincidenza con la maggiore presenza di vegetazione alle latitudini tropicali.

IL COMPORTAMENTO NATURALE DEL METANO NEI MILLENNI

Da quanto emerge dai carotaggi glaciali e da quelli oceanici, il ciclo di concentrazione atmosferica di CH₄ ha sempre mantenuto un’oscillazione costante nelle decine e centinaia di millenni passati, in correlazione coi moti millenari del pianeta [4].

Come risulta dalle verifiche effettuate in seguito sullo studio di Kutzbach, la variazione della concentrazione di metano in atmosfera è dovuta al fatto che in queste vastissime aree tropicali si trovavano grandi aree verdi che, nei momenti di maggiore intensità monsonica, venivano sommerse: la teoria aveva trovato le sue conferme.

In sostanza, il ristagno di queste acque innescava su scala macroscopica fenomeni di decomposizione organica anaerobica a carico dei microrganismi metanogeni, del tutto analoga a quella degli ambienti palustri.

Questa attività monsonica e i suoi effetti scatenanti le emissioni naturali di metano vanno estesi, oltre che alla regione del Sahel nordafricano studiato da Kutzbach, anche a tutte le vastissime aree tropicali che attraversano l’Arabia meridionale, l’India, il Sudest asiatico, fino ad arrivare alla Cina meridionale [5].

PERCHÉ AUMENTO ANOMALO “RECENTE” DELLE EMISSIONI DI CH₄?

Il ciclo di precessione coi suoi relativi effetti studiati da Kutzbach si compie in circa 25.000 anni, con intensità variabili dovute al concorso degli altri moti millenari compiuti dalla Terra.

Al giorno d’oggi ci troviamo nel minimo storico della radiazione solare estiva, a circa 10.000 anni di distanza dal massimo, e la concentrazione atmosferica di metano, anziché diminuire come era stato previsto, è aumentata.

Come risulta dalle diverse attività di studio elencate in precedenza, l’arresto del decremento e questo trend di anomalo aumento sono cominciati ben 5000 anni fa, ossia molto prima della rivoluzione industriale, a cui fino ad allora si attribuiva l’unica variazione anomala, e il cui inizio oscilla tra 250 e 200 anni fa.

Rimaneva ancora inspiegato e dunque attribuito a fattori "naturali" e “non-industriali” l’incremento precedente a quest’ultima era della produzione umana, a vantaggio anche dei negazionisti di un anomalo cambiamento climatico in atto e di chi faceva dunque risalire le cause a questi non ben precisati fenomeni naturali.

Se la spiegazione determinante di questi cambiamenti fosse risieduta nella sola “Natura”, allora il clima terrestre sarebbe dovuto andare incontro a un raffreddamento globale. Invece non è stato così.

Non solo le temperature medie sono aumentate, ma anche le emissioni di gas serra prodotte negli ultimi 250-200 anni non erano spiegabili, in quanto rappresentavano la sola metà del totale presente in atmosfera registrato all’epoca dei suoi studi.

La metà mancante andava cercata altrove e, escluse di per certo le cause naturali, il sospetto rimaneva in ambito antropico.

---------------------

La risposta a questo comportamento anomalo pre-industriale arrivò quando William Ruddiman ebbe un'intuizione, che verrà descritta in un prossimo post.

NOTE

[1] Il post è “Stiamo ritardando la prossima glaciazione? Si.” e ne consigliamo la lettura in quanto propedeutico alla comprensione di questo presente.

[2] Questa teoria nacque dall’obiettivo primario di comprendere perché nella zona desertica del Sahel vi siano testimonianze di una precedente esistenza di fiumi e vegetazione.

[3]Vedi nota #1

[4] Fatta ovviamente esclusione per le emissioni straordinarie di metano dovute alle naturali attività vulcaniche, riconoscibili perché corrispondono ad aumenti di proporzione in un lasso brevissimo di tempo.

[5] Il lettore sarà agevolato nella comprensione di questo fenomeno di desertificazione progressiva se riporterà la sua mente agli studi scolastici sulle popolazioni della “Mezzaluna Fertile”, nonché ai monumenti e alle città ritrovate, ora in pieno deserto.

Stiamo ritardando la prossima glaciazione? Sì.

Sia il lettore più attento che quello più frettoloso avranno notato che nel titolo è già contenuta la risposta. Per quanto sinteticamente perfetta, ad entrambi, anche al più frettoloso, risulterà una risposta troppo breve ed interesserà perciò comprendere il perché di questo “Si”.

Questa evidenza emerse da una serie di studi che iniziarono negli ultimi anni del XX secolo e che si svilupparono lungo il primo decennio del XXI.

Il primo riscontro della disattesa partenza di una nuova era glaciale fu uno studio diretto dal paleoclimatologo William Ruddiman che coinvolse i meteorologi John Kutzbach e Steve Vavrus.

Essi cercarono, e trovarono – grazie a un modello di simulazione matematica che il climatologo Larry Williams creò negli anni ’70 - la conferma di quanto negli anni ‘80 aveva scoperto il geologo John Imbre: l’ultima fase interglaciale doveva essere terminata tra i 6.000 e i 5.000 anni fa.

Questo modello sul comportamento climatico venne impostato escludendo, tra i fenomeni che influenzano l’alternanza tra ere glaciali e interglaciali, le emissioni anomale di gas serra, iniziate quasi esattamente nello stesso periodo di fine dell’ultima fase interglaciale.

Secondo i risultati del modello, da allora i ghiacciai avrebbero dovuto iniziare ad accrescersi progressivamente, per via di un raffreddamento medio globale di 2°C (tantissimo in soli 6-5.000 anni) e il punto di massimo raffreddamento avrebbe dovuto presentarsi a Nord della Baia di Hudson, toccando un calo medio invernale di 5-7°C.

Però, ciò non è avvenuto.

Ancor più precisamente, lo studio rivelò che nell’Isola di Baffin (Canada) si sarebbe dovuto instaurare uno stato di glaciazione incipiente, ossia la presenza di un manto nevoso perenne, contro la sua attuale assenza per 1-2 mesi ogni estate.

In più, ai giorni nostri, avremmo dovuto assistere a qualcosa di analogo nell’altopiano del Labrador, il penultimo luogo in cui si sciolsero i ghiacciai dell’ultima glaciazione; il primo era per l’appunto l’isola di Baffin.

Lo studio generò sia plausi che critiche, e da queste ultime Ruddiman fu stimolato a fare ulteriori approfondimenti che lo portarono a studiare una glaciazione intercorsa ben 400.000 anni fa, che presentava variazioni della radiazione solare e delle emissioni naturali di gas serra analoghe a quelle della fase odierna.

L’approfondimento confermò quanto previsto dallo studio precedente e mai avvenuto perché interrotto cinque millenni fa: si sarebbe dovuto registrare un progressivo decremento fino ai valori minimi della concentrazione in atmosfera di metano (CH₄) e anidride carbonica (CO2).

Questi ulteriori studi, in sostanza, riconfermavano quanto ipotizzato: siamo oggettivamente all’interno di una fase glaciale, ma climaticamente ritardata. La causa del ritardo è da ricondursi prevalentemente a questa anomala alta concentrazione di gas serra.

PERCHÉ “OGGETTIVAMENTE” ALL’INIZIO DI UNA NUOVA FASE GLACIALE?

Se nel brevissimo periodo, anche di poche ore, è difficile prevedere localmente quale sarà il comportamento meteorologico, questo può essere, invece, fatto per il comportamento climatico globale nei tempi più lunghi delle decine e centinaia di migliaia di anni.

I paleoclimatologi hanno infatti già da tempo scoperto l’esistenza di veri e propri cicli climatici. Lo hanno potuto fare incrociando i dati geologici e paleontologici (soprattutto dai carotaggi oceanici) con quelli chimici (presenza di molecole e atomi con isotopi specifici presenti nei ghiacci e nei sedimenti fossili dei fondali marini) assieme alle leggi astronomiche ormai note dei moti terrestri detti “millenari”.

Su questi ultimi possiamo basare la “oggettività” che cercavamo.

I MOTI MILLENARI DEL PIANETA TERRA.

Se il moto orbitale della Terra attorno al Sole causa l’avvicendamento delle stagioni in circa 365 giorni, le cosiddette “ere” glaciali e i periodi interglaciali, fenomeni molto più lunghi nel tempo, sono invece principalmente conseguenza della variazione della quantità di radiazione solare ricevuta dal Pianeta, dovuta a tre movimenti che la Terra compie in decine di migliaia di anni.

1. Il primo è quello dell’oscillazione dell’asse di rotazione terrestre: scoperta dal matematico e astronomo francese Urbain Jean Joseph Le Verrier nel XIX secolo, è una lenta variazione dell’angolo di inclinazione dell’asse, che compie il proprio ciclo oscillatorio tra 22° 20’ e 24° 50’ in 41.000 anni circa.

Essa influisce direttamente sulla quantità di radiazione solare che raggiunge le latitudini più elevate del Pianeta (dai 45° N in su).

In termini più semplici: minore è il grado d’inclinazione dell’asse terrestre, minore sarà la quantità di radiazione che ricevono i poli terrestri, minori dunque saranno le temperature del clima globale e viceversa.

Attualmente l’inclinazione è di 23° 50’ circa, in fase di risalita verso la gradazione minima.

I restanti due moti influiscono invece sulla variazione della distanza della Terra dal Sole, che in termini empirici equivale alla sensazione che possiamo esperire d’inverno nel variare di pochi centimetri la nostra distanza dal tanto amato calorifero (i più freddolosi sanno bene quanto pochi centimetri facciano la differenza tra felicità e sofferenza).

2. L’eccentricità dell’orbita del Pianeta attorno al Sole: varia in un ciclo di circa 100.000 anni ed è quel fenomeno per cui l’orbita della Terra tende ad essere ellittica e solo ad avvicinarsi a un’orbita circolare (il cerchio ha eccentricità pari a 0).

Sempre scoperta da Le Verrier, questa variazione influisce sulla distanza media che il Pianeta mantiene rispetto al Sole (ripensate alla vostra distanza dal calorifero nelle giornate invernali e all’invidia che avete provato verso i compagni di classe o i colleghi che gli stavano più vicino durante l’intera giornata).

Le sue oscillazioni periodiche sono molto più irregolari rispetto a quelle dell’asse terrestre e attualmente si attesta a 0,0167, in un raggio di variazione totale tra il valore minimo di 0,0033 e quello massimo di 0,0671. In termini pratici parliamo di variazioni nell’ordine dei milioni di chilometri di differenza di distanza dalla fonte di calore che è il Sole.

3. Per ultimo abbiamo il moto di precessione, dal ciclo più breve di 25.000 anni, ossia il moto conico dell’asse di rotazione della Terra dovuto all’attrazione reciproca con la Luna e gli altri pianeti.

Scoperto nel XVIII secolo dal famoso enciclopedista francese Jean-Baptiste Le Rond d'Alembert, questo fenomeno è meno intuitivo da immaginare e viene spesso spiegato attraverso il moto di una trottola, la quale non solo gira su sé stessa ma possiede anche un movimento che la porta ad ondeggiare e inclinarsi da una parte all'altra: il moto di precessione.

Gli effetti che questi moti hanno sul clima sono anche chiamati Cicli di Milanković, dal nome dall'ingegnere e matematico serbo Milutin Milanković che li ipotizzò e studiò ai primi del XX secolo.

CONCLUSIONI

Anche se il clima è il risultato di un sistema complesso le cui variabili generano altrettanti e complessi meccanismi di feedback, in generale possiamo immaginare che valga la regola per cui ogni fenomeno che modifica per lungo tempo il comportamento della radiazione solare ricevuta dalla Terra, è determinante sul lungo tempo per il clima globale del Pianeta; i suoi effetti, però, saranno sempre riscontrabili con leggero ritardo.

La relazione tra i vari moti millenari determina dunque, oltre alla ricorrenza dei periodi glaciali, anche l’intensità con cui essi si presenteranno ciclicamente.

I dati raccolti dai paleoclimatologi ci rivelano inoltre che la storia delle glaciazioni è in realtà molto recente. È da 3 milioni di anni che la Terra si sta lentamente raffreddando, con la comparsa dei primi ghiacciai, solamente stagionali, risalente a circa 2,75 milioni di anni fa nelle regioni settentrionali del Pianeta.

È invece da “soli” 0,9 milioni di anni che hanno iniziato ad esistere i ghiacciai permanenti.

Nel periodo delle decine e centinaia di migliaia di anni, il clima globale è dunque prevedibile grazie ai modelli fisici ed astronomici confermati dagli studi di geologi, paleologi e paleoclimatologi: abbiamo la certezza che, anche basandosi esclusivamente sul moto di precessione, ci troviamo già dentro l’inizio di una nuova era glaciale - che non è però mai iniziata.

Quasi certamente questo inizio disatteso è da attribuirsi alle emissioni in atmosfera dei cosiddetti “gas serra”, che, come è ormai accettato dalla quasi totalità delle comunità scientifiche, non permettono la naturale dispersione della quantità di radiazione solare ricevuta dal pianeta che invece continua a riscaldarsi.

Inoltre, secondo i modelli climatici, questi gas sarebbero dovuti diminuire anziché aumentare, ostacolando l’innescarsi dei feedback positivi e naturali di innesco della prossima glaciazione.

Stiamo ritardando la prossima glaciazione? Si.

PER APPROFONDIMENTI

William Ruddiman, “L’aratro, la peste, il petrolio - L’impatto umano sul clima”, UBE Paperback, 2015

William Ruddiman, “Earth’s Climate”, Freeman, 2001

Gemelli digitali del pianeta? No grazie - Una riflessione sui "futuri simulati"

Un articolo recentemente pubblicato sul giornale WIRES Climate Change offre una critica articolata delle iniziative anche Europee di costruire dei gemelli digitali dell’intero pianeta, comprensivi di oceani, atmosfera, biosfera, e degli umani con le loro economie e società. Di cosa si tratta?

Molti gemelli artificiali sono già di uso corrente, in ingegneria, medicina e gestione dei processi. Secondo il sito della IBM un gemello digitale

… È una rappresentazione virtuale di un oggetto o sistema, disegnato per riflettere accuratamente un oggetto fisico. Esso copre l’intera vita dell’oggetto, viene alimentato con dati in tempo reale e usa simulazioni, nonché tecniche di apprendimento automatico (machine learning)

Gemelli di una turbina, di un ciclo produttivo o di un cuore umano, possono aiutare nello sviluppo di nuovi prodotti, processi o farmaci.

Il passaggio da una turbina al pianeta con noi sopra non è ovviamente cosa da nulla. Questi megamodelli gireranno su supercomputers inghiottendo enormi banche dati e generando immensi output che potranno essere ‘letti’ con l’ausilio di intelligenze artificiali. Essi ci consentiranno, secondo chi li propone, di affrontare le sfide dell’antropocene (un termine usato per indicare una nuova fase geologica caratterizzata da un visibile impatto umano) con particolare attenzione ai cambiamenti climatici. I gemelli del pianeta saranno collegati in tempo reale con satelliti, droni, boe, cavi sottomarini, sensori della produzione agricola e telefoni mobili.

Euronews, una rivista con sede a Bruxelles, si porta avanti, e annuncia: 'Gli scienziati hanno costruito un "gemello digitale" della Terra per prevedere il futuro del cambiamento climatico'. Secondo Margrethe Vestager, Vicepresidente Esecutiva per un'Europa dell’era digitale:

Il lancio dell'iniziale Destination Earth (DestinE) è un vero punto di svolta nella nostra lotta contro il cambiamento climatico... Significa che possiamo osservare le sfide ambientali, il che ci aiuterà a prevedere scenari futuri - come non abbiamo mai fatto prima... Oggi, il futuro è letteralmente a portata di mano.

DestinE è la versione europea dei numerosi progetti volti a costruire gemelli digitali del pianeta. L'idea che possiamo costruire una replica in silico (cioè nella pancia di un computer) della Terra ha un chiaro fascino culturale, una visione prometeica di fuga definitiva dell'umanità dalla materialità, accolta con entusiasmo come si vede da diversi decisori politici e da molte istituzioni scientifiche, come si puo’ vedere dal numero speciale del giornale Nature Computational Change, che discutendo diverse applicazioni del gemelli digitali presenta l’estensione all’intero pianeta come una naturale evoluzione della tecnologia. Perché opporsi, quando tanti fondi appaiono a portata di mano per sviluppare computers e modelli più potenti per studiare la Terra, il suo clima, l’evoluzione metereologica e gli eventi estremi? L’iperbole diventa di rigore, e così si arriva a dire che i gemelli preconizzano una nuova fase nello sviluppo dell’umanità, dove il mondo diventa “cyber-physical” cioè senza più barriere fra il virtuale ed il reale, grazie al suo nuovo esoscheletro.

Pubblicare un articolo critico come quello offerto da Wires Climate Change diventa così una sfida per gli undici autori, che richiede pazienza e una certa dose di ostinazione per procedere nonostante i rifiuti di molti giornali di scienze naturali. Quali ragioni adducono questi autori a ‘mettersi di traverso’? Le ragioni sono diverse e fanno riferimento a diverse scuole e discipline – come gli stessi autori:

- I proponenti dei gemelli digitali della Terra sostengono che essi, aumentando la risoluzione spaziale dei modelli, fino alla scala del kilometro, ci consentiranno di decifrare i misteri del cambio climatico. Per i dissidenti sopracitati:

Più alta è la risoluzione (cioè, maggiore è la localizzazione), più emergono feedback non fisici come rilevanti, che si tratti degli effetti microclimatici delle foreste o dei micropattern di albedo dovuti al ricongelamento di pozze acquose sulle calotte di ghiaccio. Il cambiamento di scala spesso comporta cambiamenti non banali nella complessità e nei principi che governano il sistema, e scale più dettagliate possono rivelare comportamenti caotici deterministici. Una risoluzione diversa potrebbe richiedere descrizioni di processi differenti, forse ancora sconosciute.

- I gemelli sono il risultato di una catena di riduzioni: la scienza viene ridotta alla fisica delle equazioni che governano il cambiamento climatico, e questa viene a sua volta ridotta ad un determinismo che solo esiste nelle equazioni stesse.

- L’enfasi sui gemelli, anche per affrontare sfide come la difesa della biodiversità, stravolge la natura della sfida e ne sposta il baricentro dal sud globale, dove si trovano le specie da classificare e difendere, al nord globale dove l’attenzione si concentrerà sulle specie sulla quali esistono più dati.

- Il progetto dei gemelli illustra drammaticamente l’autorità epistemica (relativa alla conoscenza) assunta dai modelli e da chi li opera. Gli eccessi di tale autorità, resi evidenti nel corso della recente pandemia, sono evidenti nella impostazione dei gemelli, che tendono a posizionare il cambio climatico – di certo reale e incombente – come una mono-narrazione cui tutto deve fare riferimento, comprese guerre, migrazioni, e derive autoritarie, con il risultato di oscurare la geopolitica con la fisica a danno dei deboli che si vorrebbero difendere dal cambiamento climatico.

- I gemelli digitali emergono da un intreccio di cambiamenti sociopolitici e tecnologici, in cui i numeri – indipendentemente da come vengono generati, siano essi visibili, come nelle statistiche, o invisibili, come quelli che girano nel ventre degli algoritmi – influenzano sempre più il discorso sociale, causando l’allarme dei filosofi, dei giuristi, degli economisti e degli stessi tecnologi, per non parlare degli esperti che studiano la sociologia della quantificazione e la sua relazione con la politica.

Quest’ultimo bullet, relativo alla relazione fra modelli, numeri e politica, si presta a interessanti digressioni, su come i numeri conferiscano potere epistemico e legittimità, e siano diventati il mezzo prevalente per esprimere valore nelle nostre società. L'accesso e la produzione di numeri riflettono e rafforzano le strutture di potere esistenti. I numeri catturano la nostra attenzione orientandola selettivamente. I numeri sono diventati invisibili poiché penetrano ogni aspetto della vita attraverso grandi modelli, algoritmi e intelligenza artificiale. Numeri e fatti sono diventati sinonimi. I numeri hanno colonizzato i fatti.

Un’altra digressione possibile riguarda il "fact signalling” con i numeri – «una pratica in cui i tropi stilistici del pensiero logico, della ricerca scientifica o dell'analisi dei dati vengono indossati come un costume per rafforzare un senso di giustizia morale e certezza». Questa è diventata un'attività dilagante praticata da esperti, presunti verificatori di fatti, politici e media. Un'arte simile è praticata dai cosiddetti ‘imprenditori di valori’ – esperti il cui lavoro consiste nel misurare il valore sociale di diverse iniziative al fine di stabilire legittimità, dimostrare conformità, cambiare comportamenti o giustificare un campo. Il fact signalling è anche praticato da attori industriali per difendere i propri interessi sotto il pretesto di difendere la scienza dai suoi presunti nemici. I numeri sono diventati una misura di virtù, ed i gemelli del pianeta ce ne forniranno in abbondanza.

Una terza ed ultima digressione – ci perdoneranno i lettori – riguarda il ruolo dei mezzi di comunicazione in quanto discusso fin qui. I media hanno sostanzialmente fallito nel monitorare adeguatamente gli esperti, spesso presentando le opinioni degli stessi esperti come certezze. Sul fronte cruciale della politica, i media contribuiscono a una campagna futile per difendere la democrazia e i valori dell'illuminismo attraverso la “verifica dei fatti” (sempre con numeri). Come osservato da un linguista cognitivo, ciò avvantaggia le forze antidemocratiche moltiplicando il loro messaggio: contare le bugie di Trump significa parlare di Trump ogni giorno. L'uso sconsiderato dei numeri banalizza i valori della politica e indebolisce la vita democratica.

Tornando ai gemelli del pianeta, si può concludere con una ricetta in quattro punti per un futuro più gentile, basata sullo sviluppo di diversi modelli specifici e adatti allo scopo piuttosto che su un modello universale, sull'esplorazione del potenziale di modelli semplici basati su euristiche in contesti climatici/ambientali, sulla raccolta e integrazione di dati da fonti divergenti e indipendenti, inclusa la conoscenza tradizionale, e sull'abbandono di una visione del pianeta centrata sulla fisica a favore di una diversità di processi relazionali, sia sociali che biologici, naturalmente fluttuante e irriducibilmente incerta, che richiede pratiche di cura più pluraliste e provvisorie per contrastare le narrazioni socio-ecologiche della modernizzazione ecologica, della crescita verde, dei servizi ecosistemici e simili.

Questa non è una discussione del tutto nuova. Il sociologo della scienza Brian Wynne osservava quaranta anni fa in relazione ai grandi progetti di modellizzazione:

Che sia deliberatamente concepito e utilizzato in questo modo o meno, la grande modellizzazione può essere interpretata come un simbolo politico il cui significato centrale è la diseducazione e la privazione del diritto di partecipazione delle persone dalla sfera della politica e della responsabilità.

Wynne suggeriva inoltre che:

In effetti, l'analisi delle politiche, specialmente quella condotta attorno a modellizzazioni su larga scala, tende ad essere strutturata in modo tale che ogni gruppo di modellizzazione costituisca virtualmente la propria ‘peer community’ [la comunità di esperti in grado di verificare la qualità del prodotto scientifico].

È quindi legittima la preoccupazione?

---------------------------------

Una versione di questo articolo è apparsa in inglese nel blog ‘The Honest Broker’ di Roger Pielke Jr., settembre 2024.

Razionale e reale - Osservazioni a margine del problema della determinazione dell’individuale-concreto

La tradizione classica vuole che dell’individuale non si dia scienza.

Ciascuna concrezione individuale appare contrassegnata da una quantità di connotazioni accidentali, contingenti, che sfuggono alla possibilità di una normatività esaustiva. Di conseguenza, si è consuetamente ritenuto sensato che la scienza si occupi del generico (o specifico), ossia del categoriale, di ciò che ha una sua forma (e quindi uno statuto legale) in linea di principio esaustivamente definibile.

La costituzione teorica razionale-astrattiva, per quanto saturabile di contenuti reali mediante determinazione delle variabili empiriche delle strutture formali, soggiace comunque alla limitazione della irraggiungibilità del concreto.

In questa prospettiva, H. Weyl parla di una genericità intrinseca alla scienza, che non può giungere mai all’individualità fenomenica: i suoi oggetti concreti restano indeterminati, o meglio, sono determinati “a meno di un isomorfismo” (1). E gli isomorfismi non sono altro che identità strutturali (di natura formale) tra eventi o processi potenzialmente del tutto differenti, per quanto concerne i corrispettivi contenuti materiali.

Individuale materiale e individuale formale

Il problema della determinazione del concreto-reale, ossia di ciò che è per principio individuale, non è connesso solo alla complessità della contingenza, ossia non affonda le sue radici solo nel momento materiale, bensì si presenta già nel momento formale.

In geometria, l’inafferrabilità del particolare-reale, dell’individuale, si è affacciata all’origine della cultura occidentale con la scoperta dell’incommensurabilità, una scoperta che fece peraltro vacillare la fiducia nell’idea stessa di razionalità.

L’irrazionalità dell’individuale-formale, in ambito matematico o geometrico, si esprime nella non-finitezza della sua determinazione numerica.

Del tutto correlativamente - in ambito materiale - la costituzione fenomenologica dell’individuale percettivo si realizza attraverso un infinito e inesauribile processo di avvicinamento all’oggettualità trascendente, un processo-limite chiamato adombramento (Abschattung) (2).

Da questo ordine di riflessioni emerge, in una prospettiva più generale, l’inafferrabilità di principio della determinazione individuale mediante un numero finito di determinazioni razionali (irrazionalità del reale)

Secondo A. N. Whitehead (3), ciascuna “occasione reale” (ossia ciascun oggetto o evento concreto) include una “gerarchia astrattiva infinita di oggetti eterni” (ove con “oggetti eterni” sono da intendersi le unità concettuali). Quando invece la gerarchia astrattiva è finita, si tratta di “inclusione parziale”, e pertanto di eventi mentali, e non reali (ricordi, immaginazioni, idee, ecc.).

Un altro modo di significare che solo gli enti irreali, costruibili e immanenti, sono esaustivamente definibili mediante una serie finita di determinazioni. Una proprietà, questa, che può essere vista anche come criterio per una distinzione fenomenologica tra configurazioni reali (trascendenti la coscienza) e configurazioni ideali (immanenti).

I numeri irrazionali trascendenti: numeri che sfuggono agli algoritmi

Restringiamo ora le nostre osservazioni alla determinazione formale dell’individuale.

Il genio della lingua matematica rispecchia lo stato delle cose sopra accennato fino nella semantica della teoria dei numeri reali.

I cosiddetti numeri razionali sono i numeri interi o quelli esprimibili come rapporti tra numeri interi.

Vi sono poi i numeri irrazionali (algebrici), che presentano una irrazionalità - diciamo così - di primo livello, in quanto si tratta di numeri che, seppure non esprimibili mediante rapporti di numeri interi, sono però esprimibili come radici di equazioni algebriche.

I razionali e gli irrazionali algebrici sono entrambi costruibili secondo algoritmo generativo, e pertanto è possibile stabilire un criterio affinché siano posti in correlazione biunivoca. Georg Cantor dimostrò (4) che l’insieme dei numeri razionali e quello dei numeri irrazionali algebrici (che parrebbero molto “di più”) hanno la medesima potenza: la prima potenza infinita, ossia quella del numerabile, una potenza, cioè, gerarchicamente inferiore alla potenza del continuo.

In altre parole, né l’infinita discrezione degli interi, né l’infinita densità dei razionali e degli irrazionali algebrici sono in grado di riempire tutti i “buchi” della retta reale, ossia non sono in grado di costituire la continuità, che è infinitamente più coesa.

La classe numerica che dà coesione e compattezza alla continuità della retta numerica reale è quella dei numeri irrazionali trascendenti (ossia i numeri che trascendono l’algebra). Si tratta di numeri che non possono essere espressi come radici di equazioni algebriche a coefficienti reali. Immaginativamente, possiamo vedere gli infiniti numeri interi, razionali e irrazionali algebrici, come isole sporadiche e trascurabili nell’oceano della continuità dei trascendenti.

E il curioso è che questi numeri trascendenti, che costituiscono l’infinita maggioranza dei numeri reali, non sono sistematicamente costruibili secondo alcun algoritmo generativo meccanico. Anzi, se ne conoscono relativamente pochi individui (e, π, e i loro composti) e alcune sporadiche specie costruibili.

Del resto, trascendere l’algebra significa trascendere l’algoritmo.

Il numero reale è pertanto, nella sua assoluta generalità, un numero irrazionale trascendente. La probabilità di estrarre casualmente dalla retta reale un numero che non sia un irrazionale trascendente, è formalmente nulla. Possiamo dire quindi che il reale si identifica con l’irrazionale trascendente.

Se non esiste un algoritmo generativo dei numeri reali, esiste però un principio determinativo generale, per quanto non-costruttivo, un principio ideale dato in forma definitoria e non algoritmica. Nell’analisi matematica della retta reale, il numero reale, ossia l’individuo generico, si identifica con il limite di successioni convergenti di numeri razionali (definizione di Cantor). Tra l’altro, nella visione cantoriana, la successione stessa, intesa come individualità attualmente infinita, è da vedersi come il numero reale, mentre l’identificazione del suo valore con il limite della successione, è una conseguenza, ossia un teorema (5).

Irrazionalità, non-costruibilità e non-riproducibilità del reale: ambiguità del concetto di virtuale

Dalle circostanze qui brevemente esposte, derivano alcune considerazioni di carattere significativo generale, almeno in ambito formale.

La prima e fondamentale è che l’individuale-reale è per essenza irrazionale, ossia non è esaustivamente determinabile mediante un numero finito di determinazioni finite (razionali).

In secondo luogo, la trascendenza esprime la circostanza che esso non è, nella generalità, costruibile. Abbiamo detto che trascendere l’algebra significa trascendere l’algoritmo. Ciò significa che la determinazione individuale non è - in linea di principio - raggiungibile da algoritmo.

In sintesi, l’individuale, nella sua costituzione formale, si mostra come una attualità infinita, irrazionale e trascendente la costruibilità algoritmica.

Un altro genere di considerazioni riguarda la circostanza che la determinazione formale dell’individuale-reale non riguarda unicamente la data individualità in questione, ma coinvolge per principio un insieme infinito di altre entità individuali particolari (razionali). Queste entità razionali, per quanto “oasi sporadiche nell’oceano della continuità trascendente”, sono pur esse infinite e densamente (inestricabilmente) connesse con la compattezza del reale. Ciò significa che la determinazione formale dell’individuo reale non è - in linea di principio - estrapolabile dal contesto d’ordine in cui esso è inserito, ma è inestricabilmente connessa con la totalità attualmente infinita dell’ordinamento reale. In altre parole, la determinazione dell’individuale-reale non può considerarsi avulsa dalla comprensione dell’infinita compattezza e connessione della contingenza reale e della gerarchia astrattiva razionale in esso inclusa.

Tutte queste considerazioni convergono all’evidenza che i procedimenti di simulazione e modellazione algoritmica - cosi come i procedimenti costruttivi in generale - non possono giungere, per principio, alla concretezza trascendente della determinazione reale-individuale.

La constatazione della trascendenza del reale rispetto la computabilità logica è contenuta già nel principio di ragion sufficiente di Leibniz. Così come il suo principio degli indiscernibili esclude la possibilità formale di eguaglianza numerica tra configurazioni reali.

L’individuale-reale non è, per principio, né computabile né riproducibile.

Nel dibattito odierno la dualità reale-virtuale, sostanzialmente fattuale, pare predominante rispetto alle distinzioni categoriali classiche.

L’odierna accezione di virtuale mutua il termine dalla tradizione meccanica dell’età illuministica.

Nel principio dei lavori virtuali di D’Alembert (6), con virtuali si intendono gli spostamenti o le deformazioni (di un sistema materiale rigido o elastico) infinitesime e compatibili con i vincoli al contorno. Da questo principio si evince infine che la configurazione reale è, di caso in caso, una sola e unica composizione - tra quelle potenzialmente infinite - di equilibrio e di congruenza. Il calcolo variazionale si mostrava allora come lo strumento analitico privilegiato per la determinazione della configurazione effettuale entro l’infinito ventaglio della potenzialità.

Con virtualità si intende dunque, originariamente, una categoria modale, e precisamente il potenzialmente reale. Evidentemente oggi il termine mostra una traslazione di senso, circostanza che porta con sé le inevitabili zone di ambiguità.

Oltre l’obiettivismo

Forse oggi soffriamo l’assenza di una consuetudine all’analisi categoriale, che nell’ontologia critica della prima metà del ‘900 aveva raggiunto elevati livelli di raffinatezza.

Probabilmente, per certi argomenti altamente problematici, quali la riproducibilità, la modellabilità, la simulabilità e la computabilità del concreto, così come - a monte - per i problemi concernenti la conoscenza formale in-genere (ossia quella non semplicemente empirico-percettiva), potrebbe essere adeguato e fruttuoso non limitarsi a procedimenti di tipo dimostrativo-computazionale.

Godel, in uno dei suoi ultimi scritti (7), invitava i giovani e i futuri ricercatori a trovare la via d’uscita dai paradossi, dalle indecidibilità e dalle oscurità delle teorie formali, non tanto in progressivi ampliamenti metateorici o complessificazioni computazionali, quanto piuttosto in un rigoroso lavoro immanente di chiarificazione e di elaborazione dei significati fondanti.

Il problema dell’obiettivismo, denunciato programmaticamente nella Crisi di Husserl (8), non si presenta solo nelle scienze empiriche, ma, del tutto coerentemente, anche nelle scienze logiche e matematiche, ossia nelle discipline formali.

Più precisamente, l’obiettivismo si mostra in queste ultime sotto forma del primato della computazione e della dimostrazione formale, ossia di procedimenti che possiamo anche chiamare - oggi - artificiali, in quanto per principio avulsi da ogni riferimento all’intenzionalità.

E in questa prospettiva la distinzione procedurale-intenzionale è ben più fondativa di quella (fattuale) artificiale-naturale.

Ma qui si apre evidentemente un altro orizzonte di tematiche.

Riferimenti bibliografici

(1) Weyl, Filosofia della matematica e delle scienze naturali, 1949

(2) Husserl, Idee per una fenomenologia pura e per una filosofia fenomenologica, Vol. 1, 1913.

(3) N. Whitehead, La scienza e il mondo moderno, 1925

(4) Cantor, Su una proprietà dell’insieme di tutti i numeri reali algebrici, 1874

(5) Cantor, Fondamenti di una teoria generale delle molteplicità, § 9, 1883

(6) B. Le Ronde d’Alembert, Traité de dynamique, 1743

(7) Gödel, Il moderno sviluppo dei fondamenti della matematica alla luce della filosofia, 1961

(8) Husserl, La crisi delle scienze europee e la fenomenologia trascendentale, 1938

Newton, Leibniz e il calcolo infinitesimale - uno scontro tra visioni del mondo

Per Gottfried Wilhelm Leibniz (1646-1716) non furono erette statue o monumenti. Pochi, anzi pochissimi, parteciparono al suo funerale, benché fosse stato per tutta la vita vicino agli alti vertici dei nascenti stati nazione, e sebbene per decenni avesse svolto l’incarico di storico dell’allora casata di Hannover. Dieci anni più tardi, la morte di Isaac Newton (1642-1726) sortì tutt’altra reazione: al funerale presenziò persino Voltaire, poco più che trentenne, e che di lì a pochi anni avrebbe scritto gli Elements de la philosophie di Newton (1738), diventando, al ritorno dal suo esilio in Inghilterra,1 il principale divulgatore del pensiero newtoniano sul continente. Cinquant’anni più tardi l’architetto francese Étienne-Louis Boullée (1728-1799) realizzò in onore di Newton i sei disegni del fantaprogetto del cenotafio. Con l’obbiettivo di «donare a Newton l’immortale luogo di riposo, il paradiso»,2 Boullée progettò una colossale cupola alta circa centocinquanta metri adagiata su di una zona d’appoggio adornata d’alberi perfettamente allineati, impossibile da realizzare tecnicamente.

L'accesa rivalità tra due dei più eminenti filosofi e scienziati del proprio tempo è stata spesso semplificata e ridimensionata a una mera contesa. Il che ha comportato la riduzione del problema al solo tentativo di stabilire chi dei due sia giunto per primo alla formalizzazione del calcolo infinitesimale. La morte e i funerali a volte bastano per dichiarare un vinto e un vincitore. Lo scontro tra nazioni – e la correlata tendenza a prendere posizione da una parte o dell’altra dello stretto di Dover, e dunque a stare con Parigi o con Londra – ha ulteriormente alimentato tali opposizioni riduttive.

Dopo più di un millennio in cui il calcolo della superficie e del perimetro di figure curve si era accontentato dell’antico metodo d’esaustione, e dopo i primi vagiti di una nuova matematica che aveva preso forza a cavallo tra il sedicesimo e diciassettesimo secolo, Leibniz e Newton rappresentarono per l’Europa d’allora gli inventori dell’ analisi infinitesimale che permetteva, a partire dalla curva, il calcolo dell’ «equazione tangente e il valore della sua curvatura in un punto generico, […] la tangente, massimi e minimi»3 tramite ciò che Leibniz chiamò «rapporto differenziale» e Newton «calcolo delle flussioni».

In effetti, tra i due ci fu una contesa circa la paternità del calcolo. Il filosofo di Lipsia sosteneva di aver sviluppato il fulcro delle proprie scoperte ben prima dell’inglese, mentre quest’ultimo affermava di aver consegnato al tedesco una lettera, passata tra le mani dell’amico in comune Oldenburg, dove per la prima volta dimostrava le proprie scoperte.4 Mentre Newton aveva sviluppato il grosso della propria teoria già nel 1669, Leibniz iniziò ad ottenere dei risultati non prima del 1672, pubblicando le prime scoperte nel 1676. Nel 1711, per dirimere la disputa, fu chiamata in causa come parte giudicante la Royal Society, di cui lo stesso Newton era Barone dal 1715. Ne risultarono il Commercium epistolicum (1715) e la Recensio Libri, quest’ultima pubblicata anonimamente ma scritta con ogni probabilità dal fisico inglese, e in cui si condannava definitivamente Leibniz sotto gli occhi di tutto il mondo accademico del tempo.5 Newton, si diceva, aveva inventato il nuovo calcolo infinitesimale.

Riannodiamo i fili, la disputa tra Leibniz e Newton fu, semplicemente, una contesa? La sociologia delle scienze e delle tecnologie ci ha recentemente fornito un’interpretazione originale del concetto di controversia.6 Rivolgiamolo dunque al nostro caso. Ciò che accadde tra Leibniz e Newton fu una contesa o una controversia? Cambia qualcosa?

L’indicazione di Enrico Giusti è rivelatrice: «chi legge i documenti relativi alla disputa fra Leibniz e Newton circa l’invenzione del calcolo infinitesimale, […] ha l’impressione che si stia svolgendo un dialogo tra sordi».7 Non tanto perché i due non si siano voluti ascoltare, il che trasformerebbe nuovamente l’evento in una contesa. Per quanto comunichino e si attacchino, essi non paiono disquisire del medesimo oggetto. Il problema non è certo che «non si è mai capaci di parlare della stessa cosa». Piuttosto, ricostruendo il nugolo di considerazioni intorno al «calcolo infinitesimale» nell’uno e nell’altro autore, e al di là della disputa ufficiale, non ci troviamo più davanti a due oggetti simili che, in fondo, sono conciliabili. Simili - scrive sempre Giusti - «ma irrimediabilmente diversi».8

Se a parità di calcolo le due formulazioni restituiscono risultati pratici sostanzialmente sovrapponibili - dunque a parità di esattezza matematica - concettualmente sono in aspro contrasto, se non addirittura incompatibili. Finché ci si focalizza soltanto nello stabilire la paternità del calcolo, tutta la questione appare come una semplice contesa. Questa peculiarità del concetto di controversia è stata forse sottostimata: perché non ci sia controversia, basta non porsi la questione. Altro lato della medaglia: perché non ci sia controversia, basta ridurla a una contesa, alla morte dell’uno e al trionfo dell’altro, come d’altronde si premurò di fare l’esegesi illuminista che aveva infervorato Voltaire e Boullée, e che avrebbe spinto Immanuel Kant (1724-1804) a essere molto più newtoniano che leibniziano.

Ciò detto, rimane da risolvere il problema inverso. Supposto che una controversia possa differire da una contesa, bisognerà stabilire il senso di questa differenza. Se tra Leibniz e Newton avvenne una contesa, ci riduciamo a determinare storicamente chi è giunto per primo a ciò che chiamiamo «analisi infinitesimale». Il modo della relazione è già definito, ciò che resta da stabilire è unicamente la priorità cronologica di un attore sull’altro. Se, diversamente, tra i due ci fu una controversia - e qui ci viene in soccorso l’etimo della parola - ciò che v’è da stabilire è proprio il modo della relazione dell’uno e dell’altro: in una contesa ci si muove verso l’oggetto comune, in una controversia il moto è appunto «contrario» l’uno rispetto all’altro, per «versi» differenti. Ecco una seconda peculiarità: se il concetto di contesa è fin troppo generalizzabile - tutto può diventare contesa -, il concetto di controversia sembra perdere qualcosa di vitale laddove dovesse venire generalizzato. Una relazione già definita, come quella di contesa, è ipso facto generalizzabile. Al contrario, laddove si debba ancora definire il modo della relazione, non c’è alcunché di generalizzabile, se non tramite una semplice accezione negativa. Infatti, propriamente parlando, che si dica che due elementi sono in rapporto di controversia, è affermare che non è definito il modo di quel rapporto di direzione contraria dell’uno rispetto all’altro.

Torniamo dunque ai contendenti. Dei due, Leibniz è meno ambiguo sul posizionamento generale del calcolo all’interno del suo più ampio sistema di pensiero. Come hanno mostrato Gilles Deleuze ne La piega (1988) e Michel Serres nei due tomi de Le système de Leibniz et ses modèles mathématiques (1968), il rapporto differenziale dx/dy in combinazione con alcune considerazioni circa le serie convergenti, ossia tendenti verso un limite comune, rappresentano due principi ineliminabili dell’intero sistema matematico-metafisico del filosofo tedesco. A tal proposito, Ludovico Geymonat ha sostenuto, nel suo corso sulla Storia e filosofia del calcolo infinitesimale (1946-1947), che «mentre in Newton l’invenzione del calcolo infinitesimale fu dettata da preoccupazione essenzialmente tecniche, in Leibniz invece essa scaturì da considerazioni essenzialmente filosofiche».9 Il tedesco immaginava un fuscum subnigrum animato e in constante variazione. L’ha ripetuto Michel Serres nel Parassita, «il rumore di fondo è il fondo dell’essere».10 La monade è imperscrutabile qualora non considerassimo ciò che ha rimarcato Deleuze, se «le monadi non hanno finestre, attraverso le quali qualcosa possa entrare o uscire»,11 come recita la famosa VII proposizione de La monadologia, è perché tra monade e mondo c’è un rapporto di rispecchiamento reso possibile proprio dalle considerazioni di Leibniz circa il rapporto differenziale. Il calcolo di Leibniz - scrive sempre Deleuze - è inseparabile da un’anima: se il mondo è una serie infinitamente infinita di cui la monade è l’inversa, la coscienza funziona per integrazione di rapporti differenziali. Se un’infinita schiera di piccole percezioni inconsce si integrano tra di loro - ossia entrano in un rapporto differenziale convergente - divengono coscienti.12 Di conseguenza la soglia della coscienza non è l’effetto di un rapporto differenziale, bensì è il rapporto stesso, un «ripiegamento del mondo», una piega, o come annotava Leibniz nei Principi razionali della natura e della grazia «se fosse possibile dispiegare tutte le pieghe dell’anima, le quali tuttavia si esplicano in maniera evidente solo nel tempo, si potrebbe conoscere la bellezza dell’universo in ciascuna anima. Infatti ogni percezione distinta dell’anima contiene un’infinità di percezioni confuse che implicano tutto l’universo».13

Che dire di Newton? L’analisi infinitesimale ha una posizione ambigua. Se da un lato Newton sostenne sempre la finalità pratica del calcolo, e dunque la parziale estraneità dello strumento rispetto al reale, una ricognizione di ciò che scrisse in fatto di teologia e fisica[14] - caso paradigmatico è lo scolio generale che chiude i Principia[15] - rivela, in fondo, il tentativo di armonizzare la realtà stessa a quello che doveva essere un semplice «calcolo pratico». Insomma, diversamente da come si è ripetuto fino allo sfinimento, e a partire dalle accuse di oscurantismo e filosofeggiamenti che Newton mosse a Leibniz,16 chi dei due sia stato il vero empirico è tutto da vedere. Per riassumere nel modo più contratto la differenza sostanziale, si potrebbe affermare che mentre il sistema di Leibniz, inteso come immagine del reale, postula l’infinito in actu, implicato, come ragion sufficiente del sistema stesso, la teoria di Newton, rappresentazione della realtà-pratica, ostracizza l’infinito a favore dell’atomo e delle quantità «infinitamente piccole» che, tuttavia, rimangono «estese».17 Quello dell’inglese è un calcolo di flussioni, ossia dei movimenti di un punto per grandezze infinitamente piccole. E tuttavia, quest’ultimo sarà obbligato a reintrodurre ciò che aveva precedentemente escluso, così che il materialismo atomistico affermato con tanta dissimulata leggiadria venga calmierato reintroducendo un finalismo che ne giustifichi l’unità di base. Lo chiamerà Dio poiché, come confidava in una lettera a Bentley, «il materialismo granulare non potrebbe in alcun modo ‘trasformare il caos in un cosmo’». Per Leibniz, contrariamente, l’atomismo scevro d’infinito è una semplice «debolezza dell’immaginazione»:18 dev’esserci, in fondo, un punto animato. Come ha scritto il sociologo Gabriel Tarde in Monadologia e sociologia (1895), «perfino nella parte solida, se la conoscessimo meglio, dovremmo eliminare quasi tutto. E così di eliminazione in eliminazione, dove arriveremo mai, se non al punto geometrico, cioè al punto nullo, a meno che questo punto non sia un centro?»[19]

NOTE

1 Com’è noto la figura di Pangloss, maestro filosofico di Candido, è una parodia del pensiero di Leibniz. Come si legge in “Candido o l’ottimismo” in Voltaire, Vol. II, tr. it. P. Angioletti, e M. Grasso, RBA, Milano 2017, p. 216, Pangloss, insegnante di «metafisico-teologo-comolonigologia provava in modo ammirevole come non potesse esistere effetto senza causa, e come nel migliore dei mondi possibili il castello del monsignor barone fosse il più bello dei castelli, e la signora la migliore di tutte le baronesse».

2 Da Etienne-Louis Boullée, Architecture: Essai sur l’Art , trans. Sheila de Vallée, in Helen Rosenau, Boullée and Visionary Architecture (London: 1976) in P. L. Ricci, Lux et tenebris: Etienne-Louis Boulé’s Cenotaph for Sir Isaac Newton.

3 L. Geymonat, Storia del pensiero filosofico. scientifico, Vol. II, Garzanti editore, Milano 1970, p. 378.

4 Si veda il recentemente ripubblicato Disputa Leibniz-Newton sull’analisi, a cura di G. Cantelli, Bollati Boringhieri editore, Torino 2023.

5 Per approfondire la successione cronologica degli eventi si veda A. R. Hall, Philosophers at war, Cambridge University Press, 2009.

6 H. M. Collins, T. Pinch, Il Golem (1993), Dedalo, Bari 1995.

7 E. Giusti, “Introduzione”, in Disputa Leibniz-Newton sull’analisi, cit., XIII

8 Ibidem.

9 L. Geymonat, Storia e filosofia dell’analisi infinitesimale, Bollati Boringhieri editore, Torino 2008, p. 141.

10 M. Serres, Il Parassita (1980), Mimesis edizioni, Milano 2022, p. 77.

[11] G. W. Leibniz, Monadologia, Bompiani editore, Milano 2017, §7, p. 61.

12 Per il rapporto tra coscienza e inconscio differenziale si veda il capitolo VII, “La percezione nelle pieghe” in G. Deleuze, La piega (1988), Giulio Einaudi editore, Torino 2004, pp. 139-162.

13 Ivi, “Principi razionali della natura e della grazia”, §13, p. 51.

14 Si veda I. Newton, Trattato sull’apocalisse, a cura di M. Mamiani, Bollati Boringhieri editore, Torino 2022.

15 Geymonat ne parla in Storia del pensiero filosofico e scientifico, Vol. II, Garzanti editore, Milano 1970, p. 524.

16 Scriveva Newton ne lo Scolio, «infatti qualsiasi cosa non si riesca a dedurre dai fenomeni, deve chiamarsi ipotesi; e tutte le ipotesi, siano esse della metafisica, della fisica, della meccanica o delle qualità occulte, non hanno posto nella filosofia sperimentale». Nelle battute conclusive della recensio libri si legge “Si deve senza dubbio ammettere che fra Newton e Leibniz sussiste un enorme differenza nel modo di trattare la filosofia. Il primo procedere solo fin dove lo conduce l’evidenza dei fenomeni e delle esperienze, [...] il secondo è tutto imbevuto di ipotesi, che avanza non già come proposizioni da doversi esaminare con l’esperienza, ma che verità cui si deve credere a occhi chiusi”, Cantelli, p. 80.

17 Scrive Newton nello Scolio generale dei Principia, riportato da L. Geymonat, Storia del pensiero filosofico e scientifico, Vol. II, cit., p. 522, «l’estensione, la durezza, l’impenetrabilità, a mobilità e la forza d’inerzia delle part del tutto nasce dall’estensione, la durezza, l’impenetrabilità, dalla mobilità e dalla forza d’inerzia delle parti: di qui concludiamo che tutte le minime parti di tutti i corpi sono estese e Dre, impenetrabili, mobili, e dotate di forza d’inerzia. E questo è il fondamento dell’intera filosofia»

18 G. W. Leibniz, “Nuovo sistema della natura e della comunicazione delle sostanza e dell’unione tra l’anima e il corpo” (1695), in Scritti Filosofici, vol. I, cit., p. 190, §3.

19 G. Tarde, Tarde, Monadologia e sociologia (1895), tr. it. F. Domenicali, Ombre corte, Verona, 2013, p. 45.

Mai fidarsi della bellezza - Inganni e illusioni di un criterio scientifico

La bellezza può essere una splendida guida per lo sviluppo di formalismi matematici, ci suggerisce in questo blog Matteo Donolato (Che bella equazione! – Il ruolo della bellezza nelle scienze) seguendo il pensiero di P. Dirac.

Ai fisici teorici, in particolare, piace maneggiare teorie e oggetti matematici “belli”, addirittura considerano l’eleganza come un criterio di successo delle formulazioni teoriche, delle spiegazioni della realtà, delle descrizioni dei sistemi fisici.

Tuttavia sembra necessario essere cauti, perché a volte la bellezza matematica può nascondere dei tranelli.

Un bel formalismo matematico, infatti, ha il pregio di rendere la descrizione della realtà più semplice, più maneggevole, apparentemente più efficace e più elegante, ma, spesso, non rappresenta la realtà nel suo modo di essere effettivo, nei suoi comportamenti fenomenici.

Proviamo a fare qualche esempio:

- Il primo può essere l’identità di Eulero: è bellissima, compatta e semplice; comprende una serie di elementi che ricorrono in tutte le matematiche e geometrie – euclidee e non – ma, poiché è un’identità, non significa altro che un oggetto è identico a sé stesso, seppur descritto in modi diversi.

Esattamente come Hesperus e Vesperus, la stella del mattino e la stella della sera; nomi diversi per la stessa cosa, vista da angolazioni diverse, ma pur sempre una e una sola cosa è: il pianeta Venere.

L’identità di Eulero racconta di come la bellezza matematica possa diventare un formalismo di nessuna utilità nella pratica scientifica e applicativa.

È opportuno ricordare Husserl[1], quando accusava Galileo e, con lui, molta scienza della modernità, di realismo metafisico, di aver dimenticato – inseguendo i formalismi idealizzati – il contatto con il mondo delle cose reali.

Un secondo esempio – dobbiamo però per un attimo dimenticare che è stato falsificato nel ‘600 – è il modello geocentrico aristotelico-tolemaico dell’universo con la terra, con noi/io al centro di tutto. Cosa c’è di più bello, simmetrico, elegante, appagante, soprattutto per chi lo ha disegnato, di questo modello? Secondo il punto di vista antico era anche efficace nella rappresentazione della realtà. In parte anche per il nostro punto di vista: nella nostra esperienza quotidiana, non pare anche a noi di essere fermi, con il cielo che ci gira intorno?

Come sappiamo, però, questo schema non ha retto il confronto con i paradigmi successivi; per cui, è “caduto” ed è stato sostituito da un altrettanto elegante modello (quello di Newton) basato su un formalismo matematico, anch’esso, come ci dice Matteo Donolato, di grande bellezza: la legge della gravitazione universale.

Ecco, quindi, il terzo esempio: la legge di gravitazione universale si basa su un “oggetto scientifico”[2] misterioso e mai dimostrato: la forza di attrazione gravitazionale, cioè un’azione a distanza tra due corpi macroscopici.

“Oggetto” che è stato a sua volta sostituito, nella teoria della relatività, dalla nozione di campo gravitazionale. Che fa a meno della forza.

Il quarto ed ultimo esempio di bellezza teorica e matematica, nel campo della fisica delle particelle, è la Teoria supersimmetrica delle stringhe (o supersimmetria); questa teoria è in grado – grazie a dei formalismi matematici giudicati molto eleganti da quasi tutti i fisici – di descrivere il mondo dei bosoni e dei fermioni, e converge nella Teoria del Tutto: un tentativo di unificazione delle teorie quantistica e relativistica.

La “supersimmetria” – teoricamente – permetterebbe anche di aver a che fare con quantità e numeri vicine all’unità, che molti fisici definiscono “naturali”; e di evitare di far uso del cosiddetto “fine tuning”, cioè di aggiustamenti della teoria – assimilabili alle cinture di protezione di Lakatos – a fronte di casi particolari e risultati non allineati con le previsioni.

La teoria della supersimmetria, però, non sembra dare frutti sperimentali. Nessuno dei suoi risultati riesce a essere testato, con ovvio fastidio dei fisici che hanno puntato sulla sua produttività potenziale.

----------------

Al contrario, possiamo fare degli esempi di formalismi “non così belli” che – almeno per ora – sono di successo e (abbastanza) testati sperimentalmente.

Il modello che descrive una cosa apparentemente banale come i pennacchi di fumo (avete presente quelli che escono dalle ciminiere?) è costituito da un sistema di equazioni che - già in una approssimazione semplificata - riempiono almeno due pagine di un normale libro di testo – solo come formalismo matematico.

Purtroppo, un pennacchio di fumo non può essere descritto con formule prese dalla geometria solida; è, invece, un oggetto di grandissima complessità in cui compaiono più di un centinaio di fattori e termini e ancora non ne è descritta completamente la struttura. È più brutta di un orco delle favole. Ma funziona piuttosto bene.

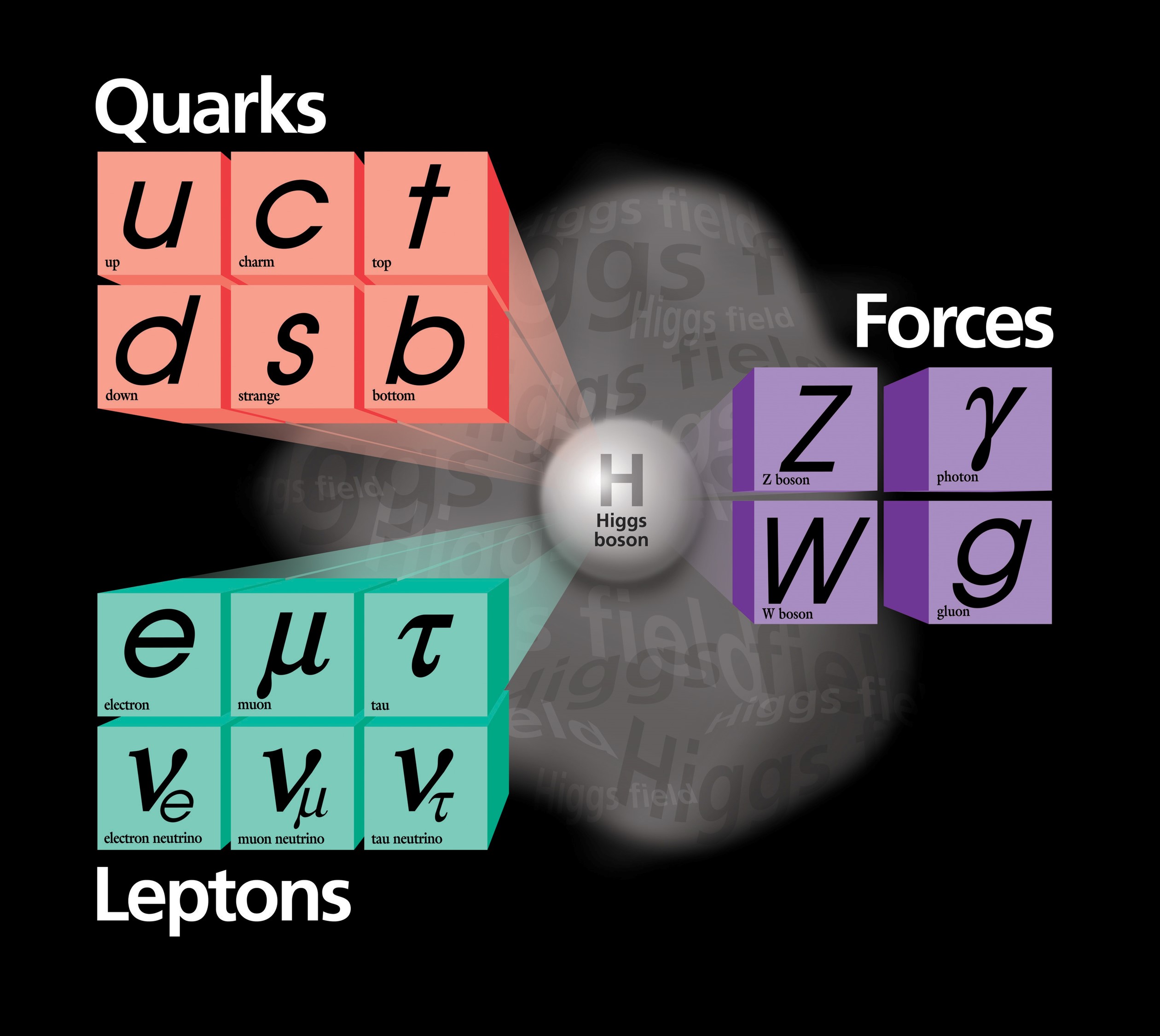

In fisica delle particelle, il "Modello standard", teoria che resiste da alcuni anni e che ha numerosi riscontri sperimentali – non ultima la rilevazione del bosone di Higgs, previsto anni prima e ora “trovato” e misurato sul campo – è abbastanza orribile, se misurata con il criterio della bellezza e dell’eleganza: più di 25 particelle “elementari”, tra cui: 6 fermioni detti quark; 8 gluoni privi di massa; 6 leptoni, che non partecipano alle interazioni forti; il fotone; 3 bosoni massivi; in ultimo il bosone di Higgs, massivo, neutro elettricamente e funzionale a dare massa a fermioni e bosoni. Tutti questi suddivisi in tre generazioni, in funzione della massa; inoltre, le generazioni non sono definite da criteri matematici a priori ma solo dalla necessità di “far funzionare” il modello (se mi si passa la semplificazione). “Vi delude che il modello standard sia così brutto?” dice Sabine Hossenfelder[3]

--------------

Sembra, quindi, estremamente pericoloso per i fisici, per i naturalisti - e direi persino per gli economisti - che desiderano descrivere in maniera realistica l’universo, affidarsi a dei formalismi molto belli.

Pericoloso perché il mondo e l’universo, nel loro presentarsi sono per lo più disuniformi, presentano continuamente singolarità, sfuggono al principio di omogeneità.

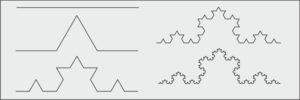

I casi eleganti come, ad esempio, le strutture polimorfe oggi chiamate frattali, sono eccezioni notevoli; tanto che uno strutturalista nato nella matematica come Roger Caillois, li presenta e li esalta proprio come eccezionalità, come fenomeni notevoli.

I salti, le catastrofi, le singolarità, sono la norma della realtà.

In fisica e nelle scienze naturali è meglio non fidarsi - e non affidarsi - alla bellezza matematica.

Si rischia di perdere la strada…

NOTE

[1] E. Husserl, La crisi delle scienze europee e la fenomenologia trascendentale, Il Saggiatore, Milano, 2015

[2] L. Daston, Biographies of scientific objects, The University of Chicago Press, Chicago and London, 2000

[3] S. Hossenfelder, Sedotti dalla matematica, Raffaello Cortina Editore, Milano, 2019, pag. 182

La matematica e la logica sono istituzioni sociali

Il sociologo britannico David Bloor (n. 1942) nel 1976 pubblicò un libro, Knowledge & social imagery [1], che segnò una svolta nella sociologia della scienza. Al suo interno egli si interessa di quelle che vengono comunemente ritenute discipline che hanno una natura cogente, che rispecchiano verità uniche e immutabili: la matematica e la logica. Con l’obiettivo di arrivare al nocciolo (che lui ritiene profondamente sociale) della conoscenza matematica:

«l’idea che la matematica sia variabile, allo stesso modo dell’organizzazione della società,

viene considerata da molti sociologi un’enormità»[2].

Eppure, già il filosofo, storico e scrittore tedesco Oswald Sprengler, nel suo famosissimo Il tramonto dell’Occidente (1918), e Ludwig Wittgenstein, nel difficile Osservazioni sopra i fondamenti della matematica (1956), avevano ipotizzato una connessione tra mondi di numeri e mondi di civiltà.

Anche il matematico, logico e filosofo tedesco Gottlob Frege, ne I fondamenti dell’aritmetica nel 1884, aveva argomentato che la matematica (contrariamente alla posizione di John Stuart Mill, presentata in Sistema di logica raziocinativa e induttiva del 1843) non era una scienza induttiva, nel senso che non si basava sull’esperienza, cioè su operazioni fisiche sugli oggetti. L’idea di Mill poteva tutt’al più essere utile pedagogicamente, ossia a insegnare ai bambini ad apprendere la matematica attraverso la manipolazione di oggetti (sassolini, granelli di pepe, biglie ecc.).

Frege sostiene che i numeri non sono esperienza: chi ha mai avuto esperienza dello zero («zero sassolini») o di numeri estremamente grandi come 10.000.000.000? Avere esperienza di «una cosa», non significa avere esperienza del numero 1, dice Frege. I numeri naturali (0, 1, 2, 3 ecc.) servono per numerare, ma non si identificano con le cose numerate. Infatti, hanno proprietà che non si trovano nella cosa numerata (es. il pari o il dispari), che non si vedono né si toccano, mentre si vedono e toccano le cose a cui essi si riferiscono. Allo stesso modo è difficile sostenere che i numeri ‘immaginari’ (es. 2i), che nascono dal fatto che non è possibile calcolare la radice quadrata di un numero negativo, e i numeri ‘complessi’ (dati dalla somma di una parte reale e una immaginaria - es. 5 + 2i) siano astrazioni ottenute da cose reali.

E anche il matematico tedesco Richard Dedekind, nel suo Essenza e significato dei numeri (1888), riteneva i numeri libere creazioni dello spirito umano, del tutto indipendenti dalla realtà, e un’emanazione diretta delle pure leggi del pensiero.

Come sottolinea il matematico italiano Enrico Giusti (1999) anche gli oggetti della geometria euclidea (retta, piano, lunghezza, area, cerchio, angoli, ecc.) non provengono dall’astrazione di oggetti reali, esterni, indipendenti dall’osservatore, ma da un processo di oggettivazione delle procedure, di pratiche sociali che formalizzano l’operare umano (come tracciare un cerchio sul terreno usando una corda ecc.). La matematica si sviluppa mediante il ripetersi di una sorta di modulo che porta a «fissare», e quindi a far esistere, gli oggetti matematici. Questo avviene in tre fasi: inizialmente vengono introdotti nuovi strumenti, metodi dimostrativi originati da idee innovative; poi essi diventano soluzioni di problemi e insieme oggetti di studio; infine, se vengono accettati, acquistano una vera e propria esistenza oggettiva.

Lo stesso sostiene Bloor (1976/1994, p. 143-4):

i tessitori di tappeti imparano a riprodurre un modello osservando e lavorando con gli altri. Dopo di che possono lavorare autonomamente e applicare più e più volte la tecnica a nuovi casi. Potrebbero, per esempio, mettersi a tessere il tappeto più grande che si sia mai visto: a loro basta solo aver imparato ed essersi esercitati su quelli piccoli.

Questa è la natura delle tecniche.

Analogamente, una spiegazione dell’aritmetica può basarsi su un’esperienza di portata limitata, a condizione che l’esperienza fornisca modelli, procedure e tecniche che possano essere applicati

o riprodotti all’infinito.

Certamente la matematica non nasce dall’esperienza e dalla percezione (come già sosteneva Frege), ma viene inventata.

Tuttavia, secondo Bloor, essa non è solo un’invenzione (un gioco formale, mentale, puramente soggettivo) senza rapporti con la realtà circostante, perché essa nasce da necessità, da una manipolazione empirica.

In altri termini, essa è un’invenzione sociale, una costruzione (quindi con una certa dose di arbitrarietà) basata su pratiche. Gli enti matematici hanno, quindi, la natura di costrutti ideali, che trovano però un fondamento in una concreta prassi umana che col tempo si stabilizza e si generalizza nella forma di soluzione di problemi.

Bloor, quindi, da una parte accetta la posizione di Frege; dall’altra la porta alle estreme conseguenze, criticando lo stesso Frege e rivalutando e correggendo Mill (che aveva parlato della matematica anche come realtà soggettiva, psicologica): se i numeri non sono basati su una realtà empirica bensì su nozioni teoriche (altamente elaborate, le più fini e le più pure che mai mente sia riuscita a pensare), da dove vengono queste nozioni? Se non dalla natura, allora dalla cultura: «la componente teorica della conoscenza è proprio la componente sociale»[3].

-----------

Bloor comincia quindi, fenomenologicamente, a immaginare una matematica alternativa[4] in cui gli esiti delle operazioni dovrebbero produrre sistematicamente risultati diversi. In questa idea apparentemente assurda, egli trova conforto nella matematica greca antica, dove il numero 1 non era considerato un numero. Non era neppure pari o dispari; esso era entrambi, cioè parimpari, perché era considerato il punto di partenza, il generatore dei numeri (1+1=2; 1+1+1=3 ecc.), sia dei pari che dei dispari, per cui partecipava di entrambe le nature (pp. 155-6). All’interno di questa visione, l’1 è anche il numero più grande perché contiene tutti gli altri numeri; è inoltre il numero con il più alto numero di relazioni/rapporti con gli altri numeri, perché tutti i numeri partono da lui e sono scomponibili nell’unità minima che è 1. Infine, l’1 è la totalità, la parte più grande: se si scompone/taglia l’1 (es. 1 torta), le parti che emergono (2, 3, 5 ecc.) sono più piccole dell’1 interezza o totalità. Peraltro, etimologicamente il numero 2 sembra derivi da «taglio».

La matematica dei pensatori pitagorici e, successivamente, dei platonici era di tipo catalogatorio e riecheggiava le classificazioni in uso nella vita quotidiana. Tale “schema di classificazione simboleggiava la società, la vita e la natura [...] I vari tipi di numeri ‘stavano per‘ proprietà come la Giustizia, l’Armonia e Dio“ (p. 169). Era una matematica applicata, usata per questioni pratiche e carica di magia: per esempio i Pitagorici consideravano il 2 un numero femminile, come tutti i numeri pari, e il numero 10 era collegato alla salute e all’ordine del cosmo. Un po’ come la smorfia napoletana[5] oppure il simbolismo numerico nella Bibbia, dove (ad esempio) il 3 era la perfezione (mentre la stessa, per i Maya, era rappresentata dal 4). Il 4 nel Medioevo era considerato un numero perno e risolutore (quattro sono i punti cardinali, i venti principali, le stagioni, le fasi lunari, le arti liberali del quadrivio, i lati del quadrato a cui veniva paragonata la Terra, in opposizione al triangolo del cielo, simbolo della Trinità). Inoltre, 4 è il numero della perfezione morale e delle proporzioni dell'uomo. Il 7 è il numero buddhista della completezza.

Bloor quindi ha trovato una matematica alternativa: “è chiaro che se non riconosciamo il misticismo del numero come una forma di matematica, nessuna questione di matematica alternativa può essere posta [...] esso rende tautologico il fatto che non via sia una matematica alternativa»[6]. Quindi la matematica non ha una vita propria o un significato intrinseco racchiuso negli stessi simboli che devono essere solo percepiti e compresi[7].

Bloor si chiede: la radice quadrata di 2 è un numero irrazionale (1.41421 35623…), come sostengono i moderni, oppure non è per niente un numero, come dicevano gli antichi greci? Nessuna dimostrazione giungerà a risolvere la questione perché si tratta di visioni matematiche incommensurabili, il cui «significato [non] risiede sulla carta o nelle procedure simboliche del calcolo stesso»[8]. Occorre che esistano determinate condizioni sociali, cioè un sistema di classificazioni e un insieme di significati culturalmente condivisi, perché il calcolo abbia un significato[9].

Quindi il numero è un ruolo[10], una posizione da non confondersi con l’oggetto che incontra stando in quel ruolo. Ma se parliamo di ruoli, posizioni, allora ci troviamo nel campo della sociologia e i numeri possono essere tranquillamente definiti delle istituzioni sociali: «se la matematica riguarda i numeri e le loro relazioni e se queste sono prodotti e convenzioni sociali, allora, effettivamente, la matematica riguarda qualcosa di sociale»[11].

Citando le conclusioni a cui giunge il filosofo (di origini lettoni) Jacob Klein, studioso del pensiero matematico greco, Bloor sostiene che «attribuire alla nozione di numero una tradizione di significato unica e ininterrotta sia un errore [...] la continuità che noi vediamo nella tradizione della matematica è artificiale. Deriva dal fatto che attribuiamo il nostro stile di pensiero a opere precedenti»[12].

----------

Per concludere, e rafforzare l’idea di un nucleo sociale della matematica, possiamo notare che i numeri raramente vengono usati in forma pura o astratta. Più spesso appaiono sempre insieme a un referente: “possedere 5 case”, “decidere in 2”, “conservare 10 lingotti”.

Il referente è il motore dell’interpretazione, del giudizio, dell’invidia o risentimento. Inoltre, a seconda del referente, possono perdere la loro natura cardinale: avere 3 figli non vuol dire avere 3 volte 1 figlio e non è come avere 3 sassolini o 3 fagioli.