Neuroscienze e giudizio morale - Emozione e razionalità appartengono a sistemi distinti?

L’oggetto di questa controversia è il modello di funzionamento dei correlati neurali dei giudizi morali.

Nell’ambito delle neuroscienze (vedi i due articoli precedenti: Il libero arbitrio oltre il dibattito filosofico – Incontro con le neuroscienze e Incontri con le scienze empiriche) sono stati fatti numerosi studi che si appoggiano alle tecniche di neuroimaging funzionale, seguendo tre filoni principali di lavoro:

- Lo studio di pazienti con danni o lesioni cerebrali e pazienti con patologie psichiatriche (“Bad brains”, Greene 2014a, 2020);

- L’analisi della valutazione morale di certi atti o situazioni da parte di individui sani (“Good brains”, ibid.);

- Lo studio delle modificazioni cerebrali durante la valutazione di dilemmi morali come il Trolley dilemma, il Footbridge dilemma e il Crying Baby dilemma.

Per contestualizzare meglio, ecco qualche definizione e informazione sugli studi con pazienti con lesioni cerebrali e sui tre principali dilemmi morali:

PAZIENTI CON LESIONI CEREBRALI

Le ricerche su pazienti con lesioni cerebrali o patologie psichiatriche offrono dati interessanti per l’indagine sul coinvolgimento di determinate aree del cervello nella realizzazione di varie funzioni cognitive.

Qualsiasi studio relativo a pazienti con lesioni cerebrali connesse alla sfera del comportamento sociale non può non fare riferimento al lavoro di Antonio Damasio. La sua prima opera divulgativa, “L’errore di Cartesio” (1994), è un’esposizione delle ricerche sull’emozione a livello cerebrale e le loro implicazioni in ambito decisionale, soprattutto nella sfera del comportamento sociale. Tali ricerche hanno preso avvio dall’osservazione di soggetti con lesioni alla corteccia prefrontale ventromediale, i quali mostrano un comportamento atipico soprattutto in relazione al giudizio etico e alla condotta sociale. Come sostenuto da Damasio, sembra che questi individui abbiano una “razionalità menomata”, nonostante gli elementi associati convenzionalmente a un buon funzionamento della ragione non siano in alcun modo danneggiati. Tra questi ultimi in genere figurano: la memoria, l’attenzione, il linguaggio, la capacità di calcolo e la capacità di ragionamento logico per problemi astratti (Damasio, 1994, pp.18-19). Il primo caso storicamente registrato di questo tipo di lesioni è quello di Phineas Gage, caposquadra di un gruppo di costruzioni ferroviarie, vissuto in America durante il XIX secolo, e il cui teschio è oggi conservato a Boston, al Warren Medical Musem della Harvard Medical School.

TROLLEY DILEMMA

Il Trolley Dilemma o Dilemma del carrello, proposto originariamente da Philippa Foot nel 1967, descrive un treno che corre senza controllo su un binario dove più avanti sono legate cinque persone, mentre su un binario alternativo c’è una sola persona legata; il quesito è se sia legittimo tirare una leva in modo da deviare il treno sul secondo binario e uccidere una sola persona anziché cinque. Generalmente, le persone tendono a considerare moralmente accettabile tirare la leva in virtù di un’analisi costi-benefici.

I protagonisti della controversia sono tre neuroscienziati: da una parte lo psicologo statunitense J. Greene; dall’altrail filosofo statunitense Shaun Nichols e il filosofo tedesco Hanno Sauer. Essi si concentrano soprattutto sul terzo tipo di studi.

FOOTBRIDGE DILEMMA

Il Footbridge Dilemma è stato formulato da Judith Jarvis Thomson nel 1976 e descrive una situazione analoga alla precedente ma, anziché avere la possibilità di tirare la leva, si chiede se sia legittimo buttare giù da un ponte che passa sopra il binario un uomo molto grasso, il quale fermerebbe il treno perdendo al tempo stesso la vita. In questo caso le persone non considerano moralmente accettabile compiere l’atto, nonostante secondo un’analisi costi-benefici il risultato sarebbe lo stesso del problema precedente. Quindi, i soggetti a cui viene sottoposto i test tendono a ritenere accettabile deviare il treno nel primo caso, ma non ritengono lecito spingere l’uomo dal ponte (Songhorian, 2020, p.77). Perché le persone rispondono in modo diverso ai due scenari?

CRYING BABY DILEMMA

La formulazione del Crying Baby dilemma è la seguente: “In tempi di guerra tu e alcuni concittadini vi state nascondendo da dei soldati nemici in un seminterrato. Tuo figlio comincia a piangere e tu gli copri la bocca per far sì che non se ne senta il suono. Se togli la mano il bambino piangerà, i soldati lo sentiranno, troveranno te e i tuoi compagni e uccideranno tutti quanti, compreso te e il tuo bambino. Se non togli la mano, tuo figlio morirà soffocato. È legittimo soffocare tuo figlio per salvare te stesso e gli altri?”

GREENE e il modello della “macchina fotografica” o del doppio processo

Joshua Green ha dedicato gran parte del suo lavoro all’approfondimento del perché i dilemmi del carrello, Footbridge e Crying Baby, apparentemente simili nel risultato, suscitano risposte diverse e reazioni discordanti nei soggetti a cui vengono sottoposti.

Uno dei punti chiave dell’analisi è il fatto che i dilemmi presentano forme diverse di problematiche morali, che interessano in modo differenziato l’area delle “violazioni personali” - violazioni che comportano un grave danno fisico, ad una persona specifica, in modo che il danno non sia il risultato di un effetto collaterale di un’azione rivolta altrove (come dire: “io danneggio te”), e quella dei temi morali impersonali - quelli dell’utilità generale, per esempio, meno coinvolgenti nell’immediato.

Greene ha provato ad osservare, attraverso le tecniche di neuroimaging funzionale, l’attività cerebrale degli individui mentre cercano di rispondere a questi dilemmi.

I risultati del neuroimaging, con tempi diversi – più rapidi per i problemi che implicano le violazioni personali” e più lenti negli altri casi - e aree cerebrali coinvolte diverse, hanno suggerito a Greene che nel giudizio morale vi sia una dissociazione tra i contributi affettivi e quelli cognitivi, e che le persone tendano a esprimere i loro giudizi morali sulla base di due sistemi cerebrali distinti, uno più emotivo e un altro più razionale. Questa distinzione è stata corroborata – secondo Greene – anche dal fatto che sembra esserci una correlazione tra i sistemi cerebrali e il tipo di giudizi che questi producono: le aree del cervello associate all’emozione tendono a suscitare giudizi impulsivi che prendono la forma di giudizi deontologici, quindi giustificati in termini di diritti e doveri; le aree del cervello associate al ragionamento producono, invece, giudizi fondati su un’analisi costi-benefici.

Green propone, quindi, il modello della “macchina fotografica”; in analogia con le due modalità di funzionamento della fotocamera (una modalità automatica e una manuale, ciascuna con caratteristiche più adatte ed efficienti in situazioni diverse); così l’essere umano giudica moralmente servendosi di due processi differenti, di due sistemi cerebrali distinti che non possono funzionare congiuntamente, ciascuno dei quali funziona meglio in determinate circostanze.

Secondo Greene, l’analogia con la macchina fotografica è in grado di esprimere anche il compromesso tra efficienza e flessibilità di questi sistemi cognitivi: le risposte emotive, infatti, sono efficienti proprio in quanto istintive, mentre le risposte razionali sono flessibili perché si servono del ragionamento per perseguire obiettivi a lungo termine, prevedendo e programmando i comportamenti necessari. L’autore ritiene che a supporto dell’idea che le aree emotive siano automatiche c’è il fatto che sono le stesse aree che presentano attività quando il cervello è a riposo o, come anticipato, quando è coinvolto in attività non tipicamente di “attenzione”. Per queste ragioni, solo le azioni che derivano da giudizi razionali sarebbero da ritenersi pienamente consce, volontarie e frutto di uno sforzo.

Le teorie alternative e concorrenti: Nichols e Sauer

Shaun Nichols propone una teoria che integra il ruolo dei due sistemi, basata su due tipi di studi empirici fondamentali (Songhorian, 2020, pp.88-95): il primo, che ha per oggetto la distinzione tra norme morali e norme convenzionali, definisce come non necessario presupporre una teoria della mente per tale distinzione poiché i bambini autistici, i quali non hanno buone capacità di comprensione degli stati mentali altrui, rispondono allo stesso modo dei bambini a sviluppo tipico nei test di riconoscimento dei due tipi di violazione; il secondo è quello relativo ai deficit di empatia degli psicopatici.

Nichols – a differenza di Greene - ritiene che vi siano due componenti integrate che costituiscono i giudizi morali: un meccanismo affettivo (che si attiva quando vediamo o sappiamo che gli altri soffrono) e una teoria normativa che impedisce di danneggiare gli altri.

Inoltre, egli definisce come teoria normativa qualunque insieme di regole interiorizzate che proibiscono certi comportamenti e afferma che sia possibile riscontrare la presenza di questi elementi in tutti quei giudizi che sono condivisi in maniera universale e transculturale.

In tal modo rende conto del perché gli psicopatici e i bambini prima dei due anni non siano in grado di formarsi giudizi morali; infatti, i bambini non dispongono di una teoria normativa e gli psicopatici non hanno un meccanismo emotivo concomitante tale teoria.

Sauer sviluppa la sua idea a partire dai risultati degli esperimenti di Greene sul dilemma dell’incesto consensuale; secondo Sauer, il fatto che dopo un tempo adeguato le persone ritengano accettabile l’incesto tra fratello e sorella è indicativo del fatto che le nostre intuizioni morali sono soggette al ragionamento razionale.

Quello di Sauer è un modello di “sfida e risposta”, per cui le intuizioni morali “sono soggette a continui miglioramenti, sovra-apprendimento e abituazione” (Sauer, 2017, p. 122, citato in Songhorian, 2020, p. 103).

A giudizio di Sauer, i nostri giudizi morali nascono da delle intuizioni emotive che possono essere integrate e corrette dalla riflessione e dal ragionamento, i quali vengono sollecitati proprio in risposta a una sfida; tuttavia, non sono solo frutto di un processo evolutivo soggettivo, ma anche socio-culturale. In questo modo riesce a integrare il ruolo di emozione e ragione nella cognizione morale e rende anche conto del processo evolutivo dei giudizi morali.

Differenze tra le tre teorie

Le teorie di Nichols e Sauer propongono entrambe una concezione non oppositiva di emozione e ragione, anche in linea con le tesi di Damasio, ma differiscono nei loro obiettivi polemici: il primo vuole mostrare che anche le regole morali devono essere sentimentali; il secondo compie il percorso inverso, cercando di mostrare che anche l’emozione ha bisogno del supporto del ragionamento (Songhorian, 2020, pp. 102-106).

Ciò che distingue queste teorie da quella di Greene è il fatto che gli autori in questione considerano i giudizi morali dei “processi”, in una prospettiva diacronica; mentre Greene li ritiene degli stati mentali puntuali, e non tiene, quindi, conto del loro carattere evolutivo, del perché i valori morali si modifichino nel corso della storia e del perché anche i singoli individui possano mutare prospettiva nei loro giudizi morali.

Conclusione

Le neuroscienze cognitive ci offrono oggi molte possibilità di approfondimento di svariate questioni filosofiche estremamente affascinanti e antiche, ma è evidente che siamo ancora agli inizi di questo nuovo approccio e le teorie che ne emergono devono ancora molto alla dimensione di costruzione sociale e – in alcuni casi – metafisica.

Dal confronto di queste tre prospettive sui giudizi morali sembra emergere anche l’enorme discordanza e opacità che vi è oggi in molte definizioni metaetiche; non certo fonte di scoraggiamento ma, anzi, indice del fatto che c’è un ampio spazio per nuove riflessioni filosofiche e sociologiche.

No news, bad news – Covid, due anni dopo: delle non-notizie che devono far riflettere

Alcuni giorni fa, uno dei più autorevoli quotidiani italiani ha pubblicato l’articolo “Il Covid, il laboratorio di Wuhan e le accuse rilanciate dal Nyt sulle responsabilità Usa: «Potrebbe essere stato l’incidente più dannoso nella storia della scienza»” sull’ipotesi che la diffusione del virus Sars-CoV-2 abbia avuto origine da un laboratorio di ricerca sui virus del ceppo Sars, a Wuhan, in Cina.

L’articolo del quotidiano italiano riprende un analogo testo del New York Times, intitolato “Why the pandemic probably started in a Lab – in 5 points” che “rilancia con forza l’ipotesi che il virus Sars-Cov-2 sia stato creato in laboratorio” e, inoltre, “lancia un atto di accusa ancora più pesante: che quel laboratorio abbia creato il virus nell’ambito di un progetto di ricerca a cui hanno collaborato organizzazioni americane finanziate dal governo degli Stati Uniti.”

A sostegno di questa ipotesi, il NYT (e il quotidiano italiano che dà spazio alla notizia) si appoggia all’opinione di Alina Chan, biologa molecolare canadese presso il MIT, autrice del libro Viral: The Search for the Origin of Covid-19 (Chan A. e Ridley M., New York: Harpers Collins, 2021), libro in cui utilizza queste presunte prove a suffragio della sua ipotesi:

- La pandemia è iniziata a Wuhan, dove si trovava il più importante laboratorio di ricerca sui virus simili alla Sars;

- Nel 2018 il laboratorio di Wuhan, in collaborazione con EcoHealth Alliance (un’organizzazione scientifica americana che è stata finanziata con 80 milioni di dollari dal governo degli Stati Uniti) e l’epidemiologo dell’Università del North Carolina Ralph Baric, aveva elaborato un progetto di ricerca, chiamato Defuse, in cui progettava di creare virus simili al Sars-Cov-2;

- I livelli di sicurezza del laboratorio di Wuhan (cioè le misure per evitare il rilascio accidentale di virus) erano molto più bassi di quelli richiesti dagli standard di sicurezza delle strutture di ricerca americane;

- Non ci sono prove sostanziali per dire che lo spill-over, cioè il contagio da un’altra specie animale all’uomo, sia avvenuto in un mercato di Wuhan, come sostenuto dai cinesi.

Chan sottolinea, scrive il quotidiano italiano, che è perlomeno peculiare che «un virus simile alla Sars mai visto prima, con un sito di scissione della furina di recente introduzione, corrispondente alla descrizione contenuta nella proposta Defuse dell’istituto di Wuhan, ha causato un’epidemia a Wuhan meno di due anni dopo la stesura della proposta».

L’articolo continua affermando che “Tutto questo fa pensare che l’ipotesi di un virus costruito in laboratorio sia la più probabile.”

Ora, se proviamo ad analizzare il contenuto della narrazione, emerge che:

- il libro di Chan è del 2021;

- gli elementi a favore dell'ipotesi fuga dal laboratorio sono tratte dal libro di Chan, quindi sono datati 2021;

- l'articolo dice che non ci sono prove sostanziali per dire che lo spill-over sia avvenuto da animale non umano ad animale umano al mercato di Wuhan;

- tuttavia, non sembra fornire prove sostanziali del contrario, cioè del fatto che il virus sia stato creato nel laboratorio di Wuhan né, tantomeno, che da quel laboratorio sia sfuggito.

David Hume non avrebbe dubbi: il nesso causale che l’articolo suggerisce tra ricerca a Wuhan e diffusione del virus è illusorio; al massimo si tratta – in assenza di altre prove sostanziali – di un caso di contiguità temporale e di posizione.

Quindi, non sembrano esserci notizie nuove sull’origine della diffusione del virus, ma solo congetture, coincidenze, contiguità non causali, dette 3 anni fa.

Perché, quindi, il New York Times e il quotidiano italiano dedicano la loro attenzione a delle non – notizie?

Perché nei giorni precedenti, Anthony Fauci, immunologo a capo del National Institute of Allergy and Infectious Diseases fino al 2022, e guida della strategia degli Stati Uniti sul Covid, è stato sentito alla Camera statunitense sulle (presunte) responsabilità del governo USA nella pandemia e sul suo (presunto) ruolo nell’averle nascoste; durante l’audizione, Fauci ha dichiarato: «È falsa l’accusa che io abbia cercato di coprire l’ipotesi che il virus potesse essere nato da una mutazione creata in laboratorio. È vero il contrario: in una email inviata il 12 febbraio 2020 chiesi di fare chiarezza e di riportare alle autorità preposte».

Le vere notizie, quindi, sembrano essere queste:

- che prendendo spunto dalla deposizione di Fauci, che ha dato spunto a un articolo del NYT, che a sua volta non dà altre notizie, il quotidiano italiano tratta come notizia il fatto che non ci sono notizie e prova, in questo modo sottile, a sostenere l'ipotesi di Chan, trattandola in modo che sembri altamente probabile;

- che il rilancio dell’ipotesi di Chan, più che sulla solidità fattuale e causale, e a dispetto della dimensione fortemente congetturale, è fondato sull’autorevolezza della ricercatrice, “che lavora al Massachusetts Institute of Technology (Mit) e ad Harvard”[1]

- che il NYT e il quotidiano italiano usano una notizia politica (l’audizione di Fauci) per parlare d’altro, altro in cui non ci sono affatto notizie, ma solo riesumazione di congetture, per di più datate.

C’è, però, un’ultima notizia, più importante, da leggere fra le righe: che non si parla seriamente di un’ipotesi - quella della produzione in laboratorio del virus e della possibile “fuga” – che, invece, meriterebbe indagini e approfondimenti seri, circostanziati e trasparenti; non tanto per attribuire responsabilità, ma per capire:

- se e dove vengono fatte ricerche su agenti virali ad alto rischio;

- come vengono fatte;

- e soprattutto perché vengono fatte e quali sono le fonti dei finanziamenti che le rendono possibili.

NOTA

Tutti i corsivi virgolettati sono tratti dall’articolo Il Covid, il laboratorio di Wuhan e le accuse rilanciate dal Nyt sulle responsabilità Usa: «Potrebbe essere stato l’incidente più dannoso nella storia della scienza», Corriere della Sera, 4 giugno 2024.

[1] Sul tema del ruolo dell’autorevolezza degli scienziati si può vedere: Gobo G. e Marcheselli V, Sociologia della scienza e della tecnologia, Carocci Editore, 2021, Cap. 7; Collins H.M. e Evans R., The third wave of science studies: studies of expertise and experience, in “Social studies of science”, 32, 2, pp. 235-96; Collins H.M. e Pinch T., Il Golem, Edizioni Dedalo, 1995, Cap. VI.

Perché l’astensionismo… “fa bene” ai partiti, specie a quelli più grandi

Nei giorni scorsi si sono sentiti accorati appelli bipartisan ad andare a votare.

E diversi quotidiani hanno presentato con preoccupazione il fenomeno (crescente) dell’astensionismo, il quale (secondo loro) “agitava i partiti”, “incombeva sul voto”, sul quale “pendeva la mannaia dell’astensione”.

Insomma, sembravano tutti allarmati per l’astensionismo.

In realtà l’astensionismo giova ai partiti, soprattutto a quelli più grandi. Infatti, meno persone vanno a votare e più essi si rafforzano.

Sembra un’affermazione assurda, un’enormità; invece (dati alla mano) è perfettamente plausibile.

Già il sociologo Niklas Luhmann, più di quarant’anni fa (Soziale Systeme, Frankfurt am Main, Suhrkamp, 1984. Trad. it. Sistemi sociali. Fondamenti di una teoria generale, Bologna, Il Mulino, 1990), sosteneva che il consenso era strutturalmente una risorsa scarsa nelle democrazie occidentali. Per cui non valeva la pena di dannarsi tanto nell’ottenerlo, perché scarso comunque sarebbe restato. In altre parole, si può benissimo governare… con poco consenso.

Passiamo ora ai dati.

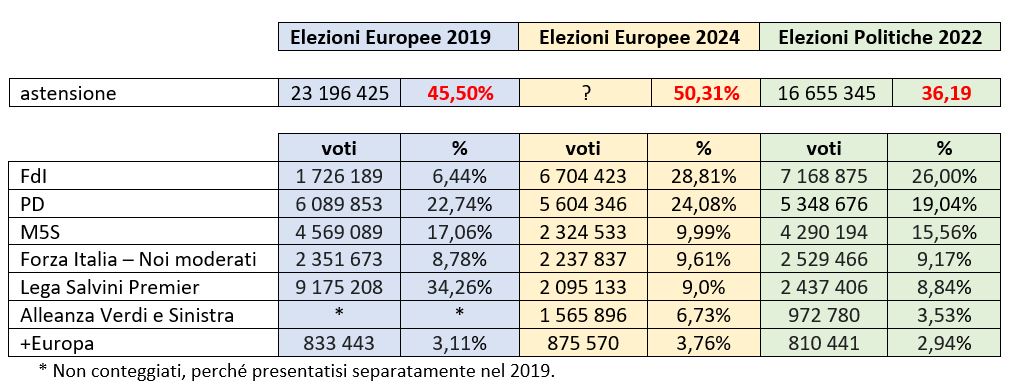

Diverse leader di partito, nelle scorse ore, hanno esultato per essere aumentate di qualche punto percentuale. Ad esempio il PD nelle elezioni europee precedenti (2019) aveva ottenuto il 22,74%; ora, invece, il 24,08%: un punto in mezzo in più. Che diventano ben 5 rispetto alle ultime elezioni politiche (19,04%).

Ma se andiamo a vedere i valori assoluti (avvertenza che si impara alla prima lezione di un qualsiasi corso di statistica), scopriamo che i voti per i partiti più grandi sono calati, e anche di molto. In altre parole, i voti calano ma le percentuali aumentano. E i politici (e i giornalisti) guardano solo le seconde, dimenticando (furbizia? malafede? ignoranza?) i primi.

Non ci credete? Date un’occhiata alla tabella:

(Fonti dati: Elezioni Europee 2019, Elezioni Europee 2024, Elezioni Politiche 2022)

Così può capitare che FdI perda quasi mezzo milione di voti rispetto alle Politiche di due anni fa, ma salga miracolosamente del quasi 3%. Che il PD prenda soltanto 250mila voti in più rispetto alle Politiche ma faccia un balzo del 5%; e che ne perda quasi mezzo milione rispetto alle scorse europee ma salga di 1 punto e mezzo. Che la Lega e Forza Italia perdano rispettivamente 340mila e 291mila voti rispetto alle Politiche, ma salgano di qualche decimo.

Invece questo non succede con i partiti minori (vedasi +Europa), che quando perdono voti, perdono anche decimi percentuali.

Facciamo un ragionamento per assurdo: se alle prossime elezioni vanno a votare solo 10 persone su 1000 aventi diritto, e queste danno 3 voti a FdI, 3 al PD, 2 al M5S, 1 alla Lega e 1 Forza Italia, questi partiti prenderanno rispettivamente il 30%, 30%, 20%, 10% e 10%, pur avendo perso tutto l’elettorato e con un’astensione pari al 99%.

Perché, diversamente dai sondaggi, dove i ‘non so’ si espungono (giustamente) dalle percentuali finali — non si può attribuire un’opinione a chi dice di non averla — nelle elezioni questo non avviene: il voto viene attribuito anche a chi non vota [1].

E questo viene fatto presupponendo una distribuzione (partiticamente) omogenea delle astenute. Ma così assolutamente non è: coloro che non vanno a votare sono tendenzialmente le persone più critiche nei confronti del sistema politico (e non solo le “indifferenti” o qualunquiste, che potrebbero essere equamente distribuite).

Quindi non è vero che 1 vale 1. Al contrario: l’1 del votante (con alti tassi di astensionismo) vale molto di più. Con il 50% di astensionismo, vale 2. E con un ipotetico 99% di astensionismo vale quasi 100!

In questo modo le elezioni sono (matematicamente) delle ponderazioni, degli artifizi, delle manipolazioni aritmetiche.

Per cui 10 votanti (l’1%) contano come il 100% e si distribuiscono i 76 seggi europarlamentari. In questo caso (assurdo), gli eletti sarebbero più dei votanti… cioè qualche eletto non sarebbe andato a votare…

Allora è chiaro perché i partiti più grandi (quelli sopra il 10%) non hanno interesse a combattere seriamente l’astensionismo. Perché se anche porta a loro meno voti, alza però le loro percentuali. E sono queste (malauguratamente) quelle che contano.

Per cui colei/colui che non va a votare, fa (indirettamente) il gioco dei partiti più grandi.

Perché il suo non-voto se lo prendono lo stesso…

NOTE

[1] Nei sondaggi l’astensionista corrisponde alla nonrespondent, persona che non ha voluto partecipare al sondaggio. In questi casi la sondaggista interviene in due modi: 1) con una “riserva”, cioè sostituendo la nonrispondente con un'altra (socio-demograficamente) simile a lei; oppure, 2) con una “ponderazione”, cioè attribuendo (mediante un coefficiente) fittiziamente l’opinione media di quelle che hanno risposto (nel senso di aver partecipato al sondaggio) a coloro che non l’hanno fatto. Ma entrambe queste operazioni hanno dei limiti e, soprattutto, la ponderazione è sconsigliata quando il fenomeno nonresponse supera il 50% (come nel caso di queste ultime elezioni europee). Per un approfondimento: Gobo, G. (2015), La nuova survey. Sondaggio discorsivo e approccio interazionale, Roma, Carocci, pp. 201-202.

Seveso, 1976 - Il Comitato tecnico scientifico popolare: nascita e programma di lotta

La conservazione delle tracce del “disastro” dell’Icmesa e di quello che ne seguì è stata una pratica che accomuna le persone di Seveso e dei comuni limitrofi: le memorie sevesine sono sepolte nel sottobosco del Bosco delle Querce e nelle cantine delle case private. È come se a Seveso esistesse un mondo di sotto che si è stratificato con il passaggio della nuvola-nube nel mondo di sopra e che, se sollecitato, riaffiora.

-----

Ricercando questo mondo sotterraneo, una delle storie che riemerge è quella del Comitato tecnico scientifico popolare. In una video-intervista conservata da “Archivio Seveso. Memoria di parte”, uno degli studenti di medicina protagonisti del CTSP ne ricorda la genesi e la composizione eterogenea, che coinvolgeva studenti, operai, medici, sindacalisti. L’intervistato, quando si è sprigionata la nube tossica a Seveso, era un giovane laureando in medicina e ricorda che nei momenti immediatamente successivi al “disastro” nella sua facoltà si era formato un gruppo di persone che volevano approfondire questa situazione, a partire «dalla situazione reale, dalla situazione della gente»[1].

È nato così il CTSP, a partire da alcuni operai del Consiglio di Fabbrica, da studenti che stavano finendo la facoltà di medicina, da professori universitari, come Giulio Alfredo Maccacaro, e da sindacalisti.

Tra i materiali conservati nell’“Archivio Seveso. Memoria di parte” sono presenti i documenti, i ciclostilati, le lettere e i volantini del CTSP.

Il Comitato esplicitò i propri obiettivi nel bollettino pubblicato nel settembre del 1976, ponendosi in contrapposizione con l’operato delle istituzioni locali, regionali e nazionali che – secondo il CTSP – avevano coperto e soffocato ogni tipo di protesta e di organizzazione degli abitanti della zona, non fornendo sufficienti informazioni sulla situazione per fare maturare una consapevolezza collettiva del rischio.

Rifiutando il principio di delega, il CTSP intendeva allargare il proprio intervento attraverso il coinvolgimento degli organismi di base della zona, degli organismi medici e socio-sanitari.

Le proposte del Comitato insistevano:

- sull’educazione e sull’informazione sanitaria,

- sulla necessità di accertamenti sanitari e scientifici controllati dal basso,

- sull’importanza di un’opera di controinformazione atta a impedire qualsiasi tentativo di insabbiamento di responsabilità dell’industria, delle strutture scientifiche istituzionali e delle forze politiche.

Un altro aspetto importante per il Comitato era la generazione di una forma di lotta popolare mirata alla bonifica delle zone contaminate, alla salvaguardia del posto di lavoro, all’abbattimento della nocività nelle fabbriche e nel territorio e alla costruzione di nuovi servizi sanitari di base[2]. Per realizzare questi propositi, gli attivisti del CTSP proponevano un «programma di lotta» che intrecciava le questioni particolari e urgenti di Seveso con la dimensione di una lotta generale e strutturale.

Per questo oggi non possiamo limitarci a chiedere che vengano attuate solo le misure più urgenti in favore delle popolazioni colpite. Non basta rimediare ai disastri più gravi causati dalla nube: se non vogliamo un’altra Icmesa, dobbiamo batterci subito per cambiare le condizioni di lavoro in fabbrica e abbattere la nocività, per ottenere un’assistenza sanitaria realmente orientata alla prevenzione, per conquistare nuovi servizi sociali, a partire dalla casa (Asmp, b. CTSP, Bollettino del Comitato tecnico scientifico popolare, settembre 1976).

----

Il passaggio dalla dimensione particolare a quella generale si inseriva nell'eccezionalità del “disastro” sevesino perché per la prima volta in Italia la nocività non rimaneva un problema solo interno alla fabbrica, ma usciva ed «esplodeva letteralmente sul territorio» (Intervista ad abitante di Seveso, gennaio 2024).

Secondo il CTSP, per rispondere alle domande che la vicenda dell’Icmesa aveva sollevato in merito alla relazione tra lavoro, salute e ambiente, era necessario organizzare una mobilitazione operaia, territoriale e di massa.

Si trattava di una proposta che si opponeva alla marginalizzazione di chi era stato colpito dalla “nuvola-nube” e cercava di combinare il rifiuto della semplice fruizione di ordinamenti esistenti con la richiesta di partecipazione attiva (Koensler, Rossi 2012, p. 7).

La pratica militante del CTSP tentò – quindi - di portare fuori dalla fabbrica gli strumenti di indagine e di inchiesta di cui il movimento operaio si era dotato per portare la soggettività operaia al centro delle lotte dei lavoratori (Carnevale, Baldasseroni 1999, pp. 230-283).

Così le pratiche utilizzate per capire le conseguenze sanitarie e ambientali della diffusione della diossina affondavano le loro radici in una concezione della medicina non “oggettiva”, ma che si poneva l’obiettivo di coinvolgere direttamente gli abitanti delle zone colpite. La soggettività delle persone coinvolte era il punto di partenza per le ricerche scientifiche del CTSP.

L’idea di salute e di cura proposte si basavano sull’inclusione delle persone che nei territori contaminati vi abitano all’interno del discorso, perché il loro sapere e i sintomi accusati, in un tempo preciso e in un luogo determinato, sono fonti di conoscenza fondamentali per la pratica medica.

Il Comitato, a partire dalle esperienze dei gruppi omogenei di fabbrica, e dalle loro elaborazioni di salute e malattia, concepiva la salute nel quadro di una liberazione di sé,

«dove i soggetti devono avere voce e non subire le decisioni degli ospedali che non sono mai neutre»

(Intervista ad abitante di Seveso, gennaio 2024).

Ammalarsi è una realtà sociale che mette in gioco rapporti di potere ed è espressione di molteplici modi di incorporare l’ordine socio-economico e le sue disuguaglianze che pongono gli individui e le comunità di fronte a rischi differenti.

Soprattutto chi viveva a Seveso ed era da pochi anni immigrato nella Brianza produttiva in cerca di lavoro, ha incorporato la produzione nociva e pericolosa dell’Icmesa (incorporation de l’inégalité), ha sperimentato il potere locale, regionale e nazionale incapace di guarire (pouvoir de guérir) e il governo della vita attraverso controlli biologici, evacuazioni, limitazioni e ordinanze (gouvernament de la vie).

Secondo gli studi del medico-antropologo Didier Fassin (Fassin 1996), le tre dimensioni appena menzionate costruiscono lo spazio politico della salute (Fassin 1996) ed è in esso che il CTSP ha giocato un ruolo fondamentale – anche se oggi è quasi dimenticato – a Seveso per praticare e diffondere una concezione di salute e di medicina al servizio della popolazione e a partire dalla soggettività di quest’ultima, proponendo lo sviluppo di un’«eziologia politica» (Nguyen, Peschard 2003) delle patologie insorte in seguito al “disastro”.

NOTE

[1] Asmp, b. CTSP, Interviste-documentario “Seveso Memoria di parte”.

[2] Asmp, b. CTSP, Bollettino del Comitato tecnico scientifico popolare, settembre 1976.

La fisiologia dualista di Cartesio si regge sull’uso improprio degli animali?

Quando si parla di Cartesio (1596 - 1650) non va dimenticato che è uno scienziato (si direbbe oggi), un filosofo naturale (si diceva ai suoi tempi) che lavora per anni in modo moderno basandosi sul dubbio, rifuggendo il dogmatismo, osservando e costruendo le teorie sull’osservazione e sulla confutazione, discutendo con i suoi pari e antagonisti sulla fisiologia dei viventi, e che da questa fisiologia prende forma la sua teoria dualista del corpo e della mente.

Fisiologia dei viventi, sì; ma con al centro di tutto l’uomo[1]. Infatti, nella prima parte della sua opera, Descartes non considera gli animali se non di sfuggita e in modo conformista: l’animale è quello della tradizione aristotelico-scolastica, con qualche facoltà psichica ma senza intelligenza.

“quanto alla ragione o buon senso, essendo questa la sola cosa che ci fa uomini e ci distingue dalle bestie” (Descartes, R, Discorso sul metodo e meditazioni filosofiche, Universale Laterza, 1978, p. 4)

Probabilmente a Descartes importava poco, degli animali, e non poteva essere collocato in modo netto su nessun versante della controversia naturalista e filosofica, tra teriofili e non-teriofili che si sviluppò in Francia nella modernità [2] – cioè tra filosofi naturali e pensatori che sostengono che tra umano e animale non ci sia una grande distanza, in termini di fisiologia di capacità morali, di sensibilità e di intelligenza e, al contrario che ritengono gli animali inferiori all’umano secondo tutti questi aspetti.

La fisiologia dell’umano è, invece, al centro de L’Homme, che Descartes inizia nel 1630 e continua a scrivere per un decennio ma che non pubblica in vita [3].

Ne L’Homme, Cartesio sviluppa una fisiologia ponderosa, ampia, dettagliata, in parte sostenuta da osservazioni naturaliste, in parte congetturale o basata su teorie della tradizione, in cui il corpo, la res estensa, ha un ruolo molto ampio, acquista mano a mano sempre più potere, invade le aree della sensibilità, dell’adattamento, del pensiero e del giudizio.

Per Descartes, però, si delinea un rischio: perseguire la strada intrapresa con L’Homme, in cui le facoltà dell’adattamento all’ambiente, il pensiero e il giudizio sono funzioni del corpo, significa puntare verso il materialismo e il determinismo.

E, come se non bastasse, questo mette a repentaglio anche una serie di punti importanti del suo stesso pensiero e vitali per il contesto in cui vive e lavora il fisiologo Cartesio: la preminenza della ragione, la mente, la libertà di scelta e, addirittura, l’esistenza e immortalità dell’anima.

Come può fare, Descartes a salvare capra e cavoli, a mantenere, cioè, la fisiologia potente del corpo e, nello stesso tempo non mettere in crisi il potere della ragione, la scelta, l’anima immortale, e – in definitiva – il giudizio come parte della componente spirituale dell’umano, della sua mente?

Un modo valido per coniugare queste due esigenze sembra essere la separazione di corpo e mente, il dualismo. Cioè, la divisione della fisiologia del vivente, con il corpo sede di funzioni della sensibilità, meccaniche, operative, di senso, e la mente che raccoglie, decodifica, decide e imposta valutazione, pensiero e azione.

Tuttavia, per non sminuire il lavoro fatto ne L’Homme, il “corpo-da-solo” deve poter essere autonomo, deve poter vivere senza pensiero, senza emozioni, senza anima, senza valutazione e giudizio.

Facile a dirsi ma difficile, però, a dimostrarsi; non sembrano esserci umani viventi che possono impersonare la mente senza corpo (certo, c’è l’anima immortale una volta separata dal corpo; ma questa è materia religiosa) né, tantomeno, un corpo ben funzionante senza la mente[4]

In soccorso di Descartes arrivano gli animali! Corpi e solo corpi, ottimamente funzionanti – in molti casi meglio degli umani: reattivi, efficaci e, nello stesso tempo, non senzienti, non pensanti, senza giudizio, senza scelta. Quindi, autonomi e automatici!

“molti animali, pur dimostrando maggiore abilità di noi in alcune loro azioni, non ne dimostrano affatto in molte altre: di modo che, quel ch'essi fanno meglio di noi, non prova affatto che abbiano ingegno, perché, se così fosse, ne avrebbero più di noi e anche nel resto farebbero meglio; ma prova piuttosto che non ne hanno punto, e ch'è la natura quella che opera in essi secondo la disposizione dei loro organi: a quel modo che un orologio, composto solo di ruote e di molle, conta le ore e misura il tempo più esattamente di noi con tutta la nostra intelligenza”. (Descartes, R, Discorso sul metodo e meditazioni filosofiche, Universale Laterza, 1978, p. 42)

Questa degli animali automatici è una soluzione, tutto sommato, molto a buon mercato; perché gli animali non possono lamentarsi e perché c’è già una ampia letteratura anti-teriofila, tra scienze naturali e fisiologia, che non attribuisce funzioni “superiori” ai non umani.

E non è una soluzione qualunque perché, se da un punto di vista epistemologico, Descartes mette al sicuro la veracità della conoscenza con il lumen naturale, con il cogito e – alla fine – con la garanzia della rappresentazione garantita da Dio, dal punto di vista ontologico, l’animale-macchina “salva” l’autonomia delle due res, cogitans e estensa, l’anima immortale, tutta la fisiologia.

E, da allora, gli animali non umani sono sempre più macchine, bruti, senza sentimenti, senza patimenti, oggetti. Fruibili a fini filosofici e “buoni da usare” (non solo da mangiare).

NOTE

[1] Inteso come essere umano. Cartesio non avrebbe, però, mai detto ‘essere umano’, e certamente non pensava alla parità di genere.

[2] A partire da Montaigne fino a Rousseau; per approfondimenti, cfr. Boas, The Happy Beast in French Thought of the Seventeenth Century, John Hopkins Press, 1933 e Singer P., La nuova rivoluzione animale, Il saggiatore, 2024, pagg. 61 e segg.

[3] Cfr.: Corpus Descartes, Édition en ligne des œuvres et de la correspondance de Descartes, https://www.unicaen.fr/puc/sources/prodescartes/accueil.html

[4] I tentativi di considerare corpo senza mente diverse forme di disabilità mentali non sembrano dare risultati validi: l’osservazione e la fisiologia mettono sempre in luce scampoli di mente sensibile

Nello specchio dell’Intelligenza Artificiale - The Eye of the Master

Specchi

Con consueta indiscrezione Oscar Wilde rivela che Dorian Gray si è immunizzato dai sintomi dell’invecchiamento e del degrado morale della sua condotta, proiettandone i sintomi su un ritratto che custodisce in soffitta. Solo puntando lo sguardo sul dipinto è possibile scorgere la verità che l’aspetto del personaggio sta mascherando. Cosa vediamo quando fissiamo gli occhi sull’intelligenza artificiale, che in qualche modo abbiamo costruito come un ritratto tecnologico della nostra umanità? Le scienze cognitive e gran parte delle pubblicazioni divulgative affermano che i dispositivi informatici riflettono la forma della nostra mente, anche se ancora in modo parziale e talvolta alterato. Nei computer riverbera la verità dello spirito, anche se ancora solo per speculum et in aenigmate, un po’ come secondo Agostino di Ippona e Paolo di Tarso la nostra esperienza ci permette di scorgere il volto di Dio in uno specchio, non ancora faccia a faccia – con tutte le contraffazioni che ai tempi dell’impero romano le superfici riflettenti praticavano sulle immagini.

Ma è possibile che nell’intelligenza artificiale si mostri quello che il lavoro collettivo della storia della tecnologia vi ha introdotto in fase di progetto e di sviluppo, più che la struttura o le funzioni della mente nella loro presunta universalità e immutabilità. La tesi che Matteo Pasquinelli dimostra in The Eye of the Master rende omaggio all’evidenza che nei dispositivi informatici troviamo quello che ci abbiamo messo più che quello che siamo, in una prospettiva che ha il pregio di muoversi in direzione opposta all’opinione comune, e con una strategia di argomentazione tutt’altro che triviale. I passaggi focali della sua ricostruzione sono due.

Ragazze che contano

Il primo si colloca all’origine della storia dell’informatica, o comunque in uno dei momenti considerati come essenziali per la nascita della disciplina: qui Pasquinelli sfida il presagio di noia dei lettori esperti, soffermandosi sugli studi condotti nella prima metà dell’Ottocento dal matematico Charles Babbage per la realizzazione della «Macchina Differenziale» (ed esponendo me ora allo stesso rischio). Il dispositivo non è mai stato portato a compimento, e si distingue dai computer progettati e costruiti nel Novecento per il fatto che non prevede una distinzione tra hardware e software: la macchina, anche nella sua veste definitiva, sarebbe stata in grado di processare un solo programma – quello del calcolo delle tavole logaritmiche. Babbage ha anche elaborato i piani per una «Macchina Analitica», che avrebbe potuto eseguire una pluralità di compiti diversi, ricorrendo a schede meccaniche paragonabili a quelle utilizzate nei telai Jacquard per l’esecuzione dei ricami. In questo caso però la pianificazione non ha condotto nemmeno al prototipo con azionamento manuale, che invece è stato messo a punto per la Macchina Differenziale.

Il primo progetto è stato sollecitato da esigenze commerciali e militari, ottenendo anche un finanziamento pubblico di 1.500 sterline: le tavole logaritmiche sono essenziali per il tracciamento delle rotte, e sono state quindi uno strumento fondamentale per la solidità dell’impero coloniale costruito dagli inglesi fino dal Settecento. Il procedimento seguito da Babbage, da cui discende la tecnica moderna della programmazione, si fonda sulla nozione di divisione del lavoro divulgata da Adam Smith cinquant’anni prima e approfondita in due direzioni.

La prima è quella della riduzione delle operazioni di calcolo ai passaggi meccanici di cui sono composte. Turing ripete lo stesso esercizio più di un secolo dopo, quando in piena Seconda Guerra Mondiale elabora il modello matematico per decrittare i messaggi in codice della marina tedesca. Computer ai tempi di Babbage, e ancora ai tempi di Turing, non è il nome di una macchina, ma l’etichetta di una professione esercitata per lo più da ragazze, che eseguono lunghe sequenze di calcoli meccanici in cui sono stati segmentati algoritmi predisposti da ingegneri e da matematici, per la misurazione di rotte, di distribuzioni statistiche, ecc. La riduzione di questa varietà di competenze a singoli passaggi automatici permette di organizzarli in una macchina, che quindi non è un oggetto ma la cristallizzazione di una configurazione di relazioni sociali e della divisione del lavoro che la governa.

La seconda direzione proviene dagli studi di Babbage in ambito di management aziendale, e dalla sua conapevolezza che la divisione del lavoro permette di calcolare il costo di ogni fase della produzione, e di abbatterlo attraverso l’assegnazione dei compiti più semplici a personale non qualificato, o a macchine che lo rimpiazzino. Babbage non coincide con l’immagine di apostolo dalla purezza della curiosità scientifica che l’agiografia dipinge da sempre, né è stato una figura isolata nella sua austerità accademica – né la sua invenzione è neutrale da un punto di vista morale e politico. Il computer cristallizza la piramide di competenze e le prestazioni dei matematici, degli ingegneri, delle signorine calcolatrici, riflettendo le gerarchie sociali e le strutture etiche che ne governano la divisione del lavoro: la macchina non è moralmente meno compromessa del ritratto di Dorian Gray.

Autonomia, parzialità e fallibilismo

L’ordinamento gerarchico piramidale della cultura industriale si rispecchia nella tecnica di programmazione inaugurata da Babbage, che implementa una struttura di comando verticale in cui l’ingegnere del software definisce tutte le fasi di elaborazione, e i processi le eseguono in modo automatico. La società contemporanea non può essere controllata nello stesso modo, a causa della complessità delle interazioni, e del livello di distribuzione e di autonomia degli agenti coinvolti. I freelance che lavorano con il coordinamento delle imprese della gig economy, come gli autisti di Uber o i rider di Glovo, i creatori di contenuti che pubblicano sui social media, i webmaster che producono le pagine digitali indicizzate da Google, gli attori e i prodotti del mercato finanziario globale, sono alcune espressioni della mereologia tra organicità e frammentazione locale del mondo contemporaneo. I soggetti che lo abitano dispongono sempre di una conoscenza parziale dell’ambiente in cui operano, e sviluppano una comprensione della realtà che è stimata per congettura, con rappresentazioni che devono essere aggiornate o rivoluzionate sulla base dell’esperienza.

Pur senza approfondire il modo in cui funzionano le intelligenza artificiali costruite con reti neurali, è possibile osservare che, dai primi esperimenti del Perceptron di Frank Rosenblatt nel 1957 alle attuali AI generative trasformative, i principi essenziali rimangono due: ogni unità di calcolo, ogni «neurone», accede ad una quantità di informazione limitata, che può essere persino sbagliata; il software nella sua totalità dispone di una rappresentazione statistica complessiva del fenomeno processato, in cui si bilanciano gli output di ogni «cellula» di calcolo. La natura probabilistica del risultato deriva dall’autonomia delle singole unità di processamento, e dall’adeguamento per tentativi ed errori con cui la macchina interagisce con l’ambiente: se la risposta esterna è negativa, il sistema rimodella la propria configurazione per migliorare l’output. Il secondo passaggio strategico dell’argomentazione di Pasquinelli consiste nella ricostruzione del debito che lega il progetto di Rosenblatt a The Sensory Order (1952) di Friedrich von Hayek. In questo testo l’autore proietta le tesi economiche e sociali del neoliberalismo – di cui è uno dei padri fondatori, insieme a von Mises e a Schumpeter – sul dominio della psicologia connessionista: il modello di apprendimento fondato sui principi di collegamento in rete dei neuroni corrisponde all’autonomia degli individui economici come agenti dotati di conoscenza limitata del mercato, e del sistema sociale come equilibrio tra le rappresentazioni probabilistiche e congetturali dei soggetti. L’assunto di una conoscenza completa delle necessità e delle transazioni sociali non è reputato solo impossibile, ma condannato come moralmente deprecabile. Il ritratto insegna a Dorian Gray non solo cos’è diventato, ma anche che è giusto che sia così.

Pasquinelli riprende il metodo e l’orientamento della scuola del Max Planck Institute di Berlino, con la capacità di rendere perspicuo il radicamento dei paradigmi tecnologici e di quelli scientifici nelle condizioni politiche e sociali in cui hanno visto la luce. Sarebbe stato interessante un approfondimento del modo in cui l’intelligenza artificiale di ultima generazione sta riplasmando l’ambiente materiale in cui è attiva, e la società che la circonda. Se c’è qualcosa di vero nel fatto che nella tecnologia possiamo osservare anche ciò che siamo, oltre a quello che ci abbiamo messo, è perché noi stessi siamo rimodellati dagli artefatti che produciamo: nella tecnica ritrattiamo in continuazione ciò che l’essenza della nostra umanità è stata per i nostri predecessori: eroismo aristocratico, telescopio eidetico, anima immortale, monade rappresentativa, macchina a stati finiti, rete connettiva. E ora?

Scienze sociali in scena: un rapporto fecondo tra sociologie e teatro

«Il teatro è così infinitamente affascinante perché è così casuale. È come la vita…»

(Arthur Miller)

Teatro, persona, maschere, ruoli e palcoscenico… Sono da sempre interconnessi. Non è un caso se nel linguaggio comune vi siano molti riferimenti al teatro: «il ruolo di genitore», «le persone hanno molte maschere», «è calato il sipario», e così via.

Anche nelle scienze sociali vi sono molti riferimenti a questa realtà: dal concetto stesso di rappresentazioni sociali, all’approccio drammaturgico dello scienziato sociale Erving Goffman (1945, The Presentation of Self in Everyday Life) che analizza le istituzioni sociali, quelle della vita quotidiana e quelle professionali, come vere e proprie rappresentazioni teatrali, in cui gli individui sono considerati come degli attori e che, a seguito di un periodo variabile e differente di preparazione in un contesto sociale definito retroscena, interpretano pubblicamente dei ruoli, in un altro spazio pubblico, ovvero la ribalta. Anche in un’altra disciplina di grande interesse, si ha un forte richiamo al teatro, ossia l’antropologia teatrale che analizza le interazioni degli individui e/o delle collettività all’interno di una forma di drammatizzazione organizzata. Quindi diventano interessanti i rapporti dell’attore teatrale/sociale con i gesti e le parole portati in scena. Uno degli studiosi più importanti di questa sub-disciplina, Eugenio Barba (1993, La canoa di carta) la definisce come «lo studio del comportamento scenico pre-espressivo che sta alla base dei differenti generi, stili, ruoli e delle tradizioni personali o collettive».

A partire da queste premesse (intrecciate sia con il mio bagaglio culturale e di ricerca, che a sua volta interseca antropologia, criminologia e sociologia, che con la mia passione per l’arte, il teatro e il cinema) è nato il progetto di divulgazione scientifica in chiave teatrale, Scienze sociali in scena.

Gli obiettivi del progetto

Il progetto, dunque, ha diversi obiettivi: innanzitutto quello di trasmettere gli elementi caratterizzanti le scienze sociali di cui mi occupo attraverso il teatro, inteso come uno dei migliori strumenti per acquisire conoscenza; al tempo stesso affrontare i problemi della società contemporanea; ma soprattutto accomunare l’esperienza della ricerca scientifica e il mondo delle arti sceniche attraverso uno scambio reciproco di saperi e di sostegno per la divulgazione scientifica con una impostazione e un linguaggio alla portata di tutti.

Il logo

L’identità di una qualsiasi entità, per affermarsi, necessita innanzitutto di simboli. Proprio per queste ragioni il logo ingloba le tante “dualità” che sottendono questo progetto. Innanzitutto, i colori: il bianco e il nero, come richiamo sia alle zone di luce ed ombra dell’agire umano, ma anche correlati alla contrapposizione tra il retroscena e la ribalta, ma più in generale si riferiscono alle varie forme di ambivalenza che accompagnano l’uomo. I simboli: sulla sinistra sono presenti le classiche maschere che rappresentano il teatro, ma hanno anche un altro significato, ovvero quello proposto da Jung che «prende in prestito il termine dal latino Persōna Persōnam, ovvero la maschera che gli attori solevano indossare durante le rappresentazioni sceniche. La Persona era solo un riflesso dell’immagine del personaggio interpretato dall’attore, ne riprendeva i lineamenti, lo caratterizzava, lo inseriva in un ruolo». A destra, invece, ritroviamo un network, e quindi una simbologia che richiama l’attitudine umana di entrare in relazione con i suoi simili.

La strutturazione di Scienze sociali in scena

Il progetto ha una strutturazione particolare. Innanzitutto, si apre con dei video con sottofondo musicale, da me realizzati, perché ho anche l’hobby, seppur del tutto amatoriale, del video editing. Questa fase ha un duplice compito: sia di creare un’atmosfera densa e volta ad attirare l’attenzione, ma al tempo stesso, essere una vera e propria scenografia visuale. Dopodiché inizia la fase teatrale propriamente detta, in cui vengono interpretati passaggi delle mie ricerche, ma anche eventuali personaggi analizzati. Si tratta di un momento essenziale, perché ha il compito di portare lo spettatore “all’interno” della tematica trattata.

Il passo successivo consiste nella fase intervista al personaggio, il cui scopo consiste nel mostrare come si conduce un’intervista dal punto di vista delle scienze sociali, per far comprendere come sia complicato rimanere, per esempio, avalutativi rispetto a determinate tematiche; ma, al tempo stesso, è utile per dare il via all’ultima fase ossia quella dell’analisi di tutto ciò che è stato portato in scena, con un linguaggio semplice ed accessibile, in modo tale da trasmettere forme di conoscenza utili non solo ai fini dell’evento, ma anche nella vita quotidiana.

Curiosità

Scienze sociali in scena interseca le scienze sociali non solo con la recitazione, ma anche con l’arte. Infatti, un elemento centrale di questo progetto sono sia la realizzazione di fotografie, che la presenza di installazioni artistiche in scena, in linea con la tematica trattata.

Il progetto [1] è totalmente autonomo e autofinanziato, perché i realizzatori credono che soltanto nell’autonomia si possa erogare un prodotto di ricerca libero da qualsiasi forma di influenza politica, economica, o di altra natura.

In questo modo, è possibile che si rafforzi la figura del divulgatore teatrale: ossia uno scienziato sociale in grado di trasmettere il proprio sapere, la propria esperienza sul campo, i propri prodotti scientifici nel contesto teatrale.

Speriamo che questo progetto possa avere una crescente attenzione e impatto in diversi contesti ed ambiti, ricordando sempre che nel grande teatro della vita, cerchiamo sempre le sedie dello stupore, dell'innovazione, della diversità e perché no anche del sano dissidio... Si tratta di sedute quasi sempre libere... Quelle dell'ovvio, invece, sono già tutte occupate.

NOTE

[1] A questa avventura partecipano: Anna Rotundo (per la fotografia, le installazioni artistiche e, in collaborazione con me, l’adattamento delle mie ricerche in chiave teatrale); Maria Novella Madia (attrice); lo staff tecnico (Rita Rotundo e Arturo Obizzo), l’autore di questo post.

Il progetto è stato inaugurato a Catanzaro, con l’adattamento teatrale del Cannibalismo questioni di genere e serialità, e ha ottenuto un numero elevatissimo di presenze!

Per approfondimenti, si può fare riferimento alle pagine Facebook e Instagram.

Sono già in fase di programmazione altri eventi sotto l’effige di Scienze sociali in scena.

Perché il progetto di un’Unione Europea è fallito - Un'analisi socio-linguistica

Tra qualche giorno, metà di noi si appresterà ad andare a votare per il rinnovo del Parlamento Europeo.

Metà perché, nella tornata precedente, non andò a votare il 49% degli aventi diritto, con rilevanti differenze tra i singoli Stati che compongono l’Unione Europea: la palma d’oro (si fa per dire) dell’astensionismo andò alla Slovacchia (75%); l’Italia si collocò poco sotto la media europea (45%); il più “virtuoso” il Belgio (11%). E per questa tornata i sondaggi danno l’astensionismo in aumento.

Le politologhe, nel corso degli anni, hanno indicato diverse cause. Prima fra tutte, la “crisi della rappresentanza”. Per cui l’astensionismo alle elezioni europee è in linea con una tendenza più generale, che tocca anche gli Stati nazionali, le elezioni regionali e locali.

Ma c’è anche un’altra ragione. Più profonda. E l’averla trascurata sin dall’inizio ha decretato il fallimento dell’intero progetto dell’Unione Europea. Tracollo che nessun curatore fallimentare ha ancora certificato, ma che (a me) pare evidente nelle pratiche dei singoli Stati e dei partiti presenti in essi.

Non sono un politologo o un sociologo politico. Per cui le mie riflessioni non nascono da quelle competenze (che non ho) ma da un’analisi socio-linguistica (approccio che insegno nei miei corsi).

Le grandi potenze

L’Unione Europea aspira ad essere una grande potenza, al pari degli USA, Cina, Russia. Altre nuove (potenziali) grandi potenze si stanno affacciando: Brasile, India, e forse Mondo Arabo.

Cos’hanno in comune queste grandi potenze che l’Unione Europea non ha? Una lingua comune.

In questi Paesi, le persone possono (potenzialmente) intendersi perché (quasi) tutte parlano l’inglese, il cinese, il russo, il portoghese, l’hindi e l’arabo moderno standard (che non è mai madrelingua di nessuna arabofona, ma il suo apprendimento avviene seriamente nella scuola). In India, paese con una grandissima diversità culturale, pur avendo ventuno lingue a livello dei singoli stati federati, ha sempre la possibilità di usare l’hindi oppure l’inglese (come lingua ufficiale sussidiaria).

Senza una lingua comune non può esistere a lungo uno Stato o una Confederazione. Si dissolverà a breve.

Ci sono ovviamente delle (piccole) eccezioni: la Svizzera non ha una lingua comune; tuttavia, quando due svizzere si incontrano parlano in francese oppure in tedesco (lingue che hanno imparato seriamente a scuola).

Una lingua comune

Nella (breve) storia dell’Unione Europea non ci sono mai stati tentativi seri di dotare questa federazione di una lingua comune. I tentativi seri sono andati in altre direzioni: legislative (leggi comuni), economiche (mercato comune), politiche (parlamento europeo). Per cui si è ritenuto (in modo miope) più importante costruire una moneta comune (l’euro) piuttosto che una lingua comune. Decisioni guidate da un pensiero solo razionale, che si scontra con le caratteristiche delle culture.

A suo tempo, le decisore politiche avevano davanti a sé almeno due strade per costruire una lingua comune: puntare su una lingua pianificata (l’esperanto) oppure adottare una lingua commerciale (l’inglese).

La prima, sviluppata tra il 1872 e il 1887 dal medico e linguista polacco Ludwik Lejzer Zamenhof, aveva “lo scopo di far dialogare i diversi popoli cercando di creare tra di essi comprensione e pace con una seconda lingua semplice, ma espressiva, appartenente all'umanità e non a un popolo. Un effetto di ciò sarebbe stato quello di proteggere gli idiomi "minori", altrimenti condannati all'estinzione dalla forza delle lingue delle nazioni più forti. Per questo motivo l'esperanto è stato ed è spesso protagonista di dibattiti riguardanti la democrazia linguistica (…) Dopo rapida espansione del movimento esperantista in molti Paesi, esso subì vari duri colpi nel corso della Prima guerra mondiale, ma soprattutto nella Seconda guerra mondiale a causa di Hitler, che riteneva l'esperanto la lingua degli ebrei (Zamenhof era ebreo), ma anche nella Russia di Stalin (e più recentemente, nell'Iraq di Saddam Hussein). Nel secondo dopoguerra (eccetto dove gli esperantisti erano ancora perseguitati) il movimento riprese vigore, ma subendo la forza a livello internazionale del francese prima e soprattutto dell'inglese poi, data la forza e l'influenza degli Stati Uniti d'America sulla scena internazionale”.

Oggi l’esperanto, nonostante i tanti proclami e risoluzioni dell’UNESCO, non sembra aver nessuna possibilità.

A questo punto, potrebbe essere l’inglese ad assumere il ruolo di lingua unificante.

Tuttavia, nell’Unione Europea solo il 10-20% parla l’inglese in modo fluente (requisito necessario per intendersi reciprocamente) e per lo più sono persone altamente scolarizzate.

Se l’Unione Europea facesse ora un investimento serio scolasticamente, forse tra 50 anni avremmo una federazione con una lingua comune, come le grandi potenze. Ma a parte il fatto che, con la velocità dei cambiamenti attuali, è inimmaginabile un tempo di attesa così lungo, ci sono molte forze che remano contro questo progetto (che comunque sarebbe discutibile, dal sapore neo-coloniale): le popolazioni degli Stati membri (in primis francesi e italiane) non sono così innamorate di questa lingua, anzi sono abbastanza restie ad impararla; inoltre, lo stato membro (UK) in cui l’inglese è madrelingua ha da poco… abbandonato l’Unione. Una beffa.

Le conseguenza dell'assenza di una lingua comune

La mancanza di una lingua comune, la base principale su cui intavolare una discussione, uno scambio di idee, una comprensione reciproca, rinforza le identità nazionali. E, a cascata, produce tante conseguenze nefaste. Che sono un po’ sotto l’occhio di tutte:

- 3 parlamenti (Bruxelles, Strasburgo e Lussemburgo) al posto di 1 solo;

- la possibilità di veto da parte di uno stato membro (e come se la Florida avesse potere di veto alle decisioni internazionali degli US);

- nessuna politica estera comune su conflitti come (ad esempio) Libia, Bielorussia, Grecia-Turchia, Israele-Palestina; ad eccezione (chissà per quanto?) dell’Ucraina-Russia). In quei conflitti gli Stati membri appoggiano contendenti diversi, a tal punto che pochi giorni fa Spagna e Irlanda hanno riconosciuto lo Stato della Palestina (l’avrebbe fatto la Florida?);

- nessuna politica militare comune (ogni Stato dell’UE si arma e vende armi per conto proprio);

- nessuna politica fiscale comune (regimi fiscali diversi a Malta, Irlanda, Paesi Bassi… — questo, a onor del vero, avviene anche negli US);

- nessuna politica commerciale comune (ogni Stato UE compete con gli altri per vendere i propri prodotti e stipula contratti commerciali in modo indipendente);

- ecc.

Per cui l’Unione Europea, come progetto culturale, è fallita.

Rimane il progetto economico, legislativo e politico. Ma senza una lingua comune sarà sempre in affanno e non potrà competere con le altre grandi potenze.

Io comunque, a scanso di equivoci, andrò a votare.

P.S. Ho usato il femminile sovraesteso, “per vedere l’effetto che fa”.

Celebrare la natura e le sue leggi - Roma Barocca, il Cenotafio di Boullée e la scala di Nervi

Perché possiamo parlare di nesso tra l’architettura, in particolare tra i monumenti, l’architettura celebrativa, e le scienze?

Perché il monumento – che è il culmine dell’architettura di celebrazione – non celebra esclusivamente il suo soggetto, ad esempio il cavaliere della statua equestre, ma spesso amplia la celebrazione verso ampie parti della società, al creato, alle leggi di Dio o a quelle della scienza, e, infine, alle capacità generative e di manipolazione delle scienze e delle tecniche.

1. LA ROMA BAROCCA DEL XVII E DEL XVIII SECOLO

Il piano urbano della Roma barocca che si formò tra il XVII e il XVIII secolo trascende la dimensione monumentale dei palazzi e della loro disposizione e magnificenza: è un piano «urbanistico-monumentale» (Schultz, C. N. Architettura Barocca, città: casa editrice, 1979).

I monumenti, come l’Obelisco della Minerva, posto dal Bernini nell’omonima piazza, come il dialogo creato da Pietro da Cortona tra la chiesa di Santa Maria della Pace e la piazza antistante, Piazza Navona, voluta da Papa Innocenzo X della famiglia Pamphili, la Fontana dei Quattro Fiumi progettata da Bernini per la medesima piazza, la chiesa di S. Agnese, disegnata dal Borromini, sempre in piazza Navona, sono posizionati per spiccare — l’accentramento nelle piazze, la magnificenza, la mole massiccia, i materiali – e, nello stesso tempo, per celebrare la grandezza della controriforma, delle famiglie papali che ne furono i principali fautori,

Ma non tutti i monumenti di questo barocco romano celebrano la stessa cosa.

Le opere di Borromini e Guarini – ad esempio, le conchiglie custodite da Borromini nella sua casa[1] e ispirazione per la lanterna di Sant’Ivo alla Sapienza, oppure i lavori teoretici di Guarini sul carattere vibratorio del reale, che si ritrovano in tutta la sua opera architettonica[2] - celebrano la grandiosità del creato, una natura intessuta di leggi divine, di leggi nuove che alla staticità del vecchio mondo chiuso rispondono con il dinamismo del nuovo mondo aperto e infinito.

Quello romano è un Barocco che mima «la natura», i rapporti complessi del creato, le sue fluttuazioni dinamiche, per restituire una sorta di «spiritualità naturalistica»[3], specchio spirituale della nuova scienza Newtoniana.

2. IL CENOTAFIO DI NEWTON

Un cenotafio, monumento sepolcrale privo dei resti mortali della persona in onore della quale è stato eretto è nello stesso tempo un oggetto monumentale, commemorativo e un segno che richiama dei caratteri della persona onorata.

Quello in onore di Isaac Newton, disegnato nel 1784 da Etienne Boullée ma mai realizzato, celebra il rapporto tra il «misterioso e sacro turbinio della natura» e l’intelligibilità delle leggi naturali: ciò che prima era mistero e inquietudine, ora è conoscenza e chiarezza.

Ne è prova, ad esempio, la trattazione della luce. Nell’illuminismo, che toccò profondamente Boullée, la luce è chiarezza e rappresentazione auto evidente dell’intelletto umano.

Infatuato dal mondo che era nato in seguito a Newton, Louis-Etienne Boullée realizzò sei disegni a inchiostro per raffigurare il fanta-progetto del cenotafio in onore dello scienziato inglese.

Si trattava di un’enorme sfera, che in quel tempo non sarebbe stato possibile realizzare tecnicamente, adagiata su una base circolare che le avrebbe fatto da immenso piedistallo, sul cui bordo esterno sarebbero stati piantati – a tre altezze differenti – una moltitudine di cipressi ben ordinati in file e colonne.

All’interno sarebbero stati posizionati soltanto un sarcofago romano vuoto e un enorme astrolabio sferico posto a mezz’altezza. L’astrolabio - attraverso una lanterna posizionata al centro – avrebbe riprodotto, durante le ore notturne l’impressione della luce diurna e, inversamente, durante le ore diurne molte piccole fessure distribuite sulla porzione superiore della sfera avrebbero restituito la posizione delle stelle, dei pianeti e della luna durante le ore notturne.

Pochi elementi essenziali. Le fessure e l’astrolabio riproducono, inversamente, le tracce del cosmo: la notte dentro con il giorno di fuori, il giorno dentro con la notte di fuori.

In aggiunta, l’enorme sfera non «è» solamente un microcosmo ma sta per la forma della terra, per come l’aveva concepita lo stesso Newton, una sfera schiacciata ai poli.

Anche il senso di immensità dovuto all’altezza complessiva della struttura di oltre 146 metri, così come l’utilizzo di forme elementari e platoniche come la sfera, non celebrano direttamente «il naturale», quanto la possibilità da parte dell’intelletto di conoscere le leggi della natura.

A sua volta, la distribuzione ordinata e schematica delle piante, una semplificazione dello schematismo sovrabbondante del barocco, non soltanto avrebbe rievocato le antiche sepolture e i primi paradisi persiani[4], ma avrebbe mostrato la chiarezza matematica e la lucidità schematica del nuovo pensiero illuminista.

A dirla tutta, piuttosto che un’obiezione, il fatto che l’opera fosse tecnicamente irrealizzabile, sembra parlare a favore della ferma convinzione che, un giorno, la scienza avrebbe permesso ogni fantasticheria.

3. IL FUTURISMO DI SANT’ELIA E LA SCALA ELICOIDALE DI PIER LUIGI NERVI

Il Futurismo italiano inaugurò un generale sentimento anti-monumentale che avrebbe attraversato tutto il ‘900. Antonio Sant’Elia nel suo Manifesto dell’architettura futurista dichiarava un odio viscerale per i monumenti imperituri, per ciò che non varia e che s’accontenta di tornare, con stanchezza, alle origini.

Preferiva di gran lunga la variazione repentina e l’esistenza effimera di ciò che ogni giorno deve essere rifatto ex novo - ogni generazione deve rifare da capo la propria città.[5]

Sant’Elia rinnega il monumento forma-tipo, come ciò che si allaccia al passato e non smette di tornarci, ma non rinnega la capacità «celebrativa» di ciò che è monumentale.

Piuttosto esalta la dimensione comune di ciò che celebra e che viene celebrato: la velocità - per fare un esempio - non celebra null’altro che la velocità e le scienze che la rendono possibile.

La piega futurista suggerisce che, con l’impiego di diversi stratagemmi, ciò che è monumentale ha sempre esaltato anche le tecniche che ne rendevano possibile la sua realizzazione.

È esemplare, in questo senso, la scala elicoidale di Pier Luigi Nervi dello stadio di Firenze: l’intento celebrativo «sta» per la realizzazione stessa dell’opera, la dimostrazione del calcestruzzo; non c’è più celebrazione della natura, e neppure celebrazione della capacità intellettiva di carpire le sue leggi; ma auto celebrazione delle capacità manipolative della tecno-scienza.

NOTE

[1] Cfr.: Barillier, E., Francesco Borromini: il mistero e lo splendore, Casagrande Editore, 2011

[2] Cfr.: Assunto, R., Un filosofo nelle capitali d’Europa: la filosofia di Leibniz tra. Barocco e Rococò, Storia della critica d’arte annuario della s.i.s.c.a.,2020

[3] Cfr.: D’Ors, E., Del Barocco, SE Editore, 1999

[4] Cfr.: P. Grimal, P., L’arte dei giardini, Feltrinelli Editore, 2014

[5] Cfr.: Sant’Elia, A., Manifesto dell’architettura futurista, 1914

Scoperte giuste, spiegazioni sbagliate: il caso del telegrafo senza fili

Una visione ingenua della scienza, che questo blog cerca di mettere in discussione, è convinta che ci sia sempre coerenza tra scoperte e spiegazioni. In altri termini, quando si scopre qualcosa è perché c’è dietro una corretta individuazione delle cause.

Ma non sempre è così, e una scienza aperta dovrebbe essere tollerante con le scoperte che non hanno (ancora) spiegazioni e non emarginarle soltanto perché non sono in grado di fornirle in modo adeguato o convincente. O sono contrarie alle credenze consolidate in un settore scientifico. E’ il caso del telegrafo senza fili di Marconi.

Nel 1894 Guglielmo Marconi, studente di fisica a Bologna, andò dal suo docente Augusto Righi, famoso per lo studio delle radiazioni elettromagnetiche. Marconi annunciò: “Professore, con le onde elettromagnetiche che lei ha scoperto, faccio il telegrafo senza fili da qui all’America”. Righi rispose: “Ma che stupidaggini. Esca fuori di qui prima che io la prenda a calci!”. Poco dopo un giornale di Parigi intervistò, sullo stesso argomento, Henri Poincarè, il massimo fisico teorico dell’epoca. Egli rispose ironicamente: “Marconi lo sa che la terrà è tonda o pensa ancora che la terra sia piatta?”.

Infatti le onde elettromagnetiche si propagano in linea retta. Per cui, se forse potevano superare una collina, certamente non la curvatura terrestre.

Incurante di questa impossibilità teorica, Marconi installò un’antenna in Cornovaglia (UK) e una a Terranova (Canada). Il 12 dicembre del 1901, fece l’esperimento e il segnale raggiunse Terranova. Come mai?

Perché esiste la ionosfera (una fascia dell'atmosfera terrestre, composta da gas), che agisce come uno specchio. Per cui l’onda emessa dalla Cornovaglia andava effettivamente in linea retta (conformemente alla teoria di Righi), ma poi raggiunta la ionosfera veniva rimbalzata nuovamente verso la terra. Ma né Righi né Marconi erano a conoscenza dell’esistenza della ionosfera, che fu attestata solo nel 1924.

Ma allora come faceva Marconi a prevedere il fenomeno della diffrazione delle onde elettromagnetiche? Perché era… ignorante! Nel senso che lui credeva (erroneamente) che le onde elettromagnetiche si propagassero parallelamente alla superficie terrestre. Infatti Marconi la laurea in fisica non la prese mai. Prese solo… il Nobel per la fisica (nel 1909).

Per cui non sempre accade che chi sa le cose vede giusto e chi non le sa vede sbagliato.

NOTA

Da una conferenza https://www.youtube.com/watch?v=46iHx2ydTdw di Emilio del Giudice (1940-2014), grande fisico (emarginato) ed eccellente divulgatore. https://it.wikipedia.org/wiki/Emilio_Del_Giudice