Il tempo schermo e i suoi impatti educativi sull’infanzia

Le tecnologie digitali non sono né buone né cattive, ma nemmeno neutre. Il concetto di "tempo schermo”, benché sia poco diffuso in Italia, gode di un ampio uso in ambito internazionale ed è particolarmente adatto per comprendere gli effetti di un’esposizione precoce e prolungata su bambine/i. Il tempo schermo è l’insieme delle ore trascorse davanti a uno schermo, indipendentemente dal tipo di contenuto o dal tipo di dispositivo (connesso o meno a internet) sia esso smartphone, televisione, tablet o qualsiasi altro schermo. Il concetto permette quindi di non guardare solo alle tecnologie digitali “recenti” e includere la “vecchia” televisione, anche perché con l’arrivo delle smart Tv la distinzione è sempre più sfumata. Paradigmatico è oggi You Tube che è sia un canale televisivo, sia una app di smartphone, sia una piattaforma di internet, ed è seguitissimo da piccoli/e.

Oggi, la presenza di schermi in ogni casa è significativa: in una famiglia occidentale media (di quattro persone) ci sono dieci schermi; si tratta di diversi dispositivi, per lo più connessi a internet, che caratterizzano un vero e proprio “ambiente schermo" in cui i bambini crescono. Questa disponibilità di schermi – per lo più accesi e visti anche in modo indiretto – contribuisce a modellare l’ambiente, il ritmo di vita, gli stimoli e le stesse attività quotidiane, con impatti misurabili anche in termini di minore parole ricevute e prodotte e maggiori interruzioni di attenzione focalizzata.

IMPATTO DEL TEMPO SCHERMO SULLO SVILUPPO FISICO E MENTALE

L'aumento del tempo schermo riduce drasticamente altre temporalità essenziali nell’infanzia, come il tempo di sonno, di gioco libero, di interazione sociale; riduce il tempo trascorso all'aria aperta e il tempo della lettura. Gli studi in letteratura scientifica confermano che il tempo schermo ha un impatto sia diretto sia indiretto su questi tempi, i quali sono fondamentali per l’apprendimento e lo sviluppo delle capacità cognitive, sociali e sullo stesso sviluppo psicofisico, soprattutto nei primi cinque anni di vita, per i quali l’OMS consiglia il meno tempo schermo possibile, in particolare zero minuti nei primi due anni.[1]

È importante chiarire però che non è corretto affermare che il tempo schermo abbia sempre un impatto negativo sullo sviluppo psicofisico: fattori come il contesto familiare, il tipo di contenuti fruiti e le differenze individuali di bambini/e giocano un ruolo cruciale nel determinare l’entità dell’effetto. D’altro canto, il tempo schermo precoce (prima dei cinque anni) e prolungato (superiore alle due ore giornaliere dopo i cinque anni) è certamente un fattore di rischio, poiché aumenta le probabilità di riscontrare problemi di vario tipo. È anche opportuno precisare che i dati mostrano che gran parte del tempo schermo nei bambini da 0 a 8 anni è impiegato per la visione di brevi video (73%) o videogiochi (16%), e quindi, al netto di eccezioni, minoranze e contesti specifici, il tempo schermo non è un tempo dedicato a contenuti adeguati all’età, ad app effettivamente educative o dedicate a un uso creativo.

Le principali associazioni pediatriche a livello mondiale, basandosi su una vasta letteratura scientifica, sottolineano come il tempo schermo influenzi aspetti fondamentali dello sviluppo, quali la vista, l’alimentazione, il rischio di sovrappeso e, soprattutto, il sonno; nell’area cognitiva influisce negativamente su attenzione, linguaggio, memoria e quindi capacità scolastiche. Inoltre, sono stati riscontrati effetti relazionali come ansia, depressione, isolamento sociale, cyberbullismo, dipendenze che sollevano preoccupazioni per il benessere mentale a lungo termine. Benché nei prossimi anni possano divenire tra gli effetti più preoccupanti, sono ancora poco studiati gli effetti sulla intimità, affettività e sessualità dovuti a una esposizione precoce a video pornografici (l’età media si sta abbassando spaventosamente persino sotto i dieci anni), al punto che in Spagna si parla di Generación Porno.

Il mio interesse di ricerca si concentra sui rischi legati all’esposizione precoce e prolungata agli schermi in bambine/i, dalla nascita fino alla fine della scuola primaria, dove insegno. Sono anni in cui si apprendono le cose essenziali per la vita, ma anche anni vulnerabili: sono anni in cui si sviluppano le capacità cognitive alla base della carriera scolastica, nei primi quattro anni il linguaggio orale, fino a dieci la letto-scrittura.

La psicologia dell’età dello sviluppo ci spiega che l’attenzione e il linguaggio si possono sviluppare solo con una relazione umana; il tempo schermo non solo non sviluppa queste capacità ma spesso lo rallenta[2] Infatti in assenza del cosiddetto "co-viewing" – ovvero la visione congiunta dei contenuti e il dialogo costante con l’adulto su ciò che si sta vedendo e facendo – l’apprendimento tramite schermi risulta non solo limitato ma anche limitante poiché intacca i prerequisiti di apprendimento, rendendo l’attenzione più frammentata. Un’intera linea di esperimenti nota come il video deficit effect spiega proprio come l’apprendimento (non la comprensione) sia migliore con la presenza umana, mentre risulti molto arduo se non persino assente, quando è mediato dagli schermi. Il "co-viewing" è considerato una condizione essenziale per garantire che i bambini traggano un beneficio educativo reale da questi dispositivi, riducendo gli effetti negativi. Per fare in modo che si possa apprendere tramite gli schermi fino all’inizio della scuola primaria è caldamente consigliata la presenza e la mediazione adulta, non solo nella scelta dei contenuti ma proprio nell’attività di ascolto e interazione. Il che è in palese contraddizione con quanto fanno oggi gli adulti, che danno gli schermi proprio per essere separati (o non disturbati) dai bambini.

LE SETTE CARATTERISTICHE DEL TEMPO SCHERMO

Il tempo schermo si caratterizza per lo più per alcune caratteristiche che derivano dal suo far parte dei mezzi di comunicazione di massa con le relative evoluzioni digitali del XXI secolo. Benché si possano fare usi creativi e attivi del digitale, e la Media Education ne descriva una infinità, essi rimangono “potenzialità” auspicate, perché la realtà è meno edulcorata di come questa disciplina di norma ce la presenta; le salienze del tempo schermo possono essere sintetizzate in sette punti che ne indicano la tendenza:

- Sedentarietà. La caratteristica principale del tempo schermo è la sedentarietà. Il movimento di mani e piedi è essenziale nei primi anni di vita per lo sviluppo del cervello, mentre il tempo schermo smaterializza il corpo immobilizzandolo. La mancanza di attività fisica associata all’uso prolungato degli schermi può influenzare negativamente lo sviluppo fisico e cognitivo del bambino.

- Deprivazione Sensoriale. Il tempo schermo è limitato quasi esclusivamente alla visione, deprivando la stimolazione multisensoriale di cui il bambino ha bisogno (tatto, olfatto, gusto e anche l’ascolto della parola nella misura in cui i dialoghi sono spesso inutili). Recenti studi oftalmologici hanno inoltre osservato che l’uso precoce di piccoli schermi può portare a un aumento della miopia in bambini/e e dello strabismo con ulteriori effetti negativi persino sulla capacità di lettura e di equilibrio.

- Convergenza Digitale. La convergenza digitale, ovvero il fatto che un dispositivo sia contemporaneamente telefono, telegrafo, macchina fotografica, e la possibilità di utilizzare lo stesso contenuto (per es. un videogioco, una partita di calcio, ecc…) su diversi dispositivi (televisione, tablet, smartphone), comporta il precipitare di ogni esperienza nel tempo schermo, con una fruizione continua e spesso priva di interruzioni lunghe, pervasiva e difficilmente limitabile.

- Illimitatezza. Le piattaforme digitali sono progettate per offrire contenuti in maniera continua, senza una "fine" naturale, tramite algoritmi che rilevano e si adattano alle preferenze dell’utente, incentivando un uso prolungato dello schermo.

- Divertissment. La maggior parte delle app e dei contenuti rivolti ai bambini è pensata principalmente per il divertissment, termine francese che designa il distrarre, il divertire, l’intrattenere. Non hanno scopo principalmente educativo. Questo tipo di intrattenimento punta alla "distrazione" eterodiretta, cioè a una gestione dell’attenzione orientata a trattenere il bambino davanti allo schermo divertendolo, che è esattamente il contrario della salutare distrazione propria al fantasticare della rêverie.

- Spettacolarità e isolamento. Il tempo schermo è spesso una fruizione individuale, che comporta l'isolamento sociale perché ciascuno ha il suo schermo; limita le attività di gruppo e le interazioni faccia a faccia, limitando così lo sviluppo di abilità sociali cruciali.

- Cronofagia. Il tempo schermo distorce la percezione del tempo. Bambini e adolescenti spesso non riescono a controllare il tempo trascorso davanti agli schermi, con un impatto negativo sulla gestione del tempo. Questo effetto è stato definito filosoficamente "cronofagia", ovvero la capacità di “divorare” il tempo.

In aggiunta, studi recenti indicano che l’esposizione precoce e prolungata agli schermi è associata a una diminuzione delle capacità attentive richieste in ambito scolastico. L’attenzione stimolata dagli schermi è di tipo "bottom-up", cioè orientata alla cattura immediata dell’attenzione tramite stimoli visivi, allarmi o segnali di pericolo, piuttosto che alla concentrazione sostenuta. Questo tipo di attenzione, studiato dalla psicologia cognitiva, può essere associato alla progettazione di app e piattaforme che utilizzano meccanismi per incentivare l’uso prolungato, perseguendo finalità commerciali più che educative.

QUALCHE CONCLUSIONE

È importante essere consapevoli che più ci si avvicina alla nascita più gli studi concordano sulla negatività degli effetti, a prescindere dai contenuti. Il fenomeno della disgiunzione dell’attenzione è forse il più importante. L’attenzione è infatti un prerequisito della trasmissione culturale in ogni cultura ed è per questo che educatori ed educatrici di tutto il mondo hanno individuato l’attenzione come la fonte dei processi di apprendimento. Come vedremo nel prossimo numero, la relazione pedagogica si basa su processi attentivi, ma negli esseri umani l’attenzione si sviluppa principalmente per vie extracorticali ed è predittiva dello sviluppo del linguaggio umano e delle capacità simboliche. L’attenzione cioè si sviluppa anche a livello biologico grazie all’aggancio oculare con altri simili tramite la condivisione di intenzionalità e il fenomeno da tempo noto di attenzione congiunta.

NOTE

[1] Cfr. World Health Organization (Who) (2019), Guidelines on Physical Activity, Sedentary Behaviour and Sleep for Children Under 5 Years of Age, Genève; cf. Grollo M., Zanor S., Lanza S., et al. (2022), Pediatri custodi digitali, la prima guida per i pediatri di famiglia sull’educazione digitale familiare dalla nascita, IAM Edizioni, Udine.

[2] Per una ampia bibliografia si veda: Desmurget M. (2020) Il cretino digitale. Difendiamo i nostri figli dai veri pericoli del web, Rizzoli, Milano. Mi sia permesso rimandare al mio saggio: in corso di pubblicazione: L’attenzione contesa, come il tempo schermo modifica l’infanzia, Armando, Roma.

Decalogo Latouriano - Il pensiero meno noto di Bruno Latour, Prima parte

Questo è un dono alle tante laturiane[1] superficiali e distratte, che hanno preso di Bruno Latour (1947-2022) solo gli aspetti più eclatanti (come mettere sullo stesso piano umani e non-umani, l’agency degli oggetti, il messaggio apparentemente post-moderno ecc.), affinché diventino laturiane profonde, meticolose e convinte. Tirato per la giacca da tante (postmoderniste, sociologhe interpretative, nuove materialiste, decostruzioniste ecc.), Latour è stato infatti un personaggio poliedrico, contraddittorio, escapologico. Per cui, è lui a essere il primo responsabile dei tanti fraintendimenti della sua opera.

Al fine di recuperare la parte meno utilizzata del suo messaggio e del suo metodo, propongo una collezione del suo pensiero, così come delineato ne Riassemblare il sociale (2005), diviso in sette sezioni:

- Il sociale, la società e la sociologia

- Una critica agli altri approcci e tradizioni di ricerca

- Il costruzionismo

- Gli attanti

- Il micro e il macro

- Il metodo ANT: come tracciare associazioni

- Con Latour, oltre Latour

In questo primo post affronteremo i primi due.

1. IL SOCIALE, LA SOCIETÀ E LA SOCIOLOGIA

- Il “sociale” non è un dominio particolare. Per cui di un fenomeno non esiste una spiegazione sociale, accanto a quella psicologica, economica, culturale ecc.

- Per questo motivo, la scienza (o meglio, un contenuto scientifico) non può essere spiegata dal suo contesto sociale. Anzi, è proprio il contrario: è il contenuto scientifico che spiega la società. Sono gli oggetti della Scienza che possono spiegare il sociale.

Non bisogna, però, essere deterministi, e convenire che nemmeno il contenuto scientifico deve essere usato per spiegare i componenti delle relazioni sociali. Il tema è quindi molto più complesso: possiamo dire che la scienza lega le varie entità in modo scientifico.

- Per cui il “sociale”, agli occhi dell'Actor-Network Theory (ANT), è un movimento assai peculiare, di riassociazione e riassemblaggio di tutte le entità che attraversano un campo d’azione. Cogliere questo movimento è compito dello studioso. Tuttavia, per farlo, egli deve sviluppare una sensibilità particolare, che consiste nel potenziare il nostro “senso del movimento”, ovvero nell’acquisire “il senso del sociale”. Infatti, i fisiologi hanno mostrato che, perché una percezione abbia luogo sono necessari continui movimenti e aggiustamenti: se non c'è movimento, non c'è sensazione. Con l'assenza di movimenti sopraggiunge un offuscamento dei sensi. Lo stesso vale per il ‘senso del sociale’: se lo studioso non è capace di vedere nuove associazioni, non sarà nemmeno in grado di vedere il sociale.

- Il compito dello studioso è quindi il tracciamento di nuove associazioni (configurazioni), fra forze sino ad allora inassociate.

- Nel fare questo, occorre quindi tener ben presente che la società non esiste. Esistono solo i raggruppamenti, il collettivo, che è il progetto di assemblaggio di entità nuove non ancora riunite; inoltre bisogna mettere in luce l’eterogeneità di attanti molto diversi fra loro, i quali si mescolano come “una squadra di operai che costruisce un muro di mattoni: le loro strade si separano di nuovo solo dopo che il muro è stato completato. Tuttavia, mentre lo si costruisce, non c'è dubbio che siano collegate. Come? Sarà la ricerca di determinarlo”

- Bisogna riconoscere appieno chi e che cosa partecipa all’azione, includendo anche le “masse mancanti” di entità non-umane. Infatti, gli aggregati (associazioni che hanno una forma, seppur momentanea) si muovono all'interno di fenomeni non formattati. Questo sfondo Latour lo chiama "plasma": esso è astronomicamente enorme per dimensioni e portata, un immenso repertorio di masse

- A tal fine, i termini e i concetti di “sociale” e “naturale” devono perciò essere accantonati. Perché i pesci e pescatori non si fronteggiano come ‘naturale’ e ‘sociale’, ‘oggetto’ e ‘soggetto’, ‘materiale’ e ‘simbolico’. Per Gabriel Tarde (1843-1904), ricorda Latour, non c’era alcuna ragione per separare il “sociale” umano da altre associazioni come gli organismi biologici o persino gli atomi. Il sociale, per Tarde, era un fluido in circolazione, e non organismo. Ogni cosa era una società e ogni fenomeno era un fatto sociale: società cellulari, società atomiche, società di astri. Tutte le scienze, pronosticava Tarde, sembrano destinate a divenire rami della sociologia.

2. UNA CRITICA AGLI ALTRI APPROCCI E TRADIZIONI DI RICERCA

- Latour si definisce “oggettivista”, dicendo di non avere alcuna simpatia per le “sociologie interpretative”, perché l'ANT non apprezza l’eccessiva enfasi data dai fenomenologi alle fonti umane dell’azione, e ignora completamente la lunga battaglia tra oggetto e soggetto. E invita alla lettura del filosofo tedesco Peter Sloterdijk che, con i tre volumi sui diversi tipi di sfere, ha offerto una nuova e potente metafora per uscire dalla dicotomia interno/esterno.

- Ciò non significa che dovremmo privarci del ricco vocabolario descrittivo della fenomenologia; semplicemente che dobbiamo estenderlo alle entità ‘non intenzionali’.

- Per cui bisogna ritornare all’oggetto. Nel rivendicare il proprio “realismo”, Latour però ne dà un’interpretazione diversa da quella tradizionale. Egli ritiene che l’oggettività non sia una proprietà privata dei positivisti. Anzi, condivide l’affermazione del microbiologoe filosofo polacco Ludwik Fleck (1896-1961): “più sociale c'è, più realismo c'è”.

- Latour accetta anche l’etichetta di “relativista”: “ma certo, cos'altro potrei essere?”, dice. In linea con quanto scriveva Peter L. Berger (1963) sul progetto di “alternanza”, ma senza mai citarlo, Latour sostiene che “per raggiungere l'oggettività, devo essere in grado di navigare da un quadro di riferimento all'altro, da un punto di vista all'altro. Senza questi spostamenti, sarai limitato al mio ristretto punto di vista per sempre”. La “relatività”, più che il relativismo, è la bussola dello studioso.

- Latour è quindi “oggettivista”, “realista” e “relativista” nello stesso tempo; una miscela originale che attribuisce nuovi significati a vecchi termini, che tuona contro l’empirismo tradizionale a favore di un nuovo empirismo.

- Infatti l'empirismo storico è stato “una resa piuttosto povera all'esperienza. Questa povertà, tuttavia non si supera allontanandosi dall'esperienza materiale per esempio in direzione della ‘ricca soggettività umana’, ma avvicinandosi alle forme di resistenza variegate che la materia ha da offrire”. Perché “artificialità totale e oggettività totale si muovono in parallelo”.

- “Non siamo più obbligati a combattere il riduzionismo aggiungendo alla descrizione qualche ‘aspetto’ umano, simbolico, soggettivo o sociale, perché il riduzionismo, tanto per cominciare, non rende giustizia ai fatti oggettivi. Quel che si potrebbe chiamare il primo empirismo è riuscito, per ragioni politiche, a oscurare i numerosi percorsi e deviazioni dell'oggettività e a ridurre in umani all'ombra di se stessi”, scrive Latour.

- Lungi dal ‘possedere oggettività’, “i positivisti somigliano piuttosto proprietari terrieri assenteisti, che sembrano non sapere cosa farsene dei loro latifondi”. Per cui, “il riduzionismo è un'impossibilità pratica, nella misura in cui gli elementi a cui si riduce un ‘livello superiore’ saranno tanto complessi quanto il ‘livello inferiore’. Se solo gli umani nelle mani di sociologi critici potessero essere trattati al pari delle balene in zoologia…” termina sconsolato Latour.

- E alla fine, uccide il padre: “devo finalmente congedarmi da Tarde (...) Egli ha mantenuto una definizione sostanziale e non relativista della sociologia”.

NOTE

[1] Uso il femminile sovraesteso.

BIBLIOGRAFIA

Berger, Peter L. (1963), trad. it. Invito alla sociologia, Venezia: Marsilio.

Descola, Philippe (2005), trad. it. Oltre natura e cultura, Milano: Cortina, 2014.

Fleck, Ludwik (1935), trad. it. Genesi e sviluppo di un fatto scientifico, Bologna: Il Mulino

Ginzburg, Carlo (1976), Il formaggio e i vermi. Il cosmo di un mugnaio del Cinquecento, Torino, Einaudi.

James, William (1890), trad. it. Principi di Psicologia, Milano: Società Editrice Libraria, 1909.

Latour, Bruno (2005), tr. Riassemblare il sociale, Milano: Meltemi, 2022.

Sloterdijk, Peter (1998), trad. it. Sfere / Bolle vol. 1, Milano: Meltemi 2009.

Sloterdijk, Peter (1999), trad. it. Sfere / Globi vol. 2., Milano Cortina, 2014.

Sloterdijk, Peter (2004), trad. it. Sfere / Schiume vol. 3., Milano: Cortina, 2015.

Tarde, Gabriel (1894), La logique sociale, Paris: Alcan.

Intelligenza artificiale e creatività - Seconda parte: c’è differenza tra i pennelli e l’IA?

Qualche settimana fa avevamo iniziato una riflessione sull’interazione tra processo creativo artistico e Intelligenza Artificiale.

Ci eravamo chiesti se realizzare un’immagine con l’IA può essere definito come un atto creativo e abbiamo avuto le risposte di tre amici di Controversie, ognuno dalla propria ottica che deriva da un diverso percorso professionale e culturale (trovate le risposte nell’articolo pubblicato il 10 settembre scorso).

Riporto di seguito le conclusioni di quella prima riflessione:

“Non c’è dubbio che queste tre risposte siano estremamente stimolanti e che vi si possa rintracciare un minimo comune denominatore che le lega: l’idea che l’IA sia solo un mezzo, per quanto potente, ma che l’atto creativo resti saldamente appannaggio di colui che ha nel suo animo (umano) l’obiettivo concettuale.

Ottenere un risultato con l’IA si delinea, qui, come un vero atto creativo, che, però e ovviamente, non è detto che si trasformi in arte, ovvero in una manifestazione creativa in grado di dare emozione universale.

In termini più concreti: molti di noi, forse, potrebbero avere “nella testa” La notte stellata di Van Gogh (giusto per fare un esempio), ma la differenza tra la grandissima maggioranza di noi e il genio olandese è che non sapremmo neppure lontanamente “mettere a terra” questa intuizione.

Con l’IA, a forza di istruzioni che la macchina esegue, potremmo invece, avvicinarci al risultato di Vincent?”

La domanda che sorgeva spontanea, e a cui chiedo ai nostri amici un’ulteriore riflessione, è la seguente: Se così fosse, in che modo cambierebbe l’essenza stessa dell’artista?

Inserisco però un ulteriore elemento che deriva dall’aver letto la bella riflessione di Natalia Irza del 29 ottobre scorso su Controversie dal titolo “Il rating sociale tra digitale e moralità”.

Riporto testualmente un passaggio a mio avviso molto importante anche per il nostro ragionamento su processo creativo e IA. Scrive Irza:

“Per stabilire la verità su una persona, sono necessari strumenti umani. Lo stesso si può dire dell’uso dell’IA nell’arte: la pittura non è uguale alla composizione di colori, la musica non è uguale alla composizione di suoni, la poesia non è uguale alla composizione di parole. Senza la dimensione umana, che significa non solo l’operare algoritmi ma creare idee umane, l’arte cessa di essere arte.”

Aggiungo quindi una provocazione per i nostri amici chiamati a rispondere alla prima domanda, e cioè: dobbiamo quindi pensare che esisteranno in futuro due forme d’arte, una “analogica”, tradizionale, in cui l’essere umano si esprime attraverso strumenti controllati completamente dall’artista e una “nuova arte”, digitale, in cui l’autore si avvale di uno strumento che interviene nel processo creativo “aggiungendo” all’evoluzione concettuale dell’artista?

E quale sarà il livello di contaminazione fra queste due diverse situazioni?

Ecco le prime due risposte, scrive Diego Randazzo:

Quello che rende un artista tale è soprattutto il suo percorso. Un percorso interiore ed esteriore che lo porta a sviluppare una ricerca unica e indipendente. In assenza di tale percorso non vi può essere Arte, ma solo degli isolati appuntamenti con la tecnica.

Quindi, davanti alla possibilità di ricreare dei modelli digitali molto simili a capolavori storicizzati attraverso l’IA, non si può che riconoscere tale pratica come un tentativo, sicuramente curioso e sorprendente, ma molto lontano dalla definizione di Arte.

Non è un caso se utilizzo le parole tentativo e modello, che ne evidenziano l’approccio germinale, automatico e inconsapevole.

In altre parole, penso che la tensione verso la dimensione umana, a cui si riferisce Natalia Irza nell’articolo menzionato, sia necessaria e fondamentale. Del resto come possiamo capire in profondità un artista, senza conoscere qualche dettaglio, anche superficiale, della sua biografia? La Storia dell’Arte è punteggiata, da sempre, da questo binomio, indissolubile anche nel vischioso territorio dell’arte contemporanea: la pratica artistica come estensione e manifestazione della vita stessa degli artisti.

Pensiamo anche al potere del mercato odierno nel dare valore all’opera d’arte: oggi più che mai notiamo che sono le caratteristiche biografiche a fare da volano e non la qualità intrinseca dell’opera (vedi il successo della banana ‘Comedian’ di Cattelan).

Seguendo questo principio, dove la dimensione (e presenza) umana dell’artista sono sempre al centro, trovo assai difficile riconoscere valore nelle sperimentazioni con l’IA condotte dai non addetti ai lavori (non artisti?). Da considerare diversamente sono invece le incursioni degli artisti che utilizzano lo strumento dell’IA con consapevolezza e visione.

Infine di fronte alla possibile convivenza tra due tipologie di Arte (una totalmente analogica ed una totalmente mediata dallo strumento IA) nutro profondi dubbi; non ho mai creduto nella classificazione e scolastica separazione tra discipline, piuttosto credo nella ricerca della complementarità tra queste due modalità. Ad esempio, è molto stimolante l’uso dell’IA per creare ‘modelli e reference’, delle basi da cui partire e su cui innestare il gesto unico dell’autore. Tale gesto si può quindi esemplificare in una copia o rielaborazione analogica (manuale) dei modelli iniziali.

Facendo così, non solo ripercorriamo la storia dell’arte, seguendo il classico ed insuperato paradigma modello/rappresentazione, ma, contestualmente, attualizziamo il contesto: il modello da studiare e copiare non è più la realtà che ci circonda, ma una realtà mediata e spesso incontrollabile, formulata da un algoritmo.

Vorrei proseguire il discorso dando la parola ad Aleksander Veliscek, interessante artista sloveno, che attraverso i dettagli dei suoi affascinanti dipinti mette a punto proprio questa modalità, svelandoci le possibilità di un uso virtuoso ed intelligente dell’IA in pittura.

------------------------------

Ed ecco l’intervento di Aleksander Veliscek:

Penso che creare un’immagine con l’IA oggi può essere considerato un atto creativo, ma con una specificità: è una creatività mediata, e dove non necessariamente appartiene alla sensibilità di tutti gli artisti. Durante il workshop che ho curato quest’anno sul tema PITTURA e IMMAGINI I.A. a Dolomiti Contemporanee (ex stazione, Borca di Cadore), ho potuto constatare da parte di molti allievi-artisti un interessante dialogo tra chatGPT e gli autori.

Un esempio curioso era un artista che lavora in ambito astratto. Si è creato un confronto critico da entrambe le parti nella costruzione dell’immagine. Ne è risultato un pezzo indubbiamente riuscito. Spesso invece c’era un rigetto, in quanto le soluzioni proposte dalla I.A. erano banali e non riuscivano a centrare le sottili sfumature che l’artista cercava anche dopo lunghi tentativi.

È, così, evidente quanto l’essere umano giochi un ruolo essenziale nella progettazione e nell’interpretazione del risultato.

Quindi L’I.A., è sicuramente uno Strumento, sempre più potente e innovativo, ma non sostituisce l’immaginazione e il giudizio umano.

Invece come artista trovo più interessante capire l’aspetto ontologico. Le macchine intelligenti, pur essendo create dall’uomo, possono simulare comportamenti complessi che sembrano riflettere aspetti tipici dell’essere umano, come l’apprendimento, la creatività o persino l’autonomia. Tuttavia, queste simulazioni sono autentiche manifestazioni di “essere” o sono semplicemente imitazioni prive di sostanza?

Martin Heidegger, nel suo studio sull’essere, distingueva tra l’“essere autentico” e l’“essere per altri”. L’IA, in questo contesto, può essere vista come un “essere per altri”, progettata per servire scopi umani, ma incapace di una propria esperienza ontologica. Tuttavia, alcuni teorici suggeriscono che, con lo sviluppo di sistemi sempre più complessi, potremmo dover ripensare questa distinzione.

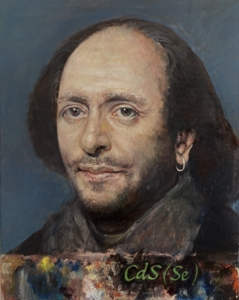

Un mio dipinto ad olio raffigurante William Shakespeare, dove l’effigie realistica del grande drammaturgo è stata creata con l’intelligenza artificiale combinando diverse fonti, partendo dalle incisioni, sculture e dipinti.

Un mio dipinto ad olio raffigurante William Shakespeare, dove l’effigie realistica del grande drammaturgo è stata creata con l’intelligenza artificiale combinando diverse fonti, partendo dalle incisioni, sculture e dipinti.

--------------------------------------

Queste due riflessioni sono certamente molto interessanti ma, tuttavia e inevitabilmente, non portano a risposte certe. Stiamo viaggiando, infatti, su un territorio privo di confini definiti, fluido e in rapido divenire.

Mi sembra si possa dire che ci sono due punti chiave nel ragionamento dei nostri due artisti: la centralità dell’uomo - con tutto il suo portato esistenziale - come attore primario e non sostituibile del processo artistico; e la contaminazione dei modi di fare arte, che per altro è cominciata ben prima dell’I.A..

Contaminazione che è un dato di fatto.

E quindi non è possibile una distinzione rigida (Diego usa la parola “scolastica”) tra arti “tradizionali” e arti in cui tecniche nuove e l’apporto potentissimo dell’I.A, irrompono nel processo creativo.

L’I.A. cambierà presto l’essenza di molti lavori; si pensi a cosa potrebbe diventare la giustizia se le sentenze dovessero passare dall’interpretazione dei fatti data da esseri umani a quelle, teoricamente neutrali, dell’IA (l’oggettività nell’interpretazione dell’agire umano non può esistere).

Forse tra pochi anni le domande che ci siamo posti in questa sede non avranno più senso, superate dalla prassi dell’utilizzo di nuove tecnologie in tutti i settori dell’agire umano, arte compresa.

Ma su questi punti aspettiamo anche il parere degli altri due amici del gruppo di questa discussione…

Legge 13 maggio 1978, n. 180 – Testo integrale

Comunemente, la legge n. 180 viene chiamata “legge Basaglia”; in realtà il suo estensore fu lo psichiatra e politico democristiano Bruno Orsini e Franco Basaglia non ne fu particolarmente soddisfatto – anche se la difese come impianto teorico ed ideologico, come dichiarò in una intervista fatta da Maurizio Costanzo:

«Non è importante tanto il fatto che in futuro ci siano o meno manicomi e cliniche chiuse, è importante che noi adesso abbiamo provato che si può fare diversamente, ora sappiamo che c'è un altro modo di affrontare la questione; anche senza la costrizione.»

La legge n. 180 nacque con un iter frettoloso: il progetto iniziale – che recepiva le istanze e le proposte di Franco Basaglia, del movimento di Psichiatria Democratica e di un numero non indifferente di psichiatri – prevedeva che la precedente legge che regolava il trattamento “dei matti” (Legge 14 febbraio 1904, n. 36 - Disposizioni sui manicomi e sugli alienati. Custodia e cura degli alienati) fosse parzialmente abrogata attraverso un referendum e sostituita nell’ambito della legge istitutiva del Servizio Sanitario Nazionale.

Tuttavia, il referendum rappresentava un rischio, perché il tema “dei matti” poteva essere sentito in modo controverso nella società, e la legge sul Sistema Sanitario avrebbe potuto avere tempi più lunghi del previsto. Il governo Andreotti optò, allora, per lo stralcio degli articoli che riguardavano i principali temi correlati ai manicomi e ne fece la legge n. 180, abrogando in buona parte (fatta esclusione per i temi economici e fiscali) la legge del 1904.

La “180” è una legge breve, molto sintetica, densa di contenuti e difficile da mettere in opera, soprattutto negli anni ’70.

Controversie ha ritenuto – per evitare che il dibattito viaggi sull’onda dei soli commenti e opinioni – di riportarla qui integralmente, insieme all’articolo 64 della legge n. 833/1978, istituiva del Sistema Sanitario Nazionale.

Legge 13 maggio 1978, n. 180

Sommario

Art. 1 Accertamenti e trattamenti sanitari volontari e obbligatori

Art. 2 Accertamenti e trattamenti sanitari obbligatori per malattia mentale

Art. 4 Revoca e modifica del provvedimento di trattamento sanitario obbligatorio

Art. 7 Trasferimento alle regioni delle funzioni in materia di assistenza ospedaliera psichiatrica

Art. 8 Infermi già ricoverati negli ospedali psichiatrici

Art. 9 Attribuzioni del personale medico degli ospedali psichiatrici

Art. 10 Modifiche al codice penale

" Accertamenti e trattamenti sanitari volontari e obbligatori "

pubblicata nella Gazzetta Ufficiale 16 maggio 1978, n. 133.

Art. 1 Accertamenti e trattamenti sanitari volontari e obbligatori.

Gli accertamenti e i trattamenti sanitari sono volontari. Nei casi di cui alla presente legge e in quelli espressamente previsti da leggi dello Stato possono essere disposti dall'autorità sanitaria accertamenti e trattamenti sanitari obbligatori nel rispetto della dignità della persona e dei diritti civili e politici garantiti dalla Costituzione, compreso per quanto possibile il diritto alla libera scelta del medico e del luogo di cura. Gli accertamenti e i trattamenti sanitari obbligatori a carico dello Stato e di enti o istituzioni pubbliche sono attuati dai presidi sanitari pubblici territoriali e, ove necessiti la degenza, nelle strutture ospedaliere pubbliche o convenzionate. Nel corso del trattamento sanitario obbligatorio chi vi è sottoposto ha diritto di comunicare con chi ritenga opportuno. Gli accertamenti e i trattamenti sanitari obbligatori di cui ai precedenti commi devono essere accompagnati da iniziative rivolte ad assicurare il consenso e la partecipazione da parte di chi vi è obbligato. Gli accertamenti e i trattamenti sanitari obbligatori sono disposti con provvedimento del sindaco, nella sua qualità di autorità sanitaria locale, su proposta motivata di un medico.

Art. 2 Accertamenti e trattamenti sanitari obbligatori per malattia mentale.

Le misure di cui al secondo comma del precedente articolo possono essere disposte nei confronti delle persone affette da malattie mentali. Nei casi di cui al precedente comma la proposta di trattamento sanitario obbligatorio può prevedere che le cure vengano prestate in condizioni di degenza ospedaliera solo se esistano alterazioni psichiche tali da richiedere urgenti interventi terapeutici, se gli stessi non vengano accettati dall'infermo e se non vi siano le condizioni e le circostanze che consentano di adottare tempestive ed idonee misure sanitarie extra ospedaliere. Il provvedimento che dispone il trattamento sanitario obbligatorio in condizioni di degenza ospedaliera deve essere preceduto dalla convalida della proposta di cui all'ultimo comma dell'articolo 1 da parte di un medico della struttura sanitaria pubblica e deve essere motivato in relazione a quanto previsto nel precedente comma.

Art. 3 Procedimento relativo agli accertamenti e trattamenti sanitari obbligatori in condizioni di degenza ospedaliera per malattia mentale.

Il provvedimento di cui all'articolo 2 con il quale il sindaco dispone il trattamento sanitario obbligatorio in condizioni di degenza ospedaliera, corredato dalla proposta medica motivata di cui all'ultimo comma dell'articolo 1 e dalla convalida di cui all'ultimo comma dell'articolo 2, deve essere notificato, entro 48 ore dal ricovero, tramite messo comunale, al giudice tutelare nella cui circoscrizione rientra il comune. Il giudice tutelare, entro le successive 48 ore, assunte le informazioni e disposti gli eventuali accertamenti, provvede con decreto motivato a convalidare o non convalidare il provvedimento e ne dà comunicazione al sindaco. In caso di mancata convalida il sindaco dispone la cessazione del trattamento sanitario obbligatorio in condizioni di degenza ospedaliera. Se il provvedimento di cui al primo comma del presente articolo è disposto dal sindaco di un comune diverso da quello di residenza dell'infermo, ne va data comunicazione al sindaco di questo ultimo comune. Se il provvedimento di cui al primo comma del presente articolo è adottato nei confronti di cittadini stranieri o di apolidi, ne va data comunicazione al Ministero dell'interno e al consolato competente, tramite il prefetto. Nei casi in cui il trattamento sanitario obbligatorio debba protrarsi oltre il settimo giorno, ed in quelli di ulteriore prolungamento, il sanitario responsabile del servizio psichiatrico di cui all'articolo 6 è tenuto a formulare, in tempo utile, una proposta motivata al sindaco che ha disposto il ricovero, il quale ne dà comunicazione al giudice tutelare, con le modalità e per gli adempimenti di cui al primo e secondo comma del presente articolo, indicando la ulteriore durata presumibile del trattamento stesso. Il sanitario di cui al comma precedente è tenuto a comunicare al sindaco, sia in caso di dimissione del ricoverato che in continuità di degenza, la cessazione delle condizioni che richiedono l'obbligo del trattamento sanitario; comunica altresì la eventuale sopravvenuta impossibilità a proseguire il trattamento stesso. Il sindaco, entro 48 ore dal ricevimento della comunicazione del sanitario, ne dà notizia al giudice tutelare. Qualora ne sussista la necessità il giudice tutelare adotta i provvedimenti urgenti che possono occorrere per conservare e per amministrare il patrimonio dell'infermo. La omissione delle comunicazioni di cui al primo, quarto e quinto comma del presente articolo determina la cessazione di ogni effetto del provvedimento e configura, salvo che non sussistano gli estremi di un delitto più grave, il reato di omissione di atti di ufficio.

Art. 4 Revoca e modifica del provvedimento di trattamento sanitario obbligatorio.

Chiunque può rivolgere al sindaco richiesta di revoca o di modifica del provvedimento con il quale è stato disposto o prolungato il trattamento sanitario obbligatorio. Sulla richiesta di revoca o di modifica il sindaco decide entro dieci giorni. I provvedimenti di revoca o di modifica sono adottati con lo stesso procedimento del provvedimento revocato o modificato.

Art. 5 Tutela giurisdizionale.

Chi è sottoposto a trattamento sanitario obbligatorio, e chiunque vi abbia interesse, può proporre al tribunale competente per territorio ricorso contro il provvedimento convalidato dal giudice tutelare. Entro il termine di trenta giorni, decorrente dalla scadenza del termine di cui al secondo comma dell'articolo 3, il sindaco può proporre analogo ricorso avverso la mancata convalida del provvedimento che dispone il trattamento sanitario obbligatorio. Nel processo davanti al tribunale le parti possono stare in giudizio senza ministero di difensore e farsi rappresentare da persona munita di mandato scritto in calce al ricorso o in atto separato. Il ricorso può essere presentato al tribunale mediante raccomandata con avviso di ricevimento. Il presidente del tribunale fissa l'udienza di comparizione delle parti con decreto in calce al ricorso che, a cura del cancelliere, è notificato alle parti nonché al pubblico ministero. Il presidente del tribunale, acquisito il provvedimento che ha disposto il trattamento sanitario obbligatorio e sentito il pubblico ministero, può sospendere il trattamento medesimo anche prima che sia tenuta l'udienza di comparizione. Sulla richiesta di sospensiva il presidente del tribunale provvede entro dieci giorni. Il tribunale provvede in camera di consiglio, sentito il pubblico ministero, dopo aver assunto informazioni e raccolte le prove disposte di ufficio o richieste dalle parti. I ricorsi ed i successivi procedimenti sono esenti da imposta di bollo. La decisione del processo non è soggetta a registrazione.

Art. 6 Modalità relative agli accertamenti e trattamenti sanitari obbligatori in condizioni di degenza ospedaliera per malattia mentale.

Gli interventi di prevenzione, cura e riabilitazione relativi alle malattie mentali sono attuati di norma dai servizi e presìdi psichiatrici extra ospedalieri. A decorrere dall'entrata in vigore della presente legge i trattamenti sanitari per malattie mentali che comportino la necessità di degenza ospedaliera e che siano a carico dello Stato o di enti e istituzioni pubbliche sono effettuati, salvo quanto disposto dal successivo articolo 8, nei servizi psichiatrici di cui ai successivi commi. Le regioni e le province autonome di Trento e di Bolzano, anche con riferimento agli ambiti territoriali previsti dal secondo e terzo comma dell'articolo 25 del decreto del Presidente della Repubblica 24 luglio 1977, n. 616, individuano gli ospedali generali nei quali, entro sessanta giorni dall'entrata in vigore della presente legge, devono essere istituiti specifici servizi psichiatrici di diagnosi e cura. I servizi di cui al secondo e terzo comma del presente articolo - che sono ordinati secondo quanto è previsto dal decreto del Presidente della Repubblica 27 marzo 1969, n. 128, per i servizi speciali obbligatori negli ospedali generali e che non devono essere dotati di un numero di posti letto superiore a 15 - al fine di garantire la continuità dell'intervento sanitario a tutela della salute mentale sono organicamente e funzionalmente collegati, in forma dipartimentale con gli altri servizi e presìdi psichiatrici esistenti nel territorio.

Le regioni e le province autonome di Trento e di Bolzano individuano le istituzioni private di ricovero e cura, in possesso dei requisiti prescritti, nelle quali possono essere attuati trattamenti sanitari obbligatori e volontari in regime di ricovero. In relazione alle esigenze assistenziali, le province possono stipulare con le istituzioni di cui al precedente comma convenzioni ai sensi del successivo articolo 7.

Art. 7 Trasferimento alle regioni delle funzioni in materia di assistenza ospedaliera psichiatrica.

A decorrere dall'entrata in vigore della presente legge le funzioni amministrative concernenti la assistenza psichiatrica in condizioni di degenza ospedaliera, già esercitate dalle province, sono trasferite, per i territori di loro competenza, alle regioni ordinarie e a statuto speciale. Resta ferma l'attuale competenza delle province autonome di Trento e di Bolzano. L'assistenza ospedaliera disciplinata dagli articoli 12 e 13 del decreto-legge 8 luglio 1974, numero 264, convertito con modificazioni nella legge 17 agosto 1974, n. 386, comprende i ricoveri ospedalieri per alterazioni psichiche. Restano ferme fino al 31 dicembre 1978 le disposizioni vigenti in ordine alla competenza della spesa. A decorrere dall'entrata in vigore della presente legge le regioni esercitano anche nei confronti degli ospedali psichiatrici le funzioni che svolgono nei confronti degli altri ospedali. Sino alla data di entrata in vigore della riforma sanitaria, e comunque non oltre il 1° gennaio 1979, le province continuano ad esercitare le funzioni amministrative relative alla gestione degli ospedali psichiatrici e ogni altra funzione riguardante i servizi psichiatrici e di igiene mentale. Le regioni e le province autonome di Trento e di Bolzano programmano e coordinano l'organizzazione dei presìdi e dei servizi psichiatrici e di igiene mentale con le altre strutture sanitarie operanti nel territorio e attuano il graduale superamento degli ospedali psichiatrici e la diversa utilizzazione delle strutture esistenti e di quelle in via di completamento. Tali iniziative non possono comportare maggiori oneri per i bilanci delle amministrazioni provinciali. E' in ogni caso vietato costruire nuovi ospedali psichiatrici, utilizzare quelli attualmente esistenti come divisioni specialistiche psichiatriche di ospedali generali, istituire negli ospedali generali divisioni o sezioni psichiatriche e utilizzare come tali divisioni o sezioni neurologiche o neuropsichiatriche. Agli ospedali psichiatrici dipendenti dalle amministrazioni provinciali o da altri enti pubblici o dalle istituzioni pubbliche di assistenza e beneficenza si applicano i divieti di cui all'articolo 6 del decreto-legge 29 dicembre 1977, n. 946, convertito con modificazioni nella legge 27 febbraio 1978, n. 43. Ai servizi psichiatrici di diagnosi e cura degli ospedali generali, di cui all'articolo 6, è addetto personale degli ospedali psichiatrici e dei servizi e presidi psichiatrici pubblici extra ospedalieri. I rapporti tra le province, gli enti ospedalieri e le altre strutture di ricovero e cura sono regolati da apposite convenzioni, conformi ad uno schema tipo, da approvare entro trenta giorni dalla data di entrata in vigore della presente legge, con decreto del Ministro della sanità di intesa con le regioni e l'Unione delle province di Italia e sentite, per quanto riguarda i problemi del personale, le organizzazioni sindacali di categoria maggiormente rappresentative. Lo schema tipo di convenzione dovrà disciplinare tra l'altro il collegamento organico e funzionale di cui al quarto comma dell'articolo 6, i rapporti finanziari tra le province e gli istituti di ricovero e l'impiego, anche mediante comando, del personale di cui all'ottavo comma, del presente articolo. Con decorrenza dal 1° gennaio 1979 in sede di rinnovo contrattuale saranno stabilite norme per la graduale omogeneizzazione tra il trattamento economico e gli istituti normativi di carattere economico del personale degli ospedali psichiatrici pubblici e dei presidi e servizi psichiatrici e di igiene mentale pubblici e il trattamento economico e gli istituti normativi di carattere economico delle corrispondenti categorie del personale degli enti ospedalieri.

Art. 8 Infermi già ricoverati negli ospedali psichiatrici.

Le norme di cui alla presente legge si applicano anche agli infermi ricoverati negli ospedali psichiatrici al momento dell'entrata in vigore della legge stessa. Il primario responsabile della divisione, entro novanta giorni dalla entrata in vigore della presente legge, con singole relazioni motivate, comunica al sindaco dei rispettivi comuni di residenza, i nominativi dei degenti per i quali ritiene necessario il proseguimento del trattamento sanitario obbligatorio presso la stessa struttura di ricovero, indicando la durata presumibile del trattamento stesso. Il primario responsabile della divisione è altresì tenuto agli adempimenti di cui al quinto comma dell'articolo 3. Il sindaco dispone il provvedimento di trattamento sanitario obbligatorio in condizioni di degenza ospedaliera secondo le norme di cui all'ultimo comma dell'articolo 2 e ne dà comunicazione al giudice tutelare con le modalità e per gli adempimenti di cui all'articolo 3. L'omissione delle comunicazioni di cui ai commi precedenti determina la cessazione di ogni effetto del provvedimento e configura, salvo che non sussistano gli estremi di un delitto più grave, il reato di omissione di atti di ufficio. Tenuto conto di quanto previsto al quinto comma dell'articolo 7 e in temporanea deroga a quanto disposto dal secondo comma dell'articolo 6, negli attuali ospedali psichiatrici possono essere ricoverati, sempre che ne facciano richiesta, esclusivamente coloro che vi sono stati ricoverati anteriormente alla data di entrata in vigore della presente legge e che necessitano di trattamento psichiatrico in condizioni di degenza ospedaliera.

Art. 9 Attribuzioni del personale medico degli ospedali psichiatrici.

Le attribuzioni in materia sanitaria del direttore, dei primari, degli aiuti e degli assistenti degli ospedali psichiatrici sono quelle stabilite, rispettivamente, dagli articoli 4 e 5 e dall'articolo 7 del decreto del Presidente della Repubblica 27 marzo 1969, n. 128.

Art. 10 Modifiche al codice penale.

Nella rubrica del libro III, titolo I, capo I, sezione III, paragrafo 6 del codice penale sono soppresse le parole: "di alienati di mente". Nella rubrica dell'articolo 716 del codice penale sono soppresse le parole: "di infermi di mente o".

Nello stesso articolo sono soppresse le parole: "a uno stabilimento di cura o".

Art. 11 Norme finali.

Sono abrogati gli articoli 1, 2, 3 e 3-bis della legge 14 febbraio 1904, n. 36, concernente "Disposizioni sui manicomi e sugli alienati" e successive modificazioni, l'articolo 420 del codice civile, gli articoli 714, 715 e 717 del codice penale, il n. 1 dell'articolo 2 e l'articolo 3 del testo unico delle leggi recanti norme per la disciplina dell'elettorato attivo e per la tenuta e la revisione delle liste elettorali, approvato con decreto del Presidente della Repubblica 20 marzo 1967, n. 223, nonché ogni altra disposizione incompatibile con la presente legge. Le disposizioni contenute negli articoli 1, 2, 3, 4, 5, 6, 7, 8 e 9 della presente legge restano in vigore fino alla data di entrata in vigore della legge istitutiva del servizio sanitario nazionale. Fino a quando non si provvederà a modificare, coordinare e riunire in un testo unico le disposizioni vigenti in materia di profilassi internazionale e di malattie infettive e diffusive, ivi comprese le vaccinazioni obbligatorie, sono fatte salve in materia di trattamenti sanitari obbligatori le competenze delle autorità militari, dei medici di porto, di aeroporto e di frontiera e dei comandanti di navi o di aeromobili.

La presente legge entra in vigore il giorno successivo a quello della sua pubblicazione nella Gazzetta Ufficiale della Repubblica.

Data a Roma, addì 13 maggio 1978

Leone - Andreotti - Bonifacio - Anselmi

Visto, il Guardasigilli: Bonifacio

STRALCIO DELLA LEGGE 833/1978

TITOLO III

Norme transitorie e finali

Art. 64 - Norme transitorie per l'assistenza psichiatrica.

La regione nell'ambito del piano sanitario regionale, disciplina il graduale superamento degli ospedali psichiatrici o neuropsichiatrici e la diversa utilizzazione, correlativamente al loro rendersi disponibili, delle strutture esistenti e di quelle in via di completamento. La regione provvede inoltre a definire il termine entro cui dovrà cessare la temporanea deroga per cui negli ospedali psichiatrici possono essere ricoverati, sempre che ne facciano richiesta, coloro che vi sono stati ricoverati anteriormente al 16 maggio 1978 e che necessitano di trattamento psichiatrico in condizioni di degenza ospedaliera; tale deroga non potrà comunque protrarsi oltre il 31 dicembre 1980 . Entro la stessa data devono improrogabilmente risolversi le convenzioni di enti pubblici con istituti di cura privati che svolgano esclusivamente attività psichiatrica . È in ogni caso vietato costruire nuovi ospedali psichiatrici, utilizzare quelli attualmente esistenti come divisioni specialistiche psichiatriche di ospedali generali, istituire negli ospedali generali divisioni o sezioni psichiatriche e utilizzare come tali divisioni o sezioni psichiatriche o sezioni neurologiche o neuro-psichiatriche. La regione disciplina altresì con riferimento alle norme di cui agli articoli 66 e 68, la destinazione alle unità sanitarie locali dei beni e del personale delle istituzioni pubbliche di assistenza e beneficienza (IPAB) e degli altri enti pubblici che all'atto dell'entrata in vigore della presente legge provvedono, per conto o in convenzione con le amministrazioni provinciali, al ricovero ed alla cura degli infermi di mente, nonché la destinazione dei beni e del personale delle amministrazioni provinciali addetto ai presidi e servizi di assistenza psichiatrica e di igiene mentale. Quando tali presidi e servizi interessino più regioni, queste provvedono d'intesa. La regione, a partire dal 1° gennaio 1979, istituisce i servizi psichiatrici di cui all'articolo 35, utilizzando il personale dei servizi psichiatrici pubblici. Nei casi in cui nel territorio provinciale non esistano strutture pubbliche psichiatriche, la regione, nell'ambito del piano sanitario regionale e al fine di costituire i presidi per la tutela della salute mentale nelle unità sanitarie locali, disciplina la destinazione del personale, che ne faccia richiesta, delle strutture psichiatriche private che all'atto dell'entrata in vigore della presente legge erogano assistenza in regime di convenzione, ed autorizza, ove necessario, l'assunzione per concorso di altro personale indispensabile al funzionamento di tali presidi. Sino all'adozione dei piani sanitari regionali di cui al primo comma i servizi di cui al quinto comma dell'articolo 34 sono ordinati secondo quanto previsto dal D.P.R. 27 marzo 1969, n. 128 , al fine di garantire la continuità dell'intervento sanitario a tutela della salute mentale, e sono dotati di un numero di posti letto non superiore a 15. Sino all'adozione e di provvedimenti delegati di cui all'art. 47 le attribuzioni in materia sanitaria del direttore, dei primari, degli aiuti e degli assistenti degli ospedali psichiatrici sono quelle stabilite, rispettivamente, dagli artt. 4 e 5 e dall'art. 7, D.P.R. 27 marzo 1969, n. 128 . Sino all'adozione dei piani sanitari regionali di cui al primo comma i divieti di cui all'art. 6 del D.L. 8 luglio 1974, n. 264 , convertito, con modificazioni, nella L. 17 agosto 1974, n. 386, sono estesi agli ospedali psichiatrici e neuropsichiatrici dipendenti dalle IPAB o da altri enti pubblici e dalle amministrazioni provinciali. Gli eventuali concorsi continuano ad essere espletati secondo le procedure applicate da ciascun ente prima dell'entrata in vigore della presente legge. Tra gli operatori sanitari di cui alla lettera i) dell'art. 27, D.P.R. 24 luglio 1977, n. 616 , sono compresi gli infermieri di cui all'art. 24 del regolamento approvato con R.D. 16 agosto 1909, n. 615 . Fermo restando quanto previsto dalla lettera a) dell'art. 6 della presente legge la regione provvede all'aggiornamento e alla riqualificazione del personale infermieristico, nella previsione del superamento degli ospedali psichiatrici ed in vista delle nuove funzioni di tale personale nel complesso dei servizi per la tutela della salute mentale delle unità sanitarie locali. Restano in vigore le norme di cui all'art. 7, ultimo comma, L. 13 maggio 1978, n. 180

Controcanto - Mario Tobino e la controversia con Basaglia

«I novatori social-psichiatrici».

(Per le antiche scale, 1982, Arnoldo Mondadori Editore)

Così, con questo linguaggio sorpassato e con evidente fastidio, Mario Tobino – psichiatra e scrittore che esercita nei manicomi dal 1939 al 1980 - chiama gli psichiatri che sostengono le proposte di Franco Basaglia e di Psichiatria Democratica.

Tobino rappresenta – di fatto - il controcanto alla rivoluzione basagliana e della Legge n. 180, controcanto che cerchiamo di far emergere analizzando la controversia con Franco Basaglia, che, nel 1978, si sviluppa sui quotidiani La Nazione e Paese Sera.

Alla fine del testo si trovano una Nota Biografica, una Bibliografia e le Note, che permettono di leggere le esatte parole usate da Tobino e da Basaglia.

LA CONTROVERSIA

Tra i due psichiatri, a pochi giorni dalla approvazione della Legge 180, si svolge una discussione pubblica, molto dura, dipanata sulla stampa in tre articoli: Lasciateli in pace, il manicomio è la loro casa, scritto da Tobino e pubblicato il 18 aprile su La Nazione; una intervista di Paese sera a Basaglia, Magliano, le false donne (4 maggio 1978); Dolorosa follia, ho udito la tua voce, di nuovo su La Nazione, 7 maggio.

(Ringraziamo la Fondazione Mario Tobino che ha messo a disposizione - dai propri archivi - le immagini dei tre articoli linkate sopra).

LASCIATELI IN PACE

Lasciateli in pace nasce dai dubbi sulla legge 180 e sulla presumibile difficoltà nel metterla in atto, preoccupazioni condivise con alcuni medici e paramedici di Maggiano. Il contenuto rilevante è nella seconda parte dell’articolo, nel dialogo tra lo psichiatra e l’infermiere Scipioni, in cui si enunciano i principi della carità continua e dell’assistenza amorevole, senza sosta, verso i malati e verso le loro esigenze. Scipioni si fa rappresentante dei timori sulla abolizione degli ospedali psichiatrici, decretata dalla legge in procinto di essere approvata.

La preoccupazione di Scipioni – e di Tobino, che sembra parlare attraverso l’infermiere – è per il destino dei tanti malati. Soprattutto quelli anziani e soli, che hanno vissuto per anni nel manicomio di Lucca e che – una volta dimessi per decreto – non avrebbero un posto dove andare. Per loro non ci sarebbe nessuna famiglia ad accoglierli, sarebbero lasciati all’abbandono e allo scherno, se non alla violenza, del mondo “libero”.

In sostanza, Tobino difende l’istituzione manicomiale come luogo di cura e di protezione per i malati di mente; una casa, per loro che una casa “fuori” non avrebbero più. È l’appello di un medico che ha vissuto tra i matti e per i matti, che adotta un criterio morale con al primo posto la dignità e l’individualità complessa di ogni singolo malato.

UNA RISPOSTA POLITICA

La risposta di Basaglia su Paese sera è durissima, quasi violenta, su un registro completamente diverso da quello di Tobino: egli accusa Tobino di ostacolare il progresso della psichiatria, di puntare sulla dimensione emotiva[1], di essere lui stesso demagogico e sprezzante quando definisce la nuova linea della psichiatria demagogia e moda.

In questa intervista, Basaglia attacca violentemente la psichiatria tradizionale e manicomiale, che ritiene essere al servizio del potere per controllare le persone emarginate, e accusa Tobino di essere al servizio del potere[2] con il suo articolo.

Il suo discorso è di carattere politico: Franco Basaglia sostiene[3] che carità continua e aspetto umano non abbiano alcun significato e che Tobino non affronti il discorso politico che sta dietro al tema della chiusura dei manicomi; egli oppone - alla dignità dell’individuo di cui parla Tobino – la dimensione antropologica molto più ampia, teoretica, della dignità dell’uomo[4]; nega la possibilità di dialogare con le posizioni altre, perché lo ritiene inutile e impossibile[5], nell’ottica di distruggere il potere.

A conclusione dell’intervista, denigra l’avversario per minarne l’autorevolezza, attaccando il romanzo Le libere donne di Magliano[6] che, a suo avviso, contiene solo falsità[7].

L’ULTIMO ATTO, TOBINO RISPONDE SULLO STESSO PIANO

Mario Tobino non può esimersi dal controbattere alle accuse di Basaglia e lo fa 3 giorni dopo, sul quotidiano toscano La Nazione, con l’articolo intitolato Dolorosa follia, ho udito la tua voce.

La controrisposta non è più né aneddotica né di piglio letterario, ma calata nello spazio analitico, teorico e metodologico. [8]

Dopo un breve preambolo di deviazione dei colpi diretti alla sua persona, va diritto ai punti che gli premono: la realtà di manicomi ben diversi dalle prigioni; l’effettiva esistenza della follia [9]; l’inopportunità della chiusura dei manicomi.

In risposta alla ideologizzazione del concetto di manicomio - prigione, Tobino ricorda che le esperienze “liberalizzanti” di Gorizia, di Colorno e di Trieste – dove ha operato Basaglia - non sono le uniche in Italia, ma ne esistono altre, altrettanto “aperte” e innovative; che lo stesso manicomio di Lucca[10] fu tra i primi ad aprirsi; che, a Lucca, i matti sono trattati con attenzione alle singole esigenze, sono liberi e girano tranquillamente, giocano a carte, lavorano allo spaccio, fanno riparazioni, sostituiscono i custodi.

Tobino ricorda - e fa appello alla memoria dello stesso Basaglia – le manifestazioni della follia, i deliri, le urla e le violenze; reali, innegabili, spesso difficilmente controllabili; la follia, secondo Tobino è questa, non la si può dimenticare.

Ed è solo grazie alla nuova chimica, all’alleanza con gli psicofarmaci[11], che si danno questi progressi: senza di essi non sarebbe stato possibile né controllare la follia – pur sopprimendo[12] una parte della personalità dei malati – né aprire i manicomi.

È l’ultimo tema, quello della chiusura dei manicomi[13], su cui Tobino pone l’accento più accorato e pone le domande critiche: dove andranno i malati che da anni vivono nei manicomi e che non hanno un luogo dove andare? Come saranno assistiti sul territorio dove le strutture ipotizzate dalla Legge non esistono, dove i reparti psichiatrici negli ospedali avranno al massimo 15 posti?

Di fatto, Tobino, affronta in modo esplicito la dimensione politica della follia e ne sottolinea l’esistenza puntuale, sociale e contestuale, chiamando in causa la fragilità dei dispositivi della Legge 180, l’impreparazione del tessuto sociale e la necessità di un posto per questi malati, di sapere che c’è un luogo adatto alla follia, seppure mascherata dalla chimica.

UNA ANALISI DELLA CONTROVERSIA

Ci sono elementi, tra quelli che emergono dalla controversia, per i quali si può intravedere una possibilità di conciliazione. È il caso della cancellazione dei trattamenti coercitivi e segreganti dei soggetti psichiatrici e dell’apertura nei confronti della società e della quotidianità, che sembrano essere obiettivi comuni a entrambi gli psichiatri.

Entrambi, inoltre, sembrano essere su una linea simile sulla modalità di gestione dei pazienti non più internati: Basaglia parla di diffusione della cura sul territorio, di somministrazione delle cure vicino a dove stanno i malati, di reinserimento; Tobino ipotizza l’ospedale come luogo di riferimento[14] per il malato; entrambi coinvolgono i pazienti in attività costruttive di laboratorio o di lavoro socialmente utile.

Nel focalizzare i principi, i criteri morali, che stanno alla base di questa etica della psichiatria, si possono trovare alcuni medesimi fondamentali: l’attenzione al malato, la cura e non la repressione, l’occupazione come mezzo per restituire un senso del tempo e dell’utilità sociale, la libertà di scelta sul ricovero e sulla presenza nel luogo di cura, il rapporto con il tessuto sociale.

Invece, sul punto dell’esistenza o meno della follia, non è possibile una composizione della controversia: Tobino, seppure non escluda del tutto l’origine sociale, ha una visione organica, fisiologica della follia, e accusa[15] Basaglia di credere che la chiusura dei manicomi cancelli ogni traccia della follia. Basaglia, infatti, la nega e nello stesso tempo, ne attribuisce la creazione alla società malata, al potere, per rinchiudere i disallineati, i disturbatori dell’ordine e dello sfruttamento[16].

Altro punto di dissidio insanabile è il tema della presenza e della forma delle strutture di cura, che coinvolge anche la visione politica delle due posizioni: Tobino non prescinde dalla necessità di un luogo dove i matti possano trovare – per periodi lunghi o brevi, più o meno volontariamente, in modo comunque aperto – riparo, protezione, cura e tranquillità[17]; e sottolinea l’assenza di preparazione dei territori, della popolazione e delle famiglie per la trasformazione dalle strutture accentrate a quelle diffuse; Basaglia, al contrario, non transige, insiste sulla necessità di distruggere l’istituzione manicomiale[18] e ribadisce la necessità della riforma, da farsi subito, in nome della «crescita politica, e quindi civile e culturale del paese».

VINCITORI

A volte le controversie scientifiche hanno un vincitore (come tra Pasteur e Pouchet[19], a metà del XIX secolo), a volte nessuno, a volte vincitori e vinti, ben oltre i contendenti.

In questo caso, la “vittoria” arride a Basaglia e alle proposte di Psichiatria Democratica[20], che vedono il parlamento prendere atto del lavoro fatto[21] e varare la legge 13 maggio 1978, n. 180.

Oltre che dalla condizione di possibilità fornita dai farmaci, questa vittoria è stata decretata:

- dal fatto che il progetto di riforma della psichiatria è nato e cresciuto nel mezzo degli anni ’70[22], in un contesto con cui condivideva lo stile di pensiero[23], il linguaggio[24] e le forme di espressione;

- dall’abilità degli innovatori nell’arruolare le forze politiche usando – appunto – concetti evocativi irrinunciabili in quegli anni: libertà dalle costrizioni, distruzione delle istituzioni, lotta contro il potere; e evocando la lotta anche contro chi resiste all’innovazione[25].

- dalla leva su elementi motivazionali anch’essi parte integrante della cultura rivoluzionaria di quegli anni, come il senso di colpa della “società”, rea della creazione e dell’espulsione della follia e dei folli[26].

ALTRI VINCITORI E MOLTI PERDENTI

Alla lunga, hanno vinto, dopo 20-30 anni, tutte le persone colpite da problemi psichiatrici – depressione, psicosi, schizofrenia – che hanno guadagnato il diritto a essere curati restando, almeno in parte, all’interno del proprio tessuto sociale (grazie al duro lavoro di chi quella legge[27] ha voluto interpretare e attuare e grazie alla diffusione e alla messa a punto dei farmaci antipsicotici).

Hanno perso, invece, i matti che vivevano dentro ai manicomi, progressivamente espulsi, poiché – scrivono Corbellino e Jervis nel 2008 – l’impossibilità di nuovi ricoveri negli ospedali psichiatrici genera una drammatica situazione di mancata assistenza per i malati critici[28].

Hanno perso anche le famiglie dei ricoverati e dei nuovi malati che, a causa della fretta della rivoluzione e dell’assenza di reali alternative alla struttura psichiatrica, si trovano sulle spalle tutto il carico della gestione, i sacrifici e le tragedie[29].

Hanno perso, più di tutti, alcune centinaia di malati che – dimessi dal manicomio – sono morti per suicidio o accidentalmente, per incapacità di vivere in un mondo ad essi ormai sconosciuto.

Dice lo psichiatra Cherubino Trabucchi[30] che si tratta di duemila – tremila persone.

MARIO TOBINO, NOTA BIOGRAFICA

Mario Tobino nasce a Viareggio nel 1910, si laurea in medicina nel 1936 e prende la specializzazione in clinica delle malattie nervose e mentali nel 1941, con una tesi sulla necessità di una rifondazione umanizzante della psichiatria contemporanea.

Esercita come psichiatra nei manicomi dal 1939 al 1980: ad Ancona, a Gorizia e a Firenze San Salvi (1939-1940), dal 1941 al 1980 nell’ospedale psichiatrico di Maggiano, in provincia di Lucca, dal 1948 come primario del reparto femminile. Nel 1944 partecipa alla guerra partigiana. Vive all’interno del manicomio – nelle stanze dei medici – fino quasi alla morte (1991).

La scrittura contende alla psichiatria il ruolo di principale occupazione. Dalla prima raccolta di poesie del 1934 a Una vacanza romana del 1992, Tobino pubblica 4 raccolte di poesie e 23 romanzi e raccolte di racconti. Di questi, almeno 4 sono incentrati sull’esperienza psichiatrica a Maggiano: Le libere donne di Magliano, Per le antiche scale (Premio Campiello 1972), Gli ultimi giorni di Magliano, Il manicomio di Pechino (Premio Strega 1990).

BIBLIOGRAFIA

M. Tobino, Lasciateli in pace, il manicomio è la loro casa, La Nazione, 18 aprile 1978

F. Basaglia, Magliano: Le false donne, Paese sera, 4 maggio 1978

M. Tobino, Dolorosa follia, ho udito la tua voce, La Nazione, 7 maggio 1978

M. Tobino, Le libere donne di Magliano, Arnoldo Mondadori Editore, 1963

M. Tobino, Per le antiche scale, Arnoldo Mondadori Editore, 1972

M. Tobino, Gli ultimi giorni di Magliano, Arnoldo Mondadori Editore, 1982; Ed. del 2019, Mondadori Libri

M. Tobino, Il manicomio di Pechino, Mondadori, 1990

health, volume 14, 1985, issues 1 and 2, The Unfinished Revolution in Italian Psychiatry: An International Perspective

https://doi.org/10.1080/

G. Corbellino - G. Jervis, La razionalità negata: psichiatria e antipsichiatria in Italia, Bollati-Boringhieri, 2008

F. Basaglia, F. Ongaro, A. Pirella, S. Taverna, La nave che affonda, Cortina, 2008

V. Furlanetto, Cento giorni che non torno – Storie di pazzia, di ribellione e di libertà, Laterza, 2024

V. Andreoli, Fratelli di Carmelo Samonà: il matto in casa, in Il matto di carta. La follia nella letteratura, BUR, 2008

S. Redaelli, Circoscrivere la follia, Mario Tobino, Alda Merini, Carmelo Samonà, Sub Lupa Academic Publishing, Warsaw, 2013

NOTE

[1] Basaglia parla di «equivoca pietà» e di «agire emotivo» (Magliano: Le false donne, Paese sera, 4 maggio 1978)

[2] «il suo scritto rende un grosso servizio al potere, su questo non si può discutere» (Cit.)

[3] «Tobino parla “di carità continua e aspetto umano”. Quale significato hanno oggi queste espressioni? Nessuno. Il discorso è politico e Tobino non lo affronta. Anzi, finge di non affrontarlo poiché tutta l’impostazione del suo articolo è politicizzata al massimo» (Cit.)

[4] «la dignità dell’uomo, di tutti gli uomini» (Cit.)

[5] «instaurare un dialogo comune, generale […] impresa impossibile poiché l’istituzione che vogliamo distruggere è il potere stesso e nessuno rinuncia senza lottare al suo potere» (Cit.)

[6] Romanzo che lo stesso Basaglia, in gioventù, aveva amato e considerato una sorta di trattato psichiatrico (cfr. Magliano: Le false donne, Paese sera, 4 maggio 1978

[7] «a Gorizia […] ho potuto verificare ogni cosa, controllare ogni sensazione. Era tutto falso» (Cit.)

[8] «non ho potuto non sorridere quando ho letto che sarei strumento del dominante potere. Da quasi quarant'anni vivo al manicomio di Lucca e in verità mai sono stato in relazione, a contatto con chi comanda, chi è dominante. Per anni e anni la mia vita si è svolta in compagnia dei malati; adesso la mattina il primo dialogo lo faccio allo spaccio, al loro spaccio, dove vado a prendere il caffè e poi ancora durante la giornata. Nel dopopranzo sono solito passeggiare qui intorno e molto spesso con malati mi accompagno, malati liberi, che se la girano tranquillamente. La sera, dopo cena, quante volte ho giocato con loro a carte e, lo giuro, mai, mai abbiamo insieme trescato col potere, mai ordimmo per difenderlo» (Dolorosa Follia, ho udito la tua voce, La Nazione, 7 maggio 1978)

[9] Come già visto, in tutta la sua produzione Mario Tobino usa in modo diretto i termini follia, malattia mentale, matto/matti, lasciando poco spazio agli eufemismi; da una parte può essere un retaggio del periodo in cui ha studiato ed esercitato, dall’altra possiamo considerarlo un modo per non dimenticare di cosa si parla in termini comuni.

[10] Tobino definisce l’ospedale psichiatrico di Maggiano «libero e umano» e ricorda che «con entusiasmo […] fummo tra i primi a tirare giù i muri di cinta, strappare le inferriate, aprire, dare luce» (M. Tobino, Dolorosa follia, ho udito la tua voce, La Nazione, 7 maggio 1978)

[11] «nel 1952, arrivarono gli psicofarmaci che riescono a velare, a intorpidire, a rendere apparentemente molli molti segni della pazzia» (Cit.);

[12] «Sono stati gli psicofarmaci a rivoluzionare i manicomi e non le loro teste. E nemmeno si domandano se la follia loro la conoscono, se ne saprebbero distinguere il volto, loro che l'hanno frequentata soltanto dopo l'avvento degli psicofarmaci, se ne sanno la violenza, la fantasia, l'orrore, l'inesprimibile immacolatezza, l'impenetrabile lutto. E neppure amano conoscere, per nulla sono ansiosi di valutare di quanto con i composti chimici la follia è stata offuscata, travestita, mascherata (ma non vinta); e a volte costretta a brancolare.

Neppure sorge loro l'inquietante interrogativo, l'as-sillo morale, se è giusto con gli psicofarmaci ottundere la personalità, arginare, imbavagliare, legare una delle più profonde, meravigliose, misteriose manifestazioni umane: la follia.» (Gli ultimi giorni di Magliano, p. 20)

[13] « fuori, come gli andrebbe? I cittadini, che hanno da lavorare, che trascinano i loro affanni, li ascolterebbero, li sopporterebbero? I cittadini debbono essere sensibilizzati ma io finora di questa sensibilizzazione non ho visto nessun progresso, se anche non è aumentato il sospetto» (M. Tobino, Dolorosa follia, ho udito la tua voce, La Nazione, 7 maggio 1978)

[14] «[Un luogo] dove ritornare, rifarsi vedere, venire […] a prendere le cure, […] un luogo dove si entra e si esce tranquillamente» (Cit.)

[15] «io credo che la follia esista e Basaglia invece mi pare che sia convinto che, chiusi i manicomi, svanisca la cupa malinconia, l’architettura della paranoia, le catene delle ossessioni» (Cit.)

[16] «La follia non esiste, non è mai esistita. Sono stati la Società, il Potere a crearla [...] hanno eretto i manicomi per rinchiudere chi disturbava il loro sfruttamento [...]» (F. Basaglia, F. Ongaro, A. Pirella, S. Taverna, La nave che affonda, Cortina, 2008)

[17] Tobino è autore, nel 1958 in tempi non sospetti, insieme a due giovani architetti, di un progetto di «un futuro ospedale psichiatrico, un ospedale per matti in armonia con le vicende dei savi, un istituto che avesse, dopo le sequele di cattiverie, dopo tanto sangue versato, un grano, appena un grano di più di bontà e tolleranza» (Gli ultimi giorni di Magliano, ed. 2019, p. 206); per avere un’idea del progetto: Mappe del progetto per l'Ospedale di Vicenza (Mario Tobino, Giorgio Ramacciotti, Piero Marello) (MTb.II.30.41), Mostre Virtuali Ficlit, #3508

[18] «I manicomi […] noi diciamo che si possono distruggere e lo abbiamo dimostrato in anni di lotta» (F. Basaglia, Magliano: Le false donne, Paese sera, 4 maggio 1978)

[19] Cfr. H.M. Collins, T. Pinch, Il Golem, Tutto quello che dovremmo sapere sulla scienza, Edizioni Dedalo, 1995

[20] https://it.wikipedia.org/wiki/Psichiatria_Democratica, https://www.psichiatriademocratica.org/

[21] «Sono perciò soddisfatto che il Parlamento abbia preso ufficialmente atto della lotta di questi anni» (F. Basaglia, Magliano: Le false donne, Paese sera, 4 maggio 1978)

[22] Cfr. Franco Basaglia e la legge 180: frammenti dello scenario sociale e politico, Controversie, 4 dicembre 2024

[23] Cfr. L. Fleck, Genesi e sviluppo di un fatto scientifico : per una teoria dello stile e del collettivo di pensiero, Il Mulino, 1983; L. Fleck, Stili di pensiero, La conoscenza scientifica come creazione sociale, a cura di F. Coniglione, Mimesis Edizioni, 2019

[24] scrive Tobino: «Si indicono di continuo le riunioni - qualsiasi scusa è buona - alle quali debbono assistere medici, infermieri e anche malati di mente […] Nelle riunioni si rimuginano le prossime salutari innovazioni, ciò che si è in procinto di operare per il trionfo della giustizia, lo smascheramento del Potere, la liberazione degli schiavi, dei martiri», (Gli ultimi giorni di Magliano, p. 19)

[25] «Tutti hanno paura: sanno che il potere, quello politico in primo luogo - quello che in molti casi li ha fatti assumere nell'ospedale -, è con la 180, e con questo i mezzi di comunicazione» (M. Zappella, Introduzione a Gli ultimi giorni di Magliano, ed. 2019)

[26] «La follia non esiste, non è mai esistita. Sono stati la Società, il Potere a crearla [...] hanno eretto i manicomi per rinchiudere chi disturbava il loro sfruttamento [...]» (Paese sera, Cit.)

[27] La legge n. 180 e il suo successivo incoroporamento nella legge istitutiva del Servizio Sanitari Nazionale, Legge 23 dicembre 1978, n. 833.

[28] «La nuova legge rendeva immediatamente illegale ogni nuovo ricovero negli ospedali pubblici […] fattore principale che causò […] una drammatica – e talora tragica – carenza di assistenza per i nuovi pazienti affetti da disturbi mentali acuti e gravi» (G. Corbellino – G. Jervis, La razionalità negata: psichiatria e antipsichiatria in Italia, Bollati-Boringhieri, 2008)

[29] «gran parte del carico fu sostenuto dalle famiglie dei pazienti con grandissimi sacrifici e non poche vere tragedie» (Cit.)

[30] Gli ultimi giorni di Magliano, p. 258

Investire sulla relazione e sugli operatori - Intervista a Raffaella Bricchetti

L: Buongiorno Dott.ssa Bricchetti.

R: Buongiorno a Lei

L: Vorrei iniziare questa nostra chiacchierata chiedendole anzitutto se ci potesse raccontare qualcosa di Lei, di cosa fa. Per poter introdurre meglio i lettori nel vivo dell’intervista

R: Certo. Dunque, chi sono e cosa faccio... Sono laureata in filosofia specializzata in psicologia alla facoltà di Lettere e Filosofia con indirizzo psicologico all’Università Statale di Milano perché ai miei tempi le facoltà di psicologia erano solo a Padova e a Roma e non avendo la possibilità di andare a Padova per mille motivi familiari ho intrapreso questa strada. Laureata mi sono iscritta alla specializzazione e sono stati altri quattro anni. Ricordo tra i miei docenti anche il Dottor Musatti[1]. Nel frattempo, sia per la prima tesi, quella di facoltà, che per la tesi di specializzazione, avevo contattato il dottor Erba[2], che ai tempi lavorava al Paolo Pini (manicomio cittadino per eccellenza ai tempi) come psichiatra.

L: Ecco Dottoressa Bricchietti, può raccontarci per la sua esperienza la realtà manicomiale Italiana prima del 1978? Qual era il vero tessuto quotidiano dell’esperienza d’esser folli e del tentare di curare e lenire?

R: Certamente, come le dicevo ho conosciuto Erba nel ’74 e insieme abbiamo fatto la prima tesi (quella di facoltà) analizzando moltissimi casi di persone che arrivavano in manicomio. Persone con delle storie psichiatriche assolutamente incredibili, “gli alienati”. Persone che non potevano essere considerate soggetti, ma erano considerate semplicemente dei reietti che dovevano essere controllati, sedati, repressi perché creavano scompiglio all’interno della società. Ricordo in manicomio, ad esempio, quest’uomo di nome Luciano che era comunque una persona molto degna, non saprei come altro definirla, sempre vestito bene con camicia e giacca, mai sciatto o trasandato, di una famiglia modesta che dall’età di 15 anni l’aveva mandato in manicomio perché era un “masturbatore compulsivo”. Lui si masturbava sempre, continuamente, anche in manicomio poi lo faceva perché in realtà diciamocelo, cosa diavolo aveva da fare di meglio?! E così lui era lì da sempre.

Ai tempi i manicomi erano dei luoghi di contenimento perché queste persone venivano prese e lì stavano. Mi ricordo anche Angela, che è stata anche uno dei capitoli della mia tesi; quando l'abbiamo presa in considerazione era arrivata al centocinquantesimo ricovero. Lei entrava, stava dentro due giorni, si rifocillava un po' e poi se ne andava. Le porte le venivano riaperte sempre perché era una donna giovane di nessuna pericolosità né per sé né per gli altri... era molto bizzarra quello sì. Mi è capitato di rivederla poi dopo la chiusura del reparto psichiatrico e mi prese in giro dicendomi “ma guarda io ti ho vista che eri grande così!” Ecco, c'erano anche questi personaggi che andavano e venivano in questo reparto molto aperto. Faccia conto che in Italia ai tempi c’erano 98 manicomi con 100mila persone dentro. La cosa che colpì di più Basaglia quando entrò nell’ospedale di Gorizia fu “l’odore di morte e di piscio”, che è vero perché l’odore di morte e di piscio caratterizzava tutto.