Ecologie delle evidenze in vaccinovigilanza: quali esperienze (non) si trasformano in conoscenza?

Le pratiche vaccinali sono generalmente rappresentate nei discorsi pubblici, nelle discussioni mediatiche, ma anche nei documenti ufficiali nazionali e sovranazionali, come una delle forme di tutela della salute pubblica più sicure ed efficaci. Vero e proprio emblema del successo biomedico – sino a diventarne spesso una metonimia - le vaccinazioni operano “salvando innumerevoli vite” (Ministero della Salute della Repubblica Italiana, 2023:4) e assicurando un rapporto “rischi/benefici particolarmente positivo” (ivi: 10). La sicurezza, in particolare, sarebbe garantita da un sistema di vaccinovigilanza, anche post-marketing, particolarmente efficiente: esso si articola attorno a complessi apparati burocratico-amministrativi che coinvolgono molteplici infrastrutture e soggetti diversificati.

Secondo le indicazioni dell’OMS, infatti, ogni AEFI (Adverse Event Following Immunization) – ossia qualsiasi episodio sfavorevole verificatosi dopo la somministrazione di un vaccino, non necessariamente causato dal vaccino stesso – andrebbe riportato al sistema di sorveglianza preposto.

SEGNALAZIONI DI AEFI IN ITALIA: TRA SICUREZZE E CRITICITA’

In Italia, l’organo deputato a questa sorveglianza è la Rete Nazionale di Farmacovigilanza (RNF), connessa, da una parte, al SSN (Sistema Sanitario Nazionale) e, dall’altra, alle reti di farmacovigilanza sovranazionali. Solo in seguito alla segnalazione, l’AIFA (Agenzia Italiana del Farmaco) è tenuta a valutare la possibile correlazione causale tra l’AEFI e la vaccinazione somministrata. Tuttavia, in Italia, la RNF è un sistema di segnalazione passivo, nel senso che la segnalazione è volontaria. Per cui i medici, così come i cittadini, possono inserire spontaneamente un AEFI sul sito dell’AIFA. La vaccinovigilanza strutturata in questo modo permetterebbe di “raccogliere, monitorare e investigare continuamente l’eventualità di eventi avversi (anche imprevedibili) ed è in grado di rilevare anche potenziali segnali di allarme, utili a rivalutare il rapporto beneficio/rischio del vaccino e a gestire gli eventuali rischi per la salute” (ivi: 14).

In quanto processi socio-culturali complessi, tuttavia, queste pratiche meritano di essere esplorate in profondità, tenendo in considerazione anche i discorsi che ne evidenziano limiti e lacune e che, spesso, sono frettolosamente derubricati come “no-vax” o “anti-vax”. Prendere in considerazione tali discorsi è un passo fondamentale non solo per comprendere come sfiducia e diffidenza possano generarsi proprio all’interno di quelle azioni di “vigilanza” che vorrebbero invece produrre affidabilità e sicurezza, ma anche perché gli sguardi critici si rivelano spesso essere strumenti utili per cogliere alcune antinomie intrinseche al sistema di produzione del sapere stesso.

VISSUTI IMMOBILIZZATI IN UN’ECOLOGIA DELLE EVIDENZE

Nel corso della ricerca etnografica che ho condotto sulle pratiche vaccinali e, in particolare, sul danno da vaccino (soprattutto in relazione all’età pediatrica, Lesmo 2024), alcune narrazioni tornavano, ostinate, a tormentare i racconti di molti genitori. “Allora dopo la seconda vaccinazione, proprio… è la catastrofe” mi ha raccontato una mamma. “Dopo che ha fatto il richiamo è cambiato tutto”, ha ricordato un’altra madre. Di narrazioni simili, rievocate con emozione da madri e padri, ne ho raccolte numerose. Nonostante ciò, un’unica famiglia aveva, faticosamente, segnalato “l’episodio sfavorevole” all’AIFA. La maggior parte degli altri genitori da me incontrati non era stata informata della possibilità di farlo in autonomia; in due casi i miei interlocutori ne acquisirono piena consapevolezza solo durante i nostri incontri. D’altra parte, i genitori si erano spesso rivolti ai pediatri evidenziando l’accadimento e, in almeno due situazioni, i medici avevano immaginato una possibile correlazione tra l’evento e le vaccinazioni. In nessuna di queste situazioni, tuttavia, l’evento era stato segnalato all’AIFA.

Perché?

Il senso di questi vuoti – questi passaggi mancati - non può restare sotto traccia. Renderli visibili diviene fondamentale perché permette di intercettare quei momenti in cui l’esperienza del singolo e il sistema volto a tradurre quest’ultima in un sapere condiviso non riescono a incontrarsi. Espulse e deviate verso traiettorie divergenti, le esperienze di alcuni soggetti non possono così contribuire alla produzione di una conoscenza di cui pure riconoscerebbero il valore (Lello, 2020). L’antropologo Charles Briggs (2016) ha definito “ecologie delle evidenze” quei processi per cui alcune esperienze individuali sono chiamate ad esistere all’interno del sapere scientifico, mentre altre ne sono rigettate, declassate “allo stato di ignoranza, superstizione, o patologia”, o finanche rese “impensabili” (ivi: 151). Quali ecologie delle evidenze vengono dunque attivate entro i processi di vaccinovigilanza, e specificamente nelle pratiche di segnalazione degli eventi avversi? Quali antinomie del sistema esse rendono manifeste?

CIRCOLARITA’ EPISTEMICHE

La maggior parte dei medici incontrati sul campo ha rilevato come, effettivamente, la segnalazione di eventi avversi non avvenga di frequente. Se alcuni tra loro attribuivano questa difficoltà all’onerosità di un tempo-lavoro da situarsi tra una crescente burocratizzazione della pratica medica e la conseguente compressione degli spazi clinici – con il rischio di una riduzione nella qualità dell’assistenza ai pazienti – altri processi sono emersi più spesso, sino a delineare un’ecologia delle evidenze specifica. Essa opera in due diverse – e paradossali – direzioni.

Da una parte, i medici incontrati hanno sottolineato come disturbi “benigni” o “quadri non gravi” (l’innalzamento della temperatura, l’irritabilità, le reazioni cutanee locali o le convulsioni febbrili…) fossero “già noti” o finanche “attesi”. In quanto tali, si riteneva superfluo segnalarli. “Ci sono eventi avversi previsti e non sono neanche considerabili tali” spiegava una dottoressa. Queste esperienze, pertanto, venivano immobilizzate all’esterno del sistema di rilevazione.

D’altra parte, un’eguale immobilità interessava alcuni disagi importanti occorsi nel periodo di somministrazione vaccinale - quali ad esempio disturbi neuro-muscolari o psicomotori severi. In questo caso, la motivazione alla base dell’esclusione era, paradossalmente, opposta a quella delineata in precedenza: dal momento che la letteratura medico-scientifica in questi casi aveva già escluso ogni possibile correlazione con le vaccinazioni, sarebbe stato superfluo segnalare l’evento.

In questo modo, tuttavia, ciò che avrebbe dovuto garantire una rivalutazione costante del rischio associato a possibili eventi avversi, veniva pre-determinato a priori dalle interpretazioni già esistenti in relazione al rischio stesso. Questa circolarità epistemica, a tratti paradossale, non affiorava in un vuoto epistemologico, ma si radicava entro una gerarchia delle evidenze ben consolidata nell’Evidence Based Medicine. I livelli di evidenza qui definiti, infatti, collocano tra le prove più attendibili le revisioni sistematiche di studi clinici randomizzati; all’opposto, le opinioni e le esperienze cliniche degli esperti si collocano alla base di simile costruzione piramidale (Oxford Centre for Evidence-Based Medicine). Tale gerarchia, profondamente interiorizzata dai medici da me incontrati, non consentiva ad osservazioni basate su singole esperienze cliniche di contravvenire quanto già sostenuto in letteratura e, dunque, neanche di ritenerlo manifesto al punto da doverlo/poterlo segnalare.

In questo modo, tuttavia, il sistema di sapere tendeva a riprodurre sé stesso riconfermando quanto già definito e dirottando – o immobilizzando - al suo esterno esperienze che avrebbero potuto contribuire a sollecitarne un riesame. Tali esperienze venivano così ricondotte - e ridotte – allo stato di banalità, ovvietà, ignoranza.

Già Foucault, in fondo, aveva rilevato come “l’esterno di una scienza è più e meno popolato di quanto non si creda” (Foucault, 2004:17), costellato da tutto ciò che ogni disciplina “respinge oltre i suoi margini” (ibidem). Tuttavia, per molti genitori da me incontrati, vedersi convergere a forza verso una simile esteriorità escludeva contemporaneamente ogni possibile credibilità di un sistema orientato, invece, a produrre fiducia: esso si trasformava piuttosto in fonte di sospetto e biasimo nelle istituzioni tutte e nei loro discorsi.

BIBLIOGRAFIA

Briggs, Charles, L. 2016. “Ecologies of evidence in a mysterious epidemic.” Medicine Anthropology Theory 3(2):149-162.

Foucault M., 2004, L'ordine del discorso e altri interventi, Torino: Einaudi.

Lello, E., 2020, “Populismo anti-scientifico o nodi irrisolti della biomedicina? Prospettive a confronto intorno al movimento free vax”, Rassegna Italiana di Sociologia, 3:479-507.

Lesmo, I., 2024, “Ecologie delle pratiche nella vaccinovigilanza italiana. Antinomie nel sapere vaccinale”, AM_Rivista della Società italiana di antropologia medica, 25(58):181-211,

Ministero della Salute della Repubblica Italiana, 2023, Piano nazionale Prevenzione Vaccinale PNPV 2023-2025.

Oxford Centre for Evidence-Based Medicine, https://www.cebm.ox.ac.uk/resources/levels-of-evidence/oxford-centre-for-evidence-based-medicine-levels-of-evidence-march-2009

Le teorie del complotto, quinta parte – Complottismo, positivismo, disincanto

È un caso che si giunga oggi a una demonizzazione – costruita a suon di meme così come di dibattito colto – della stessa capacità di esprimere un pensiero autonomo, senza delegare agli esperti di turno? Oppure questa demonizzazione ha una qualche attinenza, e coerenza, con processi storici ben più lunghi, che attengono alla storia stessa del capitalismo?

Da qui parte la quinta e ultima puntata del nostro viaggio, per arrivare a riflettere sulle strettoie in cui noi stessi rischiamo di ingabbiare la nostra capacità di pensiero critico quando la costringiamo nel solo solco del razionalismo scientifico. E, da qui, proviamo ad esplorare qualche nesso con il tema del disincanto del mondo, per come ne ha scritto S. Consigliere (in “Favole del reincanto”, DeriveApprodi 2020, da cui sono tratte le brevi citazioni seguenti). Quel disincanto che “ci fa preferire un uragano scientifico a un rifugio magico”, una frase che ogni volta mi fa venire in mente istintivamente la famosa scienziata (e senatrice a vita) che attacca duramente l’agricoltura biodinamica salvando però la scientificissima agroindustria a base di monoculture, pesticidi e manipolazioni genetiche. Quel disincanto che ci ha resi, come Occidentali, “i terminatori di un numero altissimo di mondi umani, di modi della conoscenza e forme della presenza”.

Eppure, segni di una nuova consapevolezza affiorano nelle battaglie contro l’estrattivismo, dai Salar dell’America Latina devastati dall’estrazione dei minerali per la transizione green, ai nostri Appennini, alla Sardegna intera, che resistono contro l’assalto delle speculazioni sull’eolico. Il nostro viaggio si chiude così proprio con un pensiero, che vuole essere anche una dedica, accorato e solidale con queste battaglie. Che se certo sanno parlare (giustamente) il linguaggio esperto/scientifico dei danni “quantificabili” apportati dai progetti estrattivi, dall’altra riescono a dare voce anche a dimensioni non quantificabili e però non meno cruciali, incarnando la difesa di territori che, più ancora che marginali e sacrificabili, vengono colpiti forse proprio perché rappresentano gli ultimi scogli da cui è possibile immaginare una vita non del tutto colonizzata dai tristi, disincantati miti della modernità egemone.

Chissà cosa si prova a liberare

La fiducia nelle proprie tentazioni

Allontanare gli intrusi dalle nostre emozioni

Allontanarli in tempo e prima di trovarsi solo

con la paura di non tornare al lavoro

F. de André, La bomba in testa, 1973

Quest’ultimo punto – l’enfasi sugli aspetti quantificabili che mette in ombra tutto il resto – a mio avviso è cruciale. E si allaccia all’ultima questione dirimente: il complottismo è, in fin dei conti, qualcosa da rivendicare (come fanno gli autori del Manifeste) o da problematizzare? Ognuno darà la sua risposta.

Personalmente, posti tutti i distinguo e le cautele di cui sopra – chi definisce cosa sia complottismo e cosa no, l’uso del complottismo come arma politica, il classismo, le bugie delle élite come terreno di coltura, etc. – tendo a pensare che l’anticomplottismo sia, a conti fatti, più nefasto del complottismo. Perché l’anticomplottismo si traduce in una difesa dell’indifendibile, mentre il complottismo porta in sé una salutare sfiducia e diffidenza verso le narrazioni del potere. E rappresenta il rifiuto di abdicare al tentativo di capire e darsi una ragione.

Anche perché, in fondo, i limiti del complottismo solo in parte sono responsabilità dei “complottisti” stessi. Non dovremmo scordarci che derivano, in buona misura, dal fatto che li abbiamo lasciati da soli a misurarsi con questioni di enorme complessità e rilevanza. Mentre chi avrebbe strumenti ed expertise – e responsabilità… – per scandagliare questi temi troppo spesso preferisce utilizzare quelle risorse per indagare campi meno controversi. Dove non si rischia di passare per complottisti e anzi è più semplice accordarsi alle sensibilità in voga nel clima di opinione del momento. Alimentando, però, la sensazione di autoreferenzialità e irrilevanza del sapere esperto e quindi la delegittimazione di cui poi ci si lamenta.

Questo non significa, però, non riconoscere – e anche qui l’autore di questo libro si muove in modo molto intelligente – le criticità e i problemi che il “complottismo”, come particolare modo di incanalare una potenziale opposizione al potere, pone, e che possono fargli mancare il bersaglio, o persino sviare e curvare il dissenso verso posizioni in fondo comode al potere. Che possono portare a non prendere consapevolezza del rapporto tra mezzi e fini, come testimoniato dall’abuso di tecnologia. A sopravvalutare personaggi che diventano incarnazioni di ogni male e d’altra parte a non vedere dove invece ci sono i veri nemici. Per questo è importante l’operazione che compie M. Amiech in questo libro, cioè superare narrazioni incentrate sulla drammatizzazione di casi o personaggi interpretati nella loro singolarità/straordinarietà per leggere e collocare invece i fatti contemporanei in continuità con processi storici più lunghi. Perché è solo lavorando in questa direzione che possiamo cercare di colmare quel vuoto e produrre interpretazioni teoriche capaci di orientare l’azione collettiva lungo direzioni credibili.

Particolarmente convincente, da questo punto di vista, è la riflessione, negli ultimi capitoli, sulla digitalizzazione come progetto industriale che va collocato in piena continuità con una storia del capitalismo che può e deve essere raccontata anche – sulla scorta di autori come Luxembourg, Illich, Lasch – come una storia di progressiva divisione e specializzazione del lavoro, crescente delega agli esperti e quindi crescente perdita di fiducia nelle proprie competenze: competenze nel costruirsi gli strumenti di lavoro, nel costruire una casa, nella manutenzione degli oggetti, fino al prepararsi il cibo e al prendersi cura della propria salute. Come una storia di progressiva perdita di autonomia e, di converso, di crescita della dipendenza degli individui dal mercato e dagli esperti per rispondere a ogni bisogno della vita. Ma se pensiamo al nostro punto di partenza possiamo vedere come quella spirale di sfiducia/ delega/dipendenza arrivi a coinvolgere, oggi, persino il bisogno di pensare: meglio evitare di farlo, ci sono gli esperti a cui delegare. In fondo, è proprio questo che si teorizza, quando l’idea che sia possibile pensare con la propria testa diventa hybris, e si arriva, come abbiamo visto, a sostenere la necessità di rinunciare a esercitare le proprie facoltà critiche – diventate ingannevoli e pericolose – per affidarci, proprio in nome della divisione del lavoro (scientifico e cognitivo), agli esperti semplicemente perché sono esperti, a scatola chiusa. E più non dimandare.

Ma forse la perdita di autonomia si spinge ancora più in là del pensare: arrivando a coinvolgere la sfera del sentire, la fiducia nelle proprie percezioni, l’ancoramento del soggetto alla realtà. Affascinanti, a questo proposito, le riflessioni del Manifeste (p. 22-25) a proposito dell’adozione di politiche, durante il Covid-19, che hanno costretto le persone a sospendere le loro attività e a chiudersi nell’isolamento, ma che le hanno anche precipitate in un regno dell’assurdo e del nonsense quotidiano con le mille regole, restrizioni e raccomandazioni che si contraddicevano tra loro giorno dopo giorno, evidenziando in questo qualcosa di più di mera casualità/ disordine legati alla circostanza, il cui effetto è farci perdere il filo di ogni certezza, farci dubitare della nostra presa sulla realtà, delle nostre percezioni elementari.[1] La stessa direzione cui ha condotto il chiederci di adottare uno sguardo statistico per guidare i nostri comportamenti (Ivi, p. 241-246). Il che è un nonsense in sé, visto che la statistica si basa necessariamente sulla distruzione della soggettività per costruire aggregati fittizi che hanno finalità di gestione e governo, e da quel livello non è dato tornare indietro, alla soggettività: che, all’opposto, è sempre incontro sensoriale del particolare col particolare, del soggettivo con il soggettivo, cioè esattamente quello che la statistica deve depurare per poter essere rappresentativa e generalizzabile. Solo individui deprivati di soggettività, intercambiabili, possono essere guidati dalla statistica. Ma in fondo, quando ci è stato chiesto di diventare insensibili di fronte agli anziani lasciati a morire da soli, senza congedo dai propri cari, e in alcuni momenti/Paesi senza nemmeno i riti dell’inumazione, mentre ci si estorceva un sentimento di compassione verso le cifre dei decessi riportate nei bollettini quotidiani, proprio questo ci è stato chiesto di fare: lasciare che altro si intrudesse tra noi e le nostre percezioni, fino ad adottare, al loro posto, uno sguardo statistico.

Un tema, questo, che si collega con un’ultima immagine particolarmente stimolante evocata da M. Amiech, che ci riporta ai limiti del complottismo: quest’ultimo visto come feticismo dei fatti e delle cifre portato all’estremo, come “positivismo impazzito”. Una critica, cioè, che si perde nello sparare disperato ed estenuante di dati e documenti da fonti sempre più difficilmente verificabili che, in fondo, deriva dal nostro stesso – “nostro” come movimenti, come sinistra antagonista nelle sue diverse anime, come studiosi più o meno militanti e prima ancora, semplicemente, come persone – aver idolatrato il razionalismo tanto da non saper vedere i pericoli derivanti dal porre la scienza al centro della politica. Ancora di più, tanto da non renderci conto della misura in cui abbiamo lasciato che la nostra capacità di critica venisse fagocitata dalle strettoie della degenerazione positivista dell’Illuminismo già individuata da Horkheimer e Adorno nella Dialettica dell’illuminismo (1966), giustamente ripresa dall’autore.

Dovremmo allora imparare a motivare le nostre opposizioni – agli OGM/TEA, al nucleare, all’estrattivismo, alla digitalizzazione di tutto, all’ibridazione uomo/macchina… – uscendo dalla logica dei dati, e ribadendo che anche qualora non ci fossero evidenze scientifiche di danni e nocività accertate o accertabili per la salute o l’ambiente, quelle innovazioni non le vogliamo ugualmente. E non le vogliamo perché rifiutiamo quel sistema economico che le rende necessarie allo stesso modo in cui rifiutiamo i valori e la visione del mondo che quel sistema economico innervano e legittimano. E che ce lo fanno apparire, come ci spiega Stefania Consigliere nelle Favole del reincanto, come l’unico possibile e ancor prima desiderabile, in una dinamica totalizzante, di sbarramento persino delle porte dell’immaginario, che è necessaria alla sua stessa esistenza.

Si tratta di riconoscere come la reductio ad unum da una pluralità o ecologia dei regimi conoscitivi esistenti ed esistiti nel mondo alla monocultura della scienza occidentale faccia parte di quella stessa dinamica totalizzante che ha fatto dei moderni i «terminatori di un numero altissimo di mondi umani, di modi della conoscenza e forme della presenza» (Ivi, p. 28); tanto da darci l’illusione che solo il nostro modo di essere al mondo è il punto di arrivo universale, a cui gli altri non sono ancora pervenuti, e a cui non è quindi dato, neppure a noi, immaginare alternative. È la stessa reductio ad unum che ha ridotto la pluralità dei regimi ontologici al naturalismo, dei regimi economici al plus-valore, dei regimi terapeutici alla medicina di stato (Ivi, p. 23).

Eppure, questa pretesa superiorità della modernità occidentale e della forma di conoscenza ad essa propria è esattamente ciò che ci ha portati al limite del collasso. Di fronte alla distruzione del vivente e al dominio dei pochissimi sulle moltitudini resi entrambi possibili in una portata inedita nella storia umana proprio dalla scienza e dalla tecnologia, ma di fronte anche ai vicoli ciechi in cui si è lasciata ingabbiare la nostra capacità di pensiero e di critica rendendoci tanto consapevoli quanto impotenti, quello che dovremmo problematizzare è il disincanto del mondo. Il disincanto indagato, in un passaggio bellissimo del libro, come precipitato etimologico in cui il silenziamento del mondo non umano e la sua riduzione a cieca meccanica si incontrano e si fondono con quelle passioni tristi – avidità, egoismo, sopraffazione, il leggere del mondo solo la grettezza – che devono esautorare la natura umana affinché l’organizzazione capitalista possa continuare la sua corsa (Ivi, p. 46-47).

Si tratta, dunque, di problematizzare quell’inganno che ci porta a preferire «un uragano scientifico a un rifugio magico» (Ivi, 15-16), di riaccogliere l’irrazionale e il sacro.[2] Riammettere anche le «presenze non umane», che in culture differenti dalla nostra rappresentano presenze con cui negoziare, limiti che demarcano orizzonti di non appropriabilità (Ivi, p. 28-29). Riconoscere, nella visione per cui fuori dalla socialità umana non ci sono senso o intenzionalità possibili ma solo cieco movimento meccanico, precisamente ciò che fa di noi esseri speciali autorizzati a qualunque forma di violenza sul non umano: è il disincanto che «rende accettabili le spoliazioni che incrementano i godimenti fungibili» (Ivi, 38), spazzando via ogni limite alla piena appropriabilità del reale.

Si tratta, anche, di considerare con distacco, e per fare questo di prendere atto delle vicende storiche e politiche, più che scientifiche, che hanno portato al suo affermarsi, la visione molecolare della vita basata su una biologia meccanicistica, combinazione in fondo ottimale – come ricostruiscono gli autori del Manifeste (p. 247-257) – tra visione tecnocratica della manipolazione tecnologica della vita e controllo sociale finalizzato all’estirpazione di quei “vizi” che rischiavano di frenare l’espansione capitalistica; terreno di incontro tra ingegneria genetica e sociale.

Se, come ci ricorda l’autore riprendendo Rosa Luxembourg, il capitale ha incessantemente bisogno di un ambiente non capitalistico per proseguire la sua necessaria espansione, dovendo colonizzare nuovi spazi geografici e sociali, mercificare ciò che merce non era, imporre la logica mercantile dove la produzione di beni e servizi avveniva fuori dal mercato, è utile anche ricordare, con le parole non parafrasabili di Stefania, che

Lo sbarramento dell’immaginario è indispensabile alla dinamica della totalizzazione. Le frontiere da superare e le terre da recintare non sono solo quelle geografiche: partite altrettanto rilevanti si giocano intorno a quelle psichiche, simboliche, oniriche e narrative. Nell’assoggettamento integrale niente deve arrivare, da fuori, a spezzare la continuità tra individui e mercato […]. Del mercato, infatti, sentiamo ogni sussulto, i suoi fremiti riverberano in noi: desideriamo ciò che desidera, temiamo ciò che teme. Per contro, alberi, lupi, fonti, fantasmi, mulini a vento, stelle, dèi e demoni hanno smesso di parlare. Nei sogni e nell’ebbrezza non c’è conoscenza ma solo sragione. Nel destino del mondo non ne va più di noi, nel destino nostro non ne va del mondo. È il disincanto. (Ivi., p. 33)

Forse è per questo che nelle battaglie contemporanee contro l’estrattivismo – dai Salars dell’America Latina devastati dalle estrazioni di minerali e terre rare alle periferie europee che iniziano a fare i conti con lo stesso assalto, fino, in Italia, alle proteste che nelle campagne del meridione, lungo tutto l’Appennino e in Sardegna si oppongono alle speculazioni sulle rinnovabili – mi sembra di cogliere voci che si assomigliano tanto da potersi vicendevolmente riconoscere. Sensibilità che giustamente denunciano i danni quantificabili e reclamano ricerca indipendente che possa metterli in luce, ma che imparano a parlare anche altri linguaggi. Linguaggi con cui cercare di dare parole ed espressione all’identità, alla storia, alla dimensione spirituale, ai simboli in cui ci si riconosce e in cui si riflette la propria appartenenza; alla scelta di un mo(n)do di vita nei suoi aspetti non solo materiali; alla difesa del paesaggio, e non solo per farne un prodotto da immettere nel mercato del turismo. Linguaggi capaci di riconoscere il senso di un attaccamento non quantificabile a una montagna, a un fiume, a una fonte; o al muro a secco, al complesso nuragico, alla Domus de Janas che rischiano di venire coperti dal cemento della piattaforma su cui verrà installata la prossima megapala.

Del resto, è vero che il nuovo assalto green del capitalismo ricalca e approfondisce diseguaglianze geografiche consolidate, svelando il suo volto più famelico nei territori marginalizzati, impoveriti, nelle green sacrifice zones (zone di sacrificio verdi, cfr. Zografos e Robbins 2020). Dove il ricatto della disoccupazione e della mancanza di futuro, unito alla mancanza di voce e rappresentanza, rende plausibile (e spesso, ma per fortuna non sempre, veritiera) l’ipotesi che si possano incontrare meno resistenze.

Tuttavia, se proviamo a rovesciare la prospettiva, vediamo altro. Perché non sempre, e comunque non solo, si tratta di luoghi marginalizzati e impoveriti. Anzi, a volte quella della marginalità e della mancanza di futuro diventa una retorica cavalcata da governi e investitori perché funzionale alla logica del “sacrificio”. Quegli stessi luoghi, prima che marginali – o meglio, proprio perché marginali nella prospettiva della modernità egemone – sono anche gli ultimi avamposti di biodiversità, ma soprattutto sono gli ultimi luoghi dove la modernità fa ancora i conti con qualcosa di pre-esistente e duro a morire; dove è ancora possibile dialogare con quelle parti dell’umano che non si lasciano ridurre al ciclo di produzione e consumo; e dove più attenuato arriva l’eco delle sirene dell’attivismo urbano più spettacolarizzato. Gli ultimi scogli da cui sarebbe forse possibile immaginare una vita diversa, al riparo dall’inferno tardocapitalista che ci avvolge, e che forse proprio qui, non potendo tollerare alternative che possano anche solo prefigurare resistenze al suo dover tutto ingoiare, mostra il suo volto più feroce. Ma proprio qui è anche dove incontra e suscita resistenze che ancora accendono una speranza.

NOTE

[1] Ne hanno trattato Stefania Consigliere e Cristina Zavaroni, riprendendo in particolare Micheal Taussig (1986): La cognizione del terrore. Ritrovarci tra noi, ritrovare la fiducia che l’Emergenza pandemica ha distrutto, 22 settembre 2021, <www.wumingfoundation.com/giap>.

[2] Su questo, decisivo è il rifiuto di una necessaria, automatica associazione tra incanto/irrazionale e fascismo. Su questo rimando al testo di S. Consigliere, in cui l’autrice chiarisce in modo assai convincente come l’incanto possa essere, ma non sia necessariamente, strumento di dominio; e come, d’altra parte, la modernità non ha certo cessato di farne uso, a sua volta in modo malevolo (Ivi, p. 37 e, in particolare, p. 62-72).

RIFERIMENTI BIBLIOGRAFICI

Anonimo (2022), Manifeste conspirationniste, Parigi, Seuil.

Attwell K., Smith D.T. (2017), Parenting as politics: social identity theory and vaccine hesitant communities, “International Journal of Health Governance”, 22(3): 183-98.

Bazzoli, N., Lello, E. (2022), The neo-populist surge in Italy between territorial and traditional cleavages, “Rural Sociology”, 87(1): 662-691.

Bordignon, F. (2023), Alternative science, alternative experts, alternative politics. The roots of pseudoscientific beliefs in Western Europe, “Journal of Contemporary European Studies”, 31(4): 1469-1488.

Bucchi, M., Neresini, F. (2002), Biotech remains unloved by the more informed, “Nature”, 416: 261.

Chalmers J. (2017), The transformation of academic knowledges: understanding the relationship between decolonizing and indigenous research methodologies, “Socialist Studies”, 12(1): 97-116.

Coniglione, F., eds. (2010), Through the mirrors of science. New challenges for knowledge-based societies, Heusenstamm, Ontos Verlag.

Consigliere, S. (2020), Favole del reincanto: molteplicità, immaginario, rivoluzione, Roma, DeriveApprodi.

de Sousa Santos, B., Nunes, J. A., Meneses, M.P. (2022), Opening up the canon of knowledge and recognizing difference, “Participations”, 32(1): 51-91.

Dentico, N., Missoni, E. (2021), Geopolitica della salute: Covid-19, OMS e la sfida pandemica, Soveria Mannelli, Rubbettino.

Dotson, T. (2021). The divide: how fanatical certitude is destroying democracy, Cambridge, MIT Press.

Foucart, S., Horel, S., Laurens, S. (2020), Les gardiens de la raison: enquête sur la désinformation scientifique, Parigi, La Découverte.

Gigerenzer, G. (2015), Imparare a rischiare: come prendere decisioni giuste, Milano, Cortina.

Goldenberg, M. (2016), Public misunderstanding of science? Reframing the problem of vaccine hesitancy, “Perspectives on Science”, 24(5): 552-81.

Goldenberg, M.J. (2021), Vaccine hesitancy: public trust, expertise, and the war on science, Pittsburgh, University of Pittsburgh Press.

Grignolio, A. (2016), Chi ha paura dei vaccini?, Torino, Codice.

Harambam, J. (2021), Against modernist illusions: why we need more democratic and constructivist alternatives to debunking conspiracy theories, “Journal for Cultural Research”, 25(1): 104-122.

Harambam, J., Aupers, S. (2015), Contesting epistemic authority: conspiracy theories on the boundaries of science, “Public Understanding of Science”, 24(4): 466-480.

Jasanoff, S. (2021), Knowledge for a just climate, “Climatic Change”, 169(3): 1-8.

Kahneman, D. (2012), Pensieri lenti e veloci, Milano, Mondadori.

Keren, A. (2018), The public understanding of what? Laypersons’ epistemic needs, the division of cognitive labor, and the demarcation of science, “Philosophy of Science”, 85(5): 781-792.

Lello, E. (2020), Populismo anti-scientifico o nodi irrisolti della biomedicina? Prospettive a confronto intorno al movimento free vax, “Rassegna Italiana di Sociologia”, 3: 479-507.

Lello, E., Raffini, L. (2023), Science, pseudo-science, and populism in the context of post-truth. The deep roots of an emerging dimension of political conflict, “Rassegna Italiana di Sociologia”, 4: 705-732.

Lello, E., Saltelli, A. (2022), Lobbismo scientifico e dirottamento dello spazio pubblico, in E. Lello, N. Bertuzzi (eds.), Dissenso informato. Pandemia: il dibattito mancato e le alternative possibili, Roma, Castelvecchi, 187-203.

Lolli, A. (2023), Il complottismo non esiste o Miseria dell’anticomplottismo, in M.A. Polesana, E. Risi (eds.), (S)comunicazioni e pandemia. Ricategorizzazioni e contrapposizioni di un’emergenza infinita, Milano-Udine, Mimesis, 239-271.

Nunes, J. A., Louvison, M. (2020), Epistemologies of the South and decolonization of health: for an ecology of care in collective health, “Saude e Sociedade”, 29(3): e200563.

Osimani, B., Ilardo, M.L. (2022), “Nessuna correlazione”. Gli strumenti per la valutazione del nesso causale tra vaccinazione ed evento avverso, in E. Lello, N. Bertuzzi (eds.), Dissenso Informato. Pandemia: il dibattito mancato e le alternative possibili, Roma, Castelvecchi, 167-186.

Pielke, R.A.J. (2005), Scienza e politica, Roma-Bari, Laterza.

Quijano, A. (2005), Colonialidade do poder, eurocentrismo e América Latina, in A colonialidade do saber: etnocentrismo e ciências sociais. Perspectivas latino-americanas, Buenos Aires, Clacso, 117-142.

Reich, J.A. (2014), Neoliberal mothering and vaccine refusal: imagined gated communities and the privilege of choice, in “Gender and Society”, 28(5): 679-704.

Sarewitz, D. (1996), Frontiers of illusion: science, technology, and the politics of progress, Philadelphia, Temple University Press.

Saurette, P., Gunster S. (2011), Ears wide shut: epistemological populism, argutainment and Canadian conservative talk radio, “Canadian Journal of Political Science”, 44(1): 195-218.

Schadee, H.M.A., Segatti, P., Vezzoni C. (2019), L’apocalisse della democrazia italiana: alle origini di due terremoti elettorali, Bologna, Il Mulino.

Smith, P.J., Chu, S.Y., Barker, L.E. (2004), Children who have received no vaccines: who are they and where do they live?, “Pediatrics”, 114(1): 187-95.

Steinberg, T. (2006), Acts of God: the unnatural history of natural disaster in America, Oxford, Oxford University Press.

Taussig, M.T. (1986), Shamanism, colonialism, and the wild man: a study in terror and healing, Chicago, University of Chicago Press.

Wei, F., Mullooly, J.P., Goodman, M., McCarty, M.C., Hanson, A.M., Crane, B., Nordin, J.D. (2009), Identification and characteristics of vaccine refusers, “BMC Pediatrics”, 9(18): 1-9.

Wu Ming 1 (2021), La Q di Qomplotto. QAnon e dintorni. Come le fantasie di complotto difendono il sistema, Roma, Alegre.

Ylä-Anttila, T. (2018), Populist knowledge: post-truth repertoires contesting epistemic authorities, “European Journal of Cultural and Political Sociology”, 5(4): 356-388.

Zagzebski, L.T. (2012), Epistemic authority: a theory of trust, authority, and autonomy in belief, Oxford, Oxford University Press.

Zografos, C., Robbins, P. (2020), Green sacrifice zones, or why a green new deal cannot ignore the cost shifts of just transitions, “One Earth”, 3(5): 543-546.

La dimensione morale delle scienze e delle tecnologie

In questi 18 mesi di attività, prima come blog e ora – finalmente – come rivista settimanale, abbiamo cercato – come ci eravamo ripromessi con il programma di lavoro - di presentare una visione più equilibrata delle scienze e delle tecnologie, riconoscendone la specificità ma anche facendo luce sulla loro natura di impresa umana, storicizzate e sociologizzate. Attraverso il riconoscimento del carattere sociale sia delle scienze che delle tecnologie abbiamo proposto un rapporto più bilanciato e un atteggiamento più tollerante verso le opinioni e ipotesi diverse, a beneficio sia della società che delle scienze.

Come scrivono lucidamente Collins e Pinch (1993), la scienza – e lo stesso vale per la tecnologia - è un’attività controversa: da una parte ci fornisce i mezzi per curare gli ammalati; dall’altra produce l’infido veleno causato dagli incidenti nucleari; da una parte ci offre migliori condizioni di vita e dall’altra il rischio di trovare la morte a causa degli effetti collaterali di un farmaco.

In questo tragitto, come ricorda Teo Donolato, abbiamo affrontato ― e continueremo ad affrontare ― una serie di tematiche scientifiche evidenziando l’illusione del piedestallo epistemico, della deificazione laica delle scienze e della ricerca di verità assolute; abbiamo mostrato controversie, errori e non sequitur nello sviluppo delle scienze; e, abbiamo provato a ripensare le concezioni limitanti e banalizzanti, sia delle scienze che delle tecnologie, dando spazio a pluralità di voci.

Parallelamente, sottolinea Paolo Bottazzini, abbiamo sottoposto ad analisi critica la narrazione delle più recenti tecnologie e del soluzionismo tecnologico, svelando alcune false assunzioni e la sottrazione dello sviluppo tecnologico alle decisioni collettive e responsabili, in nome del progresso, sviluppando una visione – anche in questo caso – non banalizzante e nello stesso tempo non luddista.

Quello che promettiamo è di investigare e anche la dimensione morale e, quindi, politica, della pratica scientifica e dello sviluppo tecnologico.

Quando parliamo di pluralità di voci, infatti, non lo facciamo per allinearci a una moda di democratizzazione delle scienze ma perché ogni scoperta scientifica - e ogni relativa applicazione – si basa su dei presupposti nati da scelte morali e porta con sé degli effetti morali su individui e su collettività. Individui e collettività che hanno istanze di benessere e di sopravvivenza, istanze che la ricerca scientifica e – soprattutto – le sue applicazioni devono sempre prendere in considerazione.

Facciamo un esempio: il Progetto Life Ursus di reinserimento degli orsi nell’habitat del Trentino, progetto il cui carattere scientifico – tra studio di fattibilità e organizzazione preliminare - è indiscutibile, risponde in maniera primaria all’istanza morale di preservare la presenza della specie nel territorio, portando un certo numero di esemplari dalle montagne slovene. Il rilascio di 10 “nuovi orsi” è avvenuto tra il 1999 e il 2002 con l’obiettivo di arrivare a 40 – 60 individui nel giro di alcune decine d’anni. Il progetto ha funzionato e nel 2024 la popolazione di orsi nel 2024 è stimata in un centinaio di esemplari. Ma, c’è un “ma” importante, oltre a numerosi casi di danni a strutture antropiche e numerosi incontri con gli umani, ci sono state delle vittime umane: il giovane Andrea Papi ucciso da un ‘orsa nell’aprile del 2023 e un turista francese ferito nel 2024 (e almeno 6 orsi abbattuti per ragioni di sicurezza della popolazione). Oggi, in Trentino, una elevata percentuale della popolazione sembra essere favorevole allo spostamento degli orsi altrove.

Lo studio scientifico di fattibilità comprendeva, oltre a più di 60 parametri ambientali, delle valutazioni socioeconomiche, tra cui:

- l’analisi del favore degli abitanti verso la reintroduzione degli orsi nel territorio (che è risultata statisticamente superiore al 70%, su un campione di 1.500 abitanti, il 1,25 % della popolazione del Trentino, intervistati telefonicamente[1]);

- la valutazione economica (effettuata da una Società di consulenza di Roma che ha suggerito una serie di misure di protezione e di risarcimento verso le attività economiche potenzialmente vulnerabili);

È stata poi organizzato una Emergency team, «squadra di persone appositamente addestrate potrà applicare misure dissuasive per gli orsi, procedere alla loro eventuale cattura e trasferimento ed infine sarà anche pronta ad abbattere individui che mostreranno comportamenti devianti».

In questo caso il lavoro di Controversie è di evidenziare che, probabilmente, le scienze – in nome del principio morale di «riportare l’orso su queste montagne» – hanno trascurato una serie di istanze morali non irrilevanti: quelle degli allevatori e della popolazione che abita densamente le montagne interessate, ei turisti, delle forze politiche di opposizione (che oggi sono al potere in Trentino e agiscono contro la presenza degli orsi), degli scienziati ecologisti che non riconoscono nella specie un soggetto morale rilevante e, infine, degli orsi, che sono stati tolti dal loro habitat in Slovenia e trapiantati in un territorio con una densità antropica drammaticamente superiore.

Come direbbe Bruno Latour, tutti questi attanti sono inseriti in una rete, e per ciascuno di essi occorre pensare una traduzione (o traslazione) dei loro interessi/bisogni in quelli degli altri. Pena la prevaricazione di alcuni su altri e l’entropia che si introduce nella rete e nella catena di associazioni/relazioni.

Allo stesso modo, quando si parla di sviluppo e di progresso tecnologico è necessario chiedersi “in nome di cosa e di chi” si realizzano gli sviluppi tecnologici? Chi godrà di questo progresso e come? Se c’è un prezzo da pagare per il progresso, chi lo pagherà?

La dimensione morale della tecnologia è sotto i nostri occhi ogni giorno: un bot intelligente che risponde a un cliente di un’azienda del gas allevia il lavoro degli operatori telefonici – che possono, quindi, svolgere lavori più qualità e competenza – oppure li sostituisce, creando disoccupazione? Una automobile a guida automatica permette al proprietario di fare meno fatica ma come decide in caso di emergenza?

Poiché il desiderio di una scienza intonsa, perfetta, che proponga verità assolute e di tecnologie che portino sempre e solo benessere per tutti, è legittimo ma sta nella sfera dell’impossibile, ecco che Controversie si impegna anche a lavorare sul versante della dimensione morale, evitando posizioni di negazione tecnoscientifica ma – al contrario – cercando di tracciare e di suggerire dei percorsi di ricerca e di sviluppo che tengano conto delle lateralità, delle istanze morali di benessere, se non di sopravvivenza, degli attori meno rappresentati e meno capaci di far sentire la propria voce.

NOTA

[1] Sondaggio affidato alla DOXA di Milano. Più di 1500 abitanti dell’area sono stati intervistati telefonicamente, per analizzare la loro attitudine verso l’orso, la percezione verso questa specie e la possibile reazione di fronte ai problemi che l’orso porrà. I risultati sono stati sorprendenti: più del 70% degli abitanti si sono dimostrati a favore del rilascio di orsi nell’area. Questa percentuale sale fino all’80% di fronte all’assicurazione che verranno prese misure di prevenzione dei danni e che se un orso si dimostrerà potenzialmente pericoloso per l’uomo verrà immediatamente allontanato o abbattuto. (Le probabilità di successo del Progetto di immissione di E. Duprè, P. Genovesi, L. Pedrotti Tratto da: "Adamello Brenta Parco" anno 1998 n. 2 pag. 2)

Critica del soluzionismo tecnologico

Il sociologo Morozov ha coniato alcuni anni fa l'espressione "soluzionismo digitale" per indicare l'atteggiamento prevalente ai nostri giorni nei confronti dei dispositivi digitali.

Si ritiene che i problemi siano risolvibili da qualche algoritmo, e dagli strumenti che ne automatizzano l'applicazione alla realtà. Le smart city, le smart home, i dispositivi biometrici che indossiamo, sono alcune delle declinazioni di questa concezione: l'ottimizzazione del traffico nei centri urbani, del consumo energetico e degli scenari di abitabilità nelle case, della forma fisica individuale, sono sottratti alle decisioni collettive e personali, e vengono aggregati intorno ai pattern definiti dalla medietà dei comportamenti sociali.

Persino l'uso della lingua si stabilisce sull'ortografia e sull'ortodossia media, con i motori di ricerca le piattaforme di intelligenza artificiale generativa trasformativa - e lo stesso accade alla selezione delle informazioni più rilevanti per l'assunzione di qualunque decisione.

Si avvera al massimo grado la previsione che Adorno e Horkheimer avevano elaborato sulla dialettica della ragione illuministica, che nel momento in cui si libera dal giogo delle autorità tradizionali finisce per limitarsi alla selezione degli strumenti in vista del fine, ma non è più in grado di pensare le finalità stesse, e i principi che dovrebbero governarle.

Per di più, i dispositivi digitali vantano una proprietà che le tecnologie del passato non avevano mai tentato di pretendere. Servizi digitali come Google, Facebook, Instagram, Amazon, accumulano una mole di dati così ampia e profonda su ciascun individuo, da sapere sui singoli più di quello che i soggetti sanno di se stessi.

Questa espansione quantitativa si tramuta in una condizione qualitativa: la concezione liberale del mondo, che abbiamo ereditato dall'Illuminismo, pone l'individuo come valore fondamentale, collocando nella sua coscienza e nella sua libertà le chiavi di volta della società e della storia.

Oggi le grandi piattaforme digitali possono rivendicare una conoscenza sui singoli, e sui contesti in cui si muovono, superiore a quella di cui i soggetti stessi dispongono, e potrebbero quindi reclamare un diritto di decisione sulla loro vita quotidiana e sul loro destino fondandolo sulla maggiore capacità di prevedere le conseguenze di ogni gesto, su una maggiore razionalità, quindi su una maggiore assunzione di responsabilità per ogni scelta.

-------------

Bisogna sottoporre ad analisi critica questa narrazione, dalla confusione di dati e informazioni alla definizione di "decisione razionale", per evitare non solo che la distopia si avveri, ma anche per impedire che le sue (false) assunzioni ricadano nelle attuazioni parziali che il soluzionismo tecnologico tende ad agevolare, o persino ad imporre.

Ripensare le Scienze - Perché "Controversie"?

L'intento alla base di Controversie è di ripensare le Scienze e le Tecnologie. Infatti, questa rivista è nata appunto per riesaminare – o rinegoziare – l’idea che considera le scienze come portatrici di verità assolute e oggettive, nonché distanti dalle influenze umane, come se abitassero dunque in una sorta di moderno pantheon laico. Questa visione, di stampo positivista e scientista, vuole esaltare l’impresa scientifica ma spesso non comprende che la banalizza e, in aggiunta, la mette su una sorta di piedistallo epistemologico; così facendo, le scienze vengono isolate da altre – fondamentali – attività umane con le quali devono necessariamente dialogare come, per esempio, arte, filosofia, linguistica, sociologia o storia. Tale isolamento può quindi portare a gravi errori di valutazione, su più livelli.

Inoltre, il termine scienza (al singolare) allontana da una presa di posizione consapevole della disciplina stessa. Infatti, scienza, se espressa al singolare, rappresenta un termine ombrello che raccoglie al suo interno elementi molto diversi [1], i quali trattano oggetti di studio differenti come, per esempio, l'astronomia e la zoologia, oppure l'ingegneria e la microbiologia. Se mettiamo tutte queste discipline "sotto lo stesso tetto", quindi, ne annulliamo le differenze e relative specificità.

Scopo di Controversie è dunque di ripensare concezioni limitanti e banalizzanti delle scienze e delle tecnologie, far riflettere sul fatto che esse possono dialogare in modo proficuo con altre importanti imprese umane e, di conseguenza, far capire che tutte queste discipline sono immerse in una bellissima rete e non, invece, in categorie separate le une dalle altre. Mostrare le controversie, gli errori, i non sequitur nello sviluppo delle scienze può aiutare in questo intento. Così facendo, si possono anche percepire le peculiarità e le bellezze insite nell'impresa scientifica stessa.

In conclusione, quando parliamo di scienze è necessario considerare più elementi possibili – una pluralità di voci – perché tutte queste componenti possono (e devono) lavorare insieme, in quanto nessuna di esse vive isolata e in un mondo a parte.

Ciò che si ottiene è una visione delle scienze (e delle tecnologie) più aperta, ampia e completa.

NOTE

[1] Possiamo fare un ragionamento simile anche con i termini animale o femminismo.

Scienza Post Normale – Due casi concreti di applicazione delle prescrizioni

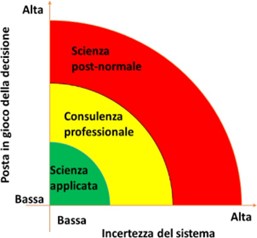

Un paio di settimane fa abbiamo parlato – in linea molto generale – del concetto di Scienza Post Normale, che abbiamo definito un “approccio normativo per la complessità e l’incertezza”. Un approccio che può guidare il lavoro di scienze e scienziati quando vengono chiamati in soccorso dalle istituzioni in condizioni, appunto, di incertezza, di rischio elevato, di conflitti valoriali e di urgenza.

Funtowicz e Ravetz sostengono che questo approccio – normativo, ricordiamolo - è utile quando la scienza normale, quella della soluzione di rompicapo all’interno di un paradigma stabile e consolidato[1] non può essere applicata perché le condizioni sfuggono alle classificazioni standard; e quando nemmeno le esperienze anche tacite, maturate dagli esperti nel corso della loro pratica, l’area della Professional Consultancy, non trovano un terreno solido su cui poggiare, a causa – soprattutto - delle condizioni di incertezza e della complessità ed intreccio delle poste in gioco.

Diagramma della scienza post-normale. Fonte: Scienza, politica e società, 2022

Può essere interessante, per comprendere la portata e l’applicabilità di questo approccio, di vedere due casi pratici, uno in cui le raccomandazioni sono state applicate in modo consapevole e uno in cui – rileggendone la storia a posteriori – si riscontrano le tracce di un utilizzo inconsapevole delle norme PNS.

L’INCONTRO PERSONALE DI ANDREA SALTELLI CON LA SCIENZA POST NORMALE

Nella sua vita “pre-post-normal-science”, Andrea Saltelli lavorava per la Commissione Europea, sullo sviluppo e sul controllo della qualità di modelli quantitativi da utilizzare nello studio e nella valutazione delle politiche comunitarie, in particolare, sull’educazione. Stimolato dal dibattito sull’approccio fondato da Funtowicz e Ravetz – comprese che il suo lavoro di controllo dei modelli “presupponeva” i modelli stessi, come se questi fossero scontati, naturali e la loro genesi non fosse affatto problematica.

C’erano domande sulla genesi dei modelli, racconta Saltelli, che fino allora non si era posto erano di questo tenore: “Perché è stato sviluppato questo modello? Chi l’ha richiesto? Con quali obiettivi e aspettative?”; e, ancora: “Quali voci sono state ascoltate nella costruzione del modello? Qual è la nozione di progresso che lo anima?”.

Tutte domande che lo spingevano a situare il focus del suo lavoro in un contesto socio-politico e in una visione del mondo, a cercare di comprenderne le distorsioni, le influenze e – soprattutto a valutarne gli effetti positivi e negativi sui programmi educativi e sui rapporti di forza tra stati o fra regioni.

In poche parole, l’approccio della PNS ha suggerito a Saltelli che i modelli quantitativi sviluppati per simulare lo sviluppo delle politiche, controllarne e monitorarne l’applicazione, a volte già contenevano quelle stesse politiche e il loro sviluppo era una forma di legittimazione delle politiche stesse. In poche parole, l’obiettivo silente dei modelli poteva in certi casi risultare nella riduzione delle politiche nelle loro dimensioni quantitative e – in questo modo – farne risaltare l’immagine oggettiva e neutrale: “lo dicono i numeri”[2].

Numeri che, volutamente, per evitare la proliferazione di scenari alternativi - con i relativi impatti socio-politici – e garantire la linearità, tralasciano i fattori di incertezza e le potenziali condizioni di deviazione. Di tanti possibili scenari, ne “scelgono” uno, quello che legittima e conferma le scelte iniziali e le assunzioni di valore della politica che descrivono.

Applicare alcune delle raccomandazioni della PNS quali, ad esempio, la ricerca del pedigree dei dati e delle assunzioni preliminari di valore, contaminando la modellistica “ufficiale” non trovò un terreno fertile ma, al contrario, incomprensione e ostilità. Questo genere di contaminazione, racconta Saltelli, significava mettere in discussione il candido positivismo e la convinzione nella neutralità della scienza verso cui inclinano la maggior parte delle istituzioni comunitarie.

Le linee di ricerca che si sono aperte dopo questa presa di coscienza, tuttavia, si sono rivelate costruttive e produttive: è iniziato per questo ricercatore un periodo di “cooperazione con statistici che guardavano con interesse alla crisi della riproducibilità in termini di problemi epistemologici e normativi, che provavano diversi approcci all’interpretazione dei legami tra scienze, tecnologie e nuovi mezzi di comunicazione, che correlavano questi approcci alla cosiddetta post-verità e alle istanze dell’integrità delle scienze”

Oggi non sembra possibile, per questi ricercatori, sviluppare e adottare modelli statistici che non prendano in considerazione le incertezze, l’origine dei dati, le diversità valoriali e la molteplicità delle voci coinvolte.

IL CASO DELLA PANDEMIA DI H1N1 NEL 2009

Nel caso della pandemia influenzale del 2009-2010, causata dal virus H1N1[3], possiamo rintracciare alcuni elementi caratteristici delle prescrizioni della Scienza Post Normale, probabilmente messe in atto in modo non consapevole.

Vediamo qualche elemento chiave che delinea questa storia[4] come esempio di applicazione della PNS. Come prima cosa va ricordato che 1) solo la WHO (World Health Organisation) può dichiarare che la diffusione di una malattia è una pandemia e 2) che la dichiarazione dovrebbe seguire un percorso quasi meccanico, in cui i fatti sono stabili e chiari, il processo e le nozioni che lo delineano sono ben definiti e le risposte sono nette, quasi da manuale.

Nel caso della diffusione del H1N1, invece, i fatti scientifici emersi – come la ampiezza della diffusione della malattia, la sua velocità di riproduzione e il suo grado di gravità - furono tutt’altro che chiari e stabili, e la nozione stessa di pandemia venne messa in discussione nel corso del processo di studio del fenomeno.

Quello che accadde nel primo periodo epidemico fu che la diffusione - apparentemente ampia e veloce - e la gravità della malattia furono difficilmente misurabile a causa dell’incertezza dei dati sul numero di persone infette nelle diverse nazioni o regioni colpite e sul numero di morti, e della evidente divergenza di percezione che si verificò tra area ed area.

In questa situazione di incertezza, il processo che portò – nel giugno 2009 - alla dichiarazione di pandemia da parte della WHO, porse il fianco a una serie di critiche, sia da parte di numerosi scienziati che non riscontrarono nel fenomeno i caratteri epidemiologici necessari per chiamarlo pandemia; che da parte del Consiglio d’Europa, il quale ritenne non giustificabile l’effetto di paura collettiva generato per una malattia che – dopo alcune settimane – si rivelò molto più lieve di quanto prospettato ; sia, infine, da parte di molti altri osservatori, per l’approccio ondivago della WHO[5]

Nel corso del processo, infatti, la WHO dovette rivedere più volte – sotto la pressione delle critiche di numerose nazioni e istituzioni, e di fronte al grado di incertezza sull’andamanto quantitativo e qualitativo della diffusione – sia la nozione di pandemia, che progressivamente incluse i fattori di novità, mutazione, diffusione, attività della malattia, e quello di imprevedibilità. Il fattore gravità fu anch’esso oggetto di discussione: prima fu escluso, a favore della dimensione della diffusione[6], poi fu reintrodotto tra i parametri di valutazione.

Ora, questa vicenda sembra avere tutte le caratteristiche di una situazione di scienza post normale: l’incertezza sui dati e sul fenomeno, la rilevanza della posta in gioco, quella della salute di grandi parti della popolazione mondiale, i conflitti tra attori e istanze valoriali, e l’urgenza di prendere decisioni.

Se, in un primo momento, la WHO si appellò al principio di precauzionalità, dando priorità al fattore urgenza, in un secondo momento diede ascolto alla pluralità di voci che si manifestarono a favore e contro la controversa dichiarazione di pandemia e, progressivamente, de-costruì e ricostruì la nozione di pandemia, includendo – tra gli altri - i fattori critici della imprevedibilità e le istanze delle istituzioni delle aree colpite.

Si tratta, quindi e con evidenza, di una costruzione sociale di un concetto che – secondo il mito della scienza intonsa (ne parla Elisa Lello qui) – dovrebbe avere confini scientifici chiari e ben definiti ma che, in realtà, è facile che non li abbia affatto e debba essere oggetto di negoziazione e di decisioni pluraliste.

QUALCOSA DI NUOVO SOTTO IL CIELO DELLA SCIENZA?

Forse no, forse l’analisi delle problematiche scientifiche proposta da Funtowicz e Ravetz non è nulla di nuovo, né di eccezionale; i critici della PNS sostengono – infatti - che la PNS non ha scoperto nulla, ma ricalca temi noti da sempre alla sociologia della scienza.

Però, posto che sia così, senza la traduzione intelligente di questi temi proposta dalla Scienza Post Normale, il messaggio – quello della necessità di organizzarsi con una nuova e più variegata cassetta degli attrezzi per affrontare i grandi temi scientifici - non sarebbe arrivato né agli scienziati naturali, che non hanno una formazione sociologica o filosofica, né alla sfera politica.

NOTE

[1] Cfr.: Kuhn H., La struttura delle rivoluzioni scientifiche, Einaudi, 2009

[2] “I formed the opinion that there is a political economy of quantification whereby epistemic authority is purchased via recourse to models whose role is to objectify—and possibly sterilize—political issues making them appear determined and solvable through impersonal objectivity” Saltelli, A. What is Post-normal Science? A Personal Encounter. Found Sci 29, 945–954 (2024). https://doi.org/10.1007/s10699-023-09932-x

[3] Fu chiamata, erroneamente, influenza o febbre suina poiché «il virus sembra essere un nuovo ceppo di H1N1, che risulta da un precedente riassortimento triplo tra virus influenzali di maiale, uccello e umano, successivamente ulteriormente combinato con l'influenza euro-asiatica dei maiali,[4] da cui deriva il nome "influenza suina"» (Wikipedia, Pandemia influenzale del 2009-2010)

[4] La vicenda della dichiarazione della pandemia da H1N1 è analizzata dettagliatamente da Sudeepa Abeysinghe, in Global Health Governance and Pandemics: Uncertainty and Institutional Decision-Making,

[5] Oltre a questi fatti, fu ampiamente criticato il rilievo che – sembra di leggere una storia più recente – la WHO diede alla prevenzione vaccinale, ignorando altre misure di contenimento come – ad esempio - lavarsi frequentemente le mani, controllare le frontiere, utilizzare degli antivirali, che fu interpretata come un tentativo di favorire le grandi case farmaceutiche.

[6] Questa scelta fu il risultato di un tentativo di neutralizzare le critiche dello European Centre for Disease Control (ECDC) che non conveniva sulla gravità della malattia.

Scienza ed arte - Per una rinnovata sinergia

Oggi, il rapporto tra arte e scienza è oscurato e perduto. L’han detto e scritto in molti: Feyerabend e Thomas (1989), Greco (2013), Odifreddi (2023), solo per citare che pochi autori. Un tema enorme, su cui un post può solo abbozzare alcune considerazioni.

Nel 1929, Norbert Wiener, il matematico che sarebbe poi diventato noto come il padre della cibernetica, affermava che la scienza dei numeri è, in senso stretto, un'arte. Secondo Wiener, la matematica poteva (e doveva) essere considerata parte integrante della storia dell'arte (Odifreddi 2023).

Sul rapporto benefico tra arte e scienza ci sono moltissimi esempi, dalla storiografia alla musica, dall'architettura e alla fisica e alle neuroscienze. Eppure, l’età scientista in cui stiamo vivendo tende a trascurarlo o a nasconderlo. Questa visione scientista è stata contrastata dalla controversia scatenata dallo scrittore e fisico inglese Charles Percy Snow, con il suo libro Le Due Culture e la rivoluzione scientifica (1959). Con esso Snow denunciava la crescente frattura tra la cultura scientifica e quella umanistica. La sua accusa risuonò con forza tra molti intellettuali, poiché questa separazione era estranea a figure come Dante, Galileo, Empedocle, Leonardo, Cartesio, Goethe, Einstein, gli anonimi architetti delle cattedrali gotiche e Michelangelo. Ancora oggi, questa divisione è sconosciuta ad artigiani esperti e fisici che affrontano i misteri dell'ignoto (cfr. Greco 2013).

Per mostrare concretamente l’utilità di questa sinergia, farò tre esempi.

SINERGIE TRA ARTE E MEDICINA

Non è sempre facile stabilire quando alcune malattie sono sorte per la prima volta. A tal fine i romanzi ci ha fornito informazioni importanti relativamente alla peste, il colera, il vaiolo etc. che si sono manifestati nel corso dei secoli. La pittura è un’altra fonte inesauribile. Infatti, nei personaggi ritratti nei quadri si possono ritrovare i segni di una malattia: la sindrome di Mondor nella Betsabea di Rembrandt (1654); l’esadattilismo nell’Uomo vitruviano di Leonardo (1490), nella Madonna di Casa Santi (1498) e nella Madonna Sistina (1513-14) di Raffaello; la neurofibromatosi di tipo I ne La Camera degli Sposi di Mantegna (1465-1474); l’ipertricosi nel Petrus Gonsalvus di un anonimo pittore tedesco (1580 circa); il tumore al seno nella scultura La notte di Michelangelo (1534). E così via per molte altre malattie come la tubercolosi, l’herpes zoster, la depigmentazione cutanea, il rinofima, l’artrite etc.

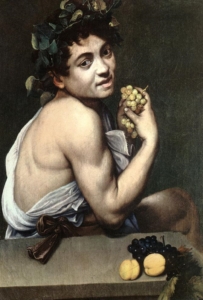

Un caso esemplare è il Bacchino malato di Caravaggio (1593), affetto dal morbo di Addison, dal nome del medico britannico che per primo lo descrisse. Ma solo nel 1855, ben 250 anni più tardi!

Bacchino malato, Caravaggio (1593)

Bacchino malato, Caravaggio (1593)

Come ha scritto il chirurgo vascolare italiano Paolo Zamboni, nelle pagine del Journal of Thrombosis and Haemostasis (28 April 2020), il modello è pallido, con riflessi scuri in alcune aree della cute; forse ha anche dolori addominali, come fa pensare la posizione curva in avanti; si sta cibando di uva come se avesse bisogno di zuccheri a causa di una possibile ipoglicemia. Inoltre, l’angolo interno dell’occhio, poco irrorato, depone per un’anemia. Il pollice scuro e l’unghia nerastra e opaca (anziché entrambi rosei) rivelano una acantosi nigricans (una condizione in cui la pelle si presenta iperpigmentata, ispessita, vellutata e di colore più scuro rispetto alle zone circostanti).

LETTERATURA E TECNOLOGIA: QUANDO FANTASIA E SCIENZA SI FONDONO

Jules Verne (1828-1905) è considerato, uno dei padri nobili della fantascienza moderna o, come veniva definita all’epoca, “narrativa d’anticipazione”. Guidato da una forte passione per la tecnologia, con i suoi racconti ambientati nell’aria, nello spazio, nel sottosuolo e nel fondo dei mari ha ispirato molti scienziati delle epoche successive.

Nel romanzo Dalla Terra alla Luna (1865), Verne descrive un viaggio a bordo di un proiettile sparato da un gigantesco cannone e uno sbarco sulla Luna. All’epoca questa idea fu contestata da molti scienziati ma, dopo tutto, si trattava di un romanzo d’avventura e di fantascienza. Un po' più tardi fu pubblicato Intorno alla Luna (1869); questo romanzo va oltre il viaggio e segue le avventure degli eroi sulla Luna.

In Ventimila leghe sotto i mari (1869-1870), Verne immagina un grande sottomarino elettrico, il Nautilus. E il Nautilus non vi ricorda forse il DSV Alvin varato nel 1964? Il Nautilus, come il DSV Alvin, era una propulsione esclusivamente elettrica. Infatti, Verne rifiutò il carbone come combustibile, proponendo invece batterie elettriche (di una composizione chimica sconosciuta) per azionare il congegno. Ciò rende Verne un precursore dei carburanti alternativi. Nello stesso libro scrive di una pistola che dà una forte scossa elettrica, molto simile all'attuale taser.

Gli studi per creare macchine volanti risalgono agli schizzi di Leonardo da Vinci, ma fu verso la fine dell'Ottocento che l'elicottero, come lo conosciamo, cominciò a prendere forma. Nello stesso periodo, Jules Verne pubblicò Robur il conquistatore (1886), un romanzo in cui il personaggio principale costruiva un velivolo di truciolato (quindi aveva grande resistenza e leggerezza allo stesso tempo) che volava tramite rotori, proprio come fanno gli elicotteri moderni. Rotori aggiuntivi a prua e a poppa servivano a spingere il velivolo verso il cielo. Verne prese i prototipi di elicottero esistenti e immaginato come si sarebbero sviluppati.

In un breve racconto scritto nel 1889, La giornata di un giornalista americano nel 2889, Verne descrive un'alternativa ai giornali: “ogni mattina, invece di essere stampato come nell'antichità, l'Earth Herald viene 'parlato'. È attraverso una vivace conversazione con un giornalista, un personaggio politico o uno scienziato che gli abbonati possono apprendere tutto ciò che capita di interessarli”. Ci vollero molto meno dei mille anni previsti da Verne per avere i primi giornali radio (negli anni Venti) e poi i primi telegiornali (negli anni Quaranta).

Jules Verne era ben lungi dall’essere uno scienziato, ma le sue opere e i progressi che si stavano realizzando all’epoca servirono a introdurre molte delle invenzioni che sarebbero arrivate successivamente e che, nel tempo, sono finite per diventare elementi ordinari della nostra vita quotidiana. Si può quindi sostenere che la letteratura ha fornito la vision alla scienza e tecnologia.

ARTE, SCIENZA E AMBIENTE

La nefologia è una branca della meteorologia che studia le nuvole (dal greco nephos che significa appunto nube, nuvola). Gli cloudspotters (osservatori di nuvole) classificano accuratamente le nuvole una a una, dando loro un’identità (con tanto di descrizione) e seguendo uno schema simile a quello degli organismi viventi, basato su aspetto e altitudine. Si contano 10 gruppi principali o generi (stratus, cumulus, stracumulus, nimbostratus, cumulonimbus, altocumulus, altostratus, cirrostratus, cirrocumulus e cirrus), che a loro volta si suddividono in specie e varietà.

Moltissimi pittori come John Constable, Joseph Mallord, Caspar David Friedrich, Gustave Courbet si sono cimentati all'interno delle loro opere nella raffigurazione delle nuvole. Il primo fra tutti fu Andrea Mantegna.

Il greco Christos Zerefos, specialista in scienze atmosferiche, sostiene che attraverso l'analisi dei colori (soprattutto le quantità di rosso e di verde) dei cieli delle pitture dei paesaggisti si può calcolare lo spessore ottico dell'atmosfera, cioè la quantità di aerosol presente nell'atmosfera al momento in cui la tela è stata dipinta. Conoscere la qualità dell'aria prima della rivoluzione industriale permette di comprendere l'impatto delle attività umane sull'inquinamento. Zeferos si è concentrato, in particolare, sul pittore e incisore inglese William Turner. I pigmenti rossi e verdi che hanno colorato i cieli dei suoi dipinti sono la prima testimonianza dei livelli di inquinamento dell'aria di un paio di secoli fa. All'epoca si sapeva poco e niente circa l'inquinamento e, anzi, nessuno scienziato fino al 1829 si preoccupò di tracciare le polveri nocive che fluttuavano nel cielo. Ai tempi di Turner le fabbriche (con i loro fumi) si moltiplicavano, le locomotive a vapore si diffondevano velocemente, i vulcani continuavano ad esplodere ― come nel caso dell'indonesiano Tambora, che nel 1815 scagliò 36 miglia cubiche di roccia frantumata nell'atmosfera ed ebbe ripercussioni sull'intero pianeta poiché le ceneri fecero più volte il giro della terra trasformando l’anno successivo (il 1816) “nell'anno senza estate”. I ricercatori hanno infatti osservato che i cieli dipinti negli anni successivi alle eruzioni vulcaniche contenevano una maggiore dose di rosso. Dura doverlo ammettere, ma, spesso, i tramonti dai colori bellissimi quanto curiosi che vediamo nei dipinti di Turner - un po' rossi, un po' arancioni - sono il frutto dell’inquinamento…

RIFERIMENTI BIBLIOGRAFICI

Feyerabend, Paul K. e Christian Thomas (1989), Arte e scienza, Roma: Armando.

Greco Pietro (2013) (a cura di) Armonicamente. Arte e scienza a confronto, Milano: Mimesis

Odifreddi, Piergiorgio (2023), Arte e matematica, due visioni complementari per descrivere la realtà, in “Le Scienze”, 18 agosto,

Snow, Charles P. (1959), trad. it. Le due culture, Milano: Feltrinelli, 2017.

Le teorie del complotto, quarta parte – I miti della scienza intonsa e della politica senza bias

Questa è la quarta puntata della riflessione avviata due settimane fa. (prima parte, seconda parte, terza parte). Qui ci parliamo del fatto che una scienza intoccata, intonsa, libera da vincoli e condizionamenti, e quindi guidata solo dalla pura curiosità intellettuale, non è altro che un mito, alimentato anche dalla credenza che possa dirimere le questioni in una maniera scevra da pregiudizi. Il testo completo è stato pubblicato come prefazione al volume Matthieu Amiech, “L’industria del complottismo. Social network, menzogne di stato e distruzione del vivente” (Edizioni Malamente, 2024).

Elisa Lello.

IL MITO DELLA SCIENZA INTONSA

Se quella appena vista – la scienza può venire corrotta e strumentalizzata – è la ragione in fondo più facile da individuare tra quelle che dovrebbero indurci alla prudenza nel mettere la scienza al centro della politica, il problema è però decisamente più complesso. Perché il punto è che non è solo quando è corrotta, o volutamente strumentalizzata, che la scienza è influenzata da valori, interessi economici o politici, condizionamenti di tipo culturale, sociale o religioso. Anzi, in ogni sua fase – dalla scelta del tema, a quella dei metodi e della prospettiva, fino alla produzione e interpretazione dell’evidenza empirica – la produzione di conoscenza scientifica è condizionata da fattori altri, extra-scientifici. Molte/i colleghe/i all’interno delle scienze sociali, per parlare del mio campo disciplinare, rivendicano la propria identità di ricercatrici/tori militanti partendo proprio dalla consapevolezza che la posizione di chi fa ricerca non possa essere neutrale e dall’acquisizione che ogni sapere non possa che essere “situato”. Anche e forse soprattutto quello che si pretende oggettivo. Quello di una scienza intoccata, intonsa, libera da vincoli e condizionamenti, e quindi guidata solo dalla pura curiosità intellettuale, non sarebbe che un mito, come fa notare Sarewitz (1996), sulla scia di lunghe tradizioni di ricerca in diverse discipline.

Un mito pericoloso, tra l’altro: perché mentre certi tipi di condizionamento vengono stigmatizzati e destano scandalo (per esempio, le ricerche che dimostrano l’innocuità del fumo passivo o di certi pesticidi, di cui risulti la sponsorizzazione a opera delle lobby dei rispettivi settori), altre forme di influenza non meno importanti non destano alcun allarme, anzi sono naturalizzate come parte del normale così vanno le cose. Per esempio, il fatto che gli investimenti per la ricerca si concentrino nelle direzioni dove si addensano importanti interessi del complesso militare-industriale (per esempio, la costruzione di armi, la digitalizzazione, l’IA) lasciando sprovvisti aree e filoni di indagine che pure sarebbero più rispondenti alle esigenze di vita di ampi settori della popolazione mondiale; o la sproporzione di investimenti nella ricerca medica a favore di patologie che colpiscono i paesi più ricchi e bianchi rispetto a quelli più poveri e abitati da maggioranze con altre gradazioni del colore della pelle. Ecco: proprio il mito di una scienza intonsa, non condizionata, “pura”, impedirebbe, sottolinea ancora Dotson (2021), l’avviarsi di un dibattito circa le misure che potrebbero continuare a condizionare, ma questa volta in modo più democratico, equo ed emancipativo, la produzione della conoscenza scientifica. Per esempio, aprendo una discussione su quali aree e filoni di ricerca serve effettivamente privilegiare, e su chi sia chiamato a prendere decisioni in merito; o favorendo la partecipazione di scienziati e cittadini di paesi del Sud del mondo nell’elaborazione dell’agenda di ricerca. E molti altri esempi potrebbero seguire.

I BIAS INTRODOTTI DALLA PRETESA DI UNA POLITICA SENZA BIAS (SCIENTIZZATA)

La credenza fasulla e insidiosa che dovremmo aggredire è dunque quella secondo cui ci sarebbe una netta separazione tra scienza e politica, laddove è vero piuttosto il contrario, cioè che è difficile capire dove l’una finisca e l’altra inizi. Anche perché proprio questa falsa credenza costituisce il presupposto della crescente scientizzazione della politica (Pielke 2005) – da qui discendono le aporie e contraddizioni che questa pone.

Con scientizzazione della politica si intende la tendenza che si va affermando sempre più a descrivere controversie che contemplano aspetti sociali, etici e politici in termini esclusivamente scientifici; pretendendo che una scienza suppostamente oggettiva possa dirimere le questioni in una maniera scevra da pregiudizi (unbiased): meglio, dunque, di quanto farebbe quel vecchio e screditato arnese della politica, ambito della ricerca di sintesi e compromessi.

Se è vero che la ricerca scientifica può essere di utilità nell’elaborazione delle politiche, il punto è mettere a fuoco le criticità che si aprono qualora si decida di mettere la scienza al centro della politica e dei processi decisionali. Per iniziare, se è facile dire che è la scienza che deve decidere, le cose si complicano quando ci chiediamo quali expertise mobilitare, o quali discipline. È evidente come la controversia legata agli OGM – di vecchia o di nuova generazione che siano – venga letta in modo differente, e dia quindi risposte sempre scientifiche ma diverse e contrapposte, a seconda se utilizziamo le lenti dell’ingegneria genetica o quelle dell’ecologia (Dotson 2021). Altro effetto nefasto della scientizzazione della politica è la tendenza a marginalizzare conoscenze differenti da quelle degli esperti. Il non tenere conto, per esempio, che persone che non hanno titoli di studio specifici in un determinato campo detengano conoscenze, expertise, informazioni che possono essere non visibili alla disciplina scientifica degli esperti di turno, eppure decisamente rilevanti. Nella storia dei disastri e delle nocività industriali è una costante la denuncia, da parte delle popolazioni colpite, del diffondersi anomalo di patologie che vengono a lungo screditate come mera “aneddotica” (o isteria e fobia, dalla “radiofobia” dei cittadini di Černobyl, alle patologie delle vittime del piombo e dell’amianto… e che dire della mancanza di sorveglianza attiva e quindi di dati affidabili sull’epidemia di “nessuna correlazione” recente?)[1] dagli esperti di turno, e che saranno poi riconosciute come fondate e reali solo molto più tardi, solitamente quando è troppo tardi.

Infine, la scientizzazione in sé introduce a sua volta bias e distorsioni. Perché induce a dare importanza solo agli aspetti che più facilmente possono essere analizzati, misurati e tradotti in numeri e grafici.[2] Un punto, questo, di cui dovremmo essere consapevoli sia per imparare a maneggiare le narrative del potere, sia – e questo forse è ancora più cruciale, e meno evidente, ci torno in chiusura – nel mettere a punto le nostre risposte e resistenze.

Per esempio, basare le decisioni politiche sugli OGM (o sui TEA) su una valutazione puramente scientifica della loro pericolosità accertata per la salute umana o per l’ambiente significa far slittare verso i margini altre questioni che non sono certo meno importanti. Significa, per esempio, non vedere né prendere in considerazione i diritti dei coltivatori biologici, o delle società tradizionali o indigene, a coltivazioni non contaminate e alla conservazione, trasmissione e scambio non monetario di sementi tradizionali. Significa preferire la via del soluzionismo tecnologico – manteniamo il modello agroindustriale che mina la biodiversità e impone abuso di diserbanti e pesticidi e poi tamponiamo (forse) il problema creando varietà che ne richiedano minori quantità – anziché mettere in discussione il modello di agricoltura che è all’origine di quei problemi. Significa marginalizzare valutazioni circa la perdita di autonomia – e quindi la dipendenza sempre più forte dalle multinazionali, la diminuzione del numero di aziende e la concentrazione della proprietà etc. – che queste tecnologie impongono al settore, assestando l’ennesimo colpo ferale all’agricoltura contadina, che poi è la stessa direzione verso cui spinge la digitalizzazione dell’agricoltura 4.0.[3] E significa escludere qualunque possibilità di discutere circa la desiderabilità della visione del mondo che è sottesa a quelle tecnologie.

Ma anche il riduzionismo climatico può essere individuato come esempio. Se quella che attraversiamo è una crisi ecologica estremamente complessa, data dall’intrecciarsi di più dimensioni dell’inquinamento – dell’aria, delle acque superficiali e delle falde, del suolo, luminoso, elettromagnetico… – con i cambiamenti climatici, con la perdita di biodiversità e con questioni come il consumo e l’impermeabilizzazione del suolo, le nocività industriali, le servitù e l’industria militari, l’agroindustria, il sistema della logistica e della distribuzione (eccetera), è arduo mettere a punto strumenti di misurazione così come è politicamente scomodo e complicato elaborare risposte: perché queste, per essere efficaci, non possono eludere l’intreccio con la dimensione sociale né evitare di mettere al centro della critica il modello di sviluppo e quindi l’idea stessa di crescita.

Di fronte a tutto questo, isolare invece il cambiamento climatico dal suo contesto ambientale e sociale è una strategia che, se da una parte si presta meglio all’elaborazione di indicatori quantitativi, parametri e scenari predittivi che possano fungere da base per politiche evidence-based, dall’altra supporta una narrativa utile a un capitalismo che sussume nella sua logica di espansione perpetua la crisi ecologica stessa. Non solo la crisi ecologica non basta a mettere in discussione l’espansione capitalista: essa diventa un pretesto per la creazione di nuovi mercati e per dare nuovo slancio all’estrattivismo dipinto di green.

NOTE

[1] Un aspetto rilevante di questa vicenda è relativo ai cambiamenti nelle procedure e negli algoritmi utilizzati in seno all’OMS per rilevare il nesso di causalità tra vaccini ed effetti avversi, un tema trattato da Osimani e Ilardo (2022).

[2] Per di più, la colonizzazione da parte dell’industria degli ambiti di governance della scienza fa sì che il principio di precauzione venga scalzato da quello di innovazione: in questo modo, l’onere della prova slitta dall’industria verso coloro che dovrebbero dimostrare la pericolosità di sostanze e prodotti. L’assenza di evidenza del danno diventa così evidenza della sua assenza (Lello e Saltelli 2022).

[3] Si veda il contributo de l’Atelier Paysan, Agricoltura 4.0 e nuovi OGM: la tecnoscienza all'assalto del vivente, 1 novembre 2023, <www.laterratrema.org>.

RIFERIMENTI BIBLIOGRAFICI

Anonimo (2022), Manifeste conspirationniste, Parigi, Seuil.

Attwell K., Smith D.T. (2017), Parenting as politics: social identity theory and vaccine hesitant communities, “International Journal of Health Governance”, 22(3): 183-98.

Bazzoli, N., Lello, E. (2022), The neo-populist surge in Italy between territorial and traditional cleavages, “Rural Sociology”, 87(1): 662-691.