Le mani e la techne - Storia di un’origine mancata, da Platone a Latour

1. TECHNE E PREGIUDIZIO

Una delle eredità più durature di Platone è il sospetto nei confronti della techne. La necessità di separare il vero sapere dall’arte dei sofisti è il movente di questo pregiudizio: Protagora, Gorgia, Lisia, e i loro colleghi, inventano tecniche di persuasione di cui vendono la padronanza, o i prodotti, al miglior offerente, senza mostrare alcun interesse per la verità. La manipolazione persegue il vantaggio egoistico di chi la pratica, mentre il logos della filosofia (della scienza) è guidato dalla physis, segue la forma e le prescrizioni di ciò che rimane stabile nell’Essere. L’atteggiamento con cui si pretende di mostrare l’appartenenza all’aristocrazia del gusto e del senno attraverso il rifiuto dell’innovazione tecnologica, e tramite l’ostentazione di disorientamento tra le pratiche e i prodotti digitali, ancora oggi è un atto di accusa contro la corruzione sofistica della techne, e una proclamazione di fedeltà alla purezza dello spirito.

2. MANCANZA DI ESSENZA

Platone proponeva lo scavo interiore per partecipare alla natura inalterabile della verità: l’anamnesi riporta alla luce le idee, la cui eternità si rispecchia in quella dei cieli che insegnano al sapiente la via per la disciplina del sapere e del decidere. La metafisica ha fissato nell’opposizione tra physis e techne, o tra logos e doxa (ma questo significa anche tra trascendentale ed empirico, tra origine e decadenza) il criterio di separazione tra il filosofo e il sofista, anche quando la tesi dell’accesso ad una sfera di universali eterni ha perso la sua presa sulla comunità scientifica, e la moda ha imposto a tutti un atto di fede nell’empirismo. Come insegna Stiegler (1994), il dibattito seguito all’atto di nascita dell’antropologia moderna, con il Discorso sull’origine e i fondamenti della disuguaglianza tra gli uomini di Rousseau, avrebbe dovuto mettere in guardia da tempo sulla validità di questa disgiunzione, introducendo almeno un nuovo genere di sospetto, che colpisce l’autonomia della natura da un lato, la strumentalità reificante della techne dall’altro lato, e la loro opposizione reciproca.

L’uomo delle origini viene descritto da Rousseau come quello moderno: ha mani e piedi e cammina eretto. Leroi-Gourhan (1964-65) dimostra con la paleontologia che la deambulazione bipede permette la liberazione della mano per la costruzione di utensili e strumenti. E l’affrancamento della mano per la tecnica stabilisce un nuovo rapporto tra la mano, il volto e la parola. Quindi Rousseau immagina un uomo delle origini che ha già le caratteristiche di quello tecnicizzato; ma nel suo errore (molto istruttivo) lo descrive come un quasi-animale che non pensa e non si sposta, usa le mani per afferrare e non per produrre, cogliendo tutto ciò che la natura gli offre in modo spontaneo. Nell’origine il tempo (lo spazio, il mondo) non esiste, proprio perché l’uomo non frequenta alcun presagio cosciente della morte, e in generale nessuna forma di programma: non ha desideri né preoccupazioni, ma solo bisogni soddisfatti immediatamente da ciò che è a portata di mano. Il pensiero e il lavoro non vengono alla luce se non per placare passioni e paura – che a loro volta irrompono nella vita dell’uomo solo se la previsione ha aperto un mondo dove gli strumenti materializzati dalla tecnica sono programmati per proteggere dall’incombenza della morte.

L’istinto è costrittivo per gli animali: il gatto non mangia i tuberi o la frutta, in assenza di carne, e l’oca non mangia la carne in assenza di tuberi. L’uomo invece è libero di imitare il comportamento di qualunque animale, aprendosi la via alla soddisfazione del bisogno con la carne o con i tuberi, secondo la disponibilità. La libertà è una potenzialità dell’origine che annienta l’origine stessa nel momento in cui passa all’atto, perché la ragione che la realizza innesca quel mondo di tecnica e passioni che allontanano dall’immobilità e indifferenza originari. La libertà è la seconda origine dell’uomo, o la sua assenza di origine, la scomparsa o la mancanza di un’essenza. Le conclusioni speculative di Rousseau finiscono comunque per coincidere con quelle della paleontologia di Leroi-Gourhan.

Le passioni di Nietzsche, le pulsioni di Freud, la ragione di Hegel, la società di Hobbes, il lavoro di Marx non possono aspirare a descrivere la condizione essenziale dell’uomo, la sua origine, che invece è sempre già annullata nel momento stesso in cui l’ominazione viene messa in moto da progettazione e tecnica, e che procede con la storia del loro sviluppo: l’interiorità è un ripiegamento del programma di gesti con cui le mani fabbricano utensili, dello schema della loro applicazione per gli usi futuri, del piano per la loro disponibilità contro gli agguati della morte. Ma questa stessa filogenesi precipita nell’oblio (persa di vista da Rousseau e persino da Heidegger), dimenticata nell’eccesso di prossimità degli oggetti tecnici, resa invisibile nella disponibilità con cui i dispositivi sono sempre sottomano, cancellata nell’esperienza che in ogni epoca essi pongono in essere. Eppure, affinché intellettuali, politici e artisti possano ostentare il loro distacco dall’innovazione digitale e dalle tendenze delle comunità virtuali, affinché la spiritualità che effonde dal loro intimo possa segnalare a tutti la loro nobiltà d’animo, è necessaria tutta la storia delle tecniche, dalle tradizioni della coltivazione di tuberi e alberi da frutta, fino all’impaginazione di libri e riviste con InDesign e alla programmazione delle ALI che sviluppano testi e immagini pubblicati sui giornali internazionali. No techne, no party.

3. DISASTRI E SFERE

Sloterdijk (1998 e 1999) ricostruisce il processo con cui Copernico ha scoperchiato la Terra lasciandola esposta al freddo del cosmo, senza più l’involucro delle stelle fisse, e l’impegno con cui gli uomini hanno progettato sfere che tornassero ad avvolgerla e a riscaldarla. Eliminare la stabilità degli astri equivale a rimuovere l’architettura stessa della physis, il primo grande schema di design del mondo, che Platone ha posto come senso dell’universo, e come sistema di orientamento del saggio e della comunità: un vero e proprio disastro, cui è stato necessario rimediare attraverso la pianificazione di nuovi globi che hanno a più riprese protetto e dissolto i territori dei regni dell’Occidente, fino alla globalizzazione del mondo contemporaneo.

L’uomo non esce mai in una natura spontanea che si dispiega in un «fuori» dalle sfere in cui agiscono le tecniche di immunità e comunità programmate dalla tecnica. Nell’universo di Platone le stelle fisse sono attori della strategia politica che salda la società ateniese, almeno quanto lo è l’istituto degli arconti o quello della bulè: a loro è assegnata la regìa ideologica della forma di vita nella città e l’ontologia dell’uomo greco. Latour (1984) mostra come i miasmi siano attori della struttura civile che compie la trasformazione sei-settecentesca dello Stato dalla configurazione feudale a quella burocratica moderna: la nascita degli uffici di igiene pubblica, l’educazione della famiglia e la cura dei figli, la nuova morale borghese, la ristrutturazione urbanistica delle grandi città, la modellazione della rete dei servizi fognari e idraulici, sono le mosse della costruzione di più sfere immunitarie contro la diffusione di peste e colera, e il contesto di formazione delle metropoli della rivoluzione industriale e del primo capitalismo. La vittoria del movimento di Pasteur coincide con l’introduzione di un nuovo attore sociale, il microbo, che in parte prende il posto dei miasmi, ma che di fatto sviluppa un nuovo mondo di istituzioni mediche e di welfare, quella che conduce all’antropologia occidentale moderna e postmoderna, dove alla cura dell’individuo si sostituisce il presidio di un’intera tassonomia di agenti patogeni.

Il contributo sui Comunelli di Ferriere su Controversie mostra come un bosco non sia il «fuori» del villaggio, ma sia l’attore che ne consolida la comunità, arrestando il suo processo di disgregazione; quello su Gagliano Aterno evidenzia come la sfera di appartenenza alla comunità sia inscritta nella ripresa della tradizione della coltivazione dei tuberi e nell’innovazione della posa dei pannelli solari. Tuberi e alberi da frutto possono incrociare il programma genetico di alcune specie di animali, ed essere obbligati ad una simbiosi da cui non possono svincolarsi; per gli uomini il programma è tecnico, non è costrittivo ma deliberato, e come ogni gramma si iscrive negli attori coinvolti e viene regolato da una grammatica. Latour (2005) la tratteggia sul modello della grammatica attanziale di Greimas (1966), mostrando che ogni forma di vita si istanzia in una rete di relazioni tra ruoli registrati in attanti (malati, contadini, miasmi, batteri, canali fognari, tuberi – a pari diritto umani o non umani), il cui grado di integrazione nella sintassi del programma misura il livello di tenuta o di dissoluzione della società in cui esso si esprime. La struttura di rapporti da cui è disegnata la rete manifesta un significato, come le isotopie narrative di Greimas, che può essere tradotto nel programma di comportamento di altri sistemi: a loro volta, questi possono essere intercettati e arruolati – l’interazione dei turisti con la foresta di Ferriere si traduce nell’inserimento in una sfera di appartenenza territoriale, il contatto tra la nuova urbanistica del Settecento e la privatizzazione dei terreni agricoli (Enclosure Act 1773) alimenta la prima rivoluzione capitalistica, l’incontro tra il movimento della «pastorizzazione» e l’espansionismo coloniale apre la globalizzazione moderna.

Ora che il cielo non è più la cupola delle stelle fisse e delle scorribande degli dèi iperurani con le loro bighe, ma una sfera della quale ci dobbiamo prendere cura rammendando i buchi nella maglia di ozono – l’Actor Network Theory di Latour invita ad abbandonare la ricerca della verità in una psyché che, comunque interpretata, continua a macinare la metafisica delle idee di Platone: chiede di imparare a osservare un mondo dove l’uomo non esce mai in spazi non pianificati, ma progetta ambienti e tempi che sono sottoposti a revisioni continue. Rivendica la necessità di rendere questa attività di design finalmente consapevole e condivisa.

BIBLIOGRAFIA

Greimas, Algirdas Julien, Sémantique structurale: recherche de méthode, Larousse, Paris 1966.

Latour, Bruno, Les Microbes. Guerre et paix, suivi de Irréductions, Métailié, «Pandore», Paris 1984.

Latour, Bruno, Reassembling the social. An introduction to Actor-Network Theory, Oxford University Press, Oxford 2005.

Leroi-Gourhan, André, Le Geste et la Parole, Albin Michel,Parigi 1964-65.

Sloterdijk, Peter, Sphären I – Blasen, Mikrosphärologie, Suhrkamp, Frankfurt am Main 1998.

Sloterdijk, Peter, Sphären II – Globen, Makrosphärologie, Suhrkamp, Frankfurt am Main 1999.

Stiegler, Bernard, La Technique et le temps, volume 1: La Faute d’Épiméthée, Galilée, Paris 1994.

Neuralink e la nuova aristocrazia della salute - Silicio e bulimia di potenza

1. Le mani, i piedi, il logos

Non so se Elon Musk conosca la ricerca paleontologica di Leroi-Gourhan (1964-65, Le Geste et la Parole), ma di sicuro ne condivide l’intuizione di fondo: la ragione, l’essenza e il destino dell’uomo (e anche di qualunque cosa debba sopraggiungere dopo di lui) non risiede nel cervello, ma nei piedi e nelle mani. L’andatura bipede ha reso possibile la liberazione degli arti superiori per la fabbricazione di utensili e per lo sviluppo delle tecniche: sono queste la natura dell’uomo, la sua origine, che ha trasformato il suo volto e il suo cranio di primate nella sede della parola. Neuralink è il progetto, nato nel 2016, che Musk ha finanziato in prima persona con 100 milioni di dollari; ha come obiettivo l’impianto di interfacce neurali capaci di curare gli effetti di patologie del sistema nervoso, anzitutto la tetraplegia. In altre parole, l’installazione nel cervello di un piccolo hardware, governato da un’intelligenza artificiale, permetterebbe di ripristinare l’uso di gambe e braccia nei malati di paralisi, in misura almeno parziale. La simbiosi tra fisiologia e tecnologia per finalità mediche non è proprio una novità: in fondo la sperimenta ogni giorno chiunque indossi un paio di occhiali. Ma per Elon Musk, che aspira a raggiungere l’infinito (e oltre) come Buzz Lightyear, l’AI di Neuralink rappresenta il primo passo del programma transumanistico di potenziamento degli esseri umani fino al limite delle loro risorse fisiche e intellettuali – per poi oltrepassare la soglia della singolarità, verso un destino non più assimilabile a nulla che sia depositato nell’esperienza della storia, e su cui siano impossibili previsioni di qualunque genere.

2. Il famedio dei macachi nel paradiso della scienza

Fino a qui, in apparenza, tutto bene. Lo scorso 29 gennaio Musk ha annunciato su X il primo innesto di Neuralink su un paziente tetraplegico: la sperimentazione si è trasferita dagli animali agli esseri umani. Può turbare questo clima di entusiasmo la notizia che la Securities and Exchange Commission (SEC) ha aperto un’inchiesta contro l’azienda e il suo fondatore per la morte dei macachi su cui sono stati testati i dispositivi. L’accusa è di non aver allevato martiri gloriosi e necessari per il progresso della scienza, ma di aver perpetrato agonie atroci, provocate dal desiderio di Musk di installare il chip al di sotto della rete vascolare, al fine di raggiungere una larghezza di banda superiore a quella delle società concorrenti. Contro le accuse sollevate dalla stampa americana, il magnate ha dichiarato che i laboratori di Neuralink sono una specie di «paradiso per le scimmie». In attesa che gli investigatori verifichino quanto la potenza del segnale sia qui sinonimo di santità o di crudeltà, formuliamo un paio di riflessioni sul significato che il progetto Neuralink può rivestire per la nostra società, assumendolo come un esempio del tipo di progetti su cui non solo Elon Musk, ma tutti i giganti della Silicon Valley stanno investendo, con una prodigalità di fondi con cui nemmeno le finanze degli stati sovrani possono competere.

3. L’agenda politica

In prima istanza, occorre sottolineare che Elon Musk, come altre Big Tech, coltiva un progetto antropologico, cioè una vera linea politica, attribuendosi un compito cui le classi dirigenti dei principali paesi occidentali hanno abdicato da anni. Il transumanesimo sogna un futuro di superuomini con ipertrofia di prestazioni fisiche e intellettuali, dovuta ad un doping permanente di innesti tecnologici, elargito a pochi o a molti (secondo l’opportunità comunicativa del momento) – ma comunque assicurato all’élite più smart del mondo, quella degli innovatori con sede in Silicon Valley. D’altra parte sono loro a prevedere e a pianificare l’evoluzione della salute, dell’abitazione, della convivenza, attraverso la rivoluzione delle applicazioni smart della wearable technology, della smart home e della smart city. Meritano il meglio della bulimia di potenza che sopraggiungerà con le AI, inclusa l’immortalità con (versione Kurzweil) o senza (versione Musk) il trasloco della personalità in un corpo di silicio.

Si può ironizzare su questo disegno per il futuro dell’umanità, che sembra estratto dai cartoon dei supereroi, ma bisogna riconoscere anzitutto che, contrariamente alla vacuità a corto raggio delle agende politiche delle classi dirigenti internazionali, Musk dispone di un piano con una visione di ampia portata, declinato in progetti che dal punto di vista finanziario camminano con le proprie gambe, senza attendere interventi pubblici – e spesso in grado di rastrellare investimenti da fonti terze. La forza economica e l’ambizione delle sue imprese sono in grado di attirare i ricercatori di maggiore talento, e di configurare la salute e i servizi del futuro. Dal Rinascimento gli intellettuali sanno di poter scorgere un orizzonte di verità più ampio, perché la posizione del loro sguardo è sorretta dalle spalle dei giganti del passato, di cui ereditano l’esperienza. Noi oggi dobbiamo sospettare di essere scesi dalle spalle ai piedi, dal momento che la ricerca cammina con le gambe di Musk, di Kurzweil e dei loro alleati. Poiché sono tutti soggetti privati, e il loro intervento sta sostituendosi al welfare pubblico, reimpostandone la definizione e i contenuti, è legittimo domandarsi se ci dobbiamo preparare ad un futuro prossimo in cui l’umanità (anche occidentale) avrà una nuova struttura sociale: sarà divisa in una piccola élite che può aspirare ad una qualità della vita altissima e ad una longevità di larghe falde – ancorché non infinita – e in una massa di individui esclusi da questa prospettiva, e dipendenti dal tipo di formazione culturale, di offerta di intrattenimento, di selezione commerciale, che proverrà da questi stessi soggetti privilegiati.

4. Lussi che non ci possiamo permettere

All’inizio degli anni Settanta lo psicologo comportamentista Burrhus Skinner aveva dichiarato senza reticenze che la libertà è un lusso che non ci possiamo permettere. Il condizionamento operante che aveva sperimentato ad Harvard (e non solo, secondo le tesi di chi lo considerava molto integrato negli apparati della CIA e della NATO) doveva condurre ad una società ordinata, dove la libertà era consentita a tutti coloro che condividevano l’ideologia dello Stato, pronta a respingere qualunque seduzione della propaganda bolscevica. Qualora davvero riuscisse a funzionare, anche solo in parte, Neuralink potrebbe riuscire dove il metodo di Skinner ha fallito: un chip di AI innestato direttamente nel cervello, con un potenziale di innervazione a banda larga, può agire come uno strumento di controllo e di condizionamento di massima efficacia. Le gambe ci porteranno dove l’ordinamento sociale programma che le nostre attività saranno di maggiore utilità, e le mani cliccheranno sui pulsanti che saranno indicati dalla pubblicità veicolata dalle concessionarie di Musk. Uno scenario distopico molto più spaventoso, e comunque meno irrealistico, di quelli che Elon Musk si impegna a propagandare sull’intelligenza artificiale generale – in particolare quella non dominata da lui in prima persona, o dagli amici della setta degli Altruisti Efficaci.

Le società tecnocratiche della disciplina e del controllo - Deleuze, Foucault e Kafka

LA SOCIETÀ DELLA DISCIPLINA

La società della disciplina è qualcosa del passato.

È una conclusione che si può trarre sia da dagli ultimi capitoli di Sorvegliare e punire (Foucault M., 1975) che dall’analisi di Michel Foucault ne La volontà di sapere (1976) ed esplicitata una terza volta da Gilles Deleuze nel Poscritto sulla società di controllo (1990), «le società disciplinari erano già qualcosa del nostro passato, qualcosa che stavamo smettendo di essere» (cit., p. 234).

Provo a ricordare i tratti funzionali della “società della disciplina”: la funzione principale è “disciplinare in stato d’internamento attraverso la sorveglianza e la punizione”, operata da un campo di tecnici appoggiati a saperi extra giuridici: il medico, il militare, la guardia, l’insegnante di scuola.

La questione in gioco nella riflessione sulla società disciplinare non è tanto se vi siano esperti, tecnici, o se costoro occupino le sale del potere, ma, piuttosto, «come si esercitano quel sapere e quel potere» (Deleuze G., 2018, Foucault, p. 88), come l’esercizio del potere produca degli esperti. Come suggeriva Foucault, non possiamo vedere il potere, ma soltanto i suoi effetti (cit.).

Questo, oltre a riguardare ad un tempo oppressi e oppressori, riguarda anche gli strumenti tecnici, le architetture, le invenzioni tecno-scientifiche, che rappresentano «sintomi» di una macchinazione sociale più complessa.

È qualcosa, diceva Deleuze, che aveva in mente anche Kafka, che «non ammira affatto una semplice macchina tecnica, ma sa bene che le macchine tecniche sono soltanto degli indizi per un concatenamento più complesso che fa coesistere macchinisti, pezzi, personale e materiali, carnefici e vittime, potenti e impotenti» (Deleuze G, Guattari F., 1975, Kafka, p. 88).1

Sorta all’alba della nostra modernità occidentale (XVII secolo), la disciplina ha impiegato circa due secoli per arrivare al suo stesso apogeo nell’architettura fantastica del Panopticon, l’utopico carcere immaginato alla fine del Settecento da Jeremy Bentham, «macchina per dissociare la coppia vedere-essere visto: nell’anello periferico si è totalmente visti, senza mai vedere; nella torre centrale, si vede tutti, senza mai essere visti» (M. Foucault, 1975, Sorvegliare e punire, p. 220).

Si tratta di una società che muove i primi passi con la rifunzionalizzazione del confinamento: «la prigione aveva un’esistenza marginale nella società di sovranità, ma nella società di disciplina oltrepassa una soglia tecnologica» (Deleuze G, Guattari F., 1975, Kafka, p. 55).2 Disciplinare riesce in condizioni di internamento tramite la punizione corporale e la divisione e ristrutturazione cellulare dello spazio e del tempo. Eppure, da principio è necessario che vi sia la possibilità stessa di pensare l’internamento e di formare un diagramma che ne permetta l’applicazione: tecnica sociale, prima ancora d’essere tecnica materiale.

L’internamento panottico è di tutt’altra natura rispetto agli internamenti della prima modernità: la punizione non deve essere più applicata, ma tramutata in funzione deterrente; la sorveglianza non agisce direttamente, ma si proietta all’interno di ogni detenuto; di qui «l’effetto principale del Panopticon: indurre nel detenuto uno stato cosciente di visibilità che assicura il funzionamento automatico del potere. L’obiettivo è: “Far sì che la sorveglianza sia permanente nei suoi effetti, anche se è discontinua nella sua azione; che la perfezione del potere tenda a rendere inutile la continuità dell’esercizio […] in breve, che i detenuti siano presi in una situazione di potere di cui sono essi stessi portatori” (Foucault M., 1975, Sorvegliare e punire, p, 219).

Allora, cosa fa sì che la società della disciplina sia qualcosa del passato?

Foucault, diceva Deleuze, è stato frainteso come teorico dell’internamento. Certo lo è stato, ma «la prigione rimanda a una funzione agile e mobile, a una circolazione controllata, a tutta una rete che attraversa anche ambiti liberi, e che può insegnare a fare a meno della prigione» (Deleuze G., 2018, Foucault, p.57).

Insomma, si è scambiato l’essenziale per il contingente, ciò che c’è a monte con ciò che c’è a valle, la causa per l’effetto.

Non si può rispondere alla domanda sul potere se non si guarda a ciò che l’architettura panottica produce, a come il potere si esercita, appunto, al diagramma.

Difatti, senza materiale umano il panottico è nulla. Con un materiale umano, è un meccanismo di soggettivazione che produce un calco.

La sorveglianza e la punizione, operate in seno all’architettura di visibilità quale è quella del panottico, si tramutano da azione sul corpo a induzione psicologica. Porre l’internato in costante posizione di visibilità attraverso lo stato di attenzione persistente induce un disciplinamento, reso a sua volta possibile dalla divisione cellulare dello spazio e del tempo. Ne risulta la produzione di un calco: il malato, l’operaio, l’internato, ossia gruppi discreti “a metà” tra l’individuo singolarizzato e la massa indiscriminata.

Eppure, dalla fine della Seconda guerra mondiale - è sempre Deleuze a parlare - «siamo in una crisi generalizzata di tutti gli ambienti di internamento» (G. Deleuze, 1990, Poscritto, p. 235).

LA SOCIETÀ DEL CONTROLLO

Questa crisi è ciò che aveva già messo in scena Kafka nel Processo, lo stesso Kafka che rappresenta una «cerniera tra la società della disciplina e la società di controllo» (cit. p. 237). Perché in quel romanzo scritto tra il 1914 e il 1915, «Kafka ha descritto le forme giuridiche più temibili: l’assoluzione apparente della società disciplinare (tra due internamenti), il differimento illimitato delle società di controllo in continua variazione» (cit. p.237).

E Foucault, sempre in Sorvegliare e punire, scriveva che c’è una «proliferazione dei meccanismi disciplinari», una tendenza a «disistuzionalizzarsi», ad «uscire dalle fortezze chiuse dove funzionavano, ed a circolare allo stato libero» (G. Deleuze, 1975, Sorvegliare e punire, p. 230).

Aprite il Processo. Nelle primissime pagine trovate una rappresentazione piuttosto lucida di tutto ciò. Il protagonista, “K.”, si trova due guardie in casa che trasformano una stanza in tribunale, «il comodino adesso era stato allontanato dal letto e spinto nel centro della camera, per servire come banco da udienza, e l’ispettore sedeva dietro di esso» (Kafka F., 1973, Il processo, p. 20).

L’aula di tribunale può essere dappertutto. L’imputato non sa perché sia imputato, da chi è imputato, e può comunque vivere “liberamente” la propria vita. È in arresto o è libero? «Lei è in arresto, certo, ma a cosa non deve impedirle di svolgere la sua professione» (cit. p. 25).

Il processo è dappertutto e coinvolge tutti, è costantemente differito, e tutti danno vita al grande processo, anzi, tutti non sono che soggetti collaterale di quest’ultimo, «i personaggi del Processo appaiono in una generale serie che prolifera senza sosta: tutti in effetti sono o funzionari o ausiliari di giustizia» (Deleuze G, Guattari F., 1975, Kafka, p. 83).

Dunque, che vi sia una «crisi degli internamenti» ha un significato piuttosto inusuale. Se c’è crisi, non è perché l’internamento non ha funzionato, ma perché - come si diceva - le forze disciplinanti che adoperavano il confinamento e la scomposizione cellulare trovano punti d’applicazione che non necessitano più la forma d’applicazione del potere necessario precedentemente. Deleuze lo descrive con una frase molto semplice, «gli internamenti sono stampi, dei calchi distinti, ma i controlli sono una modulazione, qualche cosa come un calco auto deformante che cambia costantemente» (G. Deleuze, 1990, Poscritto, p. 236).

Cambia fondamentalmente la posizione della disciplina, che da funzione principale per l’estrazione della forza lavoro scivola in secondo piano, diventa funzione collaterale o derivata.

Per il controllo, l’internamento diventa superfluo perché a monte è diventato superfluo produrre l’individuo disciplinato della società precedente.

La linea direttrice della società di controllo è «un meccanismo di controllo che dia in ogni momento la posizione di un elemento in ambiente aperto» (cit. p.240), e come scriveva Deleuze già nel 1990 «l’impresa ha sostituito la fabbrica […] la formazione permanente tende e a sostituire la scuola, e il continuo controllo ha sostituito l’esame» (cit. p.240).

Osserviamo il diagramma della società di controllo: non produce più calchi, ma dividui, che non sono più singoli soggetti facenti parte di un gruppo (medico o paziente, guardia o internato, a “metà” tra individuo e massa), ma una divisione temporalmente mutevole in seno all’individuo stesso.

Insomma, il controllo non solo è ora capace di estrarre valore dalle pulsioni multiple che sottendono l’individuo, ma come onnipresenza silente, è ora capace di modellare in modo continuativo ciò a cui in precedenza applicava calchi discontinui, il desiderio. Perciò più che formare un individuo fisso ha interesse nel direzionare i corsi multipli del desiderio che “fanno un individuo”, costringe all’espressione più che reprimere le pulsioni.

Tuttavia, il controllo non ha un interesse capillare, non deve lavorare direttamente sul singolo individuo, è un metodo statistico.

ATTUALITÀ DELLA SOCIETÀ DEL CONTROLLO

È sufficiente intercettare e ridistribuire un numero necessario di dividui per generare una massa critica: Cancel Culture, bolle mediatiche, grandi proclami di pro e contro, sono tutti prodotti di un sistema fluttuante che si avvale di grandi masse di desiderio per la creazione di temporanee forme dicotomiche che l’attimo dopo si sono già disfatte a favore di qualcosa di nuovo.

Non c’è più un calco fisso di gruppi, formati a “metà” tra la massa e l’individuo. La massa statistica dei dividui assomiglia, più che semplice fluido, ad un materiale non newtoniano: liquido e penetrabile in uno stato di quiete, solido e mortale appena è messo in moto.

Ahimè, non esiste il mondo contemporaneo in cui grandi forze ingenuamente rivoluzionare hanno sconfitto o sono in procinto di sconfiggere il tremendo mondo patriarcale delle restrizioni e dell’oppressione.

Quello che esiste è un mondo diverso dalla società della disciplina, è un mondo del controllo che si nutre del fatto stesso che qualcuno creda ancora alla liberazione delle passioni. Uno è un calco, l’altro è una modulazione. La disciplina determina dei comportamenti, il controllo sviluppa degli spettri d’azione. Ma proprio perché tutto ciò, ora, avviene in condizione di apparente apertura, e non più di internamento, e avviene non più attraverso il deterrente della punizione, ma con la modulazione di desideri apparentemente spontanei e liberi - perché ancora ci convinciamo vi sia «un desiderio esterno al potere» - l’azione e gli effetti del potere diventano ad un tempo più pervasivi ed invisibili. E tanto più il desiderio si dichiara assolutamente spontaneo, tanto più possiamo sospettare che ciò che vi sottostà sia il più capillare dei poteri.

Perciò, prendendo in prestito le parole di Kafka, Deleuze e Guattari scrivevano che bisogna «essere non uno specchio ma un orologio che anticipa» (Deleuze G, Guattari F., 1975, Kafka, p.92). Perché al tempo sempre-ora delle fluttuazioni di desiderio bisogna opporre la precisione di un orologio che immagazzina la struttura presente per anticiparne il futuro, perché chi agisce con perfetta spontaneità, vedendo nella buona società che immagina un riflesso dei propri intenti migliori, non si accorge che è il controllo l’immagine reale, e lui o lei l’immagine riflessa.

NOTE

1 In Foucault, p. 54, si legge «le macchine sono sociali prima di essere tecniche».

2 Foucault ne parla in Sorvegliare e punire, p. 244.

La conoscenza pratica dei “non esperti”: le empeiria kai tribé e lo strumento della retorica

Con questo terzo post1 andremo a completare la ricostruzione del pensiero di Platone che riguarda la conoscenza finalizzata alla pratica. Nel primo abbiamo visto come egli descrive la facoltà della Memoria e il ruolo che questa svolge nella conservazione del sapere dall’essere umano; nel secondo post abbiamo visto che cosa è definibile come “arte tecnica” (techne) e perciò che cosa sia un sapere pratico strutturato e disciplinato.

Qui ci occuperemo di comprendere meglio quelle forme del sapere pratico che come il sapere tecnico sono il frutto dell’esperienza e guardano all’utilità, ma che, diversamente da questo, non si strutturano in una disciplina e rimangono perciò un “saper fare” di possesso individuale, “al portatore”.

In conclusione verranno proposte al nostro lettore alcune riflessioni e domande che possono essergli di spunto per avviare una propria lettura di questo tema nel mondo attuale.

Le «empeiria kai tribé»2

Nei suoi dialoghi Platone ci avverte che vi sono “tecniche propriamente dette” e altre pratiche che, anche se da molti son chiamate “tecniche”, non lo sono affatto, poiché prive di un rigore disciplinare, ossia di teoria, metodo, pratica e/o finalità produttive precisabili.

Il termine utilizzato per indicare questi saperi pratici ma non tecnici è quello di empeiria kai tribé, ossia quei tipi di esperienza empirica (empeiria) che, grazie all’esercizio (tribé) pratico, vengono raffinati fino ad assicurare al loro esecutore l’ottenimento di un effetto. La loro efficacia o meno viene esperita di volta in volta da chi le pratica, che, attraverso la formulazione di congetture necessarie all’occorrenza, si doterà man mano dell’esperienza bastevole a produrre l’effetto desiderato.

Le empeiria kai tribé sono quelle forme del “saper fare”, possedute da chi viene detto “bravo a fare” qualcosa e che appare agli occhi dei non esperti un “tecnico”, anche se privo di una vera competenza nel campo in cui “fa”, ma ritenuto tale in virtù della sua sola capacità, abitudine e disinvoltura “nel fare”, che ha acquisito autonomamente (senza essere stato adeguatamente formato) esercitandosi nel tempo per “tentativi ed errori”.

Questa è la condizione di possesso della forma di conoscenza empirica più semplice, ossia quella della sola memorizzazione di meccaniche dell’azione in vista della produzione di un effetto.

Platone dedica una riflessione apposita3 a queste forme del sapere perché, per questa loro natura di grado conoscitivo insufficiente perché siano strutturabili in una forma disciplinare, rimangono un semplice “saper fare” frutto dell’esperienza individuale e nulla di più.

Per usare un esempio non platonico, il portatore della sola empeiria kai tribé somiglia al famoso “cugino” che “è bravo a fare”, i cui risultati non sono evidentemente il frutto di una conoscenza tecnica, anche se talvolta (si spera) equipollenti sul piano del prodotto finale. Egli “è pratico”, ma non è “un esperto” o un cosiddetto “professionista”.

Per comprendere meglio questa differenza tra arte tecnica ed “esperienza frutto dell’esercizio”, prenderemo ora in esame tre esempi che ci ha fornito lo stesso Platone nei suoi dialoghi.

Il flautista del Filebo

La “arte” del flautista «armonizza gli accordi non secondo misura, ma secondo congetture dedotte dalla pratica e da tutta la musica» e che «ricerca la misura della vibrazione di ciascuna corda andando per tentativi» (56 a).

Questo flautista a cui si riferisce acquisisce la propria esperienza in chiave dilettantistica. Egli prima prende tra le mani il flauto per capirne la struttura, poi, come ha visto fare ad altri, soffia nell’imboccatura e prova a emettere un suono. Procede sviluppando una sua successione di movimenti che corregge finché corrispondono a una serie di suoni tonali e ripete così l’esercizio fino a memorizzarli. Egli compone la sequenza di gesti - e non di note, visto che non le conosce, né le sa definire – imitando le melodie che ha già udito dai musicisti, forse scegliendo tra quelle che ritiene essere gradevoli in quanto ha udito essere maggiormente apprezzate tra le persone. Quando finalmente il flautista uscirà dal suo privato per esibirsi di fronte a un pubblico, ne guarderà e valuterà la risposta per capire se la propria esecuzione “funziona”, ossia viene da esso accolta favorevolmente.

Ripete poi tutte queste cose dette fino a quando non giungerà a formulare una propria esecuzione (di gesti e soffi!) che avrà come effetto l’approvazione della maggior parte degli ascoltatori che incontra e che, per questo motivo, di esso diranno essere “un bravo flautista”.

Il musicista, diversamente da questo flautista, è invece un vero “teknos”, ossia un esperto, perciò un tecnico professionista dell’esecuzione e della composizione musicale. Questo poiché ha intrapreso un percorso di studi specializzandosi nel tempo sotto la guida dei maestri di musica, perciò dei tecnici esperti che insegnano quest’arte, imparando a conoscere cosa sia la materia sonora nei suoi elementi e la tecnica necessaria a produrre armonie musicali. Inoltre, il musicista ha appreso l’arte attraverso tutti gli strumenti musicali, anche quelli più difficili da suonare e da governare rispetto al flauto.

Platone ci dice che il musicista si differenzia poi a sua volta dal musico, il quale ha invece conoscenza scientifica (episteme) della musica, in quanto si occupa non di produrre le armonie sonore, bensì di conoscere il loro rapporto armonico numerico (Platone,Phil. 17 c - d, cfr. Phaedr. 268 e). Ai tempi di Platone la Musica è infatti, oltre che l’arte della composizione di suoni come è oggi intesa, anche una seconda disciplina che studia le armonie numeriche secondo il rigore dell’aritmetica e del logismos,4 in questo caso nel campo di studio dei matematici.5

In conclusione, il procedere per tentativi senza il supporto di una conoscenza tecnica, fa sì che il flautista del Filebo sia un mero esecutore di gesti e non invece di note musicali, le quali saranno solo una conseguenza del suo soffio nello strumento e del movimento delle sue dita su fori dello stesso, che egli ha imparato corrispondere all’erogazione dei suoni desiderati. Compie tutto ciò pur non sapendo né dare un nome a ciò che fa né una spiegazione tecnica o matematica delle note di cui fa uso.

Il cuoco e il medico del Gorgia

Il medico è colui che si occupa del corpo pensando al bene che deve procurargli, mentre il cuoco ha come scopo quello di procurare al corpo un piacere fine a sé stesso.6

Se l’esempio del flautista pone l’accento sullo scarso rigore e la totale assenza di conoscenza specialistica nel campo di azione in cui egli opera, nell’esempio del cuoco e del medico emerge la problematica del grado di conoscenza che chi opera possiede dell’oggetto su cui agisce.

Entrambi, medico e cuoco, mirano a produrre un effetto sul medesimo oggetto, ossia il corpo, ma ciò che manca nella teoria e nella pratica del secondo è la conoscenza di questo oggetto per ciò che esso è, interessandosi ad esso solo come oggetto che patisce.

Il cuoco ha di mira il procurare la “sensazione di benessere”, il medico quella di ripristinarne il benessere inteso come “salute”.7 Il medico può infatti trovarsi a dover operare in seguito al danno prodotto dagli eccessi del cibo, però, nel suo caso, con una conoscenza rigorosa e “scientifica” del corpo, dunque in coerenza con e nel rispetto dell'oggetto su cui agisce.

La retorica del sofista nel Gorgia

Il buon politico ha di mira la produzione di un effetto tecnico, precisamente quello amministrativo, e utilizza la retorica come strumento per indirizzare i propri cittadini verso il bene derivante dal rispetto per le leggi della città. L’effetto ricercato dal sofista attraverso la retorica è sempre quello di indirizzare il pensiero e le passioni del cittadino, ma non verso un punto preciso. Piuttosto egli ricerca l’accrescimento della propria fama grazie al suo “saper parlare bene”, nel senso del “saper fare” leva sul pensiero del suo uditorio attraverso il discorso parlato, spesso superficiale e privo di contenuti, dunque mirato alla sola produzione di un effetto fine a sé stesso: la persuasione (peithó)8 attraverso l’espediente dell’adulazione (kholekheia) (Gorg. 463 a – b).

Inoltre, se il filosofo si occupa di indagare scientificamente gli oggetti della conoscenza e utilizza la retorica per coinvolgere il proprio interlocutore a partecipare nella costruzione di un pensiero comune, il sofista spesso non conosce ciò di cui parla benché ne parli e guarda all’uditorio solo per monitorare gli effetti che producono le proprie parole.

Il sofista “sa parlare bene” e lo fa perseguendo scopi e fini estranei ai temi di cui parla. Ricerca il favore del pubblico modificando man mano i propri discorsi sulla base degli effetti che le parole hanno su di esso.

Più in generale, leggendo il Gorgia, il Protagora e il Sofista, emerge che il sofista non è un teknos, non essendo in possesso né di un’arte né di contenuti specialistici. Egli possiede le sole strategie discorsive personali che gli sono utili per produrre l’effetto desiderato sul proprio pubblico.

Egli “è bravo a” incantare l’uditorio e vincere con le parole. Solo in questo appare possedere una tecnica.

Alcuni spunti di riflessione guardando al mondo contemporaneo

Ora che abbiamo preso confidenza con il tema delle forme di sapere pratico ma non tecnico, proporrò due campi di riflessione su cui concentrare la nostra analisi: 1) le empeiria kai tribé di oggi e 2) il ruolo odierno della retorica.

1) Sulle forme attuali di empeiria kai tribé abbiamo in parte già suggerito alcuni spunti riflessivi nel post sulla tecnica in Platone, dove proponevo al nostro lettore di considerare le dinamiche di ritorno alle pratiche analogiche contro il diffondersi di quelle digitali e di pensare al ruolo che svolge il fiorente mercato dell’accesso rapido alle conoscenze pratiche, ad esempio i “workshop”, nella formazione di nuove forme del “saper fare”. Ripensiamo ora a questi aspetti nella chiave del flautista del Filebo, ossia a quali siano le forme di conoscenza e competenza possibili per una stessa pratica e quali i percorsi che portano invece a formare i veri saperi tecnici e teorici o il semplice “saper fare”.

2) Il “saper parlare” è sicuramente una dote o una capacità che suscita fascinazione nel prossimo. Questo fenomeno non è cambiato dai tempi di Platone ad oggi e accompagnerà il genere umano probabilmente lungo la sua intera esistenza. Questo è un motivo che mi induce a pensare che sia necessario soffermarsi qualche riga in più su questo tema.

Già ai tempi di Platone, e dunque non solo di recente, la retorica era vista come una pratica ambigua e potenzialmente problematica nel campo comunicativo per la sua capacità alterante e distorsiva. Essa può mutare la direzione che prendono i discorsi in base ai contesti e alle caratteristiche dell’uditorio, divenendo, grazie alla sua forza plasmatrice, un potenziale mezzo di manipolazione degli stati d’animo.

Se il suo utilizzo è di per sé neutro, potremmo invece ricercare le cause del suo risvolto “negativo” o “dannoso” nelle competenze e nelle intenzioni di chi la utilizza.

Benché anche per essa sia possibile astrarre delle “regole”, la retorica rimane forse ancora oggi un solo strumento più che una tecnica. La sua possibilità di utilizzo per fini poco costruttivi potrebbe derivare anche dalle caratteristiche che ne individua Platone: essa è acquisibile attraverso l’emulazione dei discorsi fatti dagli altri (impostazione dei toni, utilizzo di frasi “fatte” o “ad effetto”, riproposizione di contro-argomentazioni e fallacie logiche versatili per ogni “avversario”, etc.) e rafforzabile con l’esercizio autonomo. Tant’è vero che non deve la sua efficacia alla propria applicazione di per sé, mentre è efficace per le doti di chi ne fa uso.

Sempre seguendo Platone, domandiamoci poi se potrebbe essere anche che i suoi risvolti problematici derivino dalla sua intrinseca possibilità di essere acquisita senza il possesso da parte del suo utilizzatore di particolari conoscenze o competenze, o anche dal fatto che la sua efficacia sia completamente svincolata dall’applicazione di regole e dall’esistenza di reali contenuti interni al discorso che dirige.

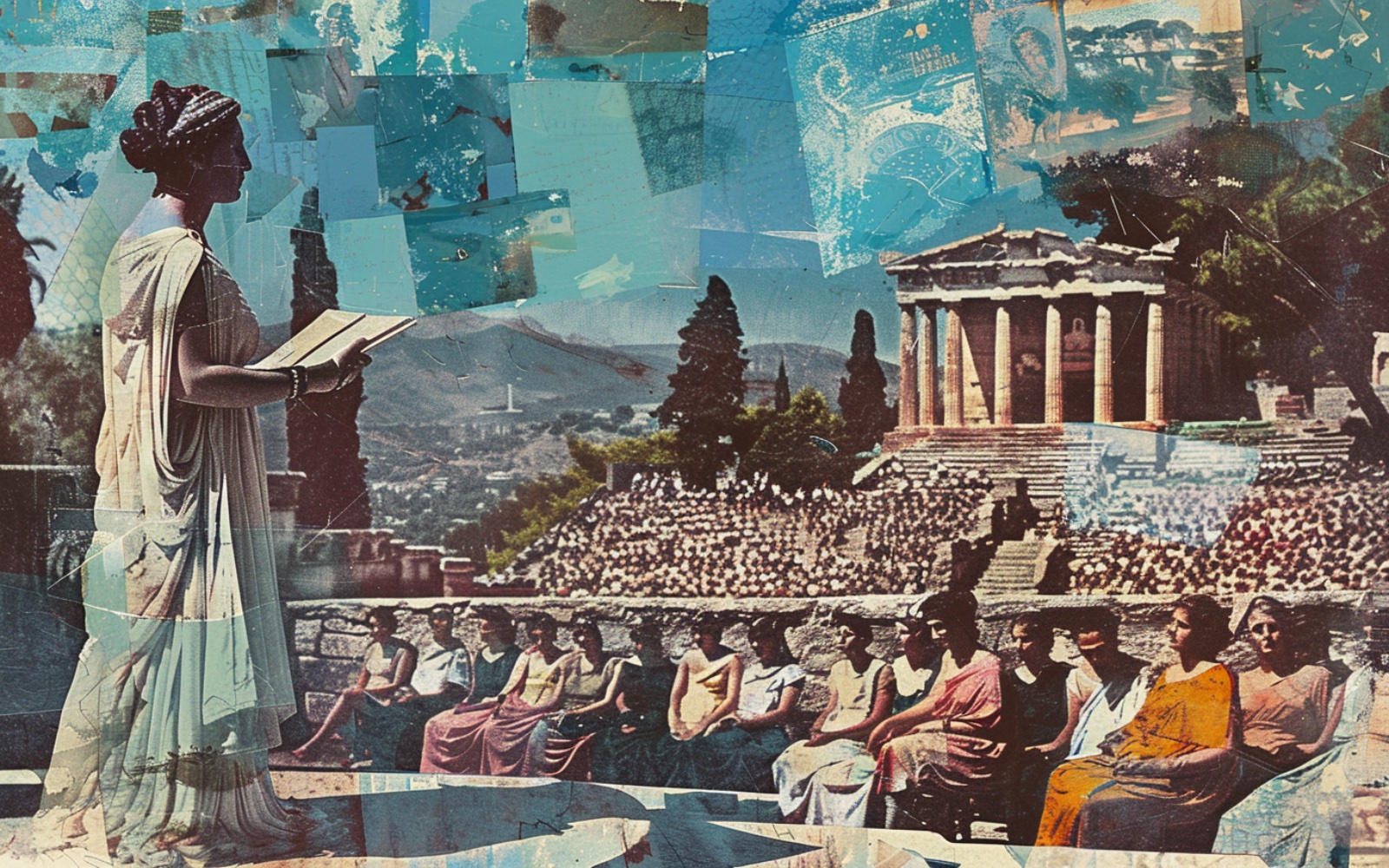

Nell’epoca in cui visse Platone, quella della grande esperienza democratica della città di Atene, il sofista è stato il massimo rappresentante di questa problematica incontrollabilità degli scopi, dei fini e degli effetti della retorica, tanto che l’appellativo e i termini che da esso abbiamo derivato hanno preso oggi una valenza negativa. Pensiamo a quando si aggettiva qualcosa o qualcuno col termine “sofisticato”, o si parla di “sofismi” e “sofisticazioni”: tutti questi termini si riferiscono a forme di modificazione, alterazione e complicazione inutili e/o potenzialmente dannose.

Cosa potremmo fare qualora volessimo sottrarci a diventare noi stessi un facile bersaglio di persuasione delle parole più che dei contenuti di un discorso?

Conclusioni

Oggi, questo problema dell’efficacia della retorica di stampo sofistico e del diffondersi di forme di approccio dilettantistico (verbale e fattuale) alle pratiche che richiederebbero la preparazione di un esperto (il tecnico, lo scienziato e, Platone direbbe, anche il filosofo), sembrerebbe essere correlato con l’instaurarsi di ritmi sempre più frenetici a cui l’esperienza deve adeguarsi a farsi spazio. Per spiegarmi meglio, il rispettivo decremento del tempo che l’individuo può dedicare all’approfondimento delle proprie conoscenze potrebbe andare a discapito di un percorso continuativo che gli permetterebbe di passare dall’essere un semplice uditorio fino a quello di studioso esperto, passando per i campi applicativi del “saper fare” e della “conoscenza pratica tecnica”, per culminare infine nel possesso reale di un bagaglio di conoscenze.

Il “tutto e subito” sembrerebbe essere preferito al “più lento” percorso di studi e di ricerca dedicato.

Pensiamo a come questa “preferibilità” possa essere corrisposta e nutrita dalle nuove forme e proposte di veicolazione rapida del sapere, e a come queste ci possano potenzialmente portare ad essere sempre più spettatori e utilizzatori improvvisati di strumenti tecnici che reali conoscitori.

In proposito è interessante riflettere su tutti quei formati digitali (facilmente accessibili e ri-producibili) che sono impostati perché l’utente possa potenzialmente assorbirne il contenuto in modalità passiva (facilmente fruibili), rapida e concentrata, quali sono le cosiddette “App” dedicate, i podcast, i documentari, gli short video (reel, shorts, etc.), le video-serie e i tutorial sulle piattaforme di streaming più popolari, gli ormai consolidati videocorsi e così via.

La richiesta di poter apprendere rapidamente è tale per cui i servizi di distribuzione di questi contenuti mettono a disposizione anche le funzioni di riproduzione velocizzata a 1.5x, 2x, 4x.

Ciò che possiamo chiederci è in che modo permangano ancora oggi i livelli della conoscenza e i rispettivi “ranghi” dei loro possessori (l’umanista, lo scienziato, il tecnico, il “bravo a fare”, lo spettatore) identificati da Platone. Quanto i soli “aver udito qualcosa”, “saper fare” e “saper parlare” avanzano tra le preferenze degli individui a discapito del formarsi di una teoria e una pratica proprie di una “conoscenza autentica”?

E ancora, la diffusione delle empeiria kai tribé a discapito delle forme della conoscenza approfondita è dovuta anche alla appetibilità del proprio “raggiungere comunque un risultato”? Di possesso di una conoscenza “quanto basta”, bastevole a farci produrre immediatamente un effetto che ci permetta anche di poter dire di noi “saper fare” qualcosa?

NOTE

1 I precedenti due post sono 1) “La memoria e la sua corruzione nell’era digitale - A confronto con il pensiero di Platone“ e 2) “La conoscenza tecnica – Meditazioni a partire dal pensiero di Platone".

2 «empeiria kai (tini) tribé» è una definizione che compare esplicitamente sia nel Gorgia (463 b) che nel Filebo (55 e). Il tema compare anche nel Fedro (270 b).

3 I passi di riferimento Phil. 55 e - 56 a, Gorg. 500 e - 501 a, sviluppano e affrontano parallelamente, ma con una sorprendente coincidenza, la differenza tra techne ed empeiria.

4 Disciplina matematica che si occupa dello studio dei rapporti numerici. In senso matematico “Logos” significa “rapporto”, “relazione” o “proporzione”.

5 La “Musica” così intesa è una disciplina teorica e scientifica in senso forte, che rientra, assieme all’aritmetica, alla geometria piana, alla stereometria (geometria delle figure solide) e all’astronomia, nella lista delle discipline matematiche fatta da Socrate e Glaucone nella Repubblica (533 c – d).

6 Parafrasi dei passi in Gorg. 465 d - e, 500 e - 501 a.

7 Il medico non corrisponde esattamente a ciò che intendiamo oggi con questa professione, piuttosto egli è una sorta di filosofo dell’oggetto anima-corpo, che ne studia gli effetti (le malattie) per comprenderne le cause. Chi si occupa invece delle pratiche per il mantenimento della salute è il maestro di ginnastica, che ha come obiettivo non quello del ripristino ma quello del mantenimento della salute.

8 Nel Gorgia 453 a, si arriverà ad affermare che la retorica non è di per sé un’arte tecnica e che il fine della retorica è la sua stessa essenza: la persuasione di un pubblico.

Le tecnologie non sono neutrali. La lezione dimenticata del determinismo tecnologico

Il determinismo tecnologico (DT), nella sua forma più pura, è un approccio che vede le tecnologie e le innovazioni come indipendenti dalla più ampie dinamiche sociali.

L’idea è che la tecnologia sia il fattore determinate delle vicende umane e gli sviluppi tecnologici non siano guidati dall’attività umana, ma da una logica interna all’innovazione scientifica.

Un esempio è il concetto di blockchain e cryptovalute che, secondo chi li promuove, sono liberi dalla manipolazione del potere istituzionale e generano effetti sociali in modo autonomo; un secondo esempio è la IA che, secondo alcuni sostenitori in grado aumentare le capacità umane e di rivoluzionare settori quali la finanza, sicurezza nazionale l’assistenza sanitaria ecc.

I principi del DT sono tre:

- la tecnologia rappresenta una dimensione esterna rispetto alla società, in grado di agire al di fuori di essa;

- ogni cambiamento tecnologico produce un cambiamento nelle forme di organizzazione e di interazione sociale;

- la società si adatta alla tecnologia.

Il DT è stato molto criticato dagli Science and Technology Studies (STS), tra la fine degli anni ‘70 e l’inizio degli ’80, , ritenuto un approccio obsoleto, se non addirittura sbagliato, e “ridotto allo status di uno spaventapasseri” (Lynch 2008, 10).

Infatti, sociologicamente parlando, risulta difficile sostenere che le innovazioni tecnologiche riescano a plasmare in maniera univoca la nostra vita quotidiana.

Per cui è più interessante impostare delle analisi in cui, si tiene conto di una serie di dinamiche che le tecnologie innescano, senza però farsi affascinare troppo e senza pensare che queste siano le uniche possibili.

Dunque, è più corretto parlare di tre forme di DT:

- forte: la tecnologia impatta sulla società e rappresenta il principale motore del cambiamento sociale;

- media: la tecnologia determina lo sviluppo sociale e le possibilità d’azione dei soggetti;

- leggera: la tecnologia influenza la società e orienta l’innovazione sociale.

Quindi, cosa possiamo salvare del determinismo tecnologico?

Ciò che di buono ha messo in luce il DT è che le tecnologie non sono neutre, ma producono degli effetti. Ovviamente poi possiamo discutere l’intensità di questi effetti. Ma un approccio sociale alle tecnologie deve partire dall’idea che la tecnologia non sia qualcosa di neutrale. Se così non fosse, le tecnologie sarebbero materia solamente per gli ingegneri o tecnologi. Invece, anche gli scienziati sociali possono dire la loro, partendo proprio dall’idea che la diffusione di una tecnologia è legata al proliferare delle dinamiche d’uso.

Quest’ultima idea è stata evidenziata da un altro approccio alle tecnologie: Social Construction of Technology (SCOT). Una delle lezioni fondamentali dello SCOT è che le tecnologie e i loro effetti, vanno misurate sempre in relazione ad altre cose, come l’infrastruttura esistente in un contesto o i gruppi sociali che entreranno in contatto con la tecnologia. Secondo lo SCOT non c’è niente di predeterminato nelle tecnologie; quindi, una nuova tecnologia all’inizio è caratterizzata da un certo tipo di “flessibilità interpretativa” ovvero un periodo in cui alcuni gruppi sociali si approcciano a una tecnologia e ci vedono alcune cose: per alcuni potrebbe essere utile per i propri fini, mentre per altri potrebbe essere pericolosa. Durante questo periodo entrano in gioco diversi “gruppi sociali pertinenti” che cercano di orientare l’artefatto nella loro direzione in base ai loro interessi.

In questo modo si raggiunge una stabilizzazione della tecnologia, incorniciandola, con uno specifico significato d’uso e una forma in grado di tenere insieme le diverse istanze poste dai vari gruppi.

Dunque, guardare alla tecnologia, come fa il DT, come una variabile indipendente che si origina dall’innovazione scientifica e si “impone” agli attori, determinandone le pratiche, le relazioni e le interazioni, risulta troppo radicale. Non è detto che se la tecnologia funziona in un determinato modo, allora le persone dovranno adattarsi e sforzarsi di far funzionare la tecnologia in quello stesso modo.

Risulta difficile pensare che la tecnologia offra determinati input alla società e che questa non possa far altro che adattarsi passivamente. Certo, le tecnologie non sono neutrali, ma diventano quello che sono nel momento in cui gruppi di utenti se ne appropriano, ad esempio un computer può essere utilizzato per lavoro, per lo studio, per giocare, guardare film ecc.

Il punto è che le tecnologie più diffuse sono quelle che vengono utilizzate nei modi più vari, ognuno le usa in base ai propri interessi, problemi, fini e attività quotidiane, permettono dunque una varietà di usi. Di conseguenza l’innovazione vincente non è tale soltanto perché contiene un elemento tecnico migliore o superiore ad altri, ma perché attraverso quell’elemento tecnico riesce a soddisfare una serie di istanze sociali.

Proviamo ora a fare un passo in avanti, attraverso un altro approccio alla tecnologia, l’Actor Network Theory (ANT), ovvero “un semplice metodo per imparare dagli attori senza imporre loro una definizione a priori circa la loro capacità di costruire il mondo” (Latour 1999, 20). Si tratta di un metodo che guarda alla realtà e agli attori senza partire dal presupposto che questi ultimi abbiano un qualche tipo di agency a priori. Attori umani e non-umani sono ugualmente capaci di dare forma ai processi che conducono all’emergere di un’idea, di una conoscenza o di una tecnologia.

Ma quindi in che modo possiamo descrivere il ruolo che hanno le tecnologie?

Una prima risposta è di guardare come gli oggetti intervengono all’interno delle azioni e delle pratiche e come le trasformano. Una nozione classica dell’ANT, è quella di script, ovvero ciò che è inscritto in un artefatto. L’idea è che nel processo di progettazione vengano inscritte, dai progettisti e designer, delle sceneggiature negli oggetti, dei copioni o delle istruzioni su come questi si devono utilizzare; e sono in grado di delineare ruoli, competenze e possibilità d'azione per chi interagisce con tale oggetto. In altre parole, inscrivono una certa idea di utilizzatore e per farlo introducono nell’oggetto alcune caratteristiche che riguardano le competenze dell’utilizzatore e delineano programmi d’azione e ruoli.

A questo punto potrebbe sembrare che lo script rappresenti solamente una serie prescrizioni e proscrizioni inscritte dal progettista e quindi una sorta di determinismo tecnologico, ma non è così. Il concetto di script è un concetto aperto, non ricade all’interno del determinismo tecnologico, è un partire dal presupposto che gli oggetti hanno una loro agency e contribuiscono in vari modi allo sviluppo di una azione, ma non la determinano mai.

Possiamo identificarne due aspetti. Il primo è l’inscrizione: progettisti e designer che tentano di inscrivere un qualche tipo di comportamento o azione nell’oggetto. In questa concezione l’oggetto un po' scompare. Il secondo è ciò che si ritrova inscritto nell’artefatto, ovvero il modo in cui le competenze, le possibili azioni, i ruoli degli utilizzatori sono effettivamente inscritti nell’artefatto. In questo senso l’oggetto assume una sua autonomia di cui dobbiamo tenere conto, il progetto dei designer non esaurisce le possibilità di un oggetto, ma ha una sua autonomia anche perché poi interagirà con altri oggetti e sarà sempre in trasformazione. In altre parole, si tratta di guardare le affordance (Gibson 1979), ovvero tutte quelle possibilità che gli utenti intravedono negli oggetti a partire dalle loro caratteristiche materiali e che non erano state previste dai progettisti. In questo modo gli utenti hanno l’occasione per fare qualcosa di diverso con l’oggetto che hanno di fronte.

In conclusione, la lezione del determinismo tecnologico è valida ancora oggi con alcune sfumature, ma il punto è che le tecnologie non sono neutrali. Gli STS sostengono la necessità di coltivare un approccio più “simmetrico” ai fenomenti sociali guardando alle tecnologie come pratiche sociali, ovvero si comprende l’utilità, la rilevanza, quando se ne osserva l’uso in contesti concreti. L’idea che sta dietro al concetto di affordance è che tutti quanti gli oggetti abbiamo un loro uso e ci pongono dei vincoli, però possiedono delle caratteristiche materiali che possono essere lette da chi li utilizza come inviti ad un uso diverso. La direzione non è quella di fermarsi a guardare la tecnologia-in-sé, ovvero come qualcosa che funziona ed è efficace indipendentemente dai suoi utilizzatori e contesti d’uso pratici. Piuttosto quello di focalizzarsi sulla tecnologia-in-uso (Orlikowski 1992; 2000; Gherardi 2008), ovvero come gli oggetti vengono ri-significati nella pratica, di conseguenza questi non nascono “efficaci” o “sicuri”, ma lo diventano nel momento in cui una comunità di utilizzatori, in specifici contesti d’uso, li costruisce come tali.

RIFERIMENTI

Gherardi S. (2008), La tecnologia come pratica sociale: un quadro interpretativo, in Gherardi S. (a cura di) Apprendimento tecnologico e tecnologie di apprendimento, Il Mulino, pp. 7-44.

Gibson J.G. (1979), Per un approccio ecologico alla percezione visiva, Angeli (ed. It. 1995)

Latour B. (1999), On recalling ANT, in “Actor Network Theory and After”, in J. Law, e J. Hassard (a cura di), Oxford, Blackwell, pp. 15-25.

Lynch M. (2008), Ideas and perspectives, in E Hackett, O. Amsterdamska, M. Lynch e J. Wajcman (a cura di), The Handbook of Science and Technology Studies, Cambridge, MIT Press, pp. 9-12.

Orlikowski W.J. (1992), The duality of Technology: Rethinking the Concept of Technology in Organization, in “Organizational Science”, Vol. 3, n.3, pp. 398-427.

Orlikowski W.J. (2000), Using Technology and Constituting Structures: A Practice Lens for studying technology in organizations, in “Organization Science”, vol. 11, n.4, pp. 404-428.

Le nuvole scrivono il cielo di Seveso - Il crimine di pace, la scienza e il potere

In questo scritto racconterò brevemente che cosa accadde il 10 luglio 1976 e che cos’era l’Icmesa. In seguito, solleverò alcuni problemi nati con il disastro che interpellano il rapporto tra produzione industriale, ricerca scientifica, ambiente, salute e popolazione, alternando l’utilizzo di fonti bibliografiche, articoli di cronaca e interviste realizzate durante mia ricerca etnografica a Seveso.

10 luglio 1976, ore 12.37

«Eravamo a pranzo. Era anche una bella giornata di sole. Tutto ad un tratto sentiamo pof. Poi un sibilo forte, come se fosse scoppiata una gomma. Ma più forte, come se ci fosse dell’aria che usciva. Io sono corsa sul balcone e come esco dal balcone davanti ho una casa con un altro mio amico. Anche lui era fuori e faceva così [indica il cielo con il dito]. Mi giro e vedo ‘sta nuvola fantastica, bellissima. Bianca. Proprio di un bianco, proprio bello. Bella, sì1».

Chi era presente quel giorno a Seveso non si aspettava una nuvola così bella e così pericolosa proprio in quel momento. Tuttavia, il sentore che sarebbe potuto accadere qualcosa era nell’aria.

«[Hoffmann e La Roche, N.d.R.] hanno sempre considerato l’incidente del 10 luglio ‘76 come un evento casuale. E io ho sempre detto: vero, nel dire casuale il dieci luglio 1976 alle 12.37. L’impianto era talmente obsoleto, la fabbrica e i relativi controlli erano talmente privi di sistemi di sicurezza che un incidente era nelle corde»2, mi ha raccontato Massimiliano Fratter, sevesino dalla nascita e responsabile del progetto il Ponte della memoria. Non solo il cielo fu scritto dal passaggio delle nuvole velenose, ma il risveglio sensoriale interessò anche l’olfatto. Infatti, Maria racconta che poco dopo aver visto quella nuvola bellissima ha sentito anche l’odore di saponetta, «quell’odore buono di profumo». Quello solito a cui era abituata3. L’Icmesa era soprannominata dagli abitanti della zona la fabbrica dei profumi4 per gli odori che la sua produzione esalava.

Le origini della fabbrica risalivano al 1921. Prima della seconda guerra mondiale l’azienda aveva sede a Napoli. Dopo la distruzione dello stabilimento campano a causa dei bombardamenti, la fabbrica fu trasferita Meda, sotto il controllo del gruppo svizzero Givaudan, che ne deteneva il pacchetto azionario di maggioranza e che a sua volta era stata acquisita dalla multinazionale farmaceutica Hoffmann-La Roche5. La produzione dello stabilimento cominciò tra il 1946 e il 1947 e consisteva nella realizzazione di componenti chimici, alcuni dei quali ad alto tasso di pericolosità. In particolare, dal 1969 il reparto B era stato utilizzato per la fabbricazione del 2,4,5-triclorofenolo (TCF), una sostanza impiegata principalmente per la preparazione di alcuni tipi di erbicidi e per la produzione di esaclorofene, un antibatterico utilizzato in alcuni tipi di cosmetici, di saponette e di disinfettanti6.

Tuttavia, per una parte della popolazione di Seveso, per alcuni medici e giornalisti di cronaca locale, l’Icmesa non solo inquinava da anni e avvelenava gli operai e la gente, ma produceva sostanze pericolose non solo per la cosmesi. La fuoriuscita di diossina sarebbe stata una prova.

L’8 agosto 1976 Pierpaolo Bollani intervista (per il Tempo) Fritz Möri, l’ingegnere che aveva progettato il reattore per la produzione di triclorofenolo. Nelle scettiche parole del tecnico di Losanna rispetto all’eventualità di formazione di TCDD nel reattore “a meno di compiere errori madornali», viene presentata la possibilità «che all’Icmesa in quel reattore, La Roche producesse in realtà altre cose»7. Lo stesso direttore tecnico della Givaudan Jörg Sambeth ha ammesso che l’Icmesa era una dreck fabric, una fabbrica sporca, dove l'impianto veniva fatto funzionare al di sotto di qualsiasi standard ragionevole di sicurezza e dove si portavano avanti due linee di produzione: una feriale, più pulita e probabilmente destinata a usi civili, e una festiva, realizzata a temperature critiche, vicine al punto di combustione e di sintesi della diossina.

Anche se non sapremo mai con certezza che cosa producesse l’Icmesa, quanto è accaduto a Seveso pone delle domande attuali in merito al rapporto tra la produzione industriale – e la correlata ricerca scientifica – e l’ambiente, la salute, la popolazione e la guerra. In un intervento contenuto nell’autoproduzione Topo Seveso. Produzioni di morte, nocività e difesa ipocrita della vita8 viene considerata la sottile separazione tra le «produzioni chimiche per la guerra o per la pace»9 perché «è durante la pace che si prepara e si arma la guerra: sono le stesse aziende che producono materiale da imballaggio, detergenti, disinfettanti, che poi preparano anche la base per le bombe e le altre armi chimiche, così come sono le aziende che producono le pentole e le travi per la costruzione che confezionano anche le armi. E le aziende che producono altro, non direttamente implicabile con la guerra, possono sempre investire nel mercato delle armi, più o meno legalmente»10.

Si tratta di una questione centrale per il momento storico in cui viviamo e che toglie il velo di Maya dalla ricerca scientifica intesa come attività neutrale e ab-solutas. Ci fa interrogare sui programmi di ricerca e applicazione delle istituzioni in cui studiamo e dei luoghi in cui lavoriamo. L’evento straordinario di Seveso amministrato secondo le regole dell’ordinaria amministrazione – come Laura Conti ha evidenziato nel reportage Visto da Seveso11 – ci parla ancora oggi delle relazioni che intercorrono tra industria, tecnologia e ambiente. I termini con cui l’evento del 10 luglio 1976 è stato definito sono numerosi e carichi di significati e orizzonti culturali e politici diversi tra loro: incidente, tragedia, fatto, disastro, catastrofe, crimine.

A mio avviso, il concetto di catastrofe, liberato dal particolare uso linguistico sevesino, è utile per focalizzare alcuni nodi della questione. La catastrofe genera paradossi e campi di forze contradditorie. I conflitti nati dall’evento catastrofico hanno interessato la concezione di progresso, di scienza, di salute e di ambiente di un intero Paese. L’agone tra le differenti e opposte prospettive di trattare l’evento straordinario dell’Icmesa ha avuto luogo nelle strade di Seveso, negli ufficiali comunali e nelle aule del Parlamento, nei centri di ricerca nazionali e internazionali, negli articoli di giornale e nelle fabbriche e ha svelato le forze, gli interessi e le asimmetrie di potere strutturali italiane e globali.

Le catastrofi sono totalizzanti e per questo come scrive Mara Benadusi sono «oggetti antropologici e filosofici “buoni da pensare”»12 . Ponendosi come cesure che differenziano un prima e un dopo temporale e spaziale, investono ogni sfera della vita umana e sociale. Le traiettorie biografiche individuali e collettive sono state catapultate dalla dimensione locale a quella globale. Sandro, un abitante di Seveso incontrato durante il mio lavoro di ricerca etnografico nelle zone del disastro dell’Icmesa, riesce a trasmettere la repentinità dell’evento eccezionale ed emergenziale nella sua uscita dalla dimensione locale della Brianza.

«Questa cosa è sicuramente stata molto importante dal punto di vista comportamentale della popolazione perché eri passato da una emerito sconosciuto a uno stronzo che sta inquinando il mondo. Non so come dire […] È una cosa che magari c'è chissà da quante altre parti. Ma finché non succede il fattaccio, nessuno lo viene a sapere»13.

Il crimine di pace – come lo ha definito Giulio A. Maccacaro, ha sconvolto le comunità di Seveso, Meda, Desio e Cesano Maderno14. In quei territori approdo delle migrazioni interne dell’Italia del secondo dopoguerra, l’economia di tipo artigianale, l’identità di campanile e i valori del lavoro e della religiosità cristiana cattolica furono sconquassate dalla nube del 10 luglio 1976 e dalle lotte sociali e politiche che seguirono. Bruno Ziglioli scrive:

«La popolazione si riaggregò e si divise su basi completamente diverse: tra gli evacuati della zona A che desideravano rientrare nelle proprie abitazioni e gli abitanti rimasti che temevano di essere esposti al veleno; tra coloro che erano sistemati al residence di Bruzzano (cioè vicino a casa) e quelli che invece erano alloggiati al motel Agip di Assago (molto più distante); tra chi tendeva a minimizzare e chi a enfatizzare il pericolo; tra chi era favorevole all’incenerimento in loco del terreno contaminato e chi invece chiedeva di sperimentare tecniche di decontaminazione meno invasive. Vi furono manifestazioni, proteste, blocchi stradali; gli sfollati rioccuparono a più riprese le case nella zona ad alto inquinamento. Come spesso accade in queste situazioni, si innescò anche la caccia al capro espiatorio: i lavoratori dell’Icmesa, e con loro i sindacati, furono additati da una parte degli abitanti come corresponsabili dell’incidente, perché avrebbero conosciuto e taciuto i rischi del processo produttivo e le scarse condizioni di sicurezza dello stabilimento»15 .

Tuttavia, furono proprio gli operai a interrompere la produzione della fabbrica perché dalla direzione non era arrivata nessuna indicazione chiara. Amedeo Argiuolo, operaio dell’Icmesa, ha raccontato in una recente intervista per il Giorno che «all’inizio, l’azienda tentò di minimizzare. Il reparto B era chiuso, e noi ci chiedevamo perché…i responsabili dell’Icmesa dicevano che era solo un piccolo incidente, che era tutto sotto controllo, anzi aveva mandato qualcuno di noi, solo guanti e mascherine, a fare carotaggi: dicevano che avevano mandato tutti ai laboratori di Basilea e ci avrebbero fatto sapere. Secondo loro, bisognava continuare a lavorare»16.

Il Consiglio di fabbrica dell’Icmesa ha avuto un ruolo fondamentale per fare emergere la pericolosità dell’accaduto non solo all’interno della fabbrica, ma per la popolazione e il territorio circostante. Alberto, abitante delle zone interessate dal disastro, ricorda che: «Qui [a Seveso] era nato anche un comitato. Si chiamava Comitato tecnico scientifico popolare17 e metteva insieme sia il Consiglio di fabbrica dell’Icmesa che ha avuto un ruolo importante in questa vicenda sia gli scienziati»18 .

Il CTSP con il medico G. A. Maccacaro e la rivista Sapere hanno messo in discussione la “scienza ufficiale” che procedeva a tentoni e in un primo momento aveva tentato di insabbiare e poi di minimizzare l’accaduto. Il CTSP fece un lavoro di informazione e controinformazione teso a prendere sul serio l’evento sevesino, rompendo «i giorni del silenzio» di Icmesa-Givaudan-Hoffman-La Roche e delle istituzioni italiane. Infatti, durante l’Assemblea Popolare del 28 luglio 1976, organizzata dalla Federazione Unitaria di CGIL-CISL-UIL nelle scuole medie di Cesano Maderno, i membri del CTSP hanno segnalato prima di qualsiasi altro organo ufficiale l’avvelenamento della popolazione e del territorio da parte dell’Icmesa. Gli operai del Consiglio di fabbrica che decisero di chiudere la stabilimento per avere maggiore chiarezza erano una parte fondamentale e attiva nel Comitato. Tra le pagine del numero di Sapere interamente dedicato a Seveso, il Gruppo P.I.A.19 dopo aver ricostruito il ciclo produttivo dell’Icmesa nei minimi dettagli conclude interrogando la differenza tra due tipi antagonisti di “cultura e di progresso” e di scienza. Il Gruppo P.I.A. scrive:

«Chi è spinto dalla molla del profitto e adotta la regola che i guadagni sono privati, mentre le perdite sono pubbliche, persegue lo sviluppo di una cultura basata sulla neutralità ed asetticità della Scienza, sulla sua separazione dalla politica, sugli incentivi per la ricerca che provengono dal profitto e dal potere individuali od oligarchici»20 .

Quanto accaduto a Seveso ha aperto la scatola nera in cui sono inestricabilmente imbricate una concezione della scienza neutrale tesa al progresso scientifico-tecnologico, una visione lineare del progresso e delle scelte economiche e politico-istituzionali. Lo scoppio della scatola-reattore ha portato tutte queste questioni e i loro intrecci fuori dalla fabbrica e ha dato vita a un ciclo di lotte per la salute e per l’ambiente di ampia portata, ancora oggi attuali.

NOTE

1 Intervista condotta dall’autrice a Maria, abitante della frazione Baruccana di Seveso, in data 14 settembre 2023.

2 Intervista condotta dall’autrice a Massimiliano Fratter in data 28 luglio 2023. M. Fratter è nato a Seveso, è il responsabile del progetto Il ponte della memoria, ha lavorato all’Ufficio Ecologia del Comune di Seveso e ora è impiegato nella biblioteca dell’omonima città.

3 I riferimenti agli odori insistenti, all’inquinamento del torrente Certesa e alla moria di animali che pascolavano nei prati vicini all’Icmesa possono essere rintracciati nei documenti degli archivi comunali di Meda e di Seveso. Per una loro interpretazione storica, vedi M. Fratter, Seveso. Memorie da sotto il bosco, Milano, Auditorium Edizioni, 2006, pp. 53-75.

4 Il giornalista Daniele Bianchessi nel 1995 ha pubblicato il suo primo libro d’inchiesta intitolato La fabbrica dei profumi. La prima edizione è stata pubblicata da Baldini & Castoldi. Il volume è stato rieditato nel 2016 da Jaca Book.

5 Per un maggiore approfondimento sulla storia e la composizione societaria vedi Camera dei deputati, Senato della Repubblica, Relazione conclusiva, Commissione parlamentare di inchiesta sulla fuga di sostanze tossiche avvenuta il 10 luglio 1976 nello stabilimento ICMESA e sui rischi potenziali per la salute e per l’ambiente derivanti da attività industriali, VII legislatura, doc, XXIII, n. 6, 25 luglio 1978, p. 58; B. Ziglioli, La mina vagante. Il disastro di Seveso e la solidarietà nazionale, Milano, Franco Angeli, 2010, p. 16.

6 Per avere una conoscenza più approfondita dei prodotti dell’Icmesa vedi Camera dei deputati, Senato della Repubblica, Relazione conclusiva, op. cit., pp. 62-64.

7 P. Bollani, Io fabbrico morte. Ecco cosa è successo, «Tempo», 8 agosto 1976, in Giunta regionale della Lombardia, Stampa italiana. 10 luglio 1976, Seveso il dramma della nube tossica, n. 1, p. 24. Per ulteriori informazioni sulla possibili produzioni per la guerra chimica, vedi C. Risé, C. Cederna, V. Bettini, Dietro l’Icmesa in Icmesa. Una rapina di salute, di lavoro e di territorio, Milano, Mazzotta, 1976, pp. 58-69; M. Aloisi [et al.] (a cura di), Seveso. La guerra chimica in Italia, «Quaderni di Triveneto», n. 1, Verona, Bertani, 1976.

8 Aa. Vv., Topo Seveso. Produzioni di morte, nocività e difesa ipocrita della vita, Milano, Autoproduzione, 2007. Vedi, http://tuttaunaltrastoria.info/wp-content/uploads/2022/05/POIDIMANI-Atti_Topo_Seveso.pdf.

9 Ivi, p. 12.

10 Ivi, pp. 11-12.

11 L. Conti, Visto da Seveso. L’evento straordinario e l’ordinaria amministrazione, Milano, Feltrinelli, 1976.

12 M. Benadusi, Antropologia dei disastri. Ricerca, Attivismo, Applicazione. Un’introduzione in Antropologia Pubblica, Vol. 1 n. 1-2, 2015, p. 41.

13 Intervista condotta dall’autrice a Sandro, abitante della frazione Baruccana di Seveso, condotta nel mese di settembre 2023.

14 Si tratta dei quattro comuni della Brianza maggiormente contaminati.

15 B. Ziglioli, La mina vagante. Il disastro di Seveso e la solidarietà nazionale, Milano, Franco Angeli, 2010, p. 46.

16 https://www.ilgiorno.it/monza-brianza/cronaca/operaio-icmesa-fuoriuscita-diossina-0de68f02

17 Da questo punto, userò l’acronimo CTSP per riferirmi al Comitato tecnico scientifico popolare.

18 Intervista condotta dall’autrice ad Alberto presso la sede del Circolo Legambiente – Laura Conti in data 22 agosto 2023. Quando si è verificato il disastro, Alberto aveva 15 anni e andava a scuola a Cesano Maderno.

19 È il Gruppo di prevenzione e di igiene ambientale del Consiglio di fabbrica della Montedison di Castellanza.

20 Gruppo P.I.A, B. Mazza, V. Scatturin, ICMESA: come e perché in Seveso. Un crimine di pace, «Sapere», n. 796, nov.-dic. 1976, Bari, Dedalo, p. 34.

Immagine analogica ed Intelligenza Artificiale - Due mondi apparentemente distanti

Questo post nasce dal seminario tenuto da Diego Randazzo, artista visivo, sul tema “Immagine analogica ed Intelligenza Artificiale. Due mondi apparentemente distanti”.

Randazzo ha illustrato alcune funzionalità dei sistemi dialogativi di Intelligenza Artificiale text-to-image come, ad esempio Dall-E o Midjourney, nella generazione di immagini partendo da altre immagini o da una serie di specifiche dettate su una linea di comando.

Queste peculiari funzionalità della IA generativa permettono ad un artista di far generare ai sistemi delle immagini su cui poi intervenire per creare lavori del tutto personali. Oppure, dà la possibilità di generare anche immagini ibride, come, a titolo di esempio, quella di una tavolata che meticci l’Ultima cena di Leonardo da Vinci e le tavole da pranzo di Vanessa Beecroft.

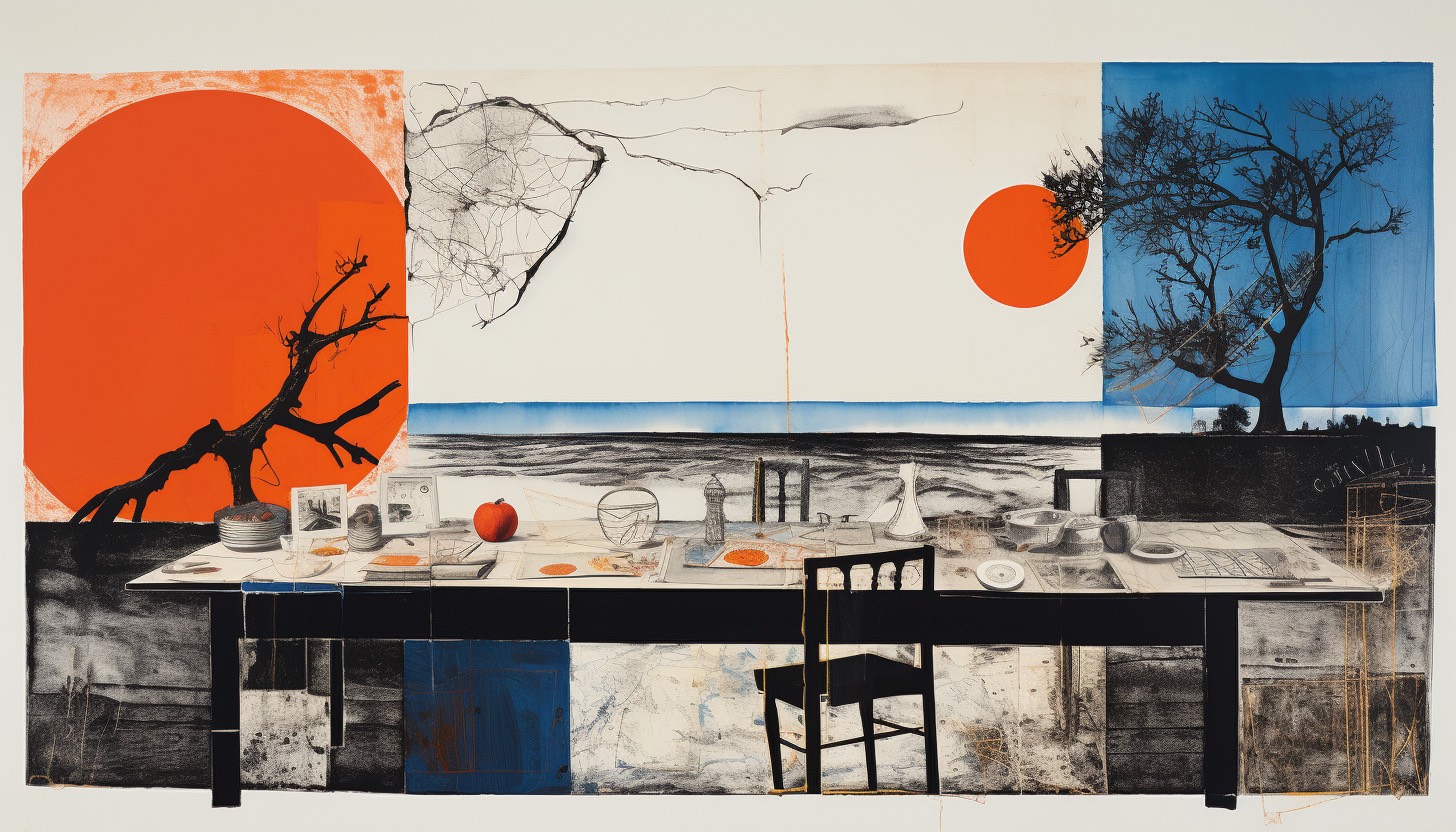

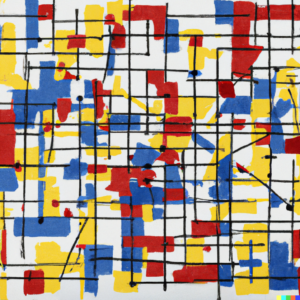

Questi di seguito sono esempi generati in tempo reale durante il seminario:

Comando:

Ultima cena di Leonardo, tavola da pranzo Vanessa Beecroft

Comando:

Ultima cena di Leonardo e Les Demoiselles D'Avignon di Picasso

Comando:

Un Pollock ed un Mondrian

La narrazione e gli esempi hanno suscitato una serie di interrogativi sulle nozioni caratteristiche del discorso artistico, in termini epistemologici e filosofici, interrogativi a cui Randazzo risponde in questo articolo.

--------

Paolo Bottazzini: La possibilità di derivare da regole statistiche un'istanza visiva o sonora, la rende un'opera d'arte o un modello possibile per un'opera d’arte?

Diego: Io parlo spesso di reference, di approccio critico e di didattica. Questi fanno parte dell’opera d’arte, ma sono solo alcuni degli elementi che dovrebbero scaturire da un’opera d’arte.

Parallelamente si può tranquillamente dichiarare, che la generazione di un’immagine con l’AI è l’inizio di un processo che può portare alla creazione di un’opera, ma non è esaustivo.

E penso - scusate la provocazione - che questo discorso valga per tutti quegli strumenti che nel corso della storia sono stati designati come strumenti a disposizione dell’artista: matita, pennello, sgorbia, scalpello, macchina fotografica, cinepresa, videocamera, computer.

Infine, le regole statistiche a cui accennate, non possono essere controllate dall’utente che, forzatamente, si deve accontentare dei risultati ricevuti. Questo mi ricorda un po’ il gioco di matrice surrealista denominato Cadaveri squisiti (cadavre exquis), a mio parere contributo fondamentale alla definizione di collage. Non stiamo in fondo parlando di questo? Associazioni e combinazioni testuali e visive, spesso incontrollate e provenienti da fonti diverse.

Quindi la descrizione che suggerite mi sembra appropriata, aggiungendo un trattino: l’AI come modello-strumento possibile per creare un'opera d’arte. Ci sono diverse modalità di utilizzo dell’AI per creare immagini; tra tutte credo sia molto affascinante la funzione che permette di espandere un ‘immagine preesistente, caricata nel software di AI.

Il ‘riempimento generativo’, lo considero una sorta di strumento conoscitivo, che a partire da qualcosa di personale (es. un’immagine dell’autore) permette di amplificare ed espandere l’universo visivo dell’autore stesso.

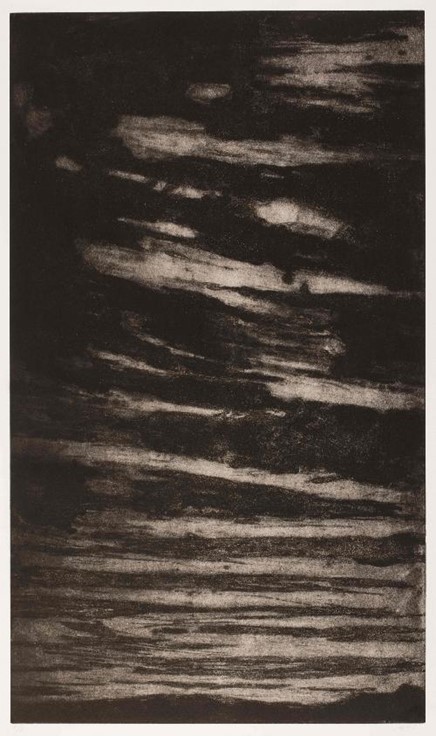

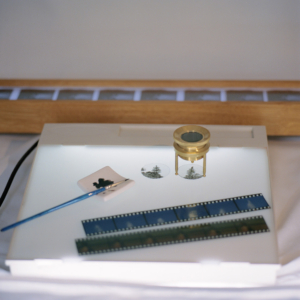

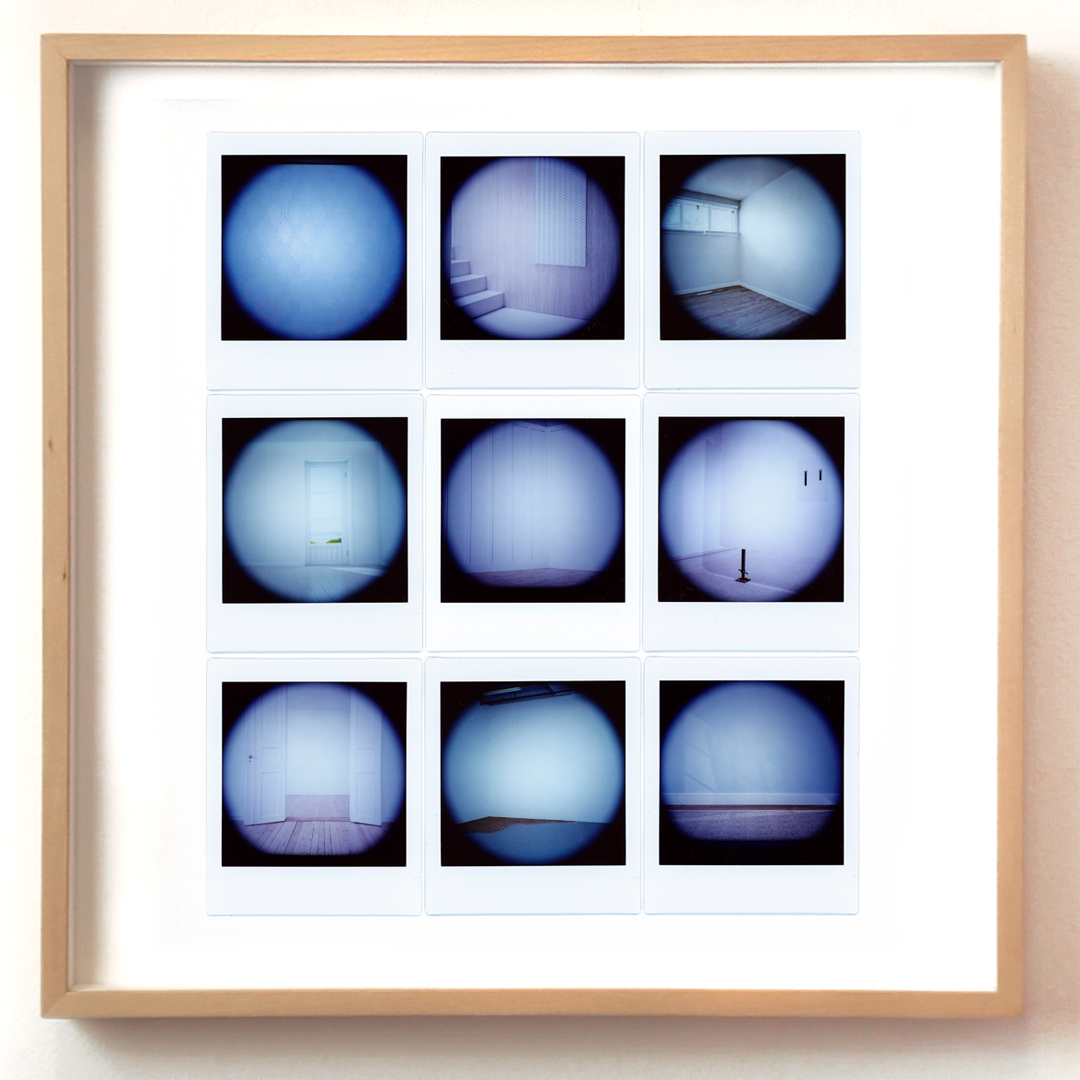

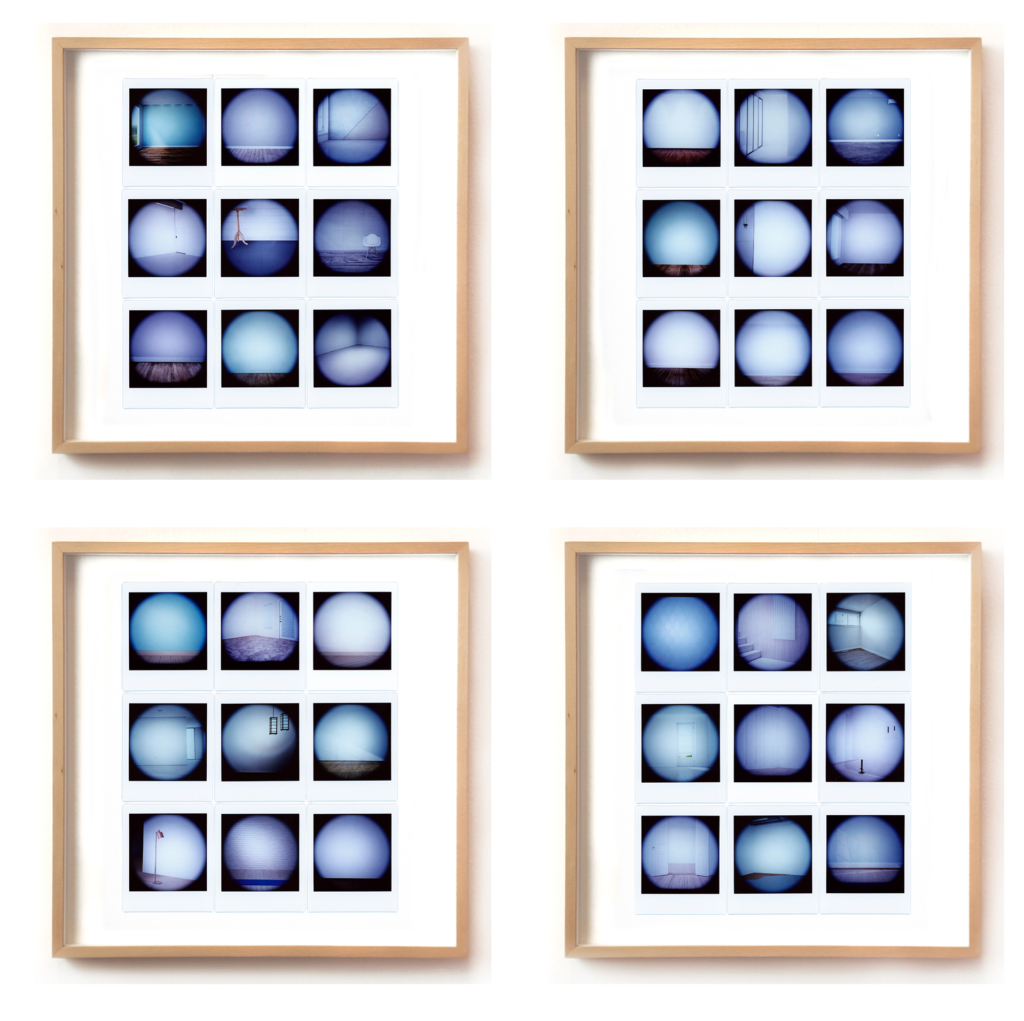

Riporto qui di seguito uno dei primi esperimenti realizzati con Dall-E a partire da alcune fotografie realizzate in pellicola medio formato (estratte del mio progetto Illusorie visioni d’argento del 2018). La prima immagine è lo scatto originale, le successive sono le espansioni generate con l’AI. E’ evidente come il rapporto che si instaura tra originale e rielaborazione AI è molto significativo, c’è una forte connessione tra due mondi che tendenzialmente teniamo separati. Qui, la concretezza del manufatto analogico e l’intangibilità dell’immagine sintetica si toccano e diventano un tutt’uno.

Lenti d’ingrandimento in ottone, becher, pellicole di piccolo e medio formato, macchine fotografiche analogiche… a questi oggetti/soggetti provenienti dal mondo proto-fotografico sono accostati altri della natura più varia (frutta e verdura imprecisata, gelatina alla menta, piante, droni, congegni elettrici, elettronici, digitali ed immagini olografiche) disposti su improbabili limbi e tavoli da lavoro componendo un eterogeneo repertorio di composizioni panoramiche. Ad una prima occhiata ci paiono dei set fotografici che strizzano l’occhio all’ambito still-life, ma avvicinando lo sguardo qualcosa non funziona. Il progetto "Elegie dell'impossibile verosimile" è un’inedita opera meta-fotografica, non ancora pubblicata, che esplora la relazione tra mondo analogico e digitale. Ogni composizione è creata a partire da uno scatto in medio-formato e successivamente combinata con altre immagini generate con il software di intelligenza artificiale Dall-E 2, che analizza un testo descrittivo e genera immagini corrispondenti. Il lavoro sperimentale affronta il tema dell'autenticità delle immagini nella contemporaneità, considerando la macchina come una possibilità di estensione poetica dell'immaginario dell’artista.