Ripensare le Scienze - Considerazioni a partire da "Il Golem"

13/02/2024Golem,STSParadigmi scientifici,Sociologie

La scienza sembra essere o tutta buona o tutta cattiva»[1]; così inizia Il Golem, saggio pubblicato nel 1993 dai sociologi Harry Collins e Trevor Pinch.

Il testo prende le distanze da una visione strettamente dicotomica dell’impresa scientifica che ne considera solo gli estremi (o tutta buona o tutta cattiva) e ne dà un giudizio etico.

Ma allora, addentrandoci nella trama e dei casi raccolti da Trevor e Pinch, viene da chiedersi: che cos’è la scienza?

Secondo gli autori essa è un golem, «un umanoide creato dall’uomo con acqua e argilla, con incantesimi e magie»[2]; esso ha una forza formidabile, ma è goffo e addirittura pericoloso: «se non è sottoposto a controllo, un golem può distruggere i suoi padri con la sua smisurata energia»[3]. Scopo di questo libro, allora, è di mostrare come la scienza sia a tutti gli effetti un golem, quindi non un’entità necessariamente malvagia ma una creatura che, nonostante la sua forza, si rivela impacciata e maldestra.

E se la scienza è incerta, quando la vediamo zoppicare? Quando mostra le sue fragilità?

Per esempio, quando in una ricerca ci sono talmente tante variabili da confondere gli scienziati stessi, oppure quando si discute sull’eventuale ripetibilità di un esperimento. Queste considerazioni (e molte altre) fanno riflettere sulle difficoltà della Scienza Golem, la quale non sempre si muove con passo sicuro, traballa, oscilla tra “tentativi ed errori”, crea controversie, anche se «alla fine, […], è la comunità scientifica […] che porta ordine in questo caos, trasformando le goffe capriole della Scienza Golem collettiva in un pulito e ordinato mito scientifico. Non c’è nulla di sbagliato in tutto questo: l’unico peccato è non riconoscere che è sempre così»[4].

In aggiunta, cosa dovremmo dire di chi lavora in ambiti scientifici? L’idea espressa da Collins e Pinch afferma che «gli scienziati non sono né dèi né ciarlatani; sono semplicemente specialisti […]. La loro conoscenza non è più perfetta di quella di economisti, ministri per la sanità, […], avvocati, […], agenti di viaggi, meccanici di automobili, o idraulici»[5].

Quindi, se la scienza – e le scienze – sono imprese umane perché umani sono coloro che ci lavorano, è indubbio che risentono anch’esse di influssi storici, culturali o sociali, oltre a variabili personali come le preferenze, le idiosincrasie o le idee dei singoli scienziati e scienziate. Pertanto, la Scienza Golem incespica, inciampa e cade perché noi la costruiamo e la mettiamo all’opera: «l’“errore” umano va diritto verso il cuore della scienza, perché il cuore è fatto dell’attività umana»[6]. I suoi errori sono dunque i nostri errori.

Come viene affermato ne Il Golem, «è impossibile separare la scienza dalla società, eppure rimanendo legati all’idea che esistono due distinte sfere di attività si contribuisce a creare quell’immagine autoritaria della scienza così familiare alla maggior parte di noi. Perché tali sfere appaiono distinte?»[7].

Forse perché abbiamo affidato alle scienze un compito troppo difficile: essere le divinità di tempi secolarizzati, essere le entità sacre di una postmoderna forma di politeismo; quando il mondo occidentale ha perso i propri capisaldi, le scienze hanno dovuto rappresentare la certezza.

Quanto peso è stato messo sulle loro spalle!

Abbiamo compiuto un enorme salto ontologico e, così facendo, abbiamo occultato il lato umano che c’è, c’è sempre stato e sempre ci sarà nell’impresa scientifica. Rendendola una divinità laica, l’abbiamo infatti sottratta a quel dominio che è il nostro dominio, ci siamo alienati, con le distorsioni e le illogicità che questa azione comporta. Quindi, non consideriamo le scienze come giganti ultraterreni ma come tessere di un insieme più ampio, che ci riguarda in modo diretto.

Dopo tutte queste considerazioni, dovremmo quindi sfiduciare la scienza? Assolutamente no!

Non dobbiamo scoraggiarla, ma contestualizzarla e capirla, comprendendo che le scienze sono costruzioni umane e, come tali, abitano in quello spazio fluido, di transizione, che è lo stesso delle nostre vite. Uno spazio effimero, contingente, sempre in movimento; può capitare infatti che le certezze di oggi non siano quelle di ieri e non saranno quelle di domani, tanto nelle nostre esistenze quanto nelle scienze. Ed è proprio questo che rende l’avventura scientifica così affascinante.

Scopo del blog Controversie è proprio quello di ripensare le scienze. Più nello specifico, ribaltare quell’idea scientista, di matrice neo-positivista, che le considera ingenuamente come depositarie di un sapere assoluto e come base di tutta la conoscenza.

Invece, è molto meglio (e più plausibile) considerare le scienze all’interno di un ambiente reale e concreto, facendole scendere dal piedistallo sul quale sono state poste affinché dialoghino con altre imprese umane come, per esempio, società, storia, arte o filosofia. È così che creeremo vera cultura: non isolando i saperi, ma mostrando che sono tutti immersi in una rete in cui comunicano, si confrontano e si influenzano, arricchendosi reciprocamente. Per imparare, si deve dialogare e, per dialogare, ci si deve incontrare. E non si incontrerà proprio nessuno, se si resta sul piedistallo.

Impareremo così ad amare la scienza, «ad amare il gigante maldestro per quello che è»[8].

NOTE

[1] Harry Collins, Trevor Pinch, Il Golem. Tutto quello che dovremmo sapere sulla scienza, trad. it, Bari, Edizioni Dedalo, 1995, p. 11.

[2] Ibidem.

[3] Ivi, p. 12.

[4] Ivi, p. 196.

[5] Ivi, p. 188.

[6] Ivi, p. 184.

[7] Ibidem.

[8] Ivi, p. 13.

Le tecnologie non sono neutrali. La lezione dimenticata del determinismo tecnologico

13/02/2024DeterminismoTecniche e Tecnologie,STS

Il determinismo tecnologico (DT), nella sua forma più pura, è un approccio che vede le tecnologie e le innovazioni come indipendenti dalla più ampie dinamiche sociali.

L’idea è che la tecnologia sia il fattore determinate delle vicende umane e gli sviluppi tecnologici non siano guidati dall’attività umana, ma da una logica interna all’innovazione scientifica.

Un esempio è il concetto di blockchain e cryptovalute che, secondo chi li promuove, sono liberi dalla manipolazione del potere istituzionale e generano effetti sociali in modo autonomo; un secondo esempio è la IA che, secondo alcuni sostenitori in grado aumentare le capacità umane e di rivoluzionare settori quali la finanza, sicurezza nazionale l’assistenza sanitaria ecc.

I principi del DT sono tre:

- la tecnologia rappresenta una dimensione esterna rispetto alla società, in grado di agire al di fuori di essa;

- ogni cambiamento tecnologico produce un cambiamento nelle forme di organizzazione e di interazione sociale;

- la società si adatta alla tecnologia.

Il DT è stato molto criticato dagli Science and Technology Studies (STS), tra la fine degli anni ‘70 e l’inizio degli ’80, , ritenuto un approccio obsoleto, se non addirittura sbagliato, e “ridotto allo status di uno spaventapasseri” (Lynch 2008, 10).

Infatti, sociologicamente parlando, risulta difficile sostenere che le innovazioni tecnologiche riescano a plasmare in maniera univoca la nostra vita quotidiana.

Per cui è più interessante impostare delle analisi in cui, si tiene conto di una serie di dinamiche che le tecnologie innescano, senza però farsi affascinare troppo e senza pensare che queste siano le uniche possibili.

Dunque, è più corretto parlare di tre forme di DT:

- forte: la tecnologia impatta sulla società e rappresenta il principale motore del cambiamento sociale;

- media: la tecnologia determina lo sviluppo sociale e le possibilità d’azione dei soggetti;

- leggera: la tecnologia influenza la società e orienta l’innovazione sociale.

Quindi, cosa possiamo salvare del determinismo tecnologico?

Ciò che di buono ha messo in luce il DT è che le tecnologie non sono neutre, ma producono degli effetti. Ovviamente poi possiamo discutere l’intensità di questi effetti. Ma un approccio sociale alle tecnologie deve partire dall’idea che la tecnologia non sia qualcosa di neutrale. Se così non fosse, le tecnologie sarebbero materia solamente per gli ingegneri o tecnologi. Invece, anche gli scienziati sociali possono dire la loro, partendo proprio dall’idea che la diffusione di una tecnologia è legata al proliferare delle dinamiche d’uso.

Quest’ultima idea è stata evidenziata da un altro approccio alle tecnologie: Social Construction of Technology (SCOT). Una delle lezioni fondamentali dello SCOT è che le tecnologie e i loro effetti, vanno misurate sempre in relazione ad altre cose, come l’infrastruttura esistente in un contesto o i gruppi sociali che entreranno in contatto con la tecnologia. Secondo lo SCOT non c’è niente di predeterminato nelle tecnologie; quindi, una nuova tecnologia all’inizio è caratterizzata da un certo tipo di “flessibilità interpretativa” ovvero un periodo in cui alcuni gruppi sociali si approcciano a una tecnologia e ci vedono alcune cose: per alcuni potrebbe essere utile per i propri fini, mentre per altri potrebbe essere pericolosa. Durante questo periodo entrano in gioco diversi “gruppi sociali pertinenti” che cercano di orientare l’artefatto nella loro direzione in base ai loro interessi.

In questo modo si raggiunge una stabilizzazione della tecnologia, incorniciandola, con uno specifico significato d’uso e una forma in grado di tenere insieme le diverse istanze poste dai vari gruppi.

Dunque, guardare alla tecnologia, come fa il DT, come una variabile indipendente che si origina dall’innovazione scientifica e si “impone” agli attori, determinandone le pratiche, le relazioni e le interazioni, risulta troppo radicale. Non è detto che se la tecnologia funziona in un determinato modo, allora le persone dovranno adattarsi e sforzarsi di far funzionare la tecnologia in quello stesso modo.

Risulta difficile pensare che la tecnologia offra determinati input alla società e che questa non possa far altro che adattarsi passivamente. Certo, le tecnologie non sono neutrali, ma diventano quello che sono nel momento in cui gruppi di utenti se ne appropriano, ad esempio un computer può essere utilizzato per lavoro, per lo studio, per giocare, guardare film ecc.

Il punto è che le tecnologie più diffuse sono quelle che vengono utilizzate nei modi più vari, ognuno le usa in base ai propri interessi, problemi, fini e attività quotidiane, permettono dunque una varietà di usi. Di conseguenza l’innovazione vincente non è tale soltanto perché contiene un elemento tecnico migliore o superiore ad altri, ma perché attraverso quell’elemento tecnico riesce a soddisfare una serie di istanze sociali.

Proviamo ora a fare un passo in avanti, attraverso un altro approccio alla tecnologia, l’Actor Network Theory (ANT), ovvero “un semplice metodo per imparare dagli attori senza imporre loro una definizione a priori circa la loro capacità di costruire il mondo” (Latour 1999, 20). Si tratta di un metodo che guarda alla realtà e agli attori senza partire dal presupposto che questi ultimi abbiano un qualche tipo di agency a priori. Attori umani e non-umani sono ugualmente capaci di dare forma ai processi che conducono all’emergere di un’idea, di una conoscenza o di una tecnologia.

Ma quindi in che modo possiamo descrivere il ruolo che hanno le tecnologie?

Una prima risposta è di guardare come gli oggetti intervengono all’interno delle azioni e delle pratiche e come le trasformano. Una nozione classica dell’ANT, è quella di script, ovvero ciò che è inscritto in un artefatto. L’idea è che nel processo di progettazione vengano inscritte, dai progettisti e designer, delle sceneggiature negli oggetti, dei copioni o delle istruzioni su come questi si devono utilizzare; e sono in grado di delineare ruoli, competenze e possibilità d'azione per chi interagisce con tale oggetto. In altre parole, inscrivono una certa idea di utilizzatore e per farlo introducono nell’oggetto alcune caratteristiche che riguardano le competenze dell’utilizzatore e delineano programmi d’azione e ruoli.

A questo punto potrebbe sembrare che lo script rappresenti solamente una serie prescrizioni e proscrizioni inscritte dal progettista e quindi una sorta di determinismo tecnologico, ma non è così. Il concetto di script è un concetto aperto, non ricade all’interno del determinismo tecnologico, è un partire dal presupposto che gli oggetti hanno una loro agency e contribuiscono in vari modi allo sviluppo di una azione, ma non la determinano mai.

Possiamo identificarne due aspetti. Il primo è l’inscrizione: progettisti e designer che tentano di inscrivere un qualche tipo di comportamento o azione nell’oggetto. In questa concezione l’oggetto un po' scompare. Il secondo è ciò che si ritrova inscritto nell’artefatto, ovvero il modo in cui le competenze, le possibili azioni, i ruoli degli utilizzatori sono effettivamente inscritti nell’artefatto. In questo senso l’oggetto assume una sua autonomia di cui dobbiamo tenere conto, il progetto dei designer non esaurisce le possibilità di un oggetto, ma ha una sua autonomia anche perché poi interagirà con altri oggetti e sarà sempre in trasformazione. In altre parole, si tratta di guardare le affordance (Gibson 1979), ovvero tutte quelle possibilità che gli utenti intravedono negli oggetti a partire dalle loro caratteristiche materiali e che non erano state previste dai progettisti. In questo modo gli utenti hanno l’occasione per fare qualcosa di diverso con l’oggetto che hanno di fronte.

In conclusione, la lezione del determinismo tecnologico è valida ancora oggi con alcune sfumature, ma il punto è che le tecnologie non sono neutrali. Gli STS sostengono la necessità di coltivare un approccio più “simmetrico” ai fenomenti sociali guardando alle tecnologie come pratiche sociali, ovvero si comprende l’utilità, la rilevanza, quando se ne osserva l’uso in contesti concreti. L’idea che sta dietro al concetto di affordance è che tutti quanti gli oggetti abbiamo un loro uso e ci pongono dei vincoli, però possiedono delle caratteristiche materiali che possono essere lette da chi li utilizza come inviti ad un uso diverso. La direzione non è quella di fermarsi a guardare la tecnologia-in-sé, ovvero come qualcosa che funziona ed è efficace indipendentemente dai suoi utilizzatori e contesti d’uso pratici. Piuttosto quello di focalizzarsi sulla tecnologia-in-uso (Orlikowski 1992; 2000; Gherardi 2008), ovvero come gli oggetti vengono ri-significati nella pratica, di conseguenza questi non nascono “efficaci” o “sicuri”, ma lo diventano nel momento in cui una comunità di utilizzatori, in specifici contesti d’uso, li costruisce come tali.

RIFERIMENTI

Gherardi S. (2008), La tecnologia come pratica sociale: un quadro interpretativo, in Gherardi S. (a cura di) Apprendimento tecnologico e tecnologie di apprendimento, Il Mulino, pp. 7-44.

Gibson J.G. (1979), Per un approccio ecologico alla percezione visiva, Angeli (ed. It. 1995)

Latour B. (1999), On recalling ANT, in “Actor Network Theory and After”, in J. Law, e J. Hassard (a cura di), Oxford, Blackwell, pp. 15-25.

Lynch M. (2008), Ideas and perspectives, in E Hackett, O. Amsterdamska, M. Lynch e J. Wajcman (a cura di), The Handbook of Science and Technology Studies, Cambridge, MIT Press, pp. 9-12.

Orlikowski W.J. (1992), The duality of Technology: Rethinking the Concept of Technology in Organization, in “Organizational Science”, Vol. 3, n.3, pp. 398-427.

Orlikowski W.J. (2000), Using Technology and Constituting Structures: A Practice Lens for studying technology in organizations, in “Organization Science”, vol. 11, n.4, pp. 404-428.

Il complottismo degli anti-complottisti. Le trappole mentali dei debunkers

13/02/2024Attualità,ComplottismoSociologie,Politica,Psicologia

Da quasi un decennio i temi della post-verità, delle fake-news e delle teorie del complotto sono diventati un’ossessione non solo per i giornalisti, ma anche per gli accademici. Per alcuni sociologi, psicologi, filosofi ecc. sembra che tutti i mali del mondo vengano dai cospirazionisti, persone malate, irrazionali e anti-scientifiche, carbonari dei nostri giorni, che passano il loro tempo a fornicare sui social media, a costruire ad arte notizie false per poi diffonderle.

Un po’ di casi storici

Poi dopo qualche decennio si scopre, ad esempio, che il super testato dietilstilbestrolo (una specie di estrogeno prescritto tra il 1938-1971 per prevenire l'aborto spontaneo) causa centinaia di casi di adenocarcinoma (un tumore, solito insorgere mediamente intorno ai 17 anni) in donne nate (chiamate poi figlie DES) da madri che l’avevano assunto. Oppure che il super testato talidomìde, prescritto in particolar modo alle donne in gravidanza, provoca migliaia di nascituri con deformazioni (es. focomèlia); o, più recentemente (2004), che il super testato Vioxx, “un farmaco per l’artrite, largamente prescritto, fu scoperto aumentare il rischio di infarto e ictus, soltanto dopo esser stato sul mercato per cinque anni” (Conis, 2015: 233).

Per fare un altro esempio, ricordo che Albert Sabin, medico e virologo (inventore di uno dei due vaccini contro la polio), almeno sin dal 1980 (fino al 1993, anno della sua morte), manifestò più volte, mediante interviste stampa e TV, diverse perplessità su alcuni vaccini, sui vaccini antinfluenzali e sulle politiche vaccinali, anche italiane, come quella dell’obbligatorietà del vaccino antiepatite B, come ebbe a dire il 4 dicembre 1991 a RAI 3: «A mio giudizio si tratta di un errore grossolano e sono certo che il ministro della Sanità è stato molto mal consigliato. In realtà in Italia oltre l’80% di casi si verificano tra i tossicodipendenti che fanno uso di siringhe infette o che non cambiano siringhe (…) Affrontando questi aspetti del problema si otterrebbero risultati migliori di quelli garantiti dalla vaccinazione obbligatoria previsti dalla legge appena approvata...». Quel “mal consigliato” fu più chiaro vent’anni dopo, quando la magistratura accertò (con sentenza definitiva nel 2012) che l’allora ministro, il medico e liberale De Lorenzo, nel febbraio 1991 aveva ricevuto una tangente di 600 milioni di lire dalla Smith Kline Beechm (Glaxo), l’azienda produttrice proprio del vaccino Engerix B. Non risulta che De Lorenzo sia stato poi radiato dall’ordine dei medici.

Proprio quest’ultimo episodio ci insegna che i sociologi, psicologi, filosofi così ferventemente anti-complottismi dovrebbero avere un atteggiamento meno manicheo e più laico, aperto e tollerante.

Perché i complottismi di oggi potrebbero (ripeto cento volte ‘potrebbero’) essere le verità di domani.

In altre parole, un approccio cauto e “storico” non farebbe male. Come suggeriscono diversi autori (Di Piazza, Piazza e Serra 2018, Veltri e Di Caterino 2017, Cuono 2018, Lorusso 2018, Adinolfi 2019, Gerbaudo 2019, Ottonelli 2019) che hanno individuato diversi limiti epistemologici, descrittivi, normativi e strategici del concetto di post-verità.

Un caso per tutti è quello dell’amianto (ma si potrebbe parlare del tabacco, del DDT, dei coloranti per le bevande ecc.). Un minerale naturale conosciuto e usato sin dall'antichità e fino all'epoca moderna, per gli scopi più disparati: da magici e rituali fino a quelli industriali. In Italia il suo uso è proibito solo dal 1992. Ma “risale agli inizi del ’900 il primo processo in Italia (in Piemonte) nel quale venne condannato il titolare di un’azienda che lavorava amianto perché la pericolosità del minerale era stata ritenuta circostanza di conoscenza comune. La prima nazione al mondo a riconoscere la natura cancerogena dell'amianto, dimostrandone il rapporto diretto tra utilizzo e tumori e a prevedere un risarcimento per i lavoratori danneggiati, fu la Germania nazista nel 1943”[1]. Ma si sa: i nazisti facevano propaganda.

Patologizzare la critica sociale, comprimere il dissenso

Dal punto di vista scientifico, ‘complottismo’[2] è un termine che richiama un concetto con uno statuto epistemologico molto incerto e controverso. Tant’è che risulta essere un termine molto carico politicamente. Infatti secondo l’antropologo Didier Fassin (2021) esiste una tendenza crescente, nelle scienze umane, ad assimilare la critica sociale al pensiero cospirativo, utilizzando il secondo per delegittimare la prima. Per cui, mediante questo termine, abbiamo un inquinamento della sfera pubblica e un disincentivo alla partecipazione.

Allo stesso modo, il politologo greco Yannis Stavrakakis, parlando di ‘populismo’, argomentava che che è una categoria, più che descrittiva, normativa, e di conseguenza ‘performativa’, nel senso che è una costruzione di coloro che governano (gli anti-populisti) per imporre i loro “regimi di verità”, come li chiamava Michel Foucault (un autore che gli studiosi anti-complottisti sembrano aver dimenticato).

A tal fine, il filosofo della scienza Paul Feyerabend (1975), a cui il dibattito sul complottismo avrebbe probabilmente fatto ridere, diceva che “nella scienza occorre dar voce a tutti, anche ai punti di vista che in quel momento possono sembrare errati”. E continuava “è opportuno conservare tutte le teorie, anche quelle che nel corso del tempo sono state scartate, perché è sempre possibile che tornino attuali”, perché ogni teoria non è mai sviscerata in tutti i suoi aspetti: la deriva dei continenti, un tempo ritenuta una teoria pseudoscientifica, è oggi parte integrante del patrimonio scientifico, soprattutto dopo la scoperta delle prove paleomagnetiche che sostengono il concetto di tettonica a zolle. Anche l'evoluzione della specie o l'eliocentrismo furono inizialmente sottoposte a feroci critiche scientifiche.

E la filosofa femminista Sandra Harding sosteneva che “anche le scienze naturali (es. fisica e chimica), e non solo le scienze umane (es. sociologia e antropologia), sono influenzate anche dalle credenze e opinioni personali degli scienziati”.

Le trappole mentali dei debunkers e fact checkers

Sembrerebbe che solo i complottisti ragionino in modo surreale. Ed è compito dei debunkers e fact checkers, i Roland Freisler o gli Andrej Vyšinskij del XXI secolo, scoprire l’infondatezza di quelle che poi saranno definite fake news.

C’è però un particolare. Inquietante. I debunkers sono strabici: fanno il pelo sempre ai critici dello status quo, e quasi mai ai governanti o coloro che gestiscono il sistema dell’informazione. Per cui operano all’interno dei “regimi di verità” e dei “regimi di discorso”.

Altrimenti avrebbero indagato e scoperto l’infondatezza (per fare uno degli esempi più clamorosi) delle dichiarazione del Segretario di Stato americano, Colin Powell, che il 5 febbraio 2003 all’assemblea generale dell’ONU aveva mostrato le fotografie di laboratori mobili (si scoprì poi che erano dei modellini) di costruzione di armi biologiche (le famose armi di “distruzione di massa”) e avrebbero guardato cosa conteneva (talco anziché antrace) quella fialetta esibita teatralmente durante il suo discorso.

In altre parole, i debunkers e gli anti-complottisti soffrono delle stesse trappole mentali dei cosiddetti complottisti. Essi cadono nel fenomeno della “reazione all’oggetto” (Cacciola e Marradi 1988), fenomeno socio-cognitivo-emotivo, per cui nel dare un giudizio su una notizia si guarda alla fonte PRIMA che al contenuto. Per cui se la fonte è un’istituzione rispettata, allora le sue notizie non possono essere che vere (così successe per Colin Powell, mentre Saddam Hussein faceva propaganda). E’ viceversa.

Ma il contenuto della notizia non viene quasi mai esaminato senza preconcetti.

In conclusione, anti-complottisti “di terra, di mare e dell'aria”… datevi una calmata.

NOTE E BIBLIOGRAFIA

[1] https://www.inail.it/cs/internet/docs/dossier_storia_amianto-pdf.pdf

[2] Un tempo si chiamava “dietrologia” (vedi https://www.ilpost.it/2024/02/08/sgobba-quando-il-complottismo-si-chiamava-dietrologia/)

Adinolfi, M. (2019). Hanno tutti ragione? Post-verità, fake news, big data e democrazia. Roma: Salerno Editrice.

Cacciola Salvatore e Marradi Alberto (1988), Contributo al dibattito sulle scale Likert basato sull’analisi di interviste registrate, in Marradi (a cura di), Costruire il dato, Milano: Angeli, 63-105.

Conis, Elena (2015), Vaccine Nation. America’s Changing Relationship with Immunization, Chicago: University of Chicago Press.

Cuono, M. (2018). “Post-verità o post-ideologia: un problema politico,online e offline”. In Web e società democratica: un matrimonio difficile, a cura di E. Vitale and F. Cattaneo, 66–82. Torino: Accademia University Press.

Di Piazza, S., Piazza, F., and Serra, M. (2018). “Retorica e post-verità: una tesi controcorrente”. Siculorum Gymnasium 71 (4): 183–205.

Fassin, Didier (2021) Of Plots and Men. The Heuristics of Conspiracy theories,in Current Anthropology, 62(2), pp. 128-137.

Feyerabend, Paul K. (1975) Against Method, Londra: Verso Book. Trad. It. Contro il Metodo. Milano: Feltrinelli, 1979.

Gerbaudo, P. (2019). “Una falsità scomoda: fake news e crisi di autorità”. In Fake news, post-verità e politica, edited by G. Bistagnino and C. Fumagalli, 74–91. Milano: Fondazione Giangiacomo, Feltrinelli.

Harding, Sandra (1993). “Rethinking Standpoint Epistemology: What is Strong Objectivity” Feminist Epistemologies (a cura di) Alcoff L., Potter E., New York e Londra: Routledge.

Lorusso, A. M. (2018). Postverità: fra reality tv, social media e storytelling. Bari: Laterza.

Ottonelli, V. (2019). “Disinformazione e democrazia. Che cosa c’è di fake nelle fake news?”. In Fake news, post-verità e politica, a cura di G. Bistagnino and C. Fumagalli, 92–115. Milano: Fondazione Giangiacomo Feltrinelli.

Stavrakakis, Y. (2017). “How did ‘populism’ become a pejorative concept? And why is this important today? A genealogy of double hermeneutics”. POPULISMUS Working Papers 6.

http://www.populismus.gr/wp-content/uploads/2017/04/stavrakakis-populismus-wp-6-upload.pdf

Veltri, G. A., and Di Caterino, G. (2017). Fuori dalla bolla: politica e vita quotidiana nell’era della post-verità. Sesto San Giovanni: Mimesis.

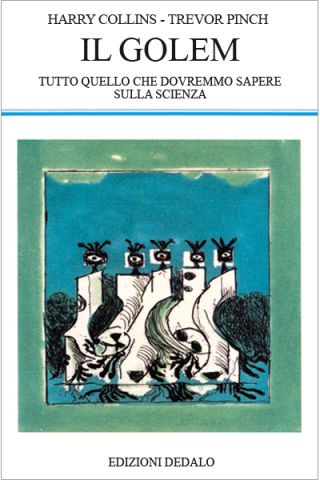

Il Golem - Tutto quello che dovremmo sapere sulla scienza, di H. Collins & T. Pinch

Il Golem – Tutto quello che dovremmo sapere sulla scienza, di H. Collins & T. Pinch, Edizioni Dedalo, 1995

Per la prima volta, un libro di scienza ma soprattutto un libro sulla scienza, presentata come un’attività umana con errori e debolezze: una questione di abilità più che di logica.

Qui, l’articolo di Teo Donolato con alcune considerazioni sulla scienza, a partire da Il Golem:

«La scienza sembra essere o tutta buona o tutta cattiva»; così inizia Il Golem, saggio pubblicato nel 1993 dai sociologi Harry Collins e Trevor Pinch.

Il testo prende le distanze da una visione strettamente dicotomica dell’impresa scientifica che ne considera solo gli estremi (o tutta buona o tutta cattiva) e ne dà un giudizio etico.

Ma allora, addentrandoci nella trama e dei casi raccolti da Trevor e Pinch, viene da chiedersi: che cos’è la scienza?

Secondo gli autori essa è un golem, «un umanoide creato dall’uomo con acqua e argilla, con incantesimi e magie»; esso ha una forza formidabile, ma è goffo e addirittura pericoloso: «se non è sottoposto a controllo, un golem può distruggere i suoi padri con la sua smisurata energia». Scopo di questo libro, allora, è di mostrare come la scienza sia a tutti gli effetti un golem, quindi non un’entità necessariamente malvagia ma una creatura che, nonostante la sua forza, si rivela impacciata e maldestra.

Le nuvole scrivono il cielo di Seveso - Il crimine di pace, la scienza e il potere

06/02/2024Seveso,Partecipazione popolare,DiossinaTecniche e Tecnologie,Ambiente e Ecologie,Salute e Medicina,Imprese

In questo scritto racconterò brevemente che cosa accadde il 10 luglio 1976 e che cos’era l’Icmesa. In seguito, solleverò alcuni problemi nati con il disastro che interpellano il rapporto tra produzione industriale, ricerca scientifica, ambiente, salute e popolazione, alternando l’utilizzo di fonti bibliografiche, articoli di cronaca e interviste realizzate durante mia ricerca etnografica a Seveso.

10 luglio 1976, ore 12.37

«Eravamo a pranzo. Era anche una bella giornata di sole. Tutto ad un tratto sentiamo pof. Poi un sibilo forte, come se fosse scoppiata una gomma. Ma più forte, come se ci fosse dell’aria che usciva. Io sono corsa sul balcone e come esco dal balcone davanti ho una casa con un altro mio amico. Anche lui era fuori e faceva così [indica il cielo con il dito]. Mi giro e vedo ‘sta nuvola fantastica, bellissima. Bianca. Proprio di un bianco, proprio bello. Bella, sì1».

Chi era presente quel giorno a Seveso non si aspettava una nuvola così bella e così pericolosa proprio in quel momento. Tuttavia, il sentore che sarebbe potuto accadere qualcosa era nell’aria.

«[Hoffmann e La Roche, N.d.R.] hanno sempre considerato l’incidente del 10 luglio ‘76 come un evento casuale. E io ho sempre detto: vero, nel dire casuale il dieci luglio 1976 alle 12.37. L’impianto era talmente obsoleto, la fabbrica e i relativi controlli erano talmente privi di sistemi di sicurezza che un incidente era nelle corde»2, mi ha raccontato Massimiliano Fratter, sevesino dalla nascita e responsabile del progetto il Ponte della memoria. Non solo il cielo fu scritto dal passaggio delle nuvole velenose, ma il risveglio sensoriale interessò anche l’olfatto. Infatti, Maria racconta che poco dopo aver visto quella nuvola bellissima ha sentito anche l’odore di saponetta, «quell’odore buono di profumo». Quello solito a cui era abituata3. L’Icmesa era soprannominata dagli abitanti della zona la fabbrica dei profumi4 per gli odori che la sua produzione esalava.

Le origini della fabbrica risalivano al 1921. Prima della seconda guerra mondiale l’azienda aveva sede a Napoli. Dopo la distruzione dello stabilimento campano a causa dei bombardamenti, la fabbrica fu trasferita Meda, sotto il controllo del gruppo svizzero Givaudan, che ne deteneva il pacchetto azionario di maggioranza e che a sua volta era stata acquisita dalla multinazionale farmaceutica Hoffmann-La Roche5. La produzione dello stabilimento cominciò tra il 1946 e il 1947 e consisteva nella realizzazione di componenti chimici, alcuni dei quali ad alto tasso di pericolosità. In particolare, dal 1969 il reparto B era stato utilizzato per la fabbricazione del 2,4,5-triclorofenolo (TCF), una sostanza impiegata principalmente per la preparazione di alcuni tipi di erbicidi e per la produzione di esaclorofene, un antibatterico utilizzato in alcuni tipi di cosmetici, di saponette e di disinfettanti6.

Tuttavia, per una parte della popolazione di Seveso, per alcuni medici e giornalisti di cronaca locale, l’Icmesa non solo inquinava da anni e avvelenava gli operai e la gente, ma produceva sostanze pericolose non solo per la cosmesi. La fuoriuscita di diossina sarebbe stata una prova.

L’8 agosto 1976 Pierpaolo Bollani intervista (per il Tempo) Fritz Möri, l’ingegnere che aveva progettato il reattore per la produzione di triclorofenolo. Nelle scettiche parole del tecnico di Losanna rispetto all’eventualità di formazione di TCDD nel reattore “a meno di compiere errori madornali», viene presentata la possibilità «che all’Icmesa in quel reattore, La Roche producesse in realtà altre cose»7. Lo stesso direttore tecnico della Givaudan Jörg Sambeth ha ammesso che l’Icmesa era una dreck fabric, una fabbrica sporca, dove l'impianto veniva fatto funzionare al di sotto di qualsiasi standard ragionevole di sicurezza e dove si portavano avanti due linee di produzione: una feriale, più pulita e probabilmente destinata a usi civili, e una festiva, realizzata a temperature critiche, vicine al punto di combustione e di sintesi della diossina.

Anche se non sapremo mai con certezza che cosa producesse l’Icmesa, quanto è accaduto a Seveso pone delle domande attuali in merito al rapporto tra la produzione industriale – e la correlata ricerca scientifica – e l’ambiente, la salute, la popolazione e la guerra. In un intervento contenuto nell’autoproduzione Topo Seveso. Produzioni di morte, nocività e difesa ipocrita della vita8 viene considerata la sottile separazione tra le «produzioni chimiche per la guerra o per la pace»9 perché «è durante la pace che si prepara e si arma la guerra: sono le stesse aziende che producono materiale da imballaggio, detergenti, disinfettanti, che poi preparano anche la base per le bombe e le altre armi chimiche, così come sono le aziende che producono le pentole e le travi per la costruzione che confezionano anche le armi. E le aziende che producono altro, non direttamente implicabile con la guerra, possono sempre investire nel mercato delle armi, più o meno legalmente»10.

Si tratta di una questione centrale per il momento storico in cui viviamo e che toglie il velo di Maya dalla ricerca scientifica intesa come attività neutrale e ab-solutas. Ci fa interrogare sui programmi di ricerca e applicazione delle istituzioni in cui studiamo e dei luoghi in cui lavoriamo. L’evento straordinario di Seveso amministrato secondo le regole dell’ordinaria amministrazione – come Laura Conti ha evidenziato nel reportage Visto da Seveso11 – ci parla ancora oggi delle relazioni che intercorrono tra industria, tecnologia e ambiente. I termini con cui l’evento del 10 luglio 1976 è stato definito sono numerosi e carichi di significati e orizzonti culturali e politici diversi tra loro: incidente, tragedia, fatto, disastro, catastrofe, crimine.

A mio avviso, il concetto di catastrofe, liberato dal particolare uso linguistico sevesino, è utile per focalizzare alcuni nodi della questione. La catastrofe genera paradossi e campi di forze contradditorie. I conflitti nati dall’evento catastrofico hanno interessato la concezione di progresso, di scienza, di salute e di ambiente di un intero Paese. L’agone tra le differenti e opposte prospettive di trattare l’evento straordinario dell’Icmesa ha avuto luogo nelle strade di Seveso, negli ufficiali comunali e nelle aule del Parlamento, nei centri di ricerca nazionali e internazionali, negli articoli di giornale e nelle fabbriche e ha svelato le forze, gli interessi e le asimmetrie di potere strutturali italiane e globali.

Le catastrofi sono totalizzanti e per questo come scrive Mara Benadusi sono «oggetti antropologici e filosofici “buoni da pensare”»12 . Ponendosi come cesure che differenziano un prima e un dopo temporale e spaziale, investono ogni sfera della vita umana e sociale. Le traiettorie biografiche individuali e collettive sono state catapultate dalla dimensione locale a quella globale. Sandro, un abitante di Seveso incontrato durante il mio lavoro di ricerca etnografico nelle zone del disastro dell’Icmesa, riesce a trasmettere la repentinità dell’evento eccezionale ed emergenziale nella sua uscita dalla dimensione locale della Brianza.

«Questa cosa è sicuramente stata molto importante dal punto di vista comportamentale della popolazione perché eri passato da una emerito sconosciuto a uno stronzo che sta inquinando il mondo. Non so come dire […] È una cosa che magari c'è chissà da quante altre parti. Ma finché non succede il fattaccio, nessuno lo viene a sapere»13.

Il crimine di pace – come lo ha definito Giulio A. Maccacaro, ha sconvolto le comunità di Seveso, Meda, Desio e Cesano Maderno14. In quei territori approdo delle migrazioni interne dell’Italia del secondo dopoguerra, l’economia di tipo artigianale, l’identità di campanile e i valori del lavoro e della religiosità cristiana cattolica furono sconquassate dalla nube del 10 luglio 1976 e dalle lotte sociali e politiche che seguirono. Bruno Ziglioli scrive:

«La popolazione si riaggregò e si divise su basi completamente diverse: tra gli evacuati della zona A che desideravano rientrare nelle proprie abitazioni e gli abitanti rimasti che temevano di essere esposti al veleno; tra coloro che erano sistemati al residence di Bruzzano (cioè vicino a casa) e quelli che invece erano alloggiati al motel Agip di Assago (molto più distante); tra chi tendeva a minimizzare e chi a enfatizzare il pericolo; tra chi era favorevole all’incenerimento in loco del terreno contaminato e chi invece chiedeva di sperimentare tecniche di decontaminazione meno invasive. Vi furono manifestazioni, proteste, blocchi stradali; gli sfollati rioccuparono a più riprese le case nella zona ad alto inquinamento. Come spesso accade in queste situazioni, si innescò anche la caccia al capro espiatorio: i lavoratori dell’Icmesa, e con loro i sindacati, furono additati da una parte degli abitanti come corresponsabili dell’incidente, perché avrebbero conosciuto e taciuto i rischi del processo produttivo e le scarse condizioni di sicurezza dello stabilimento»15 .

Tuttavia, furono proprio gli operai a interrompere la produzione della fabbrica perché dalla direzione non era arrivata nessuna indicazione chiara. Amedeo Argiuolo, operaio dell’Icmesa, ha raccontato in una recente intervista per il Giorno che «all’inizio, l’azienda tentò di minimizzare. Il reparto B era chiuso, e noi ci chiedevamo perché…i responsabili dell’Icmesa dicevano che era solo un piccolo incidente, che era tutto sotto controllo, anzi aveva mandato qualcuno di noi, solo guanti e mascherine, a fare carotaggi: dicevano che avevano mandato tutti ai laboratori di Basilea e ci avrebbero fatto sapere. Secondo loro, bisognava continuare a lavorare»16.

Il Consiglio di fabbrica dell’Icmesa ha avuto un ruolo fondamentale per fare emergere la pericolosità dell’accaduto non solo all’interno della fabbrica, ma per la popolazione e il territorio circostante. Alberto, abitante delle zone interessate dal disastro, ricorda che: «Qui [a Seveso] era nato anche un comitato. Si chiamava Comitato tecnico scientifico popolare17 e metteva insieme sia il Consiglio di fabbrica dell’Icmesa che ha avuto un ruolo importante in questa vicenda sia gli scienziati»18 .

Il CTSP con il medico G. A. Maccacaro e la rivista Sapere hanno messo in discussione la “scienza ufficiale” che procedeva a tentoni e in un primo momento aveva tentato di insabbiare e poi di minimizzare l’accaduto. Il CTSP fece un lavoro di informazione e controinformazione teso a prendere sul serio l’evento sevesino, rompendo «i giorni del silenzio» di Icmesa-Givaudan-Hoffman-La Roche e delle istituzioni italiane. Infatti, durante l’Assemblea Popolare del 28 luglio 1976, organizzata dalla Federazione Unitaria di CGIL-CISL-UIL nelle scuole medie di Cesano Maderno, i membri del CTSP hanno segnalato prima di qualsiasi altro organo ufficiale l’avvelenamento della popolazione e del territorio da parte dell’Icmesa. Gli operai del Consiglio di fabbrica che decisero di chiudere la stabilimento per avere maggiore chiarezza erano una parte fondamentale e attiva nel Comitato. Tra le pagine del numero di Sapere interamente dedicato a Seveso, il Gruppo P.I.A.19 dopo aver ricostruito il ciclo produttivo dell’Icmesa nei minimi dettagli conclude interrogando la differenza tra due tipi antagonisti di “cultura e di progresso” e di scienza. Il Gruppo P.I.A. scrive:

«Chi è spinto dalla molla del profitto e adotta la regola che i guadagni sono privati, mentre le perdite sono pubbliche, persegue lo sviluppo di una cultura basata sulla neutralità ed asetticità della Scienza, sulla sua separazione dalla politica, sugli incentivi per la ricerca che provengono dal profitto e dal potere individuali od oligarchici»20 .

Quanto accaduto a Seveso ha aperto la scatola nera in cui sono inestricabilmente imbricate una concezione della scienza neutrale tesa al progresso scientifico-tecnologico, una visione lineare del progresso e delle scelte economiche e politico-istituzionali. Lo scoppio della scatola-reattore ha portato tutte queste questioni e i loro intrecci fuori dalla fabbrica e ha dato vita a un ciclo di lotte per la salute e per l’ambiente di ampia portata, ancora oggi attuali.

NOTE

1 Intervista condotta dall’autrice a Maria, abitante della frazione Baruccana di Seveso, in data 14 settembre 2023.

2 Intervista condotta dall’autrice a Massimiliano Fratter in data 28 luglio 2023. M. Fratter è nato a Seveso, è il responsabile del progetto Il ponte della memoria, ha lavorato all’Ufficio Ecologia del Comune di Seveso e ora è impiegato nella biblioteca dell’omonima città.

3 I riferimenti agli odori insistenti, all’inquinamento del torrente Certesa e alla moria di animali che pascolavano nei prati vicini all’Icmesa possono essere rintracciati nei documenti degli archivi comunali di Meda e di Seveso. Per una loro interpretazione storica, vedi M. Fratter, Seveso. Memorie da sotto il bosco, Milano, Auditorium Edizioni, 2006, pp. 53-75.

4 Il giornalista Daniele Bianchessi nel 1995 ha pubblicato il suo primo libro d’inchiesta intitolato La fabbrica dei profumi. La prima edizione è stata pubblicata da Baldini & Castoldi. Il volume è stato rieditato nel 2016 da Jaca Book.

5 Per un maggiore approfondimento sulla storia e la composizione societaria vedi Camera dei deputati, Senato della Repubblica, Relazione conclusiva, Commissione parlamentare di inchiesta sulla fuga di sostanze tossiche avvenuta il 10 luglio 1976 nello stabilimento ICMESA e sui rischi potenziali per la salute e per l’ambiente derivanti da attività industriali, VII legislatura, doc, XXIII, n. 6, 25 luglio 1978, p. 58; B. Ziglioli, La mina vagante. Il disastro di Seveso e la solidarietà nazionale, Milano, Franco Angeli, 2010, p. 16.

6 Per avere una conoscenza più approfondita dei prodotti dell’Icmesa vedi Camera dei deputati, Senato della Repubblica, Relazione conclusiva, op. cit., pp. 62-64.

7 P. Bollani, Io fabbrico morte. Ecco cosa è successo, «Tempo», 8 agosto 1976, in Giunta regionale della Lombardia, Stampa italiana. 10 luglio 1976, Seveso il dramma della nube tossica, n. 1, p. 24. Per ulteriori informazioni sulla possibili produzioni per la guerra chimica, vedi C. Risé, C. Cederna, V. Bettini, Dietro l’Icmesa in Icmesa. Una rapina di salute, di lavoro e di territorio, Milano, Mazzotta, 1976, pp. 58-69; M. Aloisi [et al.] (a cura di), Seveso. La guerra chimica in Italia, «Quaderni di Triveneto», n. 1, Verona, Bertani, 1976.

8 Aa. Vv., Topo Seveso. Produzioni di morte, nocività e difesa ipocrita della vita, Milano, Autoproduzione, 2007. Vedi, http://tuttaunaltrastoria.info/wp-content/uploads/2022/05/POIDIMANI-Atti_Topo_Seveso.pdf.

9 Ivi, p. 12.

10 Ivi, pp. 11-12.

11 L. Conti, Visto da Seveso. L’evento straordinario e l’ordinaria amministrazione, Milano, Feltrinelli, 1976.

12 M. Benadusi, Antropologia dei disastri. Ricerca, Attivismo, Applicazione. Un’introduzione in Antropologia Pubblica, Vol. 1 n. 1-2, 2015, p. 41.

13 Intervista condotta dall’autrice a Sandro, abitante della frazione Baruccana di Seveso, condotta nel mese di settembre 2023.

14 Si tratta dei quattro comuni della Brianza maggiormente contaminati.

15 B. Ziglioli, La mina vagante. Il disastro di Seveso e la solidarietà nazionale, Milano, Franco Angeli, 2010, p. 46.

16 https://www.ilgiorno.it/monza-brianza/cronaca/operaio-icmesa-fuoriuscita-diossina-0de68f02

17 Da questo punto, userò l’acronimo CTSP per riferirmi al Comitato tecnico scientifico popolare.

18 Intervista condotta dall’autrice ad Alberto presso la sede del Circolo Legambiente – Laura Conti in data 22 agosto 2023. Quando si è verificato il disastro, Alberto aveva 15 anni e andava a scuola a Cesano Maderno.

19 È il Gruppo di prevenzione e di igiene ambientale del Consiglio di fabbrica della Montedison di Castellanza.

20 Gruppo P.I.A, B. Mazza, V. Scatturin, ICMESA: come e perché in Seveso. Un crimine di pace, «Sapere», n. 796, nov.-dic. 1976, Bari, Dedalo, p. 34.

Immagine analogica ed Intelligenza Artificiale - Due mondi apparentemente distanti

06/02/2024Tecniche e Tecnologie,Intelligenza Artificiale

Questo post nasce dal seminario tenuto da Diego Randazzo, artista visivo, sul tema “Immagine analogica ed Intelligenza Artificiale. Due mondi apparentemente distanti”.

Randazzo ha illustrato alcune funzionalità dei sistemi dialogativi di Intelligenza Artificiale text-to-image come, ad esempio Dall-E o Midjourney, nella generazione di immagini partendo da altre immagini o da una serie di specifiche dettate su una linea di comando.

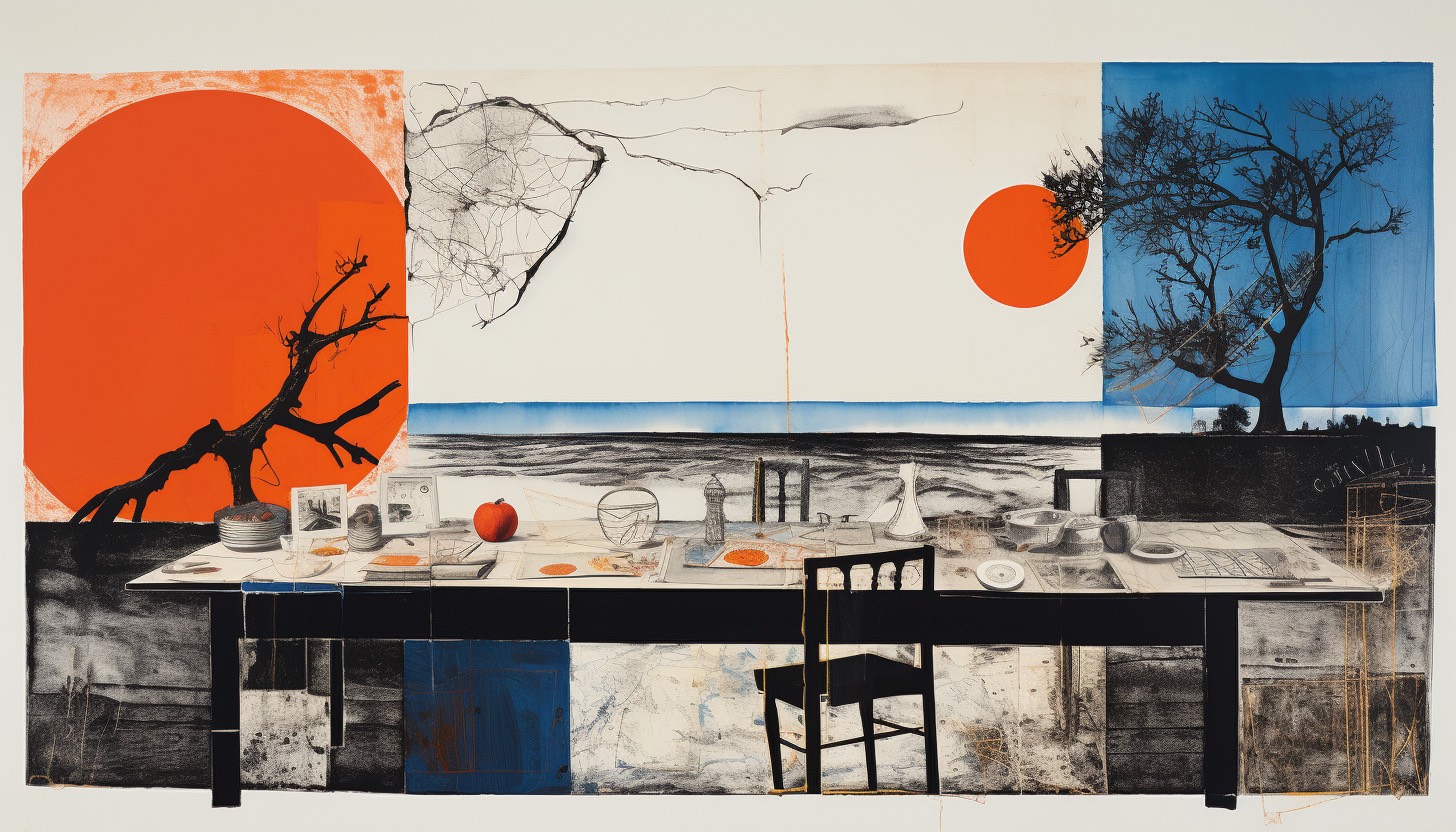

Queste peculiari funzionalità della IA generativa permettono ad un artista di far generare ai sistemi delle immagini su cui poi intervenire per creare lavori del tutto personali. Oppure, dà la possibilità di generare anche immagini ibride, come, a titolo di esempio, quella di una tavolata che meticci l’Ultima cena di Leonardo da Vinci e le tavole da pranzo di Vanessa Beecroft.

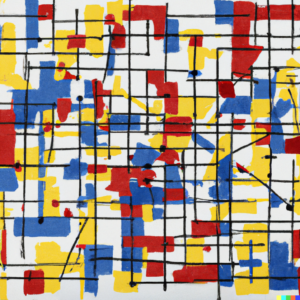

Questi di seguito sono esempi generati in tempo reale durante il seminario:

Comando:

Ultima cena di Leonardo, tavola da pranzo Vanessa Beecroft

Comando:

Ultima cena di Leonardo e Les Demoiselles D'Avignon di Picasso

Comando:

Un Pollock ed un Mondrian

La narrazione e gli esempi hanno suscitato una serie di interrogativi sulle nozioni caratteristiche del discorso artistico, in termini epistemologici e filosofici, interrogativi a cui Randazzo risponde in questo articolo.

--------

Paolo Bottazzini: La possibilità di derivare da regole statistiche un'istanza visiva o sonora, la rende un'opera d'arte o un modello possibile per un'opera d’arte?

Diego: Io parlo spesso di reference, di approccio critico e di didattica. Questi fanno parte dell’opera d’arte, ma sono solo alcuni degli elementi che dovrebbero scaturire da un’opera d’arte.

Parallelamente si può tranquillamente dichiarare, che la generazione di un’immagine con l’AI è l’inizio di un processo che può portare alla creazione di un’opera, ma non è esaustivo.

E penso - scusate la provocazione - che questo discorso valga per tutti quegli strumenti che nel corso della storia sono stati designati come strumenti a disposizione dell’artista: matita, pennello, sgorbia, scalpello, macchina fotografica, cinepresa, videocamera, computer.

Infine, le regole statistiche a cui accennate, non possono essere controllate dall’utente che, forzatamente, si deve accontentare dei risultati ricevuti. Questo mi ricorda un po’ il gioco di matrice surrealista denominato Cadaveri squisiti (cadavre exquis), a mio parere contributo fondamentale alla definizione di collage. Non stiamo in fondo parlando di questo? Associazioni e combinazioni testuali e visive, spesso incontrollate e provenienti da fonti diverse.

Quindi la descrizione che suggerite mi sembra appropriata, aggiungendo un trattino: l’AI come modello-strumento possibile per creare un'opera d’arte. Ci sono diverse modalità di utilizzo dell’AI per creare immagini; tra tutte credo sia molto affascinante la funzione che permette di espandere un ‘immagine preesistente, caricata nel software di AI.

Il ‘riempimento generativo’, lo considero una sorta di strumento conoscitivo, che a partire da qualcosa di personale (es. un’immagine dell’autore) permette di amplificare ed espandere l’universo visivo dell’autore stesso.

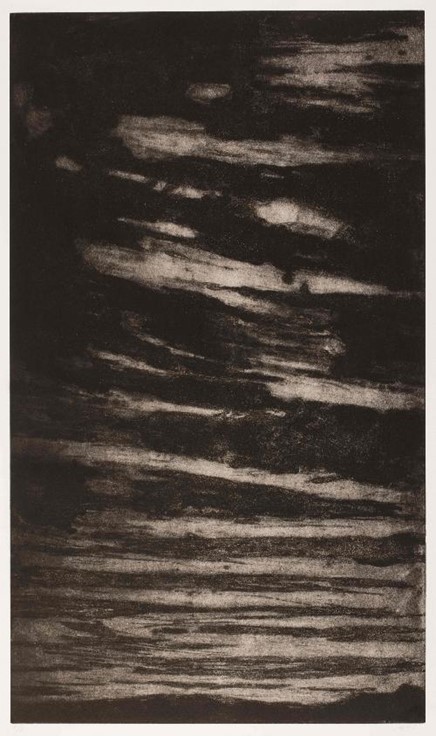

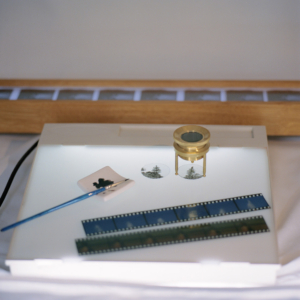

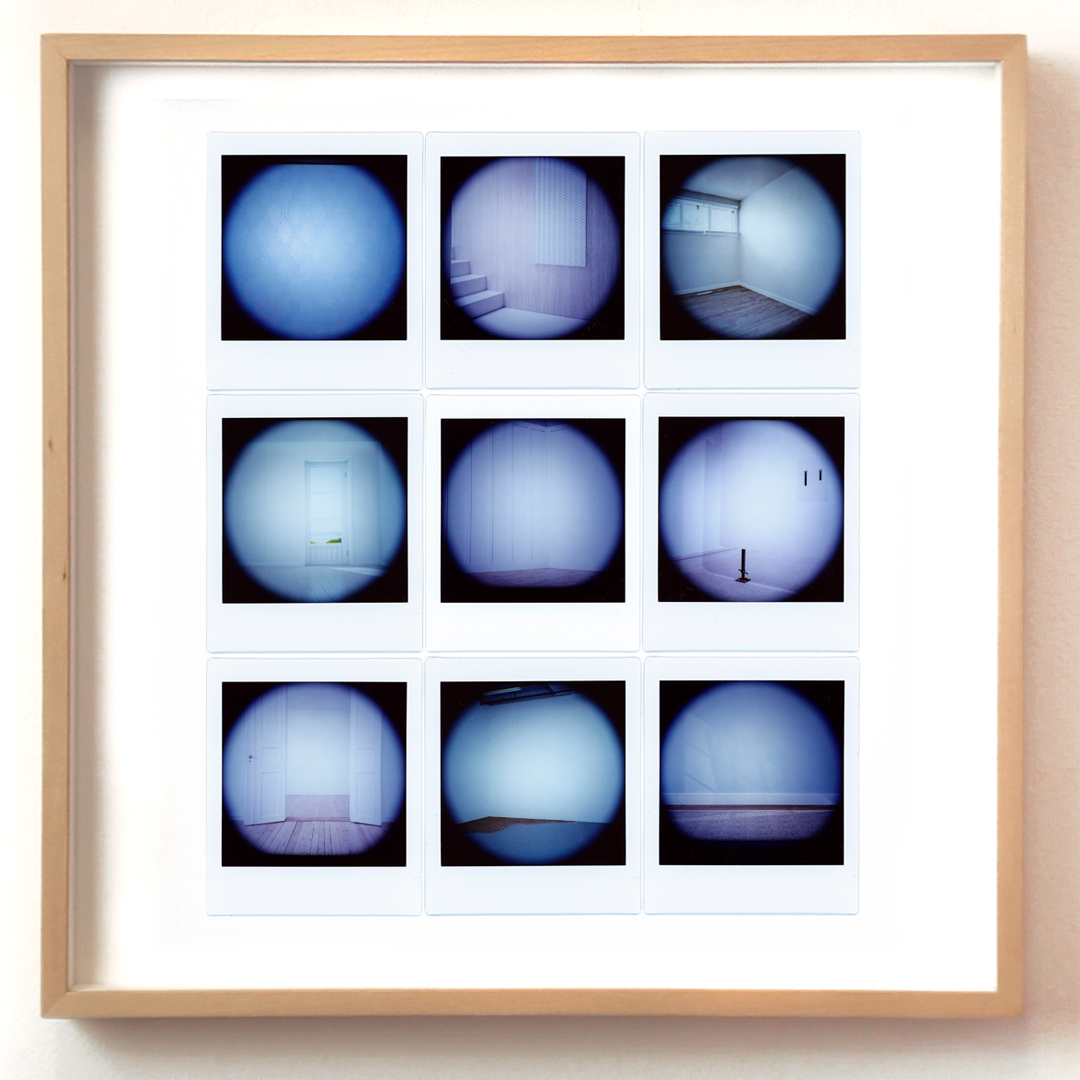

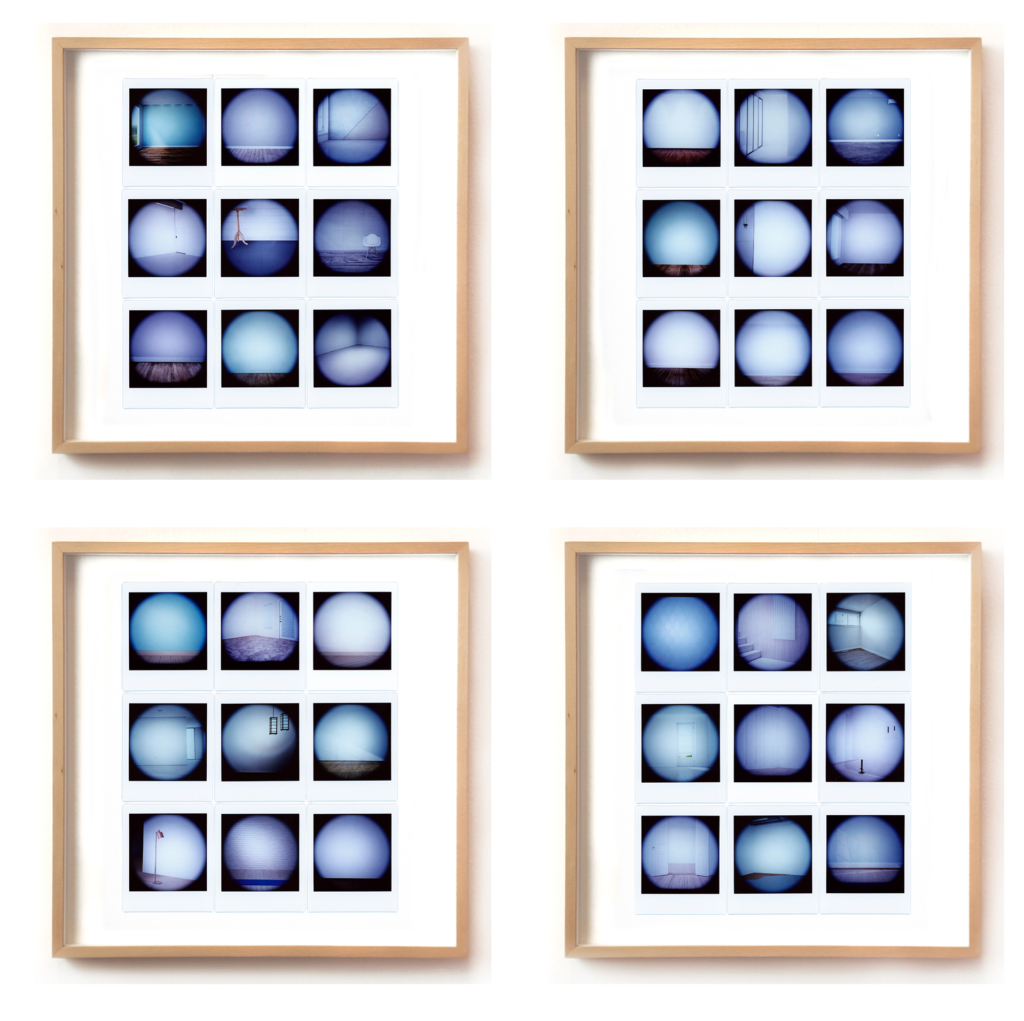

Riporto qui di seguito uno dei primi esperimenti realizzati con Dall-E a partire da alcune fotografie realizzate in pellicola medio formato (estratte del mio progetto Illusorie visioni d’argento del 2018). La prima immagine è lo scatto originale, le successive sono le espansioni generate con l’AI. E’ evidente come il rapporto che si instaura tra originale e rielaborazione AI è molto significativo, c’è una forte connessione tra due mondi che tendenzialmente teniamo separati. Qui, la concretezza del manufatto analogico e l’intangibilità dell’immagine sintetica si toccano e diventano un tutt’uno.

Lenti d’ingrandimento in ottone, becher, pellicole di piccolo e medio formato, macchine fotografiche analogiche… a questi oggetti/soggetti provenienti dal mondo proto-fotografico sono accostati altri della natura più varia (frutta e verdura imprecisata, gelatina alla menta, piante, droni, congegni elettrici, elettronici, digitali ed immagini olografiche) disposti su improbabili limbi e tavoli da lavoro componendo un eterogeneo repertorio di composizioni panoramiche. Ad una prima occhiata ci paiono dei set fotografici che strizzano l’occhio all’ambito still-life, ma avvicinando lo sguardo qualcosa non funziona. Il progetto "Elegie dell'impossibile verosimile" è un’inedita opera meta-fotografica, non ancora pubblicata, che esplora la relazione tra mondo analogico e digitale. Ogni composizione è creata a partire da uno scatto in medio-formato e successivamente combinata con altre immagini generate con il software di intelligenza artificiale Dall-E 2, che analizza un testo descrittivo e genera immagini corrispondenti. Il lavoro sperimentale affronta il tema dell'autenticità delle immagini nella contemporaneità, considerando la macchina come una possibilità di estensione poetica dell'immaginario dell’artista.

Di seguito, alcune immagini tratte da Illusorie visioni d’argento (2018), dove la prima immagine è lo scatto originale, eseguito con pellicola fotografica di medio formato, e la seconda è l'espansione dell’immagine realizzata con Dall-E.

Non a caso, nel corso del seminario di Controversie, puntavo proprio a delineare un percorso di analisi che intravede nell’immagine analogica l’antecedente concettuale della funzione generativa nell’AI.

Il mio punto di vista, sicuramente non allineato alle maggiori correnti di pensiero sul fenomeno, vuole dimostrare che alcune tendenze visuali attuali dell’AI (la dimensione distopica, disturbante, deformante da una parte e la tendenza del vintage dall’altra) non solo sono vicine, ma sono in perfetta continuità con il mondo analogico e protofotografico.

Ecco alcune linee guida, per punti, che sono state oggetto di discussione durante il seminario:

L’immagine analogica ed un certo uso dell’Intelligenza Artificiale hanno in comune la sorpresa, il mistero e la casualità. Sorpresa e mistero erano già presenti nei congegni del Precinema (le vedute ottiche dei Mondi Nuovi, vetrini e lanterne magiche, fenachistoscopi, zootropi, mutoscopi e diorami).

La sorpresa negli occhi dello spettatore ottocentesco di fronte ai congegni del Precinema (molti di questi basati sulla persistenza retinica) in qualche modo è simile a quella del pubblico di oggi davanti ad un’immagine elaborata con l’AI; stiamo parlando di quello spaesamento prodotto da qualcosa di nuovo che non riusciamo a cogliere completamente, ma che ci affascina e ci rapisce.

La casualità e l’attesa: non è possibile conoscere a priori il risultato di un’elaborazione di immagine fatta con l’AI, come non è possibile conoscere istantaneamente il risultato di uno scatto analogico. Bisogna scontrarsi con l’attesa, la perizia e la pazienza. Di fronte ad un’interrogazione posta ad un software di AI non abbiamo ancora un controllo totale sul risultato, dobbiamo affidarci al mix di combinazioni proposte dall’algoritmo.

SORPRESA: Da un’interrogazione non sappiamo cosa aspettarci, e molto spesso il risultato che ci viene restituito è sorprendente (sia in termini negativi che positivi).

ATTESA: La risposta dell’AI non è istantanea. L’attesa contribuisce a creare mistero e aspettativa.

CASUALITÀ E UNICITÀ’: un mix di combinazioni algoritmiche formula un risultato che è sempre unico. A parità di richieste, se ripetiamo più volte la stessa interrogazione, il risultato sarà sempre diverso.

Nell’AI si possono notare alcuni filoni narrativi e formali:

-

- contenuti surreali, distopici ed iperrealisti (il loro successo si basa sull’effetto wow)

- riproposizione formale del ‘vintage’: la grana della pellicola, certo utilizzo del bianco e nero oppure l’uso di filtri che richiamano specifiche pellicole fotografiche; ma in realtà questo recupero dei codici visivi del mondo analogico era già presente sin dagli albori di Instagram (il formato quadrato 6x6, l’uso delle cornici con perforazioni tipiche della pellicola e dei filtri ecc.)

Questo secondo filone è senza dubbio il più interessante e meno omologato del primo, perché si origina da un sentimento comune che possiamo chiamare nostalgia. Con due discriminanti:

i giovanissimi utilizzano questi codici in maniera inconsapevole, per inseguire la tendenza del momento. Nel nostro caso la tendenza del vintage. (filtri, cornici fotografiche, oggetti d’epoca o moderni, tecnologie obsolescenti)

I meno giovani, gli studiosi, gli appassionati, vivono questa nostalgia per una tecnologia artigianale, che basa il suo funzionamento sui meccanismi interni presenti nelle macchine: ’‘Il come è fatto’’. Si tratta di tecnologie (es. macchine fotografiche analogiche) che nella loro intrinseca ideazione e costruzione permettevano un utilizzo consapevole. Banalmente, per inserire la pellicola nella macchina analogica bisogna aprirla. Questo aspetto tecnico si inseriva in un processo di consapevolezza tecnologica e didattica, che i successivi sviluppi del digitale hanno progressivamente oscurato. Pensiamo a tutte le apparecchiature digitali che non ci permettono di essere esplorate al loro interno.

Per approfondimenti leggi qui: http://www.diegorandazzo.com/portfolio/immagini-simili-primo-studio/

Redazione di Controversie: Diego, secondo te, dove va a finire l'autorialità, quando l'opera è generata da un sistema informatico intelligente? chi è l'autore? chi ha "chiesto" un'immagine generata secondo alcuni criteri o caratteri, oppure la macchina stessa?

Diego: È una compartecipazione di attività tecniche e di pensiero, ma la firma deve essere necessariamente quella dell’artista. Autore è chi interroga e, soprattutto, rielabora e reinterpreta secondo la propria attitudine il risultato dell’Intelligenza artificiale. La macchina fa le veci del ricercatore: mette insieme e fonde tantissimi dati e, in ultima istanza, restituisce un ‘abstract grezzo’. Quell’abstract non può rimanere tale. Deve essere decostruito e manipolato dall’artista per assurgere ad opera d’arte. L’AI, come processo generativo, è quella cosa che sta in mezzo, tra il pensiero, l’idea iniziale e l’opera finale. Tutto qui. Non è semplificazione, è come dovrebbe essere inteso il ruolo dell’intelligenza artificiale nella creazione.

Il termine manipolazione, che ho appena usato, non è casuale. Innanzitutto, mi sta a cuore, perché ogni mio lavoro, che si origini da una fonte personale o da un’immagine pescata sul web, è soggetto, da sempre, ad una stratificazione di gesti ed elaborazioni, con conseguenti risemantizzazioni della sorgente iniziale, tanto da diventare una parte della mia cifra stilistica. Inoltre, manipolare si rifà proprio a quella manualità, che per me è anche ‘manualità nel pensare’, fondamentale per una trascrizione unica ed originale del processo creativo.

Il lavoro di elaborazione dell’AI implica una fusione di elementi eterogenei. Perciò nei risultati ottenuti prende forma una commistione di stili e soggetti diversi, tutti fusi assieme, tanto da creare delle aberrazioni inusuali nelle immagini. Questo processo di fusione, che spesso dà luogo ad una spaccatura di senso con l’interrogazione dell’utente, l’intelligenza artificiale lo gestisce molto bene. E l’aspetto forse più interessante è che l’algoritmo non rivela mai le sue fonti (il grande database da cui attinge), rimane misterioso a differenza degli artisti che, con un pizzico di orgoglio, snocciolano le proprie reference, le motivazioni ed i maestri ispiratori.

Siamo meno bravi nel farlo (fondere fonti diverse per creare qualcosa di nuovo) perché puntualmente inciampiamo nel facile citazionismo. E questo spesso ci riduce a degli abili saccheggiatori di pensieri ed immagini.

Forse demandare la ricerca delle proprie reference all’AI e affidarsi, in qualche modo, alla vertigine del caso, senza che il nostro ego si manifesti prepotentemente, può essere la nuova sfida della ricerca contemporanea. Mantenendo però fede alle premesse iniziali: quell’abstract fornito dall’AI non costituirà mai l’opera definitiva, bensì l’inizio di un processo dialettico.

Redazione di Controversie: Esistono ancora il concetto di unicità e di originalità di un'opera, quando il lavoro viene fatto "a macchina”?

Diego: Riprendendo in parte la prima risposta, non vedo ancora un pericolo per l’unicità dell’opera d’arte. Se, l’avvento del digitale (dalla fotografia digitale alle immagini virtuali) non ha messo in crisi questo principio non credo che sarà l’AI a metterlo in discussione. L’autorialità, se c’è e sappiamo riconoscerla, emergerà sempre sui cloni, sulle copie, sull’omologato. Ci vengono dati quotidianamente gli indizi per farlo e come nel caos dell’infodemia, bisogna aguzzare un po’ la vista per riconoscere il vero dalla finzione. Il nocciolo della questione secondo me è proprio questo: vogliamo veramente conoscere la verità? O forse preferiamo farci confondere da qualcosa che sembra apparentemente più attraente e coinvolgente? Bisogna sforzarsi, per carpire la verità, c’è poco da fare.

Non vorrei sembrare ripetitivo, ma ci tengo a sottolineare un concetto a mio parere fondamentale: la creazione di un’opera attraverso l’AI non può fermarsi al primo risultato ottenuto con un’interrogazione ad un’app. In concreto, stampare un’immagine realizzata con l’Ai ed esporla così com’è non la considero un’operazione artistica, a meno che non ci sia una dichiarata provocazione concettuale nel farlo (e nel caso andrebbe comunque motivata). L’AI è uno strumento, e come il pennello o la macchina fotografica, deve essere sottoposto ad uno sforzo di pensiero critico e di tecniche che lo rendano non solo utile, ma significativo per l’essere umano.

Una cosa interessante, che è anche il motivo fondante ed il filo conduttore del mio seminario: i risultati dell’AI non sono mai ripetibili… perciò i miei studi sul fenomeno mi hanno portato ad equipararlo al mondo dell’immagine analogica. Si tratta, infatti, di un mix di combinazioni algoritmiche che formula sempre un risultato unico. A parità di richieste - se ripetiamo più volte la stessa interrogazione - il risultato sarà sempre diverso. Quindi, se vogliamo, l’unicità dei risultati è un aspetto che ancora di più avvicina il mondo dell’AI a quello analogico e al concetto classico di Manufatto.

DISPOSITIVI / 3

15X16X3 cm,

bassorilievo in Gres, pellicola Instax wide,

elaborazione con Ai, 2023

Courtesy Galleria ADD-art e l’artista

Opera in mostra da Indigo Art Gallery a Perugia fino al 17 febbraio 2024

DISPOSITIVI / 3, dettaglio

Ovviamente il tema dell’unicità è molto ampio, profondo e stratificato, ma se ci soffermiamo sul mero aspetto tecnico, non si può non affermare che l’AI, ad oggi,

produca sempre dei risultati diversi a parità di domande.

E questo è un fatto abbastanza dirimente, soprattutto se lo inseriamo nel solco della produzione artistica.

Gestione sostenibile delle foreste - Una risposta concreta ai problemi climatici e ambientali

06/02/2024Voci dalle imprese,Foreste,SostenibilitàAmbiente e Ecologie,Imprese

Il cambiamento climatico è un dato oggettivo.

La comunità scientifica discute sulle cause e sulle conseguenze, ma non sul fatto che le temperature sul nostro pianeta siano più calde di 30, 50 o 100 anni fa. E anche sulle cause, sono pochissimi gli scienziati che negano l’effetto delle attività umane. La discussione rimane invece aperta rispetto al peso percentuale di queste attività sul fenomeno del riscaldamento globale.

Quindi, possiamo dire che il modello di sviluppo industriale novecentesco è stato largamente responsabile di questa situazione. Parliamo essenzialmente dell’emissione di gas a “effetto serra” che impediscono al calore di disperdersi oltre l’atmosfera. Si tratta dei gas emessi dal bruciare di combustibili fossili per uso industriale, soprattutto per la mobilità e delle emissioni principalmente di CO2, ma anche di metano e protossido di azoto.

Un ulteriore aspetto da non dimenticare è il popolamento degli esseri umani sulla Terra. Non va dimenticato che gli abitanti della Terra sono passati da circa 1,5 miliardi a inizio Novecento a circa 8 miliardi oggi. Otto miliardi di persone che devono nutrirsi e che generano attività economiche, quindi consumano energia. Se il problema sono i combustibili fossili, da tempo sono noti dei possibili rimedi. In primis, la sostituzione del petrolio e dei suoi derivati con energie pulite rinnovabili (sole, vento, maree), l’efficientamento dei processi produttivi e poi il formidabile potere delle foreste.

Ma se la sostituzione del fossile non è affatto semplice perché il bisogno di energia è in continua crescita, sulle foreste il discorso diventa molto interessante. Le foreste sono un formidabile strumento di stoccaggio della CO2, di regolazione del ciclo delle piogge e di conservazione della biodiversità.

Il ricercatore inglese Thomas Crowther dell’ETH di Zurigo stima che attualmente sulla Terra ci siano circa 3.000 miliardi di alberi (!!) ma che 12.000 anni fa fossero più del doppio. Egli stima anche che sul nostro pianeta ci sia spazio per piantare circa 1.000 miliardi di nuovi alberi, che darebbero un contributo enorme a risolvere il problema dei gas serra. Basti pensare che recenti studi hanno constatato che mediamente un albero ad alto fusto assorbe ogni anno 25 kg di CO2 (dato prudenziale, fonte: Ecotree). Naturalmente una piantumazione così massiccia è impossibile all’atto pratico, ma questi dati dovrebbero far capire che la strada della salvaguardia delle foreste esistenti e dell’implementazione di nuove è imprescindibile per risolvere il problema del riscaldamento globale.

Invece è triste constatare come, tutt’ora, il saldo tra deforestazione e nuove foreste sia largamente negativo con circa 10 milioni di ettari persi ogni anno e con la sola eccezione virtuosa dell’Europa che ha 158 milioni di ettari di terreni boschivi, in aumento (Fonte: Rapporto Foreste Legambiente 2023).

---------

Dopo aver brevemente contestualizzato il problema e l’argomento di discussione, ora veniamo al tema dei crediti di carbonio. Si tratta di titoli negoziabili che sono stati concepiti a seguito degli accordi del Protocollo di Kyoto. I crediti di carbonio sono strumenti finanziari introdotti con la finalità di rendere conveniente economicamente la salvaguardia delle foreste. Ogni credito equivale allo stoccaggio di una tonnellata di CO2. Di fatto le imprese possono acquistare questi titoli (su base obbligata per le grandi aziende molto energivore, su base volontaria per le altre) che corrispondono a una gestione forestale virtuosa delle grandi aree forestali africane, sudamericane e asiatiche.

I titoli di credito di carbonio possono essere emessi da consorzi che si sono dotati di un Piano di Gestione Forestale Sostenibile certificato. In queste aree vi è quindi la certezza (non sempre reale, temiamo) che la foresta sarà protetta e ci saranno piani di tagli programmati per aumentare comunque la massa legnosa e l’assorbimento netto di CO2. Tra regolamenti complessi, processi non sempre trasparenti e mille polemiche, in poco come di vent’anni di vita, il meccanismo dei crediti di carbonio non è stato un pieno successo, dal momento che non ha bloccato la deforestazione. Tuttavia, ha generato delle ricadute positive soprattutto con il concetto di Gestione Forestale Sostenibile.

Ma veniamo all’Italia. Nel nostro Paese le foreste godono di buona salute (forse contrariamente al sentire comune). In Italia ci sono circa 11 milioni di ettari di boschi e foreste, e questo dato è in continuo aumento dal dopoguerra (Fonte: Ministero dell’Agricoltura, Rapporto sullo stato delle foreste in Italia).

Grafico di Forest Sisef

Nel nostro Paese si sta diffondendo anche la pratica delle Gestione Forestale Sostenibile: i proprietari di grandi boschi (siano enti pubblici o privati) possono costruire questi piani grazie al lavoro di dottori forestali specializzati che pianificano il monitoraggio accurato dello stato della zona interessata e definiscono le pratiche per salvaguardare il bosco e per incrementare la sua capacità di protezione della biodiversità e dello stoccaggio di CO2. I piani di GFS devono essere costruiti secondo standard di enti riconosciuti. In Italia operano le filiali nazionali dei due maggiori enti internazionali: FSC (Forest Stewardship Council) e PEFC (Programme for Endorsement of Forest Certification).

Qual è il vantaggio di certificare i boschi? Chi vuol vendere legno a scopi industriali ha un plus se ha la certificazione, perché, sempre più, l’industria e i regolamenti richiedono legname certificato. D'altro canto, anche chi vuole promuovere l’uso di boschi per escursioni avrà un vantaggio nel dire che il suo è un bosco gestito in modo virtuoso.

Infine si stanno muovendo dei meccanismi economici. La GFS può generare dei crediti di sostenibilità, ovvero titoli che riconoscono una corretta gestione dei servizi della foresta (ecosistemici). Si tratta di un mercato ancora largamente agli inizi, che il legislatore, sia nazionale che europeo, sta facendo molta fatica a definire e regolamentare. Tuttavia oggi nel nostro Paese esistono consorzi che hanno ottenuto il via libera dagli enti certificatori per emettere crediti di sostenibilità, sulla base di una verifica di un beneficio dei servizi ecosistemici, segnatamente un calcolo dell’addizionalità nello stoccaggio di CO2 del bosco interessato.

Il prezzo di questi titoli oggi non si basa su criteri oggettivi ed è dato da accordi privati tra ente venditore e acquirenti.

Ci si chiederà: che vantaggio acquisisce chi acquista questi titoli? Si tratta di un vantaggio esclusivamente reputazionale. Un’azienda che acquista questi titoli racconta di aver investito nella salute dei boschi e delle comunità che li abitano.

È auspicabile che tutto questo sia solo l’inizio di una crescita di consapevolezza dell’importanza del ruolo di boschi e foreste. Se così sarà, questa consapevolezza potrà innestare un circolo virtuoso tra aziende finanziatrici e sistema naturale a beneficio di ambiente, territorio e comunità.

La conoscenza tecnica - Meditazioni a partire dal pensiero di Platone

30/01/2024Memoria,Platone,ArtigianiTecniche e Tecnologie

In molti conoscono l’esistenza di un dialogo chiamato “Apologia di Socrate”. Al suo interno, oltre al “Socrate che sa di non sapere”, viene reso noto il particolare valore che Platone attribuisce alla conoscenza posseduta dagli artigiani. Ciò avviene nell’ultimo dei tre momenti che Socrate afferma di aver passato alla ricerca degli ateniesi ritenuti “sapienti”.

Dopo aver messo alla prova i politici e i poeti, egli dice:

«Alla fine andai dai lavoratori manuali (cheirotechnas): mentre per conto mio ero consapevole di non conoscere praticamente nulla, costoro prevedevo di trovarli in possesso di parecchie preziose conoscenze. E qui non mi sbagliavo, nel senso che possedevano nozioni a me ignote e in ciò erano più sapienti di me». (Apol. 22 c – d)

Differenza tra “tecnica” e “scienza”

Per Platone esiste un genere di conoscenza unicamente umano, perciò corruttibile1 e quindi di altro genere rispetto alla più famosa forma della reminiscenza,2 un genere di conoscenza analogo a quella del noto essere divino chiamato Demiurgo presente nel dialogo Timeo: una conoscenza che permette “il fare”.

Se il termine “technikoi” indica in generale gli “esperti ”, il termine “demiurgos” indica il “lavoratore pubblico” (l’artigiano libero, non schiavo), mentre i ”cheirotechnas”, quelli di cui parlava Socrate, sono più in generale tutti coloro che producono attraverso le attività manuali. Il loro sapere è tipico dell’essere umano “di ogni giorno”, cioè che interagisce e apprende attraverso la forma di conoscenza che è l’opinione (doxa), di genere meno precisa rispetto a quella dei matematici e dei filosofi, chiamata invece episteme (scienza).

In questi termini, il sapere pratico, come quello scientifico, si genera a partire dall’esperienza del mondo fisico e materiale ma, a differenza del secondo, conclude il proprio percorso nella manipolazione delle cose su questo stesso piano fisico, ponendosi come scopo l’opera di azioni mirate a produrre effetti e oggetti utili sul piano della vita materiale. Diversamente l’episteme procede dall’osservazione e interazione col mondo fisico verso la conoscenza di enti meta-fisici, ambendo a intuirne i modelli,3 i quali comprendono anche le leggi che governano la realtà fisica. Le scienze producono conoscenza sul mondo come insieme complesso e strutturato, dunque prodotti del solo intelletto e non materiali.

Questa differenza è in qualche misura la stessa che ancora oggi troviamo tra “tecnica” e “scienza”. Solo in tempi molto più recenti queste due hanno sviluppato una reciproca interdipendenza quasi senza soluzione di continuità. Ma questo rimarrà per ora solo uno spunto di riflessione suggerito al nostro lettore.

Caratteristiche del “sapere pratico” e particolarità della tecnica

Rimanendo ancora con Platone, l’utilità (opheleia) è sia l’elemento distintivo che il coronamento stesso delle attività produttive proprie delle forme di “sapere pratico”. Agli occhi del Filosofo sono però più le technai (discipline e arti tecniche) a contraddistinguersi per la «utilità per la vita»4 che le altre forme di conoscenza pratica.

L’insieme completo delle forme di sapere rivolte al mondo materiale è infatti più ampio e comprende anche le empeiria kai tribé, che per semplicità tradurremo come “esperienze frutto della pratica”. Queste sarebbero l’insieme di quei “saper fare” non governati dal rigore disciplinare. Ma ne tratteremo in un post dedicato.

Per ora, a solo titolo di esempio, pensiamo a chi “è bravo a fare”5 ma non per questo è un esperto (technos) del campo in cui sa invece solamente districarsi. Questo “saper fare” nelle sue declinazioni è una forma del sapere “al portatore”, posseduta dai singoli individui che mostrano avere una certa disinvoltura e/o dimestichezza “nel fare” cose specifiche.

Ciò su cui dobbiamo qui focalizzarci è che la differenza tra technai ed empeiria kai tribé risiede nel modo in cui esse procedono a ottenere un risultato. Le prime lo ottengono attraverso un rigore simile a quello scientifico, perciò strutturato e disciplinato attraverso il metodo della misura e del calcolo, mentre le seconde devono la propria efficacia alla semplice pratica di azioni che l’individuo che le compie ha imparato “per esperienza” essere utili all’ottenimento di un effetto desiderato.

Le technai dunque mirano alla produzione del proprio effetto a partire da una conoscenza riflessiva dell’intelletto nella forma della retta opinione,6 tratta, finalizzata e combinata all’esperienza empirica (empeiria).

Le vere discipline tecniche inoltre generano propri modelli su cui basare la produzione e proseguire la propria ricerca sperimentale. Va notato infatti che tutti gli artigiani si avvalgono di progetti-modelli di partenza per realizzare i propri prodotti (sedie, abiti, calzature etc.); come anche l’architetto progetta lo spazio secondo misure e calcoli precisi, vincolato per la sua realizzazione alle proprietà della materia costruttiva.

Quello del “tecnico” in generale è dunque un sapere misto di esperienza, metodo e teoria, che muove tra gli estremi della doxa e della episteme. Ѐ un sapere insegnabile e quindi oggetto di apprendimento, che per essere ottenuto dunque necessita di esercizio, pratica, sperimentazione e possiede uno scopo produttivo: produce utilità sul piano fisico.

Questo processo conoscitivo pratico determina quelle forme del sapere che confluiscono nelle discipline tecniche, ossia quelle che dotano l’esperienza sensibile di un grado di articolazione teorica e strumentale forte, rivolgendosi all’attività pratica.7

Spunti di riflessione sul mondo della tecnica oggi

Venendo ora a noi, possiamo trovare in questa analisi di Platone molti punti in comune con il modo attuale di concepire e intendere gli elementi distintivi della tecnica rispetto alla “scienza pura”, tanto da aprirci diverse prospettive di riflessione.

Con ogni evidenza il contesto della cultura tecnica è oggi ampiamente mutato. Possiamo notare per esempio che il crescente trasferimento della pratica produttiva dalle mani dell’artigiano verso tecnologie e macchine complesse e automatizzate, per la loro capacità di facilitare, razionalizzare e potenziare la produzione, è sicuramente preferito per fornire una risposta migliore in termini di produzione quantitativa e temporale. Ѐ quel valore che che oggi definiamo “volume della produzione”.8

Questi strumenti complessi sono anch’essi un prodotto della tecnica, sono prodotti per l’appunto tecnologici, e la loro complessità cresce con l’accrescersi della complessità tecnica, che ne ha infatti permesso la loro progettazione e costruzione.

Ma, e ci sono diversi “MA”, allo stesso tempo ciò comporta inevitabilmente che, uscendo dal dominio delle mani dell’artigiano o comunque sfuggendogli dalle mani per la loro complessità d’utilizzo (per cui saranno necessari ulteriori nuovi ruoli “tecnici”), questi strumenti sono in grado di soppiantare le forme della conoscenza individuale specializzata precedente, tramandata attraverso l’oralità e tramandabile attraverso il coinvolgimento pratico attivo.

Il tecnico nel senso professionale è dunque oggi sempre più un “technikos”, ossia uno specialista. Nel nostro ultimo esempio è “un esperto” di strumenti, macchine e istruzione di processi complessi, più che un “cheirotechnos” o “demiurgos”, ossia un lavoratore manuale esperto. Ciò sposta il tecnico verso forme di conoscenza specialistica di "pratica teorica" e nel ruolo di esecutore di singoli processi più che un progettista “con le mani in pasta”.

Dall’altro lato, una reazione alla produzione così impostata e spersonalizzata è la nascita da parte dei singoli individui di forme d’interesse per le pratiche manuali contro quelle automatizzate e per quelle analogiche contro la sempre più diffusa cultura digitale.

Queste fascinazioni per l’attività pratica diretta le vediamo spesso in opera sia nel campo artistico che in quello dilettantistico, con le conseguenti e rispettive aperture di nuove nicchie di tendenza. Così sottratte al circuito di tramandamento diretto obbligato dalla necessità produttiva, queste conoscenze pratiche finiscono per far ricadere la tipologia di conoscenze del loro “portatore” più nel campo di quelle empeiria kai tribé a cui abbiamo accennato che in quello delle technai. Proviamo ora a pensare a quanti eventi vengono creati oggi con l’intento dichiarato di introdurci al mondo della auto-produzione manuale attraverso brevissime esperienze temporali, quali sono i corsi o i “workshop”.

La caratteristica corruttibilità del sapere pratico che individua Platone diventa maggiormente evidente oggi, in un’epoca storica in cui si assiste alla continua interruzione della linea di trasmissione continuativa di conoscenze disciplinari appartenenti al mondo pre-industriale.

Individuarne i motivi è sicuramente un lungo lavoro che non possiamo qui affrontare, ma in sintesi possiamo affermare che questa perdita dei saperi pratici si debba non tanto a una loro intrinseca “obsolescenza” o al loro “superamento” sul piano del sapere tecnico, piuttosto ciò parrebbe avvenire sul piano della sostituzione tecnologica dell’artigiano per i motivi preferibili di sopra detti.

Potremmo affermare anche che, questo fenomeno della perdita e corruzione dei saperi tecnici pre-industriali, non possa derivare esclusivamente dal loro superamento sul piano della attendibilità del “sapere” in sé preso, poiché il più di queste forme tecniche del passato possiedono di fatto un percorso di affinamento e collaudo nettamente più lungo e verificato (esperito) rispetto ai metodi, ai materiali, alle tecniche e alle tecnologie che si sono affermate solo recentemente, nella nostra epoca contemporanea.

Altrettanto si può confermare ancora oggi come intrinseca e ineliminabile quella natura corruttibile che Platone affermava essere propria di queste forme del sapere pratico tecnico. Queste, infatti, se non vengono tramandate, muoiono con i singoli esseri viventi umani che ne sono portatori-detentori. Il loro recupero futuro sarà perciò tardivo, debole o esposto al dilettantismo.

In tal proposito possiamo aggiungere che i contenuti di queste forme del sapere, anche se messi materialmente per iscritto, non potranno per loro natura sopravvivere alle singole vite degli stessi uomini che ne sono detentori praticanti e alla loro personale memoria, laddove si perda quella parte “pratica” da parte di nuovi eredi diretti di questi saperi. Diverrebbero così testimoniate ma anche quel che si dice “lettera morta”.

NOTE

1 Gli esseri umani sono mortali e tutto ciò che gli appartiene come attributo umano è di per sé corruttibile. Nel precedente post “La memoria e la sua corruzione nell’era digitale - A confronto con il pensiero di Platone” sottoponevo a chi ci legge la complessa questione della Memoria e della sua corruttibilità nel pensiero di Platone. In questo presente post emergerà con maggior evidenza il senso della scelta di presentare un tema così complesso. Platone attribuisce infatti ai “saperi pratici” (definizione di comodo e non platonica) la condizione di corruttibilità. Ed è proprio il tema della corruttibilità di un sapere che il lettore dovrà tenere presente mentre affronterà ciò che troverà qui proposto.

2 La reminiscenza o anamnesis è quel processo di risveglio della memoria dell’anima immortale, perciò che rimane identica al di là delle incarnazioni di ciascun vivente mortale. Questa memoria immortale si sopisce con l’unione dell’anima immortale a un corpo fisico (= incarnazione) e il suo contenuto si riferisce a quelle idee di alto grado metafisico, quali sono il Bene, il Bello, la Giustizia etc..

3 “Idea” o “eidos” significa per l’appunto “modello”.

4 Esplicitamente scrive Platone nel Gorgia che «si occupano della nostra vita fisica» (518 a) , costituendo di fatto veri e propri «sistemi che preparano alla vita» (500 b). Ciò emerge anche in particolare nei passi Gorg. 464 b - 466 a; Phil. 58 c, 63 a; Theaet. 177 e.

5 Chi dice cose apparentemente corrette può essere un sofista e non un tecnico o uno scienziato. Chi esegue belle armonie può essere un musico ma non un musicista. Chi sa creare belle pietanze può essere un cuoco ma non un dietologo. Insomma, non sempre chi appare padroneggiare un argomento o una pratica lo fa sulla base di una conoscenza strutturata, rigorosa, “disciplinata”.