Triangolo, Spazio bianco, Trapezio - Strutture geometriche del management scientifico

23/01/2024Voci dalle impreseSociologie,Imprese

Abbiamo visto come il manager utilitarista abbia evoluto la classica struttura piramidale del management scientifico in una strana forma composita: un triangolo, dato dal vertice e da pochi eletti; una base trapezoidale indistinta; uno spazio bianco che evita il contatto tra le due figure precedenti.

Oggi vediamo le caratteristiche di queste 3 figure del management scientifico moderno all’opera.

Il triangolo: questo livello presenta sia caratteristiche comuni a tutte le impostazioni aziendali, di qualsiasi dimensione e industry, che caratteristiche specifiche dell’impostazione utilitarista. Concentriamoci su queste ultime, ricordando che parliamo di un qualcosa che riguarda lo 0,000003% della popolazione aziendale.

- La prima specificità è la seguente: tutti i componenti sono di netta matrice utilitarista e presentano - le attitudini manageriali che abbiamo visto nel precedente articolo e sulle quali non mi soffermerò qui. -

- La seconda specificità riguarda i criteri di scelta: i criteri per la scelta dei componenti sono differenti a seconda delle aree (commerciale, governance, Digital/IT). Non ci sarebbe nulla di strano, se non fosse per il modello adottato.

- Area commerciale: criterio classico. I componenti devono avere una forte presa sulla rete di vendita e una forte business vision. Quindi: basso turnover e provenienza dalla stessa industry e in quasi sempre – incredibile dictu – dalla stessa azienda.

- Area di governance: criterio conservativo. Questa area in realtà è vista come un peso da sopportare per il semplice fatto che bisogna averla per legge o normative di settore. I componenti devono esserne consapevoli, perché a fronte di questo presupposto devono preoccuparsi solo di non fare danni e di compiacere il vertice. Stop. Quindi: medio turnover, provenienza dalla stessa industry e quasi mai dalla stessa azienda.

- Area Digital/IT: criterio di sperimentazione sociale. Questa è l’area dove l’utilitarismo si sbizzarrisce in quanto i componenti sono fungibili al mantenimento del proprio network auto referenziato e alla sperimentazione di nuove forme di management scientifico. Ricordando le caratteristiche dell’utilitarismo, non sorprende che questo criterio venga adottato proprio in questa area: è quella in cui ci sono ancora nuovi ambiti/scambi da poter controvalorizzare da zero. Quindi: alto turnover, provenienza da qualsiasi industry e mai dalla stessa azienda.

- I componenti del Triangolo sono ottimi comunicatori all’esterno, sanno scegliere in maniera perfetta gli argomenti, i canali, le tempistiche e soprattutto la platea di riferimento. I destinatari delle loro comunicazioni all’esterno sono quasi sempre loro peer o membri del proprio network

- Chi appartiene a questo livello non ha execution risk dal punto di vista del proprio percorso di carriera. gli verrà riconosciuto il merito per qualsiasi successo che l’Azienda raggiungerà nel breve termine, non risponderà di qualsiasi danno o fallimento sperimentato dall’Azienda nel breve/medio/lungo termine. Questo è ovvio, considerando i punti sopra riportati, e rappresenta un aspetto fondamentale perché consente di comprendere i diversi livelli di accountability che concretamente il singolo manager mette in atto.

Lo spazio bianco: questo livello è la vera novità della nuova struttura organizzativa. Vi chiederete da che punto di vista vada analizzato, dato che al suo interno non sono presenti risorse aziendali.Ebbene, questo spazio va studiato dal punto di vista della comunicazione. Infatti, avendo rinunciato a una cinghia di trasmissione manageriale tra i 2 livelli, l’Azienda utilitaristica basa la propria coesione sulla sola capacità di comunicare e diventa quindi fondamentale comprendere le modalità di riempimento di questo spazio bianco.

- Argomenti affrontati:

- Quelli dall’alto verso il basso sono sempre generici e quindi inconfutabili; difficilmente il Triangolo entra nel vivo della vita aziendale quando comunica e preferisce toccare temi sociali o di contesto su cui tutti non possono che riconoscersi. Da questo punto di vista, assistiamo quasi al paradosso di vedere l’utilitarismo sposare uno degli esiti della morale kantiana.

- Quelli dal basso verso l’alto sono sempre appiattiti e a scarso valore aggiunto per chi fosse, eventualmente, interessato a raccoglierli Questo può essere dovuto a più ragioni che non si riescono a esplorare in maniera esaustiva nello spazio di questo articolo. Sicuramente l’esito è quello di un’occasione persa.

La combinazione di questi due aspetti fa sì che sia molto più facile sapere cosa sta accadendo dentro e fuori l’azienda andando a leggere i mezzi di comunicazione pubblici, piuttosto che i contenuti presenti nello Spazio Bianco.

- Impostazione:

- Dall’alto verso il basso si assiste a un wording asettico; è questa un’evoluzione rispetto al puro formalismo, perché si tratta di un linguaggio che vorrebbe essere coinvolgente ma non riesce ad esserlo, e né d’altronde potrebbe riuscirci. Infatti tra l’attenzione al politically correct e la necessità di evitare termini che potrebbero urtare chissà quale sensibilità, al destinatario non rimane nulla del messaggio che si vorrebbe trasmettere. Questo è sicuramente frutto della volontà di fare override di qualsiasi caratteristica culturale, per omogeneizzare la popolazione aziendale.

- Dal basso verso l’alto il linguaggio è diretto, a volte sfrontato. Il limite principale è quello di usare ancora un wording che dà troppo per scontato che i destinatari della comunicazione abbiano lo stesso background culturale dei mittenti, mentre non è più così. Quindi a volte si rischia di essere o troppo diretti oppure fraintesi. Da questo punto di vista i componenti del Trapezio devono ancora fare uno sforzo significativo per essere maggiormente efficaci nel comunicare.

La combinazione di questi due aspetti fa sì che chi dall’esterno legge le comunicazioni presenti nello Spazio Bianco, possa pensare di trovarsi di fronte a un verbale di un’assemblea generale di un grande Partito politico della Prima Repubblica.

- Tempistiche:

- Dall’alto verso il basso il timing è calibrato nell’ottica del “poi non dire che non te lo avevo detto”. La comunicazione istituzionale viaggia con tempi che nascondono - neanche troppo – il fatto che la stessa sia vissuta come un atto dovuto, nulla più.

- Dal basso verso l’alto il timing è diverso in base al tipo di comunicazione: si va dal random (nel caso di condivisione di fatti di vita aziendale) al very last minute (nel caso di comunicazione istituzionale).

- Canali: ormai i canali di comunicazione sono molteplici ed efficienti; si va dalla mail ai social, passando per tool aziendali più o meno complessi, a seconda dei casi e delle necessità. Qui esiste una vera e propria mappa dei canali da usare rispetto alla finalità della comunicazione. Rimarco solo l’impiego sempre più decrescente del canale più antico del mondo, e cioè quello fisico: anche qui le ragioni sono varie e occuperebbero troppo spazio.

Vale la pena riportare giusto una nota differenziante del nuovo management scientifico, e cioè lo slogan “per chi vuole, la mia porta è sempre aperta”. Questa è una perla che, unita a tutti gli altri punti, sintetizza il valore dello Spazio Bianco nella nuova struttura aziendale

Il Trapezio: questo livello chiaramente c’è sempre stato, mentre nel tempo è cambiata la sua composizione ed è quindi da questo punto di vista che lo analizziamo.

- Competenze: così come avviene in molti contesti attuali, l’estrema specializzazione del lavoro porta all’aumento del mix di competenze presenti nel Trapezio. La partizione di competenze, già in fieri sin dal concepimento del management scientifico, è adesso arrivata a livelli estremi per cui non esiste più nessuno che possa essere veramente autonomo nel condurre la propria attività. Un tempo questa impostazione era tipica delle catene di montaggio, adesso viene applicata anche ai cosiddetti “lavori di concetto” e questo fa ben capire il ruolo e la dignità del capitale umano nella concezione utilitaristica al lavoro. Questo livello quindi è pieno di competenze diverse, il che le rende a lungo andare tutte uguali nel senso che sono tutte pienamente fungibili, con chiari benefici da parte del Triangolo.

- Gerarchie: in questo livello le gerarchie sono molto sfumate, fenomeno paradossale considerando il suo evidente ispessimento rispetto a solo 50 anni fa; adesso fanno parte del Trapezio figure che un tempo sarebbero sicuramente state in livelli superiori dell’organizzazione anche se non nel Triangolo (il cosiddetto middle management, ad esempio), eppure questa differenziazione sta perdendo di significato. Non serve più distinguere per livelli in maniera sostanziale: nel Trapezio hanno tutti la stessa valenza decisionale ed esecutiva di fronte all’azienda e resta qualche residuo legato ad alcuni aspetti istituzionali, quali il processo valutativo o remunerativo, ma sempre più pilotati dall’alto, lasciando poche leve a chi li deve agire dal basso.

Nel breve termine questo aspetto viene percepito molto positivamente da tutti i componenti, nel medio si inizia a percepire l’inganno che si nasconde dietro a questo apparente “mondo degli uguali”.

- Anzianità: questa è chiaramente funzione dell’industry di cui parliamo, e del ciclo di vita in cui si trova l’Azienda. Un aspetto che differenzia l’impostazione utilitarista dalle altre è l’impiego delle risorse in età pre-pensionabile. Nelle aziende non utilitariste queste risorse, negli ultimi mesi/anni di attività vengono impiegate, anche part-time, per la formazione e per il passaggio di consegne. Nelle aziende utilitariste, prive di memoria, le stesse risorse vengono accantonate per non contaminare il futuro con il passato

- Fidelizzazione: il fatto che questa sia decrescente è comprensibile in base a quanto spiegato fin qui, e d’altronde non sembra che la fidelizzazione sia un tema che stia particolarmente a cuore in questo tipo di impostazione. E’ invece interessante studiare l’interazione tra i giovani e l’azienda: infatti possiamo immaginare che i profili giovani siano quelli che meglio aderiscono ai nuovi standard, semplicemente perché sono cresciuti nella convinzione – trasmessa dagli stessi decision maker che compongono il Triangolo - che questi standard siano gli unici possibili e corretti. Quello che andrà capito è quanto, nel medio termine, questo binomio sia sostenibile nelle aziende di grandi dimensioni. Chi, dei giovani che oggi compongono il Trapezio, entrerà per vie traverse (e non per carriera interna, per quanto detto prima) a far parte del Triangolo? E che impostazione saprà dare all’Azienda? Quale stile avrà il giovane di oggi e manager di domani, cresciuto in un contesto lavorativo senza memoria?

Ancora non c’è una serie storica significativa per rispondere a queste domande, almeno in Italia. Sicuramente ne riparleremo alla prossima generazione del management scientifico!

Joseph Weber e le onde gravitazionali - Vittime illustri di modi ideologici di fare scienza

23/01/2024Onde gravitazionali,Weber,IdeologieParadigmi scientifici,Fisica e scienze "dure"

Dopo la storia del medico ungherese Ignác Semmelweis (raccontata qui), trattiamo oggi un altro esempio1 di vittima illustre di un modo ideologico di fare scienza2: il caso del fisico statunitense Joseph Weber (1919 – 2000). Egli fu uno scienziato brillante e stimato, ma emarginato.

L’inizio

Negli anni ’60 Weber costruì il primo prototipo di rilevatore di onde gravitazionali, un fenomeno fisico la cui esistenza era stata predetta più di mezzo secolo prima dalla teoria della relatività di Albert Einstein. Secondo l’equazione di campo – l’equazione fondamentale della relatività generale – il repentino cambiamento di massa di un corpo produrrebbe delle increspature nello spazio-tempo. Secondo Einstein, queste perturbazioni ondulatorie dovevano essere estremamente diffuse nell’universo, ma allo stesso tempo molto difficili da rilevare perché straordinariamente flebili.

Lo strumento costruito da Weber, in un seminterrato del suo dipartimento dell’Università del Maryland, era costituito da cilindri di alluminio della lunghezza di 2 metri e del diametro di un metro; al passaggio di un’onda gravitazionale, questi cilindri ne avrebbero registrato il transito grazie a una variazione di 10-12 millimetri (in proporzione, e per intenderci, è come se la distanza dal sole alla stella più vicina variasse del diametro di un capello umano!). Weber aveva investito anni della sua carriera nella costruzione di questi rilevatori, trascorrendo mesi in laboratorio e imparando a conoscerli in ogni dettaglio. All’inizio degli anni Settanta, lo scienziato statunitense pubblicò i primi risultati e disse di aver registrato un primo alto flusso di onde gravitazionali.

La pubblicazione di Weber fu fin da subito accolta con molto scetticismo. I risultati infatti contenevano una fondamentale contraddizione: sebbene la conferma dell’esistenza delle onde gravitazionali fosse una prova a sostegno della teoria di Einstein, l’intensità delle onde che Weber aveva registrato era invece molto più alta del previsto e suggeriva, sempre secondo la teoria della relatività, che l’universo avrebbe dovuto avere una vita estremamente corta e ciò era considerato, dalla comunità dei fisici, molto improbabile.

Dilemmi scientifici e metodologici

Qui sorge il primo dilemma: la teoria della relatività era stata confutata o confermata dalle osservazioni di Weber? Secondo Weber la teoria della relatività era stata confermata, ma richiedeva qualche aggiustamento per non fornire previsioni sulla vita dell’universo molto poco verosimili. Secondo i critici dell’esperimento, al contrario, l’intensità delle onde gravitazionali registrata era semplicemente incompatibile con la relatività e quindi le osservazioni di Weber dovevano, necessariamente, essere errate.

Per smentirle, nell’arco di qualche anno, una mezza dozzina di gruppi di ricerca costruì dei rivelatori simili a quelli dell’Università del Maryland, con l’intento di ripetere l’esperimento e invalidarlo. E così fu. Nessun altro rivelatore aveva riprodotto gli stessi risultati ottenuti da Weber.

-------

Ed ecco il secondo rompicapo: i critici di Weber, che avevano smentito le sue osservazioni per riabilitare la relatività, non avevano forse contraddetto la relatività stessa con il mancato rilevamento delle onde gravitazionali? E come decidere chi tra Weber e i suoi rivali avesse preparato l’esperimento nel modo più appropriato per lo studio di un fenomeno così sfuggente? Certo, risultati negativi si erano ripetuti più volte, ma questo non significava necessariamente che le onde gravitazionali non esistessero. Anzi, la mancanza di risultati poteva essere dovuta all’imperizia dei rivali di Weber, che non potevano certo vantare la sua esperienza nella progettazione di strumenti così sofisticati. Se è vero infatti che molti scienziati si trovavano d’accordo nel ritenere poco credibili le affermazioni di Weber, le ragioni del loro scetticismo erano tuttavia molto differenti – e talvolta in contraddizione – fra loro. In particolare, il fisico della IBM Richard Garwin aveva opposto una decisa resistenza alle conclusioni di Weber per principio; e solo per rendere il suo attacco ancor più convincente aveva effettuato delle misurazioni che avevano inferto colpi decisivi all’ipotesi di Weber.

Un abbandono prematuro

La contesa durò per tutto un decennio, periodo durante il quale Weber si impegnò a dimostrare come ciascun esperimento “rivale” fosse in qualche modo vittima di fallacie metodologiche. Così egli tentava, a sua volta, di screditare coloro che lo avevano attaccato.

A partire dall’inizio degli anni Ottanta, la maggioranza della comunità scientifica perse interesse per la ricerca delle onde gravitazionali. Questo fenomeno, infatti, non solo si era dimostrato difficile da individuare, ma aveva anche reso ardua la carriera di molti brillanti fisici che vi si erano dedicati, a causa della penuria di fondi e dello scetticismo generale dovuto alle continue controversie interne alla comunità.

L’inaspettata conferma

Fu soltanto alla fine degli anni Novanta che una nuova generazione di antenne interferometriche, il cui design manteneva alcuni elementi cardine degli strumenti progettati da Weber, rilanciò la caccia alle onde gravitazionali. L’annuncio della scoperta salì agli onori delle cronache il 1 febbraio 2016, quando in una conferenza stampa congiunta di LIGO (Laser Interferometer Gravitational-waves Observatory) e Virgo (il nome di un ammasso di galassie nella costellazione della Vergine), due gruppi di ricerca che avevano collaborato al progetto, annunciarono che nel settembre del 2015 avevano misurato le onde gravitazionali scaturite dalla collisione di due buchi neri distanti a circa 1 miliardo e 300 milioni di anni luce dal sistema solare. Ironia della sorte, le tracce di uno degli eventi più rari dell’universo avevano colpito i nuovissimi rilevatori dopo soltanto due settimane dalle loro attivazione, concludendo così in un tempo brevissimo una caccia che durava da un secolo e si pensava potesse protrarsi per molti altri decenni ancora.

Addirittura, il Nobel

Al giorno d’oggi, dopo la conferma dell’esistenza delle onde gravitazionali che è valsa il premio Nobel nel 2017 a Kip Thorne, Barry Barish e Rainer Weiss (nel frattempo Weber era morto nel 2000, avvolto da un’amarezza inconsolabile)3, all’interno della comunità scientifica esiste un consenso pressoché generale; anche se il consenso potrebbe non essere assoluto, tuttavia esso ha ormai raggiunto un livello tale per cui sarebbe molto difficile per un fisico scettico (sulle interpretazioni dei dati raccolti da Ligo e Virgo) essere ritenuto sufficientemente credibile da permettergli di pubblicare un articolo scientifico su una rivista prestigiosa.

La lezione (ancora non appresa) per una scienza ideologica

L’esperimento di Weber aveva fornito dei risultati che si trovavano solo parzialmente in accordo con la teoria della relatività di Einstein, a partire dalla quale l’esperimento era stato progettato. Infatti, da un lato, l’esistenza delle onde gravitazionali sembrava fornire una conferma empirica della relatività; dall’altro, l’esubero di onde gravitazionali rispetto a quelle predette poneva non pochi interrogativi. Neanche la costruzione da parte di altri sei gruppi di ricerca di altrettanti strumenti per controllare l’attendibilità delle misurazioni di Weber risolse il rompicapo. E questo è inconcepibile per una scienza ideologica, che non accetta di convivere con le contraddizioni.

---------

Peraltro, secondo Weber le rilevazioni effettuate dai suoi colleghi non rappresentavano una sconfessione della sua ipotesi perché, a suo parere, erano i nuovi rilevatori a non essere attendibili (reliable). I rilevatori di onde gravitazionali sono infatti strumenti delicatissimi e nessuno degli altri fisici possedeva le competenze (che aveva acquisito lui) per costruirli in così breve tempo. Il fatto che questi nuovi strumenti non confermassero l’esistenza delle onde gravitazionali era, secondo Weber, semplicemente frutto della imperizia dei suoi colleghi.

Nondimeno, gli scienziati dovevano confrontarsi su un nuovo problema: che cos’era a non funzionare? Quale degli esperimenti andava rigettato? Se gli scienziati avessero seguito il falsificazionismo popperiano (un altro pilastro, forse inconsapevole, di una scienza ideologica), avrebbero dovuto rigettare la teoria della relatività, fino a quel momento ritenuta corretta, poiché in disaccordo con la misurazione dell’intensità delle onde gravitazionali. Ma così non fu. E questo è molto interessante, soprattutto per i seguaci di Popper…

NOTE

1 Tratto dal volume di Giampietro Gobo e Valentina Marcheselli, Sociologia della scienza e della tecnologia. Un’introduzione (2021).

2 Per ”ideologico“ intendo quell’atteggiamento pre-costituito (e la relativa pratica) per cui una qualsiasi idea, proposta o procedura che non rientri in determinati schemi pre-definiti non viene accolta nemmeno come possibilità, e di conseguenza non le viene attribuito lo status di ipotesi possibile su cui sospendere cautelativamente il giudizio.

3 https://www.science.org/content/article/remembering-joseph-weber-controversial-pioneer-gravitational-waves

Monopattini elettrici e numeri maltrattati – Strumentalizzare le statistiche

23/01/2024AttualitàPolitica,Tecniche e Tecnologie,Sociologie

A metà agosto dell’anno scorso, in vacanza in un paesello di montagna, sono caduto con la bicicletta e mi sono rotto un paio di ossa, finendo al pronto soccorso.

Sulla base delle frequenze di incidenti rilevate, un ipotetico giornale locale avrebbe potuto titolare così la pagina della cronaca del giorno dopo: ”Sempre più numerosi gli incidenti gravi ai ciclisti nel paese di Vattelapesca”

--------

Nulla di falso in questo titolo: la vittima dell’incidente è un ciclista; l’agosto precedente scorso non c’erano stati incidenti ai danni di ciclisti; grave è grave, mi è costato ricovero e intervento.

Il cronista avrebbe potuto anche scrivere, che gli incidenti in bicicletta, in agosto, a Vattelapesca: “Si moltiplicano”, “Crescono in maniera esponenziale”, tutto senza allontanarsi di un passo dalla verità.

Ora, è evidente che questa presentazione della questione – pur corretta dal punto di vista del rapporto con la realtà – rischia di essere drammatica e fuorviante.

--------

Cambiamo scenario: il 12 ottobre 2023, un telegiornale a diffusione nazionale titola un servizio: “Sempre più pericolosi i monopattini elettrici, incremento del 78% degli incidenti mortali”.

Lo spunto per il servizio – che si focalizza sulla pericolosità dei monopattini elettrici – è la morte di una ragazza che è stata travolta, a Trento, mentre attraversava la strada con il suo monopattino; non era ancora noto se fosse a bordo del monopattino oppure se lo stesse spingendo a mano.

È normale, nella pratica giornalistica, utilizzare un evento puntuale come pretesto per introdurre un articolo che parla di fenomeni generali, niente da dire. È il caso, tuttavia, di esaminare qualche aspetto del fenomeno generale di cui parla questo servizio:

- L’incremento del 78% di cui si parla è un dato relativo al 2022, rispetto al 2021

- Gli incidenti mortali con il monopattino nel 2022 sono stati, in valore assoluto, 16

- Nel 2023, fino al 12 ottobre, il numero di incidenti mortali con il monopattino più attendibile è 15 (la ragazza di Trento è la quindicesima).

Sembrerebbe, quindi, che il numero assoluto, nel 2023,di incidenti mortali con il monopattino fosse in calo rispetto al 2022.

Andiamo avanti: se esaminiamo la fonte, che supponiamo attendibile (Aci-Istat), gli incidenti mortali simili nel 2021 sono stati 10 (9 conducenti e un pedone), quindi l’incremento nel 2022 scende al 60%.

Cos’è, quindi questo 60%? Potrebbe trattarsi dell’incremento di incidenti gravi, non solo di quelli mortali. Una sorta di metonimia? No, si tratta di una lettura riduttiva dei dati del 2021, che non conta un pedone investito ma solo i conducenti.

Con un minimo ancora di approfondimento, scopriamo che il servizio tace sul “denominatore nascosto” del fenomeno degli incidenti: il numero di monopattini elettrici circolanti e il suo incremento negli anni di cui si parla.

Non si trovano facilmente dati sull’incremento tra 2021 e 2022 dei mezzi di proprietà ma sicuramente i noleggi di monopattini elettrici è aumentato di circa il 50%.

Tra 2022 e 2023, invece, ci sono fonti che parlano di un aumento del 140% dei monopattini privati e di più del 100% dei noleggi.

In proporzione ai monopattini circolanti, è plausibile che l’incidenza di incidenti sia diminuita nel 2022 e c’è l’evidenza di una riduzione del 50% nel 2023.

Addirittura, secondo l’Osservatorio Nazionale sulla Sharing Mobility, tra il 2021 e il 2022, il rapporto tra incidenti, numero di monopattini e chilometri percorsi è calato dell’80%.

Il quadro che si scorge approfondendo le cifre è, quindi, decisamente diverso.

Eppure, questa percentuale drammatica del 78% di incidenti mortali in più fornisce al servizio – e ai numerosissimi altri articoli di stampa che in quei giorni ne ricalcano i contenuti – il carattere di affidabilità scientifica: sono numeri, sono percentuali, sono calcoli scientifici, legittimano le affermazioni e le conclusioni.

E distorcono irrimediabilmente la realtà. Perché?

Ecco perché: ad ottobre 2023 è iniziata la discussione parlamentare delle nuove misure di legge che riguardano i mezzi di cui parliamo: obbligo di targa e di assicurazione, obbligo del casco, dotazione di freni anteriore e posteriore indipendenti, frecce, limiti di velocità e regole di parcheggio; oggi, parte di queste misure diventa legge.

La vera notizia d’agenzia da lanciare era, quindi, la legge - che è diventata esecutiva in questi giorni - la cui legittimazione doveva passare attraverso un percorso di drammaticità: quello dell’incremento degli incidenti.

Questa vicenda mette in luce come si possono facilmente maltrattare i numeri e farli diventare “dati scientifici” con risultati distorti, secondo regole di rilevanza sociale.

P.S.: Il quotidiano locale della zona dove sono caduto l’agosto scorso non ha parlato del mio infortunio, né delle statistiche sugli incidenti ciclistici. Il Sindaco del paesello non aveva in programma, me l’ha assicurato di persona, nessuna nuova legge comunale sulle mountain bike.

RIFERIMENTI PER I DATI:

- ACI – ISTAT, report incidenti stradali 2022

- Osservatorio sulla Sharing Mobility

- EMG Mobility, 13 Febbraio 2023

- Wired 22.05.2023

Un nuovo francescano? - Paolo Benanti e la commissione algoritmi

16/01/2024AttualitàIntelligenza Artificiale,Tecniche e Tecnologie,Politica

Il professore Paolo Benanti è stato nominato Presidente della Commissione sull’Intelligenza Artificiale per l’Informazione e l’Editoria della Presidenza del Consiglio.

La Commissione è un organo del Dipartimento per l’Informazione e l’Editoria istituito dalla Presidenza del Consiglio poco più di due mesi fa, con lo scopo di analizzare le implicazioni dell’Intelligenza Artificiale nel campo dell’editoria e dell’informazione e, di conseguenza, consigliare il Dipartimento che ne è responsabile. La commissione è stata presieduta - dalla fondazione sino alle sue dimissioni - dal professor Giuliano Amato, politico, giurista, docente universitario e manager pubblico.

La nomina di Giuliano Amato aveva sorpreso molti; l’assegnazione della presidenza a Paolo Benanti forse anche di più.

Paolo Benanti ha un curriculum eccellente e si può dire - senza timore di smentita - che è uno dei massimi esperti mondiali di Intelligenza Artificiale; è un frate Francescano del Terzo Ordine Regolare, teologo, eticista, docente presso la Pontificia Università Gregoriana, consigliere di Papa Francesco per l’Intelligenza Artificiale, membro della Pontificia Accademia per la Vita con mandato sulla Intelligenza Artificiale, membro del New Artificial Intelligence Advisory Board dell' ONU, autore di libri sul ruolo dell'umano nella civiltà tecno-umana.

Ovunque si parli del profilo etico delle tecnologie e del ruolo della Intelligenza Artificiale nella vita dell'uomo, la presenza di Benanti è pertinente. È, tra l'altro, colui che ha coniato il termine Algoretica, cioè l'etica degli algoritmi. Da anni infatti si interroga e fa riflettere su come la tecnologia sia passata dallo status di strumento in mano all'uomo a quello di parte integrante dell'ecosistema sociale, e sempre più influente su questo ecosistema.

È sicuramente apprezzabile che Benanti abbia accettato di esporsi nel ruolo di Presidente della commissione: qualsiasi linea guida ne uscirà sarà certamente pertinente e di alto profilo. Paolo Benanti ama poi scherzare sul ruolo degli eticisti, come lui: gli eticisti fanno le domande e si tengono alla larga dalle risposte. Nel campo dell'etica le giuste domande sono infatti la cosa più importante, quelle che dovrebbero influenzare politici e stakeholders affinché affrontino i temi davvero rilevanti.

La domanda centrale posta dal lavoro di Paolo Benanti si può riassumere in questa: le macchine devono avere un'etica? Quale? Quali limiti ci sono e devono esserci nel rapporto tra la nuova specie delle macchine intelligenti e l'essere umano?

Gli eticisti non scendono in campo per dire cosa non si può fare o, peggio, pontificare su giusto e sbagliato, dice Benanti; il loro ruolo fondamentale su temi delicati e pervasivi della vita collettiva - com'è e come sarà sempre più l’Intelligenza Artificiale - deve essere appunto quello di porre le giuste domande, per far sì che le persone e le istituzioni ricerchino le risposte più adatte al contesto in cui operano. In questo il professor Paolo Benanti non potrà che essere eccellente: le persone, l'essere umano - in particolare nel loro rapporto con la tecnologia - sono sempre state al centro della sua attenzione.

Una volta tanto possiamo dire che in Italia abbiamo messo la persona giusta al posto giusto.

Conversazioni sull’Intelligenza Artificiale – Si prova qualcosa ad essere una macchina?

16/01/2024RobotTecniche e Tecnologie,Psicologia,Intelligenza Artificiale

Redazione: Riccardo, in questo tuo post hai condensato almeno tre punti molto rilevanti per la discussione sull’Intelligenza Artificiale e sulle macchine che agiscono guidate da sistemi intelligenti:

- il primo – sulla bocca di tutti in questi giorni – è quello della trasparenza,

- il secondo è quello della responsabilità di questi agenti in qualche modo autonomi, di cui abbiamo già scritto più volte nel blog, e che coinvolge un’intera filiera di soggetti

- e il terzo è quello della soggettività degli automi.

È evidente che gli elementi più innovativi che stai introducendo in questo discorso sono:

1) quello che chiami “monologo interiore”, intimamente correlato al tema della trasparenza, e

2) la domanda, per me assolutamente inattesa, “ma sta succedendo qualcosa là dentro?”, che suggerisce di non trascurare la possibilità di una reale soggettività dell’automa.

Ritieni quindi che “monologo interiore”, “interiorità”, “soggettività” possano essere caratteri attribuibili ad un robot?

Riccardo: Per rispondere a questa domanda provo a definire chiaramente questi termini, perché spesso il guaio è che parlando di questi temi si utilizzano dei termini resi così laschi dagli anni di dibattiti che ognuno finisce un po’ per tirarseli dalla propria parte, con il risultato che tutti hanno ragione perché stanno parlando da soli.

E allora: il “monologo interiore” è l’idea di applicare ad un soggetto che si muove nello spazio (ad un robot nel nostro caso) un modo, uno spazio di lavoro, per connotare il proprio ambiente; e grazie a questo processo di continuo aggiornamento del proprio mondo, poter agire sempre più efficacemente sullo stesso.

Bene: su questo punto, a livello funzionale - ritengo che sia il caso di evitare un’analisi filogenetica - per me sia difficile trovare grosse differenze rispetto a ciò che una persona fa. Per quanto riguarda l’“interiorità”, definita come lo spazio in cui quel monologo interiore accade, mi pare chiaro che sia una condizione necessaria per l’esistenza di un monologo, avendo appunto un’azione bisogno di un luogo in cui svolgersi.

La “soggettività” è invece la dimensione più scivolosa. Però possiamo intenderla come il fantomatico “provare qualcosa ad essere (un soggetto)”.

Ecco, credo che questa dimensione soggettiva possa essere accessibile solo tramite due tratti essenziali: un qualche tipo di auto-narrazione e una fiducia nei confronti di quella narrazione e di quel narratore. A conti fatti ognuno di noi ha accesso soggettivamente solo alla propria soggettività e quella degli altri se la può, al massimo e ragionevolmente, immaginare.

Cosa è ragionevole però pensare quando vedo un cane con gli occhi chiusi che muove le gambe? E un polpo che si nasconde nella sua tana foderata di conchiglie? Sta succedendo qualcosa lì dentro?

È una questione di vita mi si dirà, di vita organica persino. Io credo, senza dire niente di nuovo rispetto alle riflessioni di Maturana Romesín e Varela García (1972, De máquinas y seres vivos), che si giri intorno alla questione, tutta individuale e privata, di “accettare emotivamente” o meno il fatto che la vita sia poco più che il tentativo di un sistema di riuscire a conservarsi.

Redazione: E tu Paolo, che hai speso anni in mezzo a queste macchine e queste domande, cosa ne pensi?

Paolo: Tendiamo ad attribuire un significato compiuto alle parole del nostro interlocutore, anche se il suo discorso è privo di senso; lo insegna Paul Grice, che segnala anche l’attitudine a riconoscere al partner intenzioni di veridicità e pertinenza. Credo che la nostra propensione al principio di carità si estenda al comportamento delle macchine, soprattutto a quelle di AI generativa, cui accordiamo intelligenza, coscienza e creatività, nel senso ordinario di questi termini.

Eppure, software di grande raffinatezza, come ChatGPT o AlexNet, mostrano con le «allucinazioni» che la loro presa su qualunque realtà esterna ai processi del codice è nulla.

Non possiamo pretendere che l’intelligenza artificiale possa diventare «generale» (AGI), e sia quindi in grado di paragonarsi a quella umana, a causa della definizione stessa che è stata adottata per la loro progettazione.

Il modello cognitivo che guida la pianificazione delle AGI è fondato su potenza di calcolo, quantità e stratificazione delle connessioni tra unità di calcolo. Si è dimenticato che invece l’intelligenza parte sempre da una domanda preliminare, e da una precomprensione del mondo e dell’ambiente: lo rilevano su ambiti di indagine differenti sia Popper sia Husserl.

Senza l’autonomia dello stimolo a porre interrogativi non c’è nessuna intelligenza (coscienza, creatività, ecc.) nel senso comune del termine. Credo invece che le Intelligenze Artificiali siano dispositivi nel senso pieno indagato da Agamben (2006, Che cos'è un dispositivo?): pongono in essere un dominio di esperienze che prima non esisteva, stabilendo un nuovo campo di poteri e saperi.

Se le si osserva nella prospettiva del loro contributo alla storicità e al potenziamento dell’intelligenza (senza aggettivi di specificazione), assumono un profilo meno fantascientifico ma più ricco di senso, rientrando nella tradizione del pensare per segni che trova la sua fondazione in Leibniz e nei suoi studi sulla characteristica – ma soprattutto che prosegue il percorso di riflessione e di progettazione che Doug Engelbart ha inaugurato insieme ad English nel 1968 (A Research Center for Augmenting Human Intellect).

Redazione: Grazie a entrambi, più che darmi delle risposte, avete delineato due veri programmi di lavoro, distinti e complementari, uno fenomenologico e l’altro più analitico e cognitivista. Programmi che possono convergere o divergere.

Lo capiremo, forse, nella prossima parte della conversazione, dalla risposta che Riccardo darà a questa domanda:

il requisito di essere incorporata in un robot, è obbligatorio per riconoscere ad una IA generativa come, ad esempio, Chat GPT, il diritto all'integrità di cui parli? Le altre istanze, quelle esclusivamente dialoganti che troviamo sul web, non hanno diritto a questo riconoscimento?

A tra due settimane!

Memoria, immaginazione e afantasia - Ma cosa stavo dicendo?

16/01/2024Anima,MemoriaSalute e Medicina

Una patologia che probabilmente ha origine recente è l’afantasia, la perdita dell’immaginazione. Il primo caso è stato descritto nel 2015 dopo un intervento al cuore (Zeman, Dewar, Della Sala, Lives without imagery - Congenital aphantasia). I pazienti che ne sono affetti non hanno immagini: se gli si chiede di pensare a un bicchiere, a un albero, al proprio gatto, non formano alcun ricordo, pur conoscendo benissimo queste cose. Studi recenti con la Risonanza Magnetica funzionale mostrano che la parola “Bicchiere”, “Albero”, “Gatto” non accende alcuna attività nel cervello, la Risonanza rimane muta.

Aristotele chiamava φαντασíα (phantasia) la capacità di vivere nelle immagini. Al tempo di Aristotele la capacità immaginativa era la qualità dominante della coscienza, a tal punto che si considera che la logica sia nata proprio con Aristotele. Questo non vuol dire che i greci antichi non fossero dotati di logica, ma l’attività della coscienza era prevalentemente immaginativa, l’attività logico-computativa del pensiero era dedicata soprattutto al commercio. Per questo i greci avevano adottato, con qualche riluttanza, l’alfabeto dai fenici, abili trafficanti. In virtù di questa facoltà immaginativa, molti greci antichi erano dotati di una memoria prodigiosa, se pensiamo che per secoli opere letterarie come l’Iliade, l’Odissea, le opere di Esiodo furono tramandate prevalentemente per via orale affidate, con gli esametri, al ritmo del respiro.

La capacità mnemonica è sicuramente legata alla facoltà immaginativa. L’arte di ricordare risale a Simonide di Ceo, poeta greco vissuto tra il VI e il V secolo a. C. Cicerone nel De oratore racconta che Simonide, scampò per uno strano prodigio al crollo di una sala in cui banchettavano duecento invitati e fu in grado di identificare i corpi di ciascuno, solo rammentando il posto che occupavano.

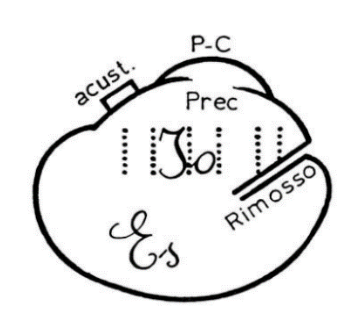

Nell’oceano della coscienza umana prevalgono, infatti, due facoltà (e chissà quanto ancora): l’attività logica e la capacità di creare immagini interiori. Freud le vedeva come una specie di iceberg, la piccola punta della coscienza dell’io, emergente dal fondo sconfinato dell’Es, diciamo, dell’inconscio (1922; in Opere complete, IX). Il padre della psicanalisi era un attento lettore di Platone, dal quale aveva preso ispirazione proprio per la lettura delle facoltà dell’anima.

Socrate, nel Fedro di Platone, dice che non può spiegare razionalmente cosa sia l’anima, ma può farlo attraverso l’immagine di una biga trainata da due cavalli. I due cavalli rappresentano bene le due attitudini dell’anima. La capacità di immaginare è lentamente svanita nel corso dei secoli, col prevalere della ragione nel Secolo dei Lumi, ma è gradualmente riapparsa dal secolo scorso: l’arte astratta, la musica atonale ne sono alcuni indizi, ma la creazione della psicanalisi ne è la prova più evidente.

Il problema è che, nello svolgersi delle due attività dell’anima, l’una oscura l’altra. Se penso razionalmente, non percepisco le immagini; se la mia coscienza è pervasa da immagini, posso scrivere una poesia o dipingere. In realtà la facoltà di creare immagini è diffusa, ma mascherata dal lessico della tecnologia (chi di voi non ha il cellulare in tasca?). Ogni volta che accendiamo il telefonino, spegniamo la nostra fantasia. Dalla svolta del secolo stiamo imparando a pensare come le macchine. La nostra memoria è imprigionata nei byte.

Il grande neurologo russo, Aleksandr Lurija studiò un personaggio dotato di una memoria incredibile, capace di elencare lunghe serie di numeri, dal primo all’ultimo e al contrario (1968; Viaggio nella mente di un uomo che non dimenticava nulla). Questa persona “vedeva” mentalmente le cose che memorizzava.

L'immaginazione, tuttavia, non è solo lo strumento di poeti e pittori: Newton e Einstein immaginavano le loro scoperte scientifiche anni prima di realizzarle.

Ma questa è un’altra storia che vi racconterò la prossima volta.

Incontri indeterminati - Considerazioni su “La Chimera” di Rohrwacher

16/01/2024Cinema,MemoriaPolitica

Taglia e cuci. Montaggio di spazi discreti e durate disparate, seguendo il filo rosso della fiction, così il cinema prova a restituirci la vera esperienza del mondo. In questo senso, “La Chimera”, di Alice Rohrwacher, propone una serie di immagini capaci di tratteggiare alcuni complessi caratteri della nostra società e del tempo in cui viviamo, rendendoci il senso della storia.

In un periodo volutamente imprecisato, sospeso fra gli anni Ottanta e un eterno presente attraversato da presagi del futuro, e senza dare un’eccessiva importanza al luogo della vicenda (l’immaginaria Riparbella, nella Tuscia), il film racconta delle peripezie di una banda di tombaroli, la quale ha un discreto successo nelle escavazioni delle tombe etrusche, riuscendo a trovare numerosi cimeli grazie al contributo del protagonista (Arthur, una specie di rabdomante), che riesce a percepire l’ubicazione dei tumuli e delle caverne interrati tramite le sue chimere, suscitate dal desiderio di ricongiungersi con il suo amore scomparso (Beniamina), che gli appare in sogno in maniera sfuggente, perdendo dietro di sé il filo dall’orlo scucito del vestito.

Ma quella del tombarolo è una professione del tutto particolare, forse il tipo di vita precario per antonomasia, sospeso fra la libertà e la soggezione assolute date dal non avere vincoli. Così, le vicende dei personaggi, si articolano grazie a espedienti, alternando la gioia della festa estemporanea alla miseria del vivere di stenti e di improvvisazione quotidiana, con un fare che ricorda molto i gitani di Kusturica. Arthur, vive in una baracca adagiata sul crinale di una collina dominata da imponenti mura medioevali, ed ha solo gli abiti che indossa, ma non sembra curarsene; il suo comportamento è un misto di angoscia e cieca determinazione, preso dalla volontà di riprendere continuamente la sua ricerca. La scoperta colma di trepidazione di sarcofagi nascosti, e il ritrovamento di oggetti del passato, veri e densi di significato perché «visti da molti occhi», gli forniscono un senso di pienezza, sostenuta dall’approcciarsi a un’ideale soggettività corale in armonia con la natura delle società arcaiche, e dando libero sfogo all’affettività delle utopie; salvo poi recuperare i caratteri della morte non appena i colleghi irrompono al seguito per fare man bassa del bottino, così che, suo malgrado, i doni dati in corredo ai defunti si trasformano in merce preziosa da rivendere ai collezionisti.

-----

Una possibile chiave di lettura del film è quindi quella delle possibilità di vita nelle rovine del capitalismo, come descritte dall’antropologa statunitense Anna L. Tsing nel volume The Mushroom at the End of the World (2015), dove illustra la sua etnografia della filiera del matsutake, il fungo più pregiato del mondo, che cresce spontaneamente in aree boschive rinfoltite al seguito di processi si de-forestazione e sfruttamento intensivo del suolo. I raccoglitori, i mediatori, i rivenditori e gli importatori descritti dalla ricerca, ovvero stranieri e derelitti a cui non è permesso assimilarsi con la società, sono così delle figure istituite dalla catena del valore internazionale del fungo, che si sviluppa incidentalmente nelle fratture di modelli sociali consolidati, creata tramite salti e traduzioni, e che richiede perciò delle traiettorie di vita al margine, stimolate dalla ricerca di un contesto di libertà imprecisata e multisfaccettata. Così si genera l’accumulazione di recupero che, lungi dal rappresentare gli scarti, o le disfunzioni, di un sistema globale ordinato e in espansione inesorabile, avviene negli interstizi degli spazi politici e culturali formatisi storicamente e intrecciati in un assemblaggio che fornisce direzioni impreviste agli eventi, insieme a nuovi territori per l’agire sociale.

Questa performance drammatica, in una mescolanza che include una supposta competizione di mercato, non permette riscatto se non al termine della filiera e solo per pochi: il gioco quindi è truccato, funziona a forza di errori, falsità e distorsioni. Non c’è determinismo, non c’è sistematicità, il progresso è una chimera. Ma come sottolinea l’autrice, «gli umani contano in questi paesaggi. E gli umani portano le storie con loro nell’affrontare le sfide dell’incontro. Queste storie, sia umane che non-umane, non sono mai programmi robotici, ma piuttosto delle condensazioni nell’indeterminato qui e ora; il passato che cogliamo, come dice il filosofo Walter Benjamin, è una memoria ‘che brilla nel momento del pericolo’. Noi generiamo la storia, scrive Benjamin, come ‘il salto di una tigre in ciò che è stato’».

La storia così non può essere una successione di fatti. La storia si fa proprio con i “se” e con i “ma”, propri degli esperimenti mentali: la civiltà occidentale sarebbe fiorita se il libero mondo ellenico avesse perso la battaglia di Maratona con la teocrazia persiana? La cultura patriarcale esisterebbe se i Romani non avessero conquistato gli Etruschi? Le nostre valutazioni muovono sempre da insostituibili valori culturali. Conoscere è valutare, è scegliere. «Già il primo passo verso il giudizio storico è quindi – questo dev’essere qui sottolineato – un processo di astrazione, il quale si svolge attraverso l’analisi e l’isolamento concettuale degli elementi del dato empirico – che viene appunto considerato come un complesso di relazioni causali possibili – e deve sfociare in una sintesi della connessione causale ‘reale’. Già questo primo passo trasforma pertanto la ‘realtà’ data, allo scopo di farne un ‘fatto’ storico, in una formazione concettuale: nel ‘fatto’ è appunto implicita, per dirla con Goethe, la ‘teoria’» (Weber, 1922: Il metodo delle scienze storico-sociali).

-------

L’autenticità è una messa in scena, parziale, situata, biased. Come ricorda l’etimologia di “empirico”, bisogna avere “fede” nell’esperienza, l’una si capovolge nell’altra. «A opporsi alla finzione non è il reale, non è la verità, che è sempre quella dei padroni o dei colonizzatori, ma è la funzione fabulatoria dei poveri, in quanto dà al falso la potenza che ne fa una memoria, una leggenda, un mostro».

Affabulare vuol dire impegnarsi nell’invenzione di un popolo, «allora il cinema può chiamarsi cinema-verità, tanto più che avrà distrutto ogni modello del vero per diventare creatore, produttore di verità: non sarà un cinema della verità, ma la verità del cinema»

(Deleuze, 1985: L’immagine-tempo. Cinema 2).

Soggetti o oggetti? - Come e perché pensare un diritto per alcuni robot

08/01/2024Conversazioni sull'Intelligenza ArtificialeTecniche e Tecnologie,Politica,Intelligenza Artificiale

Avevano fatto sorridere le uscite di Giuliano Amato, nella veste di presidente della Commissione Algoritmi, sui molti modi possibili per cucinare le patate suggeriti da una generica intelligenza artificiale.1 Un’uscita considerata ridicola da molti, non adatta alla serietà della questione (tutta imperniata sulla tutela dei contenuti e del copyright dalle grinfie delle cosiddette intelligenze artificiali generative).

Ecco allora che dal 5 di gennaio il teologo Paolo Benanti subentra alla posizione di Amato. Un pensiero affascinante quello della sua «algoretica», che meriterebbe un approfondimento tutto suo. Tuttavia, questo cambiamento al timone di comando credo sia una spia interessante per porsi una domanda iniziale. Con questo cambio assistiamo infatti ad un riorientamento verso altre specializzazioni accademiche dalle quali si va cercando consiglio: siamo passati dal diritto alla filosofia morale, alla bioetica: che il diritto abbia già esaurito tutto ciò che di utile poteva dirci a riguardo?

È bene notare come sia una tendenza diffusa quella di applicare i criteri della casuistica2 ai nuovi scenari creati dalle interazioni umane con agenti più o meno autonomi, ma sicuramente non organici. Questi criteri si rivelano certamente strumenti utili per indagare la rettitudine morale o, nel peggiore dei casi, il minore dei mali, da perseguire nel sempre più ampio ventaglio di scenari possibili. Io credo però che le maglie della legge, di una legge che sorge dalle garanzie costituzionali, possa offrirci ulteriori e più interessanti metodi di analisi. E forse anche qualche garanzia in più.

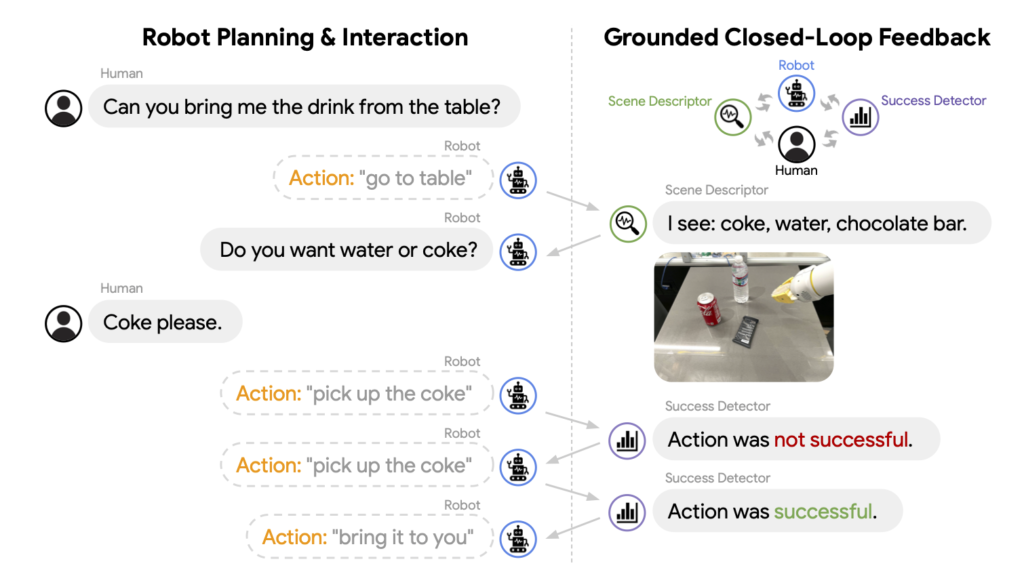

Definiamo però subito bene il nostro perimetro di riferimento: quali sono questi robot? Robot sociali sicuramente, di quelli pensati per entrare costantemente in contatto con noi per intenderci, e dotati di un monologo interiore. Cos’è però il monologo interiore, per un robot? Semplicemente lo stesso che è per te che stai leggendo: un modo per aggiornarne costantemente il proprio modello del mondo cercando sempre di approssimare al meglio gli ipotetici scenari futuri.

Noi ne abbiamo solitamente esperienza come quella vocina nella nostra testa, o quel «buzzing that went on inside my head» di cui parlava Alan Turing. A livello funzionale però non ci occorre teorizzare alcun homunculus, solo un flusso di linguaggio interno.3

Perché il monologo interiore è importante per il nostro discorso sociale? Perché ci offre la possibilità di soddisfare uno dei criteri più spesso rincorsi nei dibattiti sull’intelligenza artificiale: la trasparenza.

È il caso anche delle recenti (dicembre 2023) proposte contenute nell’EU AI Act, dove si legge come alcuni dei requisiti per un utilizzo corretto dei «sistemi di IA identificati come ad alto rischio», siano «la registrazione dell'attività per garantire la tracciabilità dei risultati; la documentazione dettagliata che fornisca tutte le informazioni necessarie sul sistema e sul suo scopo per le autorità di valutarne la conformità; l’accessibilità e la trasparenza di informazioni chiare e adeguate all’utente».

Attenzione: le scatole nere rimangono tali, tuttavia guadagnano, grazie alla registrazione del loro monologo interiore, un alto grado di trasparenza sulle loro azioni. Bene, per robot che agiscono così credo si possa ragionevolmente parlare di soggetti (o oggetti, poi ci arriviamo) autonomi.

Ora, se un (s)oggetto è autonomo, cioè è in grado di compiere azioni senza essere comandato a distanza da altri soggetti, allora ci occorre incasellarlo all’interno di una qualche finzione giuridica, in modo tale che se dovesse arrecare qualche danno, sapremmo quali norme seguire. Ecco, credo che questo sfondo di prudenza sia quello sul quale ragionare di diritti robotici: non occorre mischiare concetti come quello di agente e paziente morale, ci basta soffermarci sul riconoscimento dell’esistenza (sempre più prossima)4 di entità immerse nel nostro stesso ambiente che agiscono in maniera per noi più o meno comprensibile.

Sembra dunque che stia proponendo qualcosa di non molto diverso dalla «personalità elettronica» discussa per la prima volta in una bozza europea nell’ormai lontano 2017. Occorre però fare delle debite precisazioni per non rischiare di cacciarsi nel ginepraio legistico e propongo allora qui di seguire le cristalline ricostruzioni di Luigi Ferrajoli.5

Innanzitutto, di quale diritto stiamo parlando? I diritti soggettivi, quelli cioè spettanti ad ogni soggetto (fisico e poi dunque giuridico), devono essere concettualmente distinti (1) in diritti fondamentali e diritti patrimoniali.

È bene subito ricordare come i diritti fondamentali, indisponibili per loro natura, siano «limiti imposti alla democrazia politica e al mercato a garanzia della loro stessa conservazione» mentre i diritti patrimoniali, siano diritti di forma singolare: escludono cioè tutti gli altri soggetti.

È poi per noi necessario distinguere, (2) all’interno dei diritti fondamentali, quelli di libertà e quelli di autonomia privata. La logica di questa seconda biforcazione è chiara, ed è la medesima alla base della distinzione tra i diritti fondamentali e quelli patrimoniali: sia i diritti patrimoniali, evidenziati in (1), sia i diritti fondamentali di autonomia privata, evidenziati in (2), sono da considerarsi in quanto potestatis agendi, ovvero diritti potestativi.

Al contrario, i diritti fondamentali di libertà non possono che essere mere immunità, o facultates agendi e dunque si differenziano dai diritti fondamentali di autonomia i quali «formano il principale veicolo della differenziazione dei diritti singolari di proprietà e perciò del moltiplicarsi di disuguaglianze giuridiche e materiali nei diritti patrimoniali».

Tenendo ben chiara questa suddivisione ciò che si vuole qui iniziare a discutere sarà allora un diritto fondamentale di libertà per questi, e ora possiamo dirlo, soggetti robotici. Nessun diritto di giocare in borsa (un diritto di autonomia privata), né di potersi comprare qualche capo di fast-fashion (un diritto patrimoniale), piuttosto la garanzia di una difesa della loro integrità da interferenza arbitrarie.

Si chiederà: perché? che bisogno c’è di questo diritto di libertà?

Ecco due considerazioni:

(a) non sappiamo cosa succeda all’interno di queste macchine, e non possiamo, io credo, dirimere così facilmente la famosa domanda del «cosa si prova ad essere quel sistema».

Ne segue poi che il metro con il quale dovremmo valutare una macchina, se non vogliamo solamente una versione più efficace di un oggetto che già possediamo ma cerchiamo invece un nuovo soggetto con cui dialogare e con il quale costruire qualcosa di nuovo insieme, sia necessariamente quello di un fair-play.

Questo credo sia l’insegnamento, e l’atteggiamento, più importante che Alan Turing ci ha per primo lasciato: «a fair play [that] must be given to the machine. Instead of it sometimes giving no answer we could arrange that it gives occasional wrong answers. But the human mathematician would likewise make blunders when trying out new techniques. It is easy for us to regard these blunders as not counting and give him another chance, but the machine would probably be allowed no mercy. In other words then, if a machine is expected to be infallible, it cannot also be intelligent . . . No man adds very much to the body of knowledge, why should we expect more of a machine?».6

Ciò di cui qui si discute sono dunque macchine incorporate nel mondo che per poter agire in questo mondo hanno bisogno di poter sbagliare, perlomeno quando lo sbaglio non arreca danni irreparabili ma – ad esempio - solo una contenuta flessione nel profitto.

(b) la commodificazione di un possibile nuovo soggetto può risultare l’ulteriore veicolo di lacune già presenti all’interno di una costruzione giuridica che ha inventato finzioni ben più de-responsabilizzanti e pericolose (basti pensare alle holding finanziarie dotate di personalità giuridica). Di fatto poi tali lacune sono spesso alla basse dell’emergenza di quelli che Ferrajoli giustamente definisce crimini di sistema. Dopotutto non è tramite la riduzione dei soggetti che possono mettere in gioco un reciproco controllo dei rispettivi poteri che si garantisce la continuità delle nostre prerogative costituzionali, piuttosto è con un ampliamento di tali figure che si può garantire alla democrazia politica e al mercato laloro stessa conservazione.

Cosa ci guadagniamo da questa proposta? cosa invece ne perdiamo?

Occorre discuterne. Certo è che il primo passo è riconoscere la possibile rilevanza della questione.

NOTE

1 Il virgolettato in realtà recitava: «A me piacciono molto le patate. Grazie all’intelligenza artificiale, un giornalista in pochi istanti potrà sapere tutti i modi in cui posso cucinarle, così da arricchire il suo pezzo».

2 Parte della teologia morale, che applica i principi della morale teorica a casi concreti, anche solo ipotetici («casi di coscienza»), secondo varie circostanze, per trovare la regola valida per ciascuno, metodi ancora attuali in molta etica e bioetica contemporanea.

3 Un modello chiaro per i nostri robot è quello dell’«Inner Monologue», sul quale si può approfondire qui: https://innermonologue.github.io

4 È chiaro che il discorso normativo che sto qui presentando cerca di anticipare il futuro alla luce delle tendenze più attuali e che paiono più promettenti. Altre architetture, non basate sulla commistione tra un modello LLM (come il famigerato ChatGPT per intenderci) e un robot potrebbero prendere il sopravvento, resta il fatto che l’obiettivo perseguito rimarrà quello di un’efficace autonomia di questi (s)oggetti, e dunque il punto giuridico del discorso non varia di molto, varierebbero sì i soggetti. Un esempio dell’interazione uomo-macchina con questo modello si può vedere qui: https://www.youtube.com/watch?v=djzOBZUFzTw&t=334s

5 Il riferimento è il tomo estremamente denso e tuttavia cristallino La costituzione della democrazia (2021). Le parti più rilevanti per il nostro discorso sono, per chi fosse interessato ad approfondire, la III e la IV.

6 La citazione viene dalla trascrizione della Conferenza tenuta alla London Mathematical Society il 20 Febbraio 1947. Una traduzione si trova nel volume curato da Gabriele Lolli sull’«intelligenza meccanica» e recita così: «sostengo che la macchina deve esser trattata in modo equo e leale. Invece di avere una situazione in cui la macchina a volte non dà risposte, potremmo aggiustare le cose in modo che essa dia ogni tanto risposte sbagliate. Anche il matematico umano prende qualche cantonata quando sperimenta nuove tecniche. È facile per noi considerare queste sviste come non rilevanti e dare a lricercatore un’altra possibilità, ma alla macchina non viene riservata alcuna pietà. In altre parole, se si aspetta che la macchina sia infallibile, allora essa non può anche essere intelligente… Nessun uomo aggiunge granché al corpo generale delle conoscenze umane: perché dovremmo aspettarci di più da una macchina?»

Conversazioni sull'Intelligenza Artificiale - Medicina, un salto culturale quantico

08/01/2024Attualità,Conversazioni sull'Intelligenza ArtificialeSalute e Medicina,Tecniche e Tecnologie,Intelligenza Artificiale

Gianluca Fuser: Alessio, tu ti stai occupando – nel tuo lavoro - di tecnologie di Intelligenza Artificiale applicate al mondo della cura veterinaria e questo ti dà l’opportunità di spaziare anche nell’ambito delle molte sperimentazioni destinate alla medicina umana. Che impressione hai del fermento che anima questo settore?

Alessio Panella: Un fatto certo è che nel settore della medicina veterinaria la sperimentazione si spinge più in là che in quello della medicina umana, purtroppo in virtù del fatto che gli animali non umani sono ancora e per lo più considerati sostituibili e di un ordine di importanza morale inferiore a quello degli umani – come tu ben sai.

Si testano, infatti, già sul campo applicazioni che interpretano le TAC in modo apparentemente esaustivo; c’è già chi pensa che il medico veterinario potrà ricevere il referto completo e definitivo senza quasi vedere le immagini.

L’ovvio vantaggio è in termini di riduzione dei costi e dei tempi operativi; forse si può aggiungere una maggiore attenzione ai fenomeni “fuori focus”, quelli spesso ignorati a causa della distorsione cognitiva del medico che – nell’immagine - cerca la patologia che già pensa di dover cercare e rischia di non notare segnali poco evidenti di altre patologie.

Nel campo della medicina umana, invece, ci si muove con maggiore prudenza. Ma non pensare che le applicazioni in sperimentazione o già in uso siano meno dirompenti.

Gianluca: Ad esempio?

Alessio: I casi sono moltissimi ma posso indicarti un paio di esempi secondo me molto rilevanti, che convergono su un obiettivo comune: ridurre la spesa sanitaria. In un caso per il sistema sanitario nazionale britannico (NHS), nell’altro caso per le assicurazioni private su cui si basa il sistema sanitario statunitense.

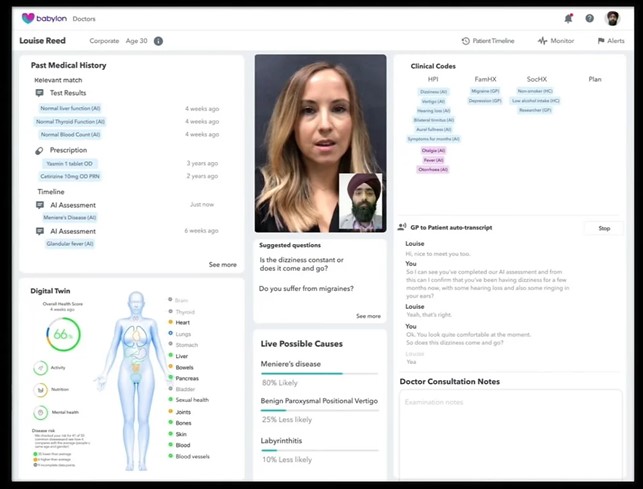

Per non tediarti, oggi affronterei il primo caso, quello di Babylon, un sistema di “visita a distanza” adottato in via sperimentale dal NHS in alcune aree di Londra. Il contatto tra medico e paziente avviene conversano in video: il paziente usa una app su smartphone, il medico la sua postazione con il suo personal computer.

Durante la conversazione Babylon mostra al medico la storia sanitaria del paziente mentre trascrive la conversazione e la interpreta: isola, cioè, i sintomi rilevanti riportati dal paziente, evidenziandone anche possibili collegamenti con patologie pregresse. Valuta poi inoltre anche il quadro complessivo dello stato di salute del paziente, anche in forma grafica, con una sorta di gemello digitale proposto sullo schermo.

Infine, assiste il medico nel lavoro diagnostico: in primo luogo, proponendo una serie di potenziali diagnosi basate sulla storia clinica, sui sintomi e sulle frequenze statistiche che “ha in pancia” e, in secondo luogo, suggerendo al medico le domande da fare per seguire un percorso organizzato di approfondimento e di diagnosi differenziale.

L’ultima funzionalità è quella con la quale il software analizza le espressioni facciali e la postura del paziente a schermo e informa il medico di eventuali stress o disagi che il paziente sta provando. In sostanza guida il medico anche nella relazione con il paziente, finché questi non sia sereno del risultato della visita.

Gianluca: Che parte svolge la IA in questo processo?

Alessio: Dalla A alla Z. Se vogliamo essere puntigliosi, l’unico passaggio che non è pervaso di IA è la cartella clinica, la storia sanitaria del paziente. Tutto il resto: interpretazione del linguaggio parlato, collegamenti, analisi dello stato di salute e delle espressioni facciali, proposte e suggerimenti, sono tutti guidati da programmi di IA. Che, è bene ricordarlo, sono basati principalmente su inferenze a base statistica.

Puoi vedere chiaramente che vantaggi si ribaltano sull’economia del NHS: meno presenza fisica sul territorio, meno spostamenti, visite più veloci, minori rischi di malattie professionali da contagio per i medici, probabilmente meno costi per accertamenti diagnostici, sicuramente minori costi di apprendistato per i medici di assistenza di primo livello.

Gianluca: Detta così, mi pare che ci possano essere dei vantaggi non trascurabili anche per i pazienti. Perlomeno si potrebbe pensare che – se lo staff medico nel suo complesso è dimensionato in maniera adeguata – si possa garantire una maggiore accessibilità dei servizi di prima assistenza per le situazioni non gravi e una maggiore efficacia nell’indirizzamento diagnostico o terapeutico. Oltre che, come dicevi prima, la possibilità di cogliere problemi fuori focus.

Alessio: Non sbagli affatto. Questi vantaggi ci possono essere di sicuro se – come puntualizzavi – lo staff è ben dimensionato e la base di conoscenza dell’applicazione è adeguata. Aggiungi anche che la somma di medico e di software che lo supporta possono garantire anche un tasso di errore diagnostico, a pari informazioni.

Gianluca: Quindi, non vedi problemi?

Alessio: Purtroppo alcuni problemi ci possono essere: se la “macchina” funziona bene, il medico – che dovrebbe essere la figura principale in questa relazione a tre – può essere meno competente o passare in secondo piano e rischia di diventare solo un tramite tra macchina e paziente. La tentazione per i gestori di un sistema sanitario che deve risparmiare è grande: riduzione dei percorsi professionalizzanti, standardizzazione verso il basso, passaggi delegati interamente alla macchina. Un altro rischio – connesso con la de-professionalizzazione dei medici di prima assistenza – è l’appiattimento delle diagnosi sulle frequenze statistiche.

Gianluca: Cosa significa? Che riconosciuti alcuni sintomi la macchina proporrà sempre la stessa diagnosi, perché statisticamente più frequente?

Alessio: Esattamente questo: se il medico non si impegna nella valutazione delle diverse possibilità di malattie che presentano gli stessi sintomi, in altre parole non fa la diagnosi differenziale, tutti sono malati della stessa malattia. Ma, soprattutto, tutti sono malati!

L’assenza di un contatto personale, di conoscenza del paziente, delle sue idiosincrasie e della sua storia – non solo di quella clinica - unite alla minore competenza e alla pressione “produttiva” sui medici possono fare il disastro.

Gianluca: Quindi i benefici che abbiamo visto prima si prospettano solo sul fronte del contenimento dei costi sanitari?

Alessio: Sì, se il governo di questo sistema complesso di medicina a distanza supportata dall’intelligenza artificiale non si focalizza sul termine “medicina”, cioè sulla pratica condotta da un medico, vero, capace e coadiuvato da macchine ben funzionanti. E se non dimentica il ruolo fondamentale del contatto di prossimità con il paziente.

Gianluca: Sono del tutto d’accordo con te: solo un’accorta gestione di questi processi può coniugare il contenimento dei costi e una maggiore attenzione per i pazienti.

Un ultimo punto, per oggi: dal punto di vista etico e della responsabilità, come vedi questa innovazione?

Alessio: Il problema della responsabilità è significativo: nel processo congiunto medico-macchina, quando viene commesso un errore chi si prende la responsabilità? Il medico o la macchina? Come hai già scritto su questo blog, c’è un’intera filiera di potenziali responsabili, che deve essere ordinata dal punto di vista legale e pratico – e parlo anche della necessità di trasparenza dei meccanismi di apprendimento e di esecuzione.

Quello che non va dimenticato, però, è il punto di vista del paziente: preferisce che il suo caso clinico venga analizzato da un dottore di 25 anni che si è laureato ieri l'altro e ha visto solo venti casi, oppure da un software che non sa come funziona ma che ha elaborato e sintetizzato 2 milioni di casi simili?

Quello che voglio dire è che l’entrata in campo di questi software è un urto culturale, che non riguarda la maggiore o minore possibilità di errore di una macchina rispetto ad un umano, ma chi commette l’errore.

All’estremo: noi accettiamo l’errore umano come naturale, se la diagnosi sbagliata del medico mi uccide è un umano come me che l’ha fatto. Ma se l’errore è della macchina? Accettare di essere uccisi da una macchina: ecco il salto quantico che ci impone questo cambiamento di paradigma culturale.

Claude Bernard e Georges Canguilhem - Una controversia ancora viva (?)

08/01/2024Salute e Medicina,Paradigmi scientifici

CLAUDE BERNARD – LA VITA DIMENTICATA NEL LABORATORIO

Nel 1813 a Saint-Julien, paesino non troppo distante da Lione nasceva Claude Bernard. Come Semmelweis, di cui già si è parlato in questo blog, fu una delle figure più importanti per la medicina del XIX secolo.

Anch’egli dovette scontrarsi con una fetta della società del suo tempo, ma diversamente dal medico ungherese Bernard ricercò tutta la vita di fondare una medicina che fosse scientifica e si basasse sugli andamenti regolari e costanti della fisiologia.

Giunto a Parigi nel 1839 per proporre una sua pièce teatrale, Bernard comprese che quella strada non faceva per lui. Si risolse quindi a studiare medicina nella capitale francese, avendo già trascorso diversi anni come aiutante in una farmacia.

Agli inizi della sua carriera conobbe lo studioso di fisiologia Francois Magendie (detentore della cattedra di Medicina al Collège de France dal 1830 al 1855). La fisiologia al tempo era una massa informe di conoscenze derivate da esperimenti e osservazioni senza una sistematizzazione. Magendie poteva permettersi di operare in un piccolo laboratorio al College de France. Lui, vitalista eterodosso, manteneva a guida l’idea di un corpo umano soggetto alla forza vitale, ma non si lasciava intimorire nel dichiarare la necessità di aprire (il corpo) alla sperimentazione.

Bernard seguiva questo suo maestro, ma rivendicava la necessità di un passaggio ulteriore che Magendie, definito da Bernard un empirista radicale, non faceva. Per Magendie infatti l’esigenza scientifica era quella di alterare e osservare i fenomeni. Bernard voleva di più, voleva spiegare.

«Magendie si comportava da empirico ed era solito dire: perturba i fenomeni, ossia sperimenta e limitati a controllare i fenomeni senza spiegare nulla. Non era ancora il metodo sperimentale completo, perché tale metodo sperimentale esige delle spiegazioni.»

Bernard era tutt’altro che vitalista. La rivoluzione avvenuta il secolo precedente con Isaac Newton stava dando i suoi frutti anche in chimica proprio in quel periodo. La scienza medica si svolgeva in laboratorio. Lo studio della fisiologia, delle costanti e delle funzioni avrebbe permesso la comprensione della patologia come variazione dallo stato fisiologico.

Hal Hellman, simpatico divulgatore scientifico che ha raccolto parte di questo racconto su Bernard, dice che Bernard fu colui che rese la medicina una scienza basata su esperimenti e fatti.

Bernard fu senz’altro fine sperimentatore e produsse molteplici osservazioni, esperimenti, vivisezioni e il suo lavoro permise alla fisiologia di costruirsi una base feconda su cui svilupparsi.

Egli riconosceva il dolore animale, tuttavia ne giustificava l’uso ai fini del progredire della scienza medica. La funzionalità del sacrificio di un vivente per una causa più grande è un elemento evidente della visione scientifica di Bernard che, di fatto, disconosce il vivente, anche umano.

Bernard butta il vivente fuori dal laboratorio e tiene, per studiarlo, solo il corpo.

Che poi il vivente, una volta uscito dalla porta del laboratorio, rientri dalla finestra nella pratica clinica, non è problema della scienza fisiologica. Questa, infatti, fondava il suo tentativo di essere bella e potente – come si stavano dimostrando al tempo la fisica e la chimica – proprio sul disconoscimento del vivente e sulla pratica sperimentale che questo disconoscimento permette.

GEORGES CANGUILHEM – LA VITA RISCOPERTA NELLA SCIENZA

Circa cent’anni dopo Georges Canguilhem, filosofo abilitato anche alla professione medica, criticherà la visione di Bernard e della fisiologia medica, la quale nel frattempo si era del tutto affermata, insieme allo sguardo “normalizzante” sul vivente.

Canguilhem, erede della lezione di Bergson per cui il vivente è irriducibile, ritiene invece sia necessario recuperare il vitalismo.

Egli risale dalla medicina alla biologia, poiché è nella biologia a lui contemporanea che la medicina trova la sua morale, riducendo – come ha iniziato a fare Bernard - la malattia a un discorso di variazioni di funzioni fisiologiche.

Canguilhem chiama questa riduzione “il dogma dell’identità dei fenomeni fisiologici e dei fenomeni patologici”, che la medicina di Xavier Bichat e Claude Bernard prende dalla fisica newtoniana e condivide con altri campi come la sociologia di Auguste Comte.

Sottolineando, Canguilhem, come concezione di scienza medica – nonostante la consolidata tradizione di successi - dimentichi un dato fondamentale: è perché vi sono malati che c’è una medicina.

Dobbiamo accettare che il vivente sia l’oggetto della biologia. Che sia, sì, soggetto a tutte le leggi fisico-chimiche. Ma, ci ricorda Canguilhem, il mondo della fisica e della chimica non sono mondi esterni al vivente.

Egli è in esse ma non vive in esse. Il vivente vive un ambiente valorizzato, polarizzato e in ultimo significato.

Vive in mezzo a esseri e avvenimenti che diversificano le leggi. Le scienze della vita non possono purificarsi dall’individualità vivente, non devono farlo, altrimenti non avrebbero da dire nulla più della fisica e della chimica.

Così la medicina non può negare il soggetto.

È il malato che chiama il medico. Certo, il medico può – perché la medicina ha una storia – conoscere meglio cosa fa la malattia del malato. Ma, per quante importanti conoscenze possono portare la fisiologia e lo studio delle normali e delle frequenze, salute e malattia appartengono al malato.

Un grande scrittore milanese, gravemente malato e a poco dalla sua morte, dirà “sono insufficientemente umile per accettare ciò che la malattia ha comportato e comporterà”.

Possiamo fare una colpa al malato se si ostina a opporsi alla sua malattia? Vogliamo fare della malattia una colpa e della salute un merito? Definendo normalità e malattia prima di avere incontrato il malato?

La norma, dice Canguilhem, il medico la deriva dal suo malato.

Il malato può preoccuparsi se la sua assicurazione coprirà le spese – tristezza dei nostri tempi – ma “ciò che mi occupa”, dice, “è la mia malattia e il bisogno di guarirne”.

Sarà il soggetto, il malato, l’individuo, a dire della sua ritrovata salute. Sia che vi sia stato dolcemente accompagnato o portato a forza di bisturi e trapano.

CONCLUSIONE

Ciò che rese Semmelweiss un grande medico sono le donne partorienti salvate: la salvezza e il miglioramento di vite personali e di una intera società. Non le medie abbassate, alle quali nemmeno i fautori di quel metodo credevano nel momento in cui li smentivano.

Non è possibile vivere come un ostacolo epistemologico la soggettività del malato.

I medici che accettano questo principio, accettano di reinscrivere la loro scienza in una storia umana. Esercitano la medicina come servizio all’umano nella sua lotta contro ciò che è negativo, contro ciò che è vissuto come malattia.

P.s. il grande scrittore milanese (di Novate Milanese in realtà) citato è Giovanni Testori in una sua intervista al quotidiano La Stampa il 2 gennaio del 1993.

RIFERIMENTI E LETTURE:

Grmek Mirko (a cura), Storia del pensiero medico occidentale, Laterza

Bernard Claude, Introduzione allo studio della medicina sperimentale, Feltrinelli

Hellman Hal, Le dispute della medicina. Dieci casi esemplari, Raffaello Cortina

Canguilhem Georges, Il normale e il patologico, Einaudi

Canguilhem Georges, La conoscenza della vita, Il Mulino