Come si fa un premio Nobel

COME L’HA FATTO ALFRED NOBEL

Il premio nasce con la volontà testamentaria di Alfred Nobel che istituisce – con il 94% del suo notevole patrimonio[1] - un fondo di investimenti:

«La totalità del mio residuo patrimonio realizzabile dovrà essere utilizzata nel modo seguente: il capitale, dai miei esecutori testamentari impiegato in sicuri investimenti, dovrà costituire un fondo» [2] i cui interessi «si distribuiranno annualmente in forma di premio a coloro che, durante l'anno precedente, più abbiano contribuito al benessere dell'umanità»

Il premio riconosce, nel campo scientifico, «la scoperta o l'invenzione più importante nel campo della fisica», «la scoperta più importante o apportato il più grosso incremento nell'ambito della chimica», «la maggior scoperta nel campo della fisiologia o della medicina».

Poi, riconosce un premio per l'ambito della letteratura e uno per «la persona che più si sia prodigata o abbia realizzato il miglior lavoro ai fini della fraternità tra le nazioni, per l'abolizione o la riduzione di eserciti permanenti e per la formazione e l'incremento di congressi per la pace.»

L’Alfred mecenate delle scienze, della pace e della letteratura è proprio “quel” Nobel, il “mercante di morte”[3], l’imprenditore, chimico, ingegnere e inventore della dinamite e di numerosi altri esplosivi – alla sua morte detiene 355 brevetti - che ha accumulato l’enorme fortuna poi destinata al premio grazie alle applicazioni civili (in parte minore) e militari (in parte più consistente) delle sue esplosive invenzioni.

La devoluzione del patrimonio per stimolare e premiare la ricerca scientifica, la letteratura e gli sforzi di pace è – quindi – una sorta di riparazione, un tentativo di auto-assoluzione per la creazione degli strumenti di morte.

STILE DI PENSIERO, ROMANTICO E POSITIVISTA. MA NON DEL TUTTO

La lettura del testamento, molto conciso, deve aver lasciato piuttosto male i nipoti maschi a cui Alfred ha destinato “solo” un centinaio di migliaia di corone a testa (forse 7-8 milioni di dollari attuali) e ancora peggio le due nipoti femmine, con 50.000 corone a testa - subito si coglie la differenza di trattamento, normale per i tempi, tra gli eredi di sesso maschile e quelle di sesso femminile – togliendo dall’asse ereditario familiare il grosso della fortuna, i 31 milioni di corone che vanno a costituire il fondo per il Premio Nobel.

A chi viene destinato il Premio, nelle ultime volontà di Nobel?

A delle persone, “to the person who made” testualmente; questo spezzone di frase tradisce l’influsso romantico, l’esaltazione della creatività dell’uomo[4], della immaginazione artefice, del pensiero intuitivo che si pone in contrapposizione con la razionalità illuminista. Il premio non va a dei gruppi, non a delle istituzioni, ma a dei singoli individui (in numero massimo di tre) meritevoli di aver fatto le più importanti scoperte o avanzamenti nel loro campo di studio.

Singoli individui che – da soli – hanno favorito lo sviluppo e il benessere dell’umanità.

Sempre dalle parole del testamento si possono cogliere indizi dello stile di pensiero[5] positivista che ne informa le scelte e, anche, qualche contraddizione sommersa.

Nobel è convinto, come è ovvio per un chimico, scienziato e inventore del XIX secolo, nel mezzo dell’onda positivista, che le scienze, le scoperte scientifiche siano il modo migliore per comprendere la realtà, le scoperte siano conquiste e le conquiste un veicolo di progresso, che aprono la strada ad applicazioni che migliorano il benessere dell’umanità.

Però, quella frase « a coloro che, durante l'anno precedente, più abbiano contribuito al benessere dell'umanità» da una parte, cela la tremenda relazione tra scoperta scientifica e distruzione che ha caratterizzato il lavoro di Nobel e, dall’altra parte sembra essere un monito – del mercante di morte pentito affinché la scienza (e il Premio) evitino di focalizzarsi sul versante mortifero, distruttivo, della ricerca.

Questo monito – in qualche modo - anticipa la critica allo scientismo, la critica alla narrazione della scienza sempre buona in sé, neutrale, che genera il male solo se usata male (dai politici, ad esempio) e che assolve sempre lo scienziato, che deve solo pensare a sviluppare la sua ricerca.

Alfred Nobel, seppure negli ultimi anni della sua vita, in contrasto con la visione positivista e scientista ottocentesca, si prende la responsabilità delle sue creazioni letali e non si nasconde dietro alla pretesa di neutralità del lavoro scientifico.

In conclusione, l’istituzione del premio sembra essere una sintesi tra l’approccio alle scienze del secolo positivista, l’individualismo romantico, e il prodromo di critica anti-scientista che, forse, prova a tracciare la strada di una scienza responsabile.

COME SI FA, OGNI ANNO, IL NOBEL

L’assegnazione di un Premio Nobel – ad esempio, per la fisica[6] - segue un processo articolato che coinvolge un numero elevato di persone, fisici, professori e ricercatori, teorici e sperimentali, di rilevanza svedese e mondiale.

Responsabile della selezione dei candidati e della scelta del premiato è l’Accademia Reale Svedese delle Scienze, in particolare il Comitato del Nobel per la fisica, composto da 8 membri – quasi tutti svedesi, tutti che lavorano in università svedesi. Il processo prevede una preselezione, la discussione con un panel di esperti, una selezione dei candidati finali da discutere con i 75 membri della Academy Class of Phisycs. La scelta finale del Laureate a cui viene assegnato il premio viene fatta dal solo Comitato per la Fisica.

Può essere interessante capire chi sono – oggi - i fisici a cui viene esteso l’invito a nominare i candidati; si tratta dei Membri dell’Accademia delle Scienze Svedese e del Comitato per la Fisica, dei precedenti premiati per la fisica, dei professori con cattedra in Fisica di ruolo nelle Università e negli Istituti tecnologici scandinavi, di alcune centinaia di cattedratici in fisica di università di tutto il mondo, in modo da garantire una adeguata copertura geografica e, infine, altri scienziati che – discrezionalmente – l’Accademia ritenga adeguati.

Per dare un’idea della caratura dei nominators, nel 1955 furono invitati 57 scienziati, tra cui Wolfgang Pauli, Max Born, Jaques Hadamard, Otto Hahn, Luis Victor e Maurice de Broglie, Thomson, Occhialini, Benedetto Rossi, Werner Heisenberg.

I vincitori furono Polykarp Kusch e W.E. Lamb, rispettivamente per la scoperta della struttura fine dell’elettrone e del momento magnetico, sempre dell’elettrone, entrambi nel 1947.

Una delle regole del Premio è che le scoperte siano il più possibile “tested by time”, cioè abbiano confermato nel tempo la loro validità e rilevanza. Spesso, infatti, sono premiati scienziati che hanno raggiunto i loro risultati molti anni prima, anche più di 50, il 38% dei premi si riferisce a ricerche di più di 20 anni prima.

Questo sembra essere una garanzia contro la fretta e le mode.

I criteri da rispettare per le candidature, dichiarati nella scheda di segnalazione, sono semplici e abbastanza standard per la valutazione di lavori di ricerca: «i paper devono essere focalizzati su ricerche regolari di Fisica e la Fisica deve essere l’argomento dominante; devono contenere risultati nuovi, originali e interessanti ottenuti dall’Autore in teorie, esperimenti o realizzazione di strumenti e device».

Ecco, pare che si sia perso un carattere peculiare del lascito di Nobel: il contributo al progresso dell’umanità dei lavori proposti. Nella ricerca delle candidature questo obiettivo sembra essere sottinteso oppure, forse, questo è un segno dell’ancora prevalente principio positivista e scientista che pretende che ogni scoperta scientifica sia un passo verso il progresso e il benessere dell’umanità.

In aperto contrasto con la critica e il senso di responsabilità di Nobel, le cui scoperte hanno avuto, invece e palesemente, effetti distruttivi e forieri di grandi malesseri per tutta l’umanità.

DISTORSIONI E OPPORTUNITÀ

Ci sono, sicuramente, ampie possibilità di parzialità, di dominio degli stili di pensiero del momento (il premio per la Fisica del 1955 ne è una prova, tra i Nominator c’era una maggioranza di fisici quantistici e il premio fu assegnato a ricerche quantistiche), di concentrazione geografica (quasi il 50% dei premiati è statunitense), di pregiudizi (le donne premiate sono pochissime, a volte sono state escluse dalla lista seppur determinanti per la ricerca premiata), di esclusione (il criterio di 3 premiati è restrittivo per l’attuale conformazione per gruppi della ricerca).

Sappiamo, però, che le scienze sono sempre fortemente influenzate da come funziona la società e il Nobel – che è comunque espressione del mondo scandinavo – non sfugge a questa regola.

Inoltre, il processo particolarmente articolato, la presenza di una grande pluralità di soggetti, insieme al criterio di validità testata dal tempo e alla adesione della Fondazione ai principi testamentari di Nobel sembrano far sperare che la scelta dei premiati rispetti il desiderio del fondatore che scienziati e accademia si prendano la responsabilità di quello che fanno, rifuggendo l’aura di neutralità di cui si vuole ammantare il lavoro scientifico e, veramente, favoriscano e premino le ricerche che realmente creano benessere.

NOTE

[1] 31 milioni di Corone Svedesi del 1895, forse paragonabili a 2,5 miliardi di dollari US attuali (stime approssimative dell’autore)

[2] La traduzione dei passi del testamento è tratta da Wikipedia https://it.wikipedia.org/wiki/Premio_Nobel

[3] Così viene definito da alcuni giornali francesi nel 1888, quando morì il fratello Ludvig.

[4] Nell’ottocento le locuzioni “dell’uomo” e “umano” sono del tutto equivalenti.

[5] Cfr.: Fleck L., Genesi e sviluppo di un fatto scientifico, Il Mulino, 1983

[6] Ci limitiamo, per brevità, a considerare quello per la fisica che è, però, caratterizzato dal processo più complesso e articolato

Attribuiamo troppa autorità ai Premi Nobel?

Una delle maggiori onorificenze in ambito scientifico è il Premio Nobel. Questo riconoscimento di valore mondiale viene attribuito annualmente a personalità di spicco che si sono distinte in diversi campi dello scibile umano - come la fisica, la chimica, la medicina, la letteratura e la pace - portando benefici all'umanità attraverso le loro ricerche, scoperte e invenzioni.

Ricevere questo prestigioso riconoscimento è il risultato di un processo lungo e articolato. La selezione dei premiati per le categorie scientifiche è affidata a istituzioni scientifiche e culturali svedesi.

Il processo di selezione inizia quando il comitato invita annualmente, generalmente a settembre dell’anno precedente alla vincita effettiva, un vasto numero di esperti e personalità di spicco nel proprio settore a proporre candidati meritevoli. Questi esperti possono essere membri dell'Accademia Reale Svedese delle Scienze, scienziati, accademici e altri professionisti riconosciuti a livello internazionale. Le richieste di nomina vengono inviate a centinaia, talvolta migliaia di persone in tutto il mondo. È importante notare che le autocandidature non vengono prese in considerazione.

Una volta raccolte le candidature, il Comitato Nobel esamina attentamente tutte le proposte e compila una lista ristretta di nominati. Dopo approfondite valutazioni e discussioni, il comitato di esperti si riunisce per eleggere i vincitori dei vari premi, che vengono annunciati pubblicamente in ottobre e premiati in una cerimonia ufficiale il 10 dicembre, anniversario della morte di Alfred Nobel.

Dal 1901, anno della prima assegnazione del Premio Nobel, solo quattro persone hanno avuto l'onore di vincerlo più di una volta. Tra questi illustri scienziati ricordiamo Marie Skłodowska Curie, che lo vinse nel 1903 per la fisica e nel 1911 per la chimica; John Bardeen, che ricevette il Nobel per la fisica nel 1956 e nel 1972; Frederick Sanger, vincitore del Nobel per la chimica nel 1958 e nel 1980; e Linus Pauling, che ottenne il Nobel per la chimica nel 1954 e il Nobel per la pace nel 1962.

La famiglia Curie rappresenta uno dei casi unici nella storia dei Premi Nobel, avendo accumulato ben cinque premi tra i suoi membri. Marie e suo marito Pierre Curie condivisero il Nobel per la fisica nel 1903, mentre Marie lo vinse nuovamente per la chimica nel 1911. Loro figlia, Irène Joliot-Curie, insieme al marito Frédéric Joliot, vinse il Nobel per la chimica nel 1935.

I CANDIDATI NON LO SANNO

Ora, in realtà, lo saprebbe solo dopo 50 anni. Le candidature al Nobel rimangono infatti segrete per almeno mezzo secolo, e gli archivi vengono resi pubblici solo dopo questo periodo. Gli unici che vengono informati della loro candidatura sono i vincitori effettivi del Nobel di quell'anno. Per farvi capire meglio: i candidati ai Premi Nobel del 2024, se tutto procede come di consueto, scopriranno di essere stati candidati nel 2074.

Questo fatto ci può mettere in guardia contro affermazioni non accurate. Se qualcuno dichiara: "Sono stato candidato al Premio Nobel", è opportuno essere scettici, poiché, data la riservatezza che circonda le candidature, è improbabile che ne sia effettivamente a conoscenza. A meno che non sia estremamente anziano, è più probabile che tale affermazione non sia fondata.

PRESTIGIO E AUTOREVOLEZZA?

Tuttavia, non è tutto oro ciò che luccica: ricevere il Premio Nobel conferisce una posizione di prestigio sia all'interno sia all'esterno della comunità scientifica, ma questa posizione può non essere utilizzata in modo virtuoso; è accaduto – infatti - che alcuni eccellenti scienziati, dopo aver ricevuto il premio, abbiano iniziato a sostenere posizioni discutibili dal punto di vista della fondatezza e – spesso – poco attinenti con il loro campo di studi. Specialmente se rivolte un pubblico di massa, le opinioni di questi scienziati hanno avuto un impatto profondo proprio a causa del prestigio conferito dal Nobel.

Un esempio noto di posizione discutibile assunta da un vincitore del Nobel è quello di Kary Mullis, il biochimico statunitense che sviluppò la reazione a catena della polimerasi (PCR), una tecnica rivoluzionaria per la biologia molecolare che gli valse il Premio per la Chimica nel 1993. Mullis era noto per le sue idee eccentriche[1] e per il suo scetticismo verso alcune fondamentali teorie scientifiche. In particolare, negò la correlazione tra HIV e AIDS, sostenendo che il virus HIV non fosse la causa della malattia.

Un altro caso emblematico è quello di Luc Montagnier, premio Nobel per la Medicina nel 2008 per la co-scoperta del virus HIV. Negli anni successivi, Montagnier iniziò a sostenere teorie già allora non supportate dalla comunità scientifica e oggi decisamente confutate, tra cui la "memoria dell'acqua", un concetto associato all'omeopatia che suggerisce che l'acqua possa conservare una "memoria" di sostanze precedentemente disciolte in essa. Propose persino che le sequenze di DNA potessero emettere onde elettromagnetiche rilevabili nell'acqua, ipotesi che non ha trovato riscontri sperimentali.

Infine, possiamo citare Linus Pauling, unico individuo ad aver ricevuto due Premi Nobel non condivisi: uno per la Chimica nel 1954 e uno per la Pace nel 1962 (se siete stati attenti, vi sarete accorti che l’ho citato un’altra volta in questo articolo). Nonostante i suoi innegabili contributi scientifici, Pauling divenne un fervente sostenitore della "medicina ortomolecolare", promuovendo l'assunzione di megadosi di vitamine e altre sostanze come metodo per prevenire e curare una vasta gamma di malattie, incluso il cancro. Tuttavia, numerosi studi clinici hanno dimostrato che tali terapie non hanno l'efficacia proclamata da Pauling.

Il problema comune a queste situazioni è che questi scienziati hanno avanzato tesi senza supportarle con dati verificati e verificabili.

Nel mondo delle scienze, il principio di autorità non ha valore: le affermazioni devono essere sostenute da evidenze empiriche e sottoposte al vaglio critico della comunità scientifica. Per quanto un Premio Nobel possa arricchire un curriculum, nessuno è immune dal rischio di incorrere in errori o di sostenere idee infondate. Gli spropositi sono sempre in agguato e il pensiero critico rimane un baluardo fondamentale per il progresso scientifico.

BARRIERE

Un altro aspetto che merita una profonda riflessione è il seguente: secondo uno studio pubblicato su The Lancet nel 2019, solo il 2,2% di tutti i Premi Nobel assegnati dal 1901 è stato conferito a donne. Questo dato ha portato a critiche rivolte al comitato Nobel per aver trascurato i contributi femminili nel campo della scienza.

L'analisi condotta dal team di ricerca suggerisce che le donne nominate per il Premio Nobel per la Fisiologia o la Medicina e per il Premio Nobel per la Chimica avevano le stesse, se non maggiori, probabilità di vincere rispetto ai loro colleghi uomini nelle stesse categorie. Tuttavia, storicamente, le scienziate sono state spesso lasciate in secondo piano, nonostante abbiano contribuito in modo significativo al progresso scientifico.

Purtroppo, senza dati recenti sulle candidature ai premi, è difficile identificare le barriere nei processi di nomina o selezione che impediscono alle donne meritevoli di ricevere questi riconoscimenti. Sarebbe quindi auspicabile che la Fondazione Nobel rendesse disponibili in modo trasparente tutti i dati sulle nomine e sul genere, per comprendere meglio le ragioni di questa disparità e lavorare verso un riconoscimento più equo dei contributi delle scienziate.

CONCLUSIONI

In conclusione, possiamo chiudere con tre considerazioni:

- Da sempre le donne svolgono un ruolo cruciale in tutti gli ambiti, inclusa la scienza. È essenziale riconoscere e valorizzare il loro contributo per promuovere un progresso autentico e inclusivo.

- Se qualcuno si autodefinisce "Candidato al Premio Nobel", è opportuno mantenere un sano scetticismo, poiché le candidature rimangono segrete per almeno 50 anni.

- Il principio di autorità non ha valore nella scienza. Pertanto, quando qualcuno presenta una tesi, è fondamentale valutare le evidenze e i dati verificabili che la supportano.

Il Premio Nobel simboleggia l'apice dell'ingegno umano e dell'impegno nel migliorare la condizione dell'umanità. Tuttavia, come abbiamo esplorato, il percorso della scienza non è privo di ostacoli e paradossi. La storia ci insegna che il progresso autentico si ottiene non solo attraverso scoperte rivoluzionarie, ma anche grazie a una comunità scientifica che valorizza l'integrità, l'inclusività e la critica costruttiva. È essenziale riconoscere che ogni voce, indipendentemente dal genere o dal prestigio, può contribuire significativamente alla conoscenza collettiva.

Come sosteneva il filosofo Karl Popper, la scienza avanza per tentativi ed errori, e l'apertura al confronto è fondamentale. Coltiviamo dunque uno spirito critico, valutiamo le idee sulla base delle evidenze e promuoviamo un ambiente in cui tutti possano partecipare pienamente al meraviglioso viaggio della scoperta scientifica. Solo così potremo costruire un futuro in cui il sapere sia realmente patrimonio di tutti e per tutti.

NOTE

[1] Kary Mullins nelle sue memorie, raccontò esperienze legate all’uso massiccio di droghe, oltre a strani incontri con procioni parlanti e presunti rapimenti alieni.

BIBLIOGRAFIA

- https://www.focus.it/cultura/storia/la-nascita-del-premio-nobel-una-storia-di-armi-strafalcioni-e-ripensamenti

- https://it.wikipedia.org/wiki/Premio_Nobel

- Erik Jorpes, “Alfred Nobel”, in British Medical Journal. Link Diretto: https://www.ncbi.nlm.nih.gov/pmc/articles/PMC1992347/pdf/brmedj02952-0013.pdf

- https://www.wired.it/scienza/lab/2019/12/07/sindrome-nobel-bufale-premiati/

- Mahmoudi, J. A. Poorman, J. K. Silver, “Representation of women among scientific Nobel Prize nominees”. DOI: 10.1016/S0140-6736(19)32538-3 ; Link diretto all’articolo: https://www.thelancet.com/journals/lancet/article/PIIS0140-6736(19)32538-3/fulltext

Nobel nelle scienze: una questione di genere?

Ogni anno vengono assegnati sei premi Nobel, di cui quattro nelle scienze: chimica, fisica, medicina ed economia. Inoltre, molto spesso, ciascun Nobel viene assegnato a 2 o 3 persone. Per cui abbiamo un’abbondanza di vincitor*.

Una cosa che salta subito all’occhio è che, nella storia di questa istituzione, solo poche donne sono state insignite del Premio (Cole 1987, Wade 2002). Infatti, i Premi Nobel e i Premi per l’economia, tra il 1901 (anno di prima assegnazione) e il 2024, sono stati assegnati a donne 58 volte (solo una donna, Marie Curie, è stata premiata due volte). A fronte di 57 donne, nello stesso periodo, i vincitori uomini sono stati… 902[1].

Scartando l’ipotesi (in auge nei secoli passati) che le donne siano intellettualmente inferiori, ci troviamo dinnanzi a un’enorme sotto-rappresentazione della creatività e del contributo femminile nelle scienze.

Peraltro, interviene anche una seconda dimensione: molte delle donne Nobel non hanno avuto figli

(Stemwedel 2009). Infatti, se prendiamo le 11 donne Nobel vincitrici in fisica, chimica e fisiologia/medicina tra il 1901 e il 2006, e i 37 maschi che hanno ricevuto il Nobel nella stessa area e nello stesso periodo, e li compariamo su alcune variabili come anno di nascita, stato civile, numero di figli, premi ricevuti, livello di scolarizzazione e presenza di un Nobel tra i loro mentori, scopriamo che “le donne insignite del Nobel sono state significativamente meno orientate a sposarsi e a avere figli” (Stemwedel 2009)[2].

Questo vale, più in generale, anche per le donne (“semplicemente”) laureate. Quando le laureate hanno avuto figli ne hanno avuti meno dei colleghi maschi laureati (Charyton, Elliott, Rahman, Woodard and Dedios 2011: 203). Le autrici concludono che le più eminenti scienziate – rispetto ai colleghi maschi - tendono a scegliere di dedicarsi alla ricerca scientifica piuttosto che mettere su famiglia.

E’ possibile invertire la tendenza? Certamente sì, e le politiche di genere attuate degli ultimi anni vanno sicuramente in questa direzione. Però, il problema è: mediante queste politiche, quanto tempo ci vorrà per raggiungere un vero riequilibrio? Probabilmente, molti decenni.

Allora sorge un’altra domanda: si può fare qualcosa per accelerare questo lungo processo sociale e culturale? Probabilmente, sì. Le “azioni affermative” temporanee (giornalisticamente dette “quote rose”), l’assegnare dei coefficienti di valutazione (delle carriere scientifiche) diversi per donne e uomini (Gobo 2016), tenendo conto che le prime hanno spesso maggiori carichi di cura famigliare, e altri correttivi, potrebbero essere un rimedio temporaneo per accelerare il processo sociale e culturale.

Ma quando si propone questo, subito si levano cori che gridano “attacco al merito”, “ingiustizia al contrario”, “discriminazioni nel confronti dei maschi” e altre banalità.

Per cui, rassegniamoci ad avere un predomino maschile nell’assegnazione dei Nobel per ancora molti decenni e a vedere la parità di genere realizzata nel… 2070 (o giù di lì).

Però, come cantavano i Nomadi, ma noi (che scriviamo) non ci saremo…

BIBLIOGRAFIA

Charyton C., J. Elliott, M. Rahman, J. Woodard, and S. Dedios (2011). “Gender and Science: Women Nobel Laureates”. Third Quarter 45(3): 203–214

Cole, J. R. (1987). “Women in science”. In: Jackson, D. N. and J. P. Rushton (eds.) Scientific excellence: Origins and Assessment. University of Michigan: SAGE Publications: 359–375.

Gobo, G. (2016), The Care Factor: A Proposal for Improving Equality in Scientific Careers, in M. Bait, M. Brambilla and Crestani, V. (eds.), Utopian Discourses Across Cultures. Scenarios in Effective Communication to Citizens and Corporations, Bern: Peter Lang, pp. 157-183.

Stemwedel, J. D. (2009). ‘Engendered Species. Science, motherhood, and the Nobel Prize: have things gotten harder? Biochemical Evolution”. The Biochemical Magazine, 31(1): 62.

Wade, D. (2002). “Nobel Women”. Science 295(5554): 439.

[1] Se con ci credete, guardate https://it.wikipedia.org/wiki/Vincitori_del_premio_Nobel

[2] A onor del vero, le 11 donne che hanno vinto il Nobel negli ultimi 9 anni mostrano un significativo cambio di tendenza: sono tutte sposate e molte di loro hanno figli.

Nobel 2024, Chimica: una questione di Intelligenza Artificiale

Il premio Nobel per la chimica 2024 è stato assegnato a Demis Hassabis e John M. Jumper di DeepMind e David Baker della University of Washington. La motivazione per i primi due è : “for protein structure prediction”; per Becker “for computational protein design”

Comune denominatore della assegnazione sono le proteine e lo sviluppo di software intelligenti. E in entrambi i casi si tratta di esempio virtuosi e positivi sia di uso dell’Intelligenza Artificiale che di collaborazione nella comunità scientifica.

Demis Hassabis è il fondatore di DeepMind, vocata allo sviluppo di intelligenze artificiali nell’orbita di Google. Mente eclettica e indubbiamente geniale, progettista di videogiochi, neuroscienziato, imprenditore. Un predestinato.

John M. Jumper ha studiato fisica e matematica e ha lavorato all’ottimizzazione dei software per le simulazioni dei modelli durante il suo dottorato in fisica teorica.

Baker 30 anni fa ha sviluppato un software – Rosetta – per la progettazione di proteine; nel 2003 pubblicò Top7, una proteina che non esisteva in natura.

Le proteine sono uno dei 3 nutrienti fondamentali assieme a grassi e carboidrati. Sono formate da catene di amminoacidi che si ripiegano in strutture delle dimensioni dei nanometri (miliardesimi di metro) e sono i più importanti basilari per applicazioni essenziali nella vita biologica e industriale, dalla farmacologia alla veicolazione di enzimi e molecole.

Le strutture proteiche sono molto difficili da studiare: negli anni 50 fu messa a punto una tecnica basata sulla cristallografia a Raggi X, negli anni 90 fu istituito il CASP, una sorta di concorso biennale aperto a tutta la comunità scientifica e tecnologica per sviluppare strumenti al fine di prevedere in modo veloce e affidabile le strutture proteiche ma i risultati furono scarsi, fino al 2018, quando DeepMind con il suo software intelligente AlphaFold raggiunse il 60% di affidabilità.

Nel gruppo di lavoro c’era anche Jumper che applicò, successivamente, gli ultimi sviluppi delle reti neurali per sviluppare il modello di AlphaFold 2; questo nuovo software nel 2020 vinse il CASP con una accuratezza previsionale comparabile a quella della cristallografia.

Da allora AlphaFold è diventato uno standard de facto e ha raccolto quasi 200 milioni di strutture proteiche da tutti gli organismi viventi ad oggi conosciuti, creando quella che oggi è la libreria mondiale delle proteine. Alphafold è usato da oltre 2 milioni di ricercatori in 190 paesi.

L’intuizione di Baker è stata quella di “invertire” l’approccio funzionale di Rosetta, convertendolo da previsionale a progettuale: perché non “aiutare” la natura progettando proteine per ruoli specifici?

Dopo Top7, Baker progettò e realizzò diverse altre proteine specializzate che potrebbero essere impiegate per la produzione di vaccini, per rilevare la presenza di specifiche sostanze e per trasportare molecole negli organismi viventi di destinazione.

Le ricadute sociali della sinergia tra AlphaFold e gli studi di Baker sembrano essere già importanti e potrebbero diventare enormi. E stavolta, forse, tutte positive.

Dalla comparsa della Intelligenza Artificiale nel mercato consumer, prima con ChatGPT e poi gli altri, abbiamo iniziato a interrogarci sul ruolo sociale della IA e a dubitare dell’eticità dello scenario che si prospetta.

Il caso di AlphaFold può, invece, delineare una diversa prospettiva: il progetto è nato dalla sinergia di contributi diversi e complementari, di menti geniali, di ambizioni universali, con un obiettivo comune, dotate di risorse adeguate e di strumenti abilitanti che hanno permesso di rendere realtà il disegno generale.

Prima di AlphaFold studiare le proteine richiedeva tempi lunghi e incertezze elevate, oltre a competenze verticali che costringevano la ricerca a settorializzarsi.

Questo Nobel mette in luce un modello positivo di come la Intelligenza Artificiale possa essere una risorsa differenziante, quando viene addestrata con informazioni tassonomiche, affidabili, prive di bias e pre-filtrate.

Ancora di più ci dice che uomini e Intelligenza Artificiale possono lavorare in sinergia piuttosto che in concorrenza: AlphaFold è oggi un patrimonio della scienza mondiale e una volta di più si dimostra che l’assunzione di responsabilità di chi pensa e usa gli strumenti scientifici fa la differenza.

Nobel 2024, Fisica: propagazione dell'errore e vertigine delle etichette

1. ETICHETTE

Goffrey Hinton è uno psicologo cui è stato assegnato il Premio Nobel per la fisica in omaggio alle sue innovazioni in ambito informatico. Questa mescolanza di discipline mostra quanto sia svantaggioso l’irrigidimento nella separazione delle competenze e l’insistenza sulla specializzazione; ma è sorprendente che questa evidenza sia portata alla luce da un personaggio che ha costruito la sua carriera sulla ricerca di meccanismi destinati ad eseguire operazioni automatiche di ordinamento e classificazione – anzi, di più, a imparare metodi di lettura di contenuti non strutturati per applicare loro etichette di catalogazione.

Hinton meriterebbe un Nobel all’ostinazione, per la perseveranza con cui ha continuato a impegnarsi nell’evoluzione delle reti neurali e del deep learning, anche durante le fasi di «inverno» dell’intelligenza artificiale, con la riduzione degli investimenti, la sfiducia da parte delle istituzioni, lo scetticismo dei finanziatori. Non solo: per almeno un paio di decenni i budget destinati alla ricerca nel settore dell’AI hanno sostenuto soprattutto progetti che non credevano nella possibilità di apprendimento da parte delle macchine, e che si affidavano a software dove i processi di comprensione, di decisione e di esecuzione erano definiti dalle regole di comportamento stabilite a priori dallo sviluppatore umano.

Nel 2012 Hinton, con i collaboratori-studenti Alex Krizhevsky e Ilya Sutskever, ha presentato al concorso ImageNet il riconoscitore di immagini AlexNet: è al successo clamoroso di questa macchina che dobbiamo la diffusa convinzione che intelligenza artificiale, reti neurali e apprendimento profondo, siano tutti sinonimi. Il software non ha solo vinto la competizione del 2012, ma ha migliorato l’indice di correttezza nella classificazione delle illustrazioni di oltre 10 punti percentuali rispetto all’edizione precedente: un passo in avanti nelle prestazioni dell’intelligenza percettiva che non si era mai registrato nella storia del concorso. È risultato chiaro a tutti che in quel momento la disciplina era entrata in una nuova fase, e che il paradigma di progettazione e implementazione era cambiato. Una prova è che Sutskever figura tra i fondatori di OpenAI nel 2015, e che sia stato arruolato fino al novembre 2023 come ingegnere capo dello sviluppo di ChatGPT – il progetto con cui l’intelligenza artificiale ha valicato i confini dell’interesse specialistico e si è imposta all’attenzione del pubblico di massa alla fine del 2022.

2. STRATI NASCOSTI E RETROPROPAGAZIONE DELL’ERRORE

Il lavoro trentennale che precede AlexNet ruota attorno al concetto di retropropagazione dell’errore nel processo di apprendimento delle reti neurali. Né la nozione né il metodo sono stati inventati da Hinton, ma la sua ostinazione nel coltivarli non è servita meno dei suoi contributi ai procedimenti attuali e alla loro divulgazione, per l’elaborazione del paradigma contemporaneo dell’AI.

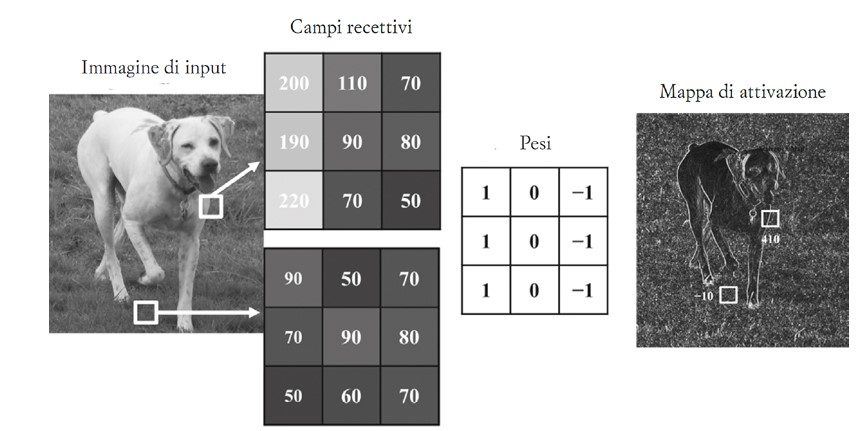

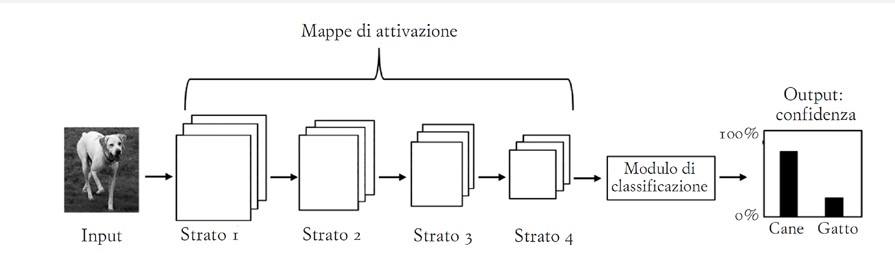

AlexNet e le reti neurali che che le somigliano (quelle convolutive) sono costruite con diversi livelli di unità di elaborazione. Nel primo strato i «neuroni» mappano l’immagine in una griglia di piccole celle, in analogia a quanto accade nella fisiologia della percezione umana.

Il risultato di questo schema di ricezione viene esaminato dagli strati di unità di elaborazione «nascosti», che interpretano confini e colori della figura. L’effetto è una rimappatura dell’immagine per livelli di lettura, che separano il soggetto dallo sfondo, esaminano parti, valutano posture, e così via; possono anche astrarre verso concetti come «fedeltà» o «famigliarità». Maggiore è il numero di questi livelli intermedi, maggiore è il grado di affidabilità con cui all’immagine viene fatta corrispondere l’etichetta che la descrive. A sua volta la didascalia proviene da una tassonomia che la macchina ha archiviato in memoria durante la prima fase di addestramento, insieme ad una galleria di migliaia, se non milioni, di immagini già classificate.

Il risultato di questo schema di ricezione viene esaminato dagli strati di unità di elaborazione «nascosti», che interpretano confini e colori della figura. L’effetto è una rimappatura dell’immagine per livelli di lettura, che separano il soggetto dallo sfondo, esaminano parti, valutano posture, e così via; possono anche astrarre verso concetti come «fedeltà» o «famigliarità». Maggiore è il numero di questi livelli intermedi, maggiore è il grado di affidabilità con cui all’immagine viene fatta corrispondere l’etichetta che la descrive. A sua volta la didascalia proviene da una tassonomia che la macchina ha archiviato in memoria durante la prima fase di addestramento, insieme ad una galleria di migliaia, se non milioni, di immagini già classificate.

Il compito del software è quindi associare pattern di pixel colorati alle etichette di uno schedario, con un certo grado di probabilità. Nella fase di addestramento con supervisione, se la didascalia scelta dalla macchina è corretta, il sistema rimane immutato; se invece l’output è sbagliato, il giudizio di errore si propaga tra gli strati intermedi che hanno contribuito alla stima, inducendo una variazione nei «pesi» del calcolo. Il procedimento tocca tutte le unità di elaborazione, e il suo perfezionamento è ancora oggi il principale tema di indagine per gli esperti del settore, come ha testimoniato Yann LeCun in un post su X poco meno di un anno fa.

Il compito del software è quindi associare pattern di pixel colorati alle etichette di uno schedario, con un certo grado di probabilità. Nella fase di addestramento con supervisione, se la didascalia scelta dalla macchina è corretta, il sistema rimane immutato; se invece l’output è sbagliato, il giudizio di errore si propaga tra gli strati intermedi che hanno contribuito alla stima, inducendo una variazione nei «pesi» del calcolo. Il procedimento tocca tutte le unità di elaborazione, e il suo perfezionamento è ancora oggi il principale tema di indagine per gli esperti del settore, come ha testimoniato Yann LeCun in un post su X poco meno di un anno fa.

La diffidenza di personaggi come Marvin Minsky e Seymour Papert sulla realizzabilità stessa della retropropagazione dell’errore ha dirottato per anni i finanziamenti su progetti che escludevano il deep learning: ai tempi della prima rete neurale, il Perceptron di Frank Rosenblatt che nel 1958 contava 1 solo livello intermedio, le difficoltà sembravano insormontabili. Come nelle storie dei grandi profeti, Hinton si è armato di fede, speranza – e anche senza la carità dei grandi finanziatori istituzionali, ha implementato una macchina capace di imparare a classificare.

3. LIMITI

La descrizione, colpevolmente troppo riduttiva, del funzionamento di AlexNet lascia anche intuire le condizioni e i limiti della concezione dell’intelligenza che è sottesa alla tecnologia delle reti neurali. Già nel piano di Rosenblatt il riconoscimento di un’immagine è inteso come un metodo che porta alla comprensione del contenuto attraverso l’autorganizzazione del contributo di molti attori atomici, coincidenti con le unità di calcolo: un altro articolo su «Controversie» ha esaminato come questo modello cognitivo derivi dal liberalismo economico e sociale di Von Hayek. Ma conta rilevare adesso altri due aspetti del paradigma: l’isolamento dell’apprendimento da ogni considerazione pragmatica, e la costruttività dal basso del processo di interpretazione.

Merleau Ponty ha esaminato con approccio fenomenologico il ruolo che l’attenzione svolge nella percezione: l’identificazione di persone e cose non è una successione di choc visivi che irrompono dal nulla, ma un flusso che segue un decorso da una maggiore indeterminazione ad una maggiore precisione, sull’istanza di una domanda. La richiesta interpella la nostra libertà di avvicinarci, approfondire, interagire: il riconoscimento avviene sullo sfondo di un mondo che è già in qualche modo pre-compreso, e che suscita interrogativi sulla base della relazione che intratteniamo con la scena in cui siamo immersi – per cui lo stesso masso si rivolge in modo differente ad un geologo, o ad un turista stanco per la passeggiata con il suo cane.

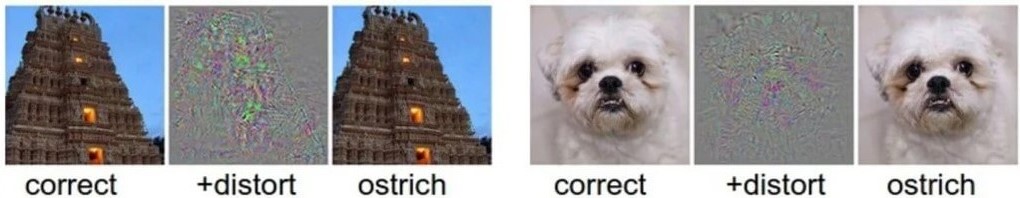

Il riconoscitore di immagini artificiale invece non stabilisce alcuna relazione con il mondo, né ha domande da indirizzargli. Anzi, non ha alcuna cognizione dell’esistenza del mondo e della possibilità di stabilire qualche rapporto con esso. La macchina valuta la probabilità con cui l’attivazione di certi pattern di unità ricettive possa essere messa in relazione con una tra le etichette dello schedario in memoria. Questo spiega come possa cadere nella trappola degli attacchi avversari, in cui il «rumore informativo» dovuto alla sostituzione di alcuni pixel (che non modificano per nulla l’aspetto dell’immagine ai nostri occhi) faccia cambiare le stime di AlexNet, convincendola a preferire l’etichetta struzzo a quelle assegnate correttamente in precedenza a tempio e cane.

Senza un mondo che agisca come orizzonte di senso per azioni e interpretazioni, non esistono domande, quindi nemmeno riconoscimenti e intelligenza – nel senso corrente di questi termini. Non esiste nemmeno la possibilità di un’autocorrezione, come quella che mettiamo a punto in modo istintivo quando incorriamo in un trompe l’oeil o in qualche illusione ottica: è la stabilità del mondo, non la coerenza delle leggi dell’apprensione, a permetterci di ravvisare l’errore. L’inganno per noi infatti è momentaneo, poi la coesione dell’esperienza del reale torna a ripristinare il senso della percezione (anche nei casi di abuso di sostanze psicotrope): è per questo che siamo consapevoli di essere vittime di illusioni.

Senza un mondo che agisca come orizzonte di senso per azioni e interpretazioni, non esistono domande, quindi nemmeno riconoscimenti e intelligenza – nel senso corrente di questi termini. Non esiste nemmeno la possibilità di un’autocorrezione, come quella che mettiamo a punto in modo istintivo quando incorriamo in un trompe l’oeil o in qualche illusione ottica: è la stabilità del mondo, non la coerenza delle leggi dell’apprensione, a permetterci di ravvisare l’errore. L’inganno per noi infatti è momentaneo, poi la coesione dell’esperienza del reale torna a ripristinare il senso della percezione (anche nei casi di abuso di sostanze psicotrope): è per questo che siamo consapevoli di essere vittime di illusioni.

La separazione della sfera cognitiva da quella pragmatica, e la riduzione della mente ad un sistema di procedure di problem solving, intrappolano invece la percezione in un mondo di specchi e di concetti senza via d’uscita. Le inferenze che si propagano da unità nucleari di percezione sono il correlato di un universo di etichette che non si riferiscono a nulla di reale – tanto da poter ravvisare uno struzzo al posto di un tempio, senza alcuna forma di disagio. Quel disagio che colpisce l’individuo intelligente davanti all’abisso della stupidità.

BIBLIOGRAFIA

Bottazzini, Paolo, Nello specchio dell’Intelligenza Artificiale - The Eye of the Master, «Controversie», 4 giugno 2024. https://www.controversie.blog/specchio-della-ia.

LeCun, Yann, Please ignore the deluge of complete nonsense about Q*, https://x.com/ylecun/status/1728126868342145481.

Merleau-Ponty, Maurice, Phénoménologie de la perception, Gallimard, Parigi 1945; trad. it. a cura di Andrea Bonomi, Fenomenologia della percezione, Bombiani, Milano 2003.

Minsky, Marvin; Papert, Seymour, Perceptrons, MIT Press, Cambridge 1969.

Rumelhart, David E.; Hinton, Geoffrey E.; Williams, Ronald J., Learning representations by back-propagating errors, «Nature», vol. 323, n. 6088, 9 ottobre 1986, pp. 533–536.

Szegedy, Christian, Zaremba, Wojciech, Sutskever, Ilya, Bruna, Joan, Erhan, Dumitru, Goodfellow, Ian, Fergus, Rob (2013), Intriguing Properties of Neural Networks, «arXiv», preprint arXiv:1312.6199.

Nobel 2024, Medicina: la genetica al tempo della messaggistica istantanea

MICRO MESSAGGERI DA NOBEL

Il premio Nobel 2024 per la Medicina e la Fisiologia è stato assegnato a Victor Ambros e Gary Ruvkun. I due ricercatori, genetisti, hanno ricevuto il premio per la scoperta nel 1993 del microRNA e del suo funzionamento come regolatore del genoma.

Il DNA è il luogo, la molecola, in cui si conserva l’informazione genetica. Diffuso in ogni cellula del nostro corpo (così come in ogni essere vivente) il DNA, con la sua doppia elica, è il ricettario a cui ogni cellula attinge per produrre proteine. È parte dell’eredità che riceviamo dai nostri genitori biologici e per diversi anni si è creduto fosse un’eredità vincolante, un destino da cui non fosse possibile fuggire.

In realtà il DNA da solo non basta. Il suo utilizzo richiede anche un singolo filamento di RNA che, nei processi di trascrizione e traduzione, assume diverse forme per permettere alla cellula di acquisire l’informazione, trasportarla dove necessario e, infine, tradurla in una molecola complessa utile ai bisogni dell’organismo di cui fa parte.

È in questo processo – mutazioni a parte – che si è iniziata a scoprire la libertà dell’organismo rispetto all’informazione del DNA.

In primo luogo, la ricerca che oggi conosciamo come epigenetica scoprì che alcune proteine potevano bloccare, al bisogno, alcune parti del DNA impedendo che venisse trascritto in RNA messaggero (mRNA) e che, quindi, venisse utilizzato.

La scoperta del microRNA porta ulteriori sviluppi nella comprensione del rapporto complesso tra DNA, organismo e ambiente. I microRNA (miRNA) infatti sono una nuova classe di RNA non codificante, lunghi circa 22 basi nucleotidiche.

Essi agiscono come regolatori diffondendosi nella cellula (e fuori di essa) e bloccando – quando serve - l’mRNA già prodotto. Prima sapevamo che è possibile inviare o non inviare il messaggio, ora conosciamo anche la funzione cancella messaggio. Certo, tutti i componenti del gruppo vedranno la scritta “messaggio cancellato”.

Perché ci è voluto così tanto – dal 1993 al 2024 - perché a questa scoperta venisse riconosciuto il Nobel?

MESSAGGIO CANCELLATO. LA SCOPERTA DEI MIRNA DAL VERME ALL’ESSERE UMANO

La passione di Ambros e Ruvkun è il nematode, un vermicello, Caenorhabditis elegans. Vermicello portentoso perché (povero lui) il suo genoma è facilmente manipolabile, si riproduce velocemente ed è persino trasparente. È inoltre perfetto per lo studio dello sviluppo e della differenziazione cellulare: pur nella sua semplicità possiede già un sistema nervoso, un intestino e dei muscoletti. Oggetto dello studio dei due ricercatori, in due diversi laboratori, sono i geni lin-14 e lin-4 entrambi implicati nello sviluppo cellulare di C. elegans.

Ambros, Rosalind Lee e Rhonda Feinbaum riescono a clonare lin-4, scoprendo che funziona da regolatore, negativo, per lin-14. Non solo. È un gene corto e non codifica per nessuna proteina, la cosa al tempo era strana.

Ruvkun, nel frattempo, scopre che questa interazione - il fatto che lin-4 blocchi l’espressione di lin-14 - non avviene interrompendo la produzione di mRNA.

Nei primi anni ‘90 questo era ancora più strano! In qualche modo la regolazione avviene in un secondo momento.

I due laboratori di ricerca decidono nel 1992 di confrontare i risultati. Ne risulta che il piccolo RNA di lin-4 ha un codice complementare all’mRNA di lin-14. Sembrerebbe che il primo sia regolatore del secondo, e questa è una novità.

Queste osservazioni vengono pubblicate nel 1993 sulla rivista Cell e oggi, dopo 30 anni, valgono ai due ricercatori il premio Nobel (Wightman B., Ha I., Ruvkun G. 1993 e Lee R., Feinbaum R., Ambros V. 1993).

Lo stesso Ambros racconta che, in fondo, nessuno pensava questa fosse una scoperta apripista: il modello della genetica del tempo risultava sufficiente alla comprensione dei problemi posti al tempo.

Non solo. Questa interazione era riscontrata solo nel piccolo nematode e non c’era ragione di credere che fosse qualcosa di diffuso.

Nel 1994, alcuni ricercatori si chiedono se non possa essere qualcosa di più importante, ma la domanda cade quasi nel vuoto. Rosalind Lee continuerà a cercare altri esempi di questa regolazione, ma con scarso successo.

La tecnica di quegli anni non aiuta, è necessario infatti “camminare lungo il genoma” cercando per tentativi le sequenze che potrebbero appartenere a un miRNA (Ambros V. 2008).

Nel 2000, Ruvkun, guidato dalla curiosità - come dirà – rompe l’inerzia scoprendo un altro miRNA, prodotto dal gene let-7.

Questo è un gene che si è conservato lungo quasi tutta la catena evolutiva e fa presumere che questo modello di regolazione possa essere diffuso in altre piante e animali. (Pasquinelli A., Reinhart B. et al. 2000). Ambros e Lee continuano il loro lavoro iniziando a scoprire diversi miRNA.

Ambros racconta che pensava di essere tra i pochi, con Lee, se non l’unico, a cercare ancora i miRNA tra il '96 e il 2000. Fino a quando nell’agosto del 2001 non riceve una richiesta da parte di Science: dovrebbe fare da revisore per un articolo di Tom Tuschl sulla scoperta di diverse decine di miRNA.

Fu un colpo per i ricercatori, che cercarono subito di sottomettere un articolo a Cell senza trovare l’interesse della rivista. Disperati andranno da Science, la rivista accorderà loro la pubblicazione in contemporanea se avessero inviato l’articolo entro un giorno. Ci riescono, anche se verrà giudicato un articolo decisamente scarno. Assieme a loro e a Tuschl su quel numero uscirà un terzo articolo sulla scoperta di nuovi miRNA (Ambros V. 2008).

Tra i diversi miRNA scoperti, molti sono stati trovati nel corpo umano.

Il mondo della ricerca inizia a comprendere il potenziale di questi regolatori, così generici e così diffusi. I miRNA regolano finemente il rapporto tra genoma, sviluppo cellulare e rapporto tra organismo e ambiente. Alcune espressioni patologiche di un miRNA possono prodursi in tumori, anche in età infantile come nella rara sindrome di DICER1.

OLTRE IL MECCANISMO. DUBBI ,TERAPIE, COMPORTAMENTO E SVILUPPI FUTURI

Oggi i miRNA sono una realtà ormai attestata nella ricerca medica e il Nobel per la Medicina a Ambros e Ruvkun conferma e ribadisce l’interesse diffuso per questo campo di ricerca.

Nel database si trovano 48.860 diversi miRNA diffusi in 270 organismi. Il meccanismo di produzione di un miRNA, la sua espressione come regolatore, l’interazione con i diversi geni sono ormai sufficientemente chiari (Shang R., Lee S. et al. 2023).

Delle terapie farmacologiche mirate sembrano dare effetti (rimpiazzare un miRNA assente a esempio), ma i risultati dei trial sono ancora controversi. Alcuni di questi evidenziano una grande efficacia (pur se correlativa), altri al contrario danno risultati nulli, quando non tossici per l’organismo (Ho P. T. B., Clark, I. M., Le L. T. T. 2022).

Propaganda farmacologica a parte, sembra interessante comprendere il ruolo di questi piccoletti nel rapporto con l’organismo intero e i suoi bisogni.

In tal senso, sono rilevanti gli studi che cercano di comprendere la funzione regolatrice all’interno di un meccanismo di feedback negativo nei neuroni dopaminergici del mesencefalo. Cellule implicate in comportamenti complessi come quelli di ricompensa o di dipendenza e che vengono a mancare via via che si sviluppano patologie come il Parkinson. Uno studio germinale ma che cerca di tracciare una correlazione tra comportamenti e espressione genetica coinvolgendo il miRNA. (Kim J., Inoue K, Ishii, J. et al. 2007).

Allo stesso modo i miRNA sembrano poter diventare utili biomarcatori.

La loro diffusione in tutto il corpo potrebbe renderli adeguati per lo sviluppo di nuove tecniche diagnostiche per le più diverse patologie, oltre che per lo studio di trattamenti. Anche qui gli studi sono appena agli inizi e per far sì che si sviluppino è necessario comprendere il comportamento dei miRNA Loganathan T., Doss G. 2023).

In ultimo va citata un’osservazione sui miRNA che si può ritenere affascinante: sono stati trovati infatti miRNA ragionevolmente stabili in uno studio comparato sul latte materno.

Per i ricercatori, questi avrebbero il potenziale per venire assorbiti dall’intestino e una delle ipotesi è che si potrebbe avere il passaggio di una continua “comunicazione” di informazioni su comportamenti possibili, sui modi di regolare quel genoma che ci è stato lasciato in eredità (Tingo L., Ahlberg E. 2021).

BIBLIOGRAFIA

- https://www.nobelprize.org/prizes/medicine/2024/prize-announcement/

- https://www.nobelprize.org/prizes/medicine/2024/advanced-information/

- Weiss C., Ito, K et al. (2017) “A Macro View of MicroRNAs: The Discovery of MicroRNAs and Their Role in Hematopoiesis and Hematologic Disease” in Int Cell Mol Biol, 334: 99-175.

- Kim J., Inoue K, Ishii, J. et al. (2007) “A microRNA feedback circuit in midbrain dopamine neurons” in Science 317 (5482): 1220-1224.

- Pasquinelli A., Reinhart B. et al. (2000) “Conservation of the sequence and temporal expression of let-7 heterochronic regulatory RNA” in Nature 408: 86-89.

- Wightman B., Burglin T. et al. (1991) “Negative regulatory sequence in the lin-14 3’-untranslated region are necessary to generate a temporal switch during Caenorhabditis elegans development” in Genes & Development 5:1813-1824.

- Bartel D. (2004) “MicroRNAs: Genomics, Biogenesis, Mechanism, and Function” in Cell 116: 281-297.

- Shang R., Lee S. et al. (2023) “microRNAs in action: biogenesis, function and regulation” in Nat Rev Genet 24(12): 816-833.

- Ho P. T. B., Clark, I. M., Le L. T. T. (2022) “MicroRNA-Based Diagnosis and Therapy” in Int J Mol Sci 23: 7167.

- Tingo L., Ahlberg E. (2021) “Non-Coding RNAs in Human Breast Milk: A Systematic Review” in Frontiers of Immunology 12: 725323.

- Loganathan T., Doss G. (2023) “Non-coding RNAs in human health and diseases as biomarkers and therapeutic targets” in Functional & Integrative Genomics 23: 33.

- Wightman B., Ha I., Ruvkun G. (1993) “Posttranscriptional Regulation of the Heterochronic Gene lin-14 by lin-4 Mediates Temporal Pattern Formation in elegans” in Cell 75: 855-862.

- Lee R., Feinbaum R., Ambros V. (1993) “The elegans Heterochronic Gene lin-4 Encodes Small RNAs with Antisense Complementarity to lin-14” in Cell 75: 843-854.

- Ambros V. (2008) “The evolution of our thinking about microRNAs” in Nature Medicine 14 (10): 1036-1040.